Die Landschaft des Produktmanagements hat sich in den letzten achtzehn Monaten radikal verändert. Während wir uns im Jahr 2026 einrichten, zeigt der Rückblick auf den „2025 Shift“, dass Künstliche Intelligenz nicht mehr nur ein Feature ist – sie ist die zugrunde liegende Infrastruktur moderner Software. Für einen Produktmanager bedeutet das, dass die traditionelle Leiter der Karriereentwicklung neu konzipiert wurde. Das Verständnis der Produktmanager-Stufen erfordert jetzt ein tiefes Verständnis dafür, wie man Produkte aufbaut, skaliert und verwaltet, die von LLMs angetrieben werden.

Die Zeiten, in denen man sich ausschließlich auf Intuition und grundlegende Analysen verließ, sind vorbei. Heute ist der Wert eines PM direkt mit seiner Fähigkeit verknüpft, die Kluft zwischen den Bedürfnissen menschlicher Nutzer und der probabilistischen Natur von Large Language Models zu überbrücken. Dieser Leitfaden zerlegt die essentiellen Fähigkeiten, Rollen und Verantwortlichkeiten, die erforderlich sind, um in dieser neuen Ära erfolgreich zu sein.

Neudefinierung der Kompetenzen im Produktmanagement für das KI-Zeitalter

Früher bedeutete der Aufstieg vom Associate zum Senior PM vor allem das Beherrschen des Stakeholder-Managements und der Roadmap-Umsetzung. Im heutigen Markt ist technische Kompetenz im Umgang mit KI-Modellen der neue Türsteher. Die Unterscheidung zwischen einer Junior- und einer Senior-Rolle hängt jetzt oft von der Tiefe des Verständnisses in Bezug auf Modellverhalten, Kostenfolgen und ethische Implementierung ab.

Es reicht nicht aus, KI einfach nur „zu nutzen“; man muss die Architektur verstehen. Ob man Microsoft Copilot vs ChatGPT in einen Workflow integriert oder eine proprietäre Lösung baut, der Entscheidungsprozess erfordert eine nuancierte Perspektive auf Kompromisse zwischen Latenz, Genauigkeit und Kosten.

Die technische Basis: Mehr als nur Schlagwörter

Um effektiv zu arbeiten, muss ein Produktmanager ein funktionierendes Wissen über die verfügbaren Tools besitzen. Es geht nicht nur um Chatbots; gemeint sind die Backend-Engines, die die Funktionalität antreiben. LLMs wie die GPT-Serie, BERT für Kontextverständnis oder T5 für Übersetzungsaufgaben sind die Bausteine. Allerdings reicht es nicht, die Namen zu kennen; man muss ihre Anwendung verstehen.

Beispielsweise kann ein PM bei der Fehlersuche an einem Produkt, das nicht wie erwartet funktioniert, nicht einfach das Ticket an die Technik abgeben. Die Vertrautheit mit häufigen Problemen wie ChatGPT-Fehlercodes oder API-Ratenlimits ermöglicht eine schnellere Diagnose und Iteration. Diese technische Empathie beschleunigt den Entwicklungszyklus und verschafft Respekt bei ML-Ingenieuren.

Strategische Umsetzung und Lifecycle-Management

Der LLM-Produktentwicklungs-Lifecycle unterscheidet sich erheblich von der traditionellen Softwareentwicklung. Die probabilistische Natur der Generativen KI führt Variablen ein, die im deterministischen Code nicht existieren. Der Lifecycle umfasst jetzt spezifische Phasen wie Modellauswahl, Feinabstimmung und Grounding, um Halluzinationen zu vermeiden.

Eine der kritischsten strategischen Entscheidungen eines PM besteht darin, Performance und Budget auszubalancieren. Die Betriebskosten für das Ausführen von LLMs können aus dem Ruder laufen, wenn sie nicht überwacht werden. Ein umsichtiger PM bewertet ständig die Ressourcenzuweisung und behält ChatGPT-Preise 2025: alles, was Sie über Tarife und Abonnements wissen müssen genau im Auge, um die Wirtschaftlichkeit auf Einheitenebene sicherzustellen. Dieses finanzielle Verständnis ist nun ein Kernbestandteil der Rollen auf Direktoren- und VP-Ebene.

Von der Entdeckung bis zur Bereitstellung 🚀

Die Produktentdeckung wurde beschleunigt. Wir können jetzt große Mengen unstrukturierter Daten – Kundenrezensionen, Support-Tickets, Verkaufsgespräche – verarbeiten, um Schmerzpunkte sofort zu identifizieren. Allerdings bringt diese Geschwindigkeit neue Herausforderungen mit sich. Das Prinzip „Garbage in, garbage out“ ist tödlicher denn je. Wenn Ihre Trainingsdaten verzerrt sind, wird Ihr Produkt es auch sein.

Nachfolgend ein Vergleich, wie sich die Verantwortlichkeiten vom traditionellen Modell zum heutigen AI-nativen Modell verschoben haben:

| Merkmal | Traditionelles Produktmanagement | AI-natives Produktmanagement (2026) |

|---|---|---|

| Kernfokus | Features, UI/UX-Flows, lineare Roadmaps | Datenpipelines, Modellgenauigkeit, probabilistische Ergebnisse |

| Nutzerforschung | Manuelle Interviews, Umfragen, langsame Synthese | LLMs analysieren Stimmungen im großen Maßstab, automatisierte Mustererkennung |

| Qualitätssicherung | Bug-Tracking, funktionale Tests | Bewertung von Halluzinationen, Bias-Erkennung, Antwortlatenz |

| Erfolgsmessung | Konversionsraten, Retention, DAU/MAU | Token-Nutzungseffizienz, Relevanz der Antwort, Vertrauens- und Sicherheitsschutz |

| Tools | Jira, Figma, Excel | Vektordatenbanken, Tools für Prompt Engineering, Bewertungsframeworks |

Navigation in der Wettbewerbslandschaft

Die Wahl des richtigen Modells ist vergleichbar mit der Auswahl der richtigen Datenbank in den frühen 2000er Jahren – sie definiert die Fähigkeiten und Begrenzungen Ihres Produkts. Ein Produktmanager muss ständig den Horizont scannen. Beispielsweise hilft der Vergleich von ChatGPT vs Bard 2025-Leistungsbenchmarks dabei, zu entscheiden, welche API ein bestimmtes Feature-Set besser bedient, etwa kreatives Schreiben versus faktische Zusammenfassung.

Darüber hinaus ist für Startups oder kleinere Enterprise-Tools Ressourceneffizienz entscheidend. Die Nutzung der besten AI-Tools für kleine Unternehmen kann einen Wettbewerbsvorteil bieten, ohne die Last, eine maßgeschneiderte Infrastruktur von Grund auf neu zu entwickeln. Diese Agilität ermöglicht kleineren Teams, über ihre Gewichtsklasse hinauszuschlagen.

Das richtige Team aufbauen

Ein KI-Produkt wird nie isoliert gebaut. Das cross-funktionale Team hat sich erweitert. Über die üblichen Softwareingenieure und Designer hinaus orchestriert der PM jetzt Workflows, die Machine Learning Engineers, Data Engineers und AI Ethiker einbeziehen. Zusammenarbeit ist der Klebstoff, der diese vielfältigen Disziplinen zusammenhält.

Wesentliche Fähigkeiten für den modernen PM

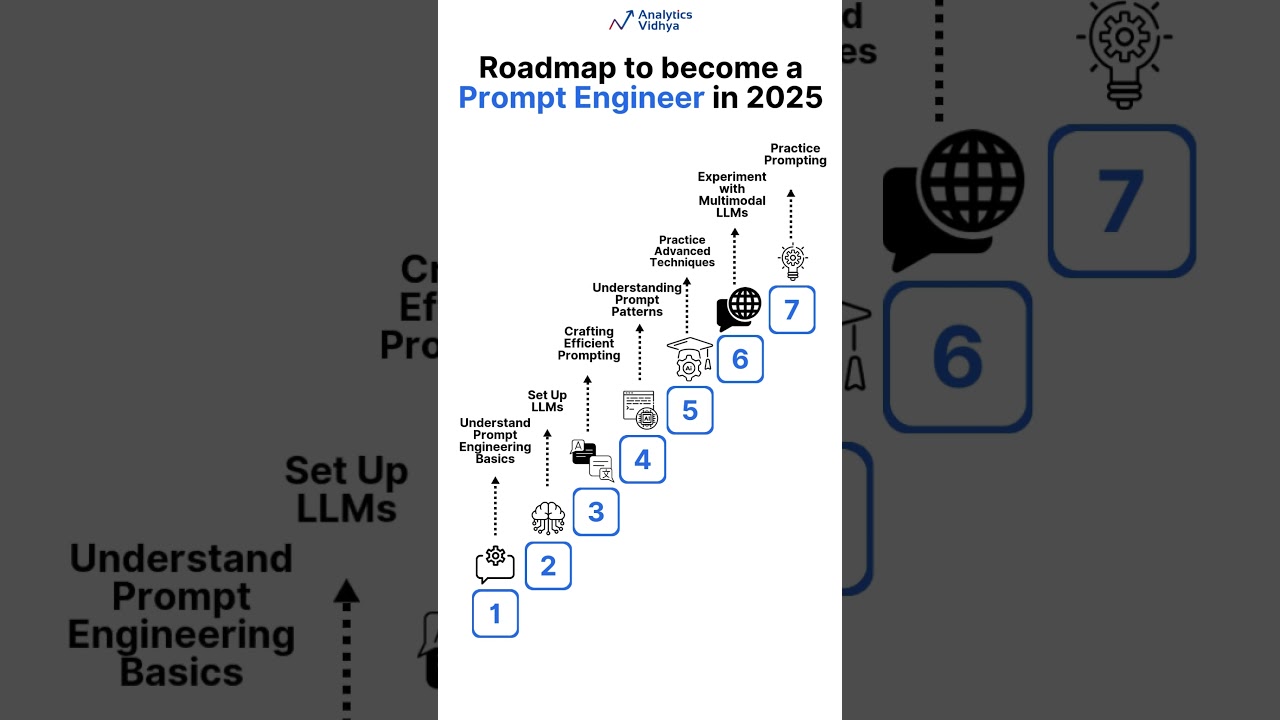

Um in diesem Umfeld erfolgreich zu sein, müssen spezifische Kompetenzen entwickelt werden. Hier eine Checkliste der unverzichtbaren Fähigkeiten für den aktuellen Markt:

- Kontext-Engineering: Die Fähigkeit, Prompts und Systemanweisungen so zu gestalten, dass das Modell zuverlässig die gewünschte Ausgabe liefert.

- Datenkompetenz: Verständnis für Datenherkunft, Reinigungs-Pipelines und rechtliche Implikationen der Datennutzung (Datenschutz, Urheberrecht).

- Bewertungsmetriken: Über einfache Genauigkeit hinausgehen; Messung von Hilfreichkeit, Sicherheit und Tonalitätskonsistenz.

- Ethisches Urteilsvermögen: Proaktives Erkennen potenzieller Verzerrungen und Implementierung von Schutzmaßnahmen vor der Bereitstellung.

- Technische Übersetzung: Komplexe Modellbeschränkungen klar für nicht-technische Stakeholder kommunizieren.

Auch in Nischenmärkten gelten diese Fähigkeiten. Ob Sie Fintech-Lösungen oder spezialisierte Hardware-Schnittstellen wie Vape-Detektoren für die Schul-sicherheit entwickeln – die Integration intelligenter Warnmeldungen und Datenverarbeitung erfordert einen PM, der das Zusammenspiel von Hardware-Sensoren und KI-Interpretation versteht.

Praxisanwendung und Ausblick in die Zukunft

Es gibt Erfolgsbeispiele, die diesen Wandel bestätigen. Unternehmen wie Zoom und Adobe haben KI nicht einfach nur ergänzt; sie haben sie in den Kernwert integriert und automatisieren Zusammenfassungen und Inhaltserstellung auf eine Weise, die für die Nutzererfahrung naturnah ist. DeepMinds AlphaCode und Spotifys AI DJ sind weitere herausragende Beispiele für tiefe Integration.

Im weiteren Verlauf werden sich die Stufen des Produktmanagements weiter auseinanderentwickeln. Der Titel „AI Product Manager“ könnte irgendwann ganz verschwinden, einfach weil jeder Produktmanager als AI Product Manager angesehen wird. Die Tools, die Strategie und die Umsetzung sind nun untrennbar mit intelligenten Systemen verbunden.

What is the main difference between a traditional PM and an AI PM?

The primary difference lies in the uncertainty of the technology. Traditional software is deterministic (Input A always leads to Output B). AI products are probabilistic. An AI PM must manage this uncertainty, focusing heavily on data quality, model evaluation, and handling unpredictable outputs (hallucinations), whereas a traditional PM focuses more on defined feature logic and UI flows.

Do I need to know how to code to be an AI Product Manager?

While you don’t necessarily need to write production code, you need a higher level of technical literacy than before. You must understand how LLMs work, the basics of prompt engineering, how APIs function, and the concepts of training versus inference. Being able to read Python or understand data structures is a massive advantage for communicating with ML engineers.

How do LLMs change the product discovery process?

LLMs accelerate discovery by automating the analysis of qualitative data. Instead of manually reading hundreds of survey responses, a PM can use an LLM to synthesize themes, sentiment, and feature requests in seconds. This allows the PM to focus on strategic validation and high-level problem solving rather than data processing.

What are the biggest risks in developing LLM-based products?

The major risks include hallucinations (confident but false information), bias in outputs based on training data, data privacy concerns (leaking sensitive user info), and spiraling inference costs. A skilled PM builds strategies and guardrails to mitigate these specific risks from day one.

No responses yet