Sobrecarga de VM vs. bare metal: ¿puede ejecutar una máquina virtual ralentizar un servidor multimedia?

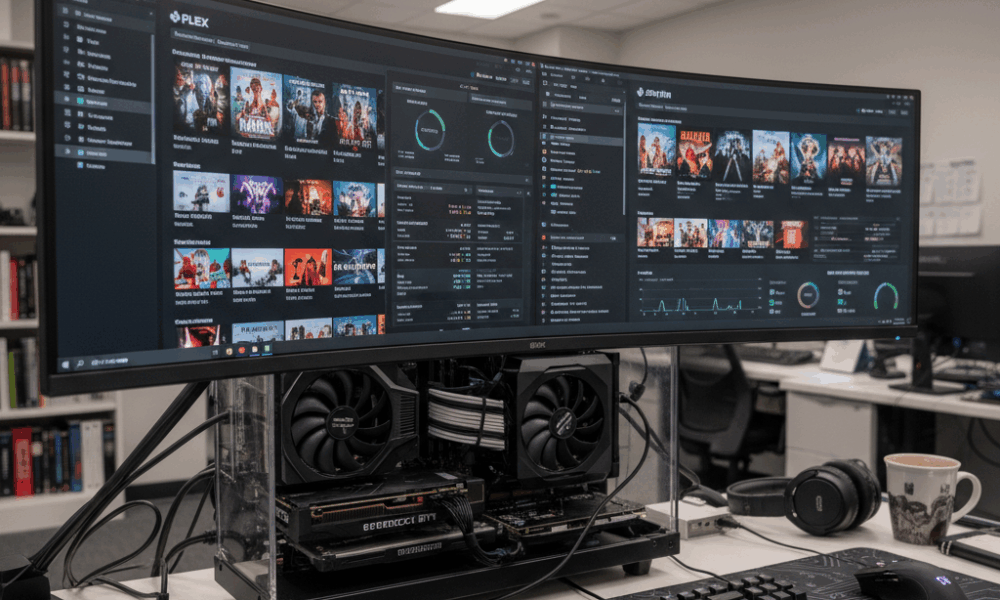

El rendimiento de un servidor multimedia está determinado por tres fuerzas: cómputo para transcoding, ancho de banda de almacenamiento para operaciones de biblioteca y entrega en red. La virtualización inserta un hipervisor entre el sistema operativo y el hardware, por lo que la pregunta es si esa capa extra altera el equilibrio. Con plataformas modernas como Hyper-V, Proxmox (con KVM/QEMU), VMware vSphere y Citrix Hypervisor, el costo base del hipervisor suele ser modesto cuando está optimizado. Por ejemplo, el programador e integración de Hyper-V están diseñados para consumir una pequeña parte de la CPU, a menudo citada alrededor de un solo dígito bajo en porcentaje para tareas administrativas, dejando la mayoría de los ciclos para las cargas de trabajo. Sin embargo, los servidores multimedia cambian el cuello de botella según la carga: las transcodificaciones en vivo 4K ponen presión en la CPU/GPU, mientras que los escaneos grandes de bibliotecas Plex/Jellyfin saturan la E/S del disco.

Considere Beacon Media, un pequeño equipo de postproducción que consolidó un servidor Plex y una VM de utilidad Windows en un solo host. En bare metal, una transcodificación de 4K HEVC a 1080p H.264 sostenía 120 fps usando NVIDIA NVENC. Dentro de una VM con passthrough de GPU, el rendimiento estuvo dentro del 2–5% del bare metal tras la optimización de controladores. El mayor impacto ocurrió durante las actualizaciones simultáneas de metadatos, cuando la cola de disco virtual de la VM se profundizó, aumentando la latencia y elevando el tiempo ready de la CPU. La conclusión es simple: la virtualización rara vez afecta el rendimiento del transcoding cuando el passthrough de GPU se usa correctamente, pero el almacenamiento y la planificación pueden convertirse en nuevos puntos críticos si no se ajustan.

Diversos hipervisores y modelos de dispositivos importan. Los dispositivos emulados son lentos para tareas multimedia de alto rendimiento, mientras que los controladores paravirtualizados o “enlightened”—como virtio en KVM/QEMU y los servicios de integración en Hyper-V—reducen significativamente la sobrecarga. En sistemas Windows invitados, eliminar adaptadores emulados y dispositivos no usados, e instalar los componentes más recientes de integración, reduce la actividad CPU en segundo plano. Esto contribuye a un servicio multimedia más fluido durante las horas pico.

Las preguntas clave guían la decisión: ¿El servidor realiza transcodificaciones múltiples de 4K con frecuencia? ¿Se requiere aceleración por GPU? ¿La biblioteca multimedia es masiva, causando operaciones intensas de escaneo? Si la respuesta es sí a cualquiera de ellas, la VM debe diseñarse como una carga de producción, no como un sandbox de conveniencia. Eso incluye recursos de CPU fijados, almacenamiento NVMe rápido y redes paravirtualizadas. Con esos elementos, muchos laboratorios domésticos y estudios pequeños reportan una paridad cercana al bare metal para streaming cotidiano.

- 🎯 Línea base: Esperar sobrecarga de CPU de un solo dígito bajo para un hipervisor moderno bien configurado.

- 🧠 Modelo de dispositivo: Preferir virtio (KVM/QEMU) o controladores enlightened (Hyper-V) sobre hardware emulado.

- ⚙️ Forma de la carga: Las transcodificaciones aceleradas por GPU dentro de VMs pueden acercarse a bare metal con passthrough adecuado.

- 📚 Escaneos de biblioteca: La latencia de almacenamiento en VMs puede bloquear escaneos; usar NVMe y ajustar la profundidad de cola.

- 🌐 Red: Los conmutadores virtuales añaden una sobrecarga mínima si se habilitan offloads y RSS.

| Hipervisor | Sobreocarga de transcodificación (GPU) ⚡ | Tareas intensivas de disco 📀 | Impacto en red 🌐 | Notas |

|---|---|---|---|---|

| Hyper-V | ~2–5% con DDA/GPU-P | Moderado si se usa VHDX en discos lentos | Bajo con offloads en vSwitch | Instalar servicios de integración; evitar NICs emuladas |

| Proxmox (KVM/QEMU) | ~0–5% con passthrough VFIO | Bajo–Moderado con virtio-scsi/NVMe | Bajo con virtio-net | Usar hugepages, fijar vCPUs para consistencia |

| VMware vSphere | ~0–5% con vGPU/passthrough | Bajo con SCSI paravirtual | Bajo con VMXNET3 | Herramientas excelentes para monitoreo de rendimiento |

| Citrix Hypervisor | ~0–6% con vGPU | Bajo–Moderado | Bajo | Stack vGPU potente en entornos empresariales |

| VirtualBox | Alto, soporte GPU limitado | Moderado–Alto para cargas pesadas I/O | Moderado | Mejor para pruebas; no ideal para streaming 4K a escala |

La conclusión práctica: sí, una VM puede afectar el rendimiento de un servidor multimedia, pero con el stack y controladores adecuados, el efecto es pequeño y predecible — especialmente cuando hay aceleración por GPU y almacenamiento rápido.

CPU, memoria y ajuste NUMA para transcoding de medios dentro de VMs

El transcoding desgasta cachés de CPU, ancho de banda de memoria y planificación. En hosts con CPUs Intel o AMD, el multithreading simultáneo (SMT) puede aumentar el rendimiento, pero solo si la topología de vCPU y la programación de hilos están alineadas con el hipervisor. Usar vCPUs en números pares cuando SMT está activo, y evitar sobredimensionar si la latencia constante es el objetivo. Para Hyper-V, los procesadores virtuales deben reflejar evaluaciones de carga máxima y no promedios; cuando sube el tiempo ready de CPU, las transcodificaciones se truncan.

La asignación de memoria interactúa con NUMA. Una VM de 24 hilos con 32–64 GB de RAM puede abarcar nodos físicos NUMA. Si vNUMA está deshabilitado o distorsionado por memoria dinámica, el pipeline de transcoding puede saltar entre nodos, incurriendo en penalizaciones de memoria remota. Hyper-V expone Virtual NUMA por defecto para VMs grandes; déjalo activado para apps conscientes de NUMA y evita la memoria dinámica cuando importa la consistencia. En KVM/QEMU, alinea numactl o el pinning de VM con la topología del host para mantener memoria y vCPUs locales.

La actividad CPU en segundo plano perjudica silenciosamente. Los invitados inactivos que ejecutan escáneres de actualizaciones, desfragmentación o indexación roban ciclos en el peor momento. La guía de Microsoft sigue vigente en 2025: eliminar NICs emuladas, deshabilitar tareas programadas innecesarias, mantener visible la pantalla de inicio de sesión cuando está inactiva y cerrar consolas de gestión que consultan constantemente las VMs. Estos pasos reducen la presión de interrupciones y estabilizan la latencia del transcoding.

- 🧩 Fijar vCPUs a núcleos/hilos físicos para FPS constantes en horas pico.

- 🧮 Respetar vNUMA: mantener la memoria local; evitar memoria dinámica para transcodificaciones pesadas.

- 🛡️ Servicios de integración: instalar las últimas mejoras para reducir la sobrecarga de CPU en E/S.

- 🧹 Minimizar tareas en segundo plano: deshabilitar SuperFetch/Busqueda en VMs cliente; eliminar dispositivos no usados.

- ⏱️ Monitorear KPIs: utilización de CPU, cola de ejecución/ready time y cambios de contexto por segundo.

| Configuración | Por qué importa 🧠 | Impacto en medios 🎬 | Acción recomendada ✅ |

|---|---|---|---|

| Conteo y fijación de vCPU | Reduce retrasos en la planificación | FPS más suaves durante transcodificaciones múltiples | Números pares con SMT; fijar VMs críticas |

| Exposición vNUMA | Preserva la localidad | Mayor bitrate sostenido bajo carga | Habilitar vNUMA; evitar memoria dinámica para VMs grandes |

| Controladores I/O enlightened | Menos trampas de emulación | Escaneos y escrituras DVR más rápidas | Usar virtio/VMXNET3/Adaptadores específicos Hyper-V |

| Ruido en segundo plano | Libera ciclos CPU | Menos interrupciones bajo actividad irregular | Deshabilitar servicios y tareas programadas innecesarias |

Los planificadores no son muy distintos de los grandes programadores de entrenamiento de IA. La contención de recursos y la colocación tienen análogos en la orquestación de IA, como se ve en discusiones sobre lo que se espera de la fase de entrenamiento de GPT-5 en 2025, donde el cómputo, la memoria y la alineación de E/S determinan el rendimiento. Los mismos principios aplican en menor escala a servidores multimedia domésticos.

Regla práctica: tratar la VM multimedia como una carga de producción, no como un pensamiento secundario, y la configuración de CPU/memoria dejará de ser el cuello de botella.

Aceleración GPU en una VM: passthrough, compartición vGPU y resultados reales en Plex/Jellyfin

La aceleración por hardware convierte un servidor multimedia de “suficientemente bueno” a una potencia. Dentro de una VM, hay dos estrategias principales para GPU: passthrough total del dispositivo y compartición de GPU virtual (vGPU). El passthrough dedica una GPU/iGPU completa de NVIDIA, AMD o Intel a la VM — ideal para transcoding NVENC/VCN/QSV consistente y cercano a bare-metal. La vGPU comparte un dispositivo entre múltiples VMs, ofreciendo más densidad a costa de cierta complejidad y a veces restricciones de características de códec.

Con KVM/QEMU (y por ende Proxmox), el passthrough VFIO es la solución principal: entrega la GPU directamente al invitado. En VMware, tanto DirectPath I/O como las pilas vGPU del proveedor están maduras. Citrix tiene amplia experiencia con vGPU para VDI, que también aplica para streaming. Hyper-V soporta Discrete Device Assignment (DDA) y particionamiento de GPU (GPU-P); Windows Server 2025 mejoró la virtualización de GPU para computo y gráficos, alineando aún más la aceleración de VMs con resultados bare-metal.

El soporte de códecs es el verdadero diferenciador. Jellyfin/Plex buscan NVENC, AMD VCE/VCN o Intel Quick Sync. El passthrough PCIe preserva estos codificadores al 100%. La vGPU puede ser más restrictiva dependiendo de licencias y perfiles. En un iGPU Intel, el passthrough QSV dentro de Proxmox ofrece a hogares una ruta económica para múltiples streams 4K SDR, mientras que una tarjeta NVIDIA de gama media permite decodificaciones simultáneas HEVC y codificaciones H.264 con margen para tone-mapping. Para densidad tipo nube, vGPU divide recursos entre, por ejemplo, una VM multimedia y una VM ligera de inferencia AI, semejante a cómo un caso de estudio de cloud gaming como ARC Raiders balancea fragmentos de tiempo de GPU para streaming de baja latencia.

- 🚀 Passthrough (VFIO/DDA/DirectPath): casi bare metal; ideal para múltiples transcodificaciones 4K.

- 🧩 vGPU: densidad y flexibilidad; verificar limitaciones de códec/perfil y licenciamiento.

- 🔌 Higiene de controladores: alinea versiones host, invitado e hipervisor para evitar reinicios.

- 🧊 Térmicos: entornos virtualizados siguen calentando GPUs; mantener flujo de aire para evitar throttling.

- 🛠️ Soporte API: verificar visibilidad de NVENC/QSV/VCN dentro del invitado antes de probar cargas.

| Método | Hipervisores 🧱 | Soporte códec 🎥 | Rendimiento ⚡ | Caso de uso |

|---|---|---|---|---|

| Passthrough PCIe | Proxmox/KVM, VMware, Hyper-V (DDA), Citrix | Completo NVENC/QSV/VCN | Cercano a bare metal | Transcoding pesado Plex/Jellyfin |

| Compartición vGPU | VMware, Citrix, Windows GPU-P | Dependiente de perfil | Alto pero no máximo | Medios mixtos + inferencia AI/VDI |

| Fallback por software | Todas las plataformas | Solo CPU | Más bajo rendimiento | Pruebas y emergencias |

Elegir entre NVIDIA, AMD e Intel depende de códecs y objetivos energéticos. Intel Quick Sync destaca para hogares con bajo consumo. NVIDIA ofrece NVENC maduro y herramientas robustas; VCN de AMD ha mejorado constantemente en generaciones recientes. Para un contexto tecnológico más amplio, la multiplexación de GPUs para medios refleja cómo se orquestan experiencias AI multimodelo, similar a debates en una comparación entre Microsoft Copilot y ChatGPT y benchmarks ChatGPT vs Gemini 2025 — las decisiones del programador finalmente determinan la velocidad percibida por el usuario.

Almacenamiento y red I/O bajo virtualización: escaneos, DVR y streams 4K

Las cargas multimedia son bimodales: ráfagas cortas durante escaneos de bibliotecas y lecturas secuenciales sostenidas durante reproducción. La virtualización expone almacenamiento a través de discos virtuales (VHDX, qcow2), mapeo directo de dispositivos o comparticiones de red. Para escaneos pesados, virtio-scsi respaldado en NVMe o adaptadores NVMe virtuales reducen la sobrecarga de emulación; cuando las funciones DVR escriben múltiples streams simultáneos, QoS de almacenamiento previene que una sola VM sature el grupo de discos. Storage QoS de Hyper-V y la limitación de I/O de Proxmox proporcionan protecciones útiles.

Las elecciones del sistema de archivos importan. Los pools ZFS en Proxmox ofrecen fuerte caché de lectura para miniaturas y metadatos, pero requieren memoria para rendir. NTFS en SSD rápido es suficiente para bibliotecas pequeñas, mientras que XFS/ext4 dentro de invitados Linux ofrece latencia predecible. Evitar anidar capas excesivas (p.ej., compartición de red dentro de una VM cuyo disco virtual reside en otra compartición de red) que complica la latencia. Una cadena simple, como NVMe host → disco virtio → sistema de archivos invitado mantiene la latencia lineal y fácil de entender.

En la red, los streams 4K HEVC rondan decenas de Mbps; un enlace 2.5 GbE maneja muchos usuarios concurrentes. Los switches virtuales añaden sobrecarga insignificante cuando se usan offloads (TSO/LRO), RSS y NICs paravirtuales (VMXNET3, virtio-net, NIC sintético Hyper-V). Aun así, hay que monitorear coalescencia de paquetes y moderación de interrupciones para estabilizar jitter en noches pico. Si el servidor multimedia también graba OTA o cámaras IP, aislar ese tráfico con VLANs evita choques entre ingest irruptivo y reproducción.

- 📦 Preferir virtio/VMXNET3 sobre NICs emuladas; habilitar checksum y segmentación offloads.

- 💾 Usar NVMe o SSD para appdata y metadatos; colocar medios grandes en discos separados.

- 📊 Aplicar Storage QoS para prevenir picos de DVR que afecten los hilos de reproducción.

- 🧯 Evitar doble virtualización en rutas de almacenamiento para mantener latencia predecible.

- 🛰️ Segmentar tráfico con VLANs para ingest vs. reproducción; considerar jumbo frames tras pruebas.

| Tarea | Cuello de botella principal 🔍 | Consejo de virtualización 🧰 | Resultado esperado 📈 |

|---|---|---|---|

| Escaneo de biblioteca | E/S aleatoria | NVMe + virtio-scsi, aumentar profundidad I/O | Construcción de metadatos más rápida |

| Transcoding 4K HDR | GPU/CPU | Passthrough PCIe, fijar vCPUs | FPS cerca de bare-metal |

| Grabación DVR | IOPS de escritura | Storage QoS + disco separado | Sin interrupciones de reproducción bajo carga |

| Streaming remoto | Ancho de banda | NIC paravirtual + offloads | Bitrates estables por usuario |

Las decisiones arquitectónicas reflejan técnicas usadas en pipelines con simulaciones pesadas, donde mundos virtuales estresan E/S y ancho de banda. Para una visión más amplia sobre cómo cargas sintéticas moldean el diseño del sistema, vea esta perspectiva sobre entornos sintéticos para IA física.

Conclusión: optimizar primero las rutas de almacenamiento y la red paravirtual; las optimizaciones de transcoding cobran vida solo cuando la E/S y la entrega son constantes.

Chequeo de realidad entre plataformas: Hyper-V, Proxmox/KVM, VMware, Citrix y VirtualBox

Diversos hipervisores ofrecen diferentes ergonomías para servidores multimedia. Hyper-V se integra limpiamente con Windows, con baja sobrecarga, vNUMA y DDA para acceso GPU, más Storage QoS. Proxmox agrega una UI accesible sobre KVM/QEMU, con passthrough VFIO, ZFS y dispositivos virtio excelentes—popular en laboratorios domésticos por una razón. VMware vSphere provee gestión de primera clase y pilas vGPU para configuraciones densas, mientras que Citrix sobresale donde VDI y compartición multimedia se cruzan. VirtualBox sigue siendo una herramienta excelente para desarrolladores pero carece del enfoque de rendimiento necesario para transcodificaciones 4K en vivo múltiples.

¿A qué se parecen los resultados medidos? En laboratorios 2024–2025, entornos cuidadosamente configurados reportan que una VM Plex o Jellyfin con passthrough tiene un déficit ~0–5% respecto a bare metal para transcoding acelerado por GPU. La variabilidad viene de configuraciones BIOS, comportamiento IOMMU/ACS y madurez de controladores. Para operaciones intensivas de disco, mover appdata a NVMe y habilitar controladores paravirtuales suele reducir a la mitad los tiempos de escaneo respecto a la emulación por defecto. No son trucos exóticos; son básicos para VMs de calidad producción.

El ángulo de gestión también importa. Los hipervisores difieren en valores predeterminados de temporizadores, interrupciones y estados de potencia en reposo. Microsoft recomienda minimizar la actividad en segundo plano del invitado y eliminar dispositivos emulados no usados, consejos válidos también para KVM y VMware. La exposición NUMA debe estar habilitada en VMs grandes en general — Virtual NUMA de Hyper-V, flags de topología de KVM y el planificador NUMA de VMware existen para mantener la memoria cerca del cómputo.

- 🧭 Hyper-V: DDA/GPU-P, vNUMA, Storage QoS, baja sobrecarga para invitados Windows.

- 🧱 Proxmox (KVM/QEMU): passthrough VFIO, controladores virtio, caché ZFS, mapeo GPU sencillo.

- 🏢 VMware: pilas vGPU paravirtual maduras (PVSCI, VMXNET3), profundo monitoreo.

- 🏛️ Citrix: perfiles vGPU robustos y control de políticas para cargas mixtas.

- 🧪 VirtualBox: excelente para pruebas; no recomendado para grandes cargas 4K.

| Plataforma | Capacidad GPU 🎮 | Ruta de disco 🔗 | Adaptador de red 🌐 | Mejor ajuste |

|---|---|---|---|---|

| Hyper-V | DDA / GPU-P | VHDX en NVMe; disco passthrough | NIC sintético | Servidores multimedia centrados en Windows |

| Proxmox | Passthrough VFIO | ZFS o LVM en NVMe | virtio-net | Laboratorios domésticos y configuraciones prosumer |

| VMware | vGPU/DirectPath | vSAN/NVMe, PVSCI | VMXNET3 | Streaming multimedia empresarial |

| Citrix | Perfiles vGPU | SR-IOV/NVMe | Paravirtual | Cargas mixtas VDI + medios |

| VirtualBox | Limitado | VDI basado en archivos | Emulado/virtio | Uso ligero y pruebas |

La elección entre plataformas refleja comparaciones tecnológicas más amplias: compensaciones en prestaciones, costo y ecosistema similares a comparaciones de modelos o asistentes en el mundo de AI. Para una lectura lateral relevante sobre cómo las diferencias de capacidad afectan resultados, explore benchmarks ChatGPT vs Gemini.

Principio guía: la elección de plataforma debe seguir la calidad del modelo de dispositivo, opciones de GPU y claridad de la ruta de almacenamiento. El resto es configuración.

Manual operativo: cuándo virtualizar un servidor multimedia y cuándo mantenerse en bare metal

La virtualización permite consolidación, snapshots y recuperación rápida. El bare metal maximiza la determinismo y simplicidad. La decisión depende de la forma de la carga, hardware y objetivos de mantenimiento. Un servidor doméstico con un iGPU Intel y unos pocos usuarios se beneficia de una VM Proxmox o Hyper-V con passthrough Quick Sync. Una operación boutique de streaming que maneja docenas de transcodificaciones 4K HDR concurrentes puede preferir hardware dedicado—o una VM con GPU NVIDIA completa y CPUs fijadas, donde las diferencias con bare metal se vuelven insignificantes tras la optimización.

La disciplina en mantenimiento paga dividendos. Mantenga el firmware (IOMMU/BIOS), controladores GPU y paravirtualizados alineados entre host e invitado. Pruebe con un conjunto pequeño de títulos representativos—HEVC HDR10, H.264 de alto bitrate y fuentes entrelazadas—para asegurar que las características del codificador sean visibles y estables dentro de la VM. Documente qué ajustes marcaron la diferencia (profundidad de cola, planificadores I/O, RSS) para que los cambios no se pierdan durante actualizaciones.

- 🧪 Evaluar carga: picos de streams concurrentes, mezcla de códecs, tamaño de biblioteca.

- 🧷 Elegir camino: bare metal para simplicidad; VM para flexibilidad y consolidación.

- 🔐 Estrategia GPU: passthrough para acceso máximo a códecs/características; vGPU para densidad.

- 📈 Medir: seguir % CPU ready, latencia disco y fps por stream en estrés.

- 🧭 Iterar: ajustar vNUMA, fijación y QoS; re-testear y documentar.

| Escenario | Recomendación 🧭 | Por qué funciona 🎯 | Mitigación de riesgo 🛡️ |

|---|---|---|---|

| Hogar pequeño, iGPU Intel | VM con passthrough QSV | Bajo consumo, buen soporte de códecs | Fijar vCPUs; habilitar vNUMA si >8 vCPUs |

| Prosumer, GPU dedicada NVIDIA | VM con passthrough PCIe | NVENC cercano a bare metal | Bloqueo versión controlador; cuidar térmicos |

| Streaming empresarial | VMware/Citrix vGPU | Densidad + gestión | Pruebas de perfil; QoS en almacenamiento |

| Concurrencia extrema 4K HDR | Bare metal o VM dedicada | Determinismo máximo | Redes separadas para ingest y reproducción |

Para lectores interesados en cómo debates de orquestación y planificación se reflejan en dominios adyacentes, este panorama de una comparación entre Microsoft Copilot y ChatGPT muestra cómo la capacidad y los patrones de carga guían la elección de plataforma. Similarmente, las perspectivas conceptuales de diseño de sistemas desde entornos sintéticos para IA física pueden agudizar el pensamiento sobre aislamiento de recursos. Los mismos modelos mentales usados para streams complejos de AI o gaming escalan eficazmente a un rack doméstico.

Regla final: virtualizar cuando la flexibilidad, copias de seguridad y consolidación importen; considerar bare metal cuando la consistencia absoluta bajo carga extrema sea innegociable.

{“@context”:”https://schema.org”,”@type”:”FAQPage”,”mainEntity”:[{“@type”:”Question”,”name”:”¿Cuánto rendimiento se pierde típicamente al ejecutar un servidor multimedia en una VM?”,”acceptedAnswer”:{“@type”:”Answer”,”text”:”Con hipervisores modernos y controladores paravirtuales, muchas configuraciones presentan una sobrecarga de CPU de un solo dígito bajo para transcodificaciones aceleradas por GPU. Las tareas pesadas de almacenamiento como escaneos grandes de biblioteca sufren más si los discos virtuales están en medios lentos. Ajustar virtio/VMXNET3, NVMe y vNUMA mantiene resultados cercanos a bare metal.”}},{“@type”:”Question”,”name”:”¿Es necesario el passthrough de GPU para Plex/Jellyfin en una VM?”,”acceptedAnswer”:{“@type”:”Answer”,”text”:”Para múltiples streams 4K o tone-mapping HDR, sí — el passthrough PCIe de una GPU/iGPU NVIDIA, AMD o Intel preserva características del codificador y entrega fps cercanos a bare metal. Para trabajo ligero y bajo demanda en 1080p, puede bastar el transcoding por CPU, aunque aumentan consumo y térmicos.”}},{“@type”:”Question”,”name”:”¿Cuál es el mejor hipervisor para un servidor multimedia doméstico?”,”acceptedAnswer”:{“@type”:”Answer”,”text”:”Proxmox (KVM/QEMU) y Hyper-V son populares en hogares y estudios pequeños gracias a su passthrough GPU sencillo y controladores virtio/enlightened. VMware y Citrix aportan pilas vGPU más robustas y gestión para despliegues mayores. VirtualBox es mejor para pruebas que para cargas pesadas 4K.”}},{“@type”:”Question”,”name”:”¿Realmente importan NUMA y fijación de CPU para streaming?”,”acceptedAnswer”:{“@type”:”Answer”,”text”:”Sí. El transcoding estresa cachés y memoria. Exponer vNUMA y fijar vCPUs reduce tráfico de memoria entre nodos y ruido del planificador, estabilizando fps por stream. El impacto crece con más transcodificaciones concurrentes y VMs grandes.”}},{“@type”:”Question”,”name”:”¿Qué métricas de monitoreo revelan cuellos de botella inducidos por VM?”,”acceptedAnswer”:{“@type”:”Answer”,”text”:”Monitorear tiempo ready de CPU, latencia disco durante escaneos y fps por transcoding. Vigilar contadores offload de NIC y pacing de paquetes para detectar jitter. Estos KPIs identifican si el límite es planificación, almacenamiento o red.”}}]}¿Cuánto rendimiento se pierde típicamente al ejecutar un servidor multimedia en una VM?

Con hipervisores modernos y controladores paravirtuales, muchas configuraciones presentan una sobrecarga de CPU de un solo dígito bajo para transcodificaciones aceleradas por GPU. Las tareas pesadas de almacenamiento como escaneos grandes de biblioteca sufren más si los discos virtuales están en medios lentos. Ajustar virtio/VMXNET3, NVMe y vNUMA mantiene resultados cercanos a bare metal.

¿Es necesario el passthrough de GPU para Plex/Jellyfin en una VM?

Para múltiples streams 4K o tone-mapping HDR, sí—el passthrough PCIe de una GPU/iGPU NVIDIA, AMD o Intel preserva características del codificador y entrega fps cercanos a bare metal. Para trabajo ligero y bajo demanda en 1080p, puede bastar el transcoding por CPU, aunque aumentan consumo y térmicos.

¿Cuál es el mejor hipervisor para un servidor multimedia doméstico?

Proxmox (KVM/QEMU) y Hyper-V son populares en hogares y estudios pequeños gracias a su passthrough GPU sencillo y controladores virtio/enlightened. VMware y Citrix aportan pilas vGPU más robustas y gestión para despliegues mayores. VirtualBox es mejor para pruebas que para cargas pesadas 4K.

¿Realmente importan NUMA y fijación de CPU para streaming?

Sí. El transcoding estresa cachés y memoria. Exponer vNUMA y fijar vCPUs reduce tráfico de memoria entre nodos y ruido del planificador, estabilizando fps por stream. El impacto crece con más transcodificaciones concurrentes y VMs grandes.

¿Qué métricas de monitoreo revelan cuellos de botella inducidos por VM?

Monitorear tiempo ready de CPU, latencia disco durante escaneos y fps por transcoding. Vigilar contadores offload de NIC y pacing de paquetes para detectar jitter. Estos KPIs identifican si el límite es planificación, almacenamiento o red.

No responses yet