VM-overhead vs. bare metal: kan het draaien van een virtuele machine een mediaserver vertragen?

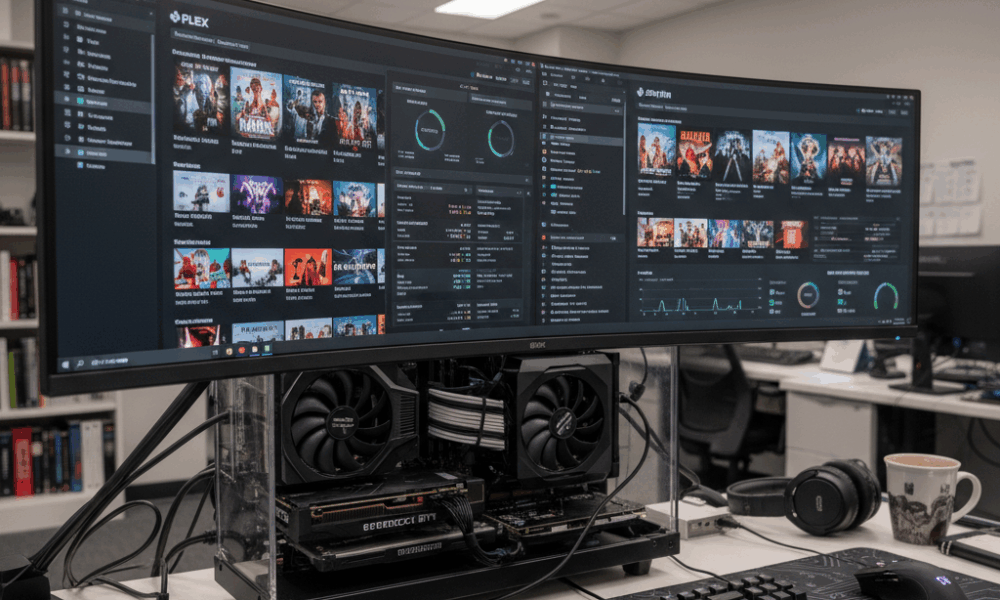

De prestaties van een mediaserver worden bepaald door drie krachten: computing voor transcoding, opslagbandbreedte voor bibliotheekbewerkingen en netwerklevering. Virtualisatie plaatst een hypervisor tussen het besturingssysteem en de hardware, dus de vraag is of die extra laag het evenwicht verandert. Met moderne platforms zoals Hyper-V, Proxmox (met KVM/QEMU), VMware vSphere en Citrix Hypervisor, is de basis hypervisorkost meestal bescheiden wanneer goed afgestemd. Zo zijn Hyper-V’s scheduler en integratiediensten ontworpen om een klein deel van de CPU te gebruiken, vaak rond een laag eencijferig percentage voor administratie, waardoor de meeste cycles beschikbaar blijven voor workloads. Mediaservers veranderen echter de bottleneck afhankelijk van de workload: live 4K-transcodes belasten de CPU/GPU, terwijl grote Plex/Jellyfin bibliotheekscans de schijf-I/O zwaar gebruiken.

Denk aan Beacon Media, een klein post-productieteam dat een Plex-server en een Windows utility VM op één host consolideerde. Op bare metal handhaafde een 4K HEVC naar 1080p H.264 transcode 120 fps met NVIDIA NVENC. In een VM met GPU passthrough lag de doorvoer binnen 2–5% van bare metal na het tunen van drivers. De grotere impact deed zich voor tijdens gelijktijdige metadata-verversingen, waarbij de virtuele diskqueue van de VM verdiepte, wat latentie toevoegde en de CPU ready time verhoogde. De conclusie is simpel: virtualisatie vermindert zelden de transcoding-prestaties wanneer GPU passthrough correct wordt gebruikt, maar opslag en scheduling kunnen nieuwe knelpunten worden als ze niet goed zijn afgestemd.

Verschillende hypervisors en apparaatmodellen doen ertoe. Geëmuleerde apparaten zijn traag voor media taken met hoge doorvoer, terwijl paravirtual- of “verlichte” drivers—zoals virtio op KVM/QEMU en integratiediensten op Hyper-V—de overhead aanzienlijk verminderen. Op Windows-gasten verlaagt het verwijderen van geëmuleerde adapters en ongebruikte apparaten, en het installeren van de nieuwste integratiecomponenten, de achtergrond-CPU-belasting. Dat draagt bij aan soepeler mediaserveren tijdens piekuren.

Belangrijke vragen begeleiden de beslissing: transcoded de server vaak meerdere 4K-streams? Is GPU-versnelling nodig? Is de mediatheek enorm, wat intense scanbewerkingen veroorzaakt? Als het antwoord op een van deze vragen ja is, moet de VM worden ontworpen als een productie-workload, niet als een sandbox voor gemak. Dat omvat vaste CPU-resources, snelle NVMe-opslag en paravirtual-netwerken. Met die voorzieningen melden veel thuislabs en kleine studio’s een bijna gelijke prestatie als bare metal voor de dagelijkse streaming.

- 🎯 Basislijn: Verwacht lage eencijferige CPU-overhead voor een moderne hypervisor die goed is geconfigureerd.

- 🧠 Apparaatmodel: Geef de voorkeur aan virtio (KVM/QEMU) of verlichte drivers (Hyper-V) boven geëmuleerde hardware.

- ⚙️ Werkloadvorm: GPU-versnelde transcodes binnen VM’s kunnen dicht bij bare metal presteren met de juiste passthrough.

- 📚 Bibliotheekscans: Opslaglatentie in VM’s kan scans bottlenecken; gebruik NVMe en tune queue depth.

- 🌐 Netwerk: Virtuele switches voegen minimale overhead toe als offloads en RSS zijn ingeschakeld.

| Hypervisor | Transcode overhead (GPU) ⚡ | Schijftaken intensief 📀 | Netwerk impact 🌐 | Opmerkingen |

|---|---|---|---|---|

| Hyper-V | ~2–5% met DDA/GPU-P | Matig bij gebruik van VHDX op trage schijven | Laag met vSwitch offloads | Installeer integratiediensten; vermijd geëmuleerde NIC’s |

| Proxmox (KVM/QEMU) | ~0–5% met VFIO passthrough | Laag–Matig met virtio-scsi/NVMe | Laag met virtio-net | Gebruik hugepages, pin vCPU’s voor consistentie |

| VMware vSphere | ~0–5% met vGPU/passthrough | Laag met paravirtual SCSI | Laag met VMXNET3 | Uitstekend gereedschap voor performancemonitoring |

| Citrix Hypervisor | ~0–6% met vGPU | Laag–Matig | Laag | Sterke vGPU-stack in enterprise-omgevingen |

| VirtualBox | Hoger, beperkte GPU-ondersteuning | Matig–Hoog voor zware I/O | Matig | Geschikt voor testen; minder geschikt voor 4K-streaming op schaal |

De praktische conclusie: ja, een VM kan de performance van een mediaserver beïnvloeden, maar met de juiste stack en drivers is het effect klein en voorspelbaar—vooral als GPU-versnelling en snelle opslag zijn ingezet.

CPU, geheugen en NUMA-tuning voor mediatranscoding binnen VM’s

Transcoding belast CPU-caches, geheugenbandbreedte en scheduling. Op hosts met Intel of AMD CPU’s kan simultaan multithreading (SMT) de doorvoer verhogen, maar alleen als vCPU-topologie en threadscheduling op één lijn liggen met de hypervisor. Gebruik even aantal vCPU’s waar SMT aan staat en vermijd overprovisioning als consistente latentie het doel is. Voor Hyper-V moeten virtuele processors het piekverbruik weerspiegelen, niet het gemiddelde; als CPU ready tijden toenemen, stotteren transcodes.

Geheugentoewijzing werkt samen met NUMA. Een VM met 24 threads en 32–64 GB RAM kan fysieke NUMA-kernen overspannen. Als vNUMA is uitgeschakeld of verstoord wordt door dynamisch geheugen, kan een transcoding-pijplijn tussen kernen schakelen, met prestatieverlies door remote memory. Hyper-V stelt Virtual NUMA standaard in bij grote VM’s; laat het aan voor NUMA-bewuste apps en vermijd dynamisch geheugen als constante doorvoer telt. Bij KVM/QEMU stem numactl of VM-pinning af op host-topologie voor lokaal geheugen en vCPU’s.

Achtergrond-CPU-belasting werkt stilletjes tegen. Inactieve gasten die updatescanners, defragmentatie of zoekindexering uitvoeren stelen cycles op het slechtste moment. Microsofts richtlijnen blijven geldig in 2025: verwijder geëmuleerde NIC’s, schakel onnodige geplande taken uit, houd inlogscreens zichtbaar bij inactiviteit, en sluit beheerdersconsoles die VM’s constant bevragen. Deze stappen verminderen interrupt druks en stabiliseren transcoding-latentie.

- 🧩 Pin vCPU’s aan fysieke cores/threads voor consistente fps in piekuren.

- 🧮 Respecteer vNUMA: houd geheugen lokaal; vermijd dynamisch geheugen voor zware transcodes.

- 🛡️ Integratiediensten: installeer nieuwste verbeteringen om I/O CPU-overhead te verminderen.

- 🧹 Minimaliseer achtergrondtaken: schakel SuperFetch/Search uit in client-VM’s; verwijder ongebruikte apparaten.

- ⏱️ Monitor KPI’s: CPU-gebruik, wachtrijen/ready tijd en context-switches per seconde.

| Instelling | Waarom belangrijk 🧠 | Mediaprestatie 🎬 | Aanbevolen actie ✅ |

|---|---|---|---|

| vCPU-aantal & pinning | Vermindert schedulingvertragingen | Gladde fps tijdens multi-stream transcodes | Even aantal vCPU’s met SMT; pin actieve VM’s |

| vNUMA-exposure | Behoudt localiteit | Hogere blijvende bitrate onder belasting | Activeer vNUMA; vermijd dynamisch geheugen voor grote VM’s |

| Verlichte I/O-drivers | Minder emulatietraps | Snellere scans en DVR-schrijfsnelheden | Gebruik virtio/VMXNET3/Hyper-V specifieke adapters |

| Achtergrondlawaai | Bevrijdt CPU-cycles | Minder stotteren bij burst-activiteit | Schakel onnodige services en geplande taken uit |

Schedulers verschillen niet zoveel van grote AI-trainingsplanners. Bronnenconcurrentie en plaatsing vertonen gelijkenissen met AI-orchestratie, zoals besproken in wat te verwachten van GPT-5’s trainingsfase in 2025 waar rekenkracht, geheugen en I/O-alignment doorvoer bepalen. Dezelfde principes gelden op kleinere schaal bij huishoudelijke mediaservers.

Praktische regel: behandel de media VM als een productie-workload, niet als een bijzaak, en CPU-/geheugeninstellingen stoppen met het vormen van bottlenecks.

GPU-versnelling in een VM: passthrough, vGPU-deling en echte Plex/Jellyfin-resultaten

Hardwareversnelling verandert een mediaserver van “goed genoeg” in een krachtpatser. Binnen een VM zijn er twee hoofd-GPU strategieën: full-device passthrough en virtuele GPU (vGPU)-deling. Passthrough wijst een volledige NVIDIA, AMD of Intel GPU/iGPU toe aan de VM, het beste voor consistente, bijna bare-metal NVENC/VCN/QSV transcoding. vGPU deelt een apparaat tussen meerdere VM’s, voor meer dichtheid ten koste van complexiteit en soms beperkingen in codec-functionaliteit.

Met KVM/QEMU (en dus Proxmox) is VFIO passthrough het werkpaard: het geeft de GPU direct aan de gast. In VMware zijn zowel DirectPath I/O als leveranciers vGPU-stacks volwassen. Citrix heeft veel ervaring met vGPU voor VDI, wat ook geldt voor streaming. Hyper-V ondersteunt Discrete Device Assignment (DDA) en GPU-partitionering (GPU-P); Windows Server 2025 verbeterde GPU-virtualisatie voor compute en graphics, waardoor VM-versnelling dichter bij bare metal komt.

Codec-ondersteuning is de echte onderscheidende factor. Jellyfin/Plex willen NVENC, AMD VCE/VCN of Intel Quick Sync. PCIe-passthrough behoudt deze encoders volledig. vGPU kan beperkter zijn afhankelijk van licenties en profielen. Op een Intel iGPU biedt QSV-passthrough binnen Proxmox huishoudens een kosteneffectieve route naar meerdere 4K SDR-streams, terwijl een enkele midrange NVIDIA-kaart gelijktijdige HEVC-decodes en H.264-encodes mogelijk maakt met ruimte voor tone-mapping. Voor cloudachtige dichtheid splitst vGPU bronnen tussen bijvoorbeeld een media VM en een lichte AI-inference VM, vergelijkbaar met hoe een cloud gaming case study zoals ARC Raiders GPU-tijdslices verdeelt voor low-latency streaming.

- 🚀 Passthrough (VFIO/DDA/DirectPath): bijna bare metal; ideaal voor meerdere 4K-transcodes.

- 🧩 vGPU: dichtheid en flexibiliteit; controleer codec-/profielbeperkingen en licenties.

- 🔌 Driverhygiëne: stem host-, gast- en hypervisor-drivers op elkaar af om resets te voorkomen.

- 🧊 Thermiek: gevirtualiseerde omgevingen verwarmen GPU’s nog steeds; zorg voor voldoende koeling om throttling te vermijden.

- 🛠️ API-ondersteuning: zorg dat NVENC/QSV/VCN zichtbaar zijn binnen de gast vóór het testen van workloads.

| Methode | Hypervisors 🧱 | Codec-ondersteuning 🎥 | Prestaties ⚡ | Gebruiksscenario |

|---|---|---|---|---|

| PCIe passthrough | Proxmox/KVM, VMware, Hyper-V (DDA), Citrix | Volledige NVENC/QSV/VCN | Bijna bare metal | Zware Plex/Jellyfin transcoding |

| vGPU-deling | VMware, Citrix, Windows GPU-P | Profiel-afhankelijk | Hoog maar niet maximaal | Gemengde media + VDI/AI inference |

| Software fallback | Alle platforms | Alleen CPU | Laagste doorvoer | Testen en noodgevallen |

De keuze tussen NVIDIA, AMD en Intel hangt af van codecs en energiedoelen. Intel Quick Sync blinkt uit voor energiezuinige huishoudens. NVIDIA biedt volwassen NVENC en robuuste tooling; AMD’s VCN is de afgelopen generaties gestaag verbeterd. Voor bredere technische context weerspiegelt de wijze waarop GPU’s worden gedeeld voor media hoe multi-model AI-ervaringen worden georganiseerd, net als discussies in een vergelijkende blik op Microsoft Copilot vs ChatGPT en ChatGPT vs Gemini benchmarks—de beslissingen van de scheduler bepalen uiteindelijk de waargenomen snelheid voor de gebruiker.

Opslag en netwerk-I/O onder virtualisatie: scans, DVR en 4K-streams

Media workloads zijn bimodaal: korte pieken tijdens bibliotheekscans en langdurige sequentiële reads tijdens playback. Virtualisatie biedt opslag via virtuele schijven (VHDX, qcow2), directe apparaatmapping of netwerkshares. Voor zware scans vermindert NVMe-ondersteunde virtio-scsi of virtuele NVMe-adapters emulatieoverhead; bij DVR-functies die meerdere gelijktijdige streams schrijven voorkomt opslag QoS dat één VM de schijfgroep verzadigt. Hyper-V’s Storage QoS en Proxmox’s I/O-beperking bieden nuttige richtlijnen.

Bestandssysteemkeuzes zijn belangrijk. ZFS-pools in Proxmox leveren sterke read caching voor thumbnails en metadata, maar hebben geheugen nodig om te schitteren. NTFS op een snelle SSD is voldoende voor kleinere bibliotheken, terwijl XFS/ext4 binnen Linux-gasten voorspelbare latentie geeft. Vermijd stapeling van te veel lagen (bijv. netwerkshare binnen een VM waarvan de virtuele schijf op een andere netwerkshare staat), dit verhoogt de latentie. Een simpelere keten zoals host NVMe → virtio disk → gast-bestandssysteem houdt latentie lineair en beheersbaar.

Netwerk aan de andere kant: 4K HEVC streams zitten rond tientallen Mbps; een enkele 2,5 GbE-link kan veel gelijktijdige gebruikers aan. Virtuele switches voegen verwaarloosbare overhead toe als offloads (TSO/LRO), RSS en paravirtual NICs (VMXNET3, virtio-net, Hyper-V synthetic NIC) actief zijn. Houd wel pakketcoalescentie en interrupt-moderatie in de gaten voor stabiele jitter tijdens piekavonden. Als de mediaserver ook OTA of IP-camera’s opneemt, isoleer dat verkeer met VLANs om te voorkomen dat piek-ingest bots met playback.

- 📦 Geef voorkeur aan virtio/VMXNET3 boven geëmuleerde NIC’s; schakel checksum- en segmentatie-offloads in.

- 💾 Gebruik NVMe of SSD voor appdata en metadata; bewaar grote media op aparte schijven.

- 📊 Pas Storage QoS toe om te voorkomen dat DVR-pieken playback verstoren.

- 🧯 Vermijd dubbele virtualisatie van opslagpaden om latentie voorspelbaar te houden.

- 🛰️ Segment verkeer met VLANs voor ingest vs. playback; overweeg jumbo frames na testen.

| Taak | Belangrijkste bottleneck 🔍 | Virtualisatietip 🧰 | Verwacht resultaat 📈 |

|---|---|---|---|

| Bibliotheekscan | Willekeurige I/O | NVMe + virtio-scsi, verhoog IO-diepte | Snellere metadataopbouw |

| 4K HDR transcode | GPU/CPU | PCIe passthrough, pin vCPU’s | Bijna bare-metal fps |

| DVR-opname | Schrijfsnelheid IOPS | Storage QoS + aparte schijf | Geen playback-stotteren onder belasting |

| Extern streamen | Bandbreedte | Paravirtual NIC + offloads | Stabiele bitrates per gebruiker |

De architectuurkeuzes weerspiegelen technieken uit simulatie-intensieve pipelines, waar virtuele werelden I/O en bandbreedte belasten. Voor een breder perspectief op hoe synthetische workloads systeemontwerp beïnvloeden, zie deze blik op synthetische omgevingen voor fysieke AI.

Samengevat: optimaliseer eerst opslagpaden en paravirtual networking; transcodingoptimalisaties komen pas tot leven als I/O en levering stabiel zijn.

Realiteitscheck over platforms: Hyper-V, Proxmox/KVM, VMware, Citrix en VirtualBox

Verschillende hypervisors bieden verschillende ergonomie voor mediaservers. Hyper-V integreert soepel met Windows, met lage overhead, vNUMA en DDA voor GPU-toegang, plus Storage QoS. Proxmox legt een toegankelijke UI over KVM/QEMU, met VFIO passthrough, ZFS en uitstekende virtio-apparaten—populair in thuislabs om een reden. VMware vSphere biedt topklasse management en vGPU-stacks voor grote setups, terwijl Citrix uitblinkt waar VDI en mediadeling samenkomen. VirtualBox blijft een uitstekende ontwikkelaarstool maar mist de performance focus voor multi-4K live transcodes.

Wat zeggen gemeten resultaten? Over labs in 2024–2025 rapporteren zorgvuldig geconfigureerde omgevingen dat een Plex- of Jellyfin-VM met passthrough een ~0–5% kloof met bare metal laat zien voor GPU-versnelde transcoding. Variatie komt door BIOS-instellingen, IOMMU/ACS-gedrag en de volwassenheid van drivers. Voor schijfintensieve bewerkingen halveert het verplaatsen van appdata naar NVMe en het inschakelen van paravirtual disk drivers meestal de scantijden vergeleken met standaardemulatie. Dit zijn geen exotische trucs; het zijn standaardvereisten voor productie-VM’s.

Ook het beheer telt mee. Hypervisors verschillen in standaarden voor timers, interrupts en idle power states. Microsoft adviseert om achtergrondactiviteit van gasten te minimaliseren en ongebruikte geëmuleerde apparaten te verwijderen. Dit advies geldt evenzeer voor KVM en VMware. NUMA-exposure moet bij grote VM’s altijd aanstaan—Hyper-V’s Virtual NUMA, KVM’s topology flags en VMware’s NUMA scheduler bestaan allemaal om geheugen dicht bij compute te houden.

- 🧭 Hyper-V: DDA/GPU-P, vNUMA, Storage QoS, lage overhead voor Windows-gasten.

- 🧱 Proxmox (KVM/QEMU): VFIO passthrough, virtio drivers, ZFS caching, eenvoudige GPU-mapping.

- 🏢 VMware: volwassen vGPU en paravirtual stacks (PVSCI, VMXNET3), diepe observability.

- 🏛️ Citrix: sterke vGPU-profielen en beleidscontrole voor gemengde workloads.

- 🧪 VirtualBox: ideaal voor testen; niet aanbevolen voor zware 4K workloads.

| Platform | GPU-capaciteit 🎮 | Schijfpad 🔗 | Netwerkadapter 🌐 | Beste toepassing |

|---|---|---|---|---|

| Hyper-V | DDA / GPU-P | VHDX op NVMe; pass-through disk | Synthetische NIC | Windows-centrische mediaservers |

| Proxmox | VFIO passthrough | ZFS of LVM op NVMe | virtio-net | Thuislab en prosumer configuraties |

| VMware | vGPU/DirectPath | vSAN/NVMe, PVSCI | VMXNET3 | Enterprise media streaming |

| Citrix | vGPU-profielen | SR-IOV/NVMe | Paravirtual | Gemengde VDI + media workloads |

| VirtualBox | Beperkt | File-backed VDI | Geëmuleerd/virtio | Light gebruik en testen |

De keuze tussen platforms weerspiegelt bredere technologische vergelijkingen—afwegingen in features, kosten en ecosysteem lijken op die in model- of assistentvergelijkingen in de AI-wereld. Voor een relevante zijlezing over hoe capaciteitsverschillen uitpakken, lees ChatGPT vs Gemini benchmarks.

Gidsprincipe: de platformkeuze volgt op apparaatmodelkwaliteit, GPU-opties en duidelijkheid van opslagpaden. De rest is configuratie.

Operationele handleiding: wanneer virtualiseer je een mediaserver en wanneer blijf je op bare metal

Virtualisatie maakt consolidatie, snapshots en snelle herstelmogelijkheden mogelijk. Bare metal maximaliseert stabiliteit en eenvoud. De beslissing hangt af van workloadvorm, hardware en onderhoudsdoelen. Een thuisserver met een Intel iGPU en een handvol gebruikers profiteert van een Proxmox- of Hyper-V VM met Quick Sync passthrough. Een boutique-streamingbedrijf dat tientallen gelijktijdige 4K HDR-transcodes drijft, kiest mogelijk voor dedicated hardware—of een VM met een volledige NVIDIA GPU en vaste CPU’s, waar het verschil met bare metal na tuning verwaarloosbaar wordt.

Onderhoudindexering betaalt zich uit. Houd firmware (IOMMU/BIOS), GPU-drivers en paravirtual drivers afgestemd tussen host en gast. Test met een kleine set representatieve titels—HEVC HDR10, hoge-bitrate H.264 en interlaced bronnen—om zeker te zijn dat encoderfuncties zichtbaar en stabiel zijn binnen de VM. Documenteer welke instellingen effect hadden (queue depth, IO schedulers, RSS) zodat wijzigingen niet verloren gaan bij upgrades.

- 🧪 Beoordeel workload: piek gelijktijdige streams, codec-mix, bibliotheekgrootte.

- 🧷 Kies een pad: bare metal voor eenvoud; VM voor flexibiliteit en consolidatie.

- 🔐 GPU-strategie: passthrough voor maximale codec-/feature toegang; vGPU voor dichtheid.

- 📈 Meet: volg CPU ready %, schijflatentie en fps per stream tijdens stress.

- 🧭 Itereer: pas vNUMA, pinning en QoS aan; test opnieuw en documenteer.

| Situatie | Aanbeveling 🧭 | Waarom werkt het 🎯 | Risico mitigating 🛡️ |

|---|---|---|---|

| Klein huishouden, Intel iGPU | VM met QSV passthrough | Laag energieverbruik, goede codec-ondersteuning | Pin vCPU’s; activeer vNUMA bij >8 vCPU’s |

| Prosumer, NVIDIA dGPU | VM met PCIe passthrough | Bijna bare-metal NVENC | Driver versie vastzetten; let op thermiek |

| Enterprise streaming | VMware/Citrix vGPU | Dichtheid + beheer | Profieltesten; QoS op opslag |

| Extreme 4K HDR-concurrentie | Bare metal of dedicated VM | Maximale stabiliteit | Scheiding ingest- en playbacknetwerken |

Voor lezers die geïnteresseerd zijn in hoe orkestratie- en schedulingdiscussies spelen in aanverwante domeinen, toont deze vergelijking van Microsoft Copilot vs ChatGPT hoe capaciteiten en belastingpatronen platformkeuze sturen. Evenzo kunnen conceptuele beschouwingen over systeemontwerp vanuit synthetische omgevingen voor fysieke AI het denken over resource-isolatie aanscherpen. Dezelfde denkkaders die voor complexe AI- of gamingstreams gelden, schalen effectief naar huishoudelijke racks.

Slotregel: virtualiseer als flexibiliteit, backups en consolidatie belangrijk zijn; overweeg bare metal als absolute consistentie onder extreme belasting ononderhandelbaar is.

{“@context”:”https://schema.org”,”@type”:”FAQPage”,”mainEntity”:[{“@type”:”Question”,”name”:”How much performance is typically lost when running a media server in a VM?”,”acceptedAnswer”:{“@type”:”Answer”,”text”:”With modern hypervisors and paravirtual drivers, many setups see low-single-digit overhead for GPU-accelerated transcodes. Storage-heavy tasks like large library scans suffer most if virtual disks sit on slow media. Tuning virtio/VMXNET3, NVMe, and vNUMA keeps results close to bare metal.”}},{“@type”:”Question”,”name”:”Is GPU passthrough necessary for Plex/Jellyfin in a VM?”,”acceptedAnswer”:{“@type”:”Answer”,”text”:”For multiple 4K streams or HDR tone-mapping, yesu2014PCIe passthrough of an NVIDIA, AMD, or Intel GPU/iGPU preserves encoder features and delivers near bare-metal fps. For light, on-demand 1080p work, CPU-based transcoding may suffice, but power use and thermals can rise.”}},{“@type”:”Question”,”name”:”Which hypervisor is best for a home media server?”,”acceptedAnswer”:{“@type”:”Answer”,”text”:”Proxmox (KVM/QEMU) and Hyper-V are popular for homes and small studios due to straightforward GPU passthrough and virtio/enlightened drivers. VMware and Citrix add richer vGPU and management for larger deployments. VirtualBox is better suited to testing than heavy 4K workloads.”}},{“@type”:”Question”,”name”:”Do NUMA and CPU pinning really matter for streaming?”,”acceptedAnswer”:{“@type”:”Answer”,”text”:”Yes. Transcoding stresses caches and memory. Exposing vNUMA and pinning vCPUs reduces cross-node memory traffic and scheduler noise, stabilizing per-stream fps. The impact grows with more concurrent transcodes and larger VMs.”}},{“@type”:”Question”,”name”:”What monitoring metrics reveal VM-induced bottlenecks?”,”acceptedAnswer”:{“@type”:”Answer”,”text”:”Track CPU ready time, disk latency under library scans, and per-stream transcoding fps. Watch NIC offload counters and packet pacing for jitter. These KPIs identify whether scheduling, storage, or networking is the limiting factor.”}}]}How much performance is typically lost when running a media server in a VM?

With modern hypervisors and paravirtual drivers, many setups see low-single-digit overhead for GPU-accelerated transcodes. Storage-heavy tasks like large library scans suffer most if virtual disks sit on slow media. Tuning virtio/VMXNET3, NVMe, and vNUMA keeps results close to bare metal.

Is GPU passthrough necessary for Plex/Jellyfin in a VM?

For multiple 4K streams or HDR tone-mapping, yes—PCIe passthrough of an NVIDIA, AMD, or Intel GPU/iGPU preserves encoder features and delivers near bare-metal fps. For light, on-demand 1080p work, CPU-based transcoding may suffice, but power use and thermals can rise.

Which hypervisor is best for a home media server?

Proxmox (KVM/QEMU) and Hyper-V are popular for homes and small studios due to straightforward GPU passthrough and virtio/enlightened drivers. VMware and Citrix add richer vGPU and management for larger deployments. VirtualBox is better suited to testing than heavy 4K workloads.

Do NUMA and CPU pinning really matter for streaming?

Yes. Transcoding stresses caches and memory. Exposing vNUMA and pinning vCPUs reduces cross-node memory traffic and scheduler noise, stabilizing per-stream fps. The impact grows with more concurrent transcodes and larger VMs.

What monitoring metrics reveal VM-induced bottlenecks?

Track CPU ready time, disk latency under library scans, and per-stream transcoding fps. Watch NIC offload counters and packet pacing for jitter. These KPIs identify whether scheduling, storage, or networking is the limiting factor.

No responses yet