Sobrecarga de VM vs. bare metal: executar uma máquina virtual pode desacelerar um servidor de mídia?

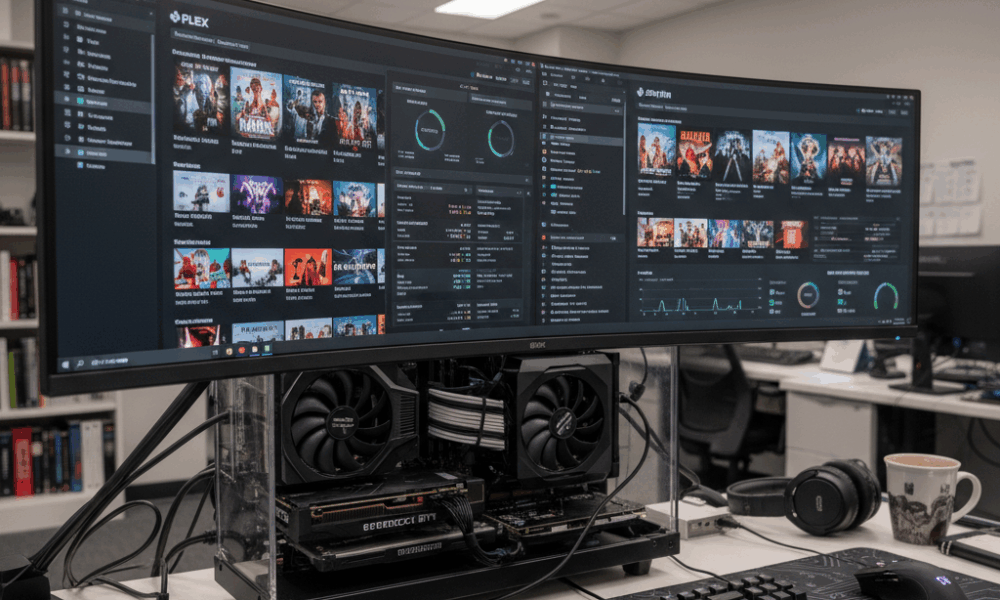

O desempenho de um servidor de mídia é moldado por três forças: processamento para transcodificação, largura de banda de armazenamento para operações na biblioteca e entrega pela rede. A virtualização insere um hipervisor entre o sistema operacional e o hardware, então a questão é se essa camada extra altera o equilíbrio. Com plataformas modernas como Hyper-V, Proxmox (com KVM/QEMU), VMware vSphere e Citrix Hypervisor, o custo base do hipervisor é tipicamente modesto quando ajustado. Por exemplo, o escalonador do Hyper-V e seus serviços de integração são projetados para consumir uma pequena fatia da CPU, frequentemente citada em torno de um percentual baixo de dígito único para tarefas administrativas, deixando a maioria dos ciclos para as cargas de trabalho. Servidores de mídia, no entanto, mudam o gargalo dependendo da carga: transcodificações ao vivo em 4K exigem muito da CPU/GPU, enquanto grandes varreduras na biblioteca do Plex/Jellyfin pressionam o I/O do disco.

Considere a Beacon Media, uma pequena equipe de pós-produção que consolidou um servidor Plex e uma VM utilitária Windows em um único host. Em bare metal, uma transcodificação 4K HEVC para 1080p H.264 sustentou 120 fps usando NVIDIA NVENC. Dentro de uma VM com passthrough de GPU, a taxa de transferência ficou entre 2–5% do bare metal após ajuste de drivers. O impacto maior ocorreu durante atualizações simultâneas de metadata, quando a fila virtual do disco da VM aumentou, adicionando latência e disparando o tempo de CPU pronto. A lição é simples: a virtualização raramente prejudica o desempenho de transcodificação quando o passthrough de GPU é usado corretamente, mas armazenamento e escalonamento podem se tornar novos gargalos se deixados sem ajuste.

Diferentes hipervisores e modelos de dispositivos importam. Dispositivos emulados são lentos para tarefas de mídia de alta taxa; já drivers paravirtuais ou “enlightened” — como virtio no KVM/QEMU e serviços de integração no Hyper-V — reduzem significativamente a sobrecarga. Em guests Windows, remover adaptadores emulados e dispositivos não usados, além de instalar os componentes de integração mais recentes, reduz o consumo desnecessário de CPU em segundo plano. Isso contribui para um serviço de mídia mais suave durante horários de pico.

Perguntas-chave orientam a decisão: o servidor frequentemente transcodifica múltiplas streams 4K? Aceleração por GPU é necessária? A biblioteca de mídia é enorme, causando operações intensas de varredura? Se a resposta for sim para qualquer uma delas, a VM deve ser projetada como uma carga de trabalho de produção, e não como um ambiente sandbox por conveniência. Isso inclui recursos de CPU fixados, armazenamento NVMe rápido e rede paravirtual. Com esses elementos, muitos laboratórios domésticos e pequenos estúdios relatam desempenho quase idêntico ao bare metal para streaming diário.

- 🎯 Baseline: Espere sobrecarga de CPU em dígito único baixo para um hipervisor moderno quando bem configurado.

- 🧠 Modelo de dispositivo: Prefira virtio (KVM/QEMU) ou drivers enlightened (Hyper-V) em vez de hardware emulado.

- ⚙️ Formato da carga: Transcodificações aceleradas por GPU dentro de VMs podem chegar perto do bare metal com passthrough adequado.

- 📚 Varreduras de biblioteca: Latência de armazenamento em VMs pode ser gargalo; use NVMe e ajuste a profundidade da fila.

- 🌐 Rede: Switches virtuais adicionam sobrecarga mínima se offloads e RSS estiverem ativados.

| Hipervisor | Sobrecarga de transcodificação (GPU) ⚡ | Tarefas intensivas no disco 📀 | Impacto na rede 🌐 | Notas |

|---|---|---|---|---|

| Hyper-V | ~2–5% com DDA/GPU-P | Moderada se usar VHDX em discos lentos | Baixa com offloads de vSwitch | Instale serviços de integração; evite NICs emuladas |

| Proxmox (KVM/QEMU) | ~0–5% com passthrough VFIO | Baixa a Moderada com virtio-scsi/NVMe | Baixa com virtio-net | Use hugepages, fixe vCPUs para consistência |

| VMware vSphere | ~0–5% com vGPU/passthrough | Baixa com SCSI paravirtual | Baixa com VMXNET3 | Ferramentas excelentes para monitoramento de desempenho |

| Citrix Hypervisor | ~0–6% com vGPU | Baixa a Moderada | Baixa | Pilha vGPU forte em ambientes corporativos |

| VirtualBox | Maior, suporte limitado a GPU | Moderada a Alta para I/O intenso | Moderada | Melhor para testes; não ideal para streaming 4K em escala |

A conclusão prática: sim, uma VM pode impactar o desempenho do servidor de mídia, mas com a pilha certa e drivers adequados, o efeito é pequeno e previsível—especialmente quando a aceleração por GPU e o armazenamento rápido estão em uso.

Configuração de CPU, memória e NUMA para transcodificação de mídia dentro de VMs

Transcodificação sobrecarrega caches da CPU, largura de banda de memória e escalonamento. Em hosts com CPUs Intel ou AMD, multithreading simultâneo (SMT) pode aumentar o rendimento, mas somente se a topologia vCPU e o escalonamento de threads estiverem alinhados com o hipervisor. Use vCPUs em número par quando SMT estiver ativado e evite superprovisionamento se a latência consistente for um objetivo. Para Hyper-V, processadores virtuais devem refletir avaliações de carga máxima, não médias; quando o tempo de CPU pronto sobe, as transcodificações travam.

A alocação de memória interage com NUMA. Uma VM de 24 threads com 32–64 GB de RAM pode abranger nós físicos NUMA. Se vNUMA estiver desativado ou distorcido por memória dinâmica, o pipeline de transcodificação pode saltar entre nós, incorrendo em penalidades de memória remota. O Hyper-V expõe Virtual NUMA por padrão para VMs grandes; deixe-o ativado para aplicativos sensíveis a NUMA e evite memória dinâmica quando o rendimento consistente for importante. No KVM/QEMU, alinhe numactl ou a fixação da VM com a topologia do host para manter memória e vCPUs locais.

O consumo silencioso de CPU em segundo plano prejudica. Guests ociosos que executam scanners de atualização, desfragmentação ou indexação de pesquisa roubam ciclos nos momentos mais críticos. A recomendação da Microsoft ainda vale em 2025: remova NICs emuladas, desative tarefas agendadas desnecessárias, mantenha a tela de login visível quando ocioso e feche consoles de gestão que constantemente fazem polling das VMs. Essas etapas reduzem a pressão de interrupções e estabilizam a latência da transcodificação.

- 🧩 Fixe vCPUs aos núcleos/threads físicos para fps estável durante horários de pico.

- 🧮 Respeite o vNUMA: mantenha a memória local; evite memória dinâmica para transcodificações pesadas.

- 🛡️ Serviços de integração: instale as últimas melhorias para reduzir a sobrecarga de CPU em I/O.

- 🧹 Minimize tarefas em segundo plano: desative SuperFetch/Search em VMs cliente; remova dispositivos não usados.

- ⏱️ Monitore KPIs: utilização de CPU, fila/tempo pronto, e trocas de contexto por segundo.

| Configuração | Por que é importante 🧠 | Impacto na mídia 🎬 | Ação recomendada ✅ |

|---|---|---|---|

| Contagem e fixação de vCPU | Reduz atrasos no escalonamento | fps mais suaves durante transcodificações multi-stream | vCPUs pares com SMT; fixe VMs quentes |

| Exposição de vNUMA | Preserva a localidade | Taxa de bits sustentada maior sob carga | Ative vNUMA; evite memória dinâmica para VMs grandes |

| Drivers I/O enlightened | Menos armadilhas de emulação | Varreduras e gravações DVR mais rápidas | Use virtio/VMXNET3/adaptadores específicos Hyper-V |

| Ruído em segundo plano | Libera ciclos de CPU | Menos travamentos sob atividade intensa | Desative serviços e tarefas agendadas desnecessárias |

Escalonadores não são tão diferentes de planejadores de treinamentos de IA em larga escala. Contenção de recursos e posicionamento têm analogias na orquestração de IA, como visto em discussões sobre o que esperar da fase de treinamento do GPT-5 em 2025, onde alinhamento de processamento, memória e I/O determina o rendimento. Os mesmos princípios se aplicam em menor escala para servidores domésticos de mídia.

Regra prática: trate a VM de mídia como uma carga de trabalho de produção, não como um detalhe, e as configurações de CPU/memória deixarão de ser gargalo.

Aceleração por GPU em VM: passthrough, compartilhamento de vGPU e resultados reais no Plex/Jellyfin

A aceleração por hardware transforma um servidor de mídia de “bom suficiente” para poderoso. Dentro de uma VM, há duas estratégias principais de GPU: passthrough completo do dispositivo e compartilhamento de GPU virtual (vGPU). Passthrough dedica uma GPU/iGPU inteira da NVIDIA, AMD ou Intel para a VM — ideal para transcodificação NVENC/VCN/QSV consistente e quase bare metal. vGPU compartilha um dispositivo entre múltiplas VMs, oferecendo maior densidade ao custo de alguma complexidade e, às vezes, restrições em recursos de codec.

Com KVM/QEMU (e portanto Proxmox), VFIO passthrough é o principal recurso: ele passa a GPU diretamente ao guest. No VMware, tanto DirectPath I/O quanto as pilhas vGPU do fornecedor são maduras. A Citrix tem vasta experiência com vGPU para VDI, que também se aplica a streaming. O Hyper-V suporta Discrete Device Assignment (DDA) e particionamento de GPU (GPU-P); o Windows Server 2025 melhorou a virtualização de GPU para computação e gráficos, alinhando ainda mais a aceleração em VM com resultados bare metal.

O suporte a codecs é o verdadeiro diferencial. Jellyfin/Plex buscam NVENC, AMD VCE/VCN ou Intel Quick Sync. Passthrough PCIe preserva completamente esses codificadores. vGPU pode ser mais restritivo dependendo de licenciamento e perfis. Em iGPUs Intel, o passthrough QSV dentro do Proxmox oferece às residências uma rota econômica para múltiplas streams 4K SDR, enquanto uma única placa NVIDIA intermediária permite decodificações HEVC simultâneas e codificações H.264 com flexibilidade para tone-mapping. Para densidade estilo nuvem, vGPU divide recursos entre, por exemplo, uma VM de mídia e uma VM leve de inferência AI, lembrando como um estudo de caso de cloud gaming como ARC Raiders equilibra fatias de tempo de GPU para streaming de baixa latência.

- 🚀 Passthrough (VFIO/DDA/DirectPath): próximo do bare metal; ideal para múltiplas transcodificações 4K.

- 🧩 vGPU: densidade e flexibilidade; verifique limitações de codec/perfil e licenciamento.

- 🔌 Higiene dos drivers: alinhe versões de drivers do host, guest e hipervisor para evitar resets.

- 🧊 Termal: ambientes virtualizados ainda aquecem GPUs; mantenha fluxo de ar para evitar throttling.

- 🛠️ Suporte de API: garanta visibilidade NVENC/QSV/VCN dentro do guest antes de testar cargas.

| Método | Hipervisores 🧱 | Suporte a codec 🎥 | Desempenho ⚡ | Caso de uso |

|---|---|---|---|---|

| Passthrough PCIe | Proxmox/KVM, VMware, Hyper-V (DDA), Citrix | Completo NVENC/QSV/VCN | Quase bare metal | Transcodificação pesada Plex/Jellyfin |

| Compartilhamento vGPU | VMware, Citrix, Windows GPU-P | Dependente de perfil | Alta mas não máxima | Mix de mídia + inferência VDI/AI |

| Fallback de software | Todas plataformas | Apenas CPU | Mínimo desempenho | Testes e emergências |

Escolher entre NVIDIA, AMD e Intel depende de codecs e metas energéticas. Intel Quick Sync brilha em residências de baixo consumo. NVIDIA oferece NVENC maduro e ferramentas robustas; o VCN da AMD melhorou consistentemente nas últimas gerações. Para contexto tecnológico mais amplo, a forma como GPUs são multiplexadas para mídia reflete como experiências multi-modelo de IA são orquestradas, semelhante a debates em uma comparação entre Microsoft Copilot e ChatGPT e benchmarks ChatGPT vs Gemini — as decisões do escalonador decidem a percepção de velocidade do usuário.

Armazenamento e I/O de rede sob virtualização: varreduras, DVR e streams 4K

Cargas de trabalho de mídia são bimodais: rajadas curtas durante varreduras da biblioteca e leituras sequenciais sustentadas durante a reprodução. A virtualização expõe armazenamento via discos virtuais (VHDX, qcow2), mapeamento direto de dispositivos ou compartilhamentos de rede. Para varredura pesada, virtio-scsi com suporte NVMe ou adaptadores NVMe virtuais reduzem a sobrecarga de emulação; quando funções DVR gravam múltiplos streams simultâneos, QoS no armazenamento impede que uma única VM sature o grupo de discos. Storage QoS no Hyper-V e limitação de I/O no Proxmox fornecem diretrizes úteis.

Escolhas do sistema de arquivos importam. Pools ZFS no Proxmox entregam forte cache de leitura para thumbnails e metadata, mas precisam de memória para brilhar. NTFS em SSD rápido é suficiente para bibliotecas menores, enquanto XFS/ext4 dentro de guests Linux garante latência previsível. Evite aninhar camadas excessivas (por exemplo, compartilhamento de rede dentro de VM cujo disco virtual reside em outro compartilhamento de rede), pois a latência se acumula. Uma cadeia mais simples, como NVMe do host → disco virtio → sistema de arquivos guest, mantém a latência linear e fácil de ser analisada.

No lado da rede, streams 4K HEVC ficam em torno de dezenas de Mbps; um único link 2.5 GbE suporta muitos usuários concorrentes. Switches virtuais adicionam sobrecarga desprezível quando offloads (TSO/LRO), RSS e NICs paravirtuais (VMXNET3, virtio-net, NICs sintéticas Hyper-V) estão em uso. Ainda assim, monitore aglomeração de pacotes e settings de moderação de interrupções para estabilizar jitter durante noites de pico. Se o servidor de mídia também grava OTA ou câmeras IP, isole esse tráfego usando VLANs para evitar colisão do ingest com a reprodução.

- 📦 Prefira virtio/VMXNET3 em vez de NICs emuladas; ative offloads de checksum e segmentação.

- 💾 Use NVMe ou SSD para appdata e metadados; coloque mídia grande em discos separados.

- 📊 Aplicar Storage QoS para evitar picos de DVR que prejudiquem threads de reprodução.

- 🧯 Evitar dupla virtualização nos caminhos de armazenamento para manter latência previsível.

- 🛰️ Segmente o tráfego com VLANs para ingest vs. reprodução; considere jumbo frames após testes.

| Tarefa | Gargalo principal 🔍 | Dica de virtualização 🧰 | Resultado esperado 📈 |

|---|---|---|---|

| Varredura de biblioteca | I/O aleatório | NVMe + virtio-scsi, aumentar profundidade da I/O | Construção de metadados mais rápida |

| Transcodificação 4K HDR | GPU/CPU | Passthrough PCIe, fixar vCPUs | fps quase bare metal |

| Gravação DVR | IOPS de escrita | Storage QoS + disco separado | Sem travamentos na reprodução sob carga |

| Streaming remoto | Largura de banda | NIC paravirtual + offloads | Taxas de bits estáveis por usuário |

As escolhas de arquitetura refletem técnicas usadas em pipelines pesados de simulação, onde mundos virtuais pressionam I/O e banda. Para uma visão mais ampla de como cargas sintéticas moldam design de sistemas, veja esta perspectiva sobre ambientes sintéticos para IA física.

Resumo: otimize primeiro caminhos de armazenamento e rede paravirtual; otimizações de transcodificação só ganham vida quando I/O e entrega estão estáveis.

Checagem de realidade entre plataformas: Hyper-V, Proxmox/KVM, VMware, Citrix e VirtualBox

Diferentes hipervisores oferecem ergonomias diferentes para servidores de mídia. Hyper-V integra bem com Windows, com baixa sobrecarga, vNUMA e DDA para acesso à GPU, além de Storage QoS. Proxmox adiciona uma UI acessível em cima do KVM/QEMU, com passthrough VFIO, ZFS e dispositivos virtio excelentes—popular em laboratórios domésticos por um motivo. VMware vSphere oferece gerenciamento de ponta e pilhas vGPU para setups densos, enquanto Citrix se destaca quando VDI e compartilhamento de mídia se cruzam. VirtualBox continua excelente para desenvolvedores, mas não foca no desempenho necessário para transcodificações ao vivo 4K múltiplas.

Como são os resultados medidos? Em laboratórios de 2024–2025, ambientes cuidadosamente configurados relatam que uma VM Plex ou Jellyfin com passthrough vê ~0–5% de diferença para bare metal em transcodificação acelerada por GPU. A variabilidade vem de configurações de BIOS, comportamento IOMMU/ACS e maturidade dos drivers. Para operações intensas no disco, mover appdata para NVMe e habilitar drivers paravirtual geralmente corta pela metade os tempos de varredura comparado à emulação padrão. Esses não são truques exóticos; são requisitos básicos para VMs grau produção.

O aspecto de gestão também importa. Hipervisores diferem nos padrões para timers, interrupções e estados de energia ociosos. Microsoft recomenda minimizar atividade de fundo em guests e remover dispositivos emulados não usados, conselho aplicável igualmente a KVM e VMware. A exposição NUMA deve ser ativada em grandes VMs em todas as plataformas—Virtual NUMA do Hyper-V, flags de topologia do KVM e escalonador NUMA do VMware existem para manter memória perto do processamento.

- 🧭 Hyper-V: DDA/GPU-P, vNUMA, Storage QoS, baixa sobrecarga para guests Windows.

- 🧱 Proxmox (KVM/QEMU): passthrough VFIO, drivers virtio, cache ZFS, mapeamento GPU direto.

- 🏢 VMware: pilhas maduras vGPU e paravirtual (PVSCI, VMXNET3), alta observabilidade.

- 🏛️ Citrix: perfis vGPU fortes e controle de políticas para cargas mistas.

- 🧪 VirtualBox: ótimo para testes; não recomendado para cargas pesadas 4K.

| Plataforma | Capacidade de GPU 🎮 | Caminho do disco 🔗 | Adaptador de rede 🌐 | Melhor ajuste |

|---|---|---|---|---|

| Hyper-V | DDA / GPU-P | VHDX em NVMe; disco pass-through | NIC sintética | Servidores de mídia centrados em Windows |

| Proxmox | Passthrough VFIO | ZFS ou LVM em NVMe | virtio-net | Setups domésticos e prósumer |

| VMware | vGPU/DirectPath | vSAN/NVMe, PVSCI | VMXNET3 | Streaming corporativo de mídia |

| Citrix | Perfis vGPU | SR-IOV/NVMe | Paravirtual | Cargas mistas VDI + mídia |

| VirtualBox | Limitado | VDI baseado em arquivo | Emulado/virtio | Uso leve e testes |

A escolha entre plataformas ecoa comparações tecnológicas mais amplas—trade-offs em recursos, custo e ecossistema se assemelham a comparações entre modelos ou assistentes no mundo da IA. Para uma leitura paralela relevante sobre como diferenças de capacidade afetam resultados, explore benchmarks ChatGPT vs Gemini.

Princípio orientador: a escolha da plataforma deve seguir a qualidade do modelo de dispositivo, opções de GPU e clareza do caminho de armazenamento. O resto é configuração.

Manual operacional: quando virtualizar um servidor de mídia e quando permanecer bare metal

A virtualização permite consolidação, snapshots e recuperação rápida. Bare metal maximiza determinismo e simplicidade. A decisão depende do formato da carga, hardware e objetivos de manutenção. Um servidor doméstico com iGPU Intel e poucos usuários se beneficia de uma VM Proxmox ou Hyper-V com passthrough Quick Sync. Uma operação boutique de streaming que executa dezenas de transcodificações 4K HDR simultâneas pode preferir hardware dedicado — ou uma VM com GPU NVIDIA completa e CPUs fixadas, onde as diferenças para bare metal se tornam desprezíveis após o ajuste.

Disciplina de manutenção traz dividendos. Mantenha firmware (IOMMU/BIOS), drivers de GPU e drivers paravirtual alinhados entre host e guest. Teste com um conjunto pequeno de títulos representativos — HEVC HDR10, H.264 de alta taxa e fontes entrelaçadas — para garantir que recursos do codificador estejam visíveis e estáveis dentro da VM. Documente quais ajustes fizeram diferença (profundidade da fila, escalonadores I/O, RSS) para que mudanças não se percam em atualizações.

- 🧪 Avalie a carga: streams simultâneos no pico, mix de codecs, tamanho da biblioteca.

- 🧷 Escolha um caminho: bare metal para simplicidade; VM para flexibilidade e consolidação.

- 🔐 Estratégia de GPU: passthrough para máximo acesso a codecs/recursos; vGPU para densidade.

- 📈 Meça: monitore % CPU pronto, latência de disco e fps por stream durante estresse.

- 🧭 Itere: ajuste vNUMA, fixação e QoS; reteste e documente.

| Cenário | Recomendação 🧭 | Por que funciona 🎯 | Mitigações de risco 🛡️ |

|---|---|---|---|

| Residência pequena, iGPU Intel | VM com passthrough QSV | Baixo consumo, bom suporte a codec | Fixar vCPUs; ativar vNUMA se >8 vCPUs |

| Prósumer, GPU dedicada NVIDIA | VM com passthrough PCIe | NVENC quase bare metal | Bloqueio de versão de driver; monitorar térmicas |

| Streaming corporativo | VMware/Citrix vGPU | Densidade + gerenciamento | Teste de perfis; QoS no armazenamento |

| Concorrência extrema 4K HDR | Bare metal ou VM dedicada | Determinismo máximo | Redes segregadas para ingest e reprodução |

Para leitores interessados em como debates sobre orquestração e escalonamento acontecem em domínios adjacentes, esta visão geral de uma comparação entre Microsoft Copilot e ChatGPT mostra como capacidade e padrões de carga dirigem a escolha de plataforma. Similarmente, abordagens conceituais sobre design de sistema em ambientes sintéticos para IA física podem aprimorar o pensamento sobre isolamento de recursos. Os mesmos modelos mentais usados para streams complexos de IA ou jogos escalam eficazmente para um rack doméstico.

Regra final: virtualize quando flexibilidade, backups e consolidação forem importantes; considere bare metal quando consistência absoluta sob carga extrema for inegociável.

{“@context”:”https://schema.org”,”@type”:”FAQPage”,”mainEntity”:[{“@type”:”Question”,”name”:”Quanto desempenho normalmente se perde ao rodar um servidor de mídia em uma VM?”,”acceptedAnswer”:{“@type”:”Answer”,”text”:”Com hipervisores modernos e drivers paravirtuais, muitos setups apresentam sobrecarga de CPU em dígitos únicos baixos para transcodificações aceleradas por GPU. Tarefas pesadas de armazenamento, como varreduras grandes de biblioteca, sofrem mais se os discos virtuais estiverem em mídia lenta. Ajustar virtio/VMXNET3, NVMe e vNUMA mantém resultados próximos ao bare metal.”}},{“@type”:”Question”,”name”:”Passthrough de GPU é necessário para Plex/Jellyfin em VM?”,”acceptedAnswer”:{“@type”:”Answer”,”text”:”Para múltiplas streams 4K ou tone-mapping HDR, sim — passthrough PCIe de GPU/iGPU NVIDIA, AMD ou Intel preserva recursos do codificador e entrega fps quase bare metal. Para trabalho leve sob demanda em 1080p, transcodificação por CPU pode ser suficiente, mas consumo de energia e térmicas podem aumentar.”}},{“@type”:”Question”,”name”:”Qual hipervisor é melhor para um servidor de mídia doméstico?”,”acceptedAnswer”:{“@type”:”Answer”,”text”:”Proxmox (KVM/QEMU) e Hyper-V são populares para residências e pequenos estúdios por conta do passthrough de GPU simples e drivers virtio/enlightened. VMware e Citrix adicionam pilhas vGPU e gerenciamento mais ricos para implantações maiores. VirtualBox é mais adequado para testes do que cargas pesadas 4K.”}},{“@type”:”Question”,”name”:”NUMA e fixação de CPU realmente importam para streaming?”,”acceptedAnswer”:{“@type”:”Answer”,”text”:”Sim. Transcodificação estressa caches e memória. Expor vNUMA e fixar vCPUs reduz tráfego cruzado de memória entre nós e ruído do escalonador, estabilizando fps por stream. O impacto cresce com mais transcodificações simultâneas e VMs maiores.”}},{“@type”:”Question”,”name”:”Quais métricas de monitoramento revelam gargalos induzidos por VM?”,”acceptedAnswer”:{“@type”:”Answer”,”text”:”Monitore tempo CPU pronto, latência de disco durante varreduras de biblioteca e fps por transcodificação. Observe contadores de offload da NIC e controle de pacotes para jitter. Esses KPIs indicam se o fator limitante é escalonamento, armazenamento ou rede.”}}]}Quanto desempenho normalmente se perde ao rodar um servidor de mídia em uma VM?

Com hipervisores modernos e drivers paravirtuais, muitos setups apresentam sobrecarga de CPU em dígitos únicos baixos para transcodificações aceleradas por GPU. Tarefas pesadas de armazenamento, como varreduras grandes de biblioteca, sofrem mais se os discos virtuais estiverem em mídia lenta. Ajustar virtio/VMXNET3, NVMe e vNUMA mantém resultados próximos ao bare metal.

Passthrough de GPU é necessário para Plex/Jellyfin em VM?

Para múltiplas streams 4K ou tone-mapping HDR, sim—passthrough PCIe de uma GPU/iGPU NVIDIA, AMD ou Intel preserva recursos do codificador e entrega fps quase bare metal. Para trabalho leve sob demanda em 1080p, transcodificação por CPU pode ser suficiente, mas consumo de energia e térmicas podem aumentar.

Qual hipervisor é melhor para um servidor de mídia doméstico?

Proxmox (KVM/QEMU) e Hyper-V são populares para residências e pequenos estúdios por conta do passthrough de GPU simples e drivers virtio/enlightened. VMware e Citrix adicionam pilhas vGPU e gerenciamento mais ricos para implantações maiores. VirtualBox é mais adequado para testes do que cargas pesadas 4K.

NUMA e fixação de CPU realmente importam para streaming?

Sim. Transcodificação estressa caches e memória. Expor vNUMA e fixar vCPUs reduz tráfego cruzado de memória entre nós e ruído do escalonador, estabilizando fps por stream. O impacto cresce com mais transcodificações simultâneas e VMs maiores.

Quais métricas de monitoramento revelam gargalos induzidos por VM?

Monitore tempo CPU pronto, latência de disco durante varreduras de biblioteca e fps por transcodificação. Observe contadores de offload da NIC e controle de pacotes para jitter. Esses KPIs indicam se o fator limitante é escalonamento, armazenamento ou rede.

No responses yet