VM-Overhead vs. Bare Metal: Kann das Ausführen einer virtuellen Maschine einen Medienserver verlangsamen?

Die Leistung eines Medienservers wird von drei Kräften geprägt: Rechenleistung für Transcodierung, Speicherbandbreite für Bibliotheksoperationen und Netzwerkübertragung. Virtualisierung fügt einen Hypervisor zwischen das Betriebssystem und die Hardware ein, sodass die Frage besteht, ob diese zusätzliche Schicht das Gleichgewicht verändert. Bei modernen Plattformen wie Hyper-V, Proxmox (mit KVM/QEMU), VMware vSphere und Citrix Hypervisor sind die Basiskosten des Hypervisors bei guter Konfiguration meist gering. So sind beispielsweise der Scheduler und die Integrationsdienste von Hyper-V so ausgelegt, dass sie einen kleinen Teil der CPU verwenden, oft genannt etwa im niedrigen einstelligen Prozentbereich für Verwaltungsaufgaben, wodurch die meisten Zyklen für Arbeitslasten übrig bleiben. Medienserver verändern jedoch je nach Arbeitslast den Engpass: Live-4K-Transcodierungen belasten CPU/GPU, während große Plex/Jellyfin-Bibliotheksscans die Festplatten-I/O beanspruchen.

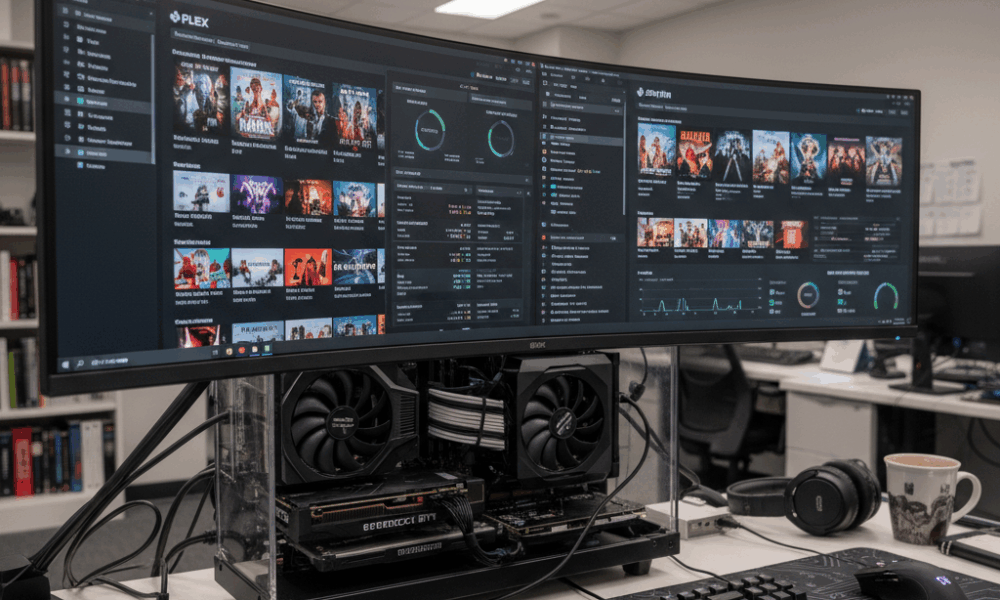

Betrachten wir Beacon Media, ein kleines Post-Production-Team, das einen Plex-Server und eine Windows-Dienst-VM auf einem einzigen Host konsolidierte. Auf Bare Metal erreichte eine 4K HEVC zu 1080p H.264 Transcodierung konstant 120 fps mit NVIDIA NVENC. Innerhalb einer VM mit GPU-Passthrough lag der Durchsatz nach Treibertuning innerhalb von 2–5% des Bare-Metal-Niveaus. Der größere Effekt trat während gleichzeitiger Metadatenaktualisierungen auf, wenn die virtuelle Festplattenwarteschlange der VM sich vertiefte, was die Latenz erhöhte und die CPU-Bereitschaftszeit in die Höhe trieb. Die Erkenntnis ist einfach: Virtualisierung beeinträchtigt die Transcodierleistung selten, wenn GPU-Passthrough korrekt verwendet wird, aber Speicher- und Scheduling-Aspekte können ohne Feinabstimmung neue Engpässe darstellen.

Verschiedene Hypervisoren und Gerätetypen spielen eine Rolle. Emulierte Geräte sind bei medienintensiven Aufgaben mit hoher Durchsatzrate langsam, während paravirtualisierte oder „erweiterte“ Treiber – wie virtio bei KVM/QEMU und Integrationsdienste bei Hyper-V – den Overhead deutlich reduzieren. Bei Windows-Gastsystemen hilft das Entfernen emulierter Adapter und nicht verwendeter Geräte sowie die Installation aktueller Integrationskomponenten, die CPU-Hintergrundbelastung zu verringern. Das trägt zu einem reibungsloseren Mediensupport während der Stoßzeiten bei.

Wichtige Fragen leiten die Entscheidung: Transkodiert der Server häufig mehrere 4K-Streams gleichzeitig? Ist GPU-Beschleunigung erforderlich? Ist die Medienbibliothek enorm und verursacht intensive Scanvorgänge? Wenn eine der Fragen mit Ja beantwortet wird, muss die VM wie eine Produktionsarbeitslast konzipiert werden, nicht als bloße Komfortumgebung. Dazu gehören fest zugewiesene CPU-Ressourcen, schneller NVMe-Speicher und paravirtualisiertes Networking. Mit diesen Voraussetzungen berichten viele Heimlabore und kleine Studios von nahezu gleichem Niveau wie Bare Metal im alltäglichen Streaming.

- 🎯 Baseline: Erwarteter niederiger einstelliger CPU-Overhead bei modernem Hypervisor und guter Konfiguration.

- 🧠 Gerätemodell: Bevorzugen Sie virtio (KVM/QEMU) oder erweiterte Treiber (Hyper-V) statt emulierter Hardware.

- ⚙️ Arbeitslastform: GPU-beschleunigte Transcodierungen in VMs können bei korrektem Passthrough nahezu Bare Metal erreichen.

- 📚 Bibliotheksscans: Speicherlatenzen in VMs können Scans ausbremsen; NVMe nutzen und Warteschlangentiefe anpassen.

- 🌐 Netzwerk: Virtuelle Switches verursachen minimalen Overhead, wenn Offloads und RSS aktiviert sind.

| Hypervisor | Transcode-Overhead (GPU) ⚡ | Festplattenintensive Aufgaben 📀 | Netzwerk-Auswirkung 🌐 | Hinweise |

|---|---|---|---|---|

| Hyper-V | ~2–5% mit DDA/GPU-P | Moderat bei Nutzung von VHDX auf langsamen Festplatten | Niedrig mit vSwitch-Offloads | Integrationsdienste installieren; emulierte NICs vermeiden |

| Proxmox (KVM/QEMU) | ~0–5% mit VFIO Passthrough | Niedrig–Moderat mit virtio-scsi/NVMe | Niedrig mit virtio-net | Hugepages nutzen, vCPUs pinnen für Konsistenz |

| VMware vSphere | ~0–5% mit vGPU/Passthrough | Niedrig mit paravirtual SCSI | Niedrig mit VMXNET3 | Sehr gute Tools zur Leistungsüberwachung |

| Citrix Hypervisor | ~0–6% mit vGPU | Niedrig–Moderat | Niedrig | Starker vGPU-Stack im Enterprise-Umfeld |

| VirtualBox | Höher, eingeschränkte GPU-Unterstützung | Moderat–Hoch bei starkem I/O | Moderat | Ideal für Tests; nicht für 4K-Streaming in großem Maßstab |

Das praktische Fazit: Ja, eine VM kann die Medienserverleistung beeinflussen, aber mit der richtigen Konfiguration und Treibern ist der Effekt gering und vorhersagbar – besonders wenn GPU-Beschleunigung und schneller Speicher genutzt werden.

CPU-, Speicher- und NUMA-Tuning für Media-Transcodierung in VMs

Transcodierung belastet CPU-Caches, Speicherbandbreite und Scheduling. Auf Hosts mit Intel– oder AMD-CPUs kann simultanes Multithreading (SMT) den Durchsatz erhöhen, aber nur wenn vCPU-Topologie und Thread-Scheduling mit dem Hypervisor übereinstimmen. Verwenden Sie gerade vCPU-Anzahlen, wenn SMT aktiviert ist, und vermeiden Sie Überprovisionierung, falls konsistente Latenz angestrebt wird. Bei Hyper-V sollten virtuelle Prozessoren das Spitzenlastprofil widerspiegeln, nicht den Durchschnitt; steigt die CPU-Bereitschaftszeit, kommt es zu Stottern bei Transcodierungen.

Die Speicherzuweisung interagiert mit NUMA. Eine VM mit 24 Threads und 32–64 GB RAM kann physische NUMA-Knoten überspannen. Ist vNUMA deaktiviert oder wird durch dynamischen Speicher verzerrt, kann die Transcoding-Pipeline zwischen Knoten pendeln und dadurch Strafen für Remote-Speicher provozieren. Hyper-V aktiviert Virtual NUMA standardmäßig bei großen VMs; lassen Sie es für NUMA-aware Anwendungen an und vermeiden Sie dynamischen Speicher bei wichtigen Durchsatzanforderungen. Bei KVM/QEMU stimmen Sie numactl oder VM-Pinning an die Host-Topologie an, um Speicher und vCPUs lokal zu halten.

Hintergrund-CPU-Last stört unbemerkt. Leerlaufende Gäste, die Update-Scanner, Defragmentierungen oder Suchindizierungen ausführen, stehlen Zyklen im ungünstigsten Moment. Microsofts Empfehlungen gelten auch 2025: emulierte NICs entfernen, unnötige geplante Aufgaben deaktivieren, Anmeldebildschirm bei Leerlauf sichtbar halten und Management-Konsolen schließen, die VM-Anfragen permanent senden. Diese Maßnahmen reduzieren Interrupt-Belastung und stabilisieren Transcoding-Latenzen.

- 🧩 vCPUs pinnen auf physische Kerne/Threads für gleichmäßige fps in Stoßzeiten.

- 🧮 vNUMA respektieren: Speicher lokal halten; dynamischen Speicher bei schweren Transcodes vermeiden.

- 🛡️ Integrationsdienste: neueste Erweiterungen installieren, um I/O-CPU-Overhead zu reduzieren.

- 🧹 Hintergrundaufgaben minimieren: SuperFetch/Suche bei Client-VMs deaktivieren; ungenutzte Geräte entfernen.

- ⏱️ KPI überwachen: CPU-Auslastung, Warteschlange/Bereitschaftszeit, Kontextwechsel pro Sekunde.

| Einstellung | Warum es wichtig ist 🧠 | Medienauswirkung 🎬 | Empfohlene Aktion ✅ |

|---|---|---|---|

| vCPU-Anzahl & Pinning | Reduziert Scheduling-Verzögerungen | Glattere fps bei Multi-Stream-Transcodes | Gerade vCPU-Anzahl bei SMT; heiße VMs pinnen |

| vNUMA Sichtbarmachung | Erhält Lokalität | Höhere kontinuierliche Bitrate unter Last | vNUMA aktivieren; dynamischen Speicher bei großen VMs vermeiden |

| Erweiterte I/O-Treiber | Weniger Emulationsfallen | Schnellere Scans und DVR-Schreibvorgänge | Virtio/VMXNET3/Hyper-V-spezifische Adapter verwenden |

| Hintergrundlast | Freiwerden von CPU-Zyklen | Weniger Stottern bei sprunghaften Aktivitäten | Überflüssige Dienste und geplante Aufgaben deaktivieren |

Scheduler unterscheiden sich nicht grundlegend von großen KI-Trainingsplanern. Ressourcenkonflikte und Platzierung haben Entsprechungen in der KI-Orchestrierung, wie in Diskussionen über die Erwartungen an die GPT-5-Trainingsphase 2025 zu sehen ist, wobei Rechenleistung, Speicher und I/O-Abstimmung den Durchsatz bestimmen. Dieselben Prinzipien gelten in kleinerem Maßstab auch für private Medienserver.

Praktische Regel: Behandle die Media-VM wie eine Produktionsarbeitslast, nicht als nachträglichen Gedanken, und CPU-/Speichereinstellungen werden keine Engpässe mehr sein.

GPU-Beschleunigung in einer VM: Passthrough, vGPU-Sharing und reale Plex/Jellyfin-Ergebnisse

Hardwarebeschleunigung wandelt einen Medienserver von „gut genug“ in eine Kraftmaschine. Innerhalb einer VM gibt es zwei Haupt-GPU-Strategien: vollständiges Geräte-Passthrough und virtual GPU (vGPU)-Sharing. Passthrough widmet der VM eine komplette NVIDIA-, AMD– oder Intel-GPU/iGPU – ideal für konsistente, nahezu Bare-Metal NVENC/VCN/QSV-Transcodierungen. vGPU teilt ein Gerät auf mehrere VMs auf, bietet damit höhere Dichte, bringt aber etwas Komplexität und teilweise Einschränkungen bei Codec-Features mit sich.

Bei KVM/QEMU (und somit Proxmox) ist VFIO Passthrough der Treiber: Er übergibt die GPU direkt an den Gast. In VMware sind sowohl DirectPath I/O als auch die vGPU-Stacks der Hersteller ausgereift. Citrix verfügt über langjährige Erfahrung mit vGPU für VDI, was sich auch auf Streaming übertragen lässt. Hyper-V unterstützt Discrete Device Assignment (DDA) und GPU-Partitionierung (GPU-P); Windows Server 2025 verbesserte die GPU-Virtualisierung für Berechnung und Grafik und bringt so VM-Beschleunigung näher an Bare Metal heran.

Codec-Unterstützung ist der eigentliche Unterschied. Jellyfin/Plex setzen auf NVENC, AMD VCE/VCN oder Intel Quick Sync. PCIe Passthrough bewahrt diese Encoder vollständig. Bei vGPU gelten je nach Lizenz und Profil mehr Einschränkungen. Bei Intel iGPU bietet QSV Passthrough in Proxmox Haushalten eine kostengünstige Möglichkeit für mehrere 4K SDR-Streams, während eine einzelne Mittelklasse-NVIDIA-Karte gleichzeitig HEVC-Decodes und H.264-Encodes ermöglicht, mit Spielraum für Tone-Mapping. Für cloudartige Dichte teilt vGPU Ressourcen z. B. zwischen einer Media-VM und einer leichten KI-Inferenz-VM, ähnlich wie in einer Cloud-Gaming-Fallstudie wie ARC Raiders, die GPU-Zeitfenster für latenzarmes Streaming ausbalanciert.

- 🚀 Passthrough (VFIO/DDA/DirectPath): nahe Bare Metal; ideal für Multi-4K-Transcodierungen.

- 🧩 vGPU: Dichte und Flexibilität; auf Codec-/Profil-Einschränkungen und Lizenzierung achten.

- 🔌 Treiberhygiene: Host-, Gast- und Hypervisor-Treiberversionen abstimmen, um Neustarts zu vermeiden.

- 🧊 Thermik: virtuelle Umgebungen erwärmen GPUs weiterhin; für ausreichende Kühlung sorgen, um Drosselung zu verhindern.

- 🛠️ API-Unterstützung: NVENC/QSV/VCN im Gast prüfen, bevor Arbeitslasten getestet werden.

| Methode | Hypervisoren 🧱 | Codec-Unterstützung 🎥 | Leistung ⚡ | Anwendungsfall |

|---|---|---|---|---|

| PCIe Passthrough | Proxmox/KVM, VMware, Hyper-V (DDA), Citrix | Volle NVENC/QSV/VCN-Unterstützung | Nahe Bare Metal | Intensive Plex/Jellyfin-Transcodierung |

| vGPU-Sharing | VMware, Citrix, Windows GPU-P | Profilabhängig | Hoch, aber nicht maximal | Mischworkload aus Medien + VDI/KI-Inferenz |

| Software-Fallback | Alle Plattformen | Nur CPU | Geringster Durchsatz | Tests und Notfälle |

Die Wahl zwischen NVIDIA, AMD und Intel hängt von Codecs und Energiesparzielen ab. Intel Quick Sync glänzt bei energiesparenden Heim-Setups. NVIDIA bietet ausgereifte NVENC-Unterstützung und robuste Tools; AMDs VCN hat sich in den letzten Generationen stetig verbessert. Im weiteren technischen Kontext spiegelt die Multiplex-Verteilung von GPUs für Medien wider, wie Multi-Model-KI-Erfahrungen orchestriert werden – ähnlich den Debatten in einem Vergleich Microsoft Copilot vs ChatGPT und ChatGPT vs Gemini Benchmarks – die Scheduler-Entscheidungen bestimmen letztlich die gefühlte Geschwindigkeit des Anwenders.

Storage- und Netzwerk-I/O unter Virtualisierung: Scans, DVR und 4K-Streams

Medienarbeitslasten sind bimodal: kurze Bursts während der Bibliotheksscans und anhaltende sequenzielle Lesevorgänge während der Wiedergabe. Virtualisierung stellt Speicher über virtuelle Festplatten (VHDX, qcow2), direktes Gerätemapping oder Netzlaufwerke bereit. Für intensives Scannen reduzieren NVMe-gestützte virtio-scsi oder virtuelle NVMe-Adapter Emulations-Overhead; wenn DVR mehrere Streams gleichzeitig schreibt, verhindert Storage-QoS, dass eine einzelne VM die Festplattengruppe überlastet. Hyper-Vs Storage QoS und Proxmox‘ I/O-Drosselung sind nützliche Schutzmechanismen.

Dateisystemauswahl ist wichtig. ZFS-Pools in Proxmox bieten starke Lese-Caches für Thumbnails und Metadaten, benötigen jedoch Speicher für volle Effektivität. NTFS auf schnellen SSDs reicht für kleinere Bibliotheken aus, während XFS/ext4 in Linux-Gastsystemen vorhersehbare Latenzen liefert. Vermeiden Sie zu viele Verschachtelungsebenen (z. B. Netzlaufwerk in einer VM, deren virtuelle Festplatte auf einem weiteren Netzlaufwerk liegt), da dies Latenzen erhöht. Eine einfache Kette wie Host NVMe → virtio-Festplatte → Gast-Dateisystem hält die Latenz linear und transparent.

Auf Netzwerkseite liegen 4K HEVC-Streams bei einigen zehn Mbps; ein einziger 2,5 GbE-Link bewältigt viele gleichzeitige Nutzer. Virtuelle Switches fügen vernachlässigbaren Overhead hinzu, wenn Offloads (TSO/LRO), RSS und paravirtualisierte NICs (VMXNET3, virtio-net, Hyper-V Synthetic NIC) aktiv sind. Dennoch überwachen Sie Packet Coalescing und Interrupt-Modulation, um Jitter zu stabilisieren, besonders in Spitzenzeiten. Zeichnet der Medienserver OTA oder IP-Kameras auf, isolieren Sie den Verkehr per VLAN, damit burstartige Eingänge nicht mit der Wiedergabe kollidieren.

- 📦 Virtio/VMXNET3 bevorzugen statt emulierter NICs; Prüfsummen- und Segmentoffloads aktivieren.

- 💾 NVMe oder SSD verwenden für App-Daten und Metadaten; große Medien auf separaten Laufwerken speichern.

- 📊 Storage QoS anwenden, um DVR-Spitzen einzudämmen und Wiedergabe stabil zu halten.

- 🧯 Doppelte Virtualisierung von Speicherpfaden vermeiden, damit die Latenz vorhersagbar bleibt.

- 🛰️ Verkehr segmentieren mit VLANs für Ingest und Wiedergabe; Jumbo Frames nach Tests in Betracht ziehen.

| Aufgabe | Primärer Engpass 🔍 | Virtualisierungstipp 🧰 | Erwartetes Ergebnis 📈 |

|---|---|---|---|

| Bibliotheksscan | Random I/O | NVMe + virtio-scsi, Warteschlangentiefe erhöhen | Schnellere Metadatenaufbau |

| 4K HDR Transcode | GPU/CPU | PCIe Passthrough, vCPUs pinnen | Nahe Bare Metal fps |

| DVR-Aufzeichnung | Schreib-IOPS | Storage QoS + separate Festplatte | Keine Wiedergabestörungen unter Last |

| Remote-Streaming | Bandbreite | Paravirtualisierte NIC + Offloads | Stabile Bitraten je Nutzer |

Die Architekturwahl ähnelt Techniken in simulationlastigen Pipelines, wo virtuelle Welten I/O und Bandbreite stark belasten. Für einen breiteren Blick, wie synthetische Arbeitslasten Systemdesign prägen, siehe diese Perspektive zu synthetischen Umgebungen für physikalische KI.

Fazit: Optimieren Sie zuerst Speicherpfade und paravirtualisiertes Networking; Transcodierungsoptimierungen entfalten erst bei stabilem I/O und Übertragungsfluss Wirkung.

Reality-Check über Plattformen hinweg: Hyper-V, Proxmox/KVM, VMware, Citrix und VirtualBox

Verschiedene Hypervisoren bieten unterschiedliche Ergonomien für Medienserver. Hyper-V integriert sich nahtlos in Windows mit geringem Overhead, vNUMA und DDA für GPU-Zugriff sowie Storage-QoS. Proxmox legt eine zugängliche UI über KVM/QEMU, inklusive VFIO Passthrough, ZFS und hervorragenden virtio-Geräten – beliebt in Heimlaboren aus gutem Grund. VMware vSphere bietet best-in-class Management und vGPU-Stacks für dichte Umgebungen, während Citrix vor allem bei VDI- und Mediensharing-Anwendungen glänzt. VirtualBox ist ein hervorragendes Entwickler-Tool, aber nicht darauf fokussiert, Multi-4K-Live-Transcodierungen performant auszuführen.

Wie sehen gemessene Ergebnisse aus? In Labors 2024–2025 berichten gut konfigurierte Umgebungen, dass eine Plex- oder Jellyfin-VM mit Passthrough ~0–5% Abstand zu Bare Metal bei GPU-beschleunigter Transcodierung aufweist. Die Varianz resultiert aus BIOS-Einstellungen, IOMMU/ACS-Verhalten und Treiberreife. Für festplattenintensive Operationen halbiert oft der Umzug von App-Daten auf NVMe und die Aktivierung paravirtualisierter Festplattentreiber die Scanzeiten im Vergleich zur Standardemulation. Das sind keine exotischen Tricks, sondern Basisanforderungen an produktionsreife VMs.

Auch die Managementseite ist entscheidend. Hypervisoren unterscheiden sich bei Timern, Interrupts und Leerlaufzuständen. Microsoft empfiehlt, die Hintergrundaktivitäten im Gast zu minimieren und ungenutzte emulierte Geräte zu entfernen – diese Ratschläge gelten gleichermaßen für KVM und VMware. Die NUMA-Sichtbarkeit sollte bei großen VMs allgemein aktiviert sein – Hyper-Vs Virtual NUMA, KVMs Topologie-Flags und die NUMA-Scheduler von VMware sorgen dafür, dass Speicher nahe bei der Recheneinheit bleibt.

- 🧭 Hyper-V: DDA/GPU-P, vNUMA, Storage QoS, geringer Overhead für Windows-Gäste.

- 🧱 Proxmox (KVM/QEMU): VFIO Passthrough, virtio-Treiber, ZFS-Caching, einfache GPU-Zuordnung.

- 🏢 VMware: ausgereifte vGPU- und paravirtualisierte Stacks (PVSCI, VMXNET3), umfassende Beobachtbarkeit.

- 🏛️ Citrix: starke vGPU-Profile und Richtliniensteuerung für gemischte Arbeitslasten.

- 🧪 VirtualBox: gut für Tests, nicht empfohlen für schwere 4K-Arbeitslasten.

| Plattform | GPU-Fähigkeit 🎮 | Festplattenpfad 🔗 | Netzwerkadapter 🌐 | Beste Verwendung |

|---|---|---|---|---|

| Hyper-V | DDA / GPU-P | VHDX auf NVMe; Passthrough-Festplatte | Synthetische NIC | Windows-zentrierte Medienserver |

| Proxmox | VFIO Passthrough | ZFS oder LVM auf NVMe | virtio-net | Heimlabor und Prosumer-Setups |

| VMware | vGPU/DirectPath | vSAN/NVMe, PVSCI | VMXNET3 | Enterprise-Medien-Streaming |

| Citrix | vGPU-Profile | SR-IOV/NVMe | Paravirtual | Mischworkloads aus VDI + Medien |

| VirtualBox | Begrenzt | Dateibasierte VDI | Emuliert/Virtio | Leichte Nutzung und Tests |

Die Auswahl zwischen Plattformen ähnelt breiteren technischen Vergleichen – Abwägungen von Funktionen, Kosten und Ökosystem erinnern an Modell- oder Assistentenvergleiche aus der KI-Welt. Für eine passende Ergänzung, wie Fähigkeitenunterschiede Ergebnisse beeinflussen, lesen Sie ChatGPT vs Gemini Benchmarks.

Leitprinzip: Plattformwahl sollte nach Qualität des Gerätemodells, GPU-Optionen und Klarheit des Speicherpfads erfolgen. Der Rest ist Konfiguration.

Betriebshandbuch: Wann einen Medienserver virtualisieren und wann Bare Metal bleiben

Virtualisierung ermöglicht Konsolidierung, Snapshots und schnelle Wiederherstellung. Bare Metal maximiert Determinismus und Einfachheit. Die Entscheidung hängt von Arbeitslast, Hardware und Wartungszielen ab. Ein Heimserver mit Intel iGPU und wenigen Nutzern profitiert von einer Proxmox- oder Hyper-V-VM mit Quick Sync Passthrough. Ein Boutique-Streaming-Anbieter mit dutzenden gleichzeitigen 4K HDR Transcodierungen bevorzugt möglicherweise dedizierte Hardware – oder eine VM mit kompletter NVIDIA-GPU und gepinnten CPUs, wo die Unterschiede zu Bare Metal nach Feinabstimmung vernachlässigbar sind.

Wartungsdisziplin zahlt sich aus. Halten Sie Firmware (IOMMU/BIOS), GPU-Treiber und paravirtualisierte Treiber auf Host und Gast synchron. Testen Sie mit einer kleinen Auswahl repräsentativer Titel – HEVC HDR10, hochbitratiges H.264 und interlaced Quellen –, um sicherzustellen, dass Encoder-Features sichtbar und stabil in der VM sind. Dokumentieren Sie Anpassungen (Warteschlangentiefe, I/O-Scheduler, RSS), damit Änderungen bei Upgrades nicht verloren gehen.

- 🧪 Arbeitslast bewerten: Spitzen gleichzeitiger Streams, Codec-Mix, Bibliotheksgröße.

- 🧷 Weg wählen: Bare Metal für Einfachheit; VM für Flexibilität und Konsolidierung.

- 🔐 GPU-Strategie: Passthrough für maximale Codec-/Feature-Unterstützung; vGPU für Dichte.

- 📈 Messen: CPU-Bereitschaft %, Festplattenlatenz und fps pro Stream bei Belastung erfassen.

- 🧭 Iterieren: vNUMA, Pinning und QoS anpassen; erneut testen und dokumentieren.

| Szenario | Empfehlung 🧭 | Warum es funktioniert 🎯 | Risiko-Absicherung 🛡️ |

|---|---|---|---|

| Kleiner Haushalt, Intel iGPU | VM mit QSV Passthrough | Niedriger Stromverbrauch, gute Codec-Unterstützung | vCPUs pinnen; vNUMA aktivieren bei >8 vCPUs |

| Prosumer, NVIDIA dGPU | VM mit PCIe Passthrough | Nahe Bare Metal NVENC | Treiberversion fixieren; Thermik überwachen |

| Enterprise Streaming | VMware/Citrix vGPU | Dichte + Management | Profiltests; QoS bei Storage |

| Extreme 4K HDR Gleichzeitigkeit | Bare Metal oder dedizierte VM | Maximale Determinismus | Ingest- und Wiedergabenetzwerke trennen |

Für Interessierte an Orchestrierungs- und Scheduling-Debatten in angrenzenden Bereichen bietet diese Übersicht zu Microsoft Copilot vs ChatGPT Einblicke, wie Fähigkeiten und Lastmuster die Plattformwahl beeinflussen. Ebenso können konzeptionelle Ansätze zum Systemdesign, wie in synthetischen Umgebungen für physikalische KI, das Denken zu Ressourcenisolation schärfen. Dieselben mentalen Modelle, die für komplexe KI- oder Gaming-Streams verwendet werden, skalieren effektiv hinunter auf einen Heim-Server-Rack.

Letzte Faustregel: Virtualisieren, wenn Flexibilität, Backups und Konsolidierung wichtig sind; Bare Metal wählen, wenn absolute Konsistenz unter extremer Last unabdingbar ist.

{“@context”:”https://schema.org”,”@type”:”FAQPage”,”mainEntity”:[{“@type”:”Question”,”name”:”Wie viel Leistung geht typischerweise verloren, wenn ein Medienserver in einer VM läuft?”,”acceptedAnswer”:{“@type”:”Answer”,”text”:”Mit modernen Hypervisoren und paravirtualisierten Treibern sehen viele Setups einen niedrigen einstelligen Overhead bei GPU-beschleunigten Transcodierungen. Speicherintensive Aufgaben wie große Bibliotheksscans leiden am stärksten, wenn virtuelle Festplatten auf langsamen Medien liegen. Die Abstimmung von virtio/VMXNET3, NVMe und vNUMA hält die Ergebnisse nahe an Bare Metal.”}},{“@type”:”Question”,”name”:”Ist GPU-Passthrough für Plex/Jellyfin in einer VM notwendig?”,”acceptedAnswer”:{“@type”:”Answer”,”text”:”Für mehrere 4K-Streams oder HDR-Tonemapping ja – PCIe-Passthrough einer NVIDIA-, AMD- oder Intel-GPU/iGPU bewahrt Encoder-Features und liefert nahezu Bare-Metal-fps. Für leichte, On-Demand 1080p-Arbeiten kann CPU-basierte Transcodierung ausreichen, jedoch steigt der Stromverbrauch und die Wärmeentwicklung.”}},{“@type”:”Question”,”name”:”Welcher Hypervisor ist für einen Heim-Medienserver am besten?”,”acceptedAnswer”:{“@type”:”Answer”,”text”:”Proxmox (KVM/QEMU) und Hyper-V sind beliebt für Heime und kleine Studios, wegen einfacher GPU-Passthroughs und virtio/erweiterter Treiber. VMware und Citrix bieten reichhaltigere vGPU- und Managementoptionen für größere Deployments. VirtualBox eignet sich besser für Tests als für schwere 4K-Arbeitslasten.”}},{“@type”:”Question”,”name”:”Sind NUMA und CPU-Pinning wirklich wichtig fürs Streaming?”,”acceptedAnswer”:{“@type”:”Answer”,”text”:”Ja. Transcodierung belastet Caches und Speicher. vNUMA zu aktivieren und vCPUs zu pinnen reduziert Speicherverkehr zwischen Knoten und Scheduler-Geräusche, stabilisiert fps pro Stream. Die Wirkung steigt mit mehr gleichzeitigen Transcodierungen und größeren VMs.”}},{“@type”:”Question”,”name”:”Welche Monitoring-Metriken zeigen VM-induzierte Engpässe?”,”acceptedAnswer”:{“@type”:”Answer”,”text”:”Überwachen Sie CPU-Bereitschaftszeit, Festplatten-Latenz bei Bibliotheksscans und fps pro Stream beim Transcodieren. Achten Sie auf NIC-Offload-Zähler und Paketverteilung zur Erkennung von Jitter. Diese KPIs zeigen, ob Scheduling, Speicher oder Netzwerk der limitierende Faktor sind.”}}]}Wie viel Leistung geht typischerweise verloren, wenn ein Medienserver in einer VM läuft?

Mit modernen Hypervisoren und paravirtualisierten Treibern sehen viele Setups einen niedrigen einstelligen Overhead bei GPU-beschleunigten Transcodierungen. Speicherintensive Aufgaben wie große Bibliotheksscans leiden am stärksten, wenn virtuelle Festplatten auf langsamen Medien liegen. Die Abstimmung von virtio/VMXNET3, NVMe und vNUMA hält die Ergebnisse nahe an Bare Metal.

Ist GPU-Passthrough für Plex/Jellyfin in einer VM notwendig?

Für mehrere 4K-Streams oder HDR-Tonemapping ja—PCIe-Passthrough einer NVIDIA, AMD oder Intel GPU/iGPU bewahrt Encoder-Features und liefert nahezu Bare-Metal-fps. Für leichte, On-Demand 1080p-Arbeiten kann CPU-basierte Transcodierung ausreichen, jedoch steigt der Stromverbrauch und die Wärmeentwicklung.

Welcher Hypervisor ist für einen Heim-Medienserver am besten?

Proxmox (KVM/QEMU) und Hyper-V sind beliebt für Heime und kleine Studios, wegen einfacher GPU-Passthroughs und virtio/erweiterter Treiber. VMware und Citrix bieten reichhaltigere vGPU- und Managementoptionen für größere Deployments. VirtualBox eignet sich besser für Tests als für schwere 4K-Arbeitslasten.

Sind NUMA und CPU-Pinning wirklich wichtig fürs Streaming?

Ja. Transcodierung belastet Caches und Speicher. vNUMA zu aktivieren und vCPUs zu pinnen reduziert Speicherverkehr zwischen Knoten und Scheduler-Geräusche, stabilisiert fps pro Stream. Die Wirkung steigt mit mehr gleichzeitigen Transcodierungen und größeren VMs.

Welche Monitoring-Metriken zeigen VM-induzierte Engpässe?

Überwachen Sie CPU-Bereitschaftszeit, Festplatten-Latenz bei Bibliotheksscans und fps pro Stream beim Transcodieren. Achten Sie auf NIC-Offload-Zähler und Paketverteilung zur Erkennung von Jitter. Diese KPIs zeigen, ob Scheduling, Speicher oder Netzwerk der limitierende Faktor sind.

No responses yet