Charge de la VM vs. bare metal : l’exécution d’une machine virtuelle peut-elle ralentir un serveur média ?

La performance d’un serveur média est influencée par trois forces : le calcul pour le transcodage, la bande passante de stockage pour les opérations de bibliothèque, et la diffusion réseau. La virtualisation insère un hyperviseur entre le système d’exploitation et le matériel, la question est donc de savoir si cette couche supplémentaire modifie l’équilibre. Sur des plateformes modernes telles que Hyper-V, Proxmox (avec KVM/QEMU), VMware vSphere et Citrix Hypervisor, le coût de base de l’hyperviseur est généralement modeste une fois optimisé. Par exemple, le planificateur et les services d’intégration de Hyper-V sont conçus pour consommer une faible part du CPU, souvent citée à un faible pourcentage à un chiffre pour les tâches de maintenance, laissant la majorité des cycles aux charges de travail. Les serveurs média, cependant, déplacent le goulot d’étranglement selon la charge : les transcodages 4K en direct sollicitent le CPU/GPU, tandis que les grandes analyses de bibliothèques Plex/Jellyfin sollicitent fortement les entrées/sorties disque.

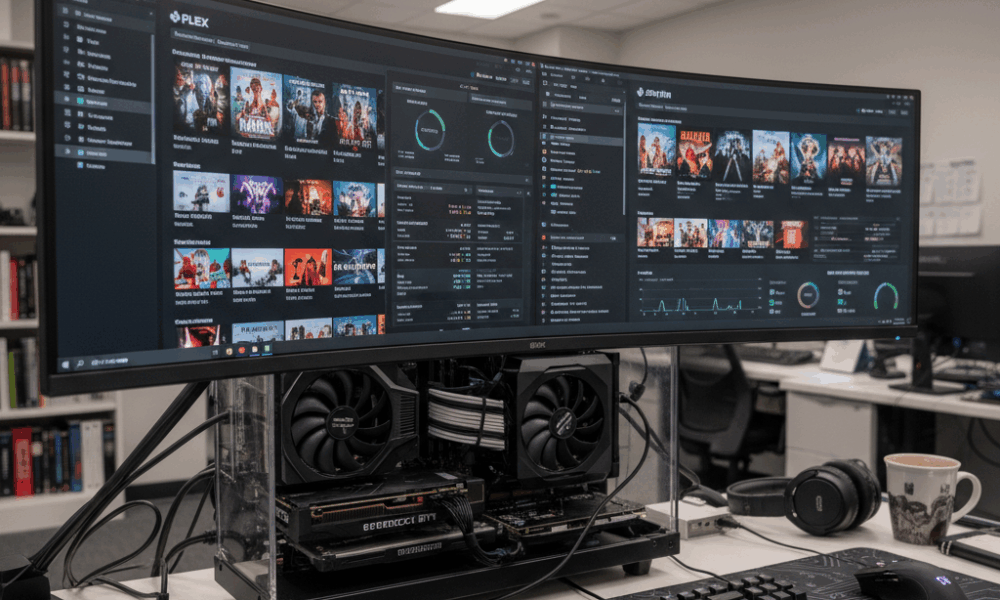

Considérez Beacon Media, une petite équipe de post-production qui a consolidé un serveur Plex et une VM utilitaire Windows sur un seul hôte. Sur bare metal, un transcodage 4K HEVC vers 1080p H.264 soutenait 120 fps en utilisant NVIDIA NVENC. Dans une VM avec passthrough GPU, le débit était à 2-5 % près du bare metal après ajustement des drivers. L’impact plus important survenait lors des actualisations simultanées des métadonnées, lorsque la file d’attente du disque virtuel de la VM s’approfondissait, ajoutant de la latence et augmentant le temps CPU ready. L’idée est simple : la virtualisation affecte rarement les performances de transcodage lorsque le passthrough GPU est bien configuré, mais le stockage et la planification peuvent devenir les nouveaux points de contention si non optimisés.

Les hyperviseurs et modèles de dispositifs différents comptent. Les périphériques émulés sont lents pour les tâches média à haut débit, tandis que les drivers paravirtualisés ou « éclairés » — comme virtio sur KVM/QEMU et les services d’intégration sur Hyper-V — réduisent significativement la surcharge. Sur les invités Windows, supprimer les adaptateurs émulés et les périphériques inutilisés et installer les composants d’intégration les plus récents réduit le travail de fond du CPU. Cela contribue à un service média plus fluide aux heures de pointe.

Les questions clés guident la décision : le serveur effectue-t-il fréquemment plusieurs transcodages 4K ? Une accélération GPU est-elle nécessaire ? La bibliothèque média est-elle massive, causant des opérations d’analyse intensives ? Si la réponse est oui à l’une de ces questions, la VM doit être conçue comme une charge de production, pas un bac à sable de commodité. Cela inclut des ressources CPU épinglées, un stockage NVMe rapide et un réseau paravirtualisé. Avec cela en place, de nombreux laboratoires domestiques et petits studios rapportent une quasi-parité avec le bare metal pour le streaming quotidien.

- 🎯 Base : Attendez-vous à une surcharge CPU à un faible pourcentage à un chiffre pour un hyperviseur moderne bien configuré.

- 🧠 Modèle de périphérique : Préférez virtio (KVM/QEMU) ou drivers éclairés (Hyper-V) aux matériels émulés.

- ⚙️ Forme de la charge : Les transcodages accélérés par GPU dans les VMs peuvent s’approcher du bare metal avec un passthrough approprié.

- 📚 Analyses de bibliothèque : La latence de stockage dans les VMs peut limiter les analyses ; utilisez NVMe et ajustez la profondeur des files d’attente.

- 🌐 Réseau : Les commutateurs virtuels ajoutent une surcharge minimale si les déchargements et RSS sont activés.

| Hyperviseur | Surcharge transcodage (GPU) ⚡ | Tâches intensives disque 📀 | Impact réseau 🌐 | Remarques |

|---|---|---|---|---|

| Hyper-V | ~2–5% avec DDA/GPU-P | Modérée si utilisation de VHDX sur disques lents | Faible avec déchargements vSwitch | Installer les services d’intégration ; éviter les NICs émulées |

| Proxmox (KVM/QEMU) | ~0–5% avec passthrough VFIO | Faible–Modérée avec virtio-scsi/NVMe | Faible avec virtio-net | Utiliser des hugepages, épingler les vCPU pour la cohérence |

| VMware vSphere | ~0–5% avec vGPU/passthrough | Faible avec SCSI paravirtualisé | Faible avec VMXNET3 | Outils excellents pour le monitoring des performances |

| Citrix Hypervisor | ~0–6% avec vGPU | Faible–Modérée | Faible | Stack vGPU robuste en environnements d’entreprise |

| VirtualBox | Plus élevé, support GPU limité | Modéré–Élevé pour I/O lourd | Modéré | Meilleur pour les tests ; pas idéal pour streaming 4K à grande échelle |

En résumé pratique : oui, une VM peut impacter la performance d’un serveur média, mais avec la bonne pile et les bons drivers, l’effet est faible et prévisible – surtout lorsque l’accélération GPU et un stockage rapide sont utilisés.

Réglage CPU, mémoire et NUMA pour le transcodage média dans les VMs

Le transcodage sollicite les caches CPU, la bande passante mémoire et la planification. Sur les hôtes avec des CPU Intel ou AMD, le multithreading simultané (SMT) peut augmenter le débit, mais seulement si la topologie vCPU et la planification des threads sont alignées avec l’hyperviseur. Utilisez un nombre pair de vCPU lorsque SMT est actif, et évitez la surallocation si une latence constante est un objectif. Pour Hyper-V, les processeurs virtuels doivent refléter les évaluations de charge de pointe, pas les moyennes ; lorsque le temps CPU ready augmente, les transcodages saccadent.

L’allocation mémoire interagit avec NUMA. Une VM 24-thread avec 32-64 Go de RAM peut s’étendre sur plusieurs nœuds NUMA physiques. Si le vNUMA est désactivé ou faussé par la mémoire dynamique, un pipeline de transcodage peut sauter entre les nœuds, entraînant des pénalités de mémoire distante. Hyper-V expose par défaut le vNUMA virtuel pour les grosses VMs ; laissez-le activé pour les applications conscientes de NUMA, et évitez la mémoire dynamique lorsque la constance du débit est importante. Sur KVM/QEMU, alignez numactl ou l’épinglage VM avec la topologie de l’hôte pour garder mémoire et vCPU localisés.

Le travail de fond du CPU nuit silencieusement. Les invités inactifs qui exécutent des analyseurs de mise à jour, défragmentation ou indexation volent des cycles au pire moment. Les conseils de Microsoft s’appliquent encore en 2025 : supprimer les NICs émulées, désactiver les tâches planifiées inutiles, garder l’écran de connexion visible en veille, et fermer les consoles de gestion qui sondent constamment les VMs. Ces mesures réduisent la pression sur les interruptions et stabilisent la latence de transcodage.

- 🧩 Épinglez les vCPU aux cœurs/threads physiques pour un fps stable aux heures de pointe.

- 🧮 Respectez le vNUMA : gardez la mémoire locale ; évitez la mémoire dynamique pour les transcodages lourds.

- 🛡️ Services d’intégration : installez les dernières améliorations pour réduire la surcharge CPU liée aux I/O.

- 🧹 Minimisez les tâches de fond : désactivez SuperFetch/Search dans les VMs clientes ; supprimez les périphériques inutilisés.

- ⏱️ Surveillez les indicateurs clés (KPI) : utilisation CPU, file d’attente d’exécution/temps ready, et commutations de contexte par seconde.

| Paramètre | Pourquoi c’est important 🧠 | Impact média 🎬 | Action recommandée ✅ |

|---|---|---|---|

| Nombre de vCPU & épinglage | Réduit les délais de planification | fps plus fluide lors de transcodages multi-flux | Nombres pairs de vCPU avec SMT ; épingler les VMs chaudes |

| Exposition vNUMA | Préserve la localité | Débit soutenu plus élevé sous charge | Activer vNUMA ; éviter la mémoire dynamique pour les grosses VMs |

| Drivers I/O éclairés | Moins de pièges d’émulation | Analyses et écritures DVR plus rapides | Utiliser virtio/VMXNET3/adaptateurs spécifiques Hyper-V |

| Bruits de fond | Libère des cycles CPU | Moins de saccades sous activité par rafales | Désactiver services et tâches planifiées inutiles |

Les planificateurs ne sont pas si différents des planificateurs pour l’entraînement massif d’IA. La contention des ressources et le placement trouvent des analogies dans l’orchestration IA, comme discuté dans ce qu’il faut attendre de la phase d’entraînement de GPT-5 en 2025 où le calcul, la mémoire et l’alignement I/O déterminent le débit. Les mêmes principes s’appliquent à plus petite échelle aux serveurs média domestiques.

Règle pratique : traitez la VM média comme une charge de production, pas comme un compromis de dernier ordre, et les réglages CPU/mémoire cesseront d’être le goulot d’étranglement.

Accélération GPU dans une VM : passthrough, partage vGPU et résultats concrets Plex/Jellyfin

L’accélération matérielle transforme un serveur média de « suffisante » à performant. Dans une VM, il existe deux principales stratégies GPU : passthrough complet du dispositif et partage de GPU virtuel (vGPU). Le passthrough dédie un GPU/iGPU entier NVIDIA, AMD ou Intel à la VM — idéal pour un transcodage NVENC/VCN/QSV constant et proche du bare metal. Le vGPU partage un dispositif entre plusieurs VMs, offrant plus de densité au prix d’une certaine complexité et, parfois, de limitations sur les fonctionnalités codec.

Avec KVM/QEMU (et donc Proxmox), le passthrough VFIO est la solution de référence : il remet le GPU directement à l’invité. Dans VMware, DirectPath I/O et les stacks vGPU des fournisseurs sont mûrs. Citrix a longue expérience du vGPU pour le VDI, applicable aussi au streaming. Hyper-V supporte la Discrete Device Assignment (DDA) et la partition GPU (GPU-P) ; Windows Server 2025 a amélioré la virtualisation GPU pour calcul et graphisme, alignant encore mieux l’accélération VM sur le bare metal.

Le support codec est le vrai différenciateur. Jellyfin/Plex cherchent NVENC, AMD VCE/VCN ou Intel Quick Sync. Le passthrough PCIe préserve ces encodeurs entièrement. Le vGPU peut être plus restrictif selon licences et profils. Sur un iGPU Intel, le passthrough QSV dans Proxmox offre aux foyers un accès économique à plusieurs flux 4K SDR, tandis qu’une carte NVIDIA milieu de gamme permet des décodages HEVC et encodages H.264 simultanés avec une marge pour le tone-mapping. Pour une densité type cloud, le vGPU partage les ressources entre, par exemple, une VM média et une VM d’inférence AI légère, rappelant comment une étude de cas gaming cloud comme ARC Raiders module les tranches de temps GPU pour un streaming à faible latence.

- 🚀 Passthrough (VFIO/DDA/DirectPath) : proche du bare metal ; idéal pour plusieurs transcodages 4K.

- 🧩 vGPU : densité et flexibilité ; vérifiez limitations codec/profil et licences.

- 🔌 Hygiène des drivers : alignez versions drivers hôte, invité, et hyperviseur pour éviter les réinitialisations.

- 🧊 Thermique : les environnements virtualisés chauffent toujours les GPUs ; maintenez un flux d’air pour éviter le throttling.

- 🛠️ Support API : assurez-vous de la visibilité NVENC/QSV/VCN dans l’invité avant de tester les charges.

| Méthode | Hyperviseurs 🧱 | Support codec 🎥 | Performance ⚡ | Cas d’usage |

|---|---|---|---|---|

| Passthrough PCIe | Proxmox/KVM, VMware, Hyper-V (DDA), Citrix | NVENC/QSV/VCN complets | Proche du bare metal | Transcodage intensif Plex/Jellyfin |

| Partage vGPU | VMware, Citrix, Windows GPU-P | Dépendant du profil | Élevé mais pas maximal | Médias mixtes + VDI/inférence AI |

| Repli logiciel | Toutes plateformes | CPU seul | Débit le plus bas | Tests et urgences |

Le choix entre NVIDIA, AMD et Intel dépend des codecs et des objectifs énergétiques. Intel Quick Sync brille pour les foyers à faible consommation. NVIDIA propose un NVENC mature et des outils robustes ; AMD VCN s’est amélioré régulièrement ces dernières générations. Pour un contexte technologique large, la manière dont les GPUs sont multiplexés pour le média reflète l’orchestration des expériences multi-modèles IA, comme les débats dans un comparatif Microsoft Copilot vs ChatGPT et benchmarks ChatGPT vs Gemini — les décisions du planificateur déterminent en fin de compte la vitesse perçue par l’utilisateur.

Stockage et I/O réseau sous virtualisation : scans, DVR et flux 4K

Les charges média sont bimodales : courts pics pendant les analyses de bibliothèque et lectures séquentielles soutenues pendant la lecture. La virtualisation expose le stockage via des disques virtuels (VHDX, qcow2), le mappage direct de périphériques ou des partages réseau. Pour les scans lourds, les virtio-scsi NVMe-backed ou adaptateurs NVMe virtuels réduisent la surcharge d’émulation ; lorsque les fonctions DVR écrivent plusieurs flux simultanés, la QoS stockage empêche qu’une seule VM ne sature le groupe disque. Storage QoS de Hyper-V et le throttling I/O de Proxmox offrent des garde-fous utiles.

Les choix de système de fichiers comptent. Les pools ZFS dans Proxmox offrent un excellent cache de lecture pour les miniatures et métadonnées, mais nécessitent de la mémoire pour être performants. NTFS sur SSD rapide suffit pour les petites bibliothèques, tandis que XFS/ext4 dans les invités Linux assure une latence prévisible. Évitez d’imbriquer trop de couches (ex. un partage réseau dans une VM dont le disque virtuel est sur un autre partage réseau), ce qui augmente la latence. Une chaîne plus simple, par exemple NVMe hôte → disque virtio → système de fichiers invité, garde la latence linéaire et facile à maîtriser.

Côté réseau, les flux 4K HEVC oscillent autour de plusieurs dizaines de Mbps ; un lien 2,5 GbE unique supporte de nombreux utilisateurs concurrents. Les commutateurs virtuels ajoutent une surcharge négligeable quand les déchargements (TSO/LRO), RSS et NICs paravirtualisées (VMXNET3, virtio-net, NIC synthétiques Hyper-V) sont actifs. Surveillez néanmoins la coalescence des paquets et la modération des interruptions pour stabiliser la gigue aux pics nocturnes. Si le serveur média enregistre aussi des flux OTA ou de caméras IP, isolez ce trafic via des VLAN pour éviter les collisions avec la lecture.

- 📦 Privilégiez virtio/VMXNET3 aux NICs émulés ; activez les déchargements checksum et segmentation.

- 💾 Utilisez NVMe ou SSD pour appdata et métadonnées ; stockez les médias lourds sur des disques séparés.

- 📊 Appliquez Storage QoS pour éviter que les pics DVR n’étouffent les threads de lecture.

- 🧯 Évitez la double virtualisation des chemins de stockage pour garder une latence prévisible.

- 🛰️ Segmenter le trafic avec des VLAN pour l’ingestion vs. la lecture ; envisagez le jumbo frames après tests.

| Tâche | Goulot principal 🔍 | Conseil virtualisation 🧰 | Résultat attendu 📈 |

|---|---|---|---|

| Analyse de bibliothèque | I/O aléatoire | NVMe + virtio-scsi, augmenter la profondeur I/O | Construction de métadonnées plus rapide |

| Transcodage 4K HDR | GPU/CPU | Passthrough PCIe, épingler vCPUs | fps proche du bare metal |

| Enregistrement DVR | IOPS écriture | QoS stock + disque séparé | Pas de saccade de lecture sous charge |

| Streaming distant | Bande passante | NIC paravirtualisée + déchargements | Débit stable par utilisateur |

Les choix architecturaux rappellent les techniques employées dans les pipelines à forte simulation, où les mondes virtuels sollicitent I/O et bande passante. Pour une perspective plus large sur comment les charges synthétiques influencent la conception système, voyez cette analyse sur environnements synthétiques pour l’IA physique.

Conclusion : optimisez d’abord les chemins de stockage et le réseau paravirtualisé ; les optimisations de transcodage prennent vie seulement quand I/O et diffusion sont stables.

Vérification de la réalité sur les plateformes : Hyper-V, Proxmox/KVM, VMware, Citrix et VirtualBox

Les différents hyperviseurs présentent une ergonomie distincte pour les serveurs média. Hyper-V s’intègre proprement à Windows, avec une faible surcharge, vNUMA et DDA pour l’accès GPU, plus Storage QoS. Proxmox propose une interface accessible sur KVM/QEMU, avec passthrough VFIO, ZFS et excellents périphériques virtio — populaire dans les laboratoires domestiques pour une bonne raison. VMware vSphere fournit une gestion de pointe et des stacks vGPU denses, tandis que Citrix excelle là où VDI et partage média se croisent. VirtualBox reste un excellent outil de développement mais manque du focus performance nécessaire pour les transcodages 4K en direct multiples.

À quoi ressemblent les résultats mesurés ? Dans les laboratoires 2024–2025, les environnements configurés avec soin rapportent qu’une VM Plex ou Jellyfin avec passthrough affiche un écart d’environ 0–5 % par rapport au bare metal pour le transcodage accéléré GPU. La variabilité vient des réglages BIOS, du comportement IOMMU/ACS et de la maturité des drivers. Pour les opérations intensives disque, déplacer les données d’application sur NVMe et activer les drivers disque paravirtualisés réduit souvent par deux les temps d’analyse par rapport à l’émulation par défaut. Ce ne sont pas des astuces exotiques, mais les bases pour des VMs de niveau production.

L’angle gestion compte aussi. Les hyperviseurs diffèrent sur les valeurs par défaut des timers, interruptions et états de puissance en veille. Microsoft recommande de minimiser l’activité de fond de l’invité et de supprimer les périphériques émulés inutilisés, conseils valables aussi pour KVM et VMware. L’exposition NUMA doit être activée sur les grosses VMs partout — Virtual NUMA de Hyper-V, flags topologiques de KVM, et planificateur NUMA de VMware existent tous pour maintenir la mémoire proche du calcul.

- 🧭 Hyper-V : DDA/GPU-P, vNUMA, Storage QoS, faible surcharge pour invités Windows.

- 🧱 Proxmox (KVM/QEMU) : passthrough VFIO, drivers virtio, cache ZFS, mapping GPU direct.

- 🏢 VMware : stacks vGPU et paravirtualisés mûrs (PVSCI, VMXNET3), observabilité poussée.

- 🏛️ Citrix : profils vGPU forts et contrôle politique pour charges mixtes.

- 🧪 VirtualBox : excellent pour tests ; déconseillé pour charges lourdes 4K.

| Plateforme | Capacité GPU 🎮 | Chemin disque 🔗 | Adaptateur réseau 🌐 | Meilleure adéquation |

|---|---|---|---|---|

| Hyper-V | DDA / GPU-P | VHDX sur NVMe ; disque en passthrough | NIC synthétique | Serveurs média orientés Windows |

| Proxmox | Passthrough VFIO | ZFS ou LVM sur NVMe | virtio-net | Laboratoires domestiques et configurations prosumers |

| VMware | vGPU/DirectPath | vSAN/NVMe, PVSCI | VMXNET3 | Streaming média en entreprise |

| Citrix | Profils vGPU | SR-IOV/NVMe | Paravirtual | Charges mixtes VDI + média |

| VirtualBox | Limité | VDI basé fichier | Émulé/virtio | Usage léger et tests |

Le choix entre plateformes reflète des comparaisons technologiques plus larges : compromis entre fonctionnalités, coûts et écosystèmes similaires aux comparaisons de modèles ou assistants dans le monde l’IA. Pour une lecture parallèle pertinente sur les différences de capacités et leurs impacts, explorez ChatGPT vs Gemini benchmarks.

Principe directeur : le choix de la plateforme doit suivre la qualité du modèle de périphérique, les options GPU et la clarté du chemin de stockage. Le reste est de la configuration.

Manuel opérationnel : quand virtualiser un serveur média et quand rester en bare metal

La virtualisation permet la consolidation, les snapshots et la récupération rapide. Le bare metal maximise la détermination et la simplicité. La décision dépend de la forme de la charge, du matériel et des objectifs de maintenance. Un serveur domestique avec un iGPU Intel et quelques utilisateurs bénéficiera d’une VM Proxmox ou Hyper-V avec passthrough Quick Sync. Un service boutique poussant des dizaines de transcodages 4K HDR simultanés peut privilégier le matériel dédié — ou une VM avec GPU complet NVIDIA et CPUs épinglés, où les différences avec le bare metal deviennent négligeables après optimisation.

La discipline de maintenance rapporte gros. Gardez le firmware (IOMMU/BIOS), les drivers GPU et paravirtualisés alignés entre hôte et invité. Testez avec un petit ensemble de titres représentatifs — HEVC HDR10, H.264 haut débit, et sources entrelacées — pour garantir que les fonctionnalités des encodeurs soient visibles et stables dans la VM. Documentez quels réglages ont changé la donne (profondeur de file d’attente, ordonnanceurs I/O, RSS) afin que les modifications ne se perdent pas lors des mises à jour.

- 🧪 Évaluez la charge : pics de flux simultanés, mix codec, taille de la bibliothèque.

- 🧷 Choisissez une voie : bare metal pour la simplicité ; VM pour la flexibilité et la consolidation.

- 🔐 Stratégie GPU : passthrough pour un accès maximal codec/fonctionnalité ; vGPU pour la densité.

- 📈 Mesurez : suivez le % CPU ready, la latence disque et le fps par flux lors de stress.

- 🧭 Itérez : ajustez vNUMA, épinglage et QoS ; retestez et documentez.

| Scénario | Recommandation 🧭 | Pourquoi ça marche 🎯 | Atténuations risques 🛡️ |

|---|---|---|---|

| Petit foyer, iGPU Intel | VM avec passthrough QSV | Faible consommation, bon support codec | Épingler vCPUs ; activer vNUMA si >8 vCPUs |

| Prosumer, GPU dédié NVIDIA | VM avec passthrough PCIe | NVENC proche bare metal | Verrouillage version driver ; surveiller thermique |

| Streaming entreprise | VMware/Citrix vGPU | Densité + gestion | Tests profils ; QoS stockage |

| Concurrence extrême 4K HDR | Bare metal ou VM dédiée | Détermination maximale | Réseaux ingestion et lecture séparés |

Pour les lecteurs intéressés par comment les débats d’orchestration et de plannification se jouent dans des domaines adjacents, cet aperçu de un comparatif Microsoft Copilot vs ChatGPT montre comment capabilities et charges influencent le choix de plateforme. De même, les notions conceptuelles sur la conception système issues de environnements synthétiques pour l’IA physique peuvent affiner la réflexion sur l’isolation des ressources. Les mêmes modèles mentaux utilisés pour l’IA complexe ou les flux gaming s’appliquent efficacement à un rack domestique.

Dernière règle pratique : virtualisez quand la flexibilité, les sauvegardes et la consolidation comptent ; considérez le bare metal quand la constance absolue sous charge extrême est non négociable.

{« @context »: »https://schema.org », »@type »: »FAQPage », »mainEntity »:[{« @type »: »Question », »name »: »How much performance is typically lost when running a media server in a VM? », »acceptedAnswer »:{« @type »: »Answer », »text »: »With modern hypervisors and paravirtual drivers, many setups see low-single-digit overhead for GPU-accelerated transcodes. Storage-heavy tasks like large library scans suffer most if virtual disks sit on slow media. Tuning virtio/VMXNET3, NVMe, and vNUMA keeps results close to bare metal. »}},{« @type »: »Question », »name »: »Is GPU passthrough necessary for Plex/Jellyfin in a VM? », »acceptedAnswer »:{« @type »: »Answer », »text »: »For multiple 4K streams or HDR tone-mapping, yesu2014PCIe passthrough of an NVIDIA, AMD, or Intel GPU/iGPU preserves encoder features and delivers near bare-metal fps. For light, on-demand 1080p work, CPU-based transcoding may suffice, but power use and thermals can rise. »}},{« @type »: »Question », »name »: »Which hypervisor is best for a home media server? », »acceptedAnswer »:{« @type »: »Answer », »text »: »Proxmox (KVM/QEMU) and Hyper-V are popular for homes and small studios due to straightforward GPU passthrough and virtio/enlightened drivers. VMware and Citrix add richer vGPU and management for larger deployments. VirtualBox is better suited to testing than heavy 4K workloads. »}},{« @type »: »Question », »name »: »Do NUMA and CPU pinning really matter for streaming? », »acceptedAnswer »:{« @type »: »Answer », »text »: »Yes. Transcoding stresses caches and memory. Exposing vNUMA and pinning vCPUs reduces cross-node memory traffic and scheduler noise, stabilizing per-stream fps. The impact grows with more concurrent transcodes and larger VMs. »}},{« @type »: »Question », »name »: »What monitoring metrics reveal VM-induced bottlenecks? », »acceptedAnswer »:{« @type »: »Answer », »text »: »Track CPU ready time, disk latency under library scans, and per-stream transcoding fps. Watch NIC offload counters and packet pacing for jitter. These KPIs identify whether scheduling, storage, or networking is the limiting factor. »}}]}Quelle perte de performance est typiquement observée lors de l’exécution d’un serveur média dans une VM ?

Avec les hyperviseurs modernes et les drivers paravirtualisés, de nombreuses configurations voient une surcharge CPU faible, à un faible pourcentage à un chiffre, pour les transcodages accélérés GPU. Les tâches lourdes en stockage comme les grandes analyses de bibliothèque souffrent le plus si les disques virtuels résident sur des médias lents. L’optimisation de virtio/VMXNET3, NVMe et vNUMA maintient les résultats proches du bare metal.

Le passthrough GPU est-il nécessaire pour Plex/Jellyfin dans une VM ?

Pour plusieurs flux 4K ou le tone-mapping HDR, oui — le passthrough PCIe d’un GPU/iGPU NVIDIA, AMD ou Intel préserve les fonctionnalités des encodeurs et offre un fps proche du bare metal. Pour du travail léger à la demande en 1080p, le transcodage CPU peut suffire, mais la consommation électrique et la gestion thermique peuvent augmenter.

Quel hyperviseur est le meilleur pour un serveur média domestique ?

Proxmox (KVM/QEMU) et Hyper-V sont populaires pour les foyers et petits studios grâce à un passthrough GPU simple et des drivers virtio/éclairés. VMware et Citrix ajoutent des stacks vGPU plus riches et une gestion adaptée aux déploiements plus importants. VirtualBox convient mieux aux tests qu’aux charges lourdes 4K.

NUMA et épinglage CPU comptent-ils vraiment pour le streaming ?

Oui. Le transcodage sollicite caches et mémoire. Exposer le vNUMA et épingler les vCPU réduit le trafic mémoire inter-nœuds et le bruit du planificateur, stabilisant le fps par flux. L’impact augmente avec le nombre de transcodages simultanés et la taille des VMs.

Quels indicateurs de suivi révèlent les goulots induits par la VM ?

Suivez le temps CPU ready, la latence disque lors des analyses de bibliothèque, et le fps par transcodage flux. Surveillez les compteurs de déchargement NIC et la cadence des paquets pour la gigue. Ces KPI identifient si la planification, le stockage ou le réseau sont le facteur limitant.

No responses yet