Overhead della VM vs. bare metal: eseguire una macchina virtuale può rallentare un media server?

Le prestazioni di un media server sono influenzate da tre fattori: potenza di calcolo per il transcoding, larghezza di banda di archiviazione per le operazioni sulla libreria e consegna di rete. La virtualizzazione introduce un hypervisor tra il sistema operativo e l’hardware, quindi la domanda è se quel livello aggiuntivo alteri l’equilibrio. Con piattaforme moderne come Hyper-V, Proxmox (con KVM/QEMU), VMware vSphere e Citrix Hypervisor, il costo base dell’hypervisor è di solito modesto se ben ottimizzato. Per esempio, il scheduler e i servizi di integrazione di Hyper-V sono progettati per consumare una piccola fetta di CPU, spesso indicata intorno a una percentuale a una cifra bassa per le operazioni di mantenimento, lasciando la maggior parte dei cicli ai carichi di lavoro. I media server, tuttavia, spostano il collo di bottiglia a seconda del carico: i transcoding live in 4K mettono sotto pressione CPU/GPU, mentre grandi scansioni di librerie Plex/Jellyfin stressano l’I/O disco.

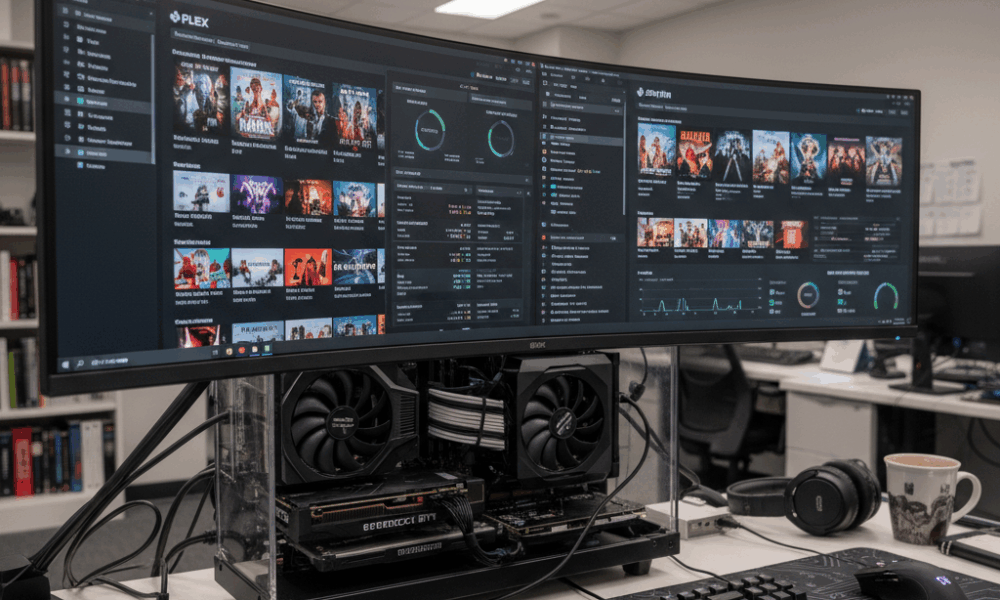

Consideriamo Beacon Media, un piccolo team di post-produzione che ha consolidato un server Plex e una VM utility Windows su un unico host. Su bare metal, un transcode da 4K HEVC a 1080p H.264 ha mantenuto 120 fps usando il NVIDIA NVENC. All’interno di una VM con passthrough GPU, la throughput si attestava entro il 2–5% rispetto al bare metal dopo ottimizzazione dei driver. L’impatto maggiore si è avuto durante aggiornamenti simultanei dei metadata, quando la coda del disco virtuale della VM si è approfondita, aggiungendo latenza e aumentando il tempo CPU ready. La lezione è semplice: la virtualizzazione raramente compromette le prestazioni di transcoding se il passthrough GPU è usato correttamente, ma lo storage e la schedulazione possono diventare i nuovi punti critici se non ottimizzati.

Diversi hypervisor e modelli di dispositivo contano. I dispositivi emulati sono lenti per task media ad alta throughput, mentre driver paravirtual o “enlightened” — come virtio su KVM/QEMU e i servizi di integrazione su Hyper-V — riducono significativamente l’overhead. Su guest Windows, rimuovere adattatori emulati e dispositivi inutilizzati, e installare i componenti di integrazione più recenti, riduce il carico CPU in background. Ciò contribuisce a un servizio media più fluido nelle ore di punta.

Domande chiave guidano la decisione: il server esegue frequentemente transcoding di più stream 4K? È richiesta l’accelerazione GPU? La libreria media è enorme, causando intense operazioni di scansione? Se la risposta è sì a uno qualsiasi di questi, la VM va progettata come un carico di lavoro di produzione, non una sandbox di convenienza. Ciò include CPU riservate, storage NVMe veloce e rete paravirtuale. Con questi elementi, molti home lab e piccoli studi riportano prestazioni quasi equivalenti a bare metal per lo streaming quotidiano.

- 🎯 Base: aspettatevi overhead CPU a una cifra bassa per un hypervisor moderno ben configurato.

- 🧠 Modello dispositivo: preferite virtio (KVM/QEMU) o driver enlightened (Hyper-V) agli hardware emulati.

- ⚙️ Forma del carico: i transcoding GPU-accelerati all’interno di VM possono avvicinarsi al bare metal con un passthrough corretto.

- 📚 Scansioni libreria: la latenza di storage nelle VM può diventare un collo di bottiglia nelle scansioni; usate NVMe e ottimizzate la profondità della coda.

- 🌐 Rete: gli switch virtuali aggiungono un overhead minimo se abilitati offload e RSS.

| Hypervisor | Overhead transcoding (GPU) ⚡ | Task intensi su disco 📀 | Impatto rete 🌐 | Note |

|---|---|---|---|---|

| Hyper-V | ~2–5% con DDA/GPU-P | Moderato se si usa VHDX su dischi lenti | Basso con vSwitch offloads | Installare i servizi di integrazione; evitare NIC emulati |

| Proxmox (KVM/QEMU) | ~0–5% con passthrough VFIO | Basso–Moderato con virtio-scsi/NVMe | Basso con virtio-net | Usare hugepages, pin vCPU per consistenza |

| VMware vSphere | ~0–5% con vGPU/passthrough | Basso con SCSI paravirtuale | Basso con VMXNET3 | Eccellente tool per monitoraggio prestazioni |

| Citrix Hypervisor | ~0–6% con vGPU | Basso–Moderato | Basso | Stack vGPU potente in ambienti enterprise |

| VirtualBox | Più alto, supporto GPU limitato | Moderato–Alto per I/O intensivo | Moderato | Ideale per test; non consigliato per streaming 4K a grande scala |

La conclusione pratica: sì, una VM può influenzare le prestazioni di un media server, ma con la giusta configurazione e i driver corretti, l’effetto è piccolo e prevedibile—soprattutto se in gioco ci sono accelerazione GPU e storage veloce.

CPU, memoria e tuning NUMA per il transcoding media dentro le VM

Il transcoding stressa cache CPU, larghezza di banda della memoria e schedulazione. Su host con CPU Intel o AMD, il multithreading simultaneo (SMT) può aumentare la throughput, ma solo se la topologia vCPU e la schedulazione dei thread sono allineate con l’hypervisor. Usate numeri pari di vCPU quando SMT è attivo, e evitate l’overprovisioning se l’obiettivo è latenza costante. Per Hyper-V, i processori virtuali dovrebbero riflettere valutazioni di carico di picco, non medie; quando i tempi CPU ready aumentano, i transcoding si bloccano.

L’allocazione della memoria interagisce con NUMA. Una VM a 24 thread con 32–64 GB RAM può estendersi su nodi NUMA fisici. Se vNUMA è disabilitato o distorto dalla memoria dinamica, una pipeline di transcoding potrebbe saltare tra nodi, incorrendo in penalità di memoria remota. Hyper-V espone Virtual NUMA di default per VM grandi; lasciatelo attivo per app NUMA-aware, e evitate la memoria dinamica per throughput costante. Su KVM/QEMU, allineate numactl o il pinning della VM con la topologia host per mantenere la memoria e le vCPU locali.

Il carico CPU in background è un nemico silenzioso. Guest inattivi che eseguono scanner di aggiornamenti, defrag o indicizzazione di ricerca ruberanno cicli nei momenti peggiori. Le linee guida Microsoft valgono ancora nel 2025: rimuovere NIC emulati, disabilitare task pianificati inutili, mantenere visibile la schermata di login quando inattivi e chiudere le console di gestione che sondano costantemente le VM. Questi passaggi riducono la pressione sulle interruzioni e stabilizzano la latenza del transcoding.

- 🧩 Pinning delle vCPU su core/thread fisici per fps stabili nelle ore di punta.

- 🧮 Rispetto di vNUMA: mantenere la memoria locale; evitare la memoria dinamica per transcoding pesanti.

- 🛡️ Servizi di integrazione: installare le ultime migliorie per ridurre l’overhead CPU su I/O.

- 🧹 Minimizzare i task in background: disabilitare SuperFetch/Search in VM client; rimuovere dispositivi inutilizzati.

- ⏱️ Monitorare KPI: utilizzo CPU, coda di esecuzione/ready time e switch di contesto al secondo.

| Impostazione | Perché conta 🧠 | Impatto media 🎬 | Azione raccomandata ✅ |

|---|---|---|---|

| Conteggio & pinning vCPU | Riduce ritardi di schedulazione | fps più fluidi durante transcoding multi-stream | Numeri pari di vCPU con SMT; pin VM “calde” |

| Esposizione vNUMA | Preserva la località | Bitrate più alto e sostenuto sotto carico | Abilitare vNUMA; evitare memoria dinamica per grandi VM |

| Driver I/O enlightened | Meno trappole di emulazione | Scansioni più rapide e scritture DVR | Usare virtio/VMXNET3/adattatori specifici Hyper-V |

| Rumore in background | Libera cicli CPU | Meno stutter con carichi a raffica | Disabilitare servizi e task pianificati inutili |

Gli scheduler sono simili ai grandi planner per training AI. Contesa di risorse e posizionamento hanno analogie con l’orchestrazione AI, come discussa in cosa aspettarsi dalla fase di training di GPT-5 nel 2025 dove calcolo, memoria e I/O allineati determinano la throughput. Gli stessi principi valgono su scala minore per media server domestici.

Regola pratica: trattate la VM media come un carico di produzione, non come un ripensamento, e le impostazioni CPU/memoria smetteranno di rappresentare un collo di bottiglia.

Accelerazione GPU in una VM: passthrough, condivisione vGPU e risultati reali Plex/Jellyfin

L’accelerazione hardware trasforma un media server da “abbastanza buono” a una potenza. All’interno di una VM, ci sono due strategie GPU principali: passthrough del dispositivo completo e condivisione GPU virtuale (vGPU). Il passthrough dedica una GPU/iGPU NVIDIA, AMD o Intel interamente alla VM—ideale per transcoding NVENC/VCN/QSV consistenti e vicino al bare-metal. La vGPU condivide un dispositivo tra più VM, offrendo maggiore densità a scapito di complessità e, talvolta, limitazioni su codec e funzionalità.

Con KVM/QEMU (e quindi Proxmox), il passthrough VFIO è lo standard: passa la GPU direttamente al guest. In VMware, sia DirectPath I/O sia gli stack vGPU dei vendor sono maturi. Citrix ha lunga esperienza con vGPU per VDI, applicata anche allo streaming. Hyper-V supporta Discrete Device Assignment (DDA) e partizionamento GPU (GPU-P); Windows Server 2025 ha migliorato la virtualizzazione GPU per calcolo e grafica, allineando ulteriormente l’accelerazione VM ai risultati bare-metal.

Il supporto codec è il vero fattore differenziante. Jellyfin/Plex cercano NVENC, AMD VCE/VCN o Intel Quick Sync. Il passthrough PCIe preserva completamente questi encoder. La vGPU può essere più restrittiva a seconda di licenze e profili. Su un iGPU Intel, il passthrough QSV dentro Proxmox offre alle famiglie una soluzione economica per più stream 4K SDR, mentre una singola scheda NVIDIA di fascia media permette decodifiche HEVC simultanee e codifiche H.264 con flessibilità per il tone-mapping. Per densità cloud-like, la vGPU divide le risorse, per esempio, tra una VM media e una VM AI leggera per inferenza, come nel case study cloud gaming di ARC Raiders che bilancia fette di tempo GPU per uno streaming low-latency.

- 🚀 Passthrough (VFIO/DDA/DirectPath): quasi bare metal; ideale per transcoding multi-4K.

- 🧩 vGPU: densità e flessibilità; verificate limitazioni codec/profilo e licenza.

- 🔌 Igiene driver: allineate versioni driver host, guest e hypervisor per evitare reset.

- 🧊 Termiche: ambienti virtualizzati riscaldano comunque le GPU; mantenete flusso d’aria per evitare throttling.

- 🛠️ Supporto API: assicuratevi che NVENC/QSV/VCN siano visibili nel guest prima di testare i carichi.

| Metodo | Hypervisor 🧱 | Supporto codec 🎥 | Prestazioni ⚡ | Caso d’uso |

|---|---|---|---|---|

| Passthrough PCIe | Proxmox/KVM, VMware, Hyper-V (DDA), Citrix | Full NVENC/QSV/VCN | Quasi bare metal | Transcoding pesante Plex/Jellyfin |

| Condivisione vGPU | VMware, Citrix, Windows GPU-P | Dipendente dal profilo | Alte ma non massime | Mix media + inferenza VDI/AI |

| Fallback software | Tutte le piattaforme | Solo CPU | Throughput più basso | Test e emergenze |

La scelta tra NVIDIA, AMD e Intel dipende da codec e obiettivi energetici. Intel Quick Sync brilla nelle case a basso consumo. NVIDIA offre NVENC maturo e ottimi strumenti; VCN di AMD è migliorato costantemente nelle ultime generazioni. Per un contesto tecnologico più ampio, il modo in cui le GPU sono multiplexate per media riflette l’orchestrazione di esperienze AI multi-modello, come nei dibattiti su confronti Microsoft Copilot vs ChatGPT e benchmark ChatGPT vs Gemini—le decisioni dello scheduler determinano in ultima analisi la velocità percepita dall’utente.

Storage e I/O di rete sotto virtualizzazione: scansioni, DVR e stream 4K

I carichi media sono bimodali: brevi esplosioni durante le scansioni libreria e letture sequenziali sostenute durante la riproduzione. La virtualizzazione espone lo storage attraverso dischi virtuali (VHDX, qcow2), mappatura diretta dispositivo o condivisioni di rete. Per scansioni pesanti, virtio-scsi su NVMe o adattatori NVMe virtuali riducono l’overhead di emulazione; quando le funzioni DVR scrivono più stream simultanei, la QoS di storage impedisce a una singola VM di saturare il gruppo disco. Storage QoS di Hyper-V e lo throttling I/O di Proxmox forniscono utili linee guida.

Le scelte di file system sono importanti. Pool ZFS in Proxmox offrono forte caching in lettura per anteprime e metadata, ma necessitano di memoria per eccellere. NTFS su SSD veloce è sufficiente per librerie piccole, mentre XFS/ext4 dentro guest Linux offre latenza prevedibile. Evitate catene troppo lunghe (per esempio condivisione di rete dentro VM il cui disco virtuale risiede su un’altra condivisione di rete), che aumentano la latenza. Una catena più semplice, come NVMe host → disco virtio → file system guest, mantiene la latenza lineare e facile da gestire.

Dal lato rete, gli stream 4K HEVC sono intorno a decine di Mbps; un singolo link 2.5 GbE gestisce molti utenti concorrenti. Gli switch virtuali aggiungono overhead trascurabile se sono abilitati offload (TSO/LRO), RSS e NIC paravirtuali (VMXNET3, virtio-net, NIC sintetica Hyper-V). Monitorate comunque coalescenza pacchetti e impostazioni di moderazione interruzioni per stabilizzare il jitter nelle notti di picco. Se il media server registra anche OTA o videocamere IP, isolate quel traffico con VLAN per evitare collisioni fra ingest a raffica e riproduzione.

- 📦 Preferite virtio/VMXNET3 a NIC emulati; abilitate checksum e segmentazione offload.

- 💾 Usate NVMe o SSD per appdata e metadata; mettete i media grandi su dischi separati.

- 📊 Applicate Storage QoS per evitare picchi DVR che soffochino i thread di riproduzione.

- 🧯 Evitate doppia virtualizzazione dei percorsi di storage per mantenere latenza prevedibile.

- 🛰️ Segmentate il traffico con VLAN per ingest e riproduzione; considerate jumbo frames dopo test.

| Task | Collo di bottiglia principale 🔍 | Consiglio virtualizzazione 🧰 | Risultato atteso 📈 |

|---|---|---|---|

| Scansione libreria | I/O casuale | NVMe + virtio-scsi, aumentare profondità coda I/O | Costruzione metadata più veloce |

| Transcoding 4K HDR | GPU/CPU | Passthrough PCIe, pinning vCPU | fps quasi bare-metal |

| Registrazione DVR | Write IOPS | Storage QoS + disco separato | Nessuno stutter di riproduzione sotto carico |

| Streaming remoto | Larghezza di banda | NIC paravirtuale + offload | Bitrate stabili per utente |

Le scelte architetturali rispecchiano tecniche usate in pipeline pesanti di simulazione, dove mondi virtuali stressano I/O e larghezza di banda. Per un’analisi più ampia su come workload sintetici influenzano il design di sistema, vedete questa prospettiva su ambienti sintetici per AI fisica.

Conclusione: ottimizzate prima i percorsi di storage e rete paravirtuale; le ottimizzazioni del transcoding si concretizzano solo con I/O e consegna stabili.

Controllo della realtà tra piattaforme: Hyper-V, Proxmox/KVM, VMware, Citrix e VirtualBox

Diversi hypervisor offrono ergonomia differente per media server. Hyper-V si integra bene con Windows, con overhead basso, vNUMA, DDA per accesso GPU e Storage QoS. Proxmox offre un’interfaccia accessibile sopra KVM/QEMU, con passthrough VFIO, ZFS e ottimi dispositivi virtio — popolare negli home lab per una ragione. VMware vSphere fornisce la migliore gestione e stack vGPU per configurazioni dense, mentre Citrix eccelle dove VDI e condivisione media si incrociano. VirtualBox rimane ottimo per sviluppatori ma manca del focus sulle prestazioni richiesto per transcoding live multi-4K.

Come si presentano i risultati misurati? In laboratori dal 2024 al 2025, ambienti configurati con cura riportano che una VM Plex o Jellyfin con passthrough mostra un gap di ~0–5% rispetto al bare metal per transcoding accelerato GPU. La variabilità dipende da impostazioni BIOS, comportamento IOMMU/ACS e maturità driver. Per operazioni intensi su disco, spostare appdata su NVMe e abilitare driver disco paravirtuali di solito dimezza i tempi di scansione rispetto all’emulazione di default. Non sono trucchi esotici; sono strumenti base per VM di livello produttivo.

L’angolo di gestione conta anche. Gli hypervisor differiscono per default in timer, interruzioni e stati di potenza a riposo. Microsoft raccomanda di minimizzare le attività in background del guest e rimuovere dispositivi emulati inutilizzati; consigli che valgono anche per KVM e VMware. L’esposizione NUMA dovrebbe essere abilitata sulle VM grandi ovunque—Virtual NUMA di Hyper-V, flag di topologia KVM e scheduler NUMA di VMware esistono tutti per mantenere la memoria vicina al calcolo.

- 🧭 Hyper-V: DDA/GPU-P, vNUMA, Storage QoS, overhead basso per guest Windows.

- 🧱 Proxmox (KVM/QEMU): passthrough VFIO, driver virtio, caching ZFS, mapping GPU semplice.

- 🏢 VMware: stack vGPU e paravirtual maturi (PVSCI, VMXNET3), ottima osservabilità.

- 🏛️ Citrix: profili vGPU solidi e controllo policy per workload misti.

- 🧪 VirtualBox: ottimo per test; non raccomandato per carichi 4K pesanti.

| Piattaforma | Capacità GPU 🎮 | Percorso disco 🔗 | Adattatore rete 🌐 | Miglior utilizzo |

|---|---|---|---|---|

| Hyper-V | DDA / GPU-P | VHDX su NVMe; disco pass-through | NIC Sintetica | Media server centrati su Windows |

| Proxmox | Passthrough VFIO | ZFS o LVM su NVMe | virtio-net | Home lab e configurazioni prosumer |

| VMware | vGPU/DirectPath | vSAN/NVMe, PVSCI | VMXNET3 | Streaming media enterprise |

| Citrix | Profili vGPU | SR-IOV/NVMe | Paravirtuale | Workload misti VDI + media |

| VirtualBox | Limitato | VDI file-backed | Emulato/virtio | Uso leggero e test |

La scelta tra piattaforme riflette confronti tecnologici più ampi—compromessi su funzionalità, costi e ecosistema ricordano i confronti tra modelli o assistenti nel mondo AI. Per una lettura laterale rilevante su come differenze di capacità influenzano i risultati, esplorate benchmark ChatGPT vs Gemini.

Principio guida: la scelta della piattaforma dovrebbe seguire la qualità del modello dispositivo, le opzioni GPU e la chiarezza del percorso storage. Il resto è configurazione.

Playbook operativo: quando virtualizzare un media server e quando restare bare metal

La virtualizzazione abilita consolidamento, snapshot e recupero rapido. Il bare metal massimizza determinismo e semplicità. La decisione dipende dalla forma del carico, dall’hardware e dagli obiettivi di manutenzione. Un server domestico con un iGPU Intel e pochi utenti beneficia di una VM Proxmox o Hyper-V con passthrough Quick Sync. Un’operazione di streaming boutique con decine di transcoding 4K HDR simultanei può preferire hardware dedicato—o una VM con GPU completa NVIDIA e CPU riservate, dove le differenze dal bare metal diventano trascurabili dopo tuning.

La disciplina nella manutenzione paga dividendi. Mantenete allineati firmware (IOMMU/BIOS), driver GPU e driver paravirtual tra host e guest. Testate con un piccolo set di titoli rappresentativi—HEVC HDR10, H.264 ad alto bitrate, e sorgenti interlacciate—per assicurarvi che le funzionalità dell’encoder siano visibili e stabili nella VM. Documentate quali settaggi hanno fatto la differenza (profondità coda, scheduler I/O, RSS) così da non perdere le modifiche negli aggiornamenti.

- 🧪 Valutare il carico: picco di stream concorrenti, mix codec, dimensione libreria.

- 🧷 Scegliere una strada: bare metal per semplicità; VM per flessibilità e consolidamento.

- 🔐 Strategia GPU: passthrough per massimo accesso codec/funzionalità; vGPU per densità.

- 📈 Misurare: monitorare CPU ready %, latenza disco e fps per stream sotto stress.

- 🧭 Iterare: regolare vNUMA, pinning e QoS; ritestare e documentare.

| Scenario | Raccomandazione 🧭 | Perché funziona 🎯 | Mitigazioni rischio 🛡️ |

|---|---|---|---|

| Piccola casa, iGPU Intel | VM con passthrough QSV | Basso consumo, buon supporto codec | Pinning vCPU; abilitare vNUMA se >8 vCPU |

| Prosumer, dGPU NVIDIA | VM con passthrough PCIe | NVENC quasi bare-metal | Bloccare versione driver; monitorare termiche |

| Streaming enterprise | VMware/Citrix vGPU | Densità + gestione | Test profili; QoS su storage |

| Concorrenza estrema 4K HDR | Bare metal o VM dedicata | Determinismo massimo | Reti ingest e riproduzione separate |

Per chi è interessato a come dibattiti su orchestrazione e schedulazione si riflettano in domini adiacenti, questa panoramica di un confronto Microsoft Copilot vs ChatGPT mostra come capacità e pattern di carico guidino la scelta della piattaforma. Allo stesso modo, le riflessioni sul design di sistema da ambienti sintetici per AI fisica possono affinare il pensiero sull’isolamento delle risorse. Gli stessi modelli mentali usati per AI complesse o streaming gaming si applicano efficacemente anche a un rack domestico.

Regola d’oro finale: virtualizzate quando contano flessibilità, backup e consolidamento; scegliete bare metal quando la coerenza assoluta sotto carichi estremi è imprescindibile.

{“@context”:”https://schema.org”,”@type”:”FAQPage”,”mainEntity”:[{“@type”:”Question”,”name”:”Quanto si perde tipicamente in termini di prestazioni eseguendo un media server in una VM?”,”acceptedAnswer”:{“@type”:”Answer”,”text”:”Con hypervisor moderni e driver paravirtuali, molte configurazioni mostrano un overhead a una cifra bassa per transcoding accelerato GPU. I task intensi su storage, come grandi scansioni della libreria, soffrono di più se i dischi virtuali sono su media lenti. Ottimizzare virtio/VMXNET3, NVMe e vNUMA mantiene risultati vicini al bare metal.”}},{“@type”:”Question”,”name”:”Il passthrough GPU è necessario per Plex/Jellyfin in una VM?”,”acceptedAnswer”:{“@type”:”Answer”,”text”:”Per multiple stream 4K o tone-mapping HDR, sì—il passthrough PCIe di una GPU/iGPU NVIDIA, AMD o Intel conserva le funzionalità dell’encoder e offre fps quasi bare-metal. Per lavoro leggero on-demand a 1080p, il transcoding CPU può bastare, ma consumo e termiche aumentano.”}},{“@type”:”Question”,”name”:”Qual è il miglior hypervisor per un media server domestico?”,”acceptedAnswer”:{“@type”:”Answer”,”text”:”Proxmox (KVM/QEMU) e Hyper-V sono popolari per case e piccoli studi grazie al passthrough GPU semplice e ai driver virtio/enlightened. VMware e Citrix aggiungono vGPU più ricche e gestione per installazioni più grandi. VirtualBox è più adatto a test che a carichi pesanti 4K.”}},{“@type”:”Question”,”name”:”NUMA e pinning CPU sono davvero importanti per lo streaming?”,”acceptedAnswer”:{“@type”:”Answer”,”text”:”Sì. Il transcoding stressa cache e memoria. Esporre vNUMA e pinning delle vCPU riduce traffico tra nodi e rumore dello scheduler, stabilizzando fps per stream. L’impatto cresce con più transcoding concorrenti e VM più grandi.”}},{“@type”:”Question”,”name”:”Quali metriche di monitoraggio rivelano i colli di bottiglia causati dalla VM?”,”acceptedAnswer”:{“@type”:”Answer”,”text”:”Monitorare tempo CPU ready, latenza disco durante le scansioni libreria e fps per streaming durante transcoding. Controllare conteggi offload NIC e pacing dei pacchetti per jitter. Questi KPI indicano se il limite è schedulazione, storage o rete.”}}]}Quanto si perde tipicamente in termini di prestazioni eseguendo un media server in una VM?

Con hypervisor moderni e driver paravirtuali, molte configurazioni mostrano un overhead a una cifra bassa per transcoding accelerato GPU. I task intensi su storage, come grandi scansioni della libreria, soffrono di più se i dischi virtuali sono su media lenti. Ottimizzare virtio/VMXNET3, NVMe e vNUMA mantiene risultati vicini al bare metal.

Il passthrough GPU è necessario per Plex/Jellyfin in una VM?

Per multiple stream 4K o tone-mapping HDR, sì—il passthrough PCIe di una GPU/iGPU NVIDIA, AMD o Intel conserva le funzionalità dell’encoder e offre fps quasi bare-metal. Per lavoro leggero on-demand a 1080p, il transcoding CPU può bastare, ma consumo e termiche aumentano.

Qual è il miglior hypervisor per un media server domestico?

Proxmox (KVM/QEMU) e Hyper-V sono popolari per case e piccoli studi grazie al passthrough GPU semplice e ai driver virtio/enlightened. VMware e Citrix aggiungono vGPU più ricche e gestione per installazioni più grandi. VirtualBox è più adatto a test che a carichi pesanti 4K.

NUMA e pinning CPU sono davvero importanti per lo streaming?

Sì. Il transcoding stressa cache e memoria. Esporre vNUMA e pinning delle vCPU riduce traffico tra nodi e rumore dello scheduler, stabilizzando fps per stream. L’impatto cresce con più transcoding concorrenti e VM più grandi.

Quali metriche di monitoraggio rivelano i colli di bottiglia causati dalla VM?

Monitorare tempo CPU ready, latenza disco durante le scansioni libreria e fps per streaming durante transcoding. Controllare conteggi offload NIC e pacing dei pacchetti per jitter. Questi KPI indicano se il limite è schedulazione, storage o rete.

No responses yet