Накладные расходы виртуальной машины против bare metal: может ли запуск виртуальной машины замедлить медиасервер?

Производительность медиасервера формируется тремя силами: вычислительные ресурсы для транскодирования, пропускная способность хранилища для операций с библиотекой и сетевые доставки. Виртуализация вставляет гипервизор между операционной системой и оборудованием, поэтому вопрос в том, изменяет ли этот дополнительный слой баланс. На современных платформах, таких как Hyper-V, Proxmox (с KVM/QEMU), VMware vSphere и Citrix Hypervisor, базовая стоимость гипервизора обычно невелика при правильной настройке. Например, планировщик и сервисы интеграции Hyper-V разработаны так, чтобы потреблять небольшой процент ЦП, часто оцениваемый в низких однозначных процентах на системное обслуживание, оставляя большинство циклов для рабочих нагрузок. Однако узкое место медиа серверов смещается в зависимости от нагрузки: живые 4K транскодирования нагружают ЦП/ГП, в то время как крупные сканирования библиотек Plex/Jellyfin сильно нагружают ввод-вывод на диск.

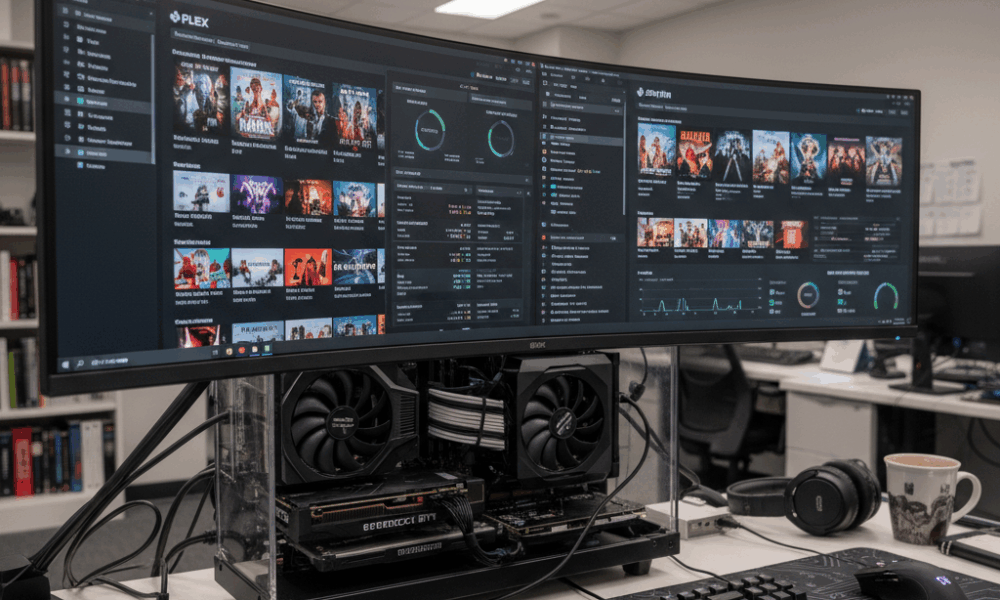

Рассмотрим Beacon Media, маленькую команду пост-продакшена, которая объединила Plex сервер и утилиту Windows VM на одном хосте. На bare metal транскодирование 4K HEVC в 1080p H.264 выдерживало 120 кадров в секунду с использованием NVIDIA NVENC. Внутри ВМ с GPU passthrough производительность была в пределах 2–5% от bare metal после настройки драйверов. Большое влияние наблюдалось во время одновременного обновления метаданных, когда виртуальная очередь дисков ВМ увеличивалась, что добавляло задержку и вызывало всплеск времени ожидания ЦП. Вывод прост: виртуализация редко снижает производительность транскодирования при правильном использовании GPU passthrough, но хранилище и планирование могут стать новыми узкими местами при отсутствии настройки.

Различные гипервизоры и модели устройств имеют значение. Эмулированные устройства медленны для задач с большой пропускной способностью медиа, в то время как паравиртуальные или «просветленные» драйверы — как virtio на KVM/QEMU и интеграционные сервисы Hyper-V — значительно уменьшают накладные расходы. На гостях Windows удаление эмулированных адаптеров и неиспользуемых устройств, а также установка последних компонентов интеграции снижает фоновые нагрузки ЦП. Это способствует более плавной работе медиа сервера в часы пик.

Ключевые вопросы помогают принять решение: часто ли сервер транскодирует несколько 4K потоков? Требуется ли ускорение на GPU? Библиотека медиа огромна, вызывая интенсивные операции сканирования? Если на любой из них ответ «да», ВМ должна быть настроена как производственная нагрузка, а не просто песочница для удобства. Это включает закреплённые ресурсы ЦП, быстрое NVMe хранилище и паравиртуальную сеть. При наличии этих условий многие домашние лаборатории и небольшие студии сообщают о почти полной близости к bare metal в повседневном стриминге.

- 🎯 Базовый уровень: ожидайте низкие однозначные проценты накладных расходов ЦП для современного гипервизора при правильной настройке.

- 🧠 Модель устройства: отдавайте предпочтение virtio (KVM/QEMU) или просветлённым драйверам (Hyper-V) вместо эмулированного оборудования.

- ⚙️ Форма нагрузки: GPU-ускоренные транскоды внутри ВМ могут быть близки к bare metal при правильном passthrough.

- 📚 Сканирование библиотек: задержка хранилища в ВМ может стать узким местом для сканирований; используйте NVMe и настройте глубину очереди.

- 🌐 Сеть: виртуальные коммутаторы добавляют минимальные накладные расходы при включённых offloads и RSS.

| Гипервизор | Накладные расходы транскодирования (GPU) ⚡ | Задачи с высокой нагрузкой на диск 📀 | Влияние на сеть 🌐 | Примечания |

|---|---|---|---|---|

| Hyper-V | ~2–5% с DDA/GPU-P | Умеренное при использовании VHDX на медленных дисках | Низкое с vSwitch offloads | Установить интеграционные сервисы; избегать эмулированных NIC |

| Proxmox (KVM/QEMU) | ~0–5% с VFIO passthrough | Низкое–Умеренное с virtio-scsi/NVMe | Низкое с virtio-net | Использовать hugepages, закреплять vCPU для стабильности |

| VMware vSphere | ~0–5% с vGPU/passthrough | Низкое с паравиртуальным SCSI | Низкое с VMXNET3 | Отличные средства мониторинга производительности |

| Citrix Hypervisor | ~0–6% с vGPU | Низкое–Умеренное | Низкое | Сильный vGPU стек в корпоративных настройках |

| VirtualBox | Выше, ограниченная поддержка GPU | Умеренно–Высокая при тяжелых I/O | Умеренное | Лучше для тестирования; не подходит для масштабного 4K стриминга |

Практический вывод: да, ВМ может влиять на производительность медиасервера, но при правильном стеке и драйверах эффект невелик и предсказуем — особенно при использовании GPU-ускорения и быстрого хранилища.

Настройка CPU, памяти и NUMA для медиа-транскодирования внутри ВМ

Транскодирование нагружает кэши ЦП, полосу пропускания памяти и планирование. На хостах с процессорами Intel или AMD одновременная многопоточность (SMT) может повысить пропускную способность, но только если топология vCPU и планирование потоков согласованы с гипервизором. Используйте чётное количество vCPU, когда SMT включён, и избегайте избыточного выделения ресурсов, если целью является стабильная задержка. Для Hyper-V виртуальные процессоры должны отражать оценки пиковых нагрузок, а не средние значения; при увеличении времени ожидания ЦП транскодирование начинает прерываться.

Распределение памяти взаимодействует с NUMA. Виртуальная машина с 24 потоками и 32–64 ГБ ОЗУ может охватывать физические NUMA-узлы. Если vNUMA отключён или искажен динамической памятью, транскодирующий конвейер может «прыгать» между узлами, неся штрафы за удалённый доступ к памяти. Hyper-V по умолчанию показывает Виртуальный NUMA для больших ВМ; оставляйте его включённым для NUMA-ориентированных приложений и избегайте динамической памяти, если нужна стабильная пропускная способность. В KVM/QEMU следует согласовывать numactl или закрепление ВМ с топологией хоста, чтобы держать память и vCPU локальными.

Фоновая нагрузка на CPU может незаметно повредить производительности. Идл-гости, запускающие сканеры обновлений, дефрагментацию или индексирование поиска, могут уводить циклы CPU в самый неподходящий момент. Рекомендации Microsoft по-прежнему актуальны в 2025 году: удалите эмулированные NIC, отключите ненужные планировщики задач, держите экран входа в систему видимым в простое и закрывайте консоли управления, которые постоянно опрашивают ВМ. Эти меры снижают нагрузку на прерывания и стабилизируют задержки транскодирования.

- 🧩 Закрепляйте vCPU на физических ядрах/потоках для стабильной частоты кадров в часы пик.

- 🧮 Учитывайте vNUMA: держите память локальной; избегайте динамической памяти для тяжёлых транскодов.

- 🛡️ Сервисы интеграции: устанавливайте последние улучшения для снижения нагрузок ЦП на I/O.

- 🧹 Минимизируйте фоновые задачи: отключайте SuperFetch/Search в клиентских ВМ; удаляйте неиспользуемые устройства.

- ⏱️ Мониторьте КПЭ: загрузку CPU, очередь выполнения/время ожидания и переключения контекста в секунду.

| Настройка | Почему это важно 🧠 | Влияние на медиа 🎬 | Рекомендуемое действие ✅ |

|---|---|---|---|

| Количество vCPU и закрепление | Снижает задержки планирования | Плавные fps при многопоточных транскодах | Чётное число vCPU при SMT; закреплять горячие ВМ |

| Экспозиция vNUMA | Сохраняет локальность | Более высокая стабильная битрейт под нагрузкой | Включить vNUMA; избегать динамической памяти для больших ВМ |

| Просветленные I/O драйверы | Меньше ловушек эмуляции | Быстрее сканирование и запись DVR | Использовать virtio/VMXNET3/специфичные адаптеры Hyper-V |

| Фоновый шум | Освобождает циклы ЦП | Меньше дерганий при прерывистой активности | Отключить ненужные службы и планировщики задач |

Планировщики не сильно отличаются от крупных планировщиков обучения ИИ. Ресурсная конкуренция и размещение имеют аналогии с оркестровкой ИИ, как видно в обсуждениях чего ожидать от фазы обучения GPT-5 в 2025, где вычисления, память и I/O влияют на пропускную способность. Те же принципы применимы в меньшем масштабе к домашним медиасерверам.

Практическое правило: обращайтесь с медиавиртуальной машиной как с производственной нагрузкой, а не как с последующей мыслью, и настройки CPU/памяти перестанут быть узким местом.

GPU-ускорение в ВМ: passthrough, совместное использование vGPU и реальные результаты Plex/Jellyfin

Аппаратное ускорение превращает медиасервер из «достаточно хорошего» в мощный инструмент. Внутри ВМ существуют две основные стратегии GPU: полное выделение устройства (passthrough) и виртуальное GPU (vGPU) с совместным использованием. Passthrough выделяет целый NVIDIA, AMD или Intel GPU/iGPU ВМ — лучше всего для стабильного, близкого к bare metal транскодирования NVENC/VCN/QSV. vGPU делит устройство между несколькими ВМ, предлагая большую плотность за счёт некоторой сложности и, иногда, ограничений в поддержке кодеков.

С KVM/QEMU (а значит и Proxmox) VFIO passthrough является рабочей лошадкой: он напрямую передаёт GPU гостю. В VMware и DirectPath I/O, и vGPU-стэки от производителей зрелы. Citrix давно работает с vGPU для VDI, что также применяется к стримингу. Hyper-V поддерживает Discrete Device Assignment (DDA) и разделение GPU (GPU-P); Windows Server 2025 улучшил виртуализацию GPU для вычислений и графики, ещё больше приближая ускорение ВМ к bare metal.

Поддержка кодеков — это главный фактор различия. Jellyfin/Plex ориентируются на NVENC, AMD VCE/VCN или Intel Quick Sync. PCIe passthrough полностью сохраняет эти энкодеры. vGPU может быть более ограниченным в зависимости от лицензирования и профилей. На Intel iGPU passthrough QSV внутри Proxmox даёт домашним пользователям доступный путь к нескольким 4K SDR потокам, в то время как одна среднеуровневая NVIDIA карта обеспечивает одновременные декодирования HEVC и кодирования H.264 с возможностью тональной коррекции. Для плотности, похожей на облачную, vGPU распределяет ресурсы между, например, медиавиртуальной машиной и лёгкой AI inference ВМ, напоминающей, как облачный кейс ARC Raiders балансирует тайм-слайсы GPU для низколатентного стриминга.

- 🚀 Passthrough (VFIO/DDA/DirectPath): близко к bare metal; идеально для множественных 4K транскодов.

- 🧩 vGPU: плотность и гибкость; проверяйте ограничения кодеков/профилей и лицензии.

- 🔌 Гигиена драйверов: согласовывайте версии драйверов хоста, гостя и гипервизора, чтобы избежать сбросов.

- 🧊 Термика: виртуализированные среды всё равно нагревают GPU; обеспечьте вентиляцию для предотвращения троттлинга.

- 🛠️ Поддержка API: убедитесь, что NVENC/QSV/VCN видны внутри гостя до тестирования нагрузок.

| Метод | Гипервизоры 🧱 | Поддержка кодеков 🎥 | Производительность ⚡ | Сценарий использования |

|---|---|---|---|---|

| PCIe passthrough | Proxmox/KVM, VMware, Hyper-V (DDA), Citrix | Полная поддержка NVENC/QSV/VCN | Близко к bare metal | Интенсивное транскодирование Plex/Jellyfin |

| vGPU sharing | VMware, Citrix, Windows GPU-P | Зависит от профиля | Высокая, но не максимальная | Смешанные медиа + VDI/AI inference |

| Программное резервирование | Все платформы | Только ЦП | Самый низкий throughput | Тестирование и экстренные случаи |

Выбор между NVIDIA, AMD и Intel зависит от кодеков и целевых энергозатрат. Intel Quick Sync выделяется для домашних систем с низким энергопотреблением. NVIDIA предлагает зрелый NVENC и мощные инструменты; VCN от AMD стабильно улучшался в последних поколениях. В более широком техническом контексте способ мультиплексирования GPU для медиа отражает оркестрацию многомодельных AI, подобно обсуждениям в сравнении Microsoft Copilot и ChatGPT и тестах ChatGPT vs Gemini — решения планировщика в конечном счёте определяют восприятие скорости пользователем.

Хранение и сетевой ввод-вывод под виртуализацией: сканирование, DVR и 4K-потоки

Медиа нагрузки двуфазные: короткие всплески при сканировании библиотек и длительные последовательные чтения при воспроизведении. Виртуализация предоставляет доступ к хранилищу через виртуальные диски (VHDX, qcow2), прямое отображение устройств или сетевые шары. Для интенсивных сканирований NVMe-ускоренные virtio-scsi или виртуальные NVMe-адаптеры снижают накладные расходы эмуляции; когда функции DVR записывают несколько одновременных потоков, QoS хранилища предотвращает монополию одной ВМ на дисковую группу. Storage QoS Hyper-V и I/O throttling Proxmox предоставляют полезные ограничения.

Выбор файловой системы важен. ZFS пулы в Proxmox обеспечивают сильное кэширование чтения для миниатюр и метаданных, но требуют памяти для эффективной работы. NTFS на быстром SSD достаточен для небольших библиотек, тогда как XFS/ext4 внутри Linux-гостей обеспечивает предсказуемую задержку. Избегайте излишней вложенности (например, сетевая шара внутри ВМ, чей виртуальный диск находится в другой сетевой шаре), это увеличивает задержки. Более простая цепочка, такая как NVMe хоста → virtio диск → файловая система гостя, сохраняет линейную задержку и понятность.

Сетевой трафик 4K HEVC колеблется в пределах десятков Мбит/с; один 2.5 GbE линк справляется с множеством одновременных пользователей. Виртуальные коммутаторы добавляют незначительные накладные расходы, если активированы offloads (TSO/LRO), RSS и паравиртуальные NIC (VMXNET3, virtio-net, синтетические NIC Hyper-V). При этом мониторьте объединение пакетов и настройки модерации прерываний для стабилизации джиттера в пиковые ночные часы. Если медиасервер также записывает OTA или IP-камеры, изолируйте этот трафик с помощью VLAN, чтобы избежать конфликтов всплесков ingest и воспроизведения.

- 📦 Предпочитайте virtio/VMXNET3 вместо эмулированных NIC; включайте offloads для контрольных сумм и сегментации.

- 💾 Используйте NVMe или SSD для appdata и метаданных; большие медиа храните на отдельных дисках.

- 📊 Применяйте Storage QoS, чтобы предотвратить торможение воспроизведения из-за пиков DVR.

- 🧯 Избегайте двойной виртуализации путей хранения для предсказуемой задержки.

- 🛰️ Сегментируйте трафик с помощью VLAN для ingest и воспроизведения; после тестирования рассмотрите jumbo frames.

| Задача | Основное узкое место 🔍 | Совет по виртуализации 🧰 | Ожидаемый результат 📈 |

|---|---|---|---|

| Сканирование библиотеки | Случайный ввод-вывод | NVMe + virtio-scsi, увеличить глубину очереди I/O | Быстрое построение метаданных |

| Транскодирование 4K HDR | GPU/ЦП | PCIe passthrough, закреплять vCPU | Почти bare-metal fps |

| Запись DVR | Запись IOPS | Storage QoS + отдельный диск | Отсутствие дерганий воспроизведения под нагрузкой |

| Удалённый стриминг | Пропускная способность | Паравиртуальная NIC + offloads | Стабильные битрейты на пользователя |

Выбор архитектуры напоминает методы из нагрузок на симуляции, где виртуальные миры нагружают ввод-вывод и полосу пропускания. Для более широкого взгляда на влияние синтетических нагрузок на дизайн систем смотрите эту статью о синтетических средах для физического ИИ.

Итог: сначала оптимизируйте пути хранения и паравиртуальную сеть; оптимизации транскодирования оживают, только когда ввод-вывод и доставка стабильны.

Реальность на разных платформах: Hyper-V, Proxmox/KVM, VMware, Citrix и VirtualBox

Разные гипервизоры предлагают разные эргономичные особенности для медиасерверов. Hyper-V плотно интегрируется с Windows, имеет низкие накладные расходы, vNUMA и DDA для доступа к GPU, а также Storage QoS. Proxmox предоставляет удобный UI поверх KVM/QEMU с VFIO passthrough, ZFS и отличными устройствами virtio — популярен в домашних лабораториях не зря. VMware vSphere предлагает лучшее управление и vGPU стеки для плотных развёртываний, а Citrix сильна там, где пересекаются VDI и медиа совместная работа. VirtualBox остаётся отличным инструментом для разработки, но не имеет производительности для массовых многопоточных 4K транскодирований.

Какие результаты наблюдаются на практике? В лабораториях 2024–2025 годов хорошо настроенные системы сообщают, что Plex или Jellyfin VM с passthrough показывают ~0–5% отставания от bare metal при GPU-ускоренном транскодировании. Колебания зависят от настроек BIOS, поведения IOMMU/ACS и зрелости драйверов. Для операций с высокой нагрузкой на диск перенос данных в NVMe и включение паравиртуальных драйверов обычно сокращают время сканирования вдвое по сравнению с эмуляцией по умолчанию. Это не экзотика, а обязательные требования для производственных ВМ.

Угол зрения на управление тоже важен. Гипервизоры отличаются настройками таймеров, прерываний и режимов простоя. Microsoft рекомендует минимизировать фоновую активность гостя и удалять неиспользуемые эмулированные устройства, совет, применимый и для KVM, и для VMware. Экспозиция NUMA должна быть включена для больших ВМ повсеместно — Virtual NUMA в Hyper-V, флаги топологии в KVM и планировщик NUMA в VMware существуют для сохранения локальности памяти и вычислений.

- 🧭 Hyper-V: DDA/GPU-P, vNUMA, Storage QoS, низкие накладные расходы для Windows-гостей.

- 🧱 Proxmox (KVM/QEMU): VFIO passthrough, virtio-драйверы, кеширование ZFS, простой маппинг GPU.

- 🏢 VMware: зрелые vGPU и паравиртуальные стеки (PVSCI, VMXNET3), глубокая наблюдаемость.

- 🏛️ Citrix: сильные vGPU профили и контроль политики для смешанных нагрузок.

- 🧪 VirtualBox: отлично для тестирования; не рекомендуется для тяжёлых 4K нагрузок.

| Платформа | Возможности GPU 🎮 | Путь диска 🔗 | Сетевой адаптер 🌐 | Лучшее применение |

|---|---|---|---|---|

| Hyper-V | DDA / GPU-P | VHDX на NVMe; пропускной диск | Синтетический NIC | Медиасерверы под Windows |

| Proxmox | VFIO passthrough | ZFS или LVM на NVMe | virtio-net | Домашние лаборатории и энтузиасты |

| VMware | vGPU/DirectPath | vSAN/NVMe, PVSCI | VMXNET3 | Корпоративный медиапоток |

| Citrix | Профили vGPU | SR-IOV/NVMe | Паравиртуальная | Смешанные VDI + медиа нагрузки |

| VirtualBox | Ограниченные | Файло-ориентированный VDI | Эмулированный/virtio | Легкое использование и тестирование |

Выбор между платформами напоминает более широкие технологические сравнения — компромиссы в функциях, стоимости и экосистемах схожи с сравнением моделей или ассистентов в AI. Для актуального чтения о том, как различия влияют на результаты, посмотрите тесты ChatGPT против Gemini.

Основной принцип: выбор платформы должен исходить из качества модели устройства, опций GPU и прозрачности пути хранения. Остальное — это настройка.

Оперативный план: когда виртуализировать медиасервер, а когда оставаться на bare metal

Виртуализация позволяет консолидацию, снимки и быстрое восстановление. Bare metal максимизирует детерминизм и простоту. Решение зависит от формы нагрузки, оборудования и целей обслуживания. Домашний сервер с Intel iGPU и парой пользователей выиграет от ВМ на Proxmox или Hyper-V с passthrough Quick Sync. Бутик-стриминговая операция, запускающая десятки 4K HDR транскодов одновременно, может предпочесть выделенное железо — либо ВМ с полноценной NVIDIA GPU и закреплёнными ЦП, где после настройки разница с bare metal почти исчезает.

Дисциплина обслуживания приносит дивиденды. Поддерживайте согласованность прошивок (IOMMU/BIOS), драйверов GPU и паравиртуальных драйверов на хосте и госте. Тестируйте на небольшом наборе актуальных материалов — HEVC HDR10, высокобитрейтный H.264 и чересстрочные источники — чтобы убедиться, что функции энкодера видны и стабильны внутри ВМ. Документируйте, какие настройки улучшили показатели (глубина очереди, планировщики I/O, RSS), чтобы изменения не потерялись при обновлениях.

- 🧪 Оцените нагрузку: максимальное количество одновременных потоков, состав кодеков, размер библиотеки.

- 🧷 Выберите путь: bare metal для простоты; ВМ — для гибкости и консолидации.

- 🔐 Стратегия GPU: passthrough для максимального доступа к кодекам/функциям; vGPU для плотности.

- 📈 Измеряйте: отслеживайте CPU ready %, задержку диска и fps на поток при нагрузке.

- 🧭 Итерации: корректируйте vNUMA, закрепление и QoS; повторно тестируйте и документируйте.

| Сценарий | Рекомендация 🧭 | Почему работает 🎯 | Управление рисками 🛡️ |

|---|---|---|---|

| Небольшое хозяйство, Intel iGPU | ВМ с QSV passthrough | Низкое энергопотребление, хорошая поддержка кодеков | Закрепление vCPU; включение vNUMA при >8 vCPU |

| Профессиональный пользователь, NVIDIA dGPU | ВМ с PCIe passthrough | Почти bare-metal NVENC | Фиксация версии драйверов; контроль термики |

| Корпоративный стриминг | VMware/Citrix vGPU | Плотность и управление | Тестирование профилей; QoS для хранилища |

| Максимальная одновременность 4K HDR | Bare metal или выделенная ВМ | Максимальная детерминированность | Отдельные сети для ingest и воспроизведения |

Для заинтересованных в оркестровке и дебатах по планированию в смежных областях, этот обзор сравнения Microsoft Copilot и ChatGPT показывает, как возможности и нагрузки влияют на выбор платформы. Аналогично, концептуальные идеи о дизайне систем с синтетическими средами для физического ИИ могут помочь лучше понять изоляцию ресурсов. Те же мысленные модели, что используются в сложных AI или игровых потоках, эффективно масштабируются до бытовых серверных стеллажей.

Заключительное правило: виртуализируйте, когда важны гибкость, бэкапы и консолидация; рассматривайте bare metal, если неприемлема любая потеря последовательности при экстремальных нагрузках.

{“@context”:”https://schema.org”,”@type”:”FAQPage”,”mainEntity”:[{“@type”:”Question”,”name”:”Сколько обычно теряется производительности при запуске медиасервера в ВМ?”,”acceptedAnswer”:{“@type”:”Answer”,”text”:”На современных гипервизорах с паравиртуальными драйверами многие системы показывают низкие однозначные проценты накладных расходов при GPU-ускоренном транскодировании. Задачи, нагружающие хранилище, такие как крупные сканирования библиотек, страдают больше всего, если виртуальные диски находятся на медленных носителях. Настройка virtio/VMXNET3, NVMe и vNUMA позволяет приблизиться к производительности bare metal.”}},{“@type”:”Question”,”name”:”Нужен ли GPU passthrough для Plex/Jellyfin в ВМ?”,”acceptedAnswer”:{“@type”:”Answer”,”text”:”Для множества 4K потоков или HDR-тональной коррекции — да, PCIe passthrough для NVIDIA, AMD или Intel GPU/iGPU сохраняет функции энкодера и обеспечивает почти bare-metal fps. Для лёгких или запросных задач 1080p достаточно транскодирования на ЦП, но энергопотребление и термика возрастают.”}},{“@type”:”Question”,”name”:”Какой гипервизор лучше для домашнего медиасервера?”,”acceptedAnswer”:{“@type”:”Answer”,”text”:”Proxmox (KVM/QEMU) и Hyper-V популярны для домашних систем и малых студий благодаря удобному passthrough GPU и virtio/просветлённым драйверам. VMware и Citrix предлагают более продвинутые vGPU и управление для крупных развертываний. VirtualBox больше подходит для тестирования, чем для тяжёлых 4K нагрузок.”}},{“@type”:”Question”,”name”:”Действительно ли NUMA и закрепление ЦП важны для стриминга?”,”acceptedAnswer”:{“@type”:”Answer”,”text”:”Да. Транскодирование нагружает кэши и память. Экспонирование vNUMA и закрепление vCPU снижает трафик между узлами и шум планировщика, стабилизируя fps на поток. Влияние увеличивается с ростом числа одновременных транскодов и размера ВМ.”}},{“@type”:”Question”,”name”:”Какие метрики мониторинга выявляют узкие места из-за ВМ?”,”acceptedAnswer”:{“@type”:”Answer”,”text”:”Отслеживайте время ожидания CPU ready, задержки на диске во время сканирования библиотек и fps транскодирования на поток. Контролируйте счётчики offload NIC и темп пакетов для выявления джиттера. Эти КПЭ показывают ограничивающий фактор: планирование, хранение или сеть.”}}]}Сколько обычно теряется производительности при запуске медиасервера в ВМ?

На современных гипервизорах с паравиртуальными драйверами многие системы показывают низкие однозначные проценты накладных расходов при GPU-ускоренном транскодировании. Задачи, нагружающие хранилище, такие как крупные сканирования библиотек, страдают больше всего, если виртуальные диски находятся на медленных носителях. Настройка virtio/VMXNET3, NVMe и vNUMA позволяет приблизиться к производительности bare metal.

Нужен ли GPU passthrough для Plex/Jellyfin в ВМ?

Для множества 4K потоков или HDR-тональной коррекции — да, PCIe passthrough для NVIDIA, AMD или Intel GPU/iGPU сохраняет функции энкодера и обеспечивает почти bare-metal fps. Для лёгких или запросных задач 1080p достаточно транскодирования на ЦП, но энергопотребление и термика возрастают.

Какой гипервизор лучше для домашнего медиасервера?

Proxmox (KVM/QEMU) и Hyper-V популярны для домашних систем и малых студий благодаря удобному passthrough GPU и virtio/просветлённым драйверам. VMware и Citrix предлагают более продвинутые vGPU и управление для крупных развертываний. VirtualBox больше подходит для тестирования, чем для тяжёлых 4K нагрузок.

Действительно ли NUMA и закрепление ЦП важны для стриминга?

Да. Транскодирование нагружает кэши и память. Экспонирование vNUMA и закрепление vCPU снижает трафик между узлами и шум планировщика, стабилизируя fps на поток. Влияние увеличивается с ростом числа одновременных транскодов и размера ВМ.

Какие метрики мониторинга выявляют узкие места из-за ВМ?

Отслеживайте время ожидания CPU ready, задержки на диске во время сканирования библиотек и fps транскодирования на поток. Контролируйте счётчики offload NIC и темп пакетов для выявления джиттера. Эти КПЭ показывают ограничивающий фактор: планирование, хранение или сеть.

No responses yet