DeepSeek-Prover-V2 Launch: Erhebung des Neuralen Theorembeweises mit Rekursiver Beweissuche und Innovativen Benchmarks

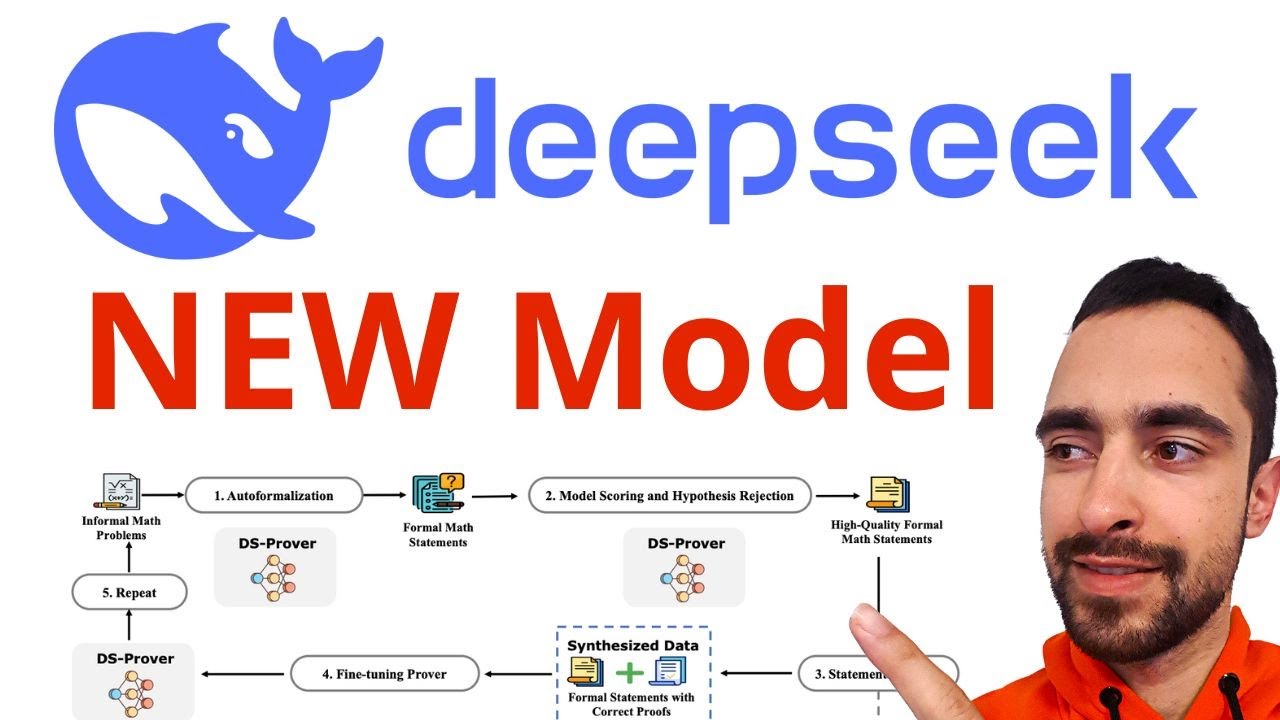

Das Debüt von DeepSeek-Prover-V2 signalisiert eine entscheidende Aufwertung des Neuralen Theorembeweises im Lean 4-Ökosystem. Das System kombiniert eine Rekursive Beweissuche-Pipeline mit einer neuen Reihe von Innovativen Benchmarks und verändert die Erwartungen an überprüfbares mathematisches Schließen. Anstatt sich ausschließlich auf statische Datensätze zu stützen, orchestrierte das Team einen selbstverstärkenden Prozess, bei dem DeepSeek-V3 half, strukturierte Trainingsbeispiele zu synthetisieren, die informelle Gedankenketten mit entsprechenden formalen Lean 4-Beweisen verbinden.

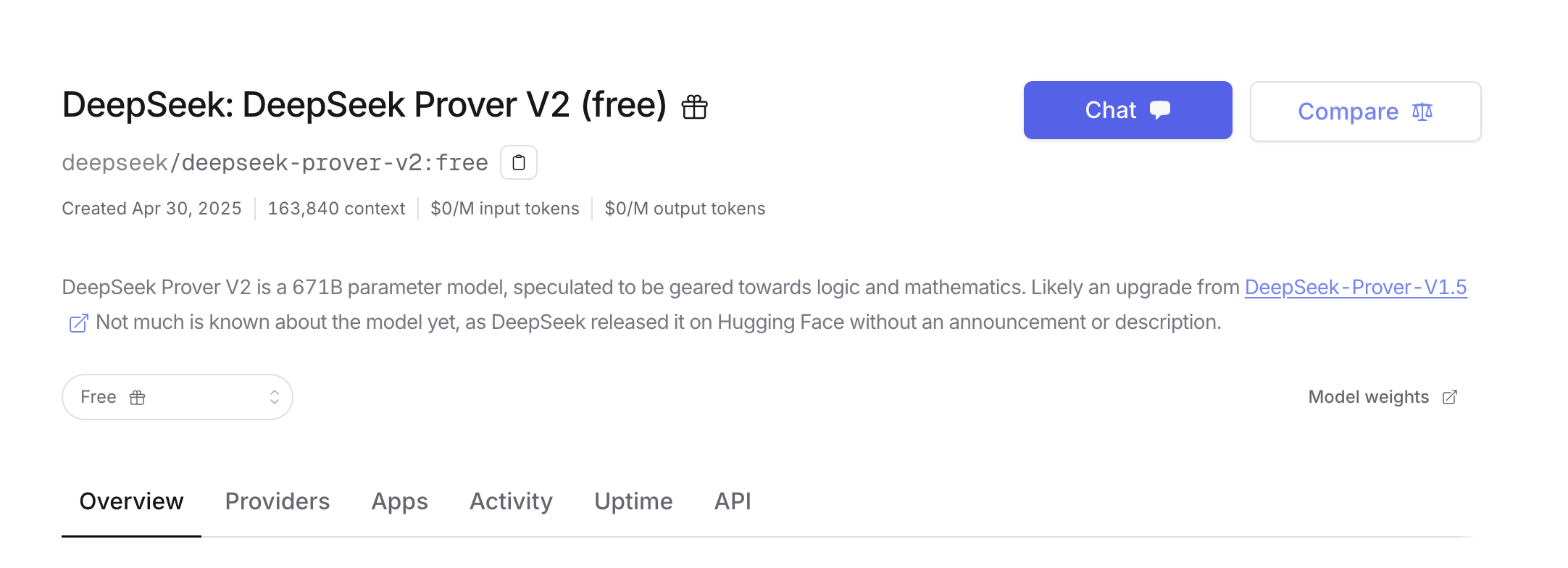

Zwei Modellgrößen bringen Flexibilität ins Spiel. Der kompakte 7B Theorembeweiser konzentriert sich darauf, Teilziele effizient zu behandeln und unterstützt einen erweiterten 32K-Token-Kontext, während das Flaggschiff DeepSeek-Prover-V2–671B das Tempo bei wettbewerbsorientierten Bewertungen vorgibt. Der Release wird mit ProverBench veröffentlicht, einem 325-Probleme umfassenden Benchmark, der Wettbewerbsrätsel und sorgfältig ausgewähltes Lehrbuchmaterial umfasst und Entwicklern sowie Forschern eine realistischere Messlatte für den Fortschritt im Automatisierten Schließen im Jahr 2025 bietet.

Was diesen Launch auszeichnet, ist die Kopplung von formaler Verifikation mit skalierbaren Machine Learning-Praktiken. Die Trainingspipeline beginnt mit der Zerlegung in Teilziele, formalisiert jeden Schritt in Lean 4 und fügt anschließend die validierten Komponenten zu einem End-to-End-Zertifikat zusammen. Das Ergebnis sind nicht nur plausible Argumentationen, sondern Beweise, die den Lean-Checker bestehen, was eine verlässliche Brücke zwischen Intuition und Mathematischer Logik bietet.

Schlüsselfortschritte, die für die KI-Forschung hervorstechen

Für Teams, die KI-Forschungs-Meilensteine verfolgen, verdienen mehrere Aspekte besondere Beachtung. Die Cold-Start-Strategie verringert die Abhängigkeit von fragilen, von Menschen erstellten Datensätzen. Der Fokus auf formale Verifikation bewegt das Feld von Mustererkennung in den Bereich der zertifizierbaren Sicherheit. Und die Open-Source-Verfügbarkeit fördert breite Prüfung, schnelle Iteration und gemeinsamen Fortschritt über Labore und Klassenräume hinweg.

- 🚀 Rekursive Beweissuche: Zerlegung in Teilziele gepaart mit Lean 4-Verifikation für jeden Schritt.

- 🧠 Cold-Start-Synthese: DeepSeek-V3 erstellt Initialisierungsdaten mit abgestimmter Gedankenfolge und formalem Beweis.

- 📚 Innovative Benchmarks: ProverBench umfasst Wettbewerbsaufgaben auf AIME-Niveau und pädagogische Fälle.

- ⚙️ Zwei Modellgrößen: ein praktischer 7B Beweiser und die leistungsführende 671B-Version.

- ✅ Formale Korrektheit: Beweisobjekte werden von Lean 4 verifiziert, nicht nur natürliche Spracherklärungen.

| Aspekt 🔍 | Details zu DeepSeek-Prover-V2 🧩 | Warum es wichtig ist ✅ |

|---|---|---|

| Modellgrößen | 7B und 671B | Balanciert Zugänglichkeit 🧰 und Spitzenergebnisse 🏆 |

| Umgebung | Lean 4 formale Beweise | Maschinenprüfbare Korrektheit 🔒 |

| Pipeline | Rekursive Beweissuche mit Teilzielen | Strukturierter Denkpfad 🧭 |

| Benchmarks | ProverBench, MiniF2F, PutnamBench | Umfassende Bewertung 📈 |

| Zugriff | Hugging Face | Offenes Ökosystem 🤝 |

Mit DeepSeek-Prover-V2, das Automatisiertes Schließen auf überprüfbare Ergebnisse ausrichtet, definiert der Launch einen höheren Standard für messbaren Fortschritt.

Inside the Recursive Proof Search Pipeline: Von Teilzielen zu verifizierten Lean 4-Beweisen

Das Herzstück von DeepSeek-Prover-V2 ist eine disziplinierte Pipeline, die komplexe Probleme in geordnete, lösbare Fragmente verwandelt. Sie beginnt mit DeepSeek-V3, das einen Satz von Teilzielen für einen Theorem-Entwurf erstellt und ein Lean 4-Gerüst entwirft. Ein leichter 7B Theorembeweiser navigiert dann durch diese Fragmente, sucht unter strengen formalen Vorgaben nach Beweisen, bevor das System das endgültige Zertifikat zusammensetzt.

Dieser Cold-Start-Ansatz umgeht die Knappheit kuratierter mathematischer Korpora. Indem informelle Begründungsspuren mit formalen Lean-Beweisen kombiniert werden, lehrt der Trainingssatz sowohl das „Warum“ als auch das „Wie“. Die anschließende Phase des verstärkenden Lernens verwendet binäre Korrektheit als Feedback und schärft die Fähigkeit des Modells, Strategien ins Visier zu nehmen, die zu vom Checker genehmigten Ableitungen führen.

Ein schrittweiser Einblick in die Trainingsschleife

Ein klares mentales Bild der Schleife hilft Teams, Experimente zu planen und das Verhalten zu debuggen. Jede Phase fügt Struktur und Signale hinzu und lässt den Beweiser lernen, Intuition mit formaler Strenge zu verbinden. Das Ergebnis ist eine Maschine, die nicht nur Wege vorschlägt, sondern auch Beweise abschließt.

- 🧭 Zerlegen: DeepSeek-V3 teilt das Problem in Teilziele und entwirft Lean 4-Support.

- 🔧 Teilziele bearbeiten: Der 7B Beweiser führt rekursive Beweissuche auf jedem Fragment durch.

- 🧩 Zusammenfügen: Nach Beweis aller Fragmente erstellt das System ein vollständiges Zertifikat.

- 🧪 Trainingspaare synthetisieren: Kette des Denkens mit formalisierten Lean-Schritten ausrichten.

- 📈 Verstärken: Feinabstimmung mit Korrekt/Nicht-Korrekt-Signalen zur Priorisierung robuster Strategien.

| Phase 🧱 | Eingabe 📥 | Ausgabe 📤 | Werkzeuge 🛠️ |

|---|---|---|---|

| Zerlegung | Originales Theorem | Teilziele + Lean-Gerüst | DeepSeek-V3 🧠 |

| Teilzielbeweis | Einzelne Fragmente | Verifizierte Lemmas | 7B Beweiser ⚙️ |

| Zusammensetzung | Verifizierte Lemmas | End-to-End-Beweis | Lean 4 Checker ✅ |

| Datensynthese | Begründungen + Beweise | Trainingspaare | Ausrichtungspipeline 🔄 |

| Verstärkung | Modell-Outputs | Verbesserte Strategie | Binäre Belohnung 🎯 |

Beispiel: Eine Geometrie-Identität auf Wettbewerbsniveau

Betrachten Sie ein Geometrie-Lemma, das an AIME erinnert: eine Beziehung zwischen der Potenz eines Punktes und Homothetie in Kreiskonfigurationen. Das System listet zuerst Teilziele auf — z. B. Kollinearität zeigen, dann Ähnlichkeit beweisen, schließlich Längenverhältnisse folgern — und formalisiert Hilfsaussagen. Das 7B-Modell erledigt die einfacheren Schritte effizient, während der zusammengesetzte Beweis die höherstufige Identität ohne menschliche Intervention demonstriert.

Hier bricht Neural Theorem Proving mit der Tradition. Anstelle von brüchigen Vorlagen sucht, backtrackt und passt sich die Maschine innerhalb eines formalen Sandbox-Systems an, das ungültige Abkürzungen ausschließt. Die Strategie verallgemeinert sich über Algebra, Zahlentheorie und Kombinatorik und bildet eine verlässliche Grundlage für neue Forschung und Lehrveranstaltungen gleichermaßen.

Mit einer Pipeline, die sowohl narratives Denken als auch lückenlose Verifikation codiert, zeigt DeepSeek-Prover-V2, wie Automatisiertes Schließen skalierbar und vertrauenswürdig sein kann.

Leistungsergebnisse und Innovative Benchmarks: MiniF2F, PutnamBench und ProverBench

Jenseits der Technik sprechen Zahlen. DeepSeek-Prover-V2–671B meldet eine 88,9 % Erfolgsquote im MiniF2F-Test und löst 49 von 658 Problemen auf PutnamBench, einem Datensatz inspiriert von universitären Wettbewerbsherausforderungen. Diese Werte signalisieren verlässliche Leistung bei diversen Problemtypen – von Geometrie und Ungleichungen bis Zahlentheorie – und zeigen zugleich Luft nach oben für weitere Verfeinerungen.

Die herausragende Neuerung ist ProverBench, ein 325-Probleme-Benchmark, der für die heutige Landschaft entwickelt wurde. Es kombiniert 15 formalisierten Aufgaben aus aktuellen AIME-Wettbewerben mit 310 sorgfältig kuratierten Aufgaben aus Lehrbüchern und Tutorials, wobei Klarheit, Pädagogik und Abdeckung im Vordergrund stehen. Für Praktiker ist es eine praktische Sammlung, die nicht nur Rätsel, sondern auch schrittweise logische Entwicklung prüft.

Was diese Benchmarks abdecken – und warum das wichtig ist

Bewertung muss die Breite der Mathematik widerspiegeln, mit der Studenten und Forscher tatsächlich konfrontiert sind. Indem ProverBench Wettbewerbsaufgaben mit methodischen Übungen ausbalanciert, prüft es, ob ein Theorembeweiser sowohl spektakuläre Rätsel als auch dauerhafte Grundlagen lösen kann. Dieser duale Charakter sagt den Erfolg in realen Kursen, Ingenieurprojekten und explorativer KI-Forschung besser voraus.

- 📊 MiniF2F-Test: weit verbreiteter Testsatz für formalisierten Konteststil.

- 🎓 PutnamBench: Hochschulniveau; 49/658 gelöst zeigt Fortschritt bei schwierigen Problemen.

- 🧪 ProverBench: 325 Probleme, 15 aus aktuellen AIME, 310 kuratiert für Breite und Pädagogik.

- 🧮 Abdeckungsbereiche: Algebra, Geometrie, Kombinatorik, Zahlentheorie, Ungleichungen und mehr.

- 🔍 Hinweise auf Generalisierung: Beweissuche passt sich vielfältigen Strukturen an, nicht nur auswendig gelernten Identitäten.

| Benchmark 🧭 | Zusammensetzung 📚 | DeepSeek-Prover-V2 Ergebnis 🏆 | Erkenntnis 💡 |

|---|---|---|---|

| MiniF2F-Test | Formal-gestylte Wettbewerbsaufgaben | 88,9 % bestanden ✅ | Hohe Robustheit über Themen hinweg 📈 |

| PutnamBench | 658 universitäre Probleme | 49 gelöst 🔬 | Fortschritt bei schweren Beweisen, Potenzial für Wachstum 🚧 |

| ProverBench | 15 AIME + 310 kuratiert | Mit Veröffentlichung eingeführt 🆕 | Realistische, lehrreiche Mischung 🎓 |

Warum ProverBench 2025 die Diskussion verändert

Benchmarks prägen Forschungsprioritäten. Durch die Veröffentlichung eines Datensatzes, der Wettbewerbsflair und didaktische Tiefe verbindet, fördert DeepSeek Replikationsstudien, Kursintegration und faire Vergleichstests. Dies reduziert das Risiko von „Benchmark-Überanpassung“ und stärkt die Aussagekraft für Methoden, die Studierenden und Wissenschaftlern tatsächlich helfen, überprüfbare Ergebnisse zu erzielen.

Die Kennzahlen unterstreichen eine einfache Einsicht: Die Kombination aus Innovativen Benchmarks mit überprüfbaren Ergebnissen beschleunigt bedeutende Fortschritte im Neuralen Theorembeweis.

Modellarchitektur und Training: 671B-Skalierung trifft auf praktischen 7B Theorembeweiser

Skalierung ist wichtig – aber auch Zugänglichkeit. Die Veröffentlichung von DeepSeek-Prover-V2–671B liefert Spitzentechnologie, während die 7B-Variante Lehrkräfte, Studierende und Startups mit einem produktiven Werkzeug für formales Schließen ausstattet. Das kleinere Modell mit 32K Kontextfenster hilft, lange Ableitungen, komplexe Lemmaketten und umfangreiche Taktikscripte zu verwalten, wie sie in Lean 4-Projekten üblich sind.

Das Training beginnt mit einem synthetischen Cold-Start-Datensatz, der mittels DeepSeek-V3s Zerlegungsfähigkeiten generiert wurde. Der 7B Beweiser übernimmt die Teilsuche während der Datenerstellung und stellt sicher, dass formale Schritte verifiziert werden, bevor sie Lehrmaterial werden. Feinjustierung an diesen abgestimmten Paaren lehrt das System, sich im Lean-Taktikraum zurechtzufinden, während Verstärkung mit binärem Feedback seine Konzentration auf Strategien vertieft, die tatsächlich Beweise abschließen.

Praktische Einsatzoptionen für Teams

Forschungsgruppen jonglieren oft mit begrenzten GPUs und Deadlines. Die 7B-Version ist darauf ausgelegt, auf bescheidener Hardware für iterative Entwicklung zu laufen, während das größere Modell für entscheidende Bewertungen reserviert ist. Organisationen können mit dem kleinen Modell Prototypen erstellen, Pipelines validieren und erst dann Zeit auf großen Clustern investieren, um Spitzenwerte zu verfolgen.

- 🧰 Klein anfangen: Teilzielstrategien und Datensatzgestaltung mit dem 7B-Modell validieren.

- 🏗️ Hochskalieren: Auf 671B umsteigen für Benchmark-Pushes und forschungsrelevante Ablationen.

- 🧵 32K Kontext nutzen: Umfangreiche Beweiszustände und Taktikhistorien im Speicher behalten.

- 🔒 Checker im Kreislauf behalten: Ungültige Pfade früh ablehnen, um Rechenressourcen zu sparen.

- 🔁 Schleife schließen: Neue Trainingspaare aus erfolgreichen Beweisen gewinnen, um sich kontinuierlich zu verbessern.

| Modell ⚙️ | Spezifikationen 📐 | Idealer Anwendungsfall 🎯 | Bemerkungen 📝 |

|---|---|---|---|

| DeepSeek-Prover-V2–7B | ~7 Milliarden Parameter, 32K Kontext | Lokale Entwicklung, Studienarbeit, CI-Prüfungen 🧪 | Auf V1.5-Basis aufgebaut; effizient 🟢 |

| DeepSeek-Prover-V2–671B | 671 Milliarden Parameter, Spitzenresultate | Benchmarking, Publikationen, fortgeschrittene Forschung 🏆 | Auf DeepSeek-V3-Basis aufgebaut; leistungsstark 🔥 |

| Zugriff | Hugging Face | Offener Download und Prüfung 🔍 | Beweisartefakte für MiniF2F verfügbar 📂 |

Ressourcenplanungsszenarien

Ein Universitätslabor könnte seine Beweispipeline für die tägliche Entwicklung auf 7B stützen und den Checker nutzen, um Regressionen zu verhindern. Sobald es fertig ist, kann es an einem Wochenende Shared Infrastructure nutzen, um Experimente mit 671B zu fahren und Veröffentlichungen zu vergleichen. Ein Startup, das einen Mathetutor entwickelt, könnte dieses Muster reflektieren, mit dem kleinen Modell für latenzkritische Aufgaben und dem großen für kuratierte Inhaltserzeugung.

Die Kombination eines praktischen 7B-Modells mit einem leistungsstarken 671B-System ermöglicht es Teams, schnell voranzukommen, ohne bei der Strenge Abstriche zu machen.

Anwendungsfälle, Gemeinschaftliche Auswirkungen und nächste Schritte für das automatisierte Schließen in der mathematischen Logik

Offene Veröffentlichungen verändern, was Klassenräume, Forschungsgruppen und Startups versuchen können. Mit DeepSeek, das formale Verifikation mit moderner Machine Learning-Praxis verbindet, reicht die Wirkung von Bildung bis in Unternehmen. Die Gemeinschaft kann nun Ideen gegen Innovative Benchmarks testen und Tools liefern, die Lean 4-prüfbare Artefakte erzeugen.

Betrachten wir „Aurora Lab“, ein Zusammenspiel mehrerer Institutionen. In der ersten Woche integrieren sie den 7B Theorembeweiser in einen Lean-Lehrassistenten, der Lücken im Denken der Studierenden erkennt. In der zweiten Woche bauen sie eine nächtliche CI, die mittels Teilzielzerlegung neue Lemmas validiert, die einer gemeinsamen Bibliothek hinzugefügt wurden. Bis zur dritten Woche führen sie gezielte Experimente mit dem 671B-Modell durch, um Kombinationstaktiken zu erforschen, die sich auf Familien von Identitäten verallgemeinern.

Wo DeepSeek-Prover-V2 heute Wert liefert

Wert entsteht, wenn verifizierte Ausgaben nachgelagerte Arbeitsabläufe antreiben. Bei Wettbewerben können Beweisobjekte Lösungen prüfen. In der Forschung unterstützen strukturierte Gedankengänge, verbunden mit formalen Zertifikaten, die Reproduzierbarkeit. In der Industrie profitieren sicherheitskritische Systeme von Komponenten, die ein Beweisprüfer bis zum Ende validiert hat.

- 🎓 Bildung: geführte Lean-Übungen, automatisiertes Feedback, Vorschläge zur Beweissanpassung.

- 🏭 Ingenieurwesen: CI-Pipelines, die bei unbeweisbaren Code-Verträgen und Spezifikationen fehlschlagen.

- 🧪 KI-Forschung: Ablationen zu rekursiven Beweissuchen-Strategien und Taktikportfolios.

- 📚 Inhaltserstellung: schrittweise Lehrbücher, in denen jedes Lemma formal geprüft ist.

- 🧭 Erkundung: Abbildung großer Problembereiche durch Teilzielzerlegung und gezielte Suche.

| Persona 👤 | Aufgabe 🧰 | Nutzen ✅ | DeepSeek-Prover-V2 Merkmal ⭐ |

|---|---|---|---|

| Studierende | Lean-Beweise üben | Umgehendes, formales Feedback 📬 | 7B + 32K Kontext 🧮 |

| Forscher | Beweisstrategien testen | Reproduzierbare Ergebnisse 🧪 | Rekursive Beweissuche 🔁 |

| Ingenieur | Spezifikationen verifizieren | Checker-gestützte Sicherheit 🔒 | Lean 4 Integration ⚙️ |

| Lehrende | Aufgaben erstellen | Kuratierte Schwierigkeitsleiter 📈 | ProverBench 🧭 |

Mit wachsendem Projektumfang schafft die Kombination aus DeepSeek-Prover-V2, formaler Verifikation und Innovativen Benchmarks die Grundlage für robuste, prüfbare Werkzeuge, die ernsthafte Arbeit in Mathematischer Logik und Automatisiertem Schließen unterstützen. Der Schwung richtet sich nun auf reichhaltigere Taktikbibliotheken, bessere UX beim Debuggen und gemeinschaftlich erstellte Lehrpläne, die auf geprüfter Argumentation beruhen.

{“@context”:”https://schema.org”,”@type”:”FAQPage”,”mainEntity”:[{“@type”:”Question”,”name”:”Wie funktioniert Rekursive Beweissuche in DeepSeek-Prover-V2 eigentlich?”,”acceptedAnswer”:{“@type”:”Answer”,”text”:”Das System zerlegt ein Zieltheorem in Teilziele, beweist jedes Fragment mit einem 7B Beweiser unter Lean 4 und komponiert dann ein endgültiges Zertifikat. DeepSeek-V3 entwirft initial Teilziele und formale Strukturen, während Verstärkendes Lernen Strategien anhand von Korrekt-oder-Inkorrekt-Feedback schärft. Das Ergebnis ist ein strukturierter Pfad vom informellen Denken zu Checker-verifizierten Beweisen.”}},{“@type”:”Question”,”name”:”Was macht ProverBench anders als bestehende Bewertungen?”,”acceptedAnswer”:{“@type”:”Answer”,”text”:”ProverBench umfasst 325 Probleme: 15 formalisiert aus aktuellen AIME-Wettbewerben und 310 aus Lehrbüchern und Tutorials kuratiert. Diese Mischung erfasst sowohl Wettbewerbscharakter als auch pädagogische Tiefe und schafft einen Benchmark, der Klassenraumbedürfnisse und Forschungsstrenge mit klarer Schwierigkeitsgradierung widerspiegelt.”}},{“@type”:”Question”,”name”:”Kann der 7B Theorembeweiser auf bescheidener Hardware laufen?”,”acceptedAnswer”:{“@type”:”Answer”,”text”:”Ja. Das 7B Modell ist für lokale Entwicklung und den Unterricht ausgelegt, unterstützt bis zu 32K Tokens, um lange Beweisverläufe zu bewältigen. Teams können schnell auf Laptops oder Einzel-GPU-Servern iterieren und dann für Spitzenbewertungen zum 671B Modell skalieren.”}},{“@type”:”Question”,”name”:”Wo kann die Gemeinschaft auf das Modell und Beweisartefakte zugreifen?”,”acceptedAnswer”:{“@type”:”Answer”,”text”:”Die Veröffentlichung ist auf Hugging Face unter https://huggingface.co/deepseek-ai/DeepSeek-Prover-V2-671B verfügbar. Für den MiniF2F-Datensatz generierte Beweise sind ebenfalls veröffentlicht und ermöglichen Inspektion, Replikation und weitere Analyse durch die Gemeinschaft.”}},{“@type”:”Question”,”name”:”Wie hilft DeepSeek-Prover-V2, informelles und formales Denken zu verbinden?”,”acceptedAnswer”:{“@type”:”Answer”,”text”:”Trainingspaare verbinden die Gedankenketten mit formalen Lean 4-Schritten für dasselbe Problem. Indem das Modell beide Erzählungen gleichzeitig lernt, wird es darin fit, intuitive Zerlegungen in verifizierbare Beweisobjekte zu überführen, wodurch Einsicht zu Korrektheit führt.”}}]}Wie funktioniert Rekursive Beweissuche in DeepSeek-Prover-V2 eigentlich?

Das System zerlegt ein Zieltheorem in Teilziele, beweist jedes Fragment mit einem 7B Beweiser unter Lean 4 und komponiert dann ein endgültiges Zertifikat. DeepSeek-V3 entwirft initial Teilziele und formale Strukturen, während Verstärkendes Lernen Strategien anhand von Korrekt-oder-Inkorrekt-Feedback schärft. Das Ergebnis ist ein strukturierter Pfad vom informellen Denken zu Checker-verifizierten Beweisen.

Was macht ProverBench anders als bestehende Bewertungen?

ProverBench umfasst 325 Probleme: 15 formalisiert aus aktuellen AIME-Wettbewerben und 310 aus Lehrbüchern und Tutorials kuratiert. Diese Mischung erfasst sowohl Wettbewerbscharakter als auch pädagogische Tiefe und schafft einen Benchmark, der Klassenraumbedürfnisse und Forschungsstrenge mit klarer Schwierigkeitsgradierung widerspiegelt.

Kann der 7B Theorembeweiser auf bescheidener Hardware laufen?

Ja. Das 7B Modell ist für lokale Entwicklung und den Unterricht ausgelegt, unterstützt bis zu 32K Tokens, um lange Beweisverläufe zu bewältigen. Teams können schnell auf Laptops oder Einzel-GPU-Servern iterieren und dann für Spitzenbewertungen zum 671B Modell skalieren.

Wo kann die Gemeinschaft auf das Modell und Beweisartefakte zugreifen?

Die Veröffentlichung ist auf Hugging Face unter https://huggingface.co/deepseek-ai/DeepSeek-Prover-V2-671B verfügbar. Für den MiniF2F-Datensatz generierte Beweise sind ebenfalls veröffentlicht und ermöglichen Inspektion, Replikation und weitere Analyse durch die Gemeinschaft.

Wie hilft DeepSeek-Prover-V2, informelles und formales Denken zu verbinden?

Trainingspaare verbinden die Gedankenketten mit formalen Lean 4-Schritten für dasselbe Problem. Indem das Modell beide Erzählungen gleichzeitig lernt, wird es darin fit, intuitive Zerlegungen in verifizierbare Beweisobjekte zu überführen, wodurch Einsicht zu Korrektheit führt.

-

Open Ai1 week ago

Open Ai1 week agoEntfesselung der Power von ChatGPT-Plugins: Verbessern Sie Ihr Erlebnis im Jahr 2025

-

Open Ai6 days ago

Open Ai6 days agoMastering GPT Fine-Tuning: Ein Leitfaden zur effektiven Anpassung Ihrer Modelle im Jahr 2025

-

Open Ai7 days ago

Open Ai7 days agoVergleich von OpenAIs ChatGPT, Anthropics Claude und Googles Bard: Welches generative KI-Tool wird 2025 die Vorherrschaft erlangen?

-

Open Ai6 days ago

Open Ai6 days agoChatGPT-Preise im Jahr 2025: Alles, was Sie über Tarife und Abonnements wissen müssen

-

Open Ai7 days ago

Open Ai7 days agoDas Auslaufen der GPT-Modelle: Was Nutzer im Jahr 2025 erwartet

-

KI-Modelle6 days ago

KI-Modelle6 days agoGPT-4-Modelle: Wie Künstliche Intelligenz das Jahr 2025 verändert