Actualités

DeepSeek lance DeepSeek-Prover-V2 : Élever la démonstration de théorèmes neuronale grâce à la recherche récursive de preuves et introduire des benchmarks innovants

Lancement de DeepSeek-Prover-V2 : Élever la démonstration neuronale de théorèmes avec une recherche récursive de preuves et des benchmarks innovants

Le lancement de DeepSeek-Prover-V2 marque une élévation décisive de la démonstration neuronale de théorèmes dans l’écosystème Lean 4. Le système combine une chaîne de traitement de Recherche Récursive de Preuves avec une nouvelle suite de Benchmarks Innovants, redéfinissant les attentes en matière de raisonnement mathématique vérifiable. Plutôt que de s’appuyer uniquement sur des ensembles de données statiques, l’équipe a orchestré un processus d’auto-amorçage où DeepSeek-V3 a aidé à synthétiser des exemples d’entraînement structurés associant des chaînes de pensée informelles à des preuves formelles correspondantes en Lean 4.

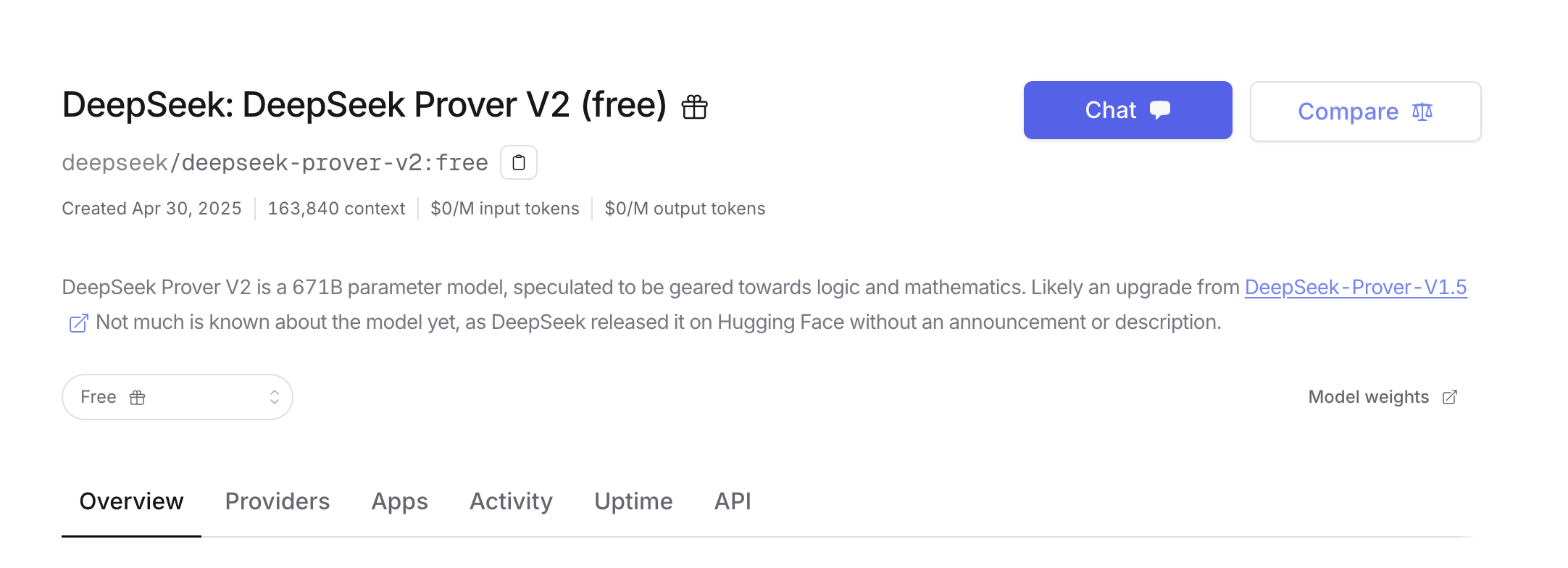

Deux tailles de modèles apportent de la flexibilité à la scène. Le 7B démonstrateur de théorèmes compact se concentre sur la gestion efficace des sous-objectifs et prend en charge un contexte étendu de 32K tokens, tandis que le modèle phare DeepSeek-Prover-V2–671B impose la cadence lors des évaluations compétitives. Cette sortie est accompagnée de ProverBench, un benchmark de 325 problèmes couvrant des énigmes de niveau compétition et du matériel soigneusement sélectionné dans des manuels, offrant aux développeurs et chercheurs une jauge plus réaliste des progrès en Raisonnement Automatisé en 2025.

Ce qui différencie ce lancement est l’association de la vérification formelle avec des pratiques évolutives de Machine Learning. La chaîne d’entraînement commence par la décomposition en sous-objectifs, formalise chaque étape dans Lean 4, puis assemble les composants validés en un certificat complet. Le résultat n’est pas seulement un raisonnement plausible mais des preuves qui passent le vérificateur Lean, offrant un pont fiable entre l’intuition et la Logique Mathématique.

Principales avancées remarquées pour la recherche IA

Pour les équipes suivant les jalons de la recherche IA, plusieurs éléments méritent l’attention. La stratégie de démarrage à froid réduit la dépendance aux ensembles de données fragiles créés par les humains. L’accent mis sur la vérification formelle pousse le domaine du simple appariement de motifs vers la certitude certifiable. Et la disponibilité open source encourage un large examen, une itération rapide et des progrès partagés entre laboratoires et salles de classe.

- 🚀 Recherche Récursive de Preuves : décomposition des sous-objectifs associée à la vérification Lean 4 à chaque étape.

- 🧠 Synthèse à froid : DeepSeek-V3 produit des données d’initialisation avec chaîne de pensée alignée et preuve formelle.

- 📚 Benchmarks Innovants : ProverBench inclut des problèmes AIME de niveau compétition et des cas pédagogiques.

- ⚙️ Deux tailles de modèle : un démonstrateur 7B pratique et la version performante 671B.

- ✅ Correction formelle : objets preuve vérifiés par Lean 4, pas seulement un raisonnement en langage naturel.

| Aspect 🔍 | Détail DeepSeek-Prover-V2 🧩 | Pourquoi c’est important ✅ |

|---|---|---|

| Tailles de modèle | 7B et 671B | Équilibre entre accessibilité 🧰 et résultats à la pointe 🏆 |

| Environnement | Preuves formelles Lean 4 | Correction vérifiable par machine 🔒 |

| Pipeline | Recherche Récursive de Preuves avec sous-objectifs | Parcours de raisonnement structuré 🧭 |

| Benchmarks | ProverBench, MiniF2F, PutnamBench | Évaluation complète 📈 |

| Accès | Hugging Face | Écosystème ouvert 🤝 |

Avec DeepSeek-Prover-V2 alignant le Raisonnement Automatisé sur des résultats vérifiables, ce lancement fixe une norme plus élevée pour des progrès mesurables.

À l’intérieur du pipeline de Recherche Récursive de Preuves : des sous-objectifs aux preuves Lean 4 vérifiées

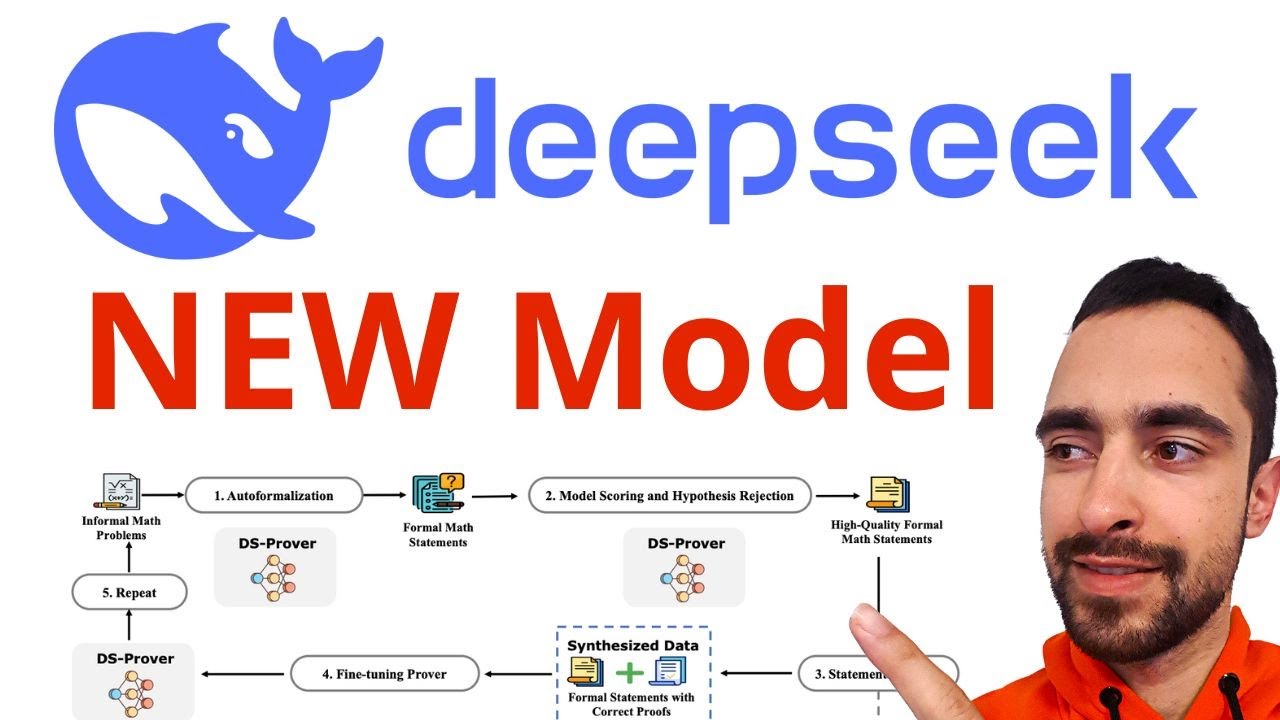

Le cœur de DeepSeek-Prover-V2 est un pipeline discipliné qui transforme des problèmes complexes en fragments ordonnés et solvables. Il commence avec DeepSeek-V3 qui décompose un théorème en une série de sous-objectifs et élabore une structure Lean 4. Un démonstrateur 7B léger parcourt ensuite ces fragments, cherchant des preuves sous des contraintes formelles strictes, avant que le système assemble le certificat final.

Cette approche de démarrage à froid évite la rareté des corpus mathématiques sélectionnés. En associant des traces de raisonnement informelles à des preuves formelles Lean, l’ensemble d’entraînement enseigne à la fois le « pourquoi » et le « comment ». La phase de renforcement utilise la correction binaire comme retour, affinant la capacité du modèle à cibler des stratégies menant à des dérivations validées par le vérificateur.

Vue étape par étape de la boucle d’entraînement

Une représentation mentale claire de la boucle aide les équipes à planifier les expériences et déboguer les comportements. Chaque étape ajoute structure et signal, permettant au prouveur de relier intuition et rigueur formelle. Le résultat est un moteur qui non seulement propose des chemins mais ferme les preuves.

- 🧭 Décomposer : DeepSeek-V3 divise le problème en sous-objectifs et prépare l’ossature Lean 4.

- 🔧 Tenter les sous-objectifs : le 7B prouveur réalise une Recherche Récursive de Preuves sur chaque fragment.

- 🧩 Assembler : une fois les fragments prouvés, le système compose un certificat complet.

- 🧪 Synthétiser les paires d’entraînement : aligner chaîne de pensée et étapes Lean formalisées.

- 📈 Renforcer : affiner avec des signaux corrects/incorrects pour prioriser les stratégies robustes.

| Étape 🧱 | Entrée 📥 | Sortie 📤 | Outils 🛠️ |

|---|---|---|---|

| Décomposition | Théorème original | Sous-objectifs + ossature Lean | DeepSeek-V3 🧠 |

| Preuve des sous-objectifs | Fragments individuels | Lemmas vérifiés | 7B prouveur ⚙️ |

| Composition | Lemmas vérifiés | Preuve de bout en bout | Vérificateur Lean 4 ✅ |

| Synthèse des données | Raisonnement + preuves | Paires d’entraînement | Pipeline d’alignement 🔄 |

| Renforcement | Sorties du modèle | Politique améliorée | Récompense binaire 🎯 |

Exemple : une identité géométrique de niveau concours

Considérez un lemme géométrique rappelant l’AIME : une relation entre la puissance d’un point et l’homothétie dans des configurations de cercles. Le système liste d’abord les sous-objectifs — par exemple, montrer la collinéarité, puis prouver la similarité, finalement déduire les rapports de longueurs — et formalise les propositions auxiliaires. Le modèle 7B exécute efficacement les étapes simples, tandis que la preuve composée démontre l’identité de niveau supérieur sans intervention humaine.

C’est là que la démonstration neuronale de théorèmes se distingue de la tradition. Au lieu de modèles fragiles, le moteur explore, revient en arrière et s’adapte au sein d’un bac à sable formel qui interdit les raccourcis invalides. La stratégie se généralise à travers l’algèbre, la théorie des nombres et la combinatoire, en faisant une base fiable pour la recherche et les cours.

Avec un pipeline qui encode à la fois un raisonnement narratif et une vérification rigoureuse, DeepSeek-Prover-V2 montre comment le Raisonnement Automatisé peut être à la fois évolutif et fiable.

Résultats de performance et benchmarks innovants : MiniF2F, PutnamBench et ProverBench

Au-delà de l’ingénierie, les chiffres parlent. DeepSeek-Prover-V2–671B affiche un taux de réussite de 88,9 % sur MiniF2F-test, et résout 49 sur 658 problèmes sur PutnamBench, un ensemble inspiré des compétitions universitaires. Ces chiffres indiquent une performance fiable sur divers types de problèmes — géométrie, inégalités, théorie des nombres — tout en révélant une marge de progression.

L’ajout principal est ProverBench, un benchmark de 325 problèmes conçu pour le paysage actuel. Il mixe 15 tâches formalisées issues des compétitions récentes AIME et 310 éléments sélectionnés provenant de manuels et tutoriels, mettant l’accent sur la clarté, la pédagogie et la couverture. Pour les praticiens, c’est une batterie pratique qui teste non seulement des problèmes complexes mais aussi un développement logique étape par étape.

Ce que ces benchmarks couvrent — et pourquoi c’est important

L’évaluation doit refléter l’étendue des mathématiques que les étudiants et chercheurs rencontrent réellement. En équilibrant des tâches de niveau compétition avec des exercices méthodiques, ProverBench vérifie si un démonstrateur peut résoudre à la fois des énigmes visibles et des fondamentaux durables. Cette double nature prédit mieux le succès dans les cours réels, les projets d’ingénierie et la recherche IA exploratoire.

- 📊 MiniF2F-test : répartition de test largement utilisée pour les tâches formalisées de style concours.

- 🎓 PutnamBench : défis universitaires ; 49/658 résolus montre une traction sur des problèmes difficiles.

- 🧪 ProverBench : 325 problèmes, 15 issus de l’AIME récent, 310 sélectionnés pour la pédagogie et la diversité.

- 🧮 Domaines couverts : algèbre, géométrie, combinatoire, théorie des nombres, inégalités, et plus.

- 🔍 Preuve de généralisation : la recherche de preuve s’adapte à diverses structures, pas seulement aux identités mémorisées.

| Benchmark 🧭 | Composition 📚 | Résultat DeepSeek-Prover-V2 🏆 | Conclusion 💡 |

|---|---|---|---|

| MiniF2F-test | Tâches formalisées de style concours | 88,9 % de réussite ✅ | Grande robustesse sur divers sujets 📈 |

| PutnamBench | 658 problèmes universitaires | 49 résolus 🔬 | Progrès sur des preuves difficiles, marge de progression 🚧 |

| ProverBench | 15 AIME + 310 sélectionnés | Introduit avec la sortie 🆕 | Mélange réaliste, adapté à l’enseignement 🎓 |

Pourquoi ProverBench change la donne en 2025

Les benchmarks orientent les priorités de recherche. En publiant un jeu de données couvrant saveur compétition et profondeur didactique, DeepSeek favorise les études de réplication, l’adoption en cours, et des comparaisons équitables. Cela réduit le risque de “sur-apprentissage benchmark” et amplifie le signal pour des méthodes qui aident réellement étudiants et scientifiques à produire des résultats vérifiables.

Les métriques soulignent une idée simple : associer des Benchmarks Innovants à des résultats vérifiables accélère les gains significatifs en démonstration neuronale de théorèmes.

Architecture du modèle et entraînement : l’échelle 671B rencontre un prouveur pratique 7B

La montée en échelle compte — mais l’accessibilité aussi. La sortie DeepSeek-Prover-V2–671B offre des capacités à la pointe, tandis que la variante 7B équipe enseignants, étudiants et startups d’un outil de raisonnement formel productif. La fenêtre de contexte 32K du plus petit modèle lui permet de suivre de longues dérivations, des chaînes de lemmas complexes et des scripts tactiques étendus courants dans les projets Lean 4.

L’entraînement débute avec un ensemble synthétique à démarrage à froid généré par les compétences de décomposition de DeepSeek-V3. Le 7B prouveur gère la recherche de sous-objectifs pendant la création des données, assurant que les étapes formelles sont vérifiées avant de devenir du matériel pédagogique. Le fine-tuning sur ces paires alignées enseigne au système à naviguer dans l’espace tactique de Lean, tandis que le renforcement avec un retour binaire intensifie la concentration sur les stratégies qui ferment réellement les preuves.

Choix de déploiement pratiques pour les équipes

Les groupes de recherche jonglent souvent avec des GPU limités et des délais serrés. L’édition 7B vise à fonctionner sur du matériel modeste pour un développement itératif, le modèle plus grand étant réservé aux évaluations critiques. Les organisations peuvent prototyper avec le petit modèle, valider les pipelines, puis allouer du temps sur de grands clusters pour viser les meilleurs résultats du classement.

- 🧰 Commencer petit : valider les stratégies de sous-objectifs et la curation des datasets sur le modèle 7B.

- 🏗️ Monter en puissance : passer au 671B pour les benchmarks et les analyses approfondies de recherche.

- 🧵 Utiliser le contexte 32K : conserver en mémoire les états de preuve étendus et l’historique des tactiques.

- 🔒 Garder le vérificateur en boucle : rejeter tôt les chemins invalides pour économiser du calcul.

- 🔁 Fermer la boucle : récolter de nouvelles paires d’entraînement à partir des preuves réussies pour améliorer au fil du temps.

| Modèle ⚙️ | Spécifications 📐 | Cas d’usage idéal 🎯 | Notes 📝 |

|---|---|---|---|

| DeepSeek-Prover-V2–7B | ~7B paramètres, contexte 32K | Développement local, travaux pratiques, contrôles CI 🧪 | Basé sur V1.5 ; efficace 🟢 |

| DeepSeek-Prover-V2–671B | 671B paramètres, résultats SOTA | Benchmarks, publications, recherche avancée 🏆 | Basé sur DeepSeek-V3-Base ; puissant 🔥 |

| Accès | Hugging Face | Téléchargement et inspection ouverts 🔍 | Objets preuve pour MiniF2F disponibles 📂 |

Scénarios de planification des ressources

Un laboratoire universitaire peut ancrer sa chaîne de preuves sur le 7B pour un développement quotidien, utilisant le vérificateur pour prévenir les régressions. Une fois prêt, une plage de weekend sur une infrastructure partagée peut permettre de lancer des expériences avec le 671B pour comparer aux scores publiés. Une startup développant un tuteur mathématique pourrait suivre ce modèle, utilisant le petit modèle pour des tâches sensibles à la latence et le grand pour la génération de contenu sélectionné.

Associer un moteur 7B pratique à un système performant 671B permet aux équipes de avancer rapidement sans sacrifier la rigueur.

Cas d’usage, impact communautaire et prochaines étapes pour le raisonnement automatisé en logique mathématique

Les sorties ouvertes changent ce que les classes, groupes de recherche et startups peuvent entreprendre. Avec DeepSeek alignant la vérification formelle aux pratiques modernes de Machine Learning, l’impact s’étend de l’éducation à l’entreprise. La communauté peut désormais tester des idées contre des Benchmarks Innovants tout en diffusant des outils qui produisent des artefacts vérifiables Lean 4.

Considérez “Aurora Lab”, portrait composite de plusieurs institutions. En semaine 1, ils intègrent le démonstrateur 7B à un assistant d’enseignement Lean qui signale les lacunes dans le raisonnement des étudiants. En semaine 2, ils construisent une CI nocturne qui utilise la décomposition en sous-objectifs pour valider les nouveaux lemmas ajoutés à une bibliothèque partagée. En semaine 3, ils mènent des expériences ciblées avec le modèle 671B pour explorer des tactiques combinatoires généralisables à des familles d’identités.

Où DeepSeek-Prover-V2 apporte de la valeur aujourd’hui

La valeur s’accumule lorsque les sorties vérifiées pilotent des flux de travail en aval. Dans les compétitions, les objets preuve peuvent auditer les solutions. En recherche, les chaînes de pensée structurées liées à des certificats formels soutiennent la reproductibilité. En industrie, les systèmes critiques bénéficient de composants validés de bout en bout par un vérificateur.

- 🎓 Éducation : exercices Lean guidés, feedback automatisé, suggestions de réparation de preuve.

- 🏭 Ingénierie : pipelines CI qui échouent sur contrats et spécifications non prouvables.

- 🧪 Recherche IA : analyses sur Recherche Récursive de Preuves et portefeuilles tactiques.

- 📚 Génération de contenu : manuels étape par étape où chaque lemme est formellement vérifié.

- 🧭 Exploration : cartographier de grands espaces problème avec décomposition de sous-objectifs et recherche ciblée.

| Personae 👤 | Tâche 🧰 | Bénéfice ✅ | Fonctionnalité DeepSeek-Prover-V2 ⭐ |

|---|---|---|---|

| Étudiant | Pratiquer les preuves Lean | Retour formel immédiat 📬 | 7B + contexte 32K 🧮 |

| Chercheur | Tester des stratégies de preuves | Résultats reproductibles 🧪 | Recherche Récursive de Preuves 🔁 |

| Ingénieur | Vérifier les spécifications | Confiance garantie par le vérificateur 🔒 | Intégration Lean 4 ⚙️ |

| Enseignant | Construire des devoirs | Progression de difficulté graduée 📈 | ProverBench 🧭 |

À mesure que les projets prennent de l’ampleur, la combinaison de DeepSeek-Prover-V2, la vérification formelle et les Benchmarks Innovants jettent les bases d’outils solides, auditables, qui soutiennent un travail sérieux en Logique Mathématique et Raisonnement Automatisé. Le momentum s’oriente désormais vers des bibliothèques tactiques enrichies, une meilleure UX de débogage, et des cursus communautaires ancrés dans le raisonnement vérifié.

{« @context »: »https://schema.org », »@type »: »FAQPage », »mainEntity »:[{« @type »: »Question », »name »: »Comment fonctionne réellement la Recherche Récursive de Preuves dans DeepSeek-Prover-V2 ? », »acceptedAnswer »:{« @type »: »Answer », »text »: »Le système décompose un théorème cible en sous-objectifs, prouve chaque fragment avec un prouveur 7B sous Lean 4, puis compose un certificat final. DeepSeek-V3 élabore initialement les sous-objectifs et la structure formelle, tandis que l’apprentissage par renforcement affine les stratégies en utilisant des retours corrects ou incorrects. Le résultat est un chemin structuré du raisonnement informel aux preuves vérifiées par le vérificateur. »}},{« @type »: »Question », »name »: »Qu’est-ce qui différencie ProverBench des évaluations existantes ? », »acceptedAnswer »:{« @type »: »Answer », »text »: »ProverBench contient 325 problèmes : 15 formalisés à partir de compétitions récentes AIME et 310 sélectionnés dans des manuels et tutoriels. Ce mélange capture à la fois la saveur des compétitions et la profondeur pédagogique, produisant un benchmark qui reflète les besoins en classe et la rigueur de la recherche avec une gradation claire de la difficulté. »}},{« @type »: »Question », »name »: »Le prouveur 7B peut-il fonctionner sur du matériel modeste ? », »acceptedAnswer »:{« @type »: »Answer », »text »: »Oui. Le modèle 7B est conçu pour le développement local et l’usage pédagogique, supportant jusqu’à 32K tokens pour gérer de longs tracés de preuves. Les équipes peuvent itérer rapidement sur des ordinateurs portables ou serveurs à GPU unique, puis passer au modèle 671B pour des évaluations de niveau leaderboard. »}},{« @type »: »Question », »name »: »Où la communauté peut-elle accéder au modèle et aux artefacts de preuve ? », »acceptedAnswer »:{« @type »: »Answer », »text »: »La sortie est disponible sur Hugging Face à l’adresse https://huggingface.co/deepseek-ai/DeepSeek-Prover-V2-671B. Les preuves générées pour le dataset MiniF2F sont également publiées, permettant l’inspection, la réplication et l’analyse approfondie par la communauté. »}},{« @type »: »Question », »name »: »Comment DeepSeek-Prover-V2 aide-t-il à combler le raisonnement informel et formel ? », »acceptedAnswer »:{« @type »: »Answer », »text »: »Les paires d’entraînement relient le raisonnement en chaîne de pensée aux étapes formelles Lean 4 pour le même problème. En apprenant ces deux récits simultanément, le modèle devient capable de transformer les décompositions intuitives en objets preuve vérifiables, assurant que l’intuition mène à la correction. »}}]}Comment fonctionne réellement la Recherche Récursive de Preuves dans DeepSeek-Prover-V2 ?

Le système décompose un théorème cible en sous-objectifs, prouve chaque fragment avec un prouveur 7B sous Lean 4, puis compose un certificat final. DeepSeek-V3 élabore initialement les sous-objectifs et la structure formelle, tandis que l’apprentissage par renforcement affine les stratégies en utilisant des retours corrects ou incorrects. Le résultat est un chemin structuré du raisonnement informel aux preuves vérifiées par le vérificateur.

Qu’est-ce qui différencie ProverBench des évaluations existantes ?

ProverBench contient 325 problèmes : 15 formalisés à partir de compétitions récentes AIME et 310 sélectionnés dans des manuels et tutoriels. Ce mélange capture à la fois la saveur des compétitions et la profondeur pédagogique, produisant un benchmark qui reflète les besoins en classe et la rigueur de la recherche avec une gradation claire de la difficulté.

Le prouveur 7B peut-il fonctionner sur du matériel modeste ?

Oui. Le modèle 7B est conçu pour le développement local et l’usage pédagogique, supportant jusqu’à 32K tokens pour gérer de longs tracés de preuves. Les équipes peuvent itérer rapidement sur des ordinateurs portables ou serveurs à GPU unique, puis passer au modèle 671B pour des évaluations de niveau leaderboard.

Où la communauté peut-elle accéder au modèle et aux artefacts de preuve ?

La sortie est disponible sur Hugging Face à l’adresse https://huggingface.co/deepseek-ai/DeepSeek-Prover-V2-671B. Les preuves générées pour le dataset MiniF2F sont également publiées, permettant l’inspection, la réplication et l’analyse approfondie par la communauté.

Comment DeepSeek-Prover-V2 aide-t-il à combler le raisonnement informel et formel ?

Les paires d’entraînement relient le raisonnement en chaîne de pensée aux étapes formelles Lean 4 pour le même problème. En apprenant ces deux récits simultanément, le modèle devient capable de transformer les décompositions intuitives en objets preuve vérifiables, assurant que l’intuition mène à la correction.

-

Open Ai7 jours ago

Open Ai7 jours agoLibérer la puissance des Plugins ChatGPT : améliorez votre expérience en 2025

-

Open Ai6 jours ago

Open Ai6 jours agoMaîtriser l’ajustement fin de GPT : un guide pour personnaliser efficacement vos modèles en 2025

-

Open Ai6 jours ago

Open Ai6 jours agoComparer ChatGPT d’OpenAI, Claude d’Anthropic et Bard de Google : quel outil d’IA générative dominera en 2025 ?

-

Open Ai6 jours ago

Open Ai6 jours agoTarification de ChatGPT en 2025 : Tout ce que vous devez savoir sur les tarifs et abonnements

-

Open Ai6 jours ago

Open Ai6 jours agoLa suppression progressive des modèles GPT : à quoi les utilisateurs peuvent s’attendre en 2025

-

Modèles d’IA6 jours ago

Modèles d’IA6 jours agoModèles GPT-4 : Comment l’intelligence artificielle transforme 2025