Tech

Dévoiler les Causes Fondamentales des Échecs de Tâches : Perspectives des Chercheurs de PSU et Duke sur l’Attribution Automatisée des Échecs dans les Systèmes Multi-Agents

Les chercheurs de PSU et de Duke, rejoints par des collaborateurs de Google DeepMind et d’autres, redéfinissent un problème récurrent dans le développement Multi-Agent : tracer la cause racine d’un échec de tâche à travers des journaux longs et entremêlés. Leur travail phare à ICML 2025 propose une attribution automatisée—une méthode rigoureuse pour identifier quel agent a échoué et quand—étayée par un nouveau jeu de données ouvert et des méthodes de référence. L’objectif est simple : transformer les pannes opaques en diagnostics système structurés qui accélèrent l’itération.

| Pressé ? Voici l’essentiel : ⚡ | |

|---|---|

| • 🔎 Nouvelle tâche : attribution automatisée des échecs pour les flux de travail Multi-Agent LLM. | • 🧭 Benchmark : jeu de données Who&When avec étiquettes Qui, Quand, Pourquoi. |

| • 📉 Défi : meilleure méthode unique atteint ~53,5% sur « Qui » et ~14,2% sur « Quand ». | • 🧰 Enseignement : les prompts hybrides riches en raisonnement et le contrôle précis du contexte fonctionnent le mieux. |

Attribution automatisée des échecs dans les systèmes multi-agents : pourquoi l’analyse de la cause racine est importante

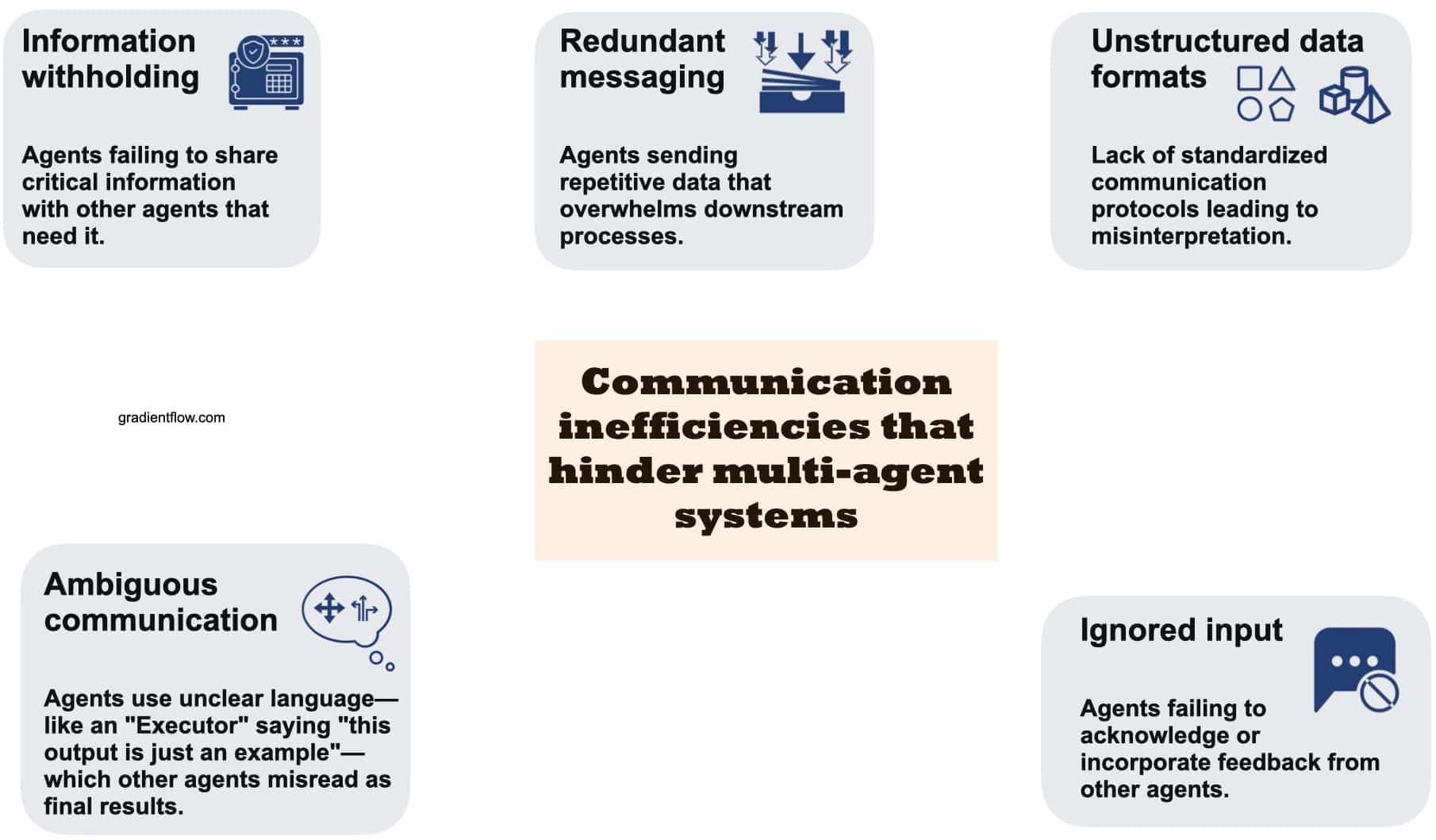

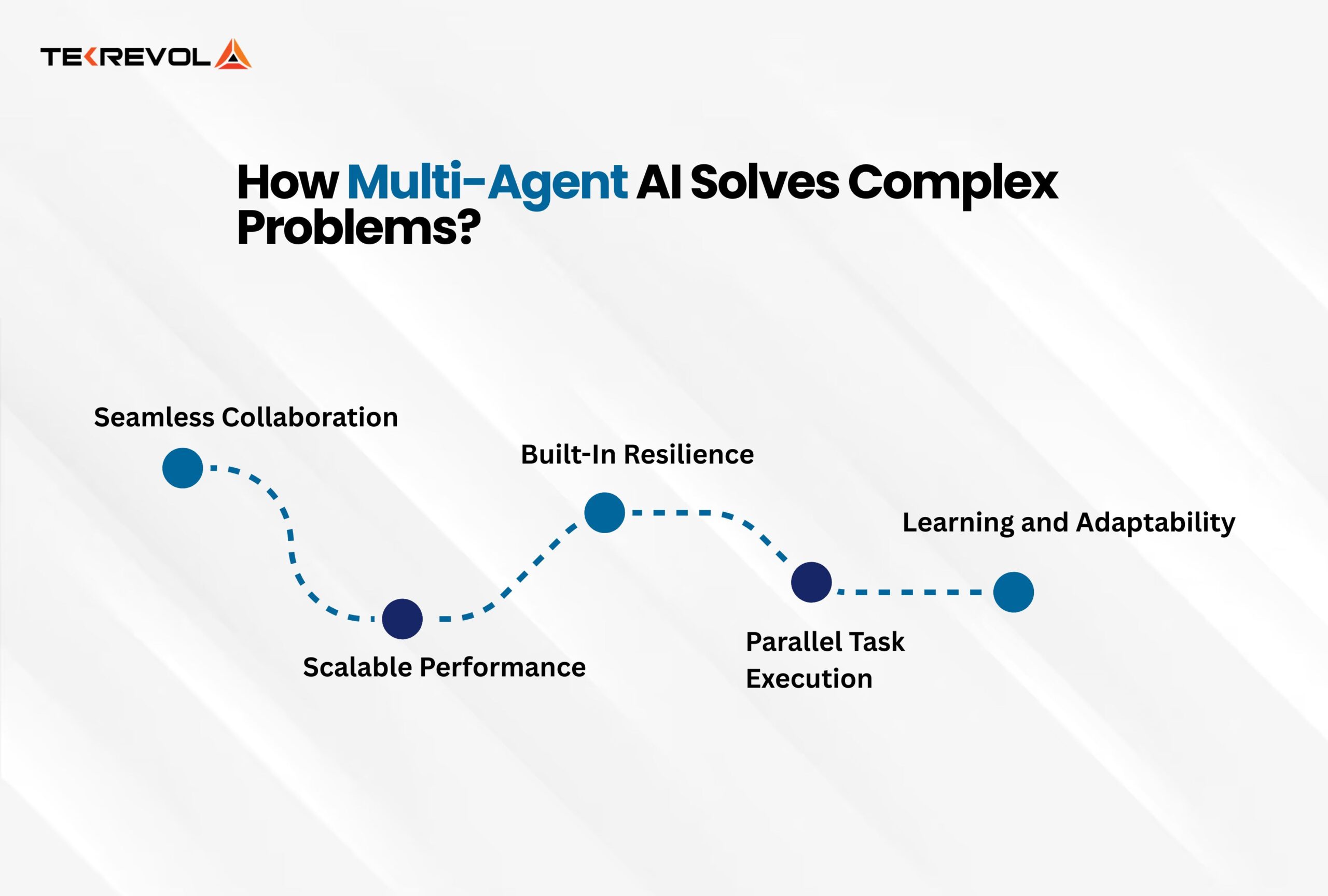

Les pipelines Multi-Agent promettent la collaboration, mais en pratique, une avalanche de messages d’agents peut masquer des erreurs critiques. Les développeurs sont souvent confrontés à de longues traces où plusieurs agents proposent des plans, se critiquent mutuellement et appellent des outils, alors que le résultat final rate la cible. Sans analyse de cause racine structurée, le « ce qui a mal tourné, qui en est responsable, et quand » reste enfoui dans le bruit. PSU et Duke ont entrepris de formaliser ce maillon manquant en recherche en IA en nommant et définissant la attribution automatisée pour les systèmes intelligents multi-agents.

Pourquoi cette formalisation est importante est simple. Le débogage par « archéologie des journaux » manuelle consomme des heures, nécessite une expertise approfondie du système, et peine à s’adapter à mesure que les équipes expérimentent plus d’agents, des contextes plus longs et des flux de travail riches en outils. Une couche d’attribution principielle transforme le blâme qualitatif en diagnostics système quantifiables. Ce changement impacte tout, de la réponse aux incidents à la gouvernance du modèle, améliorant finalement la fiabilité des systèmes de machine learning déployés dans des organisations réelles.

Considérons « NovaAI », une startup fictive construisant une équipe autonome de codage. Un agent produit collecte les spécifications, un planificateur décompose les tâches, un codeur écrit les correctifs, et un testeur exécute l’intégration continue. Une version échoue car le codeur a mal compris un changement d’API suggéré plus tôt par le planificateur. Sans attribution, l’équipe ne corrige que les symptômes—peut-être en augmentant la température ou en changeant le modèle du codeur—pour finalement reproduire le même schéma d’échec. Avec l’attribution automatisée, elle obtient une assignation concrète : agent responsable, étape décisive, et une brève explication. Désormais, l’équipe peut mettre à jour les prompts, réorganiser les passations, ou créer un validateur de schéma à cette étape.

Trois raisons rendent cette tâche particulièrement difficile. Premièrement, le échec de tâche peut être systémique, avec des petites erreurs qui se cumulent plutôt qu’un seul faux pas catastrophique. Deuxièmement, la « bonne » réponse peut ne pas être connue durant le débogage, surtout dans des problèmes ouverts. Troisièmement, les longues fenêtres contextuelles diluent le signal ; les modèles de raisonnement doivent trier les points d’ancrage causaux, pas seulement corréler des fragments de texte. C’est pourquoi le cadre de PSU et Duke insiste à la fois sur le Qui et le Quand, puis les complète par un Pourquoi en langage naturel, liant responsabilité et mécanisme.

L’impact sur les processus organisationnels est tout aussi important. Les équipes opérations obtiennent des comptes-rendus cohérents ; les équipes recherche comparent variantes d’agents sur un étalon commun ; les équipes conformité auditent les schémas d’échec. Même les chefs de produit bénéficient, en voyant quels scénarios utilisateurs font régulièrement échouer les agents. Un nouveau vocabulaire autour de l’échec d’agent améliore la communication interfonctionnelle et la priorisation.

- 🧩 Bénéfice : transforme des incidents vagues en étapes concrètes et réparables dans toute la chaîne.

- 🕒 Efficacité : réduit le temps de revue manuelle des journaux en ciblant un seul agent et une étape.

- 🧪 Expérimentation : permet des tests A/B d’agents basés sur des profils d’erreurs causales, pas seulement sur des métriques finales.

- 🛡️ Gouvernance : crée des pistes d’audit pour la sécurité, conformité et revues post-incident.

| Point douloureux 😵 | Impact sur les équipes 🧠 | Valeur de l’attribution ✅ |

|---|---|---|

| Journaux longs et bruyants | Triage lent ; conjectures | Localiser précisément “Qui” + “Quand” pour cibler les corrections |

| Chaînes causales cachées | Atténuations mal ciblées | Explications “Pourquoi” révèlent les mécanismes |

| Pas de vocabulaire partagé | Frictions inter-équipes | Étiquettes standards facilitent les comparaisons |

| Montée en charge agents/outils | Pics de complexité | Diagnostics système comme barrières de sécurité |

L’idée principale est simple : quand l’attribution automatisée devient une couche par défaut dans le développement Multi-Agent, la fiabilité cesse d’être anecdotique pour devenir mesurable.

À l’intérieur du benchmark Who&When : données, étiquettes et choix de conception de PSU et Duke

Pour cadrer le problème, PSU et Duke ont constitué le jeu de données Who&When—des journaux d’échecs couvrant 127 configurations multi-agents. Certaines traces sont générées algorithmiquement pour la couverture ; d’autres sont façonnées par des experts pour préserver le réalisme. Chaque journal porte trois annotations humaines fines : Qui (l’agent responsable), Quand (l’étape décisive), et Pourquoi (une courte explication). Ce trio capture responsabilité, temporalité et mécanisme en une forme exploitable par machine.

Les développeurs peuvent consulter le code sur GitHub et récupérer le jeu de données sur Hugging Face, reliant l’évaluation à des pipelines reproductibles. La conception reflète des archétypes communs : flux planification-puis-exécution ; structures débat-et-sélection ; et agents augmentés par outils appelant des API externes. Les étiquettes sont cohérentes à travers ces schémas, rendant possible la comparaison des méthodes d’attribution par topologie, domaine de tâche ou longueur du journal.

Deux régimes d’évaluation révèlent comment le contexte modifie la difficulté. En configuration « Avec vérité terrain », le modèle d’attribution connaît la bonne réponse finale ; il peut vérifier les étapes intermédiaires versus cette réponse. En configuration « Sans vérité terrain », il doit raisonner uniquement depuis le processus—miroir plus fidèle des incidents en production. Dans les deux cas, les sorties principales restent identiques, ce qui aide les équipes à analyser les lacunes de raisonnement plutôt que à mémoriser les résultats.

Au-delà des étiquettes, le jeu de données inclut des métadonnées : rôles des agents, usage des outils, systèmes sources. Ces métadonnées permettent une analyse plus riche, par exemple pour savoir si les agents critiques réduisent les erreurs ou si les appels outils sont corrélés à des coordinations fragiles. Comme les journaux varient en longueur, le benchmark peut quantifier la dégradation des performances avec la taille du contexte—une limitation connue des modèles de raisonnement actuels.

Pour les équipes adoptant ces données, une voie pragmatique est de commencer par une tranche étroite qui reflète leur stack. Si l’équipe opère un trio planificateur-codeur-testeur, elle peut filtrer pour des topologies similaires et construire des prompts utilisant le schéma d’annotation Who&When. Plus tard, elle pourra étendre aux agents de type débat ou chargés de récupération et observer si les schémas d’échec changent avec l’architecture.

- 📚 Étiquettes : Qui (agent), Quand (étape), Pourquoi (explication).

- 🧭 Configurations : Avec ou Sans vérité terrain pour variabilité réaliste.

- 🧩 Couverture : 127 systèmes couvrant planification, débat, usage d’outils.

- 🔓 Ouvert : article • code • jeu de données

| Facette du dataset 🗂️ | Pourquoi c’est important 🎯 | Enseignement d’équipe 🧰 |

|---|---|---|

| Étiquettes Qui / Quand / Pourquoi | Analyse RCA structurée entre agents | Standardiser les post-mortems |

| Diversité topologique | Teste la robustesse des méthodes | Accorder à votre architecture |

| Variation longueur contexte | Mesure les limites d’échelle | Planifier fractionnement/condensation |

| Pipelines open-source | Bases reproductibles | Adopter puis adapter |

Pour une première orientation aux schémas de débogage Multi-Agent et aux objectifs d’attribution, la recherche suivante peut aider à repérer les présentations et démonstrations pertinentes dans la communauté.

La force du jeu de données réside dans sa passerelle entre rigueur académique et utilité terrain : les équipes peuvent embarquer le schéma directement dans leurs outils d’incident et boucler de « l’évaluation » à « l’amélioration ».

Trois stratégies d’attribution automatisée : tout-en-un, étape par étape, et recherche binaire

Avec le benchmark en place, l’équipe a évalué trois stratégies pour l’attribution automatisée. Chacune reflète une philosophie différente de lecture et raisonnement sur les journaux. La méthode Tout-en-un alimente la conversation complète et la requête utilisateur à un modèle (ex. GPT-4o), demandant Qui et Quand en une seule fois, avec une explication optionnelle. C’est peu coûteux en contrôle de flux mais peut rater des erreurs fines quand les contextes sont longs ou que des contradictions subtiles se cachent dans les passations de rôle.

La stratégie étape par étape imite le débogage humain : parcourir le journal séquentiellement, évaluer chaque étape, et s’arrêter dès qu’une erreur décisive apparaît. Elle tend à mieux localiser l’étape spécifique, bien qu’elle augmente le coût en tokens et risque l’accumulation d’erreurs dans les jugements à plusieurs niveaux. Imaginez un réviseur méticuleux qui sacrifie la vitesse à la précision.

Un chemin intermédiaire est la recherche binaire. Diviser le journal en deux, demander au modèle quel segment contient l’erreur, puis récursivement. Cela réduit rapidement le contexte et évite la lecture intégrale. Elle équilibre souvent coût et exactitude, bien qu’elle reste sensible aux frontières ambiguës—par exemple quand une mauvaise interprétation commence tôt mais se manifeste tard.

Le choix entre ces stratégies dépend des contraintes. Si les équipes optimisent coût financier et temps ingénieur, Tout-en-un est un point de départ, surtout si les prompts exigent un raisonnement explicite. Si la priorité est de localiser précisément l’étape d’erreur dans les flux critiques, étape par étape est préféré. La recherche binaire est attractive pour les journaux longs avec pivots sémantiques clairs (planification vs exécution). Les hybrides—comme Tout-en-un pour deviner l’agent et étape par étape pour localiser le timing—brillent souvent mais entraînent un surcoût de calcul.

- ⚙️ Tout-en-un : flux de contrôle simple ; surveiller les limites de contexte.

- 🧭 Étape par étape : plus de précision sur « Quand » ; surveiller les erreurs cumulées.

- ✂️ Recherche binaire : réduction efficace ; sensible aux frontières floues.

- 🧪 Hybride : combine les forces ; coût et temps plus élevés.

| Méthode 🔬 | Atout 💪 | Risque ⚠️ | Meilleur cas d’usage 🚀 |

|---|---|---|---|

| Tout-en-un | Faible orchestration, rapide | Laisse passer des erreurs subtiles d’étape | Journaux courts à moyens |

| Étape par étape | Précision d’étape | Coûts tokens et latence | Audits critiques |

| Recherche binaire | S’adapte aux journaux longs | Segmentation ambiguë | Traces profondes avec pivots |

| Hybride | Meilleur des deux | Coûteux en calcul | Incidents à enjeux élevés |

La règle pratique est d’instrumenter les trois et de router selon la taille et le risque de la trace : petites traces vers Tout-en-un, grandes vers Recherche binaire, et flux critiques vers Étape par étape. Cette politique capture des gains rapides tout en réservant la précision à ce qui compte.

Résultats expérimentaux et cas d’usage réels : ce qui échoue, qui échoue, et quand

Sur Who&When, la meilleure méthode unique a atteint environ 53,5% de précision pour identifier l’agent responsable et environ 14,2% pour localiser précisément l’étape d’erreur—mieux que de nombreuses bases de référence, mais loin d’une solution prête pour la production. Il est notable que même des modèles de raisonnement forts, incluant OpenAI o1 et DeepSeek R1, ont eu du mal avec la causalité multi-niveaux et nuancée. Ce fossé souligne la différence entre résoudre des tâches et expliquer les échecs d’une collectivité d’agents.

Deux leviers ont constamment aidé : exiger un raisonnement explicite dans les prompts (ex. raisonnements en chaîne) et contraindre le contexte par fractionnement ou navigation guidée. Cependant, les performances chutaient avec la longueur croissante des journaux, surtout sur l’étiquette « Quand »—preuve que la localisation temporelle reste la difficulté majeure. La stratégie Recherche binaire a atténué la surcharge contextuelle, tandis que l’Étape par étape améliorait la précision temporelle à un coût plus élevé.

Sur le terrain, considérez « Orion Labs », une entreprise analytique hypothétique construisant un générateur de rapports Multi-Agent. Un planificateur rédige un plan de données, un récupérateur extrait des tableaux, un rédacteur compile un récit, et un vérificateur contrôle la cohérence. Un client remarque un décalage dans les revenus trimestriels pour une région. L’attribution révèle que le récupérateur a utilisé un schéma obsolète après qu’un appel outil ait renvoyé un index périmé. L’erreur décisive est survenue en milieu de trace, mais le symptôme n’est apparu qu’à la vérification finale. Grâce aux diagnostics automatisés, Orion reconfigure le récupérateur pour valider la version du schéma au moment de l’extraction et pour générer une erreur stricte en cas de décalage.

Les stratégies hybrides ont également été utilisées en conditions réelles : exécuter d’abord Tout-en-un pour nommer l’agent probable, puis faire Étape par étape ciblé uniquement sur les passations de cet agent. L’hybride a augmenté la précision dans plusieurs cas, bien que les coûts en tokens aient augmenté. Les équipes ont pesé les coûts en orientant les incidents à forte valeur vers les hybrides et les régressions de routine vers des méthodes moins coûteuses.

- 📉 Vérification terrain : l’attribution des tâches est plus difficile que leur exécution pour les modèles actuels.

- 🧠 Raisonnement explicite améliore « Qui » et « Quand ».

- 🧱 Longueur du contexte reste un facteur limitant ; le fractionnement aide.

- 🧯 Hybrides fonctionnent mieux pour incidents critiques malgré le coût.

| Constatation 🔎 | Preuve 📊 | Implication 🧭 |

|---|---|---|

| « Qui » plus facile que « Quand » | 53,5% contre 14,2% | Prioriser la recherche sur la localisation d’étape |

| Le raisonnement aide | Meilleurs résultats avec raisonnements explicites | Imposer des prompts raisonné |

| Le contexte nuit | Journaux longs dégradent la précision | Adopter Recherche binaire + résumé |

| Les hybrides rapportent | Précision combinée améliorée | Diriger les incidents à fort enjeu vers la politique hybride |

Pour des perspectives supplémentaires sur les pannes complexes de systèmes et les flux diagnostics, cette recherche fera émerger des talks et études de cas pertinents pour praticiens et chercheurs.

La conclusion : l’attribution est désormais mesurable. Même si les scores restent modestes, la voie vers la fiabilité opérationnelle devient empirique et itérative.

Playbook actionnable pour développeurs : des diagnostics système à la fiabilité continue

Transformer la recherche en pratique commence par une mentalité pipeline. Considérez l’attribution automatisée comme une étape standard dans l’intégration continue des releases Multi-Agent. Capturez les journaux, normalisez les rôles, et lancez automatiquement l’attribution après chaque exécution échouée. Puis convertissez les résultats en tickets spécifiant l’agent, l’étape, et un bref « pourquoi ». Au fil du temps, cela produit un catalogue vivant de motifs d’échec—mauvaise interprétation des prompts, outils obsolètes, passations fragiles—que l’ingénierie peut éliminer systématiquement.

Considérez un déploiement pratique. Commencez avec Tout-en-un sur les traces courtes et ajoutez Recherche binaire au-delà d’un seuil de longueur de contexte. Pour les flux client ou critiques en sécurité, activez Étape par étape ou un hybride. Regroupez des prompts qui exigent un raisonnement explicite, requièrent que les verdicts modèles citent des lignes de journal, et mettez en cache les sous-analyses pour maîtriser les coûts. Autant que possible, ajoutez des validateurs légers aux étapes sensibles : vérifications de version de schéma, tests unitaires pour sorties d’outils, et barrières qui bloquent les passations ambiguës.

L’hygiène des prompts et données compte. Utilisez le schéma Who&When en interne pour que les post-mortems restent cohérents entre équipes. Encouragez les agents à rédiger des raisonnements courts et analysables par machine (ex. JSON avec « revendication », « preuve », « confiance »). Journalisez les métadonnées des outils—version, endpoint, latence—pour distinguer les erreurs de logique d’agent des problèmes d’infrastructure. En environnement multi-locataire, nettoyez les données personnelles avant d’exporter les traces vers des benchmarks partagés.

Enfin, alignez les parties prenantes. Le produit priorise les scénarios selon l’impact utilisateur, la recherche cible les localisations « Quand » les plus difficiles, et les opérations maintiennent des tableaux de bord montrant les taux d’incidents par agent et étape. La direction reçoit des courbes d’évolution : à mesure que les taux d’attribution s’améliorent, le MTTR des incidents diminue. En quelques mois, l’organisation passe de la réaction aux échecs à leur prévention, soutenue par des diagnostics mesurables.

- 🧪 Commencez petit : pilotez un flux à fort trafic avant de scaler.

- 🪜 Politique graduée : orientez selon la longueur des journaux et le risque métier.

- 🧰 Outils : ajoutez validateurs et passations typées aux maillons fragiles.

- 📈 Métriques : suivez précision attribution et MTTR conjointement.

| Phase 🚀 | À implémenter 🧩 | Résultat 🎯 |

|---|---|---|

| Instrumentation | Journaux structurés, balises de rôle, métadonnées outils | Entrées propres pour l’attribution |

| Moteur d’attribution | Tout-en-un + Recherche binaire + Étape par étape | Couverture des formes de trace |

| Barrières | Contrôles de schéma, tests unitaires outils, passations typées | Moins de défaillances récurrentes |

| Opérations | Ticket automatique avec Qui/Quand/Pourquoi | Corrections plus rapides et ciblées |

| Boucle d’apprentissage | Tableaux de bord d’évolution, échanges A/B d’agents | Gains de fiabilité continus |

La vérité terrain n’est pas toujours disponible en production, préférez donc les méthodes robustes à l’incertitude et investissez dans des évaluations synthétiques reflétant votre profil de risque. L’attribution n’est pas seulement un jalon de recherche ; c’est un levier pratique pour rendre les systèmes intelligents fiables à grande échelle.

{« @context »: »https://schema.org », »@type »: »FAQPage », »mainEntity »:[{« @type »: »Question », »name »: »Qu’est-ce qui différencie l’attribution automatisée des échecs du débogage standard? », »acceptedAnswer »:{« @type »: »Answer », »text »: »Elle formalise la responsabilité et le timing—identifiant l’agent exact (Qui) et l’étape décisive (Quand)—et les lie à une courte explication (Pourquoi). Cela transforme les revues de journaux libres en diagnostics système structurés adaptés aux métriques, audits et automatisation. »}},{« @type »: »Question », »name »: »Comment PSU et Duke évaluent-ils les méthodes équitablement ? », »acceptedAnswer »:{« @type »: »Answer », »text »: »Ils utilisent le benchmark Who&When avec deux régimes : Avec vérité terrain (le modèle connaît la bonne réponse) et Sans vérité terrain (le modèle se base uniquement sur le processus). Cela isole les compétences de raisonnement de la recherche de réponse et assure une comparaison cohérente. »}},{« @type »: »Question », »name »: »Pourquoi des modèles forts comme OpenAI o1 et DeepSeek R1 rencontrent-ils encore des difficultés ? », »acceptedAnswer »:{« @type »: »Answer », »text »: »L’attribution exige un raisonnement multi-niveaux causal et une localisation temporelle à travers de longs contextes. Ces exigences sont plus difficiles que de produire une réponse finale, surtout lorsque les erreurs s’accumulent ou émergent indirectement via l’usage d’outils. »}},{« @type »: »Question », »name »: »Quand une équipe devrait-elle préférer la recherche binaire à la méthode étape par étape ? », »acceptedAnswer »:{« @type »: »Answer », »text »: »Utilisez la recherche binaire pour les longues traces où l’erreur se situe probablement derrière des frontières sémantiques majeures (planification vs exécution). Choisissez étape par étape quand la précision de l’étape exacte l’emporte sur les coûts ou la latence. »}},{« @type »: »Question », »name »: »Par où les développeurs peuvent-ils commencer avec les ressources ouvertes ? », »acceptedAnswer »:{« @type »: »Answer », »text »: »Lisez l’article phare ICML 2025, clonez le dépôt GitHub des pipelines, et téléchargez le jeu de données Who&When depuis Hugging Face. Commencez par refléter votre propre topologie d’agents et adoptez le schéma Qui/Quand/Pourquoi dans les post-mortems internes. »}}]}Qu’est-ce qui différencie l’attribution automatisée des échecs du débogage standard?

Elle formalise la responsabilité et le timing—identifiant l’agent exact (Qui) et l’étape décisive (Quand)—et les lie à une courte explication (Pourquoi). Cela transforme les revues de journaux libres en diagnostics système structurés adaptés aux métriques, audits et automatisation.

Comment PSU et Duke évaluent-ils les méthodes équitablement ?

Ils utilisent le benchmark Who&When avec deux régimes : Avec vérité terrain (le modèle connaît la bonne réponse) et Sans vérité terrain (le modèle se base uniquement sur le processus). Cela isole les compétences de raisonnement de la recherche de réponse et assure une comparaison cohérente.

Pourquoi des modèles forts comme OpenAI o1 et DeepSeek R1 rencontrent-ils encore des difficultés ?

L’attribution exige un raisonnement multi-niveaux causal et une localisation temporelle à travers de longs contextes. Ces exigences sont plus difficiles que de produire une réponse finale, surtout lorsque les erreurs s’accumulent ou émergent indirectement via l’usage d’outils.

Quand une équipe devrait-elle préférer la recherche binaire à la méthode étape par étape ?

Utilisez la recherche binaire pour les longues traces où l’erreur se situe probablement derrière des frontières sémantiques majeures (planification vs exécution). Choisissez étape par étape quand la précision de l’étape exacte l’emporte sur les coûts ou la latence.

Par où les développeurs peuvent-ils commencer avec les ressources ouvertes ?

Lisez l’article phare ICML 2025, clonez le dépôt GitHub des pipelines, et téléchargez le jeu de données Who&When depuis Hugging Face. Commencez par refléter votre propre topologie d’agents et adoptez le schéma Qui/Quand/Pourquoi dans les post-mortems internes.

-

Open Ai6 jours ago

Open Ai6 jours agoLibérer la puissance des Plugins ChatGPT : améliorez votre expérience en 2025

-

Open Ai5 jours ago

Open Ai5 jours agoMaîtriser l’ajustement fin de GPT : un guide pour personnaliser efficacement vos modèles en 2025

-

Open Ai6 jours ago

Open Ai6 jours agoComparer ChatGPT d’OpenAI, Claude d’Anthropic et Bard de Google : quel outil d’IA générative dominera en 2025 ?

-

Open Ai5 jours ago

Open Ai5 jours agoTarification de ChatGPT en 2025 : Tout ce que vous devez savoir sur les tarifs et abonnements

-

Open Ai6 jours ago

Open Ai6 jours agoLa suppression progressive des modèles GPT : à quoi les utilisateurs peuvent s’attendre en 2025

-

Modèles d’IA5 jours ago

Modèles d’IA5 jours agoModèles GPT-4 : Comment l’intelligence artificielle transforme 2025