Tecnologia

Revelando as Causas Fundamentais das Falhas de Tarefas: Insights de Pesquisadores da PSU e Duke sobre Atribuição Automatizada de Falhas em Sistemas Multiagentes

Pesquisadores da PSU e Duke, acompanhados por colaboradores do Google DeepMind e outros, estão reformulando um problema perene no desenvolvimento Multi-Agente: rastrear a causa raiz de uma falha de tarefa em longos logs entrelaçados. O trabalho destaque do ICML 2025 propõe a Atribuição Automatizada—uma maneira rigorosa de identificar qual agente falhou e quando—com o apoio de um novo conjunto de dados aberto e métodos baseline. O objetivo é simples: transformar falhas opacas em diagnósticos do sistema estruturados que aceleram a iteração.

| Com pressa? Veja o que importa: ⚡ | |

|---|---|

| • 🔎 Nova tarefa: atribuição automatizada de falhas para fluxos de trabalho LLM Multi-Agente. | • 🧭 Benchmark: conjunto de dados Who&When com rótulos Quem, Quando, Por quê. |

| • 📉 Desafio: melhor método único alcança ~53,5% em “Quem” e ~14,2% em “Quando”. | • 🧰 Conclusão: prompts híbridos, ricos em raciocínio, e controle cuidadoso de contexto funcionam melhor. |

Atribuição Automatizada de Falhas em Sistemas Multi-Agente: Por Que a Análise da Causa Raiz Importa

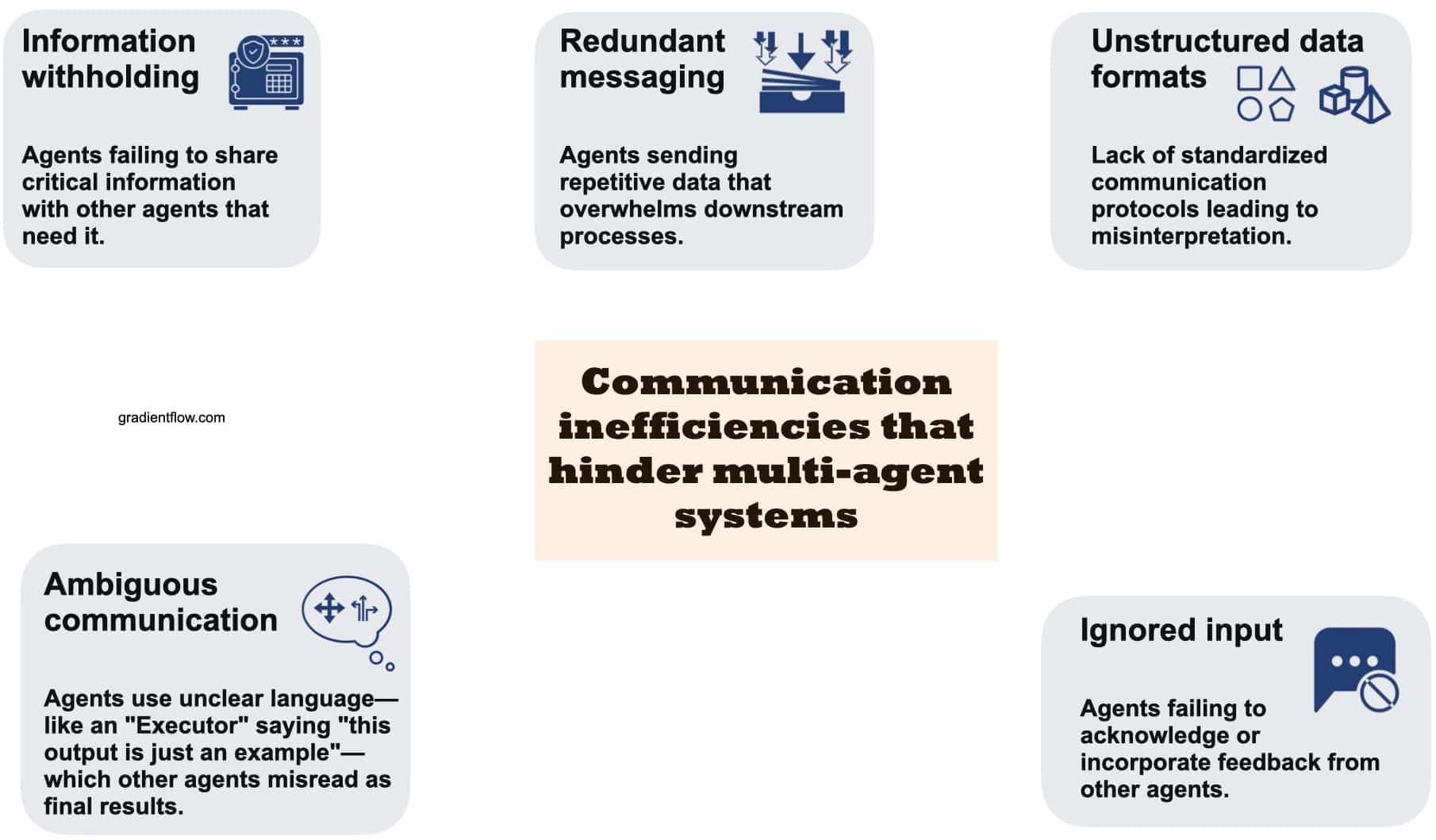

Pipelines Multi-Agente prometem colaboração, mas na prática uma enxurrada de mensagens dos agentes pode mascarar erros críticos. Desenvolvedores frequentemente enfrentam longos rastros onde vários agentes propõem planos, criticam uns aos outros e chamam ferramentas, porém o resultado final falha ao atingir o alvo. Sem uma Análise de Causa Raiz estruturada, o “o que deu errado, quem causou isso e quando” permanece enterrado no ruído. PSU e Duke buscaram formalizar essa ligação ausente em Pesquisa de IA nomeando e delimitando a Atribuição Automatizada para Sistemas Inteligentes Multi-Agente.

Por que a formalização importa é direto. Depurar através da “arqueologia de logs” manual consome horas, exige profundo conhecimento do sistema e escala mal conforme as equipes experimentam com mais agentes, contextos mais longos e fluxos de trabalho pesados em ferramentas. Uma camada de atribuição racional transforma culpa qualitativa em Diagnósticos do Sistema quantificáveis. Essa mudança impacta desde a resposta a incidentes até a governança de modelos, melhorando a confiabilidade dos sistemas de Aprendizado de Máquina implantados em organizações reais.

Considere “NovaAI”, uma startup fictícia construindo uma equipe autônoma de codificação. Um agente de produto coleta especificações, um planejador decompõe tarefas, um codificador escreve patches, e um testador executa CI. Um lançamento falha porque o codificador entendeu mal uma mudança de API sugerida anteriormente pelo planejador. Sem atribuição, a equipe corrige sintomas superficiais—talvez ajustando a temperatura ou trocando o modelo do codificador—para logo repetir o mesmo padrão de falha. Com atribuição automatizada, eles recebem uma tarefa concreta: agente responsável, passo decisivo, e uma breve explicação. Agora a equipe pode atualizar prompts, redesenhar as transições, ou criar um validador de esquema nessa etapa.

Três razões tornam essa tarefa singularmente difícil. Primeiro, a Falha de Tarefa pode ser sistêmica, com pequenos erros se acumulando em vez de um único equívoco catastrófico. Segundo, a “resposta certa” pode não ser conhecida durante a depuração, especialmente em problemas abertos. Terceiro, janelas de contexto longas diluem o sinal; modelos de raciocínio devem buscar pontos causais, não apenas correlacionar fragmentos de texto. Por isso, o enquadramento da PSU e Duke enfatiza tanto o Quem quanto o Quando, complementando-os com o Por quê em linguagem natural, ligando responsabilidade e mecanismo.

Igualmente importante é o impacto nos processos organizacionais. Equipes de operações obtêm post-mortems consistentes; equipes de pesquisa comparam variantes de agentes com uma régua comum; equipes de compliance auditam padrões de falhas. Até gerentes de produto se beneficiam, vendo quais cenários de usuários frequentemente atrapalham os agentes. Um novo vocabulário em torno da falha de agentes melhora a comunicação e priorização interfuncional.

- 🧩 Benefício: Transforma incidentes vagos em passos concretos e corrigíveis ao longo do pipeline.

- 🕒 Eficiência: Reduz o tempo de revisão manual de logs ao focar em um único agente e passo.

- 🧪 Experimentação: Permite A/B testing de agentes baseando-se em perfis de erro causal, não apenas métricas finais.

- 🛡️ Governança: Cria trilhas de auditoria para segurança, compliance e revisões pós-incidente.

| Ponto problemático 😵 | Impacto nas equipes 🧠 | Valor da atribuição ✅ |

|---|---|---|

| Logs longos e ruidosos | Triagem lenta; conjecturas | Identificar “Quem” + “Quando” para focar correções |

| Cadeias causais ocultas | Mitigações erradas | Explicações “Por quê” trazem mecanismos à tona |

| Vocabulário não compartilhado | Conflito interequipes | Rótulos padrão permitem comparações |

| Escalar agentes/ferramentas | Picos de complexidade | Diagnósticos do Sistema como guardrails |

O insight principal é simples: quando a Atribuição Automatizada se torna uma camada padrão no desenvolvimento Multi-Agente, a confiabilidade deixa de ser anedótica e passa a ser mensurável.

Dentro do Benchmark Who&When: Dados, Rótulos e Escolhas de Design da PSU e Duke

Para fundamentar o problema, PSU e Duke criaram o conjunto de dados Who&When—logs de falhas abrangendo 127 ambientes Multi-Agente. Alguns rastros são gerados algoritmicamente para cobertura; outros são elaborados por especialistas para preservar realismo. Cada log carrega três anotações humanas detalhadas: Quem (agente responsável), Quando (passo decisivo) e Por quê (uma explicação breve). Essa tríade captura responsabilidade, tempo e mecanismo em forma usável por máquina.

Desenvolvedores podem navegar no código no GitHub e obter o conjunto de dados no Hugging Face, vinculando avaliação a pipelines reproduzíveis. O design reflete arquétipos comuns: fluxos planejamento-execução; estruturas de debate e seleção; agentes aumentados com ferramentas que chamam APIs externas. Os rótulos são consistentes entre esses padrões, possibilitando comparar métodos de atribuição por topologia, domínio da tarefa ou comprimento do log.

Dois regimes de avaliação revelam como o contexto muda a dificuldade. No cenário “Com Verdade Fundamental”, o modelo que faz a atribuição conhece a resposta final correta; pode cruzar os passos intermediários com essa resposta. No cenário “Sem Verdade Fundamental”, deve raciocinar apenas pelo processo—espelhando mais de perto incidentes de produção. Em ambos, os resultados centrais permanecem iguais, o que ajuda equipes a analisar lacunas no raciocínio em vez de decorar respostas.

Além dos rótulos, o conjunto inclui metadados: papéis dos agentes, uso de ferramentas e sistemas fonte. Esses metadados permitem análises mais ricas, como avaliar se agentes críticos reduzem erros ou se chamadas a ferramentas correlacionam com coordenação frágil. Como os logs variam em comprimento, o benchmark quantifica como o desempenho se degrada com o tamanho do contexto—uma limitação conhecida dos modelos de raciocínio atuais.

Para equipes que adotam esses dados, um caminho pragmático é começar com uma fatia estreita que reflita sua pilha. Se a equipe opera trio planejador-codificador-testador, pode filtrar topologias semelhantes e construir prompts usando o esquema de anotação Who&When. Depois, podem expandir para agentes estilo debate ou com muita recuperação e ver se os padrões de falha mudam conforme a arquitetura.

- 📚 Rótulos: Quem (agente), Quando (passo), Por quê (explicação).

- 🧭 Cenários: Com e Sem Verdade Fundamental para variância realista.

- 🧩 Cobertura: 127 sistemas abrangendo planejamento, debate, uso de ferramentas.

- 🔓 Aberto: artigo • código • conjunto de dados

| Aspecto do conjunto de dados 🗂️ | Por que importa 🎯 | Resumo para a equipe 🧰 |

|---|---|---|

| Rótulos Quem / Quando / Por quê | RCA estruturada entre agentes | Padronizar post-mortems |

| Diversidade de topologia | Testa métodos em estresse | Combine com sua arquitetura |

| Variação no tamanho do contexto | Mensura limites de escala | Planeje fragmentação/condensação |

| Pipelines open-source | Baselines reproduzíveis | Adote, depois adapte |

Para uma rápida orientação sobre padrões de depuração Multi-Agente e objetivos de atribuição, a busca abaixo pode ajudar a mapear palestras e demonstrações relevantes na comunidade.

A força do conjunto está em sua ponte entre rigor acadêmico e utilidade prática: equipes podem integrar o esquema diretamente em suas ferramentas de incidentes e fechar o ciclo de “avaliação” para “melhoria.”

Três Estratégias de Atribuição Automatizada: Tudo de Uma Vez, Passo a Passo e Busca Binária

Com o benchmark estabelecido, a equipe avaliou três estratégias para Atribuição Automatizada. Cada uma reflete uma filosofia diferente de ler e raciocinar sobre logs. O método Tudo de Uma Vez fornece a conversa completa e a consulta do usuário para um modelo (por exemplo, GPT-4o), solicitando Quem e Quando em um único passo, mais uma explicação opcional. É barato em fluxo de controle, mas pode perder erros finos quando contextos são longos ou contradições sutis se escondem entre as transferências de função.

A estratégia Passo a Passo espelha a depuração humana: percorre o log sequencialmente, avalia cada passo e para ao identificar erro decisivo. Tende a localizar o passo específico melhor, embora aumente o custo de tokens e arrisque acúmulo de erros em julgamentos em vários saltos. Pense nela como um revisor meticuloso que troca velocidade por precisão.

Um meio-termo é a Busca Binária. Divide o log ao meio, pergunta ao modelo em qual segmento está o erro e recursa. Isso estreita o contexto rapidamente e evita ler tudo de uma vez. Muitas vezes equilibra custo e precisão, embora ainda possa ser sensível a limites ambíguos—por exemplo, quando uma má interpretação começa antes, mas se manifesta depois.

A escolha entre elas depende de restrições. Se equipes otimizam para custos e tempo de engenharia, Tudo de Uma Vez é um ponto de partida, especialmente se prompts exigem raciocínio explícito. Se a prioridade é localizar o erro exato em fluxos críticos de segurança, Passo a Passo vence. Busca Binária é atraente para logs longos com pivôs semânticos claros (planejamento vs. execução). Híbridos—como Tudo de Uma Vez para adivinhar o agente e Passo a Passo para identificar o tempo—frequentemente brilham, mas aumentam o custo computacional.

- ⚙️ Tudo de Uma Vez: fluxo de controle simples; atenção aos limites de contexto.

- 🧭 Passo a Passo: maior precisão em “Quando”; monitore erros cumulativos.

- ✂️ Busca Binária: estreitamento eficiente; sensível a limites imprecisos.

- 🧪 Híbrido: combina forças; pague tokens e tempo extras.

| Método 🔬 | Força 💪 | Risco ⚠️ | Melhor uso 🚀 |

|---|---|---|---|

| Tudo de Uma Vez | Baixa orquestração, rápido | Perde erros sutis em passos | Logs curtos a médios |

| Passo a Passo | Precisão por passo | Custo em tokens e latência | Auditorias críticas de segurança |

| Busca Binária | Escala para logs longos | Segmentação ambígua | Rastros profundos com pivôs |

| Híbrido | Melhor dos dois | Computacionalmente pesado | Incidentes de alto risco |

A heurística prática é instrumentar os três e direcionar conforme tamanho do rastro e risco: rastros curtos para Tudo de Uma Vez, rastros longos para Busca Binária e fluxos críticos para Passo a Passo. Essa política captura ganhos rápidos enquanto reserva precisão para onde importa.

Resultados Experimentais e Casos de Uso do Mundo Real: O Que Falha, Quem Falha e Quando

No Who&When, o melhor método isolado alcançou cerca de 53,5% de precisão em identificar o agente responsável e cerca de 14,2% em localizar o passo exato do erro—melhor que muitas linhas de base, mas longe do nirvana pronto para produção. Notavelmente, até modelos fortes, incluindo OpenAI o1 e DeepSeek R1, tiveram dificuldades com causalidade multi-salto nuanceada. Essa lacuna destaca a diferença entre resolver tarefas e explicar falhas de coletivos de agentes.

Dois fatores ajudaram consistentemente: exigir raciocínio explícito nos prompts (por exemplo, raciocínios estilo cadeia de pensamento) e limitar o contexto por fragmentação ou navegação guiada. Contudo, o desempenho caiu conforme os logs ficaram maiores, especialmente no rótulo “Quando”—evidência de que a localização temporal é a parte mais desafiadora. A estratégia Busca Binária mitigou sobrecarga de contexto, enquanto Passo a Passo melhorou a precisão temporal, mas a um custo maior.

No campo, considere “Orion Labs,” uma firma hipotética de análise que constrói um gerador de relatórios Multi-Agente. Um planejador elabora um plano de dados, um recuperador busca tabelas, um escritor compila narrativas e um verificador confere consistência. Um cliente nota que a receita trimestral está errada em uma região. A atribuição revela que o recuperador usou um esquema obsoleto após uma chamada à ferramenta retornar um índice desatualizado. O passo decisivo do erro ocorreu na metade do rastro, mas o sintoma só apareceu na verificação final. Com diagnósticos automatizados, Orion reprograma o recuperador para validar a versão do esquema no momento da busca e gerar um erro crítico se as versões não baterem.

Estratégias híbridas também viram uso real: rodar primeiro Tudo de Uma Vez para indicar o agente provável, depois executar Passo a Passo focado apenas nos passos do agente. O híbrido aumentou a precisão em vários casos, embora tenha elevado os custos de token. Equipes ponderaram o trade-off roteando incidentes de alto valor para híbridos e regressões rotineiras para métodos mais baratos.

- 📉 Cheque da realidade: atribuição de tarefas é mais difícil que execução para modelos atuais.

- 🧠 Raciocínio explícito melhora “Quem” e “Quando”.

- 🧱 Comprimento do contexto permanece limitante; fragmentar ajuda.

- 🧯 Híbridos funcionam melhor em incidentes críticos apesar do custo.

| Descoberta 🔎 | Evidência 📊 | Implicação 🧭 |

|---|---|---|

| “Quem” mais fácil que “Quando” | 53,5% vs. 14,2% | Priorize pesquisa em localização de passos |

| Raciocínio ajuda | Melhores resultados com raciocínios explícitos | Exigir prompts racionalizados |

| Contexto prejudica | Logs mais longos degradam precisão | Adote Busca Binária + sumarização |

| Híbridos compensam | Precisão combinada melhorada | Roteie casos críticos para políticas híbridas |

Para perspectivas adicionais sobre falhas complexas de sistema e fluxos de trabalho diagnósticos, essa busca revelará palestras e estudos de caso relevantes para praticantes e pesquisadores.

O ponto final: a atribuição agora é mensurável. Mesmo que as pontuações sejam modestas, o caminho para a confiabilidade operacional torna-se empírico e iterativo.

Manual Prático para Desenvolvedores: De Diagnósticos do Sistema à Confiabilidade Contínua

Transformar pesquisa em prática começa com uma mentalidade pipeline. Considere a Atribuição Automatizada uma etapa padrão na integração contínua de lançamentos Multi-Agente. Capture logs, normalize papéis e execute automaticamente a atribuição após qualquer falha. Depois, converta resultados em tíquetes que especifiquem o agente, passo e breve “por quê”. Com o tempo, isso produz um catálogo vivo de motivos de falha—leitura incorreta de prompts, ferramentas obsoletas, transferências frágeis—que a engenharia pode eliminar sistematicamente.

Considere um rollout prático. Comece com Tudo de Uma Vez em rastros curtos e adicione Busca Binária acima de um limite de tamanho de contexto. Para fluxos críticos de cliente ou de segurança, habilite Passo a Passo ou híbridos. Agrupe prompts que exigem raciocínio explícito, exija que modelos justifiquem com linhas do log, e armazene subanálises para controlar custo. Sempre que possível, adicione validadores leves em passos sensíveis: checagens de versão de esquema, testes unitários para saídas de ferramentas e guardrails que bloqueiam transições ambíguas.

Higiene de prompt e dado é essencial. Use o esquema Who&When internamente para manter post-mortems consistentes entre equipes. Incentive agentes a escrever raciocínios curtos e parseáveis por máquina (por exemplo, JSON com “afirmação,” “evidência,” “confiança”). Registre metadados de ferramentas—versão, endpoint, latência—para que a atribuição distinga erros de lógica do agente de problemas de infraestrutura. Em ambientes multi-inquilino, remova dados pessoais antes de exportar rastros para benchmarks compartilhados.

Finalmente, alinhe stakeholders. Produto prioriza cenários por impacto ao usuário, pesquisa mira localizações “Quando” mais difíceis, e operações mantém dashboards mostrando taxas de incidentes por agente e passo. Liderança recebe linhas de tendência: conforme a taxa de atribuição melhora, o MTTR dos incidentes cai. Em meses, a organização muda de reação a falhas para prevenção, sustentada por diagnósticos mensuráveis.

- 🧪 Comece pequeno: pilote em um fluxo de alto tráfego antes de escalar.

- 🪜 Política em níveis: direcione por tamanho do log e risco de negócio.

- 🧰 Ferramentas: adicione validadores e transferências tipadas em links frágeis.

- 📈 Métricas: monitore precisão de atribuição e MTTR juntas.

| Fase 🚀 | O que implementar 🧩 | Resultado 🎯 |

|---|---|---|

| Instrumentação | Logs estruturados, tags de papel, metadados de ferramenta | Entradas limpas para atribuição |

| Mecanismo de atribuição | Tudo de Uma Vez + Busca Binária + Passo a Passo | Cobertura entre formatos de rastro |

| Guardrails | Checagens de esquema, testes unitários, transferências tipadas | Menos falhas recorrentes |

| Operações | Auto-ticketing com Quem/Quando/Por quê | Correções rápidas e focadas |

| Loop de aprendizado | Dashboards de tendência, swaps de agentes A/B | Ganho contínuo de confiabilidade |

A verdade fundamental nem sempre está disponível em produção, então prefira métodos robustos à incerteza e invista em avaliações sintéticas que reflitam seu perfil de risco. Atribuição não é apenas um marco de pesquisa; é uma alavanca prática para tornar Sistemas Inteligentes confiáveis em escala.

{“@context”:”https://schema.org”,”@type”:”FAQPage”,”mainEntity”:[{“@type”:”Question”,”name”:”O que torna a atribuição automatizada de falhas diferente da depuração padrão?”,”acceptedAnswer”:{“@type”:”Answer”,”text”:”Ela formaliza a responsabilidade e o tempo—identificando o agente exato (Quem) e o passo decisivo (Quando)—e os combina com uma breve explicação (Por quê). Isso transforma revisões livres de logs em Diagnósticos do Sistema estruturados, adequados para métricas, auditorias e automação.”}},{“@type”:”Question”,”name”:”Como PSU e Duke avaliam os métodos de forma justa?”,”acceptedAnswer”:{“@type”:”Answer”,”text”:”Eles usam o benchmark Who&When com dois regimes: Com Verdade Fundamental (o modelo conhece a resposta correta) e Sem Verdade Fundamental (o modelo depende apenas do processo). Isso isola a habilidade de raciocínio da pesquisa de respostas e mantém as comparações consistentes.”}},{“@type”:”Question”,”name”:”Por que modelos fortes como OpenAI o1 e DeepSeek R1 ainda têm dificuldades?”,”acceptedAnswer”:{“@type”:”Answer”,”text”:”A atribuição exige raciocínio causal multi-salto e localização temporal em longos contextos. Essas demandas são mais difíceis que produzir uma resposta final, especialmente quando erros se acumulam ou surgem indiretamente via uso de ferramentas.”}},{“@type”:”Question”,”name”:”Quando uma equipe deve preferir Busca Binária ao Passo a Passo?”,”acceptedAnswer”:{“@type”:”Answer”,”text”:”Use Busca Binária para rastros longos onde o erro provavelmente está atrás de grandes divisões semânticas (planejamento vs. execução). Escolha Passo a Passo quando a precisão no passo exato importa mais que custo ou latência.”}},{“@type”:”Question”,”name”:”Onde desenvolvedores podem começar com os recursos abertos?”,”acceptedAnswer”:{“@type”:”Answer”,”text”:”Leia o artigo destaque do ICML 2025, clone o repositório GitHub com pipelines e baixe o conjunto de dados Who&When do Hugging Face. Comece espelhando a topologia do seu próprio agente e adote o esquema Quem/Quando/Por quê em post-mortems internos.”}}]}O que torna a atribuição automatizada de falhas diferente da depuração padrão?

Ela formaliza a responsabilidade e o tempo—identificando o agente exato (Quem) e o passo decisivo (Quando)—e os combina com uma breve explicação (Por quê). Isso transforma revisões livres de logs em Diagnósticos do Sistema estruturados, adequados para métricas, auditorias e automação.

Como PSU e Duke avaliam os métodos de forma justa?

Eles usam o benchmark Who&When com dois regimes: Com Verdade Fundamental (o modelo conhece a resposta correta) e Sem Verdade Fundamental (o modelo depende apenas do processo). Isso isola a habilidade de raciocínio da pesquisa de respostas e mantém as comparações consistentes.

Por que modelos fortes como OpenAI o1 e DeepSeek R1 ainda têm dificuldades?

A atribuição exige raciocínio causal multi-salto e localização temporal em longos contextos. Essas demandas são mais difíceis que produzir uma resposta final, especialmente quando erros se acumulam ou surgem indiretamente via uso de ferramentas.

Quando uma equipe deve preferir Busca Binária ao Passo a Passo?

Use Busca Binária para rastros longos onde o erro provavelmente está atrás de grandes divisões semânticas (planejamento vs. execução). Escolha Passo a Passo quando a precisão no passo exato importa mais que custo ou latência.

Onde desenvolvedores podem começar com os recursos abertos?

Leia o artigo destaque do ICML 2025, clone o repositório GitHub com pipelines e baixe o conjunto de dados Who&When do Hugging Face. Comece espelhando a topologia do seu próprio agente e adote o esquema Quem/Quando/Por quê em post-mortems internos.

-

Open Ai7 days ago

Open Ai7 days agoDesbloqueando o Poder dos Plugins do ChatGPT: Melhore Sua Experiência em 2025

-

Open Ai6 days ago

Open Ai6 days agoDominando o Fine-Tuning do GPT: Um Guia para Customizar Eficazmente Seus Modelos em 2025

-

Open Ai6 days ago

Open Ai6 days agoComparando o ChatGPT da OpenAI, o Claude da Anthropic e o Bard do Google: Qual Ferramenta de IA Generativa Reinará Suprema em 2025?

-

Open Ai6 days ago

Open Ai6 days agoPreços do ChatGPT em 2025: Tudo o Que Você Precisa Saber Sobre Tarifas e Assinaturas

-

Open Ai6 days ago

Open Ai6 days agoO Fim Gradual dos Modelos GPT: O que os Usuários Podem Esperar em 2025

-

Modelos de IA6 days ago

Modelos de IA6 days agoModelos GPT-4: Como a Inteligência Artificial está Transformando 2025