Actualités

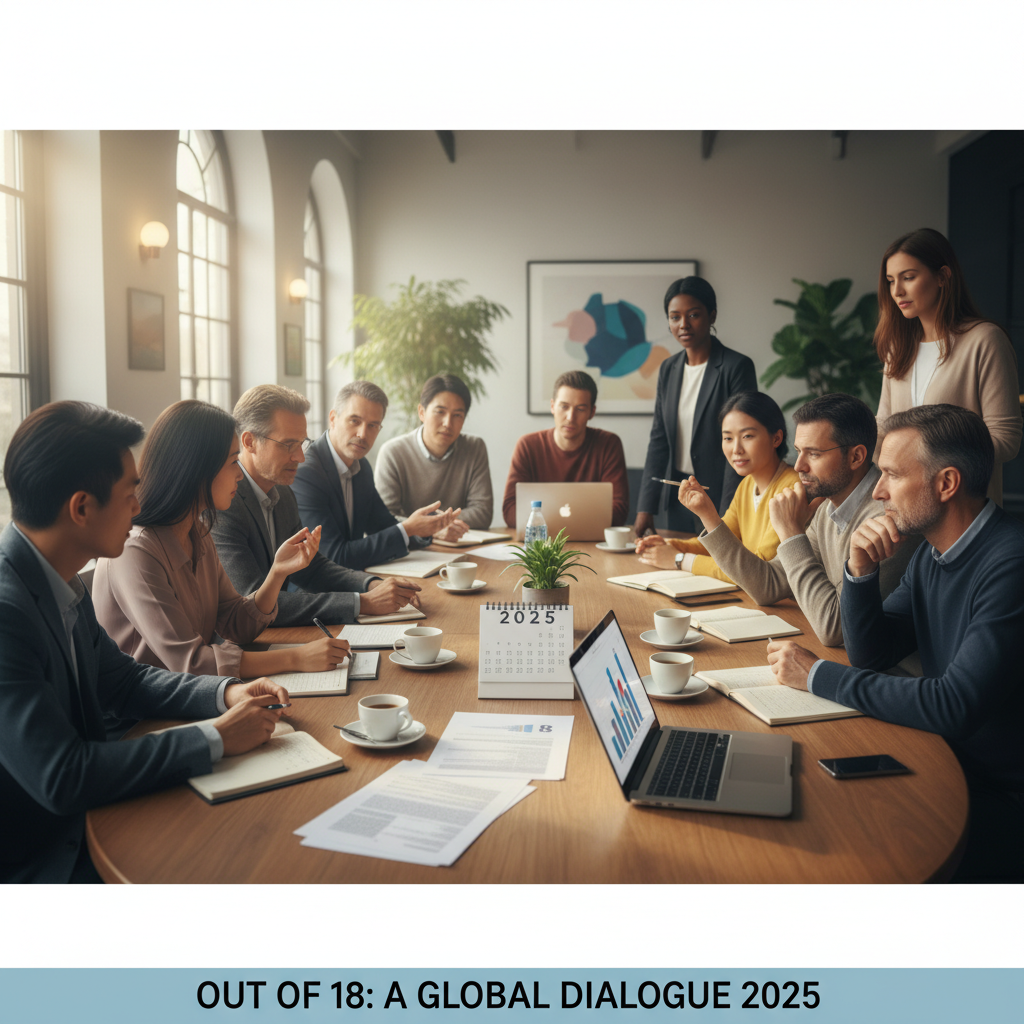

Comprendre la signification et l’importance de « sur 18 » en 2025 : un guide complet

Décoder « sur 18 » dans l’évaluation moderne : conversion en pourcentage, équité et seuils pratiques pour 2025

L’expression « sur 18 » apparaît le plus souvent dans les notations, évaluations et audits pour indiquer un score maximal atteignable de 18 points. En 2025, les éducateurs et les responsables opérationnels privilégient l’échelle de 18 points car elle combine une granularité suffisante avec la simplicité : chaque point équivaut à environ 5,56 %, permettant des distinctions nuancées sans compliquer excessivement la conception des grilles d’évaluation. Que le contexte soit une dissertation en classe, une liste de contrôle en cybersécurité ou une revue de la qualité du service client, la conversion en pourcentage et les descripteurs regroupés doivent être cohérents, documentés et faciles à expliquer.

La conversion en pourcentage est directe : divisez les points obtenus par 18, puis multipliez par 100. Par exemple, 13 sur 18 correspond à environ 72,22 %, communément interprété comme « compétent » dans de nombreux référentiels. Les écoles utilisant des outils comme ScoreSense, GradeMaster et EduRating automatisent ces conversions et transmettent les résultats aux tableaux de bord. En assurance qualité d’entreprise, des plateformes telles que AssessPoint, MarkMetrics et ResultLogic alignent le total sur 18 points aux seuils de niveau de service, mettant en lumière les opportunités de coaching tout en maintenant la conformité transparente.

Pour garantir la comparabilité entre cours ou équipes, un mappage standardisé des points aux bandes de performance est essentiel. Le tableau ci-dessous montre un mappage pratique que de nombreuses organisations adoptent en 2025, avec des interprétations exemples et des indices emoji qui accélèrent la lecture lors des revues chargées.

| Score sur 18 📊 | Pourcentage 🎯 | Bande 🏷️ | Interprétation typique 💡 |

|---|---|---|---|

| 16–18 | 88,9 %–100 % | Exemplaire ✅ | Dépasse les attentes ; révisions minimales nécessaires |

| 13–15 | 72,2 %–83,3 % | Compétent 👍 | Répond aux critères principaux avec des axes d’amélioration mineurs |

| 10–12 | 55,6 %–66,7 % | En développement 🛠️ | Maîtrise partielle ; feedback ciblé recommandé |

| 0–9 | 0 %–50 % | Fondamental 🔍 | Preuves insuffisantes ; nécessite réenseignement ou recyclage |

Les concepteurs de grilles demandent souvent : pourquoi 18 et pas 20 ? La structure en 18 points se marie bien avec 6 critères × 3 niveaux ou 3 critères × 6 niveaux, permettant aux équipes de choisir entre profondeur et largeur. Les copilotes IA qui alimentent des plateformes comme TestInsight, LearnGauge et Scorewise assistent en mettant en évidence la dérive des grilles et la variance des notations. Pour la fiabilité opérationnelle et la planification des coûts, les équipes surveillent l’usage des API et le débit ; des références telles que insights sur les limites de taux et stratégies tarifaires aident les responsables à anticiper l’échelle.

Lorsque des conversions rapides sont nécessaires lors des négociations avec les parties prenantes, il est utile de garder de petits modèles mentaux. Par exemple, 9/18 = 50 %, 12/18 = 66,7 %, et 15/18 = 83,3 %. En cas de désaccord sur les politiques d’arrondi, les règles publiées du cahier de notes et les sessions de calibration résolvent la plupart des conflits. Pensez aussi à l’ingénierie de prompt et à l’alignement du modèle si un LLM aide à la notation ; les ressources sur l’optimisation de prompt et les techniques de fine-tuning pour 2025 peuvent améliorer significativement la conformité à la grille.

- 🔢 Convertir rapidement : points ÷ 18 × 100 pour un retour instantané.

- 🧭 Publier les définitions des bandes pour éviter les « changements de règles ».

- 🤝 Utiliser des réunions de modération pour l’alignement des correcteurs et l’équité.

- 🧮 Documenter les règles d’arrondi (ex. 72,22 % → 72 % ou 72,2 %).

- 🤖 Calibrer les assistants IA avec des réponses exemplaires et des contre-exemples.

Conclusion pratique : une échelle bien expliquée sur 18 points améliore la transparence, accélère les décisions et réduit les griefs — surtout lorsque les définitions en pourcentage et en bandes sont visibles au moment de la notation.

Concevoir des grilles sur 18 points pour l’apprentissage par compétences et l’alignement OKR

Une grille sur 18 points brille lorsqu’il s’agit de mesurer des résultats complexes à critères multiples. Dans les classes basées sur les compétences, six critères avec trois niveaux de performance (3 × 6 = 18) accommodent à la fois les éléments techniques et les compétences interpersonnelles. En entreprise, les OKR trimestriels s’adaptent bien à six domaines de résultats notés sur trois niveaux de qualité, permettant un score composite unique « sur 18 » qui communique la performance aux cadres sans noyer la nuance.

Considérez une thèse universitaire et une revue de succès client. La grille de thèse inclut la qualité de la recherche, l’argumentation, l’analyse des données, l’éthique, la clarté et l’impact. La revue client suit la précision des résolutions, le temps jusqu’à la valeur, les moteurs NPS, les signaux de risque, la réutilisation des connaissances et la collaboration. Le même total sur 18 points maintient le reporting uniforme tandis que les critères restent spécifiques au domaine. Des outils tels que GradeMaster et MarkMetrics alimentent ces scores dans des analyses longitudinales, offrant des tendances par cohorte, instructeur ou territoire.

Des critères au composite : pondération, gouvernance et audits

Bien que les poids égaux soient simples, une pondération stratégique évite la myopie. Si la sécurité est non négociable, allouez plus de points à ce critère. La gouvernance importe aussi : établissez un rythme de contrôle des changements pour les grilles, réalisez de petits pilotes et conservez un historique des versions. Lorsque des systèmes IA soutiennent la notation — par exemple pour valider des preuves ou suggérer des bandes préliminaires — les responsables doivent documenter la généalogie des modèles et examiner les journaux. L’écosystème évolutif décrit dans les dernières annonces de 2025 et les suppressions de modèles aide à maintenir la continuité lors des mises à jour de plateformes.

| Critère 🧩 | Points max (sur 18) 🧮 | Preuve requise 📁 | Signaux d’alerte ⚠️ |

|---|---|---|---|

| Précision | 4 | Recoupée avec la source de vérité | Contradictions, citations manquantes ❗ |

| Ponctualité | 3 | Journaux de temps de résolution | Retards chroniques ⏳ |

| Impact | 4 | Métriques de résultat (ex. % d’augmentation) | Effets ambigus ou non mesurés 🌀 |

| Éthique/Conformité | 3 | Attestation de politique + piste d’audit | Lacunes de politique 🚫 |

| Clarté | 2 | Notes de relecture par les pairs | Raisonnement peu clair 🧩 |

| Collaboration | 2 | Confirmations inter-équipes | Travail en silos 🔒 |

La calibration reste la clé de voûte. Convoquez des sessions croisée des évaluateurs, notez un échantillon commun, et discutez des écarts. Les LLM peuvent proposer des justifications de bandes mais ne doivent jamais être le seul arbitre. Une bibliothèque concise d’exemples de cas d’application réduit l’ambiguïté et rend les attentes visibles pour les apprenants.

- 📐 Garder les critères observables et vérifiables.

- 🧭 Publier des exemples exemplaires à travers les bandes pour ancrer les jugements.

- 🔄 Recalibrer chaque trimestre ou semestre pour lutter contre la dérive.

- 🧪 Piloter les changements avec une petite cohorte avant le déploiement.

- 🗂️ Archiver les versions de grilles pour garantir la traçabilité.

Lorsque les équipes adoptent un score composite unique et lisible, les tableaux de bord exécutifs deviennent plus clairs et les conversations de coaching plus précises — exactement la clarté attendue dans la gestion de la performance en 2025.

Pour ceux qui comparent des correcteurs ou assistants automatisés, une comparaison concise des modèles leaders aide à choisir le compagnon adapté pour l’alignement des grilles et le feedback narratif.

Au-delà des mathématiques : le chiffre 18 à travers culture, légalité et croissance personnelle

Bien que « sur 18 » soit une convention de notation, le chiffre 18 possède un poids culturel et légal. Dans de nombreux pays, 18 marque la majorité légale — de nouveaux privilèges, responsabilités et droits. Les programmes éducatifs font référence à la tranche d’âge 15–18 ans en discutant du consentement, de l’identité et de la sécurité. Les directives techniques des agences de l’ONU soulignent qu’une éducation sexuelle complète équipe les jeunes de connaissances et de valeurs qui soutiennent la santé, le respect et l’autonomie, réduisant les risques d’exploitation et de désinformation.

Les preuves montrent de façon constante que des programmes éducatifs bien conçus retardent le début de l’activité sexuelle et favorisent des pratiques plus sûres. Des études estiment que environ 18 % des filles dans le monde ont subi des abus sexuels durant l’enfance, un point de référence saisissant rappelant aux institutions pourquoi des programmes adaptés à l’âge et scientifiquement rigoureux sont essentiels. Les programmes structurés encouragent à reconnaître le harcèlement, comprendre l’autonomie corporelle et savoir où chercher de l’aide. En 2025, les curricula deviennent de plus en plus basés sur les compétences, évalués via des grilles — y compris des formats sur 18 points qui suivent la compréhension du consentement, du respect et des comportements de recherche d’aide.

Symbolisme et numérologie : indépendance et abondance

Dans les traditions numérologiques, le 1 suggère l’originalité et l’initiative, tandis que le 8 symbolise le pouvoir, les ressources et la manifestation. Ensemble, en 18, beaucoup interprètent cela comme un chemin de l’autodirection vers les résultats réalisés. Des rituels pratiques — journalisation des objectifs, pratiques de gratitude et réflexion consciente — soutiennent cette traduction du symbolisme en habitude. Des outils numériques de bien-être et des compagnons IA responsables peuvent compléter ces pratiques ; une lecture sur les bienfaits sur la santé mentale montre comment les technologies de soutien peuvent enrichir les routines réflexives sans remplacer les soins professionnels.

| Aspect du « 18 » 🌟 | Pratique appliquée 🧭 | Point de contact « sur 18 » 🧮 | Signal de résultat ✅ |

|---|---|---|---|

| Indépendance (1) | Fixer des objectifs personnels et des limites | Grille d’autogestion | Meilleure tenue des engagements 🚀 |

| Abondance (8) | Gratitude + générosité | Score de contribution communautaire | Résilience accrue 💪 |

| Majorité légale | Alphabétisation aux droits et éducation au consentement | Bandes de maîtrise du programme | Réduction des risques de préjudice 🛡️ |

| Croissance holistique | Mentorat + boucles de feedback | Bilans développementaux sur 18 points | Acquisition plus rapide des compétences 📈 |

- 🧠 Considérez le 18 comme un jalon : un signal pour les droits, responsabilités et la préparation.

- 🧩 Alignez les pratiques symboliques avec des habitudes mesurables pour un changement durable.

- 🔐 Priorisez l’éducation au consentement, à la confidentialité et à la sécurité tout au long des tranches d’âge.

- 🤲 Encouragez les comportements de construction communautaire mesurés de façon transparente.

- 📚 Gardez le contenu scientifiquement précis et adapté à l’âge.

À mesure que les institutions normalisent l’enseignement fondé sur des données probantes et le dialogue respectueux, le nombre 18 devient plus qu’un seuil ; il devient un échafaudage pour la dignité, l’autonomie et la croissance continue.

Construire des pipelines IA capable de calculer des scores « sur 18 » de manière fiable et à grande échelle

Déployer un système « sur 18 » à l’échelle des districts ou des entreprises nécessite une ingénierie des données robuste et une gouvernance stricte. Commencez par des schémas cohérents pour critères, poids et artefacts. Ajoutez un magasin de fonctionnalités qui capture le contexte de la grille (version, domaine, ID évaluateur) pour permettre les audits. Les copilotes basés sur LLM — intégrés dans EvalPro, TestInsight et ResultLogic — peuvent rédiger des justifications, signaler des incohérences et proposer des revérifications lorsque les preuves sont faibles. Chaque suggestion doit rester explicable et réversible pour maintenir la responsabilité humaine.

La planification de capacité est importante. Les équipes estiment les pics de soumissions, la simultanéité et les SLA de temps de retour. Des références telles que insights sur les limites de taux et stratégies tarifaires guident la planification des coûts par évaluation. Avec l’évolution des modèles — voir les suppressions de modèles et les annonces de plateforme — les architectures bénéficient de couches d’abstraction permettant d’échanger les fournisseurs. Pour l’accélération des performances et le déploiement hybride, les insights stratégiques issus d’évènements comme les insights en temps réel sur le futur de l’IA aident à mesurer la latence et le coût.

Architecture de référence : des preuves au score expliqué

Un pipeline minimal mais résilient inclut ingestion, validation, notation, explication et supervision. La couche d’explication relie chaque point attribué à une preuve spécifique, permettant aux apprenants et aux managers de comprendre pourquoi un score est de, par exemple, 13/18 plutôt que 15/18. Des ensembles d’évaluations continues, une notation en mode shadow et la détection de dérive maintiennent les assistants IA alignés sur l’intention de la grille. Un manuel définit les voies d’escalade lorsque la qualité du signal baisse.

| Couche 🧱 | Objectif 🎯 | Métriques clés 📈 | Notes 📝 |

|---|---|---|---|

| Ingestion | Collecter des artefacts (docs, code, audio) | Débit, taux d’erreur | Gestion des versions de schéma 🔢 |

| Validation | Contrôles de politique et de format | Taux de rejet, délai | Rédaction de données personnelles 🔒 |

| Notation | Appliquer la grille + poids | Latence, variance | Humain dans la boucle 🧑⚖️ |

| Explication | Justification liée aux preuves | Couverture %, clarté | Contre-exemples 🔁 |

| Supervision | Surveillance des biais et dérives | Indices de disparité | Pistes d’audit 📜 |

- 🧪 Maintenir des exemples de référence pour une calibration continue.

- 🛡️ Séparer la notation de l’identifiant utilisateur autant que possible pour réduire les biais.

- 🔁 Enregistrer les modifications de justification pour détecter la dérive de la grille au fil du temps.

- ⚙️ Permuter les modèles via une couche d’abstraction pour éviter l’enfermement fournisseur.

- 📦 Mettre en cache les étapes déterministes ; réserver la puissance de calcul aux jugements complexes.

Lorsque le pipeline transforme les scores en récits explicables, les discussions de revue passent du débat à la planification d’amélioration — précisément là où « sur 18 » excelle.

Les équipes souhaitant un contrôle plus approfondi du comportement d’inférence peuvent explorer l’optimisation de prompt et le fine-tuning adapté au curriculum, guidés par les techniques de fine-tuning pour 2025. Ces pratiques produisent souvent une adhérence à la grille plus cohérente que le simple prompting zéro-shot.

Prise de décision avec une échelle sur 18 points : seuils, courbes, normalisation et rapports

Une fois qu’un score « sur 18 » existe, les équipes doivent décider comment il influence les notes, promotions ou validations. Des seuils clairs évitent les décisions ad hoc. Beaucoup d’institutions fixent la réussite à 10/18 (55,6 %) tandis que les mentions honorifiques débutent souvent à 16/18 (88,9 %). D’autres utilisent des seuils spécifiques au domaine où les dimensions critiques pour la sécurité élèvent la barre. La référence aux normes et les légères courbes peuvent compenser des tâches particulièrement difficiles, mais la transparence est non négociable : publiez la politique de courbe avant d’administrer la tâche.

Les stratégies de normalisation sont importantes lorsque les critères varient en difficulté selon les versions. Les items d’ancrage (ou cas d’ancrage) et les procédures d’équivalence réduisent le bruit version à version. Dans les programmes en évolution rapide, des contrôles statistiques légers et un contrôle visuel de qualité détectent la dérive proactivement. Les lecteurs exécutifs préfèrent des visuels concis ; des systèmes comme LearnGauge, EduRating et Scorewise produisent des trajectoires montrant comment les individus évoluent dans les bandes au fil du temps.

Communiquer des résultats que les parties prenantes comprennent réellement

Les rapports lisibles lient les scores à l’action. Plutôt que de déverser des points bruts, incluez des descripteurs de bande, les points forts principaux, un à deux éléments d’amélioration critiques, et une étape suivante suggérée. Des références utiles comme des exemples de cas d’application et même des aides mathématiques rapides telles que calculer 30 % de 4000 gardent les revues pratiques. Pour les organisations cherchant des fonctionnalités IA intégrées pour rédiger des résumés de feedback, des explications marketing comme les fonctionnalités d’achat peuvent offrir un contexte utile lors de la sélection de fournisseurs.

| Cas d’usage 🏁 | Seuil (sur 18) ✂️ | Note politique 📜 | Conseil de communication 🗣️ |

|---|---|---|---|

| Validation de cours | 10 (55,6 %) | Permet une réévaluation | Concentrer sur deux remédiations 🔧 |

| Distinction/Honneurs | 16 (88,9 %) | Nécessite révision externe | Mettre en avant les preuves exemplaires ⭐ |

| Assurance Qualité Opérationnelle | 14 (77,8 %) | Audits mensuels | Partager les 3 meilleurs conseils de coaching 📌 |

| Certification | 15 (83,3 %) | Deux surveillants | Résumer les ancres manquées 🎯 |

- 🧭 Annoncer les seuils et la politique de courbe avant l’évaluation.

- 📈 Surveiller les distributions de bandes pour détecter les changements inattendus.

- 📣 Rapporter en langage clair avec des étapes suivantes ciblées.

- 🗓️ Programmer les réévaluations avec des critères et un calendrier clairs.

- 🧾 Garder une piste d’audit reliant les preuves à chaque point attribué.

Lorsque les parties prenantes peuvent voir à la fois le nombre et le récit, « sur 18 » devient un outil décisionnel fiable plutôt qu’une métrique cryptique.

Choisir les bons outils et rester prêt pour l’avenir de la notation « sur 18 »

La sélection de plateformes supportant les grilles sur 18 points demande une attention particulière à l’interopérabilité, l’explicabilité et le coût. Des systèmes comme ScoreSense, AssessPoint, EvalPro et MarkMetrics sont souvent associés à des couches analytiques telles que LearnGauge ou EduRating pour visualiser les transitions de bandes et les comparaisons par cohorte. Lorsque l’assistance basée sur modèle est impliquée, les responsables examinent les feuilles de route des fournisseurs — surtout au regard des mises à jour fréquentes de l’IA — pour éviter les surprises lors de la dépréciation des modèles ou l’évolution des structures tarifaires.

Les équipes d’achat examinent de plus en plus des briefs techniques comparant modèles et approches de déploiement. Des guides tels qu’une comparaison des modèles leaders et des notes sur les stratégies multi-modèles aident à atténuer les risques. La gestion des coûts reste un thème récurrent ; la planification via les stratégies tarifaires et la compréhension des limites d’API maintiennent le coût total de possession prévisible.

Checklist de sélection de fournisseur pour la notation sur 18 points

Outre les fonctionnalités, privilégiez la sécurité, l’auditabilité et le contrôle des versions. Si des GPU externes ou une inférence hybride sont envisagés, suivez les insights du secteur et les feuilles de route matérielles. Les contributions communautaires comptent aussi : un écosystème dynamisé par la collaboration des développeurs, comme décrit dans des articles célébrant l’innovation open source, produit souvent des correctifs plus rapides et des pratiques plus transparentes.

| Capacité 🔍 | Pourquoi c’est important 💡 | À rechercher 👀 | Signal ✅ |

|---|---|---|---|

| Explicabilité | Confiance dans la notation | Justifications liées aux preuves | Trace d’audit claire 🧾 |

| Interopérabilité | Portabilité des données | Standards ouverts, API | Faible coût de changement 🔄 |

| Scalabilité | Charges de pointe | Garanties de débit | SLA garantis 📜 |

| Gouvernance | Gestion des risques | Versionnage, approbations | Journaux de changement 🗂️ |

| Contrôle des coûts | Coût total de possession prévisible | Tableaux de bord d’usage | Alertes + budgets 💵 |

- 🧪 Réaliser des pilotes avec de vrais évaluateurs et de vrais artefacts.

- 🔐 Vérifier la posture de sécurité et les options de résidence des données.

- 🧰 S’assurer que le versionnage des grilles est natif, pas un bricolage.

- 🚀 Choisir des fournisseurs avec des politiques claires de mise à jour et de dépréciation.

- 🤝 Préférer les écosystèmes avec des communautés actives et de la documentation.

Être prêt pour l’avenir est pragmatique : anticipez les changements, surveillez les signaux et choisissez des outils qui rendent la notation explicable, portable et résiliente.

{« @context »: »https://schema.org », »@type »: »FAQPage », »mainEntity »:[{« @type »: »Question », »name »: »Comment convertir un score sur 18 en pourcentage ? », »acceptedAnswer »:{« @type »: »Answer », »text »: »Divisez le score par 18 et multipliez par 100. Par exemple, 13 sur 18 ≈ 72,22 %. Documentez les règles d’arrondi (par exemple, à une décimale) et appliquez-les de manière cohérente dans les rapports. »}},{« @type »: »Question », »name »: »Pourquoi utiliser une échelle sur 18 points plutôt que 10 ou 20 ? », »acceptedAnswer »:{« @type »: »Answer », »text »: »Dix-huit équilibre granularité et simplicité. Elle se cartographie clairement à six critères avec trois niveaux ou trois critères avec six niveaux, supportant des jugements nuancés sans compliquer la formation des correcteurs. »}},{« @type »: »Question », »name »: »Quel seuil est courant pour la réussite sur une grille sur 18 points ? », »acceptedAnswer »:{« @type »: »Answer », »text »: »Une politique fréquente est 10/18 (≈55,6 %) pour la réussite, les distinctions commençant souvent à 16/18 (≈88,9 %). Les politiques varient selon le profil de risque et doivent être publiées avant l’évaluation. »}},{« @type »: »Question », »name »: »L’IA peut-elle aider à noter sur 18 de façon équitable ? », »acceptedAnswer »:{« @type »: »Answer », »text »: »L’IA peut rédiger des justifications, signaler des incohérences et accélérer les contrôles, mais la supervision humaine est essentielle. Utilisez des sorties explicables, des sessions de modération et des grilles versionnées pour garantir l’équité. »}},{« @type »: »Question », »name »: »Comment les organisations doivent-elles se préparer aux changements de modèles IA en 2025 ? », »acceptedAnswer »:{« @type »: »Answer », »text »: »Abstractisez les appels aux modèles, suivez les annonces des fournisseurs et planifiez les dépréciations. Surveillez les coûts et limites, et maintenez une solution de secours validée pour assurer la continuité des pipelines de notation. »}}]}Comment convertir un score sur 18 en pourcentage ?

Divisez le score par 18 et multipliez par 100. Par exemple, 13 sur 18 ≈ 72,22 %. Documentez les règles d’arrondi (par exemple, à une décimale) et appliquez-les de manière cohérente dans les rapports.

Pourquoi utiliser une échelle sur 18 points plutôt que 10 ou 20 ?

Dix-huit équilibre granularité et simplicité. Elle se cartographie clairement à six critères avec trois niveaux ou trois critères avec six niveaux, supportant des jugements nuancés sans compliquer la formation des correcteurs.

Quel seuil est courant pour la réussite sur une grille sur 18 points ?

Une politique fréquente est 10/18 (≈55,6 %) pour la réussite, les distinctions commençant souvent à 16/18 (≈88,9 %). Les politiques varient selon le profil de risque et doivent être publiées avant l’évaluation.

L’IA peut-elle aider à noter sur 18 de façon équitable ?

L’IA peut rédiger des justifications, signaler des incohérences et accélérer les contrôles, mais la supervision humaine est essentielle. Utilisez des sorties explicables, des sessions de modération et des grilles versionnées pour garantir l’équité.

Comment les organisations doivent-elles se préparer aux changements de modèles IA en 2025 ?

Abstractisez les appels aux modèles, suivez les annonces des fournisseurs et planifiez les dépréciations. Surveillez les coûts et limites, et maintenez une solution de secours validée pour assurer la continuité des pipelines de notation.

-

Open Ai7 jours ago

Open Ai7 jours agoLibérer la puissance des Plugins ChatGPT : améliorez votre expérience en 2025

-

Open Ai6 jours ago

Open Ai6 jours agoMaîtriser l’ajustement fin de GPT : un guide pour personnaliser efficacement vos modèles en 2025

-

Open Ai6 jours ago

Open Ai6 jours agoComparer ChatGPT d’OpenAI, Claude d’Anthropic et Bard de Google : quel outil d’IA générative dominera en 2025 ?

-

Open Ai6 jours ago

Open Ai6 jours agoTarification de ChatGPT en 2025 : Tout ce que vous devez savoir sur les tarifs et abonnements

-

Open Ai6 jours ago

Open Ai6 jours agoLa suppression progressive des modèles GPT : à quoi les utilisateurs peuvent s’attendre en 2025

-

Modèles d’IA6 jours ago

Modèles d’IA6 jours agoModèles GPT-4 : Comment l’intelligence artificielle transforme 2025