Open Ai

Naviguer dans les limites de débit de ChatGPT : Informations essentielles pour une utilisation optimale en 2025

Comprendre les limitations de débit de ChatGPT en 2025 : plans, modèles et raisons d’existence

Les contrôles d’utilisation de ChatGPT ont évolué en un système à plusieurs couches qui équilibre fiabilité, équité et coût. En 2025, les limites s’appliquent à plusieurs niveaux : quotas globaux du plan, plafonds par modèle, fenêtres glissantes courtes et restrictions spécifiques aux fonctionnalités. Cette conception aide OpenAI à offrir des performances constantes pendant les heures de pointe tout en gardant les capacités avancées — telles que les modes de raisonnement — disponibles pour les utilisateurs sérieux. La conclusion pratique est simple : les équipes qui adaptent leurs schémas de travail à cette structure évitent les interruptions et maintiennent une haute vélocité.

Au niveau du plan, trois niveaux comptent surtout pour l’usage conversationnel : Free, Plus et Pro. Free offre un accès quotidien limité et des sessions plus courtes, tandis que Plus introduit des allocations hebdomadaires assez larges pour un travail individuel soutenu. Pro — souvent utilisé par des utilisateurs avancés et de petites équipes — tend vers une utilisation générale pratiquement illimitée, sous réserve de garde-fous anti-abus. Les plafonds par modèle s’appliquent toujours, notamment pour les modes de raisonnement de pointe. Par exemple, GPT‑5 Thinking peut être limité à un nombre défini de messages chaque semaine sur Plus ou Team, alors que l’utilisation standard de GPT‑5 évolue plus librement. Combinées aux fenêtres glissantes de 3 heures pour des modèles comme GPT‑4 et GPT‑4.1, les utilisateurs bénéficient d’un accès prévisible qui se réinitialise tout au long de la journée.

Pourquoi ces limites existent-elles ? Deux raisons dominent. Premièrement, l’économie de la gestion de larges fenêtres de contexte et du raisonnement avancé est réelle — les prompts plus volumineux et les chaînes plus longues consomment plus de puissance de calcul. Deuxièmement, la qualité et la stabilité nécessitent des garde-fous ; les modes sophistiqués sont contraints pour assurer la disponibilité du travail légitime avec intervention humaine. Ceci est visible à travers l’écosystème, d’OpenAI à Anthropic et Google DeepMind, et même sur des plateformes comme Perplexity ou Grok de xAI. Les partenaires d’infrastructure tels que Microsoft Azure, Google Cloud et Amazon Web Services fournissent la puissance, mais les choix de politique maintiennent des expériences fluides et prévisibles.

Pour les professionnels qui choisissent un plan, lire les petits caractères est important. Les quotas globaux Plus peuvent indiquer un chiffre comme 3 000 messages par semaine pour un usage typique, tandis que GPT‑5‑Thinking peut afficher une allocation manuelle plus petite de 200 messages par semaine. Parallèlement, les modèles créatifs comme GPT‑4.5 peuvent avoir des plafonds hebdomadaires séparés, tandis que GPT‑4/4.1 fonctionnent souvent sur des fenêtres glissantes de 3 heures. Ces couches ne sont pas contradictoires ; elles se complètent pour équilibrer la charge entre les modèles. Ceux qui cherchent un contexte tarifaire et des changements de niveau peuvent consulter des analyses telles que un aperçu clair des tarifs de ChatGPT en 2025 ou comparer avec des approches concurrentes dans la discussion sur les stratégies de tarification GPT‑4.

Les déblocages Team et Enterprise suivent une logique similaire. « Illimité » signifie généralement pas de plafond pratique pour un usage humain normal mais toujours sous garde-fous. Cela inclut les interdictions de partage d’identifiants ou d’utilisation de l’accès UI pour alimenter des services externes automatisés. Les entreprises peuvent demander des augmentations de quota, et les admins disposent souvent de meilleurs contrôles de surveillance que les utilisateurs individuels.

Les résultats pratiques sont faciles à prévoir : les charges créatives qui pointent, comme les lancements de campagne, bénéficient de plafonds hebdomadaires qui permettent des pics courts et intenses. Les workflows de recherche quotidiens constants s’alignent mieux avec les plafonds quotidiens ou les fenêtres glissantes, qui répartissent la consommation uniformément. Les configurations hybrides — mélangeant sessions UI pour la créativité et workflows API pour la production — sont courantes. Beaucoup d’équipes complètent ChatGPT avec des modèles déployés sur Microsoft Azure, Google Cloud ou Amazon Web Services, et ajoutent en option des alternatives de Cohere ou IBM Watson, selon les exigences de conformité et de résidence des données.

- 🧠 Utilisez les modes de raisonnement pour l’analyse à enjeux élevés ; passez aux variantes mini pour les tâches volumineuses.

- 🔁 Planifiez autour des fenêtres glissantes de 3 heures pour GPT‑4/4.1 afin de maintenir l’élan.

- 📅 Exploitez les plafonds hebdomadaires pour des projets en rafales comme audits ou migrations.

- 📦 Mettez en cache localement les résultats clés pour éviter de relancer inutilement de longs prompts.

- 🧰 Explorez les SDK et l’automatisation, comme couvert dans cette vue d’ensemble du nouveau SDK d’apps, pour rationaliser les tâches répétées.

| Plan ⚙️ | Accès typique 🧭 | Plafonds notables ⏳ | Idéal pour 🎯 |

|---|---|---|---|

| Free | GPT‑5 (limité), outils basiques | Messages quotidiens plafonnés ; sessions plus courtes | Exploration légère, vérifications rapides |

| Plus | GPT‑5, GPT‑4.x, DALL·E | ~3 000 msgs/semaine au niveau plan ; fenêtres par modèle appliquées | Professionnels individuels, travail régulier |

| Pro | GPT‑5 + modèles o1/o3 | Pratiquement illimité sous garde-fous | Utilisateurs avancés, petites équipes |

Insight clé : adaptez les schémas de travail à la combinaison plan + modèle, et réservez le raisonnement premium pour les étapes à forte valeur afin d’allonger les quotas sans sacrifier la qualité.

Plafonds Hebdomadaires vs Quotidiens, Fenêtres Glissantes et Réinitialisations : Tactiques temporelles pour éviter les interruptions

La logique de réinitialisation est le point où beaucoup d’équipes accélèrent ou s’enlisent. Trois régimes temporels dominent : plafonds hebdomadaires, plafonds quotidiens et fenêtres glissantes de 3 heures. Les plafonds hebdomadaires — fréquemment utilisés par ChatGPT et Anthropic — favorisent le travail en rafales. Les équipes peuvent pousser fort pendant une semaine de lancement puis lever le pied, tout cela dans une allocation prévisible. Les plafonds quotidiens, visibles sur des plateformes comme Perplexity et certaines configurations Gemini, répartissent l’usage uniformément sur les jours, ce qui convient aux recherches soutenues ou aux pipelines de contenu. Les fenêtres glissantes de 3 heures (communes à GPT‑4/4.1) encouragent les sprints courts et morcellent les sessions marathon en segments digestes.

Les temps de réinitialisation comptent. Les fenêtres glissantes comptent à rebours depuis la dernière interaction ; les plafonds quotidiens se réinitialisent typiquement à 00:00 UTC ; les plafonds hebdomadaires se réinitialisent généralement selon un cycle roulant de sept jours à partir du premier message de la fenêtre. Toute personne concevant des workflows devrait considérer ces éléments comme des primitives de planification. Par exemple, une équipe de contenu peut prévoir des « sprints GPT‑4o de 2 heures » le matin et des « rafales GPT‑5 Thinking » en fin d’après-midi pour profiter de fenêtres différentes. Pour une stratégie large à travers plans et modèles, les recommandations pratiques dans ce guide axé sur les stratégies peuvent aider les équipes à construire des cadences prévisibles.

Un schéma récurrent se détache : les utilisateurs atteignent un plafond par modèle, l’interface passe automatiquement à un mini modèle, et la qualité baisse sans avertissement. La solution est de planifier la journée en tenant compte du plafond. Si la semaine nécessite beaucoup d’utilisation de GPT‑5‑Thinking, concentrez ces tâches en début de période et réservez la rédaction courante sur un mini modèle ou GPT‑4.1 mini. Si les refacturations de code ou les analyses multi-fichiers s’accumulent, alterner entre modèles répartit la charge tout en préservant la qualité où elle compte. Il s’agit d’un classique problème d’orchestration de charge, non d’un simple problème de limite d’usage.

Les équipes à grande échelle doivent aussi coordonner les réinitialisations entre membres. Si cinq analystes atteignent un plafond simultanément, l’équipe s’arrête. Des démarrages échelonnés et la diversité des modèles évitent les ralentissements synchronisés. Les outils de Salesforce et les tableaux de bord PM internes peuvent visualiser les fenêtres d’utilisation planifiées, tandis que l’observabilité back-end sur Microsoft Azure ou Google Cloud suit les pointes API. La communauté IA plus large fait progresser les connaissances — des événements comme les discussions NVIDIA GTC sur le futur de l’IA mettent souvent en avant des leçons d’ingénierie de planification et de débit directement applicables aux opérations LLM.

- 🗓️ Programmez des fenêtres glissantes comme des blocs de sprints pour éviter les surprises de basculement.

- 🧮 Allouez tôt dans la semaine un budget de mode raisonnement pour les décisions critiques.

- 👥 Échelonnez l’utilisation de l’équipe pour éviter un bridage synchronisé.

- 🔔 Utilisez des rappels en approchant des plafonds connus ; passez proactivement à un mini modèle.

- 🧭 Consultez les détails du plan dans cette explication tarifaire pour aligner budgets temporels et niveaux.

| Type de Réinitialisation ⏱️ | Fonctionnement 🔍 | Exemple Typique 📌 | Conseil de Planification 🧭 |

|---|---|---|---|

| Glissant 3 heures | Fenêtre compte à rebours depuis le dernier message | GPT‑4/4.1 : 80 msgs/3h | Faites des sprints ciblés ; faites une pause pour réinitialiser 🔁 |

| Quotidien | Se réinitialise à 00:00 UTC | o4‑mini : 300/jour | Équilibrez les tâches sur plusieurs jours 📅 |

| Hebdomadaire (glissant) | Se réinitialise sept jours après le premier message | GPT‑5 Thinking : ~200/semaine | Chargez tôt les travaux à forte valeur dans la fenêtre 🚀 |

Insight clé : considérez les réinitialisations comme des contraintes calendaires — bien chronométrées, les limites deviennent des rythmes de workflow, non des obstacles.

Économie des fenêtres contextuelles et gestion du budget de tokens : étendre les quotas sans sacrifier la qualité

Les larges fenêtres contextuelles sont puissantes — et coûteuses en tokens. Un contexte de 128K tokens (typique des paliers GPT‑5 et GPT‑4.1 de ChatGPT) correspond à environ 96 000 mots, tandis que 200K pour Claude gèrent environ 150 000 mots. Le contexte 1M tokens de Gemini peut contenir approximativement 750 000 mots. Ces capacités incitent les utilisateurs à coller des wikis entiers, mais chaque page supplémentaire consomme des quotas et ajoute de la latence. La tactique plus intelligente est de segmenter, indexer et résumer avant d’invoquer un raisonnement lourd. Les workflows token-aware augmentent le débit sans altérer les résultats.

Considérez une équipe de recherche reconstruisant la documentation de conformité. Plutôt que de charger des PDF entiers dans un message unique, elle divise le contenu en paquets thématiques, génère des notes condensées avec un mini modèle, puis n’élève que les résumés affinés à GPT‑5 Thinking pour une logique d’audit finale. Cette approche en deux étapes réduit la consommation de tokens tout en conservant la rigueur analytique. Lorsque le travail exige un contexte massif, réservez les fenêtres les plus larges aux passages les plus interdépendants et évitez d’inclure les annexes dans le prompt principal.

Les systèmes secondaires aident. Bases de données vectorielles, pipelines de récupération et embeddings permettent des recherches précises plutôt que de plonger entièrement dans un corpus. Beaucoup d’équipes s’appuient sur des services gérés sur Amazon Web Services ou Microsoft Azure pour une montée en charge élastique, tandis que d’autres utilisent des hubs Hugging Face pour des modèles open-source complémentaires prétraitant et compressant le contexte. La communauté continue d’expérimenter, comme le montrent des articles tels que les synthèses de collaboration open-source et les initiatives NVIDIA sur les frameworks ouverts qui influencent l’architecture de la gestion de contexte.

Le budget de raisonnement est tout aussi critique. Beaucoup de plans professionnels offrent des réponses « standard » sans longues chaînes de pensée sauf demande expresse. Réservez le raisonnement le plus approfondi aux quelques prompts qui nécessitent vraiment une synthèse multi-étapes. Pour la rédaction de routine, GPT‑4.1 mini ou o4‑mini peuvent gérer 80–90 % du volume à une fraction du coût et du quota. Les équipes qui codifient ce triage — mini pour l’échafaudage, modèle de pointe pour la finition — livrent plus vite et dépensent moins.

- 🧩 Segmentez le matériau source et résumez avant d’escalader.

- 🧷 Utilisez la récupération pour ne ramener que les passages pertinents.

- 🪙 Limitez le mode raisonnement aux décisions à impact mesurable.

- 🗂️ Mettez en cache les extraits réutilisables ; évitez de ressaisir de longs documents types.

- 🧪 Testez des idées d’économies de tokens avec des ressources comme des guides des techniques de fine-tuning pour un prétraitement léger.

| Taille du Contexte 📏 | Mots Approximatifs 📚 | Quand Utiliser ✅ | Conseil d’Économie de Tokens 💡 |

|---|---|---|---|

| 128K | ~96k mots | Briefs, spécifications, corpus de taille moyenne | Pré-résumer avec mini modèle ✂️ |

| 200K | ~150k mots | Suites de politiques, revues multi-documents | Privilégiez la récupération plutôt que le collage brut 📎 |

| 1M | ~750k mots | Ensembles de recherche massifs | Étape le contenu avec embeddings 🧭 |

Insight clé : la discipline token — pas seulement les évolutions de plan — apporte le plus grand bond en débit soutenu et fiabilité.

Choisir entre ChatGPT, Claude, Gemini, Grok et Perplexity : limites, modes de raisonnement et compromis

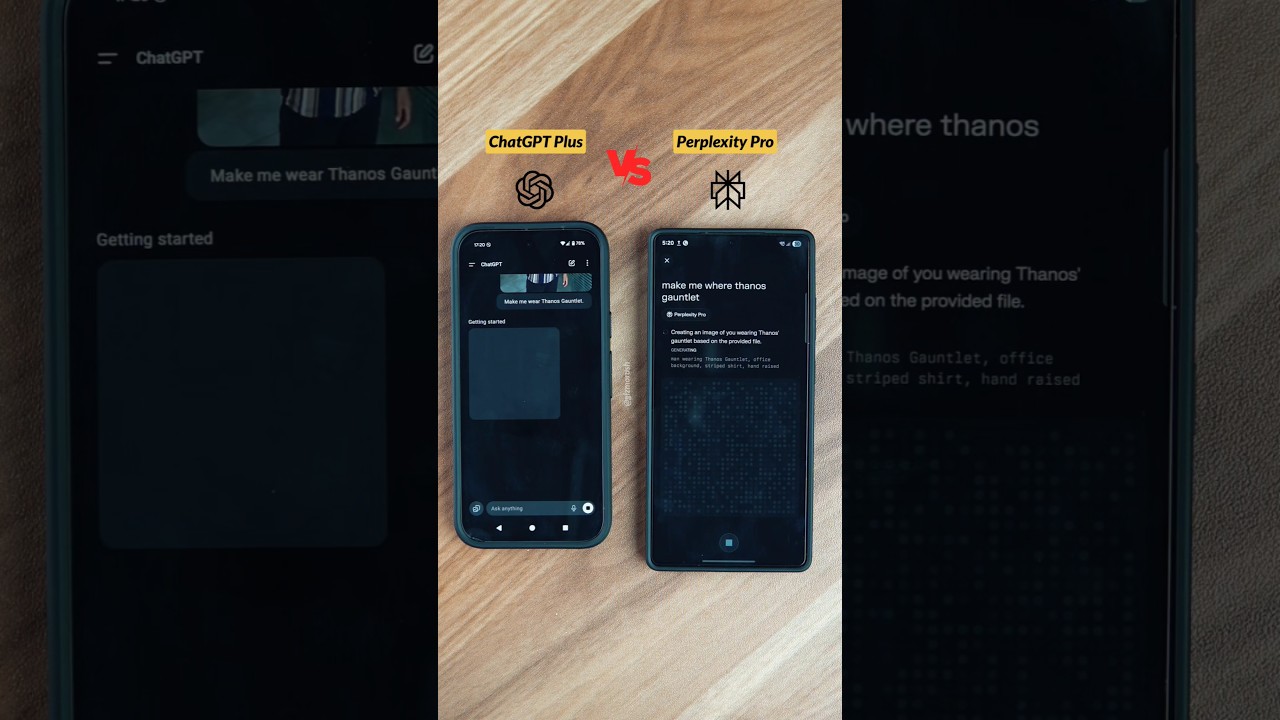

Les limites de débit prennent sens seulement dans le contexte du marché plus large. En 2025, les plateformes leaders convergent vers des schémas de conception similaires : plans à paliers, compteurs visibles et modes de raisonnement disponibles dans les paliers payants. Les différences apparaissent dans la taille du contexte, les rythmes de réinitialisation et les domaines d’excellence de chaque plateforme. Par exemple, ChatGPT met l’accent sur la largeur et les intégrations d’outils ; Claude est performant en codage et analyse structurée ; Gemini mène sur les contextes à 1M tokens ; Grok est étroitement lié au streaming en temps réel ; et Perplexity optimise les requêtes de style recherche.

En un coup d’œil, les paliers Plus se situent autour de 20 $, et les paliers premium entre 200 et 300 $. Cette fourchette supérieure vise les professionnels qui ont besoin soit d’une utilisation quasi illimitée, soit de modes de raisonnement de pointe. Chaque plateforme définit soigneusement « illimité », en se réservant le droit de faire respecter les règles contre le scraping automatisé ou la revente d’accès. Des comparaisons guidées — comme des comparaisons équilibrées ChatGPT vs. Claude — aident les équipes à choisir la bonne combinaison. Ceux qui suivent le contrôle des coûts peuvent aussi profiter des analyses des stratégies tarifaires qui expliquent comment la taille des fenêtres et les plafonds par modèle influencent les budgets.

Voici un instantané condensé, centré sur l’usage, reflétant la situation fin 2025 et servant de référence directionnelle. Confirmez toujours les derniers chiffres dans la documentation officielle avant de vous engager.

| Plateforme 🌐 | Modèles Clés 🧠 | Limites Typiques ⏳ | Mode Raisonnement 🧩 | Fenêtre Contexte 📏 |

|---|---|---|---|---|

| ChatGPT | GPT‑5, GPT‑4.x | Plus ~3 000 msgs/semaine ; fenêtres par modèle | GPT‑5 Thinking ✔️ | 128K tokens |

| Claude | Sonnet 4.5, Opus | ~15–45 msgs/5h (Pro plus élevé) | Extended Thinking ✔️ | 200K (1M beta) 🔬 |

| Gemini | Pro 2.5, Ultra | Quotas quotidiens ; Ultra jusqu’à 1M tokens/jour | Deep Think ✔️ | 1M tokens 🏆 |

| Grok | Grok 3/4 | ~10 requêtes/2h (plus élevé en payant) | Raisonnement standard | 256K tokens |

| Perplexity | GPT‑4.1, Claude 4, o3‑pro | Plafonds Pro/jour ; Max ~300+ Pro/jour | Deep Research ✔️ | Étendu (variable) 📎 |

L’adéquation à l’écosystème compte autant que les limites brutes. Les organisations très intégrées aux workflows Salesforce peuvent privilégier ChatGPT pour les résumés et la rédaction CRM. Les équipes utilisant la recherche en local accélérée par NVIDIA peuvent ajouter un prétraitement local pour réduire les tokens avant d’interroger les modèles cloud. Celles explorant des formations à coûts réduits consultent parfois des ressources comme des enquêtes sur la formation à faible coût pour leur stratégie à long terme. Par ailleurs, le travail de connaissance en temps réel continue de s’étendre, avec des insights révélés dans la couverture événementielle du futur de l’IA.

- 🛠️ Choisissez les plateformes selon leur domaine de force (codage, recherche, temps réel, suite entreprise).

- 🧭 Adaptez les types de réinitialisation au rythme de l’équipe (rafales vs. régulier).

- 📈 Commencez avec Plus/Pro et pilotez les charges avant de vous engager dans les paliers à 200–300 $.

- 🧳 Gardez un modèle de secours prêt lorsque les plafonds sont atteints en pleine tâche.

- 🔗 Utilisez des références comme ce guide limites et stratégies pour affiner un plan initial.

Insight clé : choisissez selon la compatibilité, pas le battage ; associez forces et rythmes de réinitialisation à la cadence d’opération de l’équipe pour moins de surprises.

Concevoir des workflows efficaces en tokens et temps : un guide pour équipes et entreprises

Pour les entreprises travaillant dans les documents, le code et les réunions, la différence entre prospérer et être freiné tient à la conception du workflow. Un guide pratique commence par un triage des charges, continue par un appariement des modèles, et se termine par une automatisation consciente des garde-fous. Prenons une entreprise fictive — HarborLine Financial — avec cinq analystes et deux chefs de produit. Leur travail couvre recherche, mises à jour de politique et synthèses pour parties prenantes. Sans planification, ils atteignent les plafonds dès le milieu de semaine ; avec un guide, ils livrent à temps et sous budget.

Premièrement, codifiez l’arbre décisionnel. La rédaction simple, la reformulation et l’extraction vont aux mini modèles. La synthèse structurée va à GPT‑4.1 ou GPT‑4.5. Seul le raisonnement le plus épineux — interprétation réglementaire, modélisation de scénarios — monte jusqu’à GPT‑5 Thinking. Deuxièmement, formalisez la discipline des tokens : intégrez la récupération pour les requêtes lourdes en documents, mettez en cache les extraits réutilisables, et maintenez une bibliothèque partagée de « patterns promptés ». Troisièmement, mettez en place des automatisations conscientes des garde-fous. Les tâches planifiées peuvent cibler l’API quand approprié, et l’UI reste pour la revue humaine. Quand l’échelle augmente, des architectures hybrides utilisant Microsoft Azure, Google Cloud et Amazon Web Services garantissent le débit, tandis que la diversité des fournisseurs ajoute de la résilience.

Quatrièmement, facilitez la collaboration. Les dépôts de conversation partagés évitent de poser plusieurs fois les mêmes questions. Les équipes qui soignent une base de connaissances et distribuent des « prompts en or » dépassent régulièrement celles fonctionnant au prompt ad hoc. Des guides comme recommandations pour partager des conversations servent de normes. Cinquièmement, ajoutez des outils spécialisés si besoin : saisie vocale pour capture rapide (voir un simple setup vocal), recherche multi-agents pour les plongées en profondeur, et runners de tâches pilotés par SDK. Pour ceux qui explorent la productivité en mode compagnon, des produits comme Atlas AI companions montrent comment des assistants peuvent orchestrer des flux multi-étapes à travers les apps.

Enfin, surveillez et itérez. Les tableaux de bord d’usage mettent en évidence les schémas de plafonnement. En cas de restriction temporaire due à une violation politique, des parcours d’escalade existent — documentez l’incident et contactez le support avec les détails. Les admins d’entreprise peuvent demander des modifications de quota ou un accès contrôlé aux modes de raisonnement lors de périodes critiques. Gardez les options multi-fournisseurs à portée de main : Cohere pour les embeddings, IBM Watson pour services alignés sur le domaine, et des voies open-source pour le prétraitement, comme souligné dans les spots de collaboration open-source. Pour le contexte des modèles de pointe, restez informés des tendances de formation dans des articles comme les explications sur la phase de formation GPT‑5.

- 🧭 Construisez une matrice de triage pour orienter les tâches selon complexité et coût.

- 🧲 Ajoutez récupération + mise en cache pour réduire les prompts et accélérer les exécutions.

- 🔐 Respectez les garde-fous ; gardez l’usage UI humain et authentifié.

- 🧑🤝🧑 Standardisez les patterns de prompt et partagez-les dans la bibliothèque de l’équipe.

- 📊 Suivez les plafonds et les basculements ; ajustez le calendrier et le mix de modèles proactivement.

| Pratique 🛠️ | Impact 📈 | Résilience aux Limites 🧱 | Notes 📝 |

|---|---|---|---|

| Triage des modèles | 30–60 % d’appels premium en moins | Élevée | Réservez le raisonnement aux étapes critiques 🧠 |

| Récupération + mise en cache | Réduction des tokens de 40 % | Élevée | Évite le retraitement de gros documents ♻️ |

| Prompts partagés | embarquement plus rapide | Moyenne | La cohérence améliore la qualité de sortie 📚 |

| Cloud hybride | Marge de débit | Élevée | Azure/GCP/AWS offrent de l’élasticité ☁️ |

Insight clé : un petit ensemble d’habitudes d’ingénierie — triage, récupération, mise en cache et planification — transforme les limites en garde-fous prévisibles plutôt qu’en obstacles.

Dépanner les erreurs de limite de débit et construire des routines à toute épreuve

Même avec une planification soignée, les erreurs de limite de débit sont inévitables lors des pics ou des lancements. L’objectif est de récupérer instantanément sans perturber le travail. Cela commence par comprendre la forme des erreurs. Quand un plafond est atteint, le modèle peut disparaître de la sélection, ou l’interface bascule silencieusement vers un modèle plus petit. Les notifications communiquent généralement le temps de réinitialisation ; passer la souris sur le nom du modèle indique souvent quand la fenêtre se rafraîchit. Si le schéma d’utilisation dépasse un garde-fou — comme un soupçon d’extraction automatisée — des restrictions temporaires peuvent s’appliquer jusqu’à ce que le support examine l’activité.

Les routines de récupération efficaces reposent sur des basculements hiérarchiques. Si GPT‑5 Thinking est plafonné, basculez sur GPT‑4.1 pour l’échafaudage et planifiez les vérifications finales pour la prochaine fenêtre de réinitialisation. Le batching réduit le nombre d’allers-retours : combinez plusieurs sous-demandes dans un prompt structuré plutôt que d’envoyer des messages séparés. Pour les réunions et la capture de contenu, les saisies vocales font gagner du temps ; des guides d’installation comme ce tutoriel sur le chat vocal peuvent réduire les frictions. Quand toute une équipe atteint les plafonds, la stratégie est de passer aux tâches documentaires, affiner les prompts, ou rédiger des directives — un travail productif qui ne consomme pas les fenêtres premium.

Parfois, un autre outil est la bonne solution. Deep Research de Perplexity, l’accent temps réel de Grok, ou les fenêtres longues de Claude peuvent supporter la charge en attendant. Hors UI, l’API reste une option pour des pipelines programmatiques, souvent avec des quotas et tarifications différentes. Beaucoup d’organisations déploient des agents prétraitants sur une infrastructure accélérée NVIDIA, puis envoient des requêtes concises en amont, un procédé discuté dans les initiatives open framework. En cas de doute, les petites équipes peuvent consulter des guides comme les guides cas par cas d’application pour choisir la déviation la plus rapide.

Partager les leçons renforce la résilience. Les rétrospectives d’équipe capturent les prompts qui atteignent régulièrement les plafonds et comment les basculements ont fonctionné. La documentation centralisée — combinée à la connaissance des particularités des modèles, comme les fenêtres de 3 heures pour GPT‑4.x — resserre l’exécution. Pour les praticiens quotidiens, des rappels rapides comme cet aperçu des limites accélèrent le dépannage. Pour la collaboration inter-équipes, pensez aux compagnons IA qui orchestrent des passages simples ; des exemples comme les assistants style Atlas illustrent des schémas de coordination efficaces.

- 🚦 Maintenez une matrice de basculement pour chaque workflow critique.

- 📦 Regroupez les micro-tâches en un prompt composite unique.

- 📝 Enregistrez erreurs, plafonds et temps de réinitialisation pour analyse des schémas.

- 🔄 Utilisez des outils compagnons pour préparer le travail pendant les plafonds (brouillon, étiquetage, préparation).

- 🔍 Vérifiez les détails du plan avec un aperçu à jour comme cette ressource stratégique.

| Problème 🚧 | Cause probable 🧭 | Action immédiate ⚡ | Étape suivante 🧱 |

|---|---|---|---|

| Modèle caché | Plafond atteint pour la fenêtre | Basculez vers un modèle mini ou alternatif | Planifiez la tâche premium pour la réinitialisation 🔁 |

| Baisse de qualité | Basculement automatique sous charge | Confirmez le badge du modèle | Soumettez à nouveau l’étape clé après réinitialisation 🎯 |

| Restriction temporaire | Application des garde-fous | Contactez le support avec les journaux | Révisez les ToU et ajustez le pipeline 🔐 |

Insight clé : la récupération est un processus, pas un événement — codifiez les basculements, conservez les journaux, et ayez toujours une route alternative.

{« @context »: »https://schema.org », »@type »: »FAQPage », »mainEntity »:[{« @type »: »Question », »name »: »Quelles sont les limites les plus importantes de ChatGPT à retenir ? », »acceptedAnswer »:{« @type »: »Answer », »text »: »Les quotas au niveau du plan (par exemple, Plus ~3 000 messages/semaine), les fenêtres par modèle (par exemple, GPTu20114/4.1 avec des limites glissantes de 3u2011heures), et les plafonds spécifiques au raisonnement (par exemple, GPTu20115 Thinking ~200 messages/semaine sur Plus/Team) régissent l’usage quotidien. Des quotas quotidiens s’appliquent à certains modèles comme o4u2011mini, et les fenêtres glissantes hebdomadaires se réinitialisent sept jours après le premier message de l’intervalle. »}},{« @type »: »Question », »name »: »Comment les équipes peuvent-elles éviter de toucher les limites lors de délais critiques ? », »acceptedAnswer »:{« @type »: »Answer », »text »: »Planifiez le raisonnement premium tôt dans la fenêtre hebdomadaire, exécutez GPTu20114.x en sprints serrés de 3u2011heures, et réservez les mini modèles pour la rédaction en volume. Utilisez la récupération et la mise en cache pour réduire les prompts, et échelonnez l’utilisation de l’équipe pour prévenir une limitation synchronisée. Maintenez une matrice de basculement documentée et changez de modèle de manière proactive en approchant des plafonds. »}},{« @type »: »Question », »name »: »Les plateformes tierces aident-elles lorsque les plafonds ChatGPT sont serrés ? », »acceptedAnswer »:{« @type »: »Answer », »text »: »Oui. Les fenêtres plus larges de Claude, les contextes à 1M tokens de Gemini, la focalisation temps réel de Grok, et les workflows de recherche de Perplexity peuvent combler les lacunes. De nombreuses organisations complètent ChatGPT avec les embeddings de Cohere, les services IBM Watson, ou le prétraitement open-source sur une infrastructure accélérée NVIDIA. »}},{« @type »: »Question », »name »: »Où les professionnels peuvent-ils s’informer sur les prix et changements de plans ? », »acceptedAnswer »:{« @type »: »Answer », »text »: »Consultez des explications synthétisées comme un aperçu des tarifs de ChatGPT en 2025 et des articles stratégiques analysant la dynamique tarifaire de GPTu20114. Pour l’évolution des modèles, lisez les explications sur la phase de formation GPTu20115 et suivez les notes de version des fournisseurs. »}},{« @type »: »Question », »name »: »Est-il utile de développer des outils internes pour gérer les limites ? », »acceptedAnswer »:{« @type »: »Answer », »text »: »Oui. Des tableaux de bord légers pour suivre les plafonds, des bibliothèques partagées de prompts en or, et des runners de tâches basés sur SDK réduisent les frictions et évitent les travaux redondants. Les équipes combinent souvent Microsoft Azure, Google Cloud et Amazon Web Services avec des modèles OpenAI pour standardiser la planification, la récupération et la mise en cache. »}}]}Quelles sont les limites les plus importantes de ChatGPT à retenir ?

Les quotas au niveau du plan (par exemple, Plus ~3 000 messages/semaine), les fenêtres par modèle (par exemple, GPT‑4/4.1 avec des limites glissantes de 3 heures), et les plafonds spécifiques au raisonnement (par exemple, GPT‑5 Thinking ~200 messages/semaine sur Plus/Team) régissent l’usage quotidien. Des quotas quotidiens s’appliquent à certains modèles comme o4‑mini, et les fenêtres glissantes hebdomadaires se réinitialisent sept jours après le premier message de l’intervalle.

Comment les équipes peuvent-elles éviter de toucher les limites lors de délais critiques ?

Planifiez le raisonnement premium tôt dans la fenêtre hebdomadaire, exécutez GPT‑4.x en sprints serrés de 3 heures, et réservez les mini modèles pour la rédaction en volume. Utilisez la récupération et la mise en cache pour réduire les prompts, et échelonnez l’utilisation de l’équipe pour prévenir une limitation synchronisée. Maintenez une matrice de basculement documentée et changez de modèle de manière proactive en approchant des plafonds.

Les plateformes tierces aident-elles lorsque les plafonds ChatGPT sont serrés ?

Oui. Les fenêtres plus larges de Claude, les contextes à 1M tokens de Gemini, la focalisation temps réel de Grok, et les workflows de recherche de Perplexity peuvent combler les lacunes. De nombreuses organisations complètent ChatGPT avec les embeddings de Cohere, les services IBM Watson, ou le prétraitement open-source sur une infrastructure accélérée NVIDIA.

Où les professionnels peuvent-ils s’informer sur les prix et changements de plans ?

Consultez des explications synthétisées comme un aperçu des tarifs de ChatGPT en 2025 et des articles stratégiques analysant la dynamique tarifaire de GPT‑4. Pour l’évolution des modèles, lisez les explications sur la phase de formation GPT‑5 et suivez les notes de version des fournisseurs.

Est-il utile de développer des outils internes pour gérer les limites ?

Oui. Des tableaux de bord légers pour suivre les plafonds, des bibliothèques partagées de prompts en or, et des runners de tâches basés sur SDK réduisent les frictions et évitent les travaux redondants. Les équipes combinent souvent Microsoft Azure, Google Cloud et Amazon Web Services avec des modèles OpenAI pour standardiser la planification, la récupération et la mise en cache.

-

Open Ai7 jours ago

Open Ai7 jours agoLibérer la puissance des Plugins ChatGPT : améliorez votre expérience en 2025

-

Open Ai6 jours ago

Open Ai6 jours agoMaîtriser l’ajustement fin de GPT : un guide pour personnaliser efficacement vos modèles en 2025

-

Open Ai6 jours ago

Open Ai6 jours agoComparer ChatGPT d’OpenAI, Claude d’Anthropic et Bard de Google : quel outil d’IA générative dominera en 2025 ?

-

Open Ai6 jours ago

Open Ai6 jours agoTarification de ChatGPT en 2025 : Tout ce que vous devez savoir sur les tarifs et abonnements

-

Open Ai6 jours ago

Open Ai6 jours agoLa suppression progressive des modèles GPT : à quoi les utilisateurs peuvent s’attendre en 2025

-

Modèles d’IA6 jours ago

Modèles d’IA6 jours agoModèles GPT-4 : Comment l’intelligence artificielle transforme 2025