Open Ai

Navigieren durch ChatGPTs Ratenbegrenzungen: Wichtige Einblicke für die optimale Nutzung im Jahr 2025

Verständnis der ChatGPT-Nutzungsbeschränkungen im Jahr 2025: Pläne, Modelle und warum sie existieren

Die Nutzungsbeschränkungen von ChatGPT haben sich zu einem mehrschichtigen System entwickelt, das Zuverlässigkeit, Fairness und Kosten in Einklang bringt. Im Jahr 2025 gelten Limits auf mehreren Ebenen: planweite Kontingente, modellbezogene Caps, kurze rollierende Zeitfenster und funktionsspezifische Einschränkungen. Dieses Design hilft OpenAI, während Spitzenzeiten eine konstante Leistung zu gewährleisten und gleichzeitig fortschrittliche Funktionen – wie Denkmodi – ernsthaften Nutzern zugänglich zu machen. Die praktische Erkenntnis ist einfach: Teams, die ihre Arbeitslastmuster an diese Struktur anpassen, vermeiden Unterbrechungen und halten die Geschwindigkeit hoch.

Auf Plan-Ebene sind drei Stufen für die Gesprächsnutzung am wichtigsten: Free, Plus und Pro. Free bietet eingeschränkten täglichen Zugang und kürzere Sitzungen, während Plus wöchentliche Kontingente einführt, die ausreichend für nachhaltige individuelle Arbeit sind. Pro – oft von Power-Usern und kleinen Teams genutzt – tendiert zu effektiv unbegrenzter allgemeiner Nutzung, vorbehaltlich von Missbrauchsschutzmechanismen. Modellbezogene Caps gelten weiterhin, besonders für fortschrittliche Denkmodi. Zum Beispiel kann GPT‑5 Thinking auf Plus oder Team auf eine festgelegte Anzahl von Nachrichten pro Woche begrenzt sein, während die Standardnutzung von GPT‑5 freier skaliert. Kombiniert mit rollierenden 3-Stunden-Fenstern für Modelle wie GPT‑4 und GPT‑4.1 erhalten Nutzer einen vorhersehbaren Zugang, der sich im Tagesverlauf zurücksetzt.

Warum existieren diese Limits? Zwei Gründe dominieren. Erstens sind die Kosten für die Verarbeitung großer Kontextfenster und fortschrittlicher Denkprozesse real – größere Eingaben und längere Ketten verbrauchen mehr Rechenleistung. Zweitens erfordern Qualität und Stabilität Schutzmechanismen; komplexe Modi sind eingeschränkt, um die Verfügbarkeit für legitime, menschlich überwachtes Arbeiten sicherzustellen. Dies zeigt sich im gesamten Ökosystem, von OpenAI über Anthropic und Google DeepMind bis hin zu Plattformen wie Perplexity oder xAIs Grok. Infrastrukturpartner wie Microsoft Azure, Google Cloud und Amazon Web Services liefern die Rechenleistung, aber politische Entscheidungen sorgen für reibungslose und vorhersehbare Erfahrungen.

Für Fachleute, die einen Plan wählen, ist das genaue Lesen der Bedingungen wichtig. Planweite Plus-Kontingente können eine Zahl wie 3.000 Nachrichten pro Woche für typische Nutzung zeigen, während GPT‑5 Thinking gleichzeitig eine kleinere manuelle Auswahl von 200 Nachrichten pro Woche erhalten kann. Parallel können kreative Modelle wie GPT‑4.5 separate Wochenlimits haben, während GPT‑4/4.1 häufig mit rollierenden 3-Stunden-Fenstern arbeiten. Diese Ebenen widersprechen sich nicht, sie ergänzen sich, um die Last über die Modelle auszugleichen. Die, die Preisinformationen und Stufenänderungen suchen, können Analysen wie eine klare Übersicht über ChatGPT-Preise im Jahr 2025 durchsehen oder Wettbewerbsaspekte in Diskussionen zu GPT‑4-Preisstrategien vergleichen.

Team- und Enterprise-Lizenzen folgen ähnlicher Logik. „Unbegrenzt“ bedeutet im Allgemeinen keine praktische Obergrenze für normale menschliche Nutzung, jedoch weiterhin unter Schutzmechanismen. Das umfasst Verbote der Weitergabe von Zugangsdaten oder der Nutzung von Benutzeroberflächen zur Ansteuerung externer, automatisierter Dienste. Unternehmen können Kontingenterhöhungen beantragen, und Administratoren sehen oft bessere Überwachungsfunktionen als Einzelpersonen.

Praktische Ergebnisse sind leicht vorhersehbar: Kreative Arbeitslasten, die Spitzen aufweisen, wie Kampagnenstarts, profitieren von wöchentlichen Caps, die kurze, intensive Phasen erlauben. Stetige tägliche Forschungsabläufe passen besser zu täglichen oder rollierenden Fenstern, die den Verbrauch gleichmäßig verteilen. Hybride Setups – UI-Sitzungen für Ideenfindung kombiniert mit API-Workflows für Produktion – sind üblich. Viele Teams ergänzen ChatGPT mit Modellen, die auf Microsoft Azure, Google Cloud oder Amazon Web Services bereitgestellt werden, und fügen optional Alternativen von Cohere oder IBM Watson hinzu, abhängig von Compliance- und Datenresidenz-Anforderungen.

- 🧠 Nutzen Sie Denkmodi für Analysen mit hoher Priorität; wechseln Sie für Volumenaufgaben zu Mini-Varianten.

- 🔁 Planen Sie mit rollierenden 3-Stunden-Fenstern für GPT‑4/4.1, um Schwung zu halten.

- 📅 Nutzen Sie wöchentliche Caps für sprunghafte Projekte wie Audits oder Migrationen.

- 📦 Speichern Sie wichtige Ergebnisse lokal zwischen, um lange Eingaben nicht unnötig wiederholen zu müssen.

- 🧰 Erkunden Sie SDKs und Automatisierung, wie in dieser Übersicht zum neuen Apps SDK beschrieben, um wiederkehrende Aufgaben zu optimieren.

| Plan ⚙️ | Typischer Zugang 🧭 | Bemerkenswerte Caps ⏳ | Am besten geeignet für 🎯 |

|---|---|---|---|

| Free | GPT‑5 (begrenzt), grundlegende Tools | Tägliche Nachrichten beschränkt; kürzere Sitzungen | Leichte Erkundung, schnelle Prüfungen |

| Plus | GPT‑5, GPT‑4.x, DALL·E | ~3.000 Nachrichten/Woche planweite Caps; Modellfenster gelten | Individuelle Fachleute, stetige Arbeit |

| Pro | GPT‑5 + o1/o3 Zugriffsmuster | Nahezu unbegrenzt unter Schutzmechanismen | Power-User, kleine Teams |

Wichtige Erkenntnis: Passen Sie Arbeitslastmuster an die Plan- + Modell-Kombination an und reservieren Sie Premium-Denken für wertvolle Schritte, um Kontingente zu strecken ohne Qualitätsverlust.

Wöchentliche vs. tägliche Caps, rollierende Fenster und Resets: Timing-Taktiken zur Vermeidung von Unterbrechungen

Reset-Logik ist der Punkt, an dem viele Teams entweder beschleunigen oder ins Stocken geraten. Drei Zeitregime dominieren: wöchentliche Caps, tägliche Caps und rollierende 3-Stunden-Fenster. Wöchentliche Caps – häufig genutzt von ChatGPT und Anthropic – begünstigen sprunghafte Arbeit. Teams können in einer Startwoche viel leisten und dann pausieren, alles innerhalb eines vorhersehbaren Kontingents. Tageslimits, wie bei Plattformen wie Perplexity und manchen Gemini-Konfigurationen, verteilen die Nutzung gleichmäßig über die Tage, was sich für stetige Forschung oder Content-Pipelines eignet. Rollierende 3-Stunden-Fenster (üblich für GPT‑4/4.1) fördern kurze Sprints und teilen Marathon-Sitzungen in verdauliche Abschnitte.

Die Reset-Zeiten sind wichtig. Rollierende Fenster zählen vom letzten Kontakt zurück; Tageslimite setzen meist um 00:00 UTC zurück; wöchentliche Caps resetten normalerweise sieben Tage nach der ersten Nachricht in diesem Zeitraum. Workflow-Designer sollten diese als grundlegende Zeitplanungselemente betrachten. Ein Content-Team könnte zum Beispiel „2-Stunden-GPT‑4-Sprints“ morgens und „GPT‑5 Thinking-Ausbrüche“ am späten Nachmittag planen, um verschiedene Fenster abzudecken. Für breitere Strategien über Pläne und Modelle helfen praktische Empfehlungen in diesem strategiespezifischen Leitfaden, vorhersehbare Rhythmen zu etablieren.

Ein wiederkehrendes Muster fällt auf: Nutzer erreichen ein modellbezogenes Limit, die UI wechselt automatisch auf ein Mini-Modell, und die Qualität sinkt ohne Vorwarnung. Die Lösung ist, den Tag mit dem Limit im Blick zu planen. Wenn in der Woche viel GPT‑5 Thinking gebraucht wird, sollten diese Aufgaben vorgezogen und Routineentwürfe auf ein Mini-Modell oder GPT‑4.1 Mini verschoben werden. Wenn Code-Refaktors oder mehrteilige Analysen anstehen, verteilt das Rotieren zwischen Modellen die Last und erhält die Qualität, wo sie wichtig ist. Das ist ein klassisches Orchestrierungsproblem, kein bloßes „Nutzungs-Limit“-Problem.

Teams im großen Maßstab sollten Resets auch unter den Mitgliedern koordinieren. Wenn fünf Analysten gleichzeitig ein Limit erreichen, kommt das Team zum Stillstand. Versetzte Starts und Modellvielfalt verhindern synchronisierte Verlangsamungen. Tools von Salesforce und interne PM-Dashboards können geplante Nutzungsfenster visualisieren, während Backend-Überwachung auf Microsoft Azure oder Google Cloud API-Spitzen verfolgt. Die breitere KI-Community treibt das Wissen voran – Veranstaltungen wie NVIDIA GTC-Diskussionen zur Zukunft der KI heben oft Zeitplan- und Durchsatz-Engineering-Lehren hervor, die sich direkt auf LLM-Betrieb übertragen lassen.

- 🗓️ Planen Sie rollierende Fenster wie Sprint-Blöcke, um überraschende Fallbacks zu vermeiden.

- 🧮 Verteilen Sie das Denkmodus-Budget früh in der Woche für kritische Entscheidungen.

- 👥 Staffeln Sie die Teamnutzung, um synchronisierte Drosselung zu vermeiden.

- 🔔 Setzen Sie Erinnerungen bei Annäherung an bekannte Limits; wechseln Sie proaktiv auf ein Mini-Modell.

- 🧭 Überprüfen Sie Plandetails in diesem Preiserklärer, um Zeitbudgets mit Stufen abzugleichen.

| Reset-Typ ⏱️ | Funktionsweise 🔍 | Typisches Beispiel 📌 | Planungstipp 🧭 |

|---|---|---|---|

| Rollierendes 3-Stunden | Fenster zählt vom letzten Beitrag zurück | GPT‑4/4.1: 80 Nachrichten/3h | Fokussierte Sprints fahren; Pause für Reset 🔁 |

| Täglich | Reset um 00:00 UTC | o4‑mini: 300/Tag | Aufgaben über Tage verteilen 📅 |

| Wöchentlich (rollierend) | Reset sieben Tage nach erster Nachricht | GPT‑5 Thinking: ~200/Woche | Hochwertige Arbeit früh im Fenster priorisieren 🚀 |

Wichtige Erkenntnis: Behandeln Sie Resets wie Kalender-Einschränkungen – bei richtiger Zeitwahl werden Limits zu Workflow-Rhythmen, nicht zu Hindernissen.

Ökonomie des Kontextfensters und Token-Budgetierung: Kontingente strecken ohne Qualitätsverlust

Große Kontextfenster sind mächtig – und teuer in Token-Begriffen. Ein 128K-Token-Kontext (typisch für ChatGPTs GPT‑5- und GPT‑4.1-Stufen) fasst etwa 96.000 Wörter, während 200K bei Claude etwa 150.000 Wörter handhabt. Geminis 1M-Token-Kontext fasst ungefähr 750.000 Wörter. Diese Kapazitäten verleiten Nutzer dazu, ganze Wikis einzufügen, aber jede zusätzliche Seite verbraucht Kontingent und erhöht die Latenz. Taktischer ist es, Inhalte aufzuteilen, zu indexieren und zusammenzufassen, bevor schwergewichtige Denkprozesse genutzt werden. Token-bewusste Workflows erhöhen den Durchsatz, ohne die Ergebnisse zu verschlechtern.

Betrachten Sie ein Forschungsteam, das Compliance-Dokumente neu erstellt. Statt vollständige PDFs in eine einzige Nachricht zu laden, teilen sie Inhalte thematisch auf, erzeugen mit einem Mini-Modell verdichtete Notizen und leiten die anschließend verfeinerten Zusammenfassungen an GPT‑5 Thinking für die finale Audit-Logik weiter. Dieser zweistufige Ansatz reduziert Token-Verbrauch und bewahrt analytische Tiefe. Wenn viel Kontext benötigt wird, reservieren sie die größten Fenster für die wichtigsten zusammenhängenden Passagen und halten Anhänge aus dem Haupt-Prompt heraus.

Nebenprozesse helfen. Vektordatenbanken, Retrieval-Pipelines und Embeddings ermöglichen präzises Abrufen statt Dumpen ganzer Korpora. Viele Teams verlassen sich auf Managed Services von Amazon Web Services oder Microsoft Azure für elastische Skalierung, während andere Hugging Face-Hubs für ergänzende Open-Source-Modelle nutzen, die Kontext vorverarbeiten und komprimieren. Die Community experimentiert weiter, wie in Beiträgen zu Open-Source-Kooperationsrückblicken und NVIDIAs Initiativen zu offenen Frameworks, die beeinflussen, wie Kontextmanagement gestaltet wird.

Das Denkbudget ist ebenso entscheidend. Viele professionelle Pläne liefern „Standard“-Antworten ohne umfangreiche Gedankengänge, sofern nicht angefragt. Sparen Sie tiefstehendes Denken für wenige Prompts, die wirklich mehrfaches Verknüpfen erfordern. Für Routineentwürfe können GPT‑4.1 mini oder o4‑mini 80–90 % des Volumens zu einem Bruchteil der Kosten und des Kontingents abdecken. Teams, die diese Triage kodifizieren – Mini für Grundgerüst, Frontier-Modell für den finalen Feinschliff – liefern schneller und günstiger.

- 🧩 Teilen Sie Quellmaterial auf und fassen Sie vor dem Eskalieren zusammen.

- 🧷 Nutzen Sie Retrieval, um nur relevante Abschnitte einzubeziehen.

- 🪙 Beschränken Sie den Denkmodus auf Entscheidungen mit messbarem Einfluss.

- 🗂️ Speichern Sie wiederverwendbare Ausschnitte, vermeiden Sie Wiederholung langer Standardtexte.

- 🧪 Testen Sie token-sparende Ideen mit Ressourcen wie Leitfäden zu Fine-Tuning-Techniken für eine leichte Vorverarbeitung.

| Kontextgröße 📏 | Ca. Wörter 📚 | Wann verwenden ✅ | Token-Spar-Tipp 💡 |

|---|---|---|---|

| 128K | ~96.000 Wörter | Briefings, Spezifikationen, mittelgroße Korpora | Vorab mit Mini-Modell zusammenfassen ✂️ |

| 200K | ~150.000 Wörter | Richtlinien, Überprüfungen mehrerer Dokumente | Retrieval statt Rohkopieren nutzen 📎 |

| 1M | ~750.000 Wörter | Große Forschungssätze | Inhalte mit Embeddings staffeln 🧭 |

Wichtige Erkenntnis: Token-Disziplin – nicht nur Plan-Upgrades – bringt den größten Fortschritt in dauerhaftem Durchsatz und Zuverlässigkeit.

Auswahl zwischen ChatGPT, Claude, Gemini, Grok und Perplexity: Limits, Denkmodi und Abwägungen

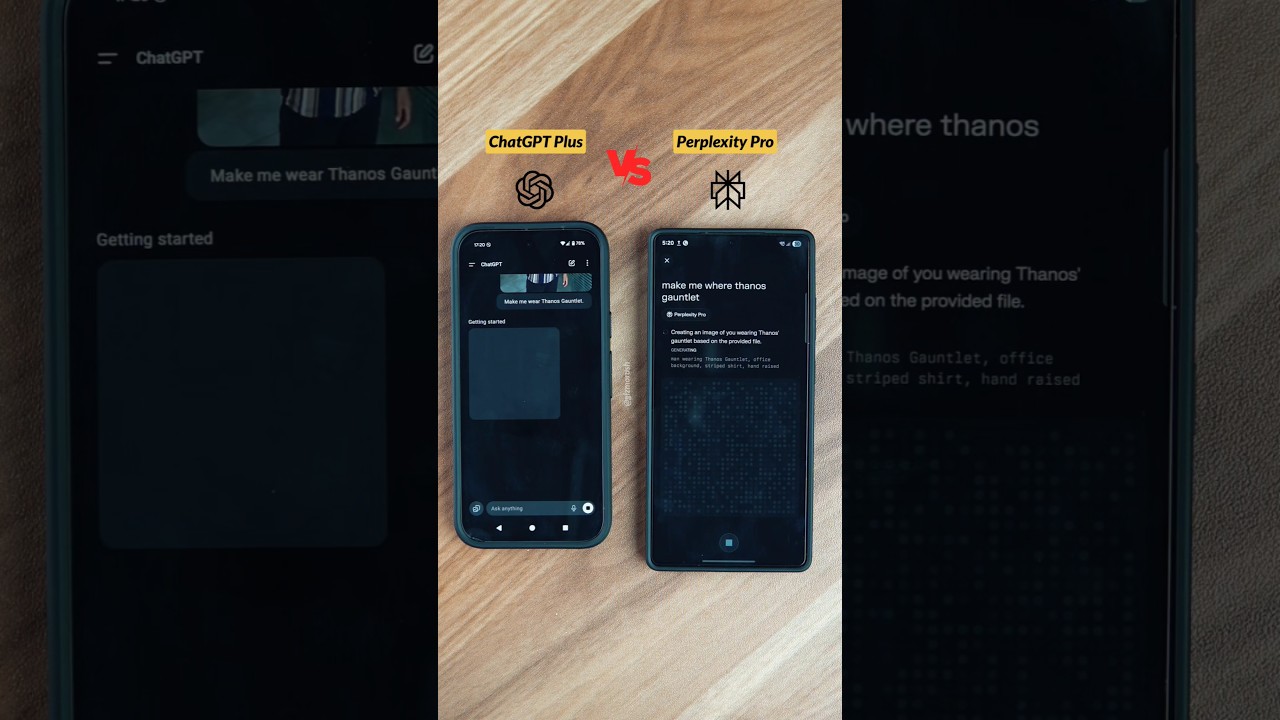

Limits sind nur im Kontext des breiteren Marktes sinnvoll. Im Jahr 2025 konvergieren die führenden Plattformen auf ähnliche Designmuster: gestufte Pläne, sichtbare Messinstrumente und Denkmodi über bezahlte Stufen. Unterschiede entstehen bei Kontextgröße, Reset-Rhythmen und Stärken der Plattformen. So legt ChatGPT Wert auf Breite und Tool-Integrationen; Claude ist stark beim Codieren und strukturierter Analyse; Gemini führt bei 1M-Token-Kontexten; Grok ist eng an Echtzeit-Streams gekoppelt; und Perplexity optimiert abfragestil für Forschung.

Auf einen Blick gruppieren sich Plus-Stufen um 20 $, Premium-Stufen liegen bei 200–300 $. Diese höhere Kategorie zielt auf Fachleute ab, die entweder nahezu unbegrenzte Nutzung oder Frontier-Denken brauchen. Jede Plattform definiert „unbegrenzt“ sorgfältig und behält sich das Recht vor, automatisiertes Scraping oder Weiterverkauf zu unterbinden. Hilfreiche Vergleiche – wie ausgewogene Gegenüberstellungen von ChatGPT und Claude – helfen Teams bei der Wahl der passenden Kombination. Wer Kostenkontrolle verfolgt, profitiert auch von Preisstrategie-Analysen, die erklären, wie Fenstergrößen und modellbezogene Caps Budgets beeinflussen.

Nachfolgend eine zusammengefasste, nutzungsorientierte Übersicht, die das Bild für Ende 2025 widerspiegelt und als grobe Referenz dient. Die neuesten Zahlen immer in offiziellen Dokumenten bestätigen, bevor Entscheidungen getroffen werden.

| Plattform 🌐 | Schlüsselmodelle 🧠 | Typische Limits ⏳ | Denkmodus 🧩 | Kontextfenster 📏 |

|---|---|---|---|---|

| ChatGPT | GPT‑5, GPT‑4.x | Plus ~3.000 Nachrichten/Woche; modellbezogene Fenster | GPT‑5 Thinking ✔️ | 128K Tokens |

| Claude | Sonnet 4.5, Opus | ~15–45 Nachrichten/5h (höher bei Pro) | Erweitertes Denken ✔️ | 200K (1M Beta) 🔬 |

| Gemini | Pro 2.5, Ultra | Tagesquoten; Ultra bis zu 1M Tokens/Tag | Tiefgreifendes Denken ✔️ | 1M Tokens 🏆 |

| Grok | Grok 3/4 | ~10 Anfragen/2h (mehr bei Bezahlung) | Standard-Denkmodus | 256K Tokens |

| Perplexity | GPT‑4.1, Claude 4, o3‑pro | Pro/Tag Caps; Max ~300+ Pro/Tag | Tiefgreifende Forschung ✔️ | Erweitert (variiert) 📎 |

Die Passung im Ökosystem ist genauso wichtig wie rohe Limits. Organisationen, die tief in Salesforce-Workflows arbeiten, bevorzugen vielleicht ChatGPT für Zusammenfassungen und CRM-Drafts. Teams, die auf lokal beschleunigte NVIDIA-Forschung setzen, können Vorverarbeitung nutzen, um Tokens vor der Cloud-Nutzung zu reduzieren. Die, die kosteneffiziente Trainingsalternativen suchen, schauen gelegentlich in Ressourcen wie Studien zu günstigen Trainingsmethoden für langfristige Strategien. Echtzeitorientierte Wissensarbeit wächst weiter, mit Erkenntnissen aus Veranstaltungsberichten zur KI-Zukunft.

- 🛠️ Wählen Sie Plattformen nach Stärken (Codierung, Forschung, Echtzeit, Enterprise-Suite).

- 🧭 Passen Sie Reset-Arten an den Rhythmus des Teams an (sprunghaft vs. stetig).

- 📈 Beginnen Sie mit Plus/Pro und testen Sie Workloads vor Investitionen in 200–300 $-Stufen.

- 🧳 Halten Sie ein Backup-Modell bereit, wenn Limits mitten im Sprint erreicht werden.

- 🔗 Nutzen Sie Referenzen wie diesen Limits-und-Strategien-Leitfaden, um einen ersten Plan zu verfeinern.

Wichtige Erkenntnis: Wählen Sie Plattformen nach Passung, nicht nach Hype; kombinieren Sie Stärken und Reset-Muster mit dem Betriebsrhythmus des Teams für weniger Überraschungen.

Design effizienter Token- und Zeitarbeitsabläufe: Ein Playbook für Teams und Unternehmen

Für Unternehmen, die in Dokumenten, Code und Meetings leben, entscheidet die Gestaltung des Workflows über Erfolg oder Stagnation. Ein praktisches Playbook beginnt mit Arbeitslast-Triage, führt über Modellzuordnung und endet mit Schutzmechanismus-bewusster Automatisierung. Betrachten wir ein fiktives Unternehmen – HarborLine Financial – mit fünf Analysten und zwei Produktmanagern. Ihre Arbeit umfasst Forschung, Richtlinienupdates und Zusammenfassungen für Stakeholder. Ohne Planung stoßen sie Mitte der Woche auf Limits; mit Playbook liefern sie pünktlich und budgetgerecht.

Zuerst kodifizieren sie den Entscheidungsbaum. Einfache Entwürfe, Umformatierung und Extraktion laufen über Mini-Modelle. Strukturierte Synthese geht an GPT‑4.1 oder GPT‑4.5. Nur die schwierigsten Denkprozesse – regulatorische Interpretation, Szenariomodellierung – eskalieren zu GPT‑5 Thinking. Zweitens: Token-Disziplin formalieren: Retrieval für dokumentlastige Abfragen, Caching wiederverwendbarer Ausschnitte und eine gemeinsame Bibliothek von „Prompt-Mustern“. Drittens: Schutzmechanismusbewusste Automatisierungen einrichten. Geplante Jobs können bei Bedarf über die API laufen, die UI bleibt für menschliches Review. Mit wachsendem Umfang bieten hybride Architekturen mit Microsoft Azure, Google Cloud und Amazon Web Services Durchsatzsicherung, während Anbieterdiversität Resilienz erhöht.

Viertens: Zusammenarbeit ermöglichen. Gemeinsame Gesprächsarchive verhindern wiederholtes Nachfragen. Teams, die eine Wissensbasis pflegen und „goldene Prompts“ verbreiten, sind beständiger als jene mit spontanen Eingaben. Leitfäden wie Empfehlungen zum Teilen von Gesprächen helfen, Normen zu setzen. Fünftens: Spezialwerkzeuge je nach Bedarf ergänzen: Spracheingabe für schnelle Erfassung (siehe ein einfaches Voice-Setup), Multi-Agenten-Forschung für tiefere Analysen und SDK-gesteuerte Task-Runner. Für produktivitätssteigernde Begleiterprodukte demonstrieren Atlas AI-Companions, wie Assistenten mehrstufige Abläufe zwischen Apps orchestrieren können.

Schließlich: Überwachen und iterieren. Nutzungs-Dashboards zeigen Limitmuster. Bei temporären Restriktionen wegen Richtlinienverstößen gibt es Eskalationspfade – Vorfall dokumentieren und Support mit Details kontaktieren. Enterprise-Admins können Kontingentänderungen oder kontrollierten Zugang zu Denkmodi in kritischen Zeiten anfragen. Halten Sie Optionen bei mehreren Anbietern bereit: Cohere für Embeddings, IBM Watson für domänenspezifische Dienste und Open-Source-Vorverarbeitung, wie deutlich in Open-Source-Kollaborations-Highlights betont. Für Kontext bei Frontier-Modellen bleiben Sie mit Trainingsentwicklungen in Beiträgen wie Erklärungen zur GPT‑5-Trainingsphase informiert.

- 🧭 Erstellen Sie eine Triage-Matrix, um Aufgaben nach Komplexität und Kosten zuzuordnen.

- 🧲 Fügen Sie Retrieval + Caching hinzu, um Prompts zu verkürzen und Durchläufe zu beschleunigen.

- 🔐 Respektieren Sie Schutzmechanismen; halten Sie UI-Nutzung menschengesteuert und authentifiziert.

- 🧑🤝🧑 Standardisieren Sie Prompt-Muster und teilen Sie diese in einer Team-Bibliothek.

- 📊 Verfolgen Sie Limits und Fallbacks; passen Sie Kalender und Modellmix proaktiv an.

| Praxis 🛠️ | Auswirkung 📈 | Limit-Resilienz 🧱 | Notizen 📝 |

|---|---|---|---|

| Modell-Triage | 30–60 % weniger Premium-Aufrufe | Hoch | Denken für kritische Schritte reservieren 🧠 |

| Retrieval + Caching | 40 % Token-Reduktion | Hoch | Verhindert wiederholte Verarbeitung großer Dokumente ♻️ |

| Gemeinsame Prompts | Schnellere Einarbeitung | Mittel | Konsistenz verbessert Ausgabequalität 📚 |

| Hybrid Cloud | Mehr Durchsatz-Puffer | Hoch | Azure/GCP/AWS bieten Elastizität ☁️ |

Wichtige Erkenntnis: Eine kleine Gruppe von Engineering-Gewohnheiten – Triage, Retrieval, Caching und Zeitplanung – verwandelt Limits in vorhersehbare Schutzmechanismen statt Blockaden.

Fehlerbehebung bei Nutzungsbeschränkungen und Aufbau ausfallsicherer Routinen

Auch bei sorgfältiger Planung sind Nutzungsbeschränkungsfehler bei Spitzen oder Starts unvermeidbar. Ziel ist eine sofortige Wiederherstellung ohne Arbeitsunterbrechung. Das beginnt mit dem Verständnis der Fehlersignaturen. Wenn ein Limit erreicht ist, kann das Modell aus dem Auswahldialog verschwinden oder die UI wechselt lautlos auf ein kleineres Modell. Benachrichtigungen kommunizieren meist den Reset-Zeitpunkt; ein Mouseover über den Modellnamen zeigt oft, wann das Fenster erneuert wird. Bei Verstößen gegen Schutzmechanismen – z. B. vermutete automatisierte Extraktion – können temporäre Einschränkungen bis zur Prüfung durch den Support gelten.

Effektive Erholungsroutinen basieren auf gestuften Fallbacks. Ist GPT‑5 Thinking gesperrt, wechselt man zu GPT‑4.1 für Zwischenschritte und plant abschließende Prüfungen für das nächste Reset-Fenster ein. Batchen reduziert Anzahl der Rückfragen: Mehrere Teilanfragen in einem strukturierten Prompt bündeln statt einzeln senden. Für Meetings und Content-Erfassung sparen Spracheingaben Zeit; Einrichtungsanleitungen wie diese Voice-Chat-Anleitung verringern Reibungsverluste. Wenn ein ganzes Team auf Limits stößt, kann man auf Dokumentationsaufgaben, Verfeinerung von Prompts oder das Entwerfen von Richtlinien ausweichen – produktive Arbeit, die keine Premium-Fenster belastet.

Manchmal ist ein anderes Tool die richtige Antwort. Claudes größere Fenster, Groks Echtzeitfokus oder Perplexitys Forschungs-Workflows können die Last tragen, während man wartet. Außerhalb der UI bleibt die API für Programmierpipelines eine Option, oft mit anderen Kontingenten und Preisen. Viele Organisationen setzen bei NVIDIA-beschleunigter Infrastruktur Preprocessing-Agenten ein und senden dann kompakte Anfragen nach oben, ein Vorgehen, das in Initiativen zu Open-Source-Frameworks erläutert wird. Im Zweifel können kleinere Teams auf Einsteigerleitfäden wie fallbezogene Anwendungsanleitungen zurückgreifen, um den schnellsten Umweg zu finden.

Geteilte Lernerfahrungen steigern die Resilienz. Team-Retrospektiven erfassen, welche Prompts regelmäßig Caps erreichen und wie Fallbacks funktionieren. Zentrale Dokumentation – kombiniert mit Wissen über Modellbesonderheiten, z. B. 3-Stunden-Fenster für GPT‑4.x – verbessert die Ausführung. Für tägliche Anwender beschleunigen Auffrischungen wie diese Übersicht zu Beschränkungen die Fehlersuche. Für teamübergreifende Zusammenarbeit sind KI-Begleiter sinnvoll, die einfache Übergaben orchestrieren; Beispiele wie Atlas-Style Assistenten demonstrieren effiziente Koordinationsmuster.

- 🚦 Führen Sie eine Fallback-Matrix für jeden kritischen Workflow.

- 📦 Bündeln Sie Mikroaufgaben zu einem einzigen zusammengesetzten Prompt.

- 📝 Protokollieren Sie Fehler, Caps und Reset-Zeiten zur Musteranalyse.

- 🔄 Nutzen Sie Begleittools, um Arbeit während Caps zu staffeln (Entwurf, Kennzeichnung, Vorbereitung).

- 🔍 Überprüfen Sie Plandetails mit aktuellen Übersichten wie dieser Strategie-Ressource.

| Problem 🚧 | Wahrscheinliche Ursache 🧭 | Unmittelbare Maßnahme ⚡ | Nächster Schritt 🧱 |

|---|---|---|---|

| Modell ausgeblendet | Limit für Fenster erreicht | Wechsel zu Mini- oder Alternativmodell | Premium-Aufgabe für Reset einplanen 🔁 |

| Qualitätsabfall | Automatischer Fallback unter Last | Modell-Badge überprüfen | Wichtigen Schritt nach Reset erneut senden 🎯 |

| Temporäre Beschränkung | Schutzmechanismus aktiviert | Support mit Logs kontaktieren | Nutzungsbedingungen prüfen und Pipeline anpassen 🔐 |

Wichtige Erkenntnis: Wiederherstellung ist ein Prozess, kein Ereignis – Fallbacks kodifizieren, Protokolle führen und immer eine Alternative bereithalten.

{“@context”:”https://schema.org”,”@type”:”FAQPage”,”mainEntity”:[{“@type”:”Question”,”name”:”Was sind die wichtigsten ChatGPT-Caps, die man sich merken sollte?”,”acceptedAnswer”:{“@type”:”Answer”,”text”:”Planweite Kontingente (z. B. Plus ~3.000 Nachrichten/Woche), modellbezogene Fenster (z. B. GPT‑4/4.1 mit rollierenden 3-Stunden-Limits) und spezielle Denk-Caps (z. B. GPT‑5 Thinking ~200 Nachrichten/Woche auf Plus/Team) regeln den Alltag. Tagesquoten gelten bei manchen Modellen wie o4‑mini, und rollierende wöchentliche Fenster resetten sieben Tage nach der ersten Nachricht im Intervall.”}},{“@type”:”Question”,”name”:”Wie können Teams Limits bei wichtigen Deadlines vermeiden?”,”acceptedAnswer”:{“@type”:”Answer”,”text”:”Planen Sie Premium-Denken früh im Wochenfenster, führen Sie GPT‑4.x in konzentrierten 3-Stunden-Sprints aus und reservieren Sie Mini-Modelle für Volumentexte. Nutzen Sie Retrieval und Caching, um Prompts zu verkürzen, und staffeln Sie die Teamnutzung, um synchronisierte Drosselung zu verhindern. Führen Sie eine dokumentierte Fallback-Matrix und wechseln Sie proaktiv Modelle bei Annäherung an Limits.”}},{“@type”:”Question”,”name”:”Helfen Drittanbieterplattformen, wenn ChatGPT-Caps eng sind?”,”acceptedAnswer”:{“@type”:”Answer”,”text”:”Ja. Claudes größere Fenster, Geminis 1M-Token-Kontexte, Groks Echtzeit-Fokus und Perplexitys Forschungs-Workflows können Lücken füllen. Viele Organisationen ergänzen ChatGPT mit Cohere-Embeddings, IBM Watson-Diensten oder Open-Source-Vorverarbeitung auf NVIDIA-beschleunigter Infrastruktur.”}},{“@type”:”Question”,”name”:”Wo können Fachleute mehr über Preise und Planänderungen lernen?”,”acceptedAnswer”:{“@type”:”Answer”,”text”:”Konsultieren Sie zusammengefasste Erklärungen wie eine Übersicht über ChatGPT-Preise 2025 und Strategieartikel zu GPT‑4-Preisdynamiken. Für Modellentwicklungen lesen Sie GPT‑5-Trainingsphasenerklärungen und folgen Sie den Veröffentlichungen der Anbieter.”}},{“@type”:”Question”,”name”:”Lohnt es sich, interne Tools zum Limitmanagement zu entwickeln?”,”acceptedAnswer”:{“@type”:”Answer”,”text”:”Ja. Leichtgewichtige Dashboards zur Überwachung von Caps, gemeinsame Bibliotheken mit goldenen Prompts und SDK-basierte Task-Runner reduzieren Reibung und verhindern Doppelarbeit. Teams kombinieren oft Microsoft Azure, Google Cloud und Amazon Web Services mit OpenAI-Modellen, um Zeitplanung, Retrieval und Caching zu standardisieren.”}}]}Was sind die wichtigsten ChatGPT-Caps, die man sich merken sollte?

Planweite Kontingente (z. B. Plus ~3.000 Nachrichten/Woche), modellbezogene Fenster (z. B. GPT‑4/4.1 mit rollierenden 3-Stunden-Limits), und spezielle Denk-Caps (z. B. GPT‑5 Thinking ~200 Nachrichten/Woche auf Plus/Team) regeln den Alltag. Tagesquoten gelten bei manchen Modellen wie o4‑mini, und rollierende wöchentliche Fenster resetten sieben Tage nach der ersten Nachricht im Intervall.

Wie können Teams Limits bei wichtigen Deadlines vermeiden?

Planen Sie Premium-Denken früh im Wochenfenster, führen Sie GPT‑4.x in konzentrierten 3-Stunden-Sprints aus und reservieren Sie Mini-Modelle für Volumentexte. Nutzen Sie Retrieval und Caching, um Prompts zu verkürzen, und staffeln Sie die Teamnutzung, um synchronisierte Drosselung zu verhindern. Führen Sie eine dokumentierte Fallback-Matrix und wechseln Sie proaktiv Modelle bei Annäherung an Limits.

Helfen Drittanbieterplattformen, wenn ChatGPT-Caps eng sind?

Ja. Claudes größere Fenster, Geminis 1M-Token-Kontexte, Groks Echtzeit-Fokus und Perplexitys Forschungs-Workflows können Lücken füllen. Viele Organisationen ergänzen ChatGPT mit Cohere-Embeddings, IBM Watson-Diensten oder Open-Source-Vorverarbeitung auf NVIDIA-beschleunigter Infrastruktur.

Wo können Fachleute mehr über Preise und Planänderungen lernen?

Konsultieren Sie zusammengefasste Erklärungen wie eine Übersicht über ChatGPT-Preise 2025 und Strategieartikel zu GPT‑4-Preisdynamiken. Für Modellentwicklungen lesen Sie GPT‑5-Trainingsphasenerklärungen und folgen Sie den Veröffentlichungen der Anbieter.

Lohnt es sich, interne Tools zum Limitmanagement zu entwickeln?

Ja. Leichtgewichtige Dashboards zur Überwachung von Caps, gemeinsame Bibliotheken mit goldenen Prompts und SDK-basierte Task-Runner reduzieren Reibung und verhindern Doppelarbeit. Teams kombinieren oft Microsoft Azure, Google Cloud und Amazon Web Services mit OpenAI-Modellen, um Zeitplanung, Retrieval und Caching zu standardisieren.

-

Open Ai1 week ago

Open Ai1 week agoEntfesselung der Power von ChatGPT-Plugins: Verbessern Sie Ihr Erlebnis im Jahr 2025

-

Open Ai6 days ago

Open Ai6 days agoMastering GPT Fine-Tuning: Ein Leitfaden zur effektiven Anpassung Ihrer Modelle im Jahr 2025

-

Open Ai7 days ago

Open Ai7 days agoVergleich von OpenAIs ChatGPT, Anthropics Claude und Googles Bard: Welches generative KI-Tool wird 2025 die Vorherrschaft erlangen?

-

Open Ai6 days ago

Open Ai6 days agoChatGPT-Preise im Jahr 2025: Alles, was Sie über Tarife und Abonnements wissen müssen

-

Open Ai7 days ago

Open Ai7 days agoDas Auslaufen der GPT-Modelle: Was Nutzer im Jahr 2025 erwartet

-

KI-Modelle6 days ago

KI-Modelle6 days agoGPT-4-Modelle: Wie Künstliche Intelligenz das Jahr 2025 verändert