Open Ai

Navegando pelos Limites de Taxa do ChatGPT: Insights Essenciais para Uso Ótimo em 2025

Entendendo os Limites de Taxa do ChatGPT em 2025: Planos, Modelos e Por Que Eles Existem

Os controles de uso do ChatGPT evoluíram para um sistema em camadas que equilibra confiabilidade, justiça e custo. Em 2025, os limites operam em múltiplos níveis: cotas para todo o plano, limites por modelo, janelas móveis curtas e restrições específicas de recursos. Esse design ajuda a OpenAI a entregar desempenho consistente durante horários de pico, mantendo capacidades avançadas — como modos de raciocínio — disponíveis para usuários sérios. A lição prática é simples: equipes que mapeiam seus padrões de carga de trabalho para essa estrutura evitam interrupções e mantêm alta velocidade.

No nível do plano, três categorias importam mais para uso conversacional: Free, Plus e Pro. Free oferece acesso diário limitado e sessões mais curtas, enquanto Plus introduz permissões semanais suficientemente grandes para trabalho individual sustentado. Pro — frequentemente usado por usuários avançados e pequenas equipes — tende para uso geral praticamente ilimitado, sujeito a regras contra abusos. Limites por modelo ainda se aplicam, especialmente para modos de raciocínio avançados. Por exemplo, GPT‑5 Thinking pode ser limitado a um número fixo de mensagens a cada semana no Plus ou Team, enquanto o uso padrão do GPT‑5 escala com mais liberdade. Quando combinado com janelas móveis de 3 horas para modelos como GPT‑4 e GPT‑4.1, os usuários obtêm acesso previsível que se reinicia ao longo do dia.

Por que esses limites existem? Dois motivos dominam. Primeiro, a economia de servir janelas de contexto grandes e raciocínio avançado é real — prompts maiores e cadeias mais longas consomem mais computação. Segundo, qualidade e estabilidade exigem regras; modos sofisticados são restritos para garantir disponibilidade para trabalhos legítimos com intervenção humana. Isso é visível em todo o ecossistema, da OpenAI à Anthropic e Google DeepMind, e até em plataformas como Perplexity ou Grok da xAI. Parceiros de infraestrutura como Microsoft Azure, Google Cloud e Amazon Web Services fornecem o poder computacional, mas escolhas políticas mantêm as experiências suaves e previsíveis.

Para profissionais que escolhem um plano, ler os detalhes importa. As cotas gerais do Plus podem mostrar um valor como 3.000 mensagens por semana para uso típico, ainda que o GPT‑5 Thinking possa apresentar uma permissão menor de 200 mensagens por semana para seleção manual. Paralelamente, modelos criativos como GPT‑4.5 podem ter limites semanais separados, enquanto GPT‑4/4.1 frequentemente operam sob janelas móveis de 3 horas. Essas camadas não são contraditórias; elas se complementam para equilibrar a carga entre os modelos. Quem busca contexto de preços e mudanças nas categorias pode conferir análises como um resumo claro do preço do ChatGPT em 2025 ou comparar com perspectivas competitivas em discussão sobre estratégias de preço do GPT‑4.

Desbloqueios para Team e Enterprise seguem lógica similar. “Ilimitado” geralmente significa sem teto prático para uso humano normal mas ainda sujeito a regras. Isso inclui proibições sobre compartilhamento de credenciais ou uso do acesso UI para alimentar serviços externos automatizados. Empresas podem solicitar aumentos de cota, e administradores normalmente dispõem de controles de monitoramento melhores do que usuários individuais.

Resultados práticos são fáceis de prever: cargas criativas que disparam, como lançamentos de campanhas, beneficiam-se de limites semanais que permitem picos curtos e intensos. Fluxos de trabalho diários estáveis se alinham melhor com limites diários ou janelas móveis, que distribuem o uso uniformemente. Configurações híbridas — misturando sessões UI para ideação com fluxos de trabalho API para produção — são comuns. Muitas equipes complementam o ChatGPT com modelos implantados no Microsoft Azure, Google Cloud ou Amazon Web Services, e opcionalmente adicionam alternativas da Cohere ou IBM Watson, dependendo de conformidade e necessidades de residência de dados.

- 🧠 Use modos de raciocínio para análises críticas; alterne para variantes mini para tarefas volumosas.

- 🔁 Planeje em torno de janelas móveis de 3 horas para GPT‑4/4.1 para manter o ritmo.

- 📅 Aproveite limites semanais para projetos intensos como auditorias ou migrações.

- 📦 Armazene chaves localmente para evitar reexecução desnecessária de prompts longos.

- 🧰 Explore SDKs e automação, como abordado em esta visão geral do novo SDK de apps, para agilizar tarefas repetidas.

| Plano ⚙️ | Acesso Típico 🧭 | Limites Notáveis ⏳ | Melhor Para 🎯 |

|---|---|---|---|

| Free | GPT‑5 (limitado), ferramentas básicas | Mensagens diárias limitadas; sessões menores | Exploração leve, verificações rápidas |

| Plus | GPT‑5, GPT‑4.x, DALL·E | ~3.000 msgs/semana nível do plano; janelas por modelo aplicam-se | Profissionais individuais, trabalho constante |

| Pro | GPT‑5 + padrões de acesso o1/o3 | Praticamente ilimitado sob regras | Usuários avançados, pequenas equipes |

Insight chave: mapeie os padrões de carga de trabalho para a combinação plano + modelo, e reserve o raciocínio premium para etapas de alto valor para esticar cotas sem sacrificar a qualidade.

Limites Semanais vs Diários, Janelas Móveis e Reinícios: Táticas de Tempo Que Evitam Interrupções

A lógica de reinício é onde muitas equipes aceleram ou travam. Três regimes dominam o tempo: limites semanais, diários e janelas móveis de 3 horas. Limites semanais — usados com frequência pelo ChatGPT e Anthropic — favorecem trabalhos intensos e pontuais. Equipes podem esforçar-se muito durante a semana de lançamento e depois desacelerar, tudo dentro de uma cota previsível. Limites diários, vistos em plataformas como Perplexity e algumas configurações Gemini, distribuem o uso uniformemente ao longo dos dias, adequado para pesquisas estáveis ou pipelines de conteúdo. Janelas móveis de 3 horas (comuns para GPT‑4/4.1) incentivam sprints curtos e dividem sessões longas em pedaços digeríveis.

Horários de reinício importam. Janelas móveis contam a partir da última interação; limites diários tipicamente reiniciam às 00:00 UTC; limites semanais geralmente reiniciam em uma base móvel de sete dias a partir da primeira mensagem daquele período. Quem projeta fluxos de trabalho deve tratar esses aspectos como primitivas de agendamento. Por exemplo, uma equipe de conteúdo pode planejar “sprints de GPT‑4o de 2 horas” pela manhã e “explosões GPT‑5 Thinking” no final da tarde para atingir janelas separadas. Para estratégia ampla entre planos e modelos, recomendações práticas em este guia focado em estratégias podem ajudar equipes a construir cadências previsíveis.

Um padrão recorrente se destaca: usuários atingem um limite por modelo, a interface cai automaticamente para um modelo mini e a qualidade cai sem aviso. A solução é planejar o dia considerando o limite. Se a semana requer uso intenso do GPT‑5 Thinking, concentre essas tarefas inicialmente e deixe a redação rotineira para um modelo mini ou GPT‑4.1 mini. Se refatorações de código ou análises de múltiplos arquivos se acumularem, rodar modelos diferentes espalha a carga enquanto mantém a qualidade onde importa. Este é um problema clássico de orquestração de carga, não mero “problema de limite de uso”.

Equipes em escala também devem coordenar reinícios entre membros. Se cinco analistas atingem um limite simultaneamente, a equipe trava. Inícios escalonados e diversidade de modelos previnem desacelerações sincronizadas. Ferramentas da Salesforce e painéis internos de gerenciamento de projetos podem visualizar janelas de uso planejadas, enquanto observabilidade back-end em Microsoft Azure ou Google Cloud monitora picos de API. A comunidade mais ampla de IA impulsiona o conhecimento — eventos como discussões NVIDIA GTC sobre o futuro da IA frequentemente destacam lições de agendamento e engenharia de throughput que se traduzem diretamente para operações LLM.

- 🗓️ Agende janelas móveis como blocos de sprint para evitar rebaixamentos inesperados.

- 🧮 Aloque orçamento de modo raciocínio no início da semana para decisões críticas.

- 👥 Escalone uso da equipe para evitar estrangulamentos sincronizados.

- 🔔 Use lembretes ao se aproximar dos limites conhecidos; alterne proativamente para um modelo mini.

- 🧭 Revise os detalhes do plano em este explicador de preços para alinhar os orçamentos de tempo com as categorias.

| Tipo de Reinício ⏱️ | Como Funciona 🔍 | Exemplo Típico 📌 | Dica de Planejamento 🧭 |

|---|---|---|---|

| Janela móvel de 3 horas | Contagem recua desde a última mensagem | GPT‑4/4.1: 80 msgs/3h | Execute sprints focados; pause para reiniciar 🔁 |

| Diário | Reinicia às 00:00 UTC | o4‑mini: 300/dia | Distribua tarefas ao longo dos dias 📅 |

| Semanal (móvel) | Reinicia sete dias após a primeira mensagem | GPT‑5 Thinking: ~200/semana | Concentre trabalhos de alto valor no início da janela 🚀 |

Insight chave: trate os reinícios como restrições no calendário — quando temporizados corretamente, os limites viram ritmos de trabalho, não bloqueios.

Economia da Janela de Contexto e Orçamento de Tokens: Estendendo Cotas Sem Sacrificar a Qualidade

Janelas de contexto grandes são poderosas — e caras em termos de tokens. Um contexto de 128K tokens (típico para GPT‑5 e GPT‑4.1 do ChatGPT) acomoda cerca de 96.000 palavras, enquanto 200K para Claude comporta cerca de 150.000 palavras. O contexto de 1M tokens do Gemini comporta aproximadamente 750.000 palavras. Essas capacidades tentam usuários a copiar wikis inteiras, mas cada página extra consome cota e adiciona latência. A tática mais inteligente é fragmentar, indexar e resumir antes de invocar raciocínio pesado. Fluxos de trabalho conscientes de tokens aumentam throughputs sem degradar resultados.

Considere uma equipe de pesquisa reconstruindo documentação de compliance. Em vez de carregar PDFs completos em uma única mensagem, eles dividem o conteúdo em pacotes temáticos, geram notas condensadas com um modelo mini e só então elevam os resumos refinados para o GPT‑5 Thinking para lógica final de auditoria. Essa abordagem em duas etapas reduz o consumo de tokens enquanto preserva rigor analítico. Quando o trabalho demanda um contexto massivo, reserve as janelas maiores para os trechos mais interdependentes e mantenha apêndices fora do prompt principal.

Sistemas auxiliares ajudam. Bancos de dados vetoriais, pipelines de recuperação e embeddings permitem buscas precisas em vez de despejar corpora inteiros. Muitas equipes usam serviços gerenciados em Amazon Web Services ou Microsoft Azure para escalonamento elástico, enquanto outras usam hubs Hugging Face para modelos open-source complementares que pré-processam e comprimem contexto. A comunidade continua experimentando, como visto em matérias como resumos de colaborações open-source e iniciativas NVIDIA em frameworks abertos que influenciam a arquitetura do gerenciamento de contexto.

O orçamento de raciocínio é igualmente crítico. Muitos planos profissionais oferecem respostas “padrão” sem cadeia de pensamento pesada a menos que solicitado. Economize o raciocínio mais profundo para os poucos prompts que realmente exigem síntese multi-salto. Para redação rotineira, GPT‑4.1 mini ou o4‑mini podem lidar com 80–90% do volume a uma fração do custo e da cota. Equipes que codificam essa triagem — mini para estruturação, modelo avançado para polimento final — entregam mais rápido e gastam menos.

- 🧩 Fragmentar material de origem e resumir antes de escalar.

- 🧷 Use recuperação para trazer apenas os trechos relevantes.

- 🪙 Limite modo raciocínio a decisões com impacto mensurável.

- 🗂️ Armazene snippets reutilizáveis; evite reentrar textos longos padrão.

- 🧪 Faça pilotos de ideias para economizar tokens com recursos como guias de técnicas de fine-tuning para pré-processamento leve.

| Tamanho do Contexto 📏 | Aproxim. Palavras 📚 | Quando Usar ✅ | Dica para Economizar Tokens 💡 |

|---|---|---|---|

| 128K | ~96k palavras | Briefings, especificações, corpora de médio porte | Pré-resuma com modelo mini ✂️ |

| 200K | ~150k palavras | Conjuntos de políticas, revisões de múltiplos documentos | Use recuperação ao invés de colar bruto 📎 |

| 1M | ~750k palavras | Conjuntos massivos de pesquisa | Estagie conteúdo com embeddings 🧭 |

Insight chave: disciplina de tokens — não apenas upgrades de plano — entrega o maior salto em throughput sustentado e confiabilidade.

Escolhendo Entre ChatGPT, Claude, Gemini, Grok e Perplexity: Limites, Modos de Raciocínio e Compromissos

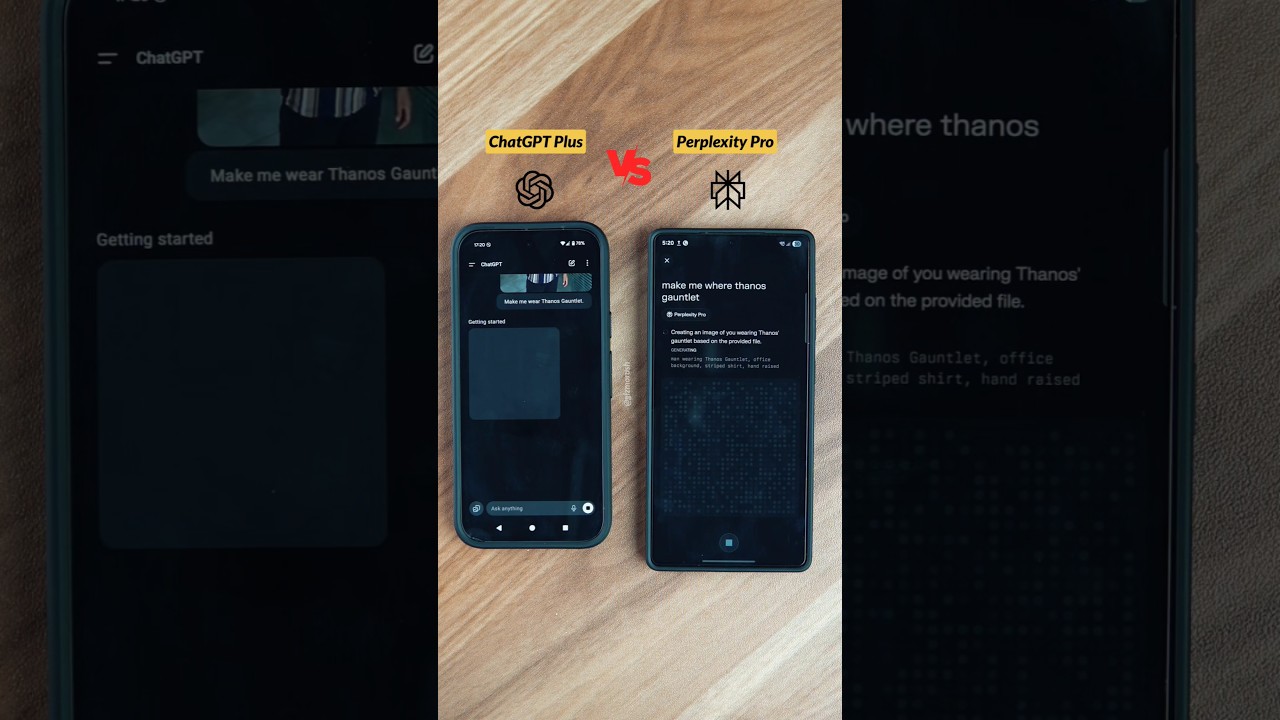

Os limites de taxa fazem sentido apenas no contexto do mercado mais amplo. Em 2025, as plataformas líderes convergem em padrões de design similares: planos em camadas, medidores visíveis e modos de raciocínio em planos pagos. Diferenças aparecem em tamanho de contexto, ritmos de reinício e onde cada plataforma se destaca. Por exemplo, ChatGPT enfatiza amplitude e integrações de ferramentas; Claude é forte em codificação e análise estruturada; Gemini lidera com contextos de 1M tokens; Grok tem foco próximo em streams em tempo real; e Perplexity otimiza para consultas com estilo de pesquisa.

A olho nu, planos Plus giram em torno de $20, e categorias premium entre $200–$300. Essa faixa mais alta mira profissionais que precisam de uso quase ilimitado ou raciocínio avançado. Cada plataforma define “ilimitado” cuidadosamente, reservando o direito de aplicar termos contra raspagem automatizada ou revenda de acesso. Guias comparativos — como comparações equilibradas de ChatGPT vs. Claude — ajudam equipes a escolher a combinação certa. Quem acompanha controle de custos também pode beneficiar-se de análises de estratégias de preço que explicam como tamanhos de janela e limites por modelo moldam orçamentos.

Abaixo está um resumo condensado e focado no uso que reflete o cenário do final de 2025 e serve como referência direcional. Sempre confirme os números mais recentes na documentação oficial antes de se comprometer.

| Plataforma 🌐 | Modelos Principais 🧠 | Limites Típicos ⏳ | Modo Raciocínio 🧩 | Janela de Contexto 📏 |

|---|---|---|---|---|

| ChatGPT | GPT‑5, GPT‑4.x | Plus ~3.000 msgs/semana; janelas por modelo | GPT‑5 Thinking ✔️ | 128K tokens |

| Claude | Sonnet 4.5, Opus | ~15–45 msgs/5h (Pro maior) | Extended Thinking ✔️ | 200K (1M beta) 🔬 |

| Gemini | Pro 2.5, Ultra | Cotas diárias; Ultra até 1M tokens/dia | Deep Think ✔️ | 1M tokens 🏆 |

| Grok | Grok 3/4 | ~10 req/2h (maior em pago) | Raciocínio padrão | 256K tokens |

| Perplexity | GPT‑4.1, Claude 4, o3‑pro | Cap diários Pro; Máx ~300+ Pro/dia | Deep Research ✔️ | Estendido (varia) 📎 |

O encaixe no ecossistema importa tanto quanto os limites puros. Organizações integradas em fluxos de trabalho Salesforce podem preferir ChatGPT para resumos e redação CRM. Equipes que dependem de pesquisas locais aceleradas pela NVIDIA podem adicionar pré-processamento local para reduzir tokens antes de acessar modelos na nuvem. Quem explora alternativas de treinamento econômicas às vezes revisa recursos como investigações de treinamento de baixo custo para estratégia de longo prazo. Enquanto isso, o trabalho de conhecimento em tempo real continua a crescer, com insights surfacing em cobertura de eventos sobre o futuro da IA.

- 🛠️ Escolha plataformas pela área de força (codificação, pesquisa, tempo real, suíte empresarial).

- 🧭 Combine tipos de reinício com o ritmo da equipe (intenso vs constante).

- 📈 Comece com Plus/Pro e teste cargas de trabalho antes de se comprometer com categorias de $200–$300.

- 🧳 Mantenha um modelo reserva pronto para quando os limites forem alcançados no meio do sprint.

- 🔗 Use referências como este guia de limites e estratégias para refinar um plano inicial.

Insight chave: escolha plataformas pelo ajuste, não pela hype; combine forças e padrões de reinício com o ritmo operacional da equipe para menos surpresas.

Projetando Fluxos de Trabalho Eficientes em Tokens e Tempo: Um Manual para Equipes e Empresas

Para empresas que vivem em documentos, código e reuniões, a diferença entre prosperar e ser engessado é o design do fluxo de trabalho. Um manual prático começa com triagem de carga, segue com correspondência de modelos e termina com automação consciente das regras. Considere uma empresa fictícia — HarborLine Financial — com cinco analistas e dois gerentes de produto. O trabalho abrange pesquisa, atualizações de políticas e resumos para partes interessadas. Sem planejamento, eles esbarram em limites em meados da semana; com um manual, entregam no prazo e dentro do orçamento.

Primeiro, codifique a árvore de decisão. Redação simples, reformatação e extração vão para modelos mini. Síntese estruturada vai para GPT‑4.1 ou GPT‑4.5. Só o raciocínio mais complexo — interpretação regulatória, modelagem de cenários — escala para GPT‑5 Thinking. Segundo, formalize a disciplina de tokens: incorpore recuperação para consultas pesadas em documentos, armazene snippets reutilizáveis e mantenha uma biblioteca compartilhada de “padrões de prompt”. Terceiro, configure automações conscientes das regras. Jobs agendados podem rotear para API quando apropriado, e a interface permanece para revisão humana. Quando a escala cresce, arquiteturas híbridas que usam Microsoft Azure, Google Cloud e Amazon Web Services garantem throughput, enquanto diversidade de fornecedores adiciona resiliência.

Quarto, habilite colaboração. Repositórios compartilhados de conversação previnem repetição de perguntas. Equipes que curam bases de conhecimento e distribuem “prompts de ouro” consistentemente superam aquelas que dependem de prompting ad hoc. Guias como recomendações para compartilhar conversas ajudam a estabelecer a norma. Quinto, adicione ferramentas especializadas conforme necessário: entrada por voz para captura rápida (veja configuração simples de voz), pesquisa multiagente para investigações profundas e runners de tarefas baseados em SDK. Para quem explora produtividade estilo companion, produtos como companions Atlas AI demonstram como assistentes podem orquestrar fluxos multi-etapas entre apps.

Por fim, monitore e itere. Painéis de uso destacam padrões de limites. Quando restrição temporária aparece por violação de políticas, existem caminhos de escalonamento — documente o incidente e contate o suporte com detalhes. Admins empresariais podem solicitar alterações de cota ou acesso controlado a modos de raciocínio em períodos críticos. Mantenha opções entre fornecedores à mão: Cohere para embeddings, IBM Watson para serviços alinhados ao domínio, e rotas open-source para pré-processamento, conforme enfatizado em destaques de colaboração open-source. Para contexto de modelos avançados, esteja atento às tendências de treinamento em matérias como explicadores da fase de treinamento do GPT‑5.

- 🧭 Construa uma matriz de triagem para rotear tarefas por complexidade e custo.

- 🧲 Adicione recuperação + armazenamento para reduzir prompts e acelerar execuções.

- 🔐 Respeite regras; mantenha o uso da interface human-driven e autenticado.

- 🧑🤝🧑 Padronize padrões de prompt e compartilhe-os em uma biblioteca de equipe.

- 📊 Acompanhe limites e rebaixamentos; ajuste o calendário e a mistura de modelos proativamente.

| Prática 🛠️ | Impacto 📈 | Resiliência a Limites 🧱 | Notas 📝 |

|---|---|---|---|

| Triagem de modelo | 30–60% menos chamadas premium | Alto | Reserve raciocínio para etapas críticas 🧠 |

| Recuperação + armazenamento | 40% de redução de tokens | Alto | Previne reprocessamento de documentos grandes ♻️ |

| Prompts compartilhados | Onboarding mais rápido | Médio | Consistência melhora a qualidade da saída 📚 |

| Nuvem híbrida | Margem de throughput | Alto | Azure/GCP/AWS oferecem elasticidade ☁️ |

Insight chave: um pequeno conjunto de hábitos de engenharia — triagem, recuperação, armazenamento e agendamento — transforma limites em regras previsíveis ao invés de bloqueios.

Resolvendo Erros de Limite de Taxa e Construindo Rotinas à Prova de Falhas

Mesmo com planejamento cuidadoso, erros de limite de taxa são inevitáveis durante picos ou lançamentos. O objetivo é recuperar instantaneamente sem derrubar o trabalho. Isso começa com entender a forma do erro. Quando um limite é alcançado, o modelo pode desaparecer do seletor, ou a interface silenciosamente cai para um modelo menor. Notificações normalmente comunicam o tempo de reinício; passar o mouse sobre o nome do modelo geralmente mostra quando a janela será atualizada. Se o padrão de uso violar um limite — como extração automatizada suspeita — restrições temporárias podem valer até o suporte revisar a atividade.

Rotinas de recuperação eficazes dependem de rebaixamentos em camadas. Se o GPT‑5 Thinking está no limite, mude para GPT‑4.1 para estruturação e deixe as revisões finais para a próxima janela de reinício. Agrupar reduz número de viagens: combine múltiplas sub-perguntas em um prompt estruturado em vez de enviar mensagens separadas. Para reuniões e captura de conteúdo, entradas de voz economizam tempo; guias de configuração como este tutorial de chat por voz podem reduzir atritos. Quando uma equipe inteira atinge limites, a aposta é mudar para tarefas de documentação, ajustar prompts ou esboçar diretrizes — trabalho produtivo que não consome janelas premium.

Às vezes, uma ferramenta diferente é a resposta certa. O Deep Research do Perplexity, o foco em tempo real do Grok, ou as janelas longas do Claude podem assumir a carga enquanto espera. Fora da interface, a API continua opção para pipelines programáticos, muitas vezes com cotas e preços diferentes. Muitas organizações implementam agentes de pré-processamento em infraestrutura acelerada pela NVIDIA e então enviam requisições concisas para cima, abordagem discutida em iniciativas de frameworks abertos. Em dúvida, equipes pequenas podem consultar guias como guias de casos de uso para escolher o desvio mais rápido.

Compartilhar lições aumenta resiliência. Retrospectivas de equipe capturam quais prompts rotineiramente atingem limites e como os rebaixamentos performaram. Documentação centralizada — combinada com conhecimento das peculiaridades dos modelos, como as janelas de 3 horas para GPT‑4.x — aperfeiçoa a execução. Para praticantes do dia a dia, revisões rápidas como este overview de limitações aceleram o diagnóstico. Para colaboração entre equipes, considere companions de IA que orquestram entregas simples; exemplos como assistentes estilo Atlas ilustram padrões de coordenação eficiente.

- 🚦 Mantenha uma matriz de rebaixamento para cada fluxo crítico.

- 📦 Agrupe micro-tarefas em um único prompt composto.

- 📝 Registre erros, limites e horários de reinício para análise de padrões.

- 🔄 Use ferramentas companion para preparar trabalho durante limites (esboço, rotulagem, preparo).

- 🔍 Verifique detalhes do plano contra um overview atualizado como este recurso estratégico.

| Problema 🚧 | Causa Provável 🧭 | Ação Imediata ⚡ | Próximo Passo 🧱 |

|---|---|---|---|

| Modelo oculto | Limite atingido para a janela | Mude para modelo mini ou alternativo | Deixe tarefa premium para reinício 🔁 |

| Queda de qualidade | Rebaixamento automático sob carga | Confira o selo do modelo | Reenvie etapa-chave após reinício 🎯 |

| Restrição temporária | Aplicação de regras | Contate suporte com logs | Revise ToU e ajuste pipeline 🔐 |

Insight chave: recuperação é um processo, não um evento — codifique os rebaixamentos, mantenha logs e sempre tenha uma rota alternativa.

{“@context”:”https://schema.org”,”@type”:”FAQPage”,”mainEntity”:[{“@type”:”Question”,”name”:”Quais são os limites mais importantes do ChatGPT para lembrar?”,”acceptedAnswer”:{“@type”:”Answer”,”text”:”Cotas no nível do plano (ex.: Plus ~3.000 mensagens/semana), janelas por modelo (ex.: GPTu20114/4.1 com limites móveis de 3u2011horas) e limites especiais de raciocínio (ex.: GPTu20115 Thinking ~200 mensagens/semana no Plus/Team) governam o uso diário. Cotas diárias aplicam-se a alguns modelos como o4u2011mini, e janelas móveis semanais reiniciam sete dias após a primeira mensagem no intervalo.”}},{“@type”:”Question”,”name”:”Como equipes evitam atingir limites em prazos críticos?”,”acceptedAnswer”:{“@type”:”Answer”,”text”:”Agende raciocínio premium no início da janela semanal, execute GPTu20114.x em sprints focados de 3u2011horas, e reserve modelos mini para redação volumosa. Use recuperação e armazenamento para reduzir prompts, e escalone o uso da equipe para evitar estrangulamento sincronizado. Mantenha uma matriz documentada de rebaixamentos e mude modelos proativamente ao se aproximar dos limites.”}},{“@type”:”Question”,”name”:”Plataformas de terceiros ajudam quando os limites do ChatGPT estão apertados?”,”acceptedAnswer”:{“@type”:”Answer”,”text”:”Sim. As janelas maiores do Claude, contextos de 1M tokens do Gemini, foco em tempo real do Grok, e fluxos de trabalho de pesquisa do Perplexity podem cobrir lacunas. Muitas organizações complementam ChatGPT com embeddings Cohere, serviços IBM Watson, ou pré-processamento open-source em infraestrutura acelerada pela NVIDIA.”}},{“@type”:”Question”,”name”:”Onde profissionais aprendem sobre preços e mudanças de plano?”,”acceptedAnswer”:{“@type”:”Answer”,”text”:”Consulte explicadores sintetizados como um overview do preço do ChatGPT em 2025 e artigos estratégicos analisando dinâmicas de preço do GPTu20114. Para evolução do modelo, leia explicadores da fase de treinamento do GPTu20115 e siga notas de lançamento dos fornecedores.”}},{“@type”:”Question”,”name”:”Vale a pena construir ferramentas internas para gerenciar limites?”,”acceptedAnswer”:{“@type”:”Answer”,”text”:”Sim. Painéis leves para acompanhar limites, bibliotecas compartilhadas de prompts valiosos e runners de tarefas baseados em SDK reduzem atrito e evitam retrabalho. Equipes frequentemente combinam Microsoft Azure, Google Cloud e Amazon Web Services com modelos OpenAI para padronizar agendamento, recuperação e armazenamento.”}}]}Quais são os limites mais importantes do ChatGPT para lembrar?

Cotas no nível do plano (ex.: Plus ~3.000 mensagens/semana), janelas por modelo (ex.: GPT‑4/4.1 com limites móveis de 3 horas), e limites especiais de raciocínio (ex.: GPT‑5 Thinking ~200 mensagens/semana no Plus/Team) governam o uso diário. Cotas diárias aplicam-se a alguns modelos como o4‑mini, e janelas móveis semanais reiniciam sete dias após a primeira mensagem no intervalo.

Como equipes evitam atingir limites em prazos críticos?

Agende raciocínio premium no início da janela semanal, execute GPT‑4.x em sprints focados de 3 horas, e reserve modelos mini para redação volumosa. Use recuperação e armazenamento para reduzir prompts, e escalone o uso da equipe para evitar estrangulamento sincronizado. Mantenha uma matriz documentada de rebaixamentos e mude modelos proativamente ao se aproximar dos limites.

Plataformas de terceiros ajudam quando os limites do ChatGPT estão apertados?

Sim. As janelas maiores do Claude, contextos de 1M tokens do Gemini, foco em tempo real do Grok, e fluxos de trabalho de pesquisa do Perplexity podem cobrir lacunas. Muitas organizações complementam ChatGPT com embeddings Cohere, serviços IBM Watson, ou pré-processamento open-source em infraestrutura acelerada pela NVIDIA.

Onde profissionais aprendem sobre preços e mudanças de plano?

Consulte explicadores sintetizados como um overview do preço do ChatGPT em 2025 e artigos estratégicos analisando dinâmicas de preço do GPT‑4. Para evolução do modelo, leia explicadores da fase de treinamento do GPT‑5 e siga notas de lançamento dos fornecedores.

Vale a pena construir ferramentas internas para gerenciar limites?

Sim. Painéis leves para acompanhar limites, bibliotecas compartilhadas de prompts valiosos e runners de tarefas baseados em SDK reduzem atrito e evitam retrabalho. Equipes frequentemente combinam Microsoft Azure, Google Cloud e Amazon Web Services com modelos OpenAI para padronizar agendamento, recuperação e armazenamento.

-

Open Ai1 week ago

Open Ai1 week agoDesbloqueando o Poder dos Plugins do ChatGPT: Melhore Sua Experiência em 2025

-

Open Ai6 days ago

Open Ai6 days agoDominando o Fine-Tuning do GPT: Um Guia para Customizar Eficazmente Seus Modelos em 2025

-

Open Ai7 days ago

Open Ai7 days agoComparando o ChatGPT da OpenAI, o Claude da Anthropic e o Bard do Google: Qual Ferramenta de IA Generativa Reinará Suprema em 2025?

-

Open Ai6 days ago

Open Ai6 days agoPreços do ChatGPT em 2025: Tudo o Que Você Precisa Saber Sobre Tarifas e Assinaturas

-

Open Ai7 days ago

Open Ai7 days agoO Fim Gradual dos Modelos GPT: O que os Usuários Podem Esperar em 2025

-

Modelos de IA6 days ago

Modelos de IA6 days agoModelos GPT-4: Como a Inteligência Artificial está Transformando 2025