Open Ai

Navigeren door ChatGPT’s limieten voor gebruik: essentiële inzichten voor optimaal gebruik in 2025

Begrip van ChatGPT Rate Limits in 2025: Plannen, Modellen en Waarom Ze Bestaan

De gebruiksbeperkingen van ChatGPT zijn geëvolueerd tot een gelaagd systeem dat betrouwbaarheid, eerlijkheid en kosten in balans houdt. In 2025 gelden limieten op meerdere niveaus: planbrede quota, per-model limieten, korte doorlopende vensters en functie-specifieke restricties. Dit ontwerp helpt OpenAI om consistente prestaties te leveren tijdens piekuren, terwijl geavanceerde mogelijkheden—zoals redeneermodi—beschikbaar blijven voor serieuze gebruikers. De praktische les is eenvoudig: teams die hun werkpatronen afstemmen op deze structuur vermijden onderbrekingen en houden de vaart erin.

Op planniveau zijn drie niveaus het belangrijkst voor conversatiegebruik: Free, Plus en Pro. Free biedt beperkte dagelijkse toegang en kortere sessies, terwijl Plus wekelijkse toeslagen introduceert die groot genoeg zijn voor langdurig individueel werk. Pro—vaak gebruikt door powerusers en kleine teams—neigt naar vrijwel onbeperkt algemeen gebruik, mits onder toezicht van misbruikbeveiligingen. Modellenlimieten blijven van toepassing, vooral voor frontier reasonering-modi. Bijvoorbeeld, GPT‑5 Thinking kan beperkt zijn tot een vastgesteld aantal berichten per week bij Plus of Team, terwijl standaard GPT‑5-gebruik vrijer schaalt. Gecombineerd met doorlopende 3-uur vensters voor modellen zoals GPT‑4 en GPT‑4.1, krijgen gebruikers voorspelbare toegang die gedurende de dag wordt gereset.

Waarom bestaan deze limieten? Twee redenen domineren. Ten eerste zijn de kosten van het bedienen van grote contextvensters en geavanceerd redeneren reëel—grotere promptlengtes en langere ketens verbruiken meer rekencapaciteit. Ten tweede vereisen kwaliteit en stabiliteit beveiligingen; ingewikkelde modi worden beperkt om beschikbaarheid te waarborgen voor legitiem, mens-in-de-lus werk. Dit is zichtbaar in het hele ecosysteem, van OpenAI tot Anthropic en Google DeepMind, en zelfs platforms als Perplexity of xAI’s Grok. Infrastructuurpartners zoals Microsoft Azure, Google Cloud en Amazon Web Services leveren de rekenkracht, maar beleidskeuzes zorgen voor soepele en voorspelbare ervaringen.

Voor professionals die een plan kiezen, is het lezen van de kleine lettertjes belangrijk. Planbrede Plus-quotums kunnen een getal tonen zoals 3.000 berichten per week voor typisch gebruik, terwijl GPT‑5‑Thinking nog steeds een kleinere 200 berichten per week handmatige-selectie-toelage kan hebben. Daarnaast kunnen creatieve modellen zoals GPT‑4.5 aparte wekelijkse limieten hebben, terwijl GPT‑4/4.1 vaak draaien op doorlopende 3-uur vensters. Deze lagen zijn niet tegenstrijdig; ze vullen elkaar aan om de belasting over modellen te balanceren. Wie prijsinformatie en tier-wijzigingen zoekt, kan analyses bekijken zoals een helder overzicht van ChatGPT-prijzen in 2025 of vergelijken met concurrerende scherpe kanten in discussies over GPT‑4 prijsstrategieën.

Team- en Enterprise-ontgrendelingen volgen vergelijkbare logica. “Onbeperkt” betekent doorgaans geen praktische limiet voor normaal menselijk gebruik, maar nog steeds onder beveiligingen. Dit omvat verboden op het delen van inloggegevens of het gebruiken van UI-toegang om externe, geautomatiseerde diensten aan te sturen. Enterprises kunnen quota-verhogingen aanvragen en admins zien meestal betere monitoringregelingen dan individuele gebruikers.

Praktische uitkomsten zijn gemakkelijk te voorspellen: creatieve workloads die pieken, zoals campagnelanceringen, profiteren van wekelijkse limieten die korte, intense bursts toestaan. Stabiele dagelijkse onderzoeksworkflows passen beter bij dagelijkse of doorlopende vensters, die het gebruik gelijkmatig verspreiden. Hybride opstellingen—mix van UI-sessies voor ideeënvorming met API-workflows voor productie—zijn gangbaar. Veel teams combineren ChatGPT met modellen die draaien op Microsoft Azure, Google Cloud of Amazon Web Services, en voegen eventueel alternatieven toe van Cohere of IBM Watson, afhankelijk van compliance- en datalocatievereisten.

- 🧠 Gebruik redeneermodi voor hoog-risico analyses; schakel over naar mini-varianten voor volumetaken.

- 🔁 Plan rond doorlopende 3-uur vensters voor GPT‑4/4.1 om de vaart erin te houden.

- 📅 Benut wekelijkse limieten voor piekprojecten zoals audits of migraties.

- 📦 Cache belangrijke output lokaal om herhaald draaien van lange prompts te vermijden.

- 🧰 Verken SDK’s en automatisering, zoals besproken in dit overzicht van de nieuwe apps SDK, om repetitieve taken te stroomlijnen.

| Plan ⚙️ | Typische Toegang 🧭 | Opvallende Limieten ⏳ | Geschikt Voor 🎯 |

|---|---|---|---|

| Free | GPT‑5 (beperkt), basisgereedschappen | Dagelijkse berichten begrensd; kortere sessies | Lichte verkenning, snelle checks |

| Plus | GPT‑5, GPT‑4.x, DALL·E | ~3.000 berichten/week plan-niveau; modelvensters gelden | Individuele professionals, steady werk |

| Pro | GPT‑5 + o1/o3 toegangspatronen | Bijna onbeperkt onder beveiligingen | Powergebruikers, kleine teams |

Belangrijk inzicht: stem werkpatronen af op de plan + model-combinatie, en reserveer premium redenering voor waardevolle stappen om quota te rekken zonder kwaliteit te verliezen.

Wekelijkse vs Dagelijkse Limieten, Doorlopende Vensters en Resetten: Tijdsstrategieën die Onderbrekingen Voorkomen

Reset-logica is waar veel teams versnellen of vastlopen. Drie tijdregimes domineren: wekelijkse limieten, dagelijkse limieten en doorlopende 3-uur vensters. Wekelijkse limieten—veelvuldig gebruikt door ChatGPT en Anthropic—voorkeuren piekwerk. Teams kunnen hard pushen tijdens een lanceerweek en daarna verslappen, alles binnen een voorspelbare toeslag. Dagelijkse limieten, gezien op platforms als Perplexity en sommige Gemini-configuraties, spreiden het gebruik over de dagen, wat geschikt is voor stabiel onderzoek of contentpijplijnen. Doorlopende 3-uur vensters (vaak bij GPT‑4/4.1) stimuleren korte sprints en breken marathonsessies op in behapbare stukken.

Resetmomenten zijn belangrijk. Doorlopende vensters tellen terug vanuit de laatste interactie; dagelijkse limieten resetten meestal om 00:00 UTC; wekelijkse limieten resetten doorgaans zeven dagen na het eerste bericht in het venster. Wie workflows ontwerpt, moet deze als planningsbouwstenen zien. Bijvoorbeeld, een contentteam plant “2-uur GPT‑4o sprints” ’s ochtends en “GPT‑5 Thinking bursts” laat op de middag om aparte vensters te benutten. Voor brede strategie over plannen en modellen kunnen praktische aanbevelingen in deze strategiegerichte gids teams helpen voorspelbare ritmes op te bouwen.

Een terugkerend patroon springt in het oog: gebruikers bereiken een per-model limiet, de UI valt automatisch terug naar een mini model en kwaliteit daalt zonder waarschuwing. De oplossing is om je dag te plannen met de limiet in het achterhoofd. Als zwaar GPT‑5‑Thinking-gebruik vereist is die week, voorkom die taken en parkeer routinematig schrijven op een mini model of GPT‑4.1 mini. Worden codeherzieningen of multi-bestandsanalyses te veel, dan spreidt roteren tussen modellen de belasting terwijl kwaliteit op belangrijke momenten behouden blijft. Dit is een klassiek orkestratieprobleem voor werklasten, geen simpel “gebruikslimiet” probleem.

Teams op schaal moeten ook resets coördineren tussen leden. Als vijf analisten tegelijkertijd een limiet bereiken, stokt het team. Verspreide starttijden en modeldiversiteit voorkomen gesynchroniseerde vertragingen. Tools van Salesforce en interne PM-dashboards kunnen geplande gebruiksvensters visualiseren, terwijl back-end observatie op Microsoft Azure of Google Cloud API-bursts volgt. De bredere AI-gemeenschap drijft kennis vooruit—evenementen zoals NVIDIA GTC discussies over de toekomst van AI belichten vaak plannings- en doorvoer-engineeringlessen die direct toepasbaar zijn op LLM-operaties.

- 🗓️ Plan doorlopende vensters als sprintblokken om onverwachte terugvallen te vermijden.

- 🧮 Reserveer vroeg in de week een redeneermodi-budget voor kritieke beslissingen.

- 👥 Verspreid teamgebruik om gesynchroniseerde beperkingen te voorkomen.

- 🔔 Gebruik herinneringen bij het naderen van bekende limieten; schakel proactief over naar een mini model.

- 🧭 Bekijk plangegevens in deze prijsuitleg om tijdsbudgetten af te stemmen met tier-niveaus.

| Reset Type ⏱️ | Hoe Het Werkt 🔍 | Typisch Voorbeeld 📌 | Planningstip 🧭 |

|---|---|---|---|

| Doorlopend 3-uur | Venster telt terug vanaf laatste bericht | GPT‑4/4.1: 80 berichten/3u | Voer gerichte sprints uit; pauzeer om te resetten 🔁 |

| Dagelijks | Reset om 00:00 UTC | o4‑mini: 300/dag | Verspreid taken over dagen 📅 |

| Wekelijks (doorlopend) | Reset zeven dagen na eerste bericht | GPT‑5 Thinking: ~200/week | Laad waardevol werk vroeg in het venster 🚀 |

Belangrijk inzicht: behandel resets als kalanderbeperkingen—bij juiste timing worden limieten workflowritmes, geen blokkades.

Contextvenster-economie en Tokenbudgettering: Quota Rekken Zonder Kwaliteitsverlies

Grote contextvensters zijn krachtig—en duur in tokentermen. Een 128K-token context (typisch voor ChatGPT’s GPT‑5 en GPT‑4.1 tiers) bevat ongeveer 96.000 woorden, terwijl 200K voor Claude ongeveer 150.000 woorden aankan. Gemini’s 1M-token context biedt ruimte voor circa 750.000 woorden. Deze capaciteiten verleiden gebruikers om hele wiki-pagina’s te plakken, maar elke extra pagina verbruikt quota en verhoogt latentie. De slimmere tactiek is om te chunk-en, indexeren en samenvatten vóór gebruik van zware redenering. Tokenbewuste workflows verhogen doorvoer zonder uitkomst te verslechteren.

Denk aan een onderzoeksteam dat compliance-documentatie herbouwt. In plaats van volledige PDF’s in één bericht te laden, splitsen ze content in thematische pakketten, genereren samengevatte notities met een mini model, en escaleren de verfijnde samenvattingen pas naar GPT‑5 Thinking voor de finale auditlogica. Deze tweefasige aanpak verlaagt tokenverbruik maar behoudt de analytische strengheid. Wanneer werk een enorme context vereist, reserveer dan de grootste vensters voor de onderling meest afhankelijke passages en houd bijlagen buiten de primaire prompt.

Zijsystemen helpen. Vectordatabases, retrieval-pijplijnen en embeddings laten precieze zoekacties toe in plaats van hele corpora te dumpen. Veel teams vertrouwen op managed services op Amazon Web Services of Microsoft Azure voor elastische schaal, terwijl anderen Hugging Face hubs gebruiken voor aanleverende open-source modellen om context te pre-processen en comprimeren. De community blijft experimenteren, zoals te zien in stukken als open-source samenwerkingsoverzichten en NVIDIA’s initiatieven op open frameworks die beïnvloeden hoe contextbeheer wordt opgebouwd.

Redeneerbudget is net zo cruciaal. Veel professionele plannen bieden “standaard” antwoorden zonder zware chain-of-thought tenzij expliciet gevraagd. Bewaar het diepste redeneren voor de enkele prompts die echt multi-hop synthese vereisen. Voor routine drafting kunnen GPT‑4.1 mini of o4‑mini 80–90% van het volume aan, tegen een fractie van kosten en quota. Teams die deze triage codificeren—mini voor scaffolding, frontier model voor finale afwerking—leveren sneller en besteden minder.

- 🧩 Chunk bronmateriaal en samenvatten voor escalatie.

- 🧷 Gebruik retrieval om alleen de relevante passages binnen te halen.

- 🪙 Beperk redeneermodi tot beslissingen met meetbare impact.

- 🗂️ Cache herbruikbare fragmenten; voorkom herhaald invoeren van lange standaardtekst.

- 🧪 Test tokensparende ideeën met bronnen als fine-tuning techniekgidsen voor lichte pre-processing.

| Contextgrootte 📏 | Ongeveer Woorden 📚 | Wanneer Gebruiken ✅ | Tokenbesparingstip 💡 |

|---|---|---|---|

| 128K | ~96k woorden | Brieven, specificaties, middelgrote corpora | Vooraf samenvatten met mini model ✂️ |

| 200K | ~150k woorden | Beleidssets, multi-doc reviews | Gebruik retrieval in plaats van ruwe plakken 📎 |

| 1M | ~750k woorden | Enorme onderzoeksets | Faseer content met embeddings 🧭 |

Belangrijk inzicht: tokendiscipline—niet alleen planafwegingen—levert de grootste sprong in duurzame doorvoer en betrouwbaarheid.

Kiezen Tussen ChatGPT, Claude, Gemini, Grok en Perplexity: Limieten, Redeneermodi en Afwegingen

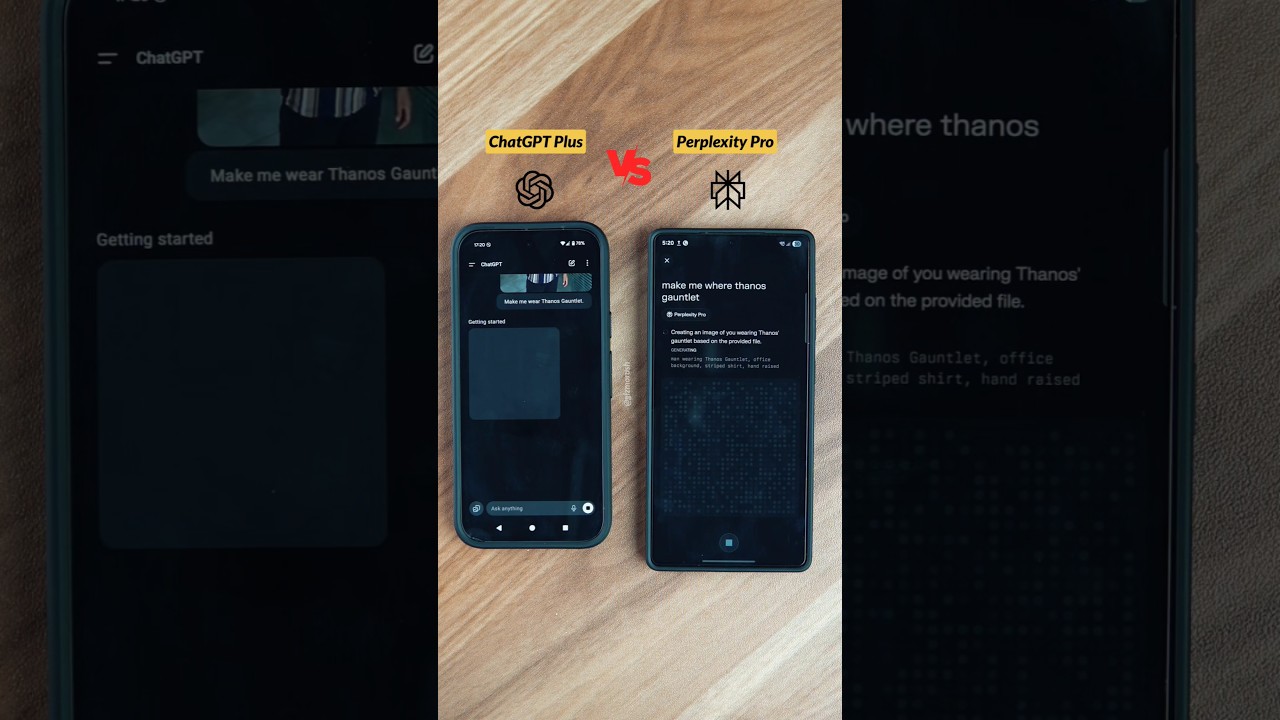

Rate limits maken alleen zin in de context van de bredere markt. In 2025 convergeren de toonaangevende platforms naar soortgelijke ontwerpprincipes: gelaagde plannen, zichtbare meters en redeneermodi binnen betaalde tiers. Verschillen ontstaan in contextgrootte, reset-ritmes en waar elk platform uitblinkt. ChatGPT benadrukt bijvoorbeeld breedte en toolintegraties; Claude blinkt uit in codering en gestructureerde analyse; Gemini leidt op 1M-token contexten; Grok is sterk in realtime streams; en Perplexity optimaliseert voor onderzoeksvragen.

In één oogopslag clusteren Plus-tiers rond $20, en premium tiers rond $200–$300. Die hogere klasse richt zich op professionals die bijna onbeperkt gebruik of frontier redeneermogelijkheden nodig hebben. Elk platform definieert “onbeperkt” zorgvuldig, met het recht om regels tegen geautomatiseerd scrapen of doorverkopen af te dwingen. Vergelijkende richtlijnen—zoals evenwichtige vergelijkingen van ChatGPT en Claude—helpen teams bij het vinden van de juiste combinatie. Wie kosten wil beheersen profiteert ook van prijstrategie-analyses die uitleggen hoe venstergroottes en per-model limieten budgetten bepalen.

Hieronder een beknopte, gebruiksgerichte momentopname die het eind-2025 beeld reflecteert en dient als richtlijn. Bevestig altijd de meest actuele cijfers in officiële documenten vóór je een keuze maakt.

| Platform 🌐 | Sleutelmodellen 🧠 | Typische Limieten ⏳ | Redeneermodus 🧩 | Contextvenster 📏 |

|---|---|---|---|---|

| ChatGPT | GPT‑5, GPT‑4.x | Plus ~3.000 berichten/week; per-model vensters | GPT‑5 Thinking ✔️ | 128K tokens |

| Claude | Sonnet 4.5, Opus | ~15–45 berichten/5u (Pro hoger) | Uitgebreide Thinking ✔️ | 200K (1M bèta) 🔬 |

| Gemini | Pro 2.5, Ultra | Dagelijkse quota; Ultra tot 1M tokens/dag | Diep Denken ✔️ | 1M tokens 🏆 |

| Grok | Grok 3/4 | ~10 verzoeken/2u (hoger bij betaald) | Standaard redenering | 256K tokens |

| Perplexity | GPT‑4.1, Claude 4, o3‑pro | Pro/dag limieten; max ~300+ Pro/dag | Diep Onderzoek ✔️ | Uitgebreid (variabel) 📎 |

Ecosysteemfit is net zo belangrijk als ruwe limieten. Organisaties die diep in Salesforce-workflows zitten, geven mogelijk de voorkeur aan ChatGPT voor samenvattingen en CRM-schrijven. Teams die vertrouwen op NVIDIA-versnelde on-premises research, kunnen lokale pre-processing toevoegen om tokens te reduceren vóór cloud-modellen. Wie kosten-efficiënte training onderzoekt, bekijkt soms bronnen als lage-kosten training-onderzoeken voor langetermijnstrategieën. Ondertussen breidt realtime kenniswerk uit, met inzichten in eventverslagen over de AI-toekomst.

- 🛠️ Kies platforms op sterktegebied (coderen, onderzoek, realtime, enterprise suite).

- 🧭 Stem resettypes af op teamritme (piekgewijs vs. steady).

- 📈 Begin met Plus/Pro en test workloads vóór je overstapt op $200–$300 tiers.

- 🧳 Houd een backup-model klaar bij limietoverschrijding midden in een sprint.

- 🔗 Gebruik referenties als deze limieten-en-strategieën gids om een initiëel plan te verfijnen.

Belangrijk inzicht: kies platforms op basis van fit, niet hype; koppel sterktes en resetpatronen aan de bedrijfsvoering van het team voor minder verrassingen.

Token- en Tijdsefficiënte Workflows Ontwerpen: Een Playbook voor Teams en Enterprises

Voor bedrijven die leven in documenten, code en vergaderingen, is het verschil tussen bloeien en stagneren workflowontwerp. Een praktisch playbook begint met werkbelastingtriage, gaat verder met model-matching en eindigt met beveiligingsbewuste automatisering. Denk aan een fictief bedrijf—HarborLine Financial—met vijf analisten en twee productmanagers. Hun werk strekt zich uit over onderzoek, beleidsupdates en stakeholder-samenvattingen. Zonder planning botsen ze halverwege de week tegen limieten; met een playbook leveren ze op tijd en binnen budget.

Eerst codificeer je de beslisboom. Eenvoudig schrijven, herformatteren en extractie gaan naar mini modellen. Gestructureerde synthese verschuift naar GPT‑4.1 of GPT‑4.5. Alleen de lastigste redeneringen—regelgevende interpretatie, scenario-modellering—escaleren naar GPT‑5 Thinking. Ten tweede, formaliseer tokendiscipline: embed retrieval voor documentenintensieve queries, cache herbruikbare snippets en onderhoud een gedeelde bibliotheek van “promptpatronen.” Ten derde, stel beveiligingsbewuste automatiseringen in. Geplande taken kunnen naar de API worden gestuurd waar passend, en de UI blijft voor mens-in-the-loop review. Bij schaalvergroting zorgen hybride architecturen met Microsoft Azure, Google Cloud en Amazon Web Services voor doorvoer, terwijl leveranciersdiversiteit veerkracht toevoegt.

Vierde, stimuleer samenwerking. Gedeelde gesprek-repositories voorkomen herhaalde vragen. Teams die een kennisbasis cureren en “gouden prompts” verspreiden, presteren consequent beter dan teams die adhoc prompten. Gidsen zoals aanbevelingen voor het delen van gesprekken helpen normen te stellen. Vijfde, voeg gespecialiseerde tools toe waar nodig: spraakinvoer voor snelle vastlegging (zie een eenvoudige spraaksetup), multi-agent onderzoek voor diepere duiken, en SDK-gestuurde taakuitvoerders. Voor wie gezelachtige productiviteit onderzoekt, tonen producten als Atlas AI compagnons hoe assistenten multi-stap flows over apps kunnen orkestreren.

Ten slotte monitor en verbeter. Gebruikdashboards belichten limietpatronen. Bij tijdelijke restricties vanwege beleidsinbreuken zijn escalatieroutes beschikbaar—documenteer incidenten en neem contact op met support met details. Enterprise admins kunnen quotaveranderingen aanvragen of gecontroleerde toegang tot redeneermodi tijdens cruciale periodes. Houd cross-vendor opties paraat: Cohere voor embeddings, IBM Watson voor domeinspecifieke services, en open-source routes voor pre-processing, zoals benadrukt in open-source samenwerkingsthema’s. Blijf de trainingstrends volgen voor frontier-modellen via stukken als GPT‑5 trainingsfase-uitleg.

- 🧭 Bouw een triagematrix om taken te routeren naar complexiteit en kosten.

- 🧲 Voeg retrieval + caching toe om prompts te verkleinen en runs te versnellen.

- 🔐 Respecteer beveiligingen; houd UI-gebruik mensgestuurd en geverifieerd.

- 🧑🤝🧑 Standaardiseer promptpatronen en deel ze in een teambibliotheek.

- 📊 Volg limieten en terugvallen; pas kalender en modelmix proactief aan.

| Praktijk 🛠️ | Impact 📈 | Limietbestendigheid 🧱 | Notities 📝 |

|---|---|---|---|

| Modeltriage | 30–60% minder premium oproepen | Hoog | Reserveer redenering voor kritieke stappen 🧠 |

| Retrieval + caching | 40% tokenreductie | Hoog | Voorkomt herverwerking van grote documenten ♻️ |

| Gedeelde prompts | Snellere onboarding | Middel | Consistentie verbetert outputkwaliteit 📚 |

| Hybride cloud | Doorvoer-kapaciteit | Hoog | Azure/GCP/AWS bieden elasticiteit ☁️ |

Belangrijk inzicht: een klein stel engineeringgewoonten—triage, retrieval, caching en planning—verandert limieten in voorspelbare beveiligingen in plaats van blokkers.

Probleemoplossing van Rate Limit-fouten en Fail-Safe Routines Bouwen

Zelfs met zorgvuldige planning zijn rate limit-fouten onvermijdelijk bij pieken of lanceringen. Het doel is direct herstellen zonder werk te verstoren. Dat begint met inzicht in de foutvorm. Wanneer een limiet bereikt is, verdwijnt het model uit de kieser, of valt de UI stilzwijgend terug naar een kleiner model. Meldingen geven doorgaans reset-tijd aan; hovering over de modelnaam toont vaak het vernieuwmoment van het venster. Bij schending van een beveiliging—zoals vermoedelijke geautomatiseerde extractie—kunnen tijdelijke restricties gelden totdat support de activiteit beoordeelt.

Effectieve herstelroutines vertrouwen op gelaagde terugvallen. Is GPT‑5 Thinking gelimiteerd, dan schakel je over naar GPT‑4.1 voor scaffolding en plan je de laatste checks voor het volgende resetvenster. Batching vermindert het aantal heen-en-weer berichten: combineer meerdere deelvragen in een gestructureerde prompt in plaats van aparte berichten te sturen. Voor vergaderingen en content-captatie bespaart spraakinvoer tijd; setupgidsen zoals deze walkthrough voor spraakchat verminderen wrijving. Wanneer een heel team limieten bereikt, schakel dan over naar documentatietaken, verfijn prompts of stel richtlijnen op—productief werk dat geen premium vensters belast.

Soms is een ander hulpmiddel de juiste keuze. Perplexity’s Diep Onderzoek, Grok’s realtime focus of Claude’s lange vensters kunnen de last opvangen tijdens wachtperiodes. Buiten de UI is de API een optie voor programmatische pijplijnen, vaak met andere quota en prijzen. Veel organisaties zetten pre-processing agenten in op NVIDIA-versnelde infrastructuur en sturen compacte verzoeken naar upstream, zoals besproken in open framework-initiatieven. In geval van twijfel kunnen kleine teams primers raadplegen zoals case-by-case gebruiksgidsen om de snelste omweg te kiezen.

Het delen van lessen verhoogt veerkracht. Team-retrospectieven leggen vast welke prompts regelmatig limieten raken en hoe terugvallen werkten. Gecentraliseerde documentatie—gecombineerd met kennis van modelsonderheden, zoals de 3-uur vensters voor GPT‑4.x—verstevigt uitvoering. Voor dagelijks gebruik versnellen snelle opfrissers zoals deze limitations-overzicht het probleemoplossen. Voor teamoverschrijdende samenwerking kunnen AI-assistenten helpen die eenvoudige overdrachten orkestreren; voorbeelden als Atlas-stijl assistants tonen efficiënte coördinatiepatronen.

- 🚦 Houd een fallback matrix bij voor elke kritieke workflow.

- 📦 Batch microtaken in één samengestelde prompt.

- 📝 Log fouten, limieten en resetmomenten voor patroonanalyse.

- 🔄 Gebruik begeleidende tools om werk te faseren tijdens limieten (schrijven, labelen, voorbereiden).

- 🔍 Controleer plangegevens tegen actuele overzichten zoals deze strategiebron.

| Probleem 🚧 | Waarschijnlijke Oorzaak 🧭 | Directe Actie ⚡ | Volgende Stap 🧱 |

|---|---|---|---|

| Model verborgen | Limiet bereikt voor venster | Schakel over naar mini of alternatief model | Plan premium taak voor reset 🔁 |

| Kwaliteitsdaling | Automatisch terugvallen onder belasting | Controleer modelbadge | Herindienen van cruciale stap na reset 🎯 |

| Tijdelijke restrictie | Beveiligingshandhaving | Contacteer support met logs | Herzie ToU en pas pijplijn aan 🔐 |

Belangrijk inzicht: herstel is een proces, geen gebeurtenis—codificeer terugvallen, houd logs bij en heb altijd een alternatieve route klaar.

{“@context”:”https://schema.org”,”@type”:”FAQPage”,”mainEntity”:[{“@type”:”Question”,”name”:”Wat zijn de belangrijkste ChatGPT-limieten om te onthouden?”,”acceptedAnswer”:{“@type”:”Answer”,”text”:”Plan-niveau quota (zoals Plus ~3.000 berichten/week), per-model vensters (zoals GPT‑4/4.1 met doorlopende 3-uur limieten), en speciale redeneerlijnen (zoals GPT‑5 Thinking ~200 berichten/week op Plus/Team) regelen het dagelijkse gebruik. Dagelijkse quota gelden voor sommige modellen zoals o4‑mini, en doorlopende wekelijkse vensters resetten zeven dagen na het eerste bericht in die periode.”}},{“@type”:”Question”,”name”:”Hoe kunnen teams voorkomen dat ze limieten raken bij kritieke deadlines?”,”acceptedAnswer”:{“@type”:”Answer”,”text”:”Plan premium redeneringen vroeg in het wekelijkse venster, laat GPT‑4.x in strakke 3-uur sprints draaien en reserveer mini-modellen voor volumetaken. Gebruik retrieval en caching om prompts te verkleinen, en spreid teamgebruik om gesynchroniseerde beperkingen te voorkomen. Houd een gedocumenteerde fallback-matrix aan en schakel proactief modellen om bij naderen van limieten.”}},{“@type”:”Question”,”name”:”Helpen derde partij-platforms bij strakke ChatGPT-limieten?”,”acceptedAnswer”:{“@type”:”Answer”,”text”:”Ja. Claude’s grotere vensters, Gemini’s 1M-token contexten, Grok’s realtime focus, en Perplexity’s onderzoeksworkflows kunnen hiaten opvangen. Veel organisaties combineren ChatGPT met Cohere embeddings, IBM Watson-diensten, of open-source pre-processing op NVIDIA-versnelde infrastructuur.”}},{“@type”:”Question”,”name”:”Waar kunnen professionals leren over prijs- en planwijzigingen?”,”acceptedAnswer”:{“@type”:”Answer”,”text”:”Raadpleeg samengestelde uitleg zoals een overzicht van ChatGPT-prijzen in 2025 en strategie-artikelen die GPT‑4 prijsdynamieken analyseren. Voor modelontwikkeling, lees uitleg over de GPT‑5 trainingsfase en volg vendor release notes.”}},{“@type”:”Question”,”name”:”Is het de moeite waard om interne tools te bouwen voor het beheren van limieten?”,”acceptedAnswer”:{“@type”:”Answer”,”text”:”Ja. Lichtgewicht dashboards om limieten te volgen, gedeelde bibliotheken van gouden prompts, en SDK-gestuurde taakuitvoerders verminderen frictie en voorkomen herwerk. Teams combineren vaak Microsoft Azure, Google Cloud en Amazon Web Services met OpenAI-modellen om planning, retrieval en caching te standaardiseren.”}}]}Wat zijn de belangrijkste ChatGPT-limieten om te onthouden?

Plan-niveau quota (zoals Plus ~3.000 berichten/week), per-model vensters (zoals GPT‑4/4.1 met doorlopende 3-uur limieten), en speciale redeneerlijnen (zoals GPT‑5 Thinking ~200 berichten/week op Plus/Team) regelen het dagelijkse gebruik. Dagelijkse quota gelden voor sommige modellen zoals o4‑mini, en doorlopende wekelijkse vensters resetten zeven dagen na het eerste bericht in die periode.

Hoe kunnen teams voorkomen dat ze limieten raken bij kritieke deadlines?

Plan premium redeneringen vroeg in het wekelijkse venster, laat GPT‑4.x in strakke 3-uur sprints draaien en reserveer mini-modellen voor volumetaken. Gebruik retrieval en caching om prompts te verkleinen, en spreid teamgebruik om gesynchroniseerde beperkingen te voorkomen. Houd een gedocumenteerde fallback-matrix aan en schakel proactief modellen om bij naderen van limieten.

Helpen derde partij-platforms bij strakke ChatGPT-limieten?

Ja. Claude’s grotere vensters, Gemini’s 1M-token contexten, Grok’s realtime focus, en Perplexity’s onderzoeksworkflows kunnen hiaten opvangen. Veel organisaties combineren ChatGPT met Cohere embeddings, IBM Watson-diensten, of open-source pre-processing op NVIDIA-versnelde infrastructuur.

Waar kunnen professionals leren over prijs- en planwijzigingen?

Raadpleeg samengestelde uitleg zoals een overzicht van ChatGPT-prijzen in 2025 en strategie-artikelen die GPT‑4 prijsdynamieken analyseren. Voor modelontwikkeling, lees uitleg over de GPT‑5 trainingsfase en volg vendor release notes.

Is het de moeite waard om interne tools te bouwen voor het beheren van limieten?

Ja. Lichtgewicht dashboards om limieten te volgen, gedeelde bibliotheken van gouden prompts, en SDK-gestuurde taakuitvoerders verminderen frictie en voorkomen herwerk. Teams combineren vaak Microsoft Azure, Google Cloud en Amazon Web Services met OpenAI-modellen om planning, retrieval en caching te standaardiseren.

-

Ongecategoriseerd4 days ago

Ongecategoriseerd4 days agohoe je afscheid zegt: zachte manieren om om te gaan met vaarwel en eindes

-

Open Ai1 week ago

Open Ai1 week agoDe Kracht van ChatGPT-plugins Ontsluiten: Verbeter je Ervaring in 2025

-

Uncategorized2 weeks ago

Uncategorized2 weeks agoOntdek het oak and ember-menu van 2025: wat te verwachten en topgerechten om te proberen

-

Open Ai6 days ago

Open Ai6 days agoMeesterschap in GPT Fine-Tuning: Een Gids voor het Effectief Aanpassen van Uw Modellen in 2025

-

Open Ai1 week ago

Open Ai1 week agoChatGPT in 2025: De belangrijkste beperkingen en strategieën om deze te overwinnen verkend

-

Tools6 days ago

Tools6 days agoChatGPT Typefouten: Hoe Veelvoorkomende Fouten te Herstellen en te Voorkomen