Open Ai

Orientarsi nei Limiti di Velocità di ChatGPT: Informazioni Essenziali per un Uso Ottimale nel 2025

Comprendere i Limiti di Velocità di ChatGPT nel 2025: Piani, Modelli e Perché Esistono

I controlli d’uso di ChatGPT si sono evoluti in un sistema stratificato che bilancia affidabilità, equità e costi. Nel 2025, i limiti operano a più livelli: quote a livello di piano, limiti per modello, finestre temporali brevi rotanti e restrizioni specifiche per funzionalità. Questo design aiuta OpenAI a offrire prestazioni costanti durante le ore di punta mantenendo disponibili capacità avanzate—come le modalità di ragionamento—per utenti seri. La conclusione pratica è semplice: i team che mappano i loro schemi di carico di lavoro su questa struttura evitano interruzioni e mantengono alta la velocità.

A livello di piano, tre livelli sono i più importanti per l’uso conversazionale: Free, Plus e Pro. Free offre accesso giornaliero limitato e sessioni più brevi, mentre Plus introduce assegni settimanali abbastanza grandi per un lavoro individuale sostenuto. Pro—spesso usato da utenti intensivi e piccoli team—tende verso un uso generale praticamente illimitato, soggetto a restrizioni contro abusi. I limiti a livello di modello si applicano ancora, specialmente per le modalità di ragionamento di frontiera. Per esempio, GPT‑5 Thinking può essere limitato a un numero definito di messaggi ogni settimana su Plus o Team, mentre l’uso standard di GPT‑5 si scala più liberamente. Quando combinato con finestre rotanti di 3 ore per modelli come GPT‑4 e GPT‑4.1, gli utenti ottengono un accesso prevedibile che si resetta durante la giornata.

Perché esistono questi limiti? Due ragioni dominano. Primo, l’economia di servire finestre di contesto ampie e ragionamenti avanzati è reale: prompt più grandi e catene più lunghe consumano più risorse di calcolo. Secondo, qualità e stabilità richiedono restrizioni; le modalità sofisticate sono vincolate per garantire disponibilità per lavori legittimi con intervento umano. Questo è visibile in tutto l’ecosistema, da OpenAI ad Anthropic e Google DeepMind, e anche su piattaforme come Perplexity o Grok di xAI. Partners infrastrutturali come Microsoft Azure, Google Cloud e Amazon Web Services forniscono la potenza, ma le scelte di policy mantengono le esperienze fluide e prevedibili.

Per i professionisti che scelgono un piano, leggere il contratto è importante. Le quote a livello di piano Plus possono indicare un valore come 3.000 messaggi a settimana per uso tipico, ma GPT‑5‑Thinking potrebbe comunque mostrare un’allocazione manuale più piccola di 200 messaggi a settimana. Parallelamente, modelli creativi come GPT‑4.5 possono avere cap settimanali separati, mentre GPT‑4/4.1 spesso operano su finestre rotanti di 3 ore. Questi livelli non sono contraddittori; si completano per bilanciare il carico tra modelli. Chi cerca contesto sui prezzi e cambi di livello può consultare analisi come una chiara panoramica dei prezzi di ChatGPT nel 2025 o confrontare con angoli competitivi in discussioni sulle strategie di prezzo di GPT‑4.

Sblocchi Team ed Enterprise seguono una logica simile. “Illimitato” generalmente significa nessun tetto pratico per uso umano normale ma sempre sotto restrizioni. Ciò include divieti di condivisione delle credenziali o di usare l’accesso UI per alimentare servizi esterni automatizzati. Le aziende possono richiedere potenziamenti di quota, e gli amministratori spesso dispongono di controlli di monitoraggio migliori rispetto agli utenti singoli.

I risultati pratici sono facili da prevedere: carichi creativi che impennano, come lanci di campagne, beneficiano di limiti settimanali che permettono burst brevi e intensi. Flussi di lavoro di ricerca stabili giornalieri si allineano meglio con limiti giornalieri o finestre rotanti, che distribuiscono l’uso in modo uniforme. Configurazioni ibride—mescolando sessioni UI per ideazione con workflow API per produzione—sono comuni. Molti team integrano ChatGPT con modelli distribuiti su Microsoft Azure, Google Cloud o Amazon Web Services, e opzionalmente aggiungono alternative da Cohere o IBM Watson, a seconda delle esigenze di conformità e residenza dati.

- 🧠 Usa modalità di ragionamento per analisi ad alta posta; passa a varianti mini per compiti di volume.

- 🔁 Pianifica intorno a finestre rotanti di 3 ore per GPT‑4/4.1 per mantenere lo slancio.

- 📅 Sfrutta i limiti settimanali per progetti a salti come audit o migrazioni.

- 📦 Memorizza in cache output chiave localmente per evitare di rilanciare prompt lunghi inutilmente.

- 🧰 Esplora SDK e automazione, come coperto in questa panoramica del nuovo apps SDK, per semplificare compiti ripetuti.

| Piano ⚙️ | Accesso Tipico 🧭 | Limiti Notevoli ⏳ | Migliore per 🎯 |

|---|---|---|---|

| Free | GPT‑5 (limitato), strumenti base | Messaggi giornalieri limitati; sessioni più brevi | Esplorazione leggera, controlli rapidi |

| Plus | GPT‑5, GPT‑4.x, DALL·E | ~3.000 msg/settimana a livello di piano; finestre modello si applicano | Professionisti individuali, lavoro regolare |

| Pro | GPT‑5 + pattern di accesso o1/o3 | Praticamente illimitato sotto restrizioni | Utenti esperti, piccoli team |

Insight chiave: abbina i modelli di carico di lavoro alla combinazione piano + modello, e riserva il ragionamento premium per fasi di alto valore per estendere le quote senza sacrificare la qualità.

Limiti Settimanali vs Giornalieri, Finestre Rotanti e Reset: Tattiche Temporali che Prevengono Interruzioni

La logica di reset è dove molti team accelerano o si bloccano. Dominano tre regimi temporali: limiti settimanali, limiti giornalieri e finestre rotanti di 3 ore. I limiti settimanali—usati frequentemente da ChatGPT e Anthropic—favoriscono lavori a salti. I team possono spingere forte durante una settimana di lancio e poi rallentare, tutto entro un’allocazione prevedibile. Limiti giornalieri, visti su piattaforme come Perplexity e alcune configurazioni Gemini, distribuiscono l’uso in modo uniforme nei giorni, adatto a ricerche stabili o pipeline di contenuti. Le finestre rotanti di 3 ore (comuni per GPT‑4/4.1) incoraggiano sprint brevi e spezzano sessioni maratona in segmenti digeribili.

I tempi di reset sono importanti. Le finestre rotanti contano a ritroso dall’ultima interazione; i limiti giornalieri si resettano tipicamente alle 00:00 UTC; i limiti settimanali si resettano di solito su base rotante di sette giorni a partire dal primo messaggio in quella finestra. Chi progetta workflow dovrebbe trattarli come primitive di programmazione. Per esempio, un team di contenuti potrebbe pianificare “sprint GPT‑4o di 2 ore” al mattino e “burst GPT‑5 Thinking” nel tardo pomeriggio per cogliere finestre separate. Per una strategia ampia su piani e modelli, raccomandazioni pratiche in questa guida strategica aiutano i team a costruire ritmi prevedibili.

Un pattern ricorrente emerge: utenti raggiungono un limite per modello, l’interfaccia automaticamente ricade su un modello mini, e la qualità scende senza avviso. La soluzione è pianificare la giornata con il limite in mente. Se la settimana richiede uso intensivo di GPT‑5‑Thinking, concentra questi compiti all’inizio e lascia la bozza di routine a un modello mini o GPT‑4.1 mini. Se refactor di codice o analisi multi-file si accumulano, ruotare tra modelli distribuisce il carico preservando la qualità dove conta. Questo è un classico problema di orchestrazione dei carichi di lavoro, non un semplice “problema di limiti d’uso”.

I team su larga scala dovrebbero anche coordinare i reset tra i membri. Se cinque analisti raggiungono un limite simultaneamente, il team si blocca. Inizii sfalsati e diversità di modelli evitano rallentamenti sincronizzati. Strumenti di Salesforce e dashboard PM interni possono visualizzare le finestre d’uso pianificate, mentre l’osservabilità back-end su Microsoft Azure o Google Cloud monitora i picchi API. La comunità AI più ampia spinge il sapere—eventi come discussioni NVIDIA GTC sul futuro dell’AI evidenziano spesso lezioni di programmazione e ingegneria della capacità che si traducono direttamente nelle operazioni LLM.

- 🗓️ Pianifica finestre rotanti come blocchi di sprint per evitare ricadute improvvise.

- 🧮 Assegna un budget per modalità di ragionamento all’inizio della settimana per decisioni critiche.

- 👥 Sfalsa l’uso del team per evitare rallentamenti sincronizzati.

- 🔔 Usa promemoria quando si avvicinano limiti noti; passa proattivamente a un modello mini.

- 🧭 Consulta i dettagli del piano in questo explainer sui prezzi per allineare i budget temporali ai livelli.

| Tipo di Reset ⏱️ | Come Funziona 🔍 | Esempio Tipico 📌 | Consiglio di Pianificazione 🧭 |

|---|---|---|---|

| Rotante 3 ore | La finestra conta a ritroso dall’ultimo messaggio | GPT‑4/4.1: 80 msg/3h | Esegui sprint focalizzati; pausa per reset 🔁 |

| Giornaliero | Reset a 00:00 UTC | o4‑mini: 300/giorno | Bilancia i compiti tra i giorni 📅 |

| Settimanale (rotante) | Reset sette giorni dopo il primo messaggio | GPT‑5 Thinking: ~200/settimana | Concentra compiti ad alto valore all’inizio della finestra 🚀 |

Insight chiave: tratta i reset come vincoli nel calendario—quando temporizzati correttamente, i limiti diventano ritmi di lavoro, non ostacoli.

Economia delle Finestre di Contesto e Budget di Token: Estendere le Quote senza Sacrificare la Qualità

Le finestre di contesto ampie sono potenti—e costose in termini di token. Un contesto da 128K token (tipico per i livelli GPT‑5 e GPT‑4.1 di ChatGPT) contiene circa 96.000 parole, mentre i 200K di Claude gestiscono circa 150.000 parole. Il contesto da 1M token di Gemini accoglie circa 750.000 parole. Queste capacità tentano gli utenti a incollare intere wiki, ma ogni pagina extra consuma quota e aumenta la latenza. La tattica più intelligente è frammentare, indicizzare e riassumere prima di invocare ragionamenti pesanti. I workflow consapevoli dei token aumentano il throughput senza degradare i risultati.

Considera un team di ricerca che ricostruisce documentazione di conformità. Invece di caricare PDF completi in un singolo messaggio, dividono il contenuto in pacchetti tematici, generano note condensate con un modello mini, e solo allora scalano i riassunti raffinati a GPT‑5 Thinking per la logica finale di audit. Questo approccio a due fasi riduce il consumo di token preservando il rigore analitico. Quando il lavoro richiede un contesto enorme, riserva le finestre più grandi ai passaggi più interdipendenti e tieni gli appendici fuori dal prompt principale.

Aiutano i sistemi secondari. Banche dati vettoriali, pipeline di recupero e embeddings permettono prelievi precisi invece di scaricare interi corpora. Molti team si affidano a servizi gestiti su Amazon Web Services o Microsoft Azure per scalabilità elastica, mentre altri usano hub Hugging Face per modelli open source complementari che pre-processano e comprimono il contesto. La comunità continua a sperimentare, come si vede in articoli come riassunti della collaborazione open source e iniziative NVIDIA su framework open che influenzano l’architettura della gestione del contesto.

Il budget di ragionamento è altrettanto critico. Molti piani professionali forniscono risposte “standard” senza catene di pensiero pesanti a meno che non richieste. Riserva il ragionamento più profondo per i pochi prompt che richiedono una sintesi multi-salto. Per la redazione di routine, GPT‑4.1 mini o o4‑mini possono gestire l’80–90% del volume a una frazione di costo e quota. I team che codificano questa triage—mini per scaffolding, modello di frontiera per raffinamento finale—spedicono più velocemente e spendono meno.

- 🧩 Frammenta il materiale sorgente e riassumi prima di scalare.

- 🧷 Usa il recupero per inserire solo i passaggi rilevanti.

- 🪙 Limita la modalità di ragionamento a decisioni con impatto misurabile.

- 🗂️ Memorizza i snippet riutilizzabili; evita di reinserire boilerplate lunghi.

- 🧪 Prova idee per risparmio di token con risorse come guide alle tecniche di fine-tuning per pre-elaborazione leggera.

| Dimensione Contesto 📏 | Parole Approssimative 📚 | Quando Usare ✅ | Consiglio per Risparmio Token 💡 |

|---|---|---|---|

| 128K | ~96k parole | Brief, specifiche, corpora di medie dimensioni | Pre-riassumi con modello mini ✂️ |

| 200K | ~150k parole | Suite di policy, revisioni multi-doc | Usa recupero invece di incollare raw 📎 |

| 1M | ~750k parole | Set di ricerca massivi | Scaletta con embeddings 🧭 |

Insight chiave: la disciplina sui token—non solo gli upgrade di piano—offre il salto più grande in throughput sostenuto e affidabilità.

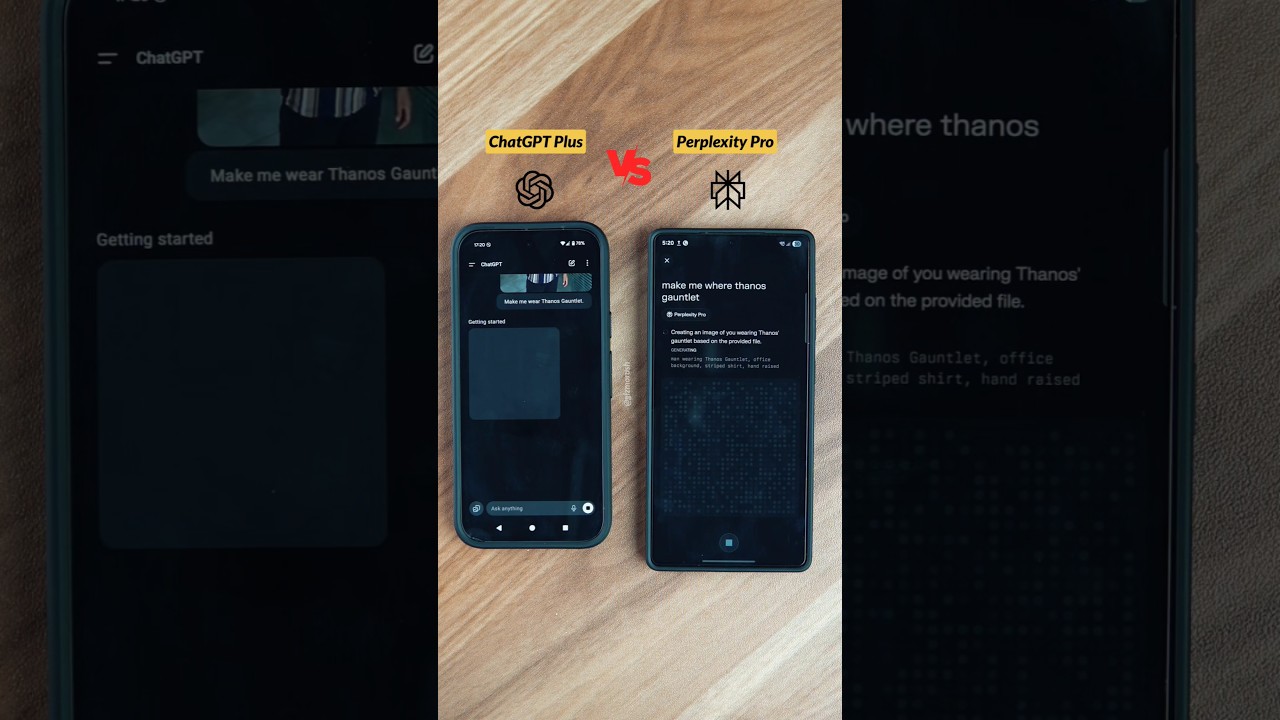

Scegliere tra ChatGPT, Claude, Gemini, Grok e Perplexity: Limiti, Modalità di Ragionamento e Compromessi

I limiti di velocità hanno senso solo nel contesto del mercato più ampio. Nel 2025, le piattaforme leader convergono su schemi simili: piani a livelli, metri visibili e modalità di ragionamento nei piani a pagamento. Le differenze emergono nelle dimensioni del contesto, nei ritmi di reset e nei punti di forza di ciascuna piattaforma. Per esempio, ChatGPT enfatizza ampiezza e integrazioni di strumenti; Claude è forte nella codifica e nell’analisi strutturata; Gemini guida su contesti da 1M token; Grok è legato da vicino a stream in tempo reale; e Perplexity si ottimizza per interrogazioni di tipo ricerca.

A colpo d’occhio, i livelli Plus si aggirano intorno a 20$, e i livelli premium intorno a 200–300$. Questa fascia più alta si rivolge a professionisti con bisogno di utilizzo quasi illimitato o ragionamento all’avanguardia. Ogni piattaforma definisce “illimitato” con attenzione, riservandosi il diritto di far rispettare termini contro scraping automatizzato o rivendita di accesso. Guide di confronto—come confronti bilanciati tra ChatGPT e Claude—aiutano i team a scegliere la combinazione giusta. Chi monitora il controllo dei costi può anche beneficiare di analisi delle strategie di prezzo che spiegano come dimensioni delle finestre e limiti per modello influenzano i budget.

Di seguito uno snapshot condensato e focalizzato sull’uso che riflette la situazione di fine 2025 e serve come riferimento indicativo. Conferma sempre i numeri più aggiornati nei documenti ufficiali prima di impegnarti.

| Piattaforma 🌐 | Modelli Chiave 🧠 | Limiti Tipici ⏳ | Modalità di Ragionamento 🧩 | Finestra di Contesto 📏 |

|---|---|---|---|---|

| ChatGPT | GPT‑5, GPT‑4.x | Plus ~3.000 msg/settimana; finestre per modello | GPT‑5 Thinking ✔️ | 128K token |

| Claude | Sonnet 4.5, Opus | ~15–45 msg/5h (Pro più alto) | Extended Thinking ✔️ | 200K (beta 1M) 🔬 |

| Gemini | Pro 2.5, Ultra | Quote giornaliere; Ultra fino a 1M token/giorno | Deep Think ✔️ | 1M token 🏆 |

| Grok | Grok 3/4 | ~10 richieste/2h (più alto su a pagamento) | Ragionamento standard | 256K token |

| Perplexity | GPT‑4.1, Claude 4, o3‑pro | Limiti Pro/giorno; max ~300+ Pro/giorno | Deep Research ✔️ | Esteso (varia) 📎 |

L’adeguatezza all’ecosistema conta tanto quanto i limiti grezzi. Organizzazioni profondamente integrate in workflow Salesforce possono preferire ChatGPT per riassunti e redazioni CRM. Team che si basano su ricerca on-premises accelerata NVIDIA possono aggiungere pre-elaborazione locale per ridurre i token prima di raggiungere i modelli cloud. Chi esplora alternative di training economico a volte consulta risorse come indagini su training a basso costo per strategie a lungo termine. Nel frattempo, il lavoro conoscitivo in tempo reale continua ad espandersi, con approfondimenti emersi in coperture di eventi sul futuro dell’AI.

- 🛠️ Scegli piattaforme per area di forza (codifica, ricerca, tempo reale, suite enterprise).

- 🧭 Abbina i tipi di reset al ritmo del team (a salti vs costante).

- 📈 Inizia con Plus/Pro e pianifica carichi di lavoro pilota prima di impegnarti in fasce da 200–300$.

- 🧳 Mantieni pronto un modello di riserva quando arrivano i limiti a metà sprint.

- 🔗 Usa riferimenti come questa guida a limiti e strategie per affinare il piano iniziale.

Insight chiave: scegli le piattaforme per adeguatezza, non per hype; abbina punti di forza e schemi di reset alla cadenza operativa del team per meno sorprese.

Progettare Workflow Efficienti in Token e Tempo: Un Manuale per Team e Aziende

Per le aziende che vivono in documenti, codice e riunioni, la differenza tra prosperare e essere rallentati è il design del workflow. Un manuale pratico inizia con una triage del carico di lavoro, continua con l’abbinamento dei modelli, e termina con automazioni consapevoli delle restrizioni. Considera una società fittizia—HarborLine Financial—with cinque analisti e due product manager. Il loro lavoro spazia tra ricerca, aggiornamenti di policy e riassunti per stakeholder. Senza pianificazione, incrociano i limiti a metà settimana; con un manuale, consegnano in tempo e sotto budget.

Prima, codifica l’albero decisionale. Bozza semplice, riformattazione ed estrazione vanno ai modelli mini. Sintesi strutturata passa a GPT‑4.1 o GPT‑4.5. Solo il ragionamento più ostico—interpretazione regolatoria, modellazione di scenari—scala a GPT‑5 Thinking. Secondo, formalizza la disciplina sui token: integra il recupero per query documentali pesanti, memorizza snippet riutilizzabili, e mantieni una libreria condivisa di “pattern promptati”. Terzo, imposta automazioni consapevoli delle restrizioni. I lavori programmati possono indirizzare alla API quando appropriato, e l’interfaccia resta per revisione umana. Quando la scala cresce, architetture ibride che sfruttano Microsoft Azure, Google Cloud e Amazon Web Services assicurano capacità, mentre la diversità dei fornitori aggiunge resilienza.

Quarto, abilita la collaborazione. Repository di conversazioni condivisi evitano di porre di nuovo le stesse domande. I team che curano una base di conoscenza e distribuiscono “prompt d’oro” superano costantemente quelli che si affidano a prompting ad hoc. Guide come raccomandazioni per condividere conversazioni aiutano a stabilire la norma. Quinto, aggiungi strumenti specializzati secondo necessità: input vocale per cattura rapida (vedi configurazione vocale semplice), ricerca multi-agente per approfondimenti, e task runner guidati da SDK. Per chi esplora la produttività in stile companion, prodotti come compagni AI Atlas mostrano come assistenti possono orchestrare flussi multi-step tra app.

Infine, monitora e itera. Dashboard di uso evidenziano schemi di limite. Quando appare una restrizione temporanea per violazioni di policy, esistono percorsi di escalation—documenta l’incidente e contatta il supporto con dettagli. Gli amministratori aziendali possono richiedere modifiche alle quote o accesso controllato alle modalità di ragionamento durante periodi critici. Mantieni opzioni cross-vendor a portata di mano: Cohere per embeddings, IBM Watson per servizi allineati al dominio, e rotte open-source per pre-elaborazioni, come sottolineato in focus su collaborazione open source. Per il contesto di modelli di frontiera, resta aggiornato sulle tendenze di training in articoli come spiegazioni della fase di training GPT‑5.

- 🧭 Costruisci una matrice di triage per indirizzare i compiti in base a complessità e costo.

- 🧲 Aggiungi recupero + caching per ridurre prompt e accelerare esecuzioni.

- 🔐 Rispetta le restrizioni; mantieni l’uso UI guidato da umani e autenticato.

- 🧑🤝🧑 Standardizza i pattern di prompt e condividili in una libreria di squadra.

- 📊 Monitora i limiti e le ricadute; adatta calendario e mix di modelli proattivamente.

| Pratica 🛠️ | Impatto 📈 | Resilienza ai Limiti 🧱 | Note 📝 |

|---|---|---|---|

| Triage modelli | 30–60% chiamate premium in meno | Alta | Riserva il ragionamento per fasi critiche 🧠 |

| Recupero + caching | 40% di riduzione token | Alta | Previene il ritrattamento di documenti grandi ♻️ |

| Prompt condivisi | Onboarding più veloce | Media | La coerenza migliora la qualità dell’output 📚 |

| Cloud ibrido | Margine di capacità | Alta | Azure/GCP/AWS offrono elasticità ☁️ |

Insight chiave: un piccolo set di abitudini ingegneristiche—triage, recupero, caching e programmazione—trasforma i limiti in restrizioni prevedibili piuttosto che ostacoli.

Risoluzione degli Errori di Limite di Velocità e Costruzione di Routine a Prova di Guasto

Anche con cura nella pianificazione, gli errori per limite di velocità sono inevitabili durante picchi o lanci. L’obiettivo è recuperare istantaneamente senza far deragliare il lavoro. Si comincia comprendendo la natura dell’errore. Quando si raggiunge un limite, il modello può sparire dal selettore, o l’UI ricade silenziosamente su un modello più piccolo. Le notifiche di solito comunicano il tempo di reset; passando il cursore sul nome del modello spesso si vede quando la finestra si aggiorna. Se il pattern d’uso ha violato una restrizione—come l’estrazione automatizzata sospetta—possono applicarsi restrizioni temporanee fino a revisione da parte del supporto.

Routine efficaci di recupero si basano su ricadute a livelli. Se GPT‑5 Thinking è limitato, passa a GPT‑4.1 per scaffolding e metti in coda i controlli finali per la finestra di reset successiva. Il batching riduce il numero di roundtrip: combina più sottodomande in un prompt strutturato invece di inviare messaggi separati. Per riunioni e cattura di contenuti, gli input vocali fanno risparmiare tempo; guide di configurazione come questa guida al voice chat possono ridurre gli attriti. Quando un intero team raggiunge limiti, si passa a compiti di documentazione, ottimizzazione dei prompt o stesura di linee guida—lavori produttivi che non consumano finestre premium.

A volte uno strumento diverso è la risposta giusta. Deep Research di Perplexity, l’enfasi in tempo reale di Grok, o le finestre lunghe di Claude possono supportare il carico in attesa. Fuori dall’UI, l’API resta un’opzione per pipeline programmatiche, spesso con quote e prezzi differenti. Molte organizzazioni implementano agenti di pre-elaborazione su infrastrutture accelerate NVIDIA e poi inviano richieste concise a monte, approccio discusso in iniziative open framework. In caso di dubbio, piccoli team possono consultare guide come guide applicative caso per caso per scegliere la soluzione più rapida.

Condividere le lezioni aumenta la resilienza. Le retrospettive di team catturano quali prompt colpiscono regolarmente i limiti e come hanno funzionato le ricadute. Documentazione centralizzata—combinata con conoscenza delle peculiarità dei modelli, come le finestre da 3 ore per GPT‑4.x—rafforza l’esecuzione. Per praticanti quotidiani, ripassi rapidi come questa panoramica sui limiti accelerano la risoluzione dei problemi. Per la collaborazione cross-team, considera compagni AI che orchestrano semplici passaggi; esempi come assistenti in stile Atlas illustrano schemi di coordinamento efficiente.

- 🚦 Mantieni una matrice di fallback per ogni workflow critico.

- 📦 Aggrega micro-compiti in un singolo prompt composito.

- 📝 Registra errori, limiti e tempi di reset per analisi di pattern.

- 🔄 Usa strumenti companion per organizzare lavoro durante i limiti (bozza, etichetta, prepara).

- 🔍 Verifica i dettagli del piano rispetto a una panoramica aggiornata come questa risorsa strategica.

| Problema 🚧 | Causa Probabile 🧭 | Azione Immediata ⚡ | Prossimo Passo 🧱 |

|---|---|---|---|

| Modello nascosto | Limite raggiunto per finestra | Passa a modello mini o alternativo | Metti in coda il compito premium per reset 🔁 |

| Calità in calo | Ricaduta automatica sotto carico | Controlla distintivo modello | Reinvia passaggio chiave dopo reset 🎯 |

| Restrizione temporanea | Applicazione restrizioni | Contatta supporto con log | Rivedi ToU e aggiusta pipeline 🔐 |

Insight chiave: il recupero è un processo, non un evento—codifica le ricadute, conserva i log, e tieni sempre una via alternativa.

{“@context”:”https://schema.org”,”@type”:”FAQPage”,”mainEntity”:[{“@type”:”Question”,”name”:”Quali sono i limiti ChatGPT più importanti da ricordare?”,”acceptedAnswer”:{“@type”:”Answer”,”text”:”Quote a livello di piano (es. Plus ~3.000 messaggi/settimana), finestre per modello (es. GPTu20114/4.1 con limiti rotanti di 3u2011ore), e limiti speciali di ragionamento (es. GPTu20115 Thinking ~200 messaggi/settimana su Plus/Team) regolano l’uso quotidiano. Quote giornaliere si applicano ad alcuni modelli come o4u2011mini, e finestre rotanti settimanali si resettano sette giorni dopo il primo messaggio nell’intervallo.”}},{“@type”:”Question”,”name”:”Come possono i team evitare di raggiungere i limiti durante scadenze critiche?”,”acceptedAnswer”:{“@type”:”Answer”,”text”:”Pianifica il ragionamento premium all’inizio della finestra settimanale, esegui GPTu20114.x in sprint stretti di 3u2011ore, e riserva modelli mini per bozze di volume. Usa recupero e caching per ridurre i prompt, e sfalsa l’uso del team per evitare limitazioni sincronizzate. Tieni una matrice documentata di fallback e cambia modello proattivamente avvicinandoti ai limiti.”}},{“@type”:”Question”,”name”:”Piattaforme di terze parti aiutano quando i limiti ChatGPT sono stretti?”,”acceptedAnswer”:{“@type”:”Answer”,”text”:”Sì. Le finestre più ampie di Claude, i contesti da 1M token di Gemini, l’enfasi in tempo reale di Grok, e i workflow di ricerca di Perplexity possono colmare le lacune. Molte organizzazioni integrano ChatGPT con embeddings Cohere, servizi IBM Watson, o pre-elaborazione open-source su infrastrutture accelerate NVIDIA.”}},{“@type”:”Question”,”name”:”Dove possono i professionisti apprendere di prezzi e cambi di piano?”,”acceptedAnswer”:{“@type”:”Answer”,”text”:”Consulta explainer sintetici come una panoramica dei prezzi di ChatGPT nel 2025 e articoli strategici sull’analisi dei prezzi di GPTu20114. Per l’evoluzione dei modelli, leggi spiegazioni della fase di training GPTu20115 e segui i note di rilascio dei vendor.”}},{“@type”:”Question”,”name”:”Vale la pena costruire tool interni per gestire i limiti?”,”acceptedAnswer”:{“@type”:”Answer”,”text”:”Sì. Dashboard leggere per tracciare i limiti, librerie condivise di prompt d’oro, e runner di compiti basati su SDK riducono gli attriti e prevengono rifacimenti. I team spesso combinano Microsoft Azure, Google Cloud, e Amazon Web Services con modelli OpenAI per standardizzare programmazione, recupero e caching.”}}]}Quali sono i limiti ChatGPT più importanti da ricordare?

Quote a livello di piano (es. Plus ~3.000 messaggi/settimana), finestre per modello (es. GPT‑4/4.1 con limiti rotanti di 3 ore), e limiti speciali di ragionamento (es. GPT‑5 Thinking ~200 messaggi/settimana su Plus/Team) regolano l’uso quotidiano. Quote giornaliere si applicano ad alcuni modelli come o4‑mini, e finestre rotanti settimanali si resettano sette giorni dopo il primo messaggio nell’intervallo.

Come possono i team evitare di raggiungere i limiti durante scadenze critiche?

Pianifica il ragionamento premium all’inizio della finestra settimanale, esegui GPT‑4.x in sprint stretti di 3 ore, e riserva modelli mini per bozze di volume. Usa recupero e caching per ridurre i prompt, e sfalsa l’uso del team per evitare limitazioni sincronizzate. Tieni una matrice documentata di fallback e cambia modello proattivamente avvicinandoti ai limiti.

Piattaforme di terze parti aiutano quando i limiti ChatGPT sono stretti?

Sì. Le finestre più ampie di Claude, i contesti da 1M token di Gemini, l’enfasi in tempo reale di Grok, e i workflow di ricerca di Perplexity possono colmare le lacune. Molte organizzazioni integrano ChatGPT con embeddings Cohere, servizi IBM Watson, o pre-elaborazione open-source su infrastrutture accelerate NVIDIA.

Dove possono i professionisti apprendere di prezzi e cambi di piano?

Consulta explainer sintetici come una panoramica dei prezzi di ChatGPT nel 2025 e articoli strategici sull’analisi dei prezzi di GPT‑4. Per l’evoluzione dei modelli, leggi spiegazioni della fase di training GPT‑5 e segui i note di rilascio dei vendor.

Vale la pena costruire tool interni per gestire i limiti?

Sì. Dashboard leggere per tracciare i limiti, librerie condivise di prompt d’oro, e runner di compiti basati su SDK riducono gli attriti e prevengono rifacimenti. I team spesso combinano Microsoft Azure, Google Cloud, e Amazon Web Services con modelli OpenAI per standardizzare programmazione, recupero e caching.

-

Open Ai1 week ago

Open Ai1 week agoSbloccare il Potere dei Plugin di ChatGPT: Migliora la Tua Esperienza nel 2025

-

Open Ai6 days ago

Open Ai6 days agoPadroneggiare il Fine-Tuning di GPT: Una guida per personalizzare efficacemente i tuoi modelli nel 2025

-

Open Ai7 days ago

Open Ai7 days agoConfronto tra ChatGPT di OpenAI, Claude di Anthropic e Bard di Google: quale strumento di IA generativa dominerà nel 2025?

-

Open Ai6 days ago

Open Ai6 days agoTariffe di ChatGPT nel 2025: Tutto quello che devi sapere su prezzi e abbonamenti

-

Open Ai7 days ago

Open Ai7 days agoLa Fase di Eliminazione dei Modelli GPT: Cosa Possono Aspettarsi gli Utenti nel 2025

-

Modelli di IA6 days ago

Modelli di IA6 days agoModelli GPT-4: Come l’Intelligenza Artificiale sta Trasformando il 2025