Open Ai

Navegando los Límites de Tasa de ChatGPT: Perspectivas Esenciales para un Uso Óptimo en 2025

Comprendiendo los Límites de Tasa de ChatGPT en 2025: Planes, Modelos y Por Qué Existen

Los controles de uso de ChatGPT han evolucionado hacia un sistema por capas que equilibra la confiabilidad, la equidad y el costo. En 2025, los límites operan en múltiples niveles: cuotas a nivel de plan, topes por modelo, ventanas móviles cortas y restricciones específicas por funciones. Este diseño ayuda a OpenAI a ofrecer un rendimiento consistente durante las horas pico, manteniendo disponibles las capacidades avanzadas —como los modos de razonamiento— para usuarios serios. La conclusión práctica es sencilla: los equipos que mapean sus patrones de trabajo a esta estructura evitan interrupciones y mantienen un alto ritmo.

A nivel de plan, tres niveles importan más para el uso conversacional: Gratis, Plus y Pro. Gratis ofrece acceso diario limitado y sesiones más cortas, mientras que Plus introduce asignaciones semanales suficientemente grandes para un trabajo individual sostenido. Pro —usado a menudo por usuarios avanzados y equipos pequeños— tiende hacia un uso general prácticamente ilimitado, sujeto a salvaguardas contra abusos. Aún se aplican topes a nivel de modelo, especialmente para modos de razonamiento fronterizos. Por ejemplo, GPT‑5 Thinking puede estar limitado a un número fijo de mensajes semanales en Plus o Team, mientras que el uso estándar de GPT‑5 escala con mayor libertad. Al combinarse con ventanas móviles de 3 horas para modelos como GPT‑4 y GPT‑4.1, los usuarios obtienen un acceso predecible que se reinicia a lo largo del día.

¿Por qué existen estos límites? Dominan dos motivos. Primero, la economía de servir ventanas de contexto grandes y razonamiento avanzado es real: indicaciones más grandes y cadenas más largas consumen más cómputo. Segundo, la calidad y estabilidad requieren salvaguardas; los modos sofisticados están restringidos para garantizar disponibilidad en trabajos legítimos con intervención humana. Esto es visible en todo el ecosistema, desde OpenAI hasta Anthropic y Google DeepMind, e incluso en plataformas como Perplexity o Grok de xAI. Socios de infraestructura como Microsoft Azure, Google Cloud y Amazon Web Services proveen la potencia, pero las decisiones de política mantienen las experiencias fluidas y predecibles.

Para profesionales que eligen un plan, leer la letra pequeña es importante. Las cuotas a nivel de plan Plus pueden mostrar una cifra como 3,000 mensajes por semana para un uso típico, pero GPT‑5‑Thinking aún puede mostrar una asignación manual menor de 200 mensajes por semana. Paralelamente, modelos creativos como GPT‑4.5 pueden tener topes semanales separados, mientras que GPT‑4/4.1 suelen funcionar bajo ventanas móviles de 3 horas. Estas capas no son contradictorias; se complementan para equilibrar la carga entre modelos. Quienes buscan contexto de precios y cambios de nivel pueden consultar análisis como un esquema claro de precios de ChatGPT en 2025 o comparar con ángulos competitivos en discusión sobre estrategias de precios de GPT‑4.

Las opciones de Team y Enterprise siguen una lógica similar. “Ilimitado” generalmente significa sin un techo práctico para uso humano normal, pero aún bajo salvaguardas. Eso incluye prohibiciones sobre compartir credenciales o usar acceso UI para alimentar servicios externos automatizados. Las empresas pueden solicitar aumentos de cuota y los administradores suelen tener mejores controles de monitoreo que usuarios individuales.

Los resultados prácticos son fáciles de prever: cargas creativas que pican fuerte, como lanzamientos de campañas, se benefician de topes semanales que permiten ráfagas cortas e intensas. Los flujos de trabajo de investigación diarios y constantes se alinean mejor con topes diarios o ventanas móviles, que distribuyen el uso de manera uniforme. Las configuraciones híbridas —mezclando sesiones UI para ideación con flujos API para producción— son comunes. Muchos equipos complementan ChatGPT con modelos desplegados en Microsoft Azure, Google Cloud o Amazon Web Services, y opcionalmente añaden alternativas de Cohere o IBM Watson según necesidades de cumplimiento y residencia de datos.

- 🧠 Usa modos de razonamiento para análisis de alto riesgo; cambia a variantes mini para tareas de volumen.

- 🔁 Planifica alrededor de ventanas móviles de 3 horas para GPT‑4/4.1 para mantener el impulso.

- 📅 Aprovecha los topes semanales para proyectos puntuales como auditorías o migraciones.

- 📦 Almacena en caché resultados clave localmente para evitar ejecutar indicaciones largas innecesariamente.

- 🧰 Explora SDKs y automatización, como se cubre en esta visión general del nuevo SDK de apps, para agilizar tareas repetidas.

| Plan ⚙️ | Acceso Típico 🧭 | Topes Notables ⏳ | Ideal Para 🎯 |

|---|---|---|---|

| Gratis | GPT‑5 (limitado), herramientas básicas | Mensajes diarios limitados; sesiones más cortas | Exploración ligera, chequeos rápidos |

| Plus | GPT‑5, GPT‑4.x, DALL·E | ~3,000 mensajes/semana a nivel plan; aplican ventanas de modelo | Profesionales individuales, trabajo constante |

| Pro | Patrones de acceso GPT‑5 + o1/o3 | Casi ilimitado bajo salvaguardas | Usuarios avanzados, equipos pequeños |

Dato clave: mapea patrones de carga de trabajo al combo plan + modelo, y reserva razonamiento premium para pasos de alto valor para extender cuotas sin sacrificar calidad.

Topes Semanales vs Diarios, Ventanas Móviles y Reinicios: Tácticas de Tiempo que Previenen Interrupciones

La lógica de reinicios es donde muchos equipos aceleran o se estancan. Dominan tres regímenes de tiempo: topes semanales, topes diarios y ventanas móviles de 3 horas. Los topes semanales —usados frecuentemente por ChatGPT y Anthropic— favorecen trabajo puntual. Los equipos pueden esforzarse mucho durante una semana de lanzamiento y luego desacelerar, todo dentro de una asignación predecible. Los topes diarios, presentes en plataformas como Perplexity y algunas configuraciones de Gemini, distribuyen el uso de manera uniforme durante los días, lo que se adapta a flujos de investigación constantes o cadenas de contenido. Las ventanas móviles de 3 horas (comunes en GPT‑4/4.1) fomentan sprints cortos y dividen sesiones maratónicas en partes digeribles.

Los tiempos de reinicio importan. Las ventanas móviles cuentan hacia atrás desde la última interacción; los topes diarios suelen reiniciarse a las 00:00 UTC; los topes semanales generalmente reinician sobre una base rodante de siete días desde el primer mensaje del intervalo. Quien diseña flujos de trabajo debería tratarlos como primitivas de programación. Por ejemplo, un equipo de contenido podría planear “sprints GPT‑4o de 2 horas” en la mañana y “ráfagas GPT‑5 Thinking” en la tarde para aprovechar ventanas separadas. Para estrategias amplias en planes y modelos, recomendaciones prácticas en esta guía enfocada en estrategias pueden ayudar a equipos a construir cadencias predecibles.

Un patrón recurrente destaca: los usuarios alcanzan un tope por modelo, la UI automáticamente cae a un modelo mini, y la calidad baja sin aviso. La solución es planificar el día considerando el tope. Si la semana requiere uso intensivo de GPT‑5‑Thinking, prioriza esas tareas y reserva la redacción rutinaria para un modelo mini o GPT‑4.1 mini. Si se acumulan refactorizaciones de código o análisis multifichero, rotar entre modelos distribuye la carga preservando la calidad donde importa. Este es un problema clásico de orquestación de carga laboral, no solo un simple “límite de uso”.

Los equipos a gran escala también deben coordinar reinicios entre miembros. Si cinco analistas llegan al tope simultáneamente, el equipo se detiene. Los inicios escalonados y la diversidad de modelos previenen desaceleraciones sincronizadas. Herramientas de Salesforce y dashboards internos de PM pueden visualizar ventanas de uso planificadas, mientras que la observabilidad de back-end en Microsoft Azure o Google Cloud rastrea picos de API. La comunidad AI más amplia impulsa el conocimiento —eventos como discusiones NVIDIA GTC sobre el futuro de la IA resaltan lecciones de programación y ingeniería de rendimiento que se traducen directamente en operaciones de LLM.

- 🗓️ Programa ventanas móviles como bloques de sprint para evitar caídas sorpresa.

- 🧮 Asigna un presupuesto de modo razonamiento temprano en la semana para decisiones críticas.

- 👥 Escalona el uso del equipo para evitar estrangulamientos sincronizados.

- 🔔 Usa recordatorios al acercarte a topes conocidos; cambia a un modelo mini proactivamente.

- 🧭 Revisa detalles del plan en este explicador de precios para alinear presupuestos de tiempo con niveles.

| Tipo de Reinicio ⏱️ | Cómo Funciona 🔍 | Ejemplo Típico 📌 | Consejo de Planificación 🧭 |

|---|---|---|---|

| Ventana móvil 3 horas | La ventana cuenta hacia atrás desde el último mensaje | GPT‑4/4.1: 80 mensajes/3h | Realiza sprints enfocados; pausa para reiniciar 🔁 |

| Diario | Reinicia a las 00:00 UTC | o4‑mini: 300/día | Equilibra tareas entre días 📅 |

| Semanal (rodante) | Reinicia siete días después del primer mensaje | GPT‑5 Thinking: ~200/semana | Prioriza trabajo de alto valor temprano en la ventana 🚀 |

Dato clave: trata los reinicios como restricciones de calendario; cuando se programan bien, los límites se vuelven ritmos de trabajo, no bloqueos.

Economía de Ventanas de Contexto y Presupuesto de Tokens: Extender Cuotas Sin Sacrificar Calidad

Las ventanas de contexto grandes son poderosas —y costosas en términos de tokens. Un contexto de 128K tokens (típico para los niveles GPT‑5 y GPT‑4.1 de ChatGPT) cabe aproximadamente 96,000 palabras, mientras que 200K para Claude maneja alrededor de 150,000 palabras. El contexto de 1M tokens de Gemini acomoda aproximadamente 750,000 palabras. Estas capacidades tientan a los usuarios a pegar wikis enteras, pero cada página extra consume cuota y añade latencia. La táctica más inteligente es fragmentar, indexar y resumir antes de invocar razonamiento pesado. Los flujos de trabajo conscientes de tokens aumentan el rendimiento sin degradar resultados.

Considera un equipo de investigación que reconstruye documentación de cumplimiento. En lugar de cargar PDFs completos en un solo mensaje, dividen el contenido en paquetes temáticos, generan notas condensadas con un modelo mini, y solo entonces escalan los resúmenes refinados a GPT‑5 Thinking para la lógica final de auditoría. Este enfoque en dos etapas reduce el gasto de tokens sin perder rigor analítico. Cuando el trabajo demanda un contexto masivo, reserva las ventanas más grandes para los pasajes más interdependientes y mantiene los apéndices fuera del prompt principal.

Los sistemas auxiliares son útiles. Bases de datos vectoriales, pipelines de recuperación y embeddings permiten extracciones precisas en lugar de volcar corpora completos. Muchos equipos confían en servicios gestionados en Amazon Web Services o Microsoft Azure para escalabilidad elástica, mientras que otros usan hubs de Hugging Face para modelos open source complementarios que preprocesan y comprimen contexto. La comunidad sigue experimentando, como se ve en piezas como resúmenes de colaboración open source y las iniciativas de NVIDIA sobre frameworks abiertos que influyen en cómo se diseña la gestión de contexto.

El presupuesto de razonamiento es igualmente crítico. Muchos planes profesionales ofrecen respuestas “estándar” sin cadena de pensamiento pesada a menos que se solicite. Reserva el razonamiento más profundo para los pocos prompts que realmente requieren síntesis multi-salto. Para redacción rutinaria, GPT‑4.1 mini o o4‑mini pueden manejar el 80–90% del volumen a una fracción del costo y cuota. Los equipos que codifican este triage —mini para andamiaje, modelo frontera para pulido final— entregan más rápido y gastan menos.

- 🧩 Fragmenta el material fuente y resume antes de escalar.

- 🧷 Usa recuperación para traer solo los pasajes relevantes.

- 🪙 Limita el modo razonamiento a decisiones con impacto medible.

- 🗂️ Almacena en caché fragmentos reutilizables; evita reingresar textos largos.

- 🧪 Prueba ideas para ahorrar tokens con recursos como guías de técnicas de fine-tuning para preprocesamiento ligero.

| Tamaño de Contexto 📏 | Palabras Aproximadas 📚 | Cuándo Usar ✅ | Consejo para Ahorrar Tokens 💡 |

|---|---|---|---|

| 128K | ~96k palabras | Briefs, especificaciones, corpus medianos | Pre-resume con modelo mini ✂️ |

| 200K | ~150k palabras | Paquetes de políticas, revisiones multidoc | Usa recuperación en lugar de pegar bruto 📎 |

| 1M | ~750k palabras | Conjuntos masivos de investigación | Etapa contenido con embeddings 🧭 |

Dato clave: la disciplina con tokens —no solo las mejoras del plan— entrega el salto más grande en rendimiento sostenido y fiabilidad.

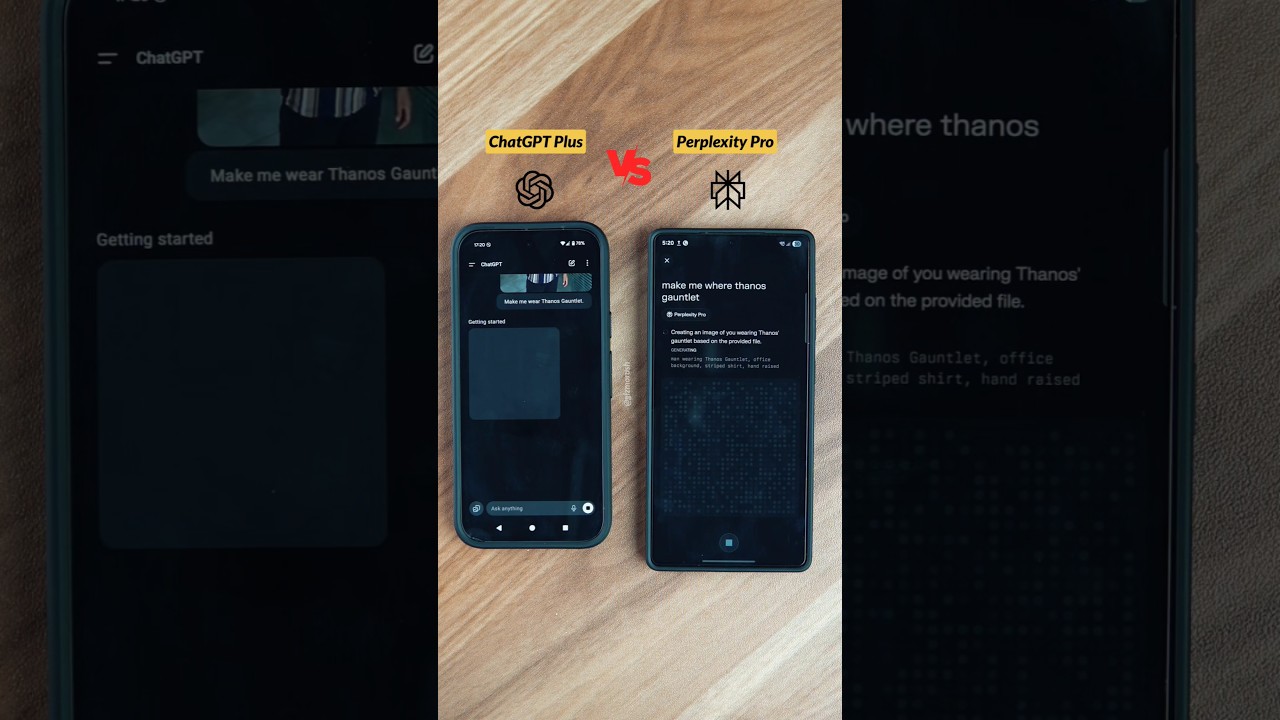

Elegir Entre ChatGPT, Claude, Gemini, Grok y Perplexity: Límites, Modos de Razonamiento y Compensaciones

Los límites de tasa solo tienen sentido en el contexto del mercado más amplio. En 2025, las principales plataformas convergen en patrones de diseño similares: planes escalonados, medidores visibles y modos de razonamiento en niveles pagos. Las diferencias aparecen en tamaño de contexto, ritmos de reinicio y dónde destaca cada plataforma. Por ejemplo, ChatGPT enfatiza la amplitud y las integraciones de herramientas; Claude es fuerte en codificación y análisis estructurado; Gemini lidera en contextos de 1M tokens; Grok se vincula estrechamente con streams en tiempo real; y Perplexity optimiza para consultas estilo investigación.

A simple vista, los niveles Plus se agrupan alrededor de $20, y los niveles premium entre $200–$300. Ese rango más alto apunta a profesionales que necesitan uso casi ilimitado o razonamiento frontera. Cada plataforma define “ilimitado” cuidadosamente, reservándose el derecho de hacer cumplir los términos contra scraping automatizado o reventa de accesos. Guías comparativas —como comparaciones equilibradas de ChatGPT vs. Claude— ayudan a equipos a elegir la combinación adecuada. Quienes siguen el control de costos también pueden beneficiarse de desgloses de estrategias de precios que explican cómo los tamaños de ventana y los topes por modelo moldean los presupuestos.

A continuación, un resumen condensado centrado en uso que refleja la imagen de finales de 2025 y sirve como referencia direccional. Siempre confirma las cifras más recientes en la documentación oficial antes de comprometerte.

| Plataforma 🌐 | Modelos Clave 🧠 | Límites Típicos ⏳ | Modo Razonamiento 🧩 | Ventana de Contexto 📏 |

|---|---|---|---|---|

| ChatGPT | GPT‑5, GPT‑4.x | Plus ~3,000 mensajes/semana; ventanas por modelo | GPT‑5 Thinking ✔️ | 128K tokens |

| Claude | Sonnet 4.5, Opus | ~15–45 mensajes/5h (Pro mayor) | Extended Thinking ✔️ | 200K (beta 1M) 🔬 |

| Gemini | Pro 2.5, Ultra | Cuotas diarias; Ultra hasta 1M tokens/día | Deep Think ✔️ | 1M tokens 🏆 |

| Grok | Grok 3/4 | ~10 solicitudes/2h (más en pago) | Razonamiento estándar | 256K tokens |

| Perplexity | GPT‑4.1, Claude 4, o3‑pro | Topes Pro/día; Máx ~300+ Pro/día | Deep Research ✔️ | Extendido (varía) 📎 |

El encaje en el ecosistema importa tanto como los límites brutos. Las organizaciones profundas en flujos de trabajo de Salesforce pueden favorecer ChatGPT para resúmenes y redacción CRM. Equipos que usan investigación local acelerada por NVIDIA pueden añadir preprocesamiento local para reducir tokens antes de enviar a modelos cloud. Quienes exploran alternativas de entrenamiento económicas a veces consultan recursos como investigaciones de entrenamiento de bajo costo para estrategia a largo plazo. Mientras tanto, el trabajo de conocimiento en tiempo real sigue creciendo, con insights expuestos en cobertura de eventos sobre el futuro de la IA.

- 🛠️ Elige plataformas por área de fortaleza (codificación, investigación, tiempo real, suite empresarial).

- 🧭 Empareja tipos de reinicio con el ritmo del equipo (puntual vs constante).

- 📈 Comienza con Plus/Pro y prueba cargas de trabajo antes de comprometerte a niveles de $200–$300.

- 🧳 Mantén un modelo de respaldo listo cuando lleguen los topes a mitad de sprint.

- 🔗 Usa referencias como esta guía de límites y estrategias para afinar un plan inicial.

Dato clave: elige plataformas por ajuste, no por hype; combina fortalezas y patrones de reinicio con la cadencia operativa del equipo para menos sorpresas.

Diseñando Flujos de Trabajo Eficientes en Tokens y Tiempo: Un Manual para Equipos y Empresas

Para empresas que viven en documentos, código y reuniones, la diferencia entre prosperar y estar bloqueados es el diseño del flujo de trabajo. Un manual práctico comienza con triage de carga de trabajo, sigue con emparejamiento de modelos y termina con automatización consciente de salvaguardas. Considera una empresa ficticia —HarborLine Financial— con cinco analistas y dos gerentes de producto. Su trabajo abarca investigación, actualización de políticas y resúmenes para stakeholders. Sin planificación, chocan con los topes a mitad de semana; con un manual, entregan a tiempo y bajo presupuesto.

Primero, codifica el árbol de decisiones. Redacción simple, reformateo y extracción van a modelos mini. La síntesis estructurada pasa a GPT‑4.1 o GPT‑4.5. Solo el razonamiento más difícil —interpretación regulatoria, modelado de escenarios— escala a GPT‑5 Thinking. Segundo, formaliza la disciplina de tokens: incrusta recuperación para consultas documentales, almacena fragmentos reutilizables en caché y mantiene una biblioteca compartida de “patrones de prompt”. Tercero, establece automatizaciones conscientes de salvaguardas. Trabajos programados pueden enrutar a la API cuando es apropiado, y la UI permanece para revisión humana. Cuando escala, arquitecturas híbridas que usan Microsoft Azure, Google Cloud y Amazon Web Services aseguran rendimiento, mientras que la diversidad de proveedores suma resiliencia.

Cuarto, habilita la colaboración. Repositorios compartidos de conversación previenen repetir preguntas. Equipos que curan bases de conocimiento y distribuyen “prompts dorados” consistentemente superan a equipos que dependen de prompts ad hoc. Guías como recomendaciones para compartir conversaciones ayudan a establecer normas. Quinto, añade herramientas especializadas según necesidad: entrada por voz para captura rápida (ver una configuración simple de voz), investigación con agentes múltiples para inmersiones profundas y ejecutores de tareas basados en SDK. Para quienes exploran productividad estilo compañero, productos como compañeros AI Atlas muestran cómo asistentes pueden orquestar flujos multi-paso en apps.

Finalmente, monitorea e itera. Los dashboards de uso destacan patrones de tope. Cuando hay una restricción temporal por violaciones de política, existen vías de escalada —documenta el incidente y contacta soporte con detalles. Los administradores empresariales pueden solicitar cambios de cuota o acceso controlado a modos de razonamiento en periodos críticos. Mantén opciones cruzadas de proveedores a mano: Cohere para embeddings, IBM Watson para servicios alineados a dominio y rutas open-source para preprocesamiento, como se enfatiza en resúmenes de colaboración open source. Para contexto de modelos frontera, mantente al tanto de tendencias de entrenamiento en piezas como explicadores de la fase de entrenamiento GPT‑5.

- 🧭 Construye una matriz de triage para enrutar tareas según complejidad y costo.

- 🧲 Añade recuperación + caché para reducir prompts y acelerar ejecuciones.

- 🔐 Respeta las salvaguardas; mantiene uso UI conducido por humanos y autenticado.

- 🧑🤝🧑 Estandariza los patrones de prompt y compártelos en una biblioteca del equipo.

- 📊 Controla topes y caídas; ajusta calendario y mezcla de modelos proactivamente.

| Práctica 🛠️ | Impacto 📈 | Resiliencia a Límites 🧱 | Notas 📝 |

|---|---|---|---|

| Triage de modelos | 30–60% menos llamadas premium | Alta | Reserva razonamiento para pasos críticos 🧠 |

| Recuperación + caché | 40% reducción de tokens | Alta | Evita reprocesar documentos grandes ♻️ |

| Prompts compartidos | Incorporación más rápida | Media | Consistencia mejora calidad de salida 📚 |

| Nube híbrida | Capacidad de rendimiento | Alta | Azure/GCP/AWS proveen elasticidad ☁️ |

Dato clave: un pequeño conjunto de hábitos de ingeniería —triage, recuperación, caché y programación— convierte límites en salvaguardas predecibles en vez de bloqueadores.

Solución de Errores de Límite de Tasa y Construcción de Rutinas a Prueba de Fallos

Aun con planificación cuidadosa, los errores de límite de tasa son inevitables durante picos o lanzamientos. El objetivo es recuperarse instantáneamente sin descarrilar el trabajo. Eso comienza entendiendo la forma del error. Cuando se alcanza un tope, el modelo puede desaparecer del selector o la UI cae silenciosamente a un modelo más pequeño. Las notificaciones típicamente comunican el tiempo de reinicio; al posar el cursor sobre el nombre del modelo suele mostrarse cuándo se refresca la ventana. Si el patrón de uso violó una salvaguarda —como extracción automatizada sospechada— pueden aplicarse restricciones temporales hasta que soporte revise la actividad.

Rutinas de recuperación efectivas se basan en caídas escalonadas. Si GPT‑5 Thinking está al tope, cambia a GPT‑4.1 para andamiaje y deja las verificaciones finales para la próxima ventana de reinicio. Las agrupaciones reducen la cantidad de viajes: combina múltiples sub-preguntas en un prompt estructurado en lugar de enviar mensajes separados. Para reuniones y captura de contenido, entradas de voz ahorran tiempo; guías de configuración como esta guía de voz reducen fricción. Cuando todo un equipo alcanza topes, la estrategia es cambiar a tareas documentales, afinar prompts o redactar pautas —trabajo productivo que no consume ventanas premium.

A veces la herramienta diferente es la solución correcta. Deep Research de Perplexity, el enfoque en tiempo real de Grok o las ventanas largas de Claude pueden asumir la carga mientras se espera. Fuera de la UI, la API sigue siendo opción para flujos programáticos, a menudo con cuotas y precios diferentes. Muchas organizaciones despliegan agentes de preprocesamiento en infraestructura acelerada por NVIDIA y luego envían solicitudes concisas, un enfoque discutido en iniciativas de frameworks abiertos. En caso de duda, equipos pequeños pueden consultar guías básicas como guías de aplicación caso por caso para elegir el desvío más rápido.

Compartir lecciones mejora la resiliencia. Las retrospectivas de equipo capturan qué prompts rutinariamente alcanzan topes y cómo funcionaron las caídas. La documentación centralizada —combinada con conocimiento de particularidades del modelo, como las ventanas de 3 horas para GPT‑4.x— mejora la ejecución. Para practicantes diarios, repasos rápidos como esta visión general de limitaciones aceleran la solución de problemas. Para colaboración entre equipos, considera compañeros AI que orquestan entregas simples; ejemplos como asistentes estilo Atlas ilustran patrones de coordinación eficientes.

- 🚦 Mantén una matriz de caídas para cada flujo crítico.

- 📦 Agrupa microtareas en un solo prompt compuesto.

- 📝 Registra errores, topes y tiempos de reinicio para análisis de patrones.

- 🔄 Usa herramientas compañeras para organizar trabajo durante topes (redactar, etiquetar, preparar).

- 🔍 Verifica detalles del plan contra una visión actualizada como este recurso estratégico.

| Problema 🚧 | Causa Probable 🧭 | Acción Inmediata ⚡ | Siguiente Paso 🧱 |

|---|---|---|---|

| Modelo oculto | Tope alcanzado para la ventana | Cambia a modelo mini o alternativo | Pon en cola tarea premium para reinicio 🔁 |

| Bajada de calidad | Caída automática bajo carga | Confirma la insignia del modelo | Reenvía paso clave tras reinicio 🎯 |

| Restricción temporal | Aplicación de salvaguarda | Contacta soporte con registros | Revisa términos de uso y ajusta flujo 🔐 |

Dato clave: la recuperación es un proceso, no un evento —codifica las caídas, mantén registros y siempre ten una ruta alternativa.

{“@context”:”https://schema.org”,”@type”:”FAQPage”,”mainEntity”:[{“@type”:”Question”,”name”:”¿Cuáles son los límites de ChatGPT más importantes para recordar?”,”acceptedAnswer”:{“@type”:”Answer”,”text”:”Las cuotas a nivel de plan (por ejemplo, Plus ~3,000 mensajes/semana), las ventanas por modelo (por ejemplo, GPTu20114/4.1 con límites móviles de 3 horas) y los topes especiales de razonamiento (por ejemplo, GPTu20115 Thinking ~200 mensajes/semana en Plus/Team) rigen el uso cotidiano. Algunos modelos como o4u2011mini tienen cuotas diarias, y las ventanas rodantes semanales se reinician siete días después del primer mensaje del intervalo.”}},{“@type”:”Question”,”name”:”¿Cómo pueden los equipos evitar alcanzar los límites durante fechas críticas?”,”acceptedAnswer”:{“@type”:”Answer”,”text”:”Programa razonamiento premium temprano en la ventana semanal, ejecuta GPTu20114.x en sprints enfocados de 3 horas, y reserva modelos mini para redacción de volumen. Usa recuperación y caché para reducir prompts y escalona el uso del equipo para evitar estrangulamientos sincronizados. Mantén una matriz de caídas documentada y cambia de modelo de forma proactiva al acercarte a límites.”}},{“@type”:”Question”,”name”:”¿Ayudan las plataformas de terceros cuando los límites de ChatGPT son estrictos?”,”acceptedAnswer”:{“@type”:”Answer”,”text”:”Sí. Las ventanas más grandes de Claude, los contextos de 1M tokens de Gemini, el enfoque en tiempo real de Grok y los flujos de investigación de Perplexity pueden cubrir brechas. Muchas organizaciones complementan ChatGPT con embeddings de Cohere, servicios de IBM Watson o preprocesamiento open source en infraestructura acelerada por NVIDIA.”}},{“@type”:”Question”,”name”:”¿Dónde pueden los profesionales aprender sobre precios y cambios de planes?”,”acceptedAnswer”:{“@type”:”Answer”,”text”:”Consulta explicadores sintetizados como una visión general de precios de ChatGPT en 2025 y artículos de estrategia que analizan la dinámica de precios de GPTu20114. Para la evolución del modelo, lee explicadores de la fase de entrenamiento de GPTu20115 y sigue las notas de lanzamiento de proveedores.”}},{“@type”:”Question”,”name”:”¿Vale la pena construir herramientas internas para gestionar límites?”,”acceptedAnswer”:{“@type”:”Answer”,”text”:”Sí. Dashboards ligeros para seguir límites, bibliotecas compartidas de prompts dorados y ejecutores de tareas basados en SDK reducen fricción y evitan reprocesos. Los equipos suelen combinar Microsoft Azure, Google Cloud y Amazon Web Services con modelos OpenAI para estandarizar programación, recuperación y caché.”}}]}¿Cuáles son los límites de ChatGPT más importantes para recordar?

Las cuotas a nivel de plan (por ejemplo, Plus ~3,000 mensajes/semana), las ventanas por modelo (por ejemplo, GPT‑4/4.1 con límites móviles de 3 horas) y los topes especiales de razonamiento (por ejemplo, GPT‑5 Thinking ~200 mensajes/semana en Plus/Team) rigen el uso cotidiano. Algunos modelos como o4‑mini tienen cuotas diarias, y las ventanas rodantes semanales se reinician siete días después del primer mensaje del intervalo.

¿Cómo pueden los equipos evitar alcanzar los límites durante fechas críticas?

Programa razonamiento premium temprano en la ventana semanal, ejecuta GPT‑4.x en sprints enfocados de 3 horas, y reserva modelos mini para redacción de volumen. Usa recuperación y caché para reducir prompts y escalona el uso del equipo para evitar estrangulamientos sincronizados. Mantén una matriz de caídas documentada y cambia de modelo de forma proactiva al acercarte a límites.

¿Ayudan las plataformas de terceros cuando los límites de ChatGPT son estrictos?

Sí. Las ventanas más grandes de Claude, los contextos de 1M tokens de Gemini, el enfoque en tiempo real de Grok y los flujos de investigación de Perplexity pueden cubrir brechas. Muchas organizaciones complementan ChatGPT con embeddings de Cohere, servicios de IBM Watson o preprocesamiento open source en infraestructura acelerada por NVIDIA.

¿Dónde pueden los profesionales aprender sobre precios y cambios de planes?

Consulta explicadores sintetizados como una visión general de precios de ChatGPT en 2025 y artículos de estrategia que analizan la dinámica de precios de GPT‑4. Para la evolución del modelo, lee explicadores de la fase de entrenamiento de GPT‑5 y sigue las notas de lanzamiento de proveedores.

¿Vale la pena construir herramientas internas para gestionar límites?

Sí. Dashboards ligeros para seguir límites, bibliotecas compartidas de prompts dorados y ejecutores de tareas basados en SDK reducen fricción y evitan reprocesos. Los equipos suelen combinar Microsoft Azure, Google Cloud y Amazon Web Services con modelos OpenAI para estandarizar programación, recuperación y caché.

-

Open Ai1 week ago

Open Ai1 week agoDesbloqueando el Poder de los Plugins de ChatGPT: Mejora Tu Experiencia en 2025

-

Open Ai6 days ago

Open Ai6 days agoDominando la Fine-Tuning de GPT: Una guía para personalizar eficazmente tus modelos en 2025

-

Open Ai7 days ago

Open Ai7 days agoComparando ChatGPT de OpenAI, Claude de Anthropic y Bard de Google: ¿Qué herramienta de IA generativa reinará suprema en 2025?

-

Open Ai6 days ago

Open Ai6 days agoPrecios de ChatGPT en 2025: Todo lo que necesitas saber sobre tarifas y suscripciones

-

Open Ai7 days ago

Open Ai7 days agoLa eliminación progresiva de los modelos GPT: qué pueden esperar los usuarios en 2025

-

Modelos de IA6 days ago

Modelos de IA6 days agoModelos GPT-4: Cómo la inteligencia artificial está transformando 2025