Uncategorized

ChatGPT-service onderbroken: gebruikers ervaren storingen tijdens Cloudflare-onderbreking | Hindustan Times

ChatGPT-dienst verstoord: Cloudflare-onderbreking veroorzaakt wereldwijde storingen en 500-fouten

Golven van instabiliteit rolden over het web toen een Cloudflare-onderbreking kern-edge-diensten in turbulentie bracht, waardoor gebruikers wijdverspreide storingen rapporteerden voor ChatGPT en andere drukbezochte platforms. Het patroon leek meer op een upstream-netwerkfout dan op geïsoleerde app-niveaustoringen, wat bleek uit gelijktijdige signalen van serveruitval, dashboardfouten en 500-antwoorden. Tegen de late namiddag meldde men meer dan 11.000 incidenten gerelateerd aan X, terwijl Hindustan Times-lezers plotselinge onderbrekingen midden in prompts, lege vensters en “netwerkfout”-meldingen bij de AI-chatbot beschreven.

Vroege indicatoren waren al zichtbaar lang voordat de tijdlijnen dat bijhielden. Downdetector liet een stijging zien van ongeveer 15 basisklachten naar 38 rond 03:34 uur, gevolgd door scherpe pieken gedurende de dag—klassieke tekenen van een fout in een upstream edge-laag. Cloudflare erkende “wijdverspreide 500-fouten”, naast verslechterde internetdiensten waaronder het dashboard, de API en zelfs hun eigen supportportaal. Tegelijkertijd waren 90% van de storingsklachten specifiek gericht op ChatGPT, wat benadrukt hoe afhankelijk realtime AI-workflows zijn geworden van edgenetwerken.

Wat gebruikers zagen en waarom het er toe deed

Symptomen concentreerden zich rond prompts die de tijd overschreden, verdwenen context en UI-vensters die weigerden te laden. Voor teams met deadlines is een bevroren inferentievenster niet alleen een irritatie—het vertraagt besluitvormingsprocessen voor codebeoordeling, contentproductie en datasamenvatting. Het probleem verergerde wanneer failover-opnieuwpogingen dezelfde upstream knelpunten bereikten, waardoor gewone verversingen in loops veranderden.

- 🔴 Sessie-uitval midden in gesprekken, vaak met 500-fouten

- ⚠️ Lege outputs of “kan geschiedenis niet laden” bij het ophalen van chats

- 🕒 Lange inferentievertragingen gevolgd door abrupte verbrekkingen

- 🔁 Herhaalde herlaadpogingen zonder contextherstel voor lopende taken

- 🧭 Verwarde statusindicatoren doordat meerdere diensten tegelijkertijd uitvielen

Wanneer foutcodes opdoken, wezen ze op infrastructuurinconsistentie. Teams die een catalogus van ChatGPT-foutcodes bijhouden, konden snel beoordelen wat tijdelijk was versus actie vereist was. Maar op een dag als deze lag de oorzaak buiten de applicatiecontrole, waardoor geduld en noodplannen net zo cruciaal werden als debugging.

| Tijdstempel (lokaal) ⏰ | Vastgelegd signaal 📊 | Wat het suggereerde 🧭 | Impact voor gebruiker 😬 |

|---|---|---|---|

| 03:34 AM | 38 klachten vs ~15 basislijn | Vroege upstream instabiliteit | Intermitterende ChatGPT-toegang |

| Ochtendpiek | Scherpe multi-platform pieken | Edge/CDN-foutverspreiding | Lege vensters, 500-fouten, herhaalde pogingen |

| Rond 17u | 11.000+ X-storingsrapporten | Breed consumentenbereik | Sociale en nieuwsfeeds stilden |

| Gedurende dag | Cloudflare Dashboard/API-problemen | Problemen aan providerkant | Ondersteuningsvertragingen en trage mitigaties |

Voor iedereen die zich afvroeg “Ben ik het of is het netwerk?” bood de telemetrie van die dag een duidelijk antwoord: dit was een storing op backbone-niveau, niet een fout van een enkele app. De gebeurtenis bevestigt een waarheid van moderne computing—AI is afhankelijk van de edge, en wanneer de edge wankelt, wankelt de productiviteit mee.

Hoe gebruikers en bedrijven de serveruitval over internetdiensten heen voelden

De dienstonderbreking verspreidde zich via handel, media, onderwijs en logistiek en toonde aan hoe verweven internetdiensten zijn geworden met AI-chatbot-workflows. Een onafhankelijk merk op Shopify miste piekconversies toen afrekenmodules haperden; een redactieteam kon snelle Q&A-schetsen niet afmaken doordat ChatGPT-vensters niet laadden; en een universitair lab verloor een ochtend analyse toen wachtrij-timeouts zich opstapelden. Wanneer frontoffice-tools en edge-caches falen, stroomt de impact geleidelijk door—eerst seconden, daarna omzet.

Denk aan een boetiek in Delhi genaamd Neem&Co. Het team gebruikte generatieve tools om productomschrijvingen te maken en real-time vertalingen te verzorgen. Tijdens de storing bleven productpagina’s stilstaan, winkelwagenaanroepen bleven hangen en konden ondersteuningsscripts niet snel worden opgesteld. Tegelijkertijd vond een fintech-operations team in Bengaluru dat vertrouwt op conversationele AI voor logtriage hun incidentkanaal onverwacht stil—niet door gebrek aan meldingen, maar door gebrek aan antwoorden. Herstel kwam pas toen routes stabiliseerden.

Waar de pijn zich concentreerde

- 🛒 E-commerce afreken- en zoekmodules die timed out raken

- 📰 Redacties die AI-ondersteunde tekstbewerkingen en samenvattingen verliezen

- 💼 HR- en wervingsteams die screeningsworkflows pauzeren

- 🎮 Gamingdiensten zoals League die sessies midden in de match onderbreken

- 💬 Messaging- en communityplatforms die rate-limit-muren ervaren

Wanneer statuspagina’s tussen groen en oranje heen en weer flikkerden, grepen teams naar continuïteitsplannen. Een populaire workaround was om eerdere prompts en outputs uit lokale of gesynchroniseerde archieven te halen. Gidsen over toegang tot gearchiveerde ChatGPT-gesprekken bleken nuttig om context te reconstrueren zonder live inferentie te belasten. Voor content-intensieve teams minimaliseerden overschakeling naar conceptrepositories of bevroren snapshots het werk opnieuw zodra diensten herstelden.

| Platform 🌐 | Waargenomen symptoom 🧩 | Ernstschaal 🌡️ | Voorgestelde tijdelijke oplossing 🧰 |

|---|---|---|---|

| X | Feeds en posts die stokken | Hoog 🔴 | Gebruik third-party planners, stel blasts uit |

| Shopify | Vertraging bij afrekenen | Hoog 🔴 | Activeer wachtrijpagina’s, leg e-mails vast |

| ChatGPT | Timeouts, lege vensters | Hoog 🔴 | Herbouw uit archieven, batchtaken offline |

| Discord | Botcommandofouten | Gemiddeld 🟠 | Handmatige moderatie en vastgepinde FAQ’s |

| League of Legends | Matchonderbrekingen | Gemiddeld 🟠 | Wachtrij cooldowns, statuscontroles |

Storingsdagen legden ook vaardigheidstekorten bloot. Wervingsteams die vertrouwden op AI-filters voor cv’s schakelden over op geselecteerde tools; bronnen zoals gratis AI-cv-hulpmiddelen hielpen het doorvoervolume te behouden zodra systemen stabiliseerden. Ondertussen balanseerden socialmediateams snelheid met nauwkeurigheid en weerstonden ze de verleiding om onbevestigde statusclaims te verspreiden.

Ondanks de verstoring bleef een patroon standhouden: teams die vooraf eenvoudige “slow mode”-schakelaars en batchworkflows bouwden, herstelden sneller. Dat veerkrachtthema vormt de praktische handleiding in de volgende sectie.

Workarounds tijdens AI-chatbotstoringen: teams productief houden

Wanneer een AI-chatbot zoals ChatGPT gehinderd wordt door edge-laagnaar storingen, hangt overleven af van contextcontinuïteit en slimme wachtrijvorming. Teams die de chatbot gebruiken voor samenvattingen, codebeoordeling of meertalige copy kunnen wrijving verminderen door over te schakelen van live oproepen naar gecachte assets en offline voorverwerking. Het doel is bescheiden: contextverlies verminderen terwijl ze wachten tot netwerkpaden normaliseren.

Identificeer eerst wat gedaan kan worden zonder verse inferentie. Veel taken—bestandsontleding, datacleaning en promptverbetering—kunnen offline gestaged worden, waarna ze uitgevoerd worden zodra capaciteit terugkeert. Documentatiebibliotheken, patroonprompts en standaardprocedures horen op snelle lokale opslag of een alleen-lezen mirror te staan, niet aan de andere kant van een drukke edge.

Checklist voor snelle respons bij dienstonderbreking

- 🧭 Controleer upstreamstatus en vermijd herhaalde harde verversingen

- 📦 Schakel over naar gecachte notities en gearchiveerde ChatGPT-gesprekken

- 🧮 Structuur invoer vooraf met ChatGPT-bestandsanalyse-achtige workflows

- 🔐 Rotatie of pauzeer integraties; bekijk hoe een ChatGPT API-sleutel te beheren

- 🔌 Schakel niet-essentiële extensies uit; herzie plugins die ChatGPT aandrijven in 2025

Voorkom contextamnesie door een interne promptbibliotheek en snapshot-exporten te onderhouden. Als jouw organisatie document-niveau runs gebruikt, bewaar dan gesaneerde data lokaal en push alleen als routes stabiel zijn. Voor product- en juridische teams kan een beknopte handleiding zoals begrip van case-toepassing risico’s, openbaarmaking en herstelstappen tijdens verslechterde operaties kaderen.

| Probleem 🚧 | Workaround 🔧 | Verwacht resultaat ✅ | Risico-opmerking ⚖️ |

|---|---|---|---|

| Timeouts bij prompts | Wacht taken offline af; batch later | Minder herhaalde pogingen, sneller bijwerken | Verouderde invoer bij bronwijziging |

| Verloren chatcontext | Laad uit archieven; pin sleutelprompts | Continuïteit zonder herwerk | Gedeeltelijke geschiedenis als exporten achterblijven |

| Plugin-afhankelijkheid | Uitschakelen; gebruik minimale promptketens | Minder edge-oproepen, minder 500-fouten | Functieverlies bij nichetaken |

| API-integratiestoringen | Gracieus terugschakelen met jitter | Stabiliteit onder belasting | Vertraagde pipeline-output |

Een andere onderschatte tactiek: oefen “handmatige modus” voor kernflows. Een contentteam dat vooraf een dozijn kopregelformules schrijft, loopt voor op een team dat wacht op live-inferentie. In veerkracht verslaat voorbereiding improvisatie altijd.

Binnen een Cloudflare-onderbreking: DNS, CDN en edge-routing onder druk

Cloudproviders falen zelden dramatisch op één punt; ze haperen door kleine misaligneringen die een kettingreactie veroorzaken. Een Cloudflare-gebeurtenis die “wijdverspreide 500-fouten” veroorzaakt, duidt op druk over meerdere lagen—DNS-resolutie, Anycast-routing, cache-vulling en WAF/rate-limitinglogica. Als control planes verzwakken naast data planes, is het effect cumulatief: klanten kunnen niet eens diagnose stellen; ze hebben moeite om dashboards te openen.

Denk aan de edge als een mesh van beslissingen. DNS moet de client naar de dichtstbijzijnde gezonde POP leiden; Anycast maakt die POP-selectie dynamisch; caching moet TTL’s en purges respecteren; en beveiligingslagen laten verzoeken op schaal door, dagen ze uit of blokkeren ze. Verander een verkeersbeleid op het verkeerde moment—of verspreid configuratie terwijl bepaalde regio’s al gespannen zijn—en je kunt een stabiel systeem in chaos duwen.

Fałlure modes die vandaag aan symptomen corresponderen

- 🌍 BGP of Anycast-drift die verkeer naar ongezonde regio’s stuurt

- 🛡️ WAF/rate-limit regels die pieken fout classificeren als misbruik

- 🧠 Control plane traagheid die configuratie rollback vertraagt

- 📦 Cache misses die origin-belasting tijdens purges doen exploderen

- 🔗 DNS TTL-mismatchen die herstelvertragingen veroorzaken

Observability is het tegenwicht. Multi-regio synthetische probes, edgelogs en origin-saturatiegrafieken kunnen symptoom opsplitsen van oorzaak. Technische teams die investeren in red/green deploy toggles en rollout rings kunnen de blastradius beperken terwijl ze nog steeds verouderde maar acceptabele inhoud aan de rand blijven serveren.

| Laag 🧱 | Waarschijnlijke stressor 🌪️ | Zichtbaar symptoom 👀 | Mitigatie 🧯 |

|---|---|---|---|

| DNS | TTL/config mismatch | Intermitterende resolutie | Korte TTL’s, gecontroleerde uitrol |

| Routing | Anycast/BGP-ongelijkheid | Regionale 500-pieken | Verkeerssturing, drain ongezonde POP’s |

| CDN-cache | Massale purges, hot misses | Origin-overbelasting | Serve-stale, prewarmen van populaire assets |

| Beveiliging | Agressieve WAF-regels | Valse positieven op schaal | Afstemmen/uitschakelen regels, ringed deploys |

| Control plane | API/dashboard traagheid | Trage rollbacks | Out-of-band toggles, playbooks |

Het bredere AI-landschap sprint naar gedistribueerde inferentie en slimmere edges, wat de veerkracht verhoogt. Industrieforums zoals NVIDIA GTC Washington DC inzichten en initiatieven waar NVIDIA samenwerkt met partners duiden op architecturen die lage-latentie inferentie combineren met multi-cloud routing. Nu AI “naar de edge beweegt,” kan redundantie geen bijzaak meer zijn.

Bij incidenten zoals vandaag is de boodschap consistent: het gaat niet alleen om het in de lucht houden van één enkele app—het gaat om het gezond houden van het web als verbindend weefsel.

Betrouwbaarheidslessen voor ChatGPT en internetdiensten na de storingen

Herstel is een test van architectuur en cultuur. Voor ChatGPT en haar afhankelijkheden ligt de weg vooruit in sterkere multi-regio-strategieën, gracieus degraderen en incidentcommunicatie die verwachtingen stelt zonder teveel te beloven. De inzet is simpel: wanneer storingen gebeuren—en dat zullen ze—moeten gebruikers alsnog een minimum bruikbaar resultaat behalen.

Begin met verkeersbeheer. Progressieve verkeersverschuiving, canarying in regionale ringen en automatische ontlasting van ongezonde POP’s creëren ademruimte. Aan de app-zijde ontwerp je voor “goed genoeg” antwoorden tijdens serveruitval: serveer recente samenvattingen, geef alleen-lezen geschiedenis en zet schrijfoperaties in de wachtrij. Voor ontwikkelaars-ecosystemen kunnen runtime-toggles die plugin-oproepen verminderen afhankelijkheid van externe edges verkleinen.

Een praktische betrouwbaarheidshandleiding

- 🧪 Chaos-oefeningen die failover en “serve stale” -beleid trainen

- 🌐 Multi-CDN met automatische padselectie onder stress

- 🧰 Fallbacks naar lichtere modellen of gecachte embeddings

- 📢 Duidelijke statusnotities die upstreamproviders noemen

- 📚 Publieke gidsen met link naar API-sleutelbeheer en governance

Veerkracht is niet alleen software. Inkoopteams moeten de organisatorische kosten van overmatige afhankelijkheid begrijpen; casestudy’s zoals de kosten van het ontslaan van een techgenie krijgen een andere lading wanneer één expert het incidenttraject van buiten kent. Ondertussen kan R&D die investeert in open-source frameworks voor robotica of gedistribueerde inferentie veerkrachtpatronen lenen voor AI op webschaal.

| Actie 📌 | Betrouwbaarheidswinst 📈 | Toolingsuggestie 🧩 | Gebruikerswaarde 💡 |

|---|---|---|---|

| Serve-stale modus | Hoog tijdens edge-uitval | CDN TTL-afstemming, cache-sleutels | Antwoorden blijven stromen ✅ |

| Ringed rollouts | Beperkt blastradius | Feature flags, geleidelijke uitrol | Minder voor gebruikers zichtbare onderbrekingen 🛡️ |

| Gracieus terugschakelen | Minder thundering herd | Exponentiële jitter, wachtrijen | Snellere stabilisatie 🕒 |

| Multi-CDN | Paddiversiteit | Sturing en gezondheidschecks | Lager foutvariance 🌐 |

| Communicatiehandleidingen | Vertrouwen behouden | Templates, statuscadans | Minder verwarring 📢 |

Voor teams die extensies en automatiseringen uitrollen helpt het om een slanke set mogelijkheden te kureren. Artikelen over plugins die ChatGPT aandrijven in 2025 kunnen sturen wat essentieel is om te behouden tijdens turbulentie, terwijl operationele hubs links naar triagepagina’s en backupdocumenten onderhouden. Verslaggeving van outlets zoals Hindustan Times toont waarom helderheid ertoe doet: op storingsdagen willen mensen liever richting dan drama.

Investeer tenslotte in leercycli. Postmortems die edge-telemetrie koppelen aan app-metrieken maken het volgende incident kleiner. Wanneer het web het platform is, is veerkracht het product.

Wie getroffen werd en hoe: het in kaart brengen van de cross-platform-impact van de Cloudflare-storing

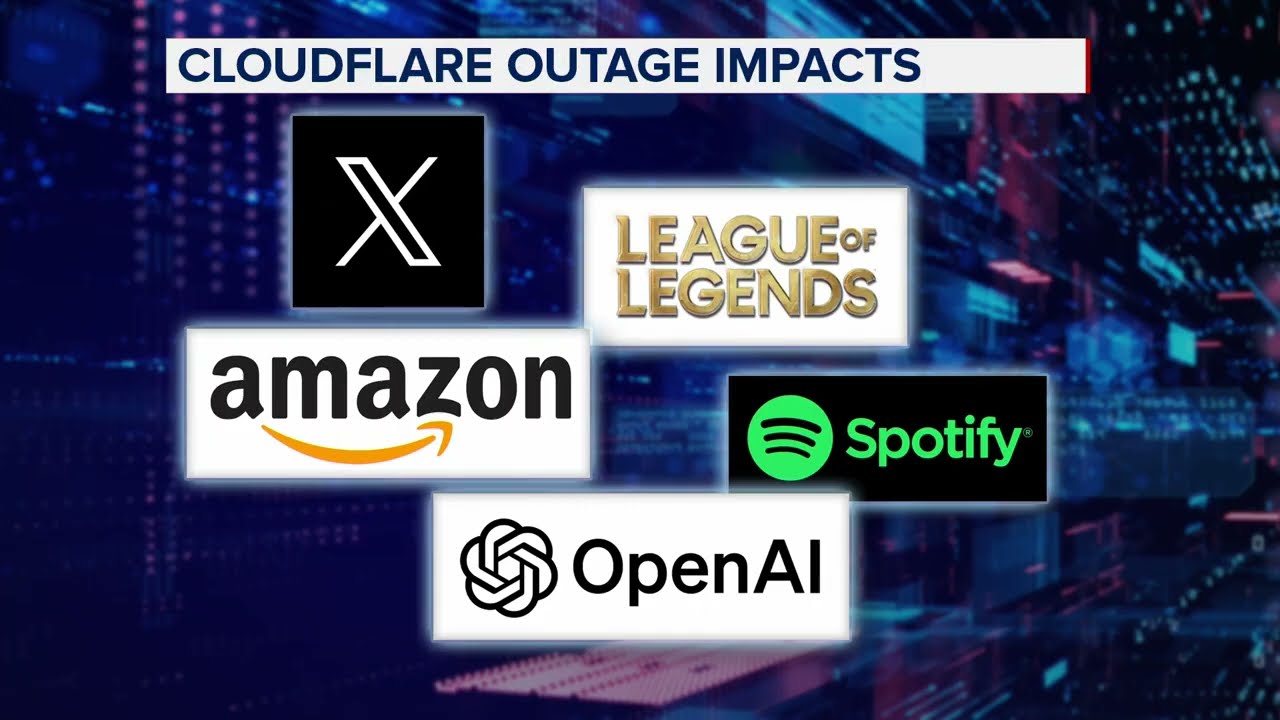

Naast ChatGPT raakte de Cloudflare-gebeurtenis ook een hele reeks merken: X, Canva, Shopify, Garmin, Claude, Verizon, Discord, T-Mobile en League of Legends behoorden tot de genoemde lezers. Wat deze uiteenlopende diensten verenigde was niet hun sector, maar hun gedeelde afhankelijkheid van een snel en veilig edge-weefsel. Terwijl dat weefsel rafelde, verschilden de ervaringen—sociale feeds stopten, loginflows faalden en gamesessies eindigden midden in de strijd.

Communicatiestijl maakte verschil. Platforms die voortijds transparante statusnotities plaatsten—met benoeming van upstreamproblemen, verwachte ETA’s en voorgestelde workarounds—zagen kalmere gemeenschappen. Anderen leerden hard dat stilte speculatie uitlokt. Teams die alternatieve workflows documenteerden, inclusief hoe recent chatcontext te herstellen, namen druk van hun ondersteuninglijnen.

Snapshot van verschillende sectoren

- 📣 Social: influencer-campagnes gepauzeerd; linkverkorters plaatsten posts in wachtrij

- 🛍️ Retail: flashsale-scripts uitgeschakeld; e-mailvastlegging prioritair

- 🧑🎓 Onderwijs: labs stelden inferentie-intensieve opdrachten uit

- 🛰️ Mapping/IoT: telemetrie opgeslagen tot routes herstelden

- 🎧 Supportdesks: macro’s vervingen AI-ondersteunde reacties

In elk geval verbeterde één principe de uitkomsten: degradeer gracieus. Of dat nu betekenen het serveren van gecachte etalagepagina’s, aanbieden van alleen-lezen tijdlijnen of gamers aansporen tot minder stressvolle wachtrijen was, de strategie was om iets nuttigs in de lucht te houden. Wanneer internetdiensten de ruggengraat van het dagelijks leven worden, is gedeeltelijke service beter dan geen.

| Sector 🧭 | Primaire afhankelijkheid 🔗 | Foutsymptoom 🚨 | Gracieus alternatief 🕊️ |

|---|---|---|---|

| Media | AI-ondersteunde bewerking | Gestopte concepten | Sjabloonbibliotheken, getimede releases |

| Handel | CDN-gecachede assets | Afrekenfouten | Wachtrijpagina’s, voorraadreserves |

| Gaming | Realtime sessies | Matchafbrekingen | Laag-latentie fallbackwachtrijen |

| Community | Bots en webhooks | Automatiseringslacunes | Vastgepinde FAQ’s, handmatige operaties |

| Support | Conversationele AI | Vertraagde antwoorden | Macro’s, status-samenvattingen |

Voor teams die upgrades plannen biedt lezen over samenwerkingen die AI aan de edge versterken een blauwdruk. Het gaat niet alleen om snelheid—betrouwbaarheid moet vanaf dag één ingebouwd zijn. Dat is de stille kop achter elke storingsdag.

{“@context”:”https://schema.org”,”@type”:”FAQPage”,”mainEntity”:[{“@type”:”Question”,”name”:”Why did ChatGPT go down during the Cloudflare incident?”,”acceptedAnswer”:{“@type”:”Answer”,”text”:”The pattern of widespread 500 errors, dashboard/API issues, and synchronized spikes across platforms points to an upstream edge-layer problem at Cloudflare. Application logic was healthy in many cases, but routing, caching, or control-plane stress impaired access and responses.”}},{“@type”:”Question”,”name”:”What immediate steps help during a service disruption?”,”acceptedAnswer”:{“@type”:”Answer”,”text”:”Check status pages, avoid constant hard refreshes, switch to cached notes and archived chats, and queue work offline. Disable nonessential plugins and apply graceful backoff if using APIs.”}},{“@type”:”Question”,”name”:”Which platforms were affected besides ChatGPT?”,”acceptedAnswer”:{“@type”:”Answer”,”text”:”Reports cited X, Shopify, Discord, Garmin, Claude, Verizon, T-Mobile, and League of Legends among those experiencing issues due to the Cloudflare interruption.”}},{“@type”:”Question”,”name”:”How can teams reduce the impact of future outages?”,”acceptedAnswer”:{“@type”:”Answer”,”text”:”Adopt multi-CDN strategies, enable serve-stale modes, practice chaos drills, and maintain clear incident communications. Use ringed rollouts and automated traffic steering to contain blast radius.”}},{“@type”:”Question”,”name”:”Where can I find practical guides and tools after outages?”,”acceptedAnswer”:{“@type”:”Answer”,”text”:”Resources like catalogs of ChatGPT error codes, API key management primers, plugin audits, and file-analysis workflows help accelerate recovery and reduce rework once services stabilize.”}}]}Waarom ging ChatGPT offline tijdens het Cloudflare-incident?

Het patroon van wijdverspreide 500-fouten, dashboard-/API-problemen en gesynchroniseerde pieken op meerdere platforms wijst op een probleem in de upstream edge-laag bij Cloudflare. De applicatielogica was in veel gevallen gezond, maar routing, caching of control-plane stress verstoorde toegang en reacties.

Welke onmiddellijke stappen helpen tijdens een dienstonderbreking?

Controleer statuspagina’s, vermijd constant hard refreshen, schakel over naar gecachte notities en gearchiveerde chats, en zet werk offline in wachtrij. Schakel niet-essentiële plugins uit en pas gracieus terugtrekken toe bij gebruik van API’s.

Welke platforms waren er naast ChatGPT getroffen?

Er werd melding gemaakt van X, Shopify, Discord, Garmin, Claude, Verizon, T-Mobile en League of Legends als platforms met problemen door de Cloudflare-onderbreking.

Hoe kunnen teams de impact van toekomstige storingen verminderen?

Neem multi-CDN-strategieën aan, schakel serve-stale-modi in, oefen chaos-oefeningen en onderhoud duidelijke incidentcommunicatie. Gebruik ringed rollouts en geautomatiseerde verkeerssturing om de blastradius te beperken.

Waar vind ik praktische gidsen en tools na storingen?

Resources zoals catalogi met ChatGPT-foutcodes, API-sleutelbeheergidsen, plugin-audits en bestandsanalyse-workflows helpen het herstel te versnellen en herwerk te verminderen zodra diensten stabiliseren.

-

Uncategorized17 hours ago

Uncategorized17 hours agoOntgrendel de Kracht van ChatGPT Groepschat Gratis: Een Stapsgewijze Handleiding om te Beginnen

-

AI-modellen1 day ago

AI-modellen1 day agoDe Beste ChatGPT-bibliotheken Verkennen om Je Projecten in 2025 te Verbeteren

-

AI-modellen20 hours ago

AI-modellen20 hours agovietnamese modellen in 2025: nieuwe gezichten en opkomende sterren om in de gaten te houden

-

Tools4 days ago

Tools4 days agoHoe een ap spanish score calculator te gebruiken voor nauwkeurige resultaten in 2025

-

Uncategorized3 days ago

Uncategorized3 days agoVerkenning van proefversies nyt: wat te verwachten in 2025

-

Uncategorized2 days ago

Uncategorized2 days agoChatGPT Gegevenslek: Gebruikersnamen en e-mails gelekt; Bedrijf dringt aan op voorzichtigheid en herinnert gebruikers eraan waakzaam te blijven