Servicio de ChatGPT Interrumpido: Interrupción de Cloudflare Provoca Fallos Globales y Errores 500

Olas de inestabilidad recorrieron la web cuando una Interrupción de Cloudflare empujó los servicios perimetrales principales hacia la turbulencia, dejando a los Usuarios reportando Fallos generalizados en ChatGPT y otras plataformas de alto tráfico. El patrón se parecía a una falla en la red ascendente más que a problemas aislados a nivel de aplicación, evidenciado por señales simultáneas de Tiempo de Inactividad del Servidor, errores en los paneles de control y respuestas 500. Para la tarde, los informes registraban más de 11,000 incidentes vinculados a X, mientras los lectores de Hindustan Times describían desconexiones repentinas a mitad del mensaje en el Chatbot de IA, paneles en blanco y mensajes de “error de red”.

Indicadores tempranos fueron visibles mucho antes de que los horarios se actualizaran. Downdetector trazó un aumento desde aproximadamente 15 quejas base hasta 38 alrededor de las 3:34 AM, seguido por picos agudos durante el día—firmas clásicas de una falla en la capa de borde ascendente. Cloudflare reconoció “errores 500 generalizados,” junto con servicios de Internet degradados incluyendo el Panel de Control, API e incluso su propio portal de soporte. Paralelamente, el 90% de las quejas por fallos se centraron en ChatGPT específicamente, subrayando cuán dependientes se han vuelto los flujos de trabajo de IA en tiempo real de las redes de borde.

Lo que vieron los usuarios y por qué importaba

Los síntomas se agruparon alrededor de solicitudes que agotaban el tiempo, contexto desaparecido y paneles de UI que se negaban a renderizar. Para equipos con fechas límite, una ventana de inferencia congelada no es solo una molestia—detiene las líneas de decisión en revisiones de código, producción de contenido y resumen de datos. El problema se agravaba cuando los reintentos de failover chocaban con los mismos cuellos de botella ascendentes, convirtiendo las actualizaciones ordinarias en bucles.

- 🔴 Fallos de sesión a mitad de conversación, que a menudo devuelven errores de clase 500

- ⚠️ Resultados en blanco o “no se puede cargar el historial” al recuperar chats

- 🕒 Demoras largas en la inferencia seguidas de desconexiones abruptas

- 🔁 Recargas repetidas sin recuperación de contexto para tareas en curso

- 🧭 Señales de estado confusas debido a fallos simultáneos de múltiples servicios

Cuando aparecieron los códigos de error, apuntaban a inconsistencias infraestructurales. Los equipos que mantienen un catálogo de códigos de error de ChatGPT pudieron diagnosticar rápidamente qué era transitorio versus qué requería acción. Sin embargo, en un día como este, las raíces estaban fuera del control de la aplicación, haciendo que la paciencia y la planificación de contingencia fueran tan vitales como la depuración.

| Marca temporal (local) ⏰ | Señal capturada 📊 | Lo que sugería 🧭 | Impacto en el usuario 😬 |

|---|---|---|---|

| 03:34 AM | 38 quejas vs ~15 base | Inestabilidad upstream temprana | Acceso intermitente a ChatGPT |

| Pico matutino | Picos agudos multi-plataforma | Fallo en capa de borde/CDN | Paneles en blanco, 500s, reintentos |

| Para las 5 PM | 11,000+ reportes de fallos en X | Alcance amplio de consumidores | Redes sociales y noticias detenidas |

| Durante todo el día | Problemas en panel/API de Cloudflare | Impairment del proveedor | Demoras en soporte y mitigaciones lentas |

Para quien preguntara “¿Soy yo o la red?” la telemetría del día ofrecía una respuesta clara: esto fue una sacudida a nivel de columna vertebral, no un fallo de una sola aplicación. El episodio refuerza una verdad de la computación moderna—la IA depende del borde, y cuando el borde cojea, la productividad cojea con él.

Cómo sintieron los usuarios y empresas el tiempo de inactividad del servidor a través de los servicios de Internet

La Interrupción del Servicio se propagó por comercio, medios, educación y logística, demostrando cuán entrelazados están los Servicios de Internet con los flujos de trabajo de Chatbot de IA. Una marca independiente en Shopify perdió conversiones en horas pico cuando los módulos de pago se retrasaron; una sala de redacción con borradores rápidos de preguntas y respuestas se detuvo porque las ventanas de ChatGPT no cargaban; y un laboratorio universitario perdió una mañana de análisis mientras los mensajes en cola fallaban por agotamiento de tiempos. Cuando las herramientas de oficina y las cachés de borde fallan, el impacto fluye gradualmente—primero segundos, luego ingresos.

Considera una boutique en Delhi llamada Neem&Co. El equipo usaba herramientas generativas para crear descripciones de productos y traducirlas en tiempo real. Durante la interrupción, las páginas de producto quedaron estáticas, las llamadas al carrito se detuvieron y los guiones de soporte no pudieron hacerse rápido. En paralelo, un equipo fintech en Bengaluru que dependía de IA conversacional para la clasificación de incidentes encontró su canal de incidentes inesperadamente silencioso—no por falta de alertas, sino por falta de respuestas. La recuperación llegó solo cuando las rutas se estabilizaron.

Dónde se concentró el dolor

- 🛒 Módulos de pago y búsqueda en e-commerce agotando tiempo

- 📰 Salas de redacción perdiendo ediciones y resúmenes asistidos por IA

- 💼 Equipos de RRHH y reclutamiento pausando flujos de selección

- 🎮 Servicios de juego como partidas de League interrumpidas a mitad

- 💬 Plataformas de mensajería y comunidades enfrentando límites de tasa

Cuando las páginas de estado parpadeaban entre verde y naranja, los equipos acudían a planes de continuidad. Una solución popular era recuperar mensajes y resultados previos de archivos locales o sincronizados. Guías sobre cómo acceder a conversaciones archivadas de ChatGPT fueron útiles para reconstruir contexto sin llamar a inferencia en vivo. Para equipos con mucho contenido, cambiar a repositorios de borradores o capturas congeladas minimizaba re-trabajos una vez que los servicios se recuperaban.

| Plataforma 🌐 | Síntoma observado 🧩 | Escala de severidad 🌡️ | Solución temporal sugerida 🧰 |

|---|---|---|---|

| X | Bloqueos en feed y publicaciones | Alta 🔴 | Usar programadores de terceros, retrasar envíos |

| Shopify | Latencia en pagos | Alta 🔴 | Habilitar páginas de cola, capturar emails |

| ChatGPT | Agotamientos de tiempo, paneles en blanco | Alta 🔴 | Reconstruir desde archivos, procesar tareas fuera de línea |

| Discord | Fallos en comandos de bots | Media 🟠 | Moderación manual y FAQs fijadas |

| League of Legends | Interrupciones en partidas | Media 🟠 | Colas en enfriamiento, chequeos de estado |

Los días de fallos también revelaron brechas de habilidades. Los equipos de reclutamiento que dependían de filtros de IA para currículums se inclinaron hacia listas de herramientas curadas; recursos como herramientas gratuitas de currículum con IA ayudaron a mantener el flujo una vez que los sistemas se estabilizaron. Mientras tanto, los equipos sociales equilibraron oportunidad con precisión, resistiendo la tentación de amplificar reclamos de estado no verificados.

A pesar de la interrupción, un patrón se mantuvo: los equipos que preconstruyeron simples modos de “funcionamiento lento” y flujos por lotes rebotaron más rápido. Ese tema de resiliencia prepara el manual práctico para la siguiente sección.

Soluciones durante las interrupciones del Chatbot de IA: manteniendo la productividad de los equipos

Cuando un Chatbot de IA como ChatGPT se ve afectado por Fallos en la capa de borde, la supervivencia depende de la continuidad del contexto y la gestión inteligente de colas. Los equipos que dependen del chatbot para resúmenes, revisión de código o copia multilingüe pueden mitigar fricciones desplazándose de llamadas en vivo a activos en caché y preprocesamiento offline. El objetivo es modesto: reducir la pérdida de contexto mientras esperan que las rutas de red se normalicen.

Primero, identifica lo que se puede hacer sin inferencia fresca. Muchas tareas—análisis de archivos, limpieza de datos y afinamiento de mensajes—pueden prepararse offline y ejecutarse cuando regresa la capacidad. Bibliotecas de documentación, mensajes patrones y procedimientos operativos estándar deben reservarse en almacenamiento local rápido o espejos de solo lectura, no al otro lado de un borde congestionado.

Lista rápida de verificación para interrupción del servicio

- 🧭 Verifica el estado upstream y evita actualizaciones duras repetidas

- 📦 Cambia a notas en caché y conversaciones archivadas de ChatGPT

- 🧮 Preestructura entradas con flujos tipo análisis de archivos de ChatGPT

- 🔐 Rota o pausa integraciones; revisa cómo dominar una clave API de ChatGPT

- 🔌 Deshabilita extensiones no esenciales; revisita plugins que impulsan ChatGPT en 2025

Evita la amnesia de contexto manteniendo una biblioteca interna de mensajes y exportaciones de capturas. Si tu organización usa ejecuciones a nivel documental, guarda datos sanitizados localmente y empuja solo cuando las rutas sean estables. Para equipos de producto y legales, un resumen conciso como comprender la aplicación de casos puede enmarcar riesgo, divulgación y pasos de recuperación durante operaciones degradadas.

| Problema 🚧 | Solución temporal 🔧 | Resultado esperado ✅ | Nota de riesgo ⚖️ |

|---|---|---|---|

| Agotamientos de tiempo en mensajes | Encolar tareas offline; procesar por lotes luego | Reducción de reintentos, recuperación más rápida | Entradas obsoletas si la fuente cambia |

| Contexto de chat perdido | Cargar desde archivos; fijar mensajes clave | Continuidad sin retrabajo | Historia parcial si exportaciones se retrasan |

| Dependencia de plugins | Deshabilitar; usar cadenas de mensajes mínimas | Llamadas de borde reducidas, menos errores 500 | Pérdida de funciones en tareas específicas |

| Paros en integración API | Retiro gradual con jitter | Estabilidad bajo carga | Salida de datos retrasada |

Una táctica subestimada: ensayar el “modo manual” para flujos clave. Un equipo de contenido que pre-escribe una docena de fórmulas de titulares superará a un equipo esperando inferencia en vivo. En resiliencia, la preparación vence a la improvisación siempre.

Dentro de una interrupción de Cloudflare: DNS, CDN y enrutamiento de borde bajo estrés

Los proveedores de nube rara vez fallan en puntos únicos dramáticos; fallan por pequeños desajustes que se propagan. Un evento de Cloudflare que genera “errores 500 generalizados” sugiere presión en múltiples capas—resolución DNS, enrutamiento Anycast, población de cachés y lógica de WAF/límites de tasa. Si los planos de control se degradan junto a los planos de datos, el efecto se agrava: los clientes no solo no pueden diagnosticar; tienen dificultades hasta para abrir paneles.

Pensemos en el borde como una malla de decisiones. DNS debe dirigir al cliente al POP saludable más cercano; Anycast vuelve dinámica la selección del POP; el cacheo debe respetar TTLs y purgas; y las capas de seguridad pasan, desafían o bloquean solicitudes a gran escala. Cambiar una política de tráfico en el momento equivocado—o propagar configuración cuando ciertas regiones ya están tensionadas—puede empujar un sistema estable al caos.

Modos de falla que corresponden a los síntomas del día

- 🌍 Deriva de BGP o Anycast enviando tráfico a regiones no saludables

- 🛡️ Reglas WAF/límites de tasa que clasifican picos como abusivos

- 🧠 Lentitud del plano de control retrasando reversión de configuraciones

- 📦 Fallos de caché que aumentan la carga de origen durante purgas

- 🔗 Desajustes en TTL DNS que alargan la recuperación

La observabilidad es el contrapeso. Sondeos sintéticos multirregionales, logs de borde y gráficos de saturación de origen pueden separar síntoma de causa. Los equipos técnicos que invierten en toggles rojo/verde y despliegues en anillos pueden contener el radio de impacto mientras continúan sirviendo contenido obsoleto pero aceptable en el borde.

| Capa 🧱 | Estresor probable 🌪️ | Síntoma visible 👀 | Mitigación 🧯 |

|---|---|---|---|

| DNS | Desajuste TTL/configuración | Resolución intermitente | TTLs cortos, despliegues controlados |

| Enrutamiento | Desbalance Anycast/BGP | Picos regionales 500 | Direccionamiento de tráfico, vaciar POPs no saludables |

| Cache CDN | Purgas masivas, fallos calientes | Saturación del origen | Servir obsoleto, precalentar activos populares |

| Seguridad | Reglas WAF agresivas | Falsos positivos masivos | Ajustar/deshabilitar reglas, despliegues en anillos |

| Plano de control | Retardo en API/panel | Reversiones lentas | Toggles fuera de banda, manuales de juego |

El panorama general de IA avanza rápidamente hacia inferencia distribuida y bordes más inteligentes, lo que eleva las apuestas de resiliencia. Foros industriales como insights de NVIDIA GTC Washington DC e iniciativas donde NVIDIA colabora con socios sugieren arquitecturas que combinan inferencia de baja latencia con enrutamiento multinube. A medida que la IA “se mueve al borde,” la redundancia ya no puede ser una ocurrencia tardía.

En incidentes como el de hoy, el mensaje es consistente: no se trata solo de mantener viva una sola aplicación—se trata de mantener saludable el tejido conectivo de la web.

Lecciones de fiabilidad para ChatGPT y servicios de Internet tras los fallos

La recuperación es una prueba de arquitectura y cultura. Para ChatGPT y sus dependientes, el camino a seguir implica estrategias multi-región más fuertes, degradación elegante y comunicaciones de incidentes que establecen expectativas sin sobreprometer. El premio es simple: cuando ocurran fallos—y sucederán—los Usuarios deben aún lograr un resultado mínimo viable.

Comienza con el control de tráfico. Cambios progresivos de tráfico, canarys en anillos regionales y drenaje automático de POPs no saludables brindan espacio para respirar. En el lado de la aplicación, diseña para respuestas “lo suficientemente buenas” durante tiempos de inactividad del servidor: sirve resúmenes recientes, permite historial de solo lectura y encola operaciones de escritura. Para ecosistemas de desarrollo, toggles en tiempo de ejecución que reducen llamadas a plugins pueden disminuir dependencia en bordes externos.

Manual práctico de fiabilidad

- 🧪 Simulacros de caos que practiquen failover y políticas de “servir obsoleto”

- 🌐 Multi-CDN con selección automatizada de ruta bajo estrés

- 🧰 Respaldo a modelos más ligeros o embeddings en caché

- 📢 Notas claras de estado que referencien proveedores ascendentes

- 📚 Guías públicas enlazando a administración de claves API y gobernanza

La resiliencia no es solo software. Los equipos de compras deben comprender el costo organizacional de la sobredependencia; estudios de caso como el costo de despedir a un genio tecnológico se leen distinto cuando un solo experto conoce el camino del incidente al dedillo. Mientras tanto, I+D que invierte en marcos open-source para robótica o inferencia distribuida puede tomar prestados patrones de resiliencia para IA a escala web.

| Acción 📌 | Ganancia en fiabilidad 📈 | Sugerencia de herramientas 🧩 | Valor para el usuario 💡 |

|---|---|---|---|

| Modo servir obsoleto | Alto durante pérdidas de borde | Ajuste TTL CDN, claves de caché | Las respuestas siguen fluyendo ✅ |

| Despliegues en anillos | Contienen radio de impacto | Flags de función, despliegues graduales | Menos interrupciones visibles para usuarios 🛡️ |

| Retiro gradual elegante | Menos “manada de ciervos” | Jitter exponencial, colas | Estabilización más rápida 🕒 |

| Multi-CDN | Diversidad de rutas | Direccionamiento y chequeos de salud | Menor variabilidad de errores 🌐 |

| Manuales de comunicación | Confianza preservada | Plantillas, cadencia de estado | Confusión reducida 📢 |

Para equipos que lanzan extensiones y automatizaciones, curar un conjunto reducido de capacidades ayuda. Artículos sobre plugins que impulsan ChatGPT en 2025 pueden guiar qué es esencial mantener durante la turbulencia, mientras los hubs de operaciones mantienen enlaces a páginas de triage y documentos de respaldo. La cobertura de medios como Hindustan Times demuestra por qué la claridad importa: en días de fallos, la gente quiere dirección más que drama.

Finalmente, invierte en ciclos de aprendizaje. Postmortems que correlacionan telemetría de borde con métricas de aplicación hacen que el siguiente incidente sea menor. Cuando la web es la plataforma, la resiliencia es el producto.

Quién fue afectado y cómo: mapeando el impacto multiplataforma de la interrupción de Cloudflare

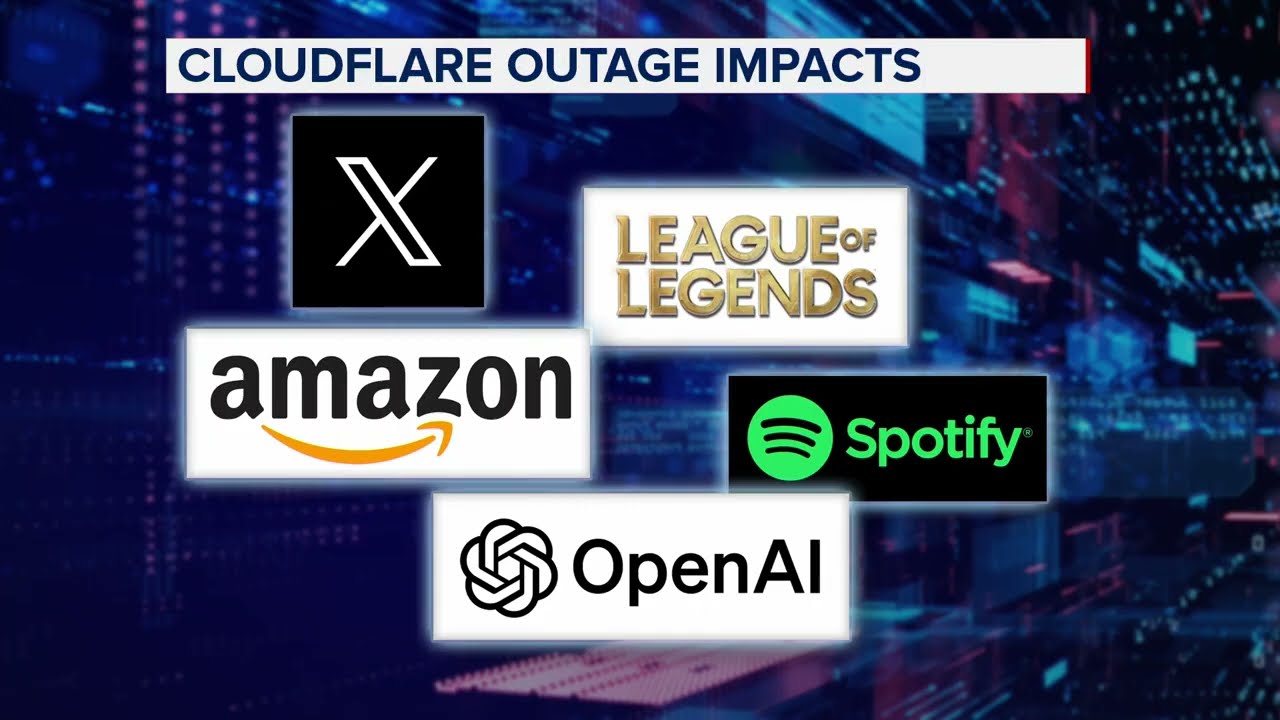

Más allá de ChatGPT, el evento de Cloudflare tocó una constelación de marcas: X, Canva, Shopify, Garmin, Claude, Verizon, Discord, T-Mobile y League of Legends entre las listas de lectores. Lo que unía a estos servicios dispares no era su vertical, sino su dependencia compartida en una tela de borde rápida y segura. A medida que la tela se rasgaba, las experiencias divergían—feeds sociales detenidos, flujos de inicio de sesión rotos y partidas terminadas a mitad de batalla.

El estilo de comunicación marcó la diferencia. Plataformas que cargaron con notas de estado transparentes—mencionando problemas ascendentes, ETAs esperados y soluciones sugeridas—vieron comunidades más calmadas. Otros aprendieron por las malas que el silencio invita a la especulación. Equipos que documentaron flujos alternativos, incluyendo cómo recuperar contexto reciente de chat, aliviaron presión en sus líneas de soporte.

Instantáneas por industria

- 📣 Social: Campañas de influencers pausadas; acortadores de enlaces encolaron publicaciones

- 🛍️ Retail: Scripts de ventas flash deshabilitados; prioritización en captura de emails

- 🧑🎓 Educación: Laboratorios reprogramaron tareas intensivas en inferencia

- 🛰️ Mapeo/IoT: Telemetría almacenada hasta que las rutas se recuperaron

- 🎧 Mesas de soporte: Macros reemplazaron respuestas asistidas por IA

En cada caso, un principio único mejoró los resultados: degradarse elegantemente. Ya sea sirviendo páginas de tienda en caché, ofreciendo líneas de tiempo de solo lectura o empujando a gamers a colas de menor estrés, la estrategia era mantener algo útil en línea. Cuando los Servicios de Internet se vuelven la columna vertebral de la vida diaria, un servicio parcial es mejor que ninguno.

| Sector 🧭 | Dependencia principal 🔗 | Síntoma de falla 🚨 | Alternativa elegante 🕊️ |

|---|---|---|---|

| Medios | Edición asistida por IA | Borradores detenidos | Bibliotecas de plantillas, lanzamientos temporizados |

| Comercio | Activos en caché CDN | Errores en pago | Páginas en cola, retención de inventario |

| Juegos | Sesiones en tiempo real | Caídas en partidas | Colas de respaldo de baja latencia |

| Comunidad | Bots y webhooks | Huecos en automatización | FAQs fijadas, operaciones manuales |

| Soporte | IA conversacional | Respuestas tardías | Macros, fragmentos de estado |

Para equipos que planean actualizaciones, leer sobre colaboraciones que fortalecen la IA en el borde ofrece un plan. No se trata solo de velocidad—la fiabilidad debe diseñarse desde el día uno. Ese es el titular silencioso detrás de cada día de fallos.

{“@context”:”https://schema.org”,”@type”:”FAQPage”,”mainEntity”:[{“@type”:”Question”,”name”:”¿Por qué ChatGPT se cayó durante el incidente de Cloudflare?”,”acceptedAnswer”:{“@type”:”Answer”,”text”:”El patrón de errores 500 generalizados, problemas en panel/API y picos sincronizados en plataformas apunta a un problema en la capa de borde ascendente en Cloudflare. La lógica de aplicación estaba sana en muchos casos, pero el enrutamiento, cacheo o estrés en el plano de control perjudicaron el acceso y las respuestas.”}},{“@type”:”Question”,”name”:”¿Qué pasos inmediatos ayudan durante una interrupción del servicio?”,”acceptedAnswer”:{“@type”:”Answer”,”text”:”Consulta las páginas de estado, evita actualizaciones duras constantes, cambia a notas en caché y chats archivados, y encola trabajo offline. Deshabilita plugins no esenciales y aplica retiro gradual si usas APIs.”}},{“@type”:”Question”,”name”:”¿Qué plataformas se vieron afectadas además de ChatGPT?”,”acceptedAnswer”:{“@type”:”Answer”,”text”:”Los informes citaron a X, Shopify, Discord, Garmin, Claude, Verizon, T-Mobile y League of Legends entre los afectados por la interrupción de Cloudflare.”}},{“@type”:”Question”,”name”:”¿Cómo pueden los equipos reducir el impacto de futuros fallos?”,”acceptedAnswer”:{“@type”:”Answer”,”text”:”Adoptar estrategias multi-CDN, habilitar modos servir obsoleto, practicar simulacros de caos y mantener comunicaciones claras de incidentes. Usar despliegues en anillos y direccionamiento automatizado para contener el radio de impacto.”}},{“@type”:”Question”,”name”:”¿Dónde puedo encontrar guías prácticas y herramientas después de los fallos?”,”acceptedAnswer”:{“@type”:”Answer”,”text”:”Recursos como catálogos de códigos de error de ChatGPT, resúmenes de administración de claves API, auditorías de plugins y flujos de análisis de archivos ayudan a acelerar la recuperación y reducir retrabajo una vez estabilizados los servicios.”}}]}¿Por qué ChatGPT se cayó durante el incidente de Cloudflare?

El patrón de errores 500 generalizados, problemas en panel/API y picos sincronizados en plataformas apunta a un problema en la capa de borde ascendente en Cloudflare. La lógica de aplicación estaba sana en muchos casos, pero el enrutamiento, cacheo o estrés en el plano de control perjudicaron el acceso y las respuestas.

¿Qué pasos inmediatos ayudan durante una interrupción del servicio?

Consulta las páginas de estado, evita actualizaciones duras constantes, cambia a notas en caché y chats archivados, y encola trabajo offline. Deshabilita plugins no esenciales y aplica retiro gradual si usas APIs.

¿Qué plataformas se vieron afectadas además de ChatGPT?

Los informes citaron a X, Shopify, Discord, Garmin, Claude, Verizon, T-Mobile y League of Legends entre los afectados por la interrupción de Cloudflare.

¿Cómo pueden los equipos reducir el impacto de futuros fallos?

Adoptar estrategias multi-CDN, habilitar modos servir obsoleto, practicar simulacros de caos y mantener comunicaciones claras de incidentes. Usar despliegues en anillos y direccionamiento automatizado para contener el radio de impacto.

¿Dónde puedo encontrar guías prácticas y herramientas después de los fallos?

Recursos como catálogos de códigos de error de ChatGPT, resúmenes de administración de claves API, auditorías de plugins y flujos de análisis de archivos ayudan a acelerar la recuperación y reducir retrabajo una vez estabilizados los servicios.

-

Modelos de IA20 hours ago

Modelos de IA20 hours agomodelos vietnamitas en 2025: nuevas caras y estrellas emergentes para observar

-

Tecnologia8 hours ago

Tecnologia8 hours agoUna visión integral del panorama tecnológico en Palo Alto para 2025

-

17 hours ago

17 hours agoDesbloquea el Poder del Chat en Grupo de ChatGPT Gratis: Una Guía Paso a Paso para Comenzar

-

Tecnologia3 days ago

Tecnologia3 days agoSu tarjeta no admite este tipo de compra: qué significa y cómo solucionarlo

-

Modelos de IA3 days ago

Modelos de IA3 days agoOpenAI vs Tsinghua: Elegir entre ChatGPT y ChatGLM para tus necesidades de IA en 2025

-

6 hours ago

6 hours agoPresentando una versión gratuita de ChatGPT diseñada específicamente para educadores