ChatGPT-Dienst gestört: Cloudflare-Unterbrechung löst globale Ausfälle und 500-Fehler aus

Wellen der Instabilität rollten durchs Web, als eine Cloudflare-Unterbrechung Kern-Edge-Dienste in Turbulenzen versetzte und Benutzer weit verbreitete Ausfälle für ChatGPT und andere stark frequentierte Plattformen meldeten. Das Muster ähnelte einem Ausfall im vorgelagerten Netzwerk statt isolierten App-Einzelfällen, belegt durch gleichzeitige Server-Ausfallzeiten, Dashboard-Fehler und 500-Antworten. Am späten Nachmittag wurden über 11.000 Vorfälle im Zusammenhang mit X gemeldet, während Leser der Hindustan Times plötzliche Verbindungsabbrüche mitten im Prompt, leere Fenster und „Netzwerkfehler“-Meldungen beim KI-Chatbot beschrieben.

Frühe Indikatoren waren schon lange vor den offiziellen Zeitlinien sichtbar. Downdetector zeichnete einen Anstieg von etwa 15 Basisbeschwerden auf 38 gegen 3:34 Uhr auf, gefolgt von starken Spitzen im Verlauf des Tages – klassische Signale eines Fehlers in der vorgelagerten Edge-Schicht. Cloudflare räumte „weitverbreitete 500-Fehler“ ein, neben beeinträchtigten Internetdiensten wie dem Dashboard, der API und sogar dem eigenen Support-Portal. Parallel entfielen 90 % der Ausfallbeschwerden speziell auf ChatGPT, was die Abhängigkeit Echtzeit-KI-Workflows von Edge-Netzwerken unterstreicht.

Was Benutzer sahen und warum es wichtig war

Symptome konzentrierten sich um zeitüberschrittene Prompts, verlorenen Kontext und UI-Fenster, die nicht renderten. Für Teams unter Zeitdruck ist ein eingefrorenes Inferenzfenster kein bloßes Ärgernis – es blockiert Entscheidungsprozesse bei Code-Reviews, Content-Produktion und Datensummierung. Das Problem vergrößerte sich, wenn Failover-Wiederholungen dieselben vorgelagerten Engpässe trafen und gewöhnliche Aktualisierungen in Schleifen verwandelten.

- 🔴 Sitzungsfehler mitten im Gespräch, oft mit 500er-Klasse-Fehlern

- ⚠️ Leere Ausgaben oder „Verlauf kann nicht geladen werden“ beim Abruf von Chats

- 🕒 Lange Inferenzverzögerungen gefolgt von abrupten Verbindungsabbrüchen

- 🔁 Wiederholtes Nachladen ohne Kontextwiederherstellung für laufende Aufgaben

- 🧭 Verwirrende Statussignale, da mehrere Dienste gleichzeitig ausfielen

Wenn Fehlermeldungen auftraten, deuteten sie auf infrastrukturelle Inkonsistenzen hin. Teams, die ein Verzeichnis der ChatGPT-Fehlercodes führen, konnten schnell unterscheiden, was vorübergehend war und was Handlungsbedarf auslöste. An einem solchen Tag lagen die Ursachen jedoch außerhalb der Anwendungssteuerung, sodass Geduld und Notfallplanungen ebenso wichtig waren wie das Debugging.

| Zeitstempel (lokal) ⏰ | Erfasster Signalwert 📊 | Was es nahelegte 🧭 | Benutzer-Auswirkung 😬 |

|---|---|---|---|

| 03:34 Uhr | 38 Beschwerden vs. ca. 15 Basiswert | Frühe vorgelagerte Instabilität | Intermittierender ChatGPT-Zugang |

| Vormittagspitze | Starke plattformübergreifende Spitzen | Verbreitung von Edge/CDN-Fehlern | Leere Fenster, 500er, Wiederholungen |

| Bis 17 Uhr | 11.000+ X-Ausfallmeldungen | Weite Verbrauchererreichbarkeit | Soziale und Nachrichten-Feeds brachen zusammen |

| Währenddessen | Cloudflare Dashboard/API-Probleme | Beeinträchtigungen auf Anbieterseite | Support-Verzögerungen und langsame Maßnahmen |

Für alle, die sich fragten „Bin ich schuld oder das Netzwerk?“ gab die Telemetrie des Tages eine klare Antwort: Das war ein Erschütterung auf Backbone-Ebene, kein einzelner App-Ausfall. Das Ereignis bestätigt eine Wahrheit der modernen IT – KI hängt vom Edge ab, und wenn der Edge wackelt, gerät auch die Produktivität ins Wanken.

Wie Benutzer und Unternehmen die Server-Ausfallzeiten über Internetdienste erlebten

Die Dienstunterbrechung breitete sich auf Handel, Medien, Bildung und Logistik aus und zeigte, wie eng Internetdienste mit KI-Chatbot-Workflows verwoben sind. Eine Indie-Marke auf Shopify verpasste Spitzenstunden-Konversionen, weil Checkout-Module verzögerten; eine Redaktion stagnierte bei schnellen Q&A-Entwürfen, weil ChatGPT-Fenster nicht luden; und ein Universitätslabor verlor einen Morgen voller Analyse, da Warteschlangen-Prompt-Timeouts sich häuften. Wenn Front-Office-Tools und Edge-Caches ausfallen, wirken sich die Folgen allmählich aus – erst Sekunden, dann Umsätze.

Betrachten wir die auf Delhi basierende Boutique Neem&Co. Das Team nutzte generative Tools zur Echtzeit-Erstellung von Produktbeschreibungen und Übersetzungen. Während der Ausfälle blieben Produktseiten stehen, Warenkorb-Anfragen stockten und Support-Skripte konnten nicht schnell erstellt werden. Parallel dazu war ein Fintech-Betriebsteam in Bengaluru, das auf konversationale KI zur Log-Triage setzte, überrascht still – nicht wegen mangelnder Warnungen, sondern fehlender Antworten. Die Erholung erfolgte erst, als die Routen sich stabilisierten.

Wo sich der Schmerz konzentrierte

- 🛒 E-Commerce-Checkout- und Suchmodule zeitüberschritten

- 📰 Redaktionen verloren KI-unterstützte Korrekturen und Zusammenfassungen

- 💼 HR- und Recruiting-Teams pausierten Screening-Workflows

- 🎮 Gaming-Dienste wie League mit Sitzungsunterbrechungen mitten im Spiel

- 💬 Messaging- und Community-Plattformen stießen auf Rate-Limiting-Barrieren

Wenn Statusseiten zwischen Grün und Orange flackerten, griffen Teams zu Kontinuitätsplänen. Ein beliebter Workaround bestand darin, frühere Prompts und Ausgaben aus lokalen oder synchronisierten Archiven abzurufen. Anleitungen zum Zugriff auf archivierte ChatGPT-Gespräche halfen beim Wiederaufbau des Kontexts ohne Live-Inferenz. Für content-lastige Teams minimierte der Wechsel zu Entwurfs-Repositories oder eingefrorenen Schnappschüssen den Mehraufwand, sobald Dienste wieder funktionierten.

| Plattform 🌐 | Beobachtetes Symptom 🧩 | Schweregrad 🌡️ | Vorgeschlagene Zwischenlösung 🧰 |

|---|---|---|---|

| X | Feeds und Postings gestoppt | Hoch 🔴 | Drittanbieter-Scheduler verwenden, Aussendungen verzögern |

| Shopify | Checkout-Verzögerungen | Hoch 🔴 | Warteseiten aktivieren, E-Mails erfassen |

| ChatGPT | Timeouts, leere Fenster | Hoch 🔴 | Aus Archiven neu aufbauen, Aufgaben offline bündeln |

| Discord | Bot-Befehlsfehler | Mittel 🟠 | Manuelle Moderation, angepinnte FAQs |

| League of Legends | Sitzungsunterbrechungen | Mittel 🟠 | Warteschlangen-Abkühlung, Statusprüfungen |

Ausfalltage beleuchteten auch Qualifikationslücken. Recruiting-Teams, die auf KI-Filter für Lebensläufe setzten, wechselten zu kuratierten Tool-Listen; Ressourcen wie kostenlose KI-Lebenslauftools halfen, den Durchsatz zu halten, sobald Systeme stabilisiert waren. Gleichzeitig balancierten Social-Teams Aktualität und Genauigkeit, widerstanden dem Drang, unbestätigte Statusmeldungen zu verbreiten.

Trotz der Störung hielt sich ein Muster: Teams, die einfache „Slow Mode“-Schalter und Batch-Workflows vorab eingerichtet hatten, erholten sich schneller. Dieses Resilienz-Thema leitet zum praktischen Handbuch im nächsten Abschnitt über.

Workarounds während KI-Chatbot-Ausfällen: Teams produktiv halten

Wenn ein KI-Chatbot wie ChatGPT durch Edge-Schicht-Ausfälle beeinträchtigt wird, hängt das Überleben von Kontextkontinuität und intelligentem Anstehen ab. Teams, die den Chatbot für Zusammenfassung, Code-Review oder mehrsprachige Texte nutzen, können Reibung abmildern, indem sie von Live-Aufrufen auf zwischengespeicherte Assets und Offline-Vorverarbeitung umsteigen. Das Ziel ist bescheiden: Kontextverluste minimieren, während man auf die Normalisierung der Netzwerkpfade wartet.

Zunächst identifizieren, was ohne frische Inferenz erledigt werden kann. Viele Aufgaben – Datei-Parsing, Datenbereinigung und Prompt-Optimierung – können offline vorbereitet und bei Verfügbarkeit abgearbeitet werden. Dokumentationsbibliotheken, Muster-Prompts und Standardabläufe gehören auf schnellen lokalen Speicher oder eine schreibgeschützte Spiegelung, nicht hinter einen überlasteten Edge.

Schnellcheckliste bei Dienstunterbrechungen

- 🧭 Upstream-Status verifizieren und wiederholte Hard-Refreshes vermeiden

- 📦 Auf zwischengespeicherte Notizen und archivierte ChatGPT-Gespräche umstellen

- 🧮 Eingaben mit ChatGPT-Dateianalyse-ähnlichen Workflows vorstrukturieren

- 🔐 Integrationen rotieren oder pausieren; ChatGPT API-Key-Management prüfen

- 🔌 Nicht essentielle Erweiterungen deaktivieren; Plugins für ChatGPT 2025 überprüfen

Vermeiden Sie Kontext-Amnesie durch Pflege einer internen Prompt-Bibliothek und Snapshot-Exports. Wenn Ihr Unternehmen dokumentbasierte Durchläufe nutzt, speichern Sie bereinigte Daten lokal und pushen nur, wenn Routen stabil sind. Für Produkt- und Rechtsteams kann eine kompakte Einführung wie Verstehen von Fallanwendungen Risiken, Offenlegung und Wiederherstellungsschritte bei beeinträchtigtem Betrieb erläutern.

| Problem 🚧 | Workaround 🔧 | Erwartetes Ergebnis ✅ | Risikohinweis ⚖️ |

|---|---|---|---|

| Timeouts bei Prompts | Aufgaben offline anstellen; später bündeln | Weniger Wiederholungen, schnelleres Nachholen | Veraltete Eingaben bei Quelländerungen |

| Verlorener Chat-Kontext | Aus Archiven laden; Schlüssel-Prompts pinnen | Kontinuität ohne Nacharbeit | Teilweise Historie bei verzögerten Exports |

| Plugin-Abhängigkeit | Deaktivieren; minimale Prompt-Ketten verwenden | Weniger Edge-Aufrufe, weniger 500er | Funktionsverlust bei Nischenaufgaben |

| API-Integrationsausfälle | Graceful Backoff mit Jitter | Stabilität bei Last | Verzögerte Pipeline-Ausgaben |

Ein weiterer unterschätzter Tipp: Üben Sie „manuellen Modus“ für Kernprozesse. Ein Content-Team, das vorab ein Dutzend Überschriftenformeln schreibt, ist einem Team voraus, das auf Live-Inferenz wartet. Bei Resilienz schlägt Vorbereitung Improvisation immer.

Einblick in eine Cloudflare-Unterbrechung: DNS, CDN und Edge-Routing unter Stress

Cloud-Anbieter fallen selten an dramatischen Einzelpunkten aus; sie versagen durch kleine Fehlanpassungen mit Kaskadenwirkung. Ein Cloudflare-Ereignis, das „weitverbreitete 500-Fehler“ erzeugt, deutet auf Druck über mehrere Ebenen hin – DNS-Auflösung, Anycast-Routing, Cache-Befüllung und WAF-/Rate-Limiting-Logik. Wenn Steuerungsebenen neben Datenebenen verschlechtern, verstärkt sich der Effekt: Kunden können nicht nur nicht diagnostizieren, sondern kämpfen sogar damit, Dashboards zu öffnen.

Betrachten Sie den Edge als Mesh von Entscheidungen. DNS muss den Client zum nächstgelegenen gesunden POP leiten; Anycast macht diesen POP dynamisch auswählbar; Caching muss TTLs und Löschungen respektieren; und Sicherheitsschichten lassen Anfragen entweder passieren, fordern heraus oder blockieren sie in großem Maßstab. Ändert man eine Verkehrsregel zur falschen Zeit – oder propagiert Konfigurationen, während bestimmte Regionen bereits belastet sind – kann man ein stabiles System in Unruhe versetzen.

Ausfallmodi passend zu heutigen Symptomen

- 🌍 BGP- oder Anycast-Drift leitet Verkehr zu ungesunden Regionen

- 🛡️ WAF-/Rate-Limit-Regeln klassifizieren Spitzen fälschlich als Missbrauch

- 🧠 Steuerungsebene träge bei Konfigurationsrücknahmen

- 📦 Cache-Misses erhöhen Ursprungslast bei Löschvorgängen

- 🔗 DNS TTL-Unstimmigkeiten verlängern Erholungszeit

Beobachtbarkeit ist das Gegengewicht. Multi-Region-Synthetik-Tests, Edge-Logs und Ursprungs-Sättigungsdiagramme trennen Ursache von Symptom. Technische Teams, die in Rot/Grün-Deploy-Toggles und Rollout-Ringe investieren, können den Schadensradius begrenzen und weiterhin veraltete, aber akzeptable Inhalte am Rand liefern.

| Ebene 🧱 | Wahrscheinlicher Stressfaktor 🌪️ | Sichtbares Symptom 👀 | Maßnahme 🧯 |

|---|---|---|---|

| DNS | TTL-/Konfigurations-Mismatch | Intermittierende Auflösung | Kurzfristige TTLs, kontrollierte Rollouts |

| Routing | Anycast/BGP-Ungleichgewicht | Regionale 500er-Spitzen | Traffic-Steuerung, Abschalten ungesunder POPs |

| CDN-Cache | Massenlöschungen, viele Cache-Misses | Überlastung des Ursprungs | Serve-Stale, Vorwärmen populärer Assets |

| Sicherheit | Aggressive WAF-Regeln | Fehlalarme in großem Umfang | Regeln anpassen/deaktivieren, Ring-Deploys |

| Steuerungsebene | API-/Dashboard-Verlangsamung | Langsame Rollbacks | Out-of-Band-Toggles, Playbooks |

Die breitere KI-Landschaft sprintet auf verteilte Inferenz und intelligentere Edges zu, was die Anforderungen an Resilienz erhöht. Branchenforen wie NVIDIA GTC Washington DC Insights und Initiativen, in denen NVIDIA mit Partnern kooperiert, deuten auf Architekturen hin, die niedriglatenzielle Inferenz mit Multi-Cloud-Routing verbinden. Wenn KI „an den Edge wandert“, darf Redundanz kein Nachgedanke mehr sein.

Bei Vorfällen wie dem heutigen ist die Botschaft klar: Es geht nicht nur darum, eine einzelne App am Leben zu erhalten – es geht darum, das verbindende Gewebe des Webs gesund zu halten.

Zuverlässigkeitslehren für ChatGPT und Internetdienste nach den Ausfällen

Die Erholung ist ein Test für Architektur und Kultur. Für ChatGPT und seine Abhängigen liegt der Weg in stärkeren Multi-Region-Strategien, einem grazilen Degradieren und sitzungsbezogener Kommunikation, die Erwartungen realistisch setzt. Der Gewinn ist einfach: Wenn Fehler passieren – und sie werden – sollten Benutzer trotzdem ein Minimalergebnis erreichen.

Beginnen Sie mit Verkehrssteuerung. Progressives Traffic-Shifting, Canary-Releases in regionalen Ringen und automatisches Abschalten ungesunder POPs schaffen Luft zum Atmen. Auf der App-Seite sollte man auf „gut genug“-Antworten während Server-Ausfallzeiten setzen: kürzliche Zusammenfassungen bereitstellen, schreibgeschichtliche Zugriffe erlauben und Schreiboperationen anstellen. Für Entwickler-Ökosysteme können Laufzeit-Toggles, die Plugin-Aufrufe reduzieren, die Abhängigkeit von externen Edges verringern.

Ein praktisches Zuverlässigkeitshandbuch

- 🧪 Chaos-Drills, die Failover und „Serve Stale“-Richtlinien üben

- 🌐 Multi-CDN mit automatischer Pfadauswahl unter Last

- 🧰 Fallbacks auf leichtere Modelle oder zwischengespeicherte Embeddings

- 📢 Klare Statusmeldungen mit Bezug auf vorgelagerte Anbieter

- 📚 Öffentliche Leitfäden mit Links zu API-Key-Verwaltung und Governance

Resilienz ist nicht nur Software. Beschaffungsteams müssen die organisatorischen Kosten von Überabhängigkeit verstehen; Fallstudien wie die Kosten der Entlassung eines Tech-Genius lesen sich anders, wenn ein einzelner Experte den Incident-Pfad auswendig kennt. Gleichzeitig kann die F&E, die in Open-Source-Rahmenwerke für Robotik oder verteilte Inferenz investiert, Resilienzmuster für KI in Webmaßstab übernehmen.

| Aktion 📌 | Zuverlässigkeitsgewinn 📈 | Tool-Empfehlung 🧩 | Benutzerwert 💡 |

|---|---|---|---|

| Serve-Stale-Modus | Hoch bei Edge-Ausfall | CDN-TTL-Tuning, Cache-Keys | Antworten fließen weiter ✅ |

| Ringförmige Rollouts | Begrenzen Schadensradius | Feature-Flags, schrittweise Deploys | Weniger sichtbare Brüche 🛡️ |

| Graceful Backoff | Weniger Thundering Herd | Exponentialer Jitter, Warteschlangen | Schnellere Stabilisierung 🕒 |

| Multi-CDN | Pfadvielfalt | Steuerung und Gesundheitschecks | Geringere Fehlervarianz 🌐 |

| Kommunikations-Playbooks | Vertrauen bleibt erhalten | Vorlagen, Statusrhythmus | Weniger Verwirrung 📢 |

Für Teams, die Erweiterungen und Automatisierungen ausliefern, hilft eine schlanke Fähigkeitsauswahl. Artikel zu Plugins, die ChatGPT 2025 antreiben geben Orientierung, was in Turbulenzen essenziell bleibt, während Operations-Hubs Links zu Triage-Seiten und Backup-Dokumenten pflegen. Berichterstattung von Medien wie der Hindustan Times zeigt, warum Klarheit zählt: An Ausfalltagen wünschen Menschen sich Orientierung mehr als Drama.

Schließlich investieren Sie in Lernzyklen. Postmortems, die Edge-Telemetrie mit App-Metriken korrelieren, machen den nächsten Vorfall kleiner. Wenn das Web die Plattform ist, ist Resilienz das Produkt.

Wer betroffen war und wie: Mapping der plattformübergreifenden Auswirkungen der Cloudflare-Ausfälle

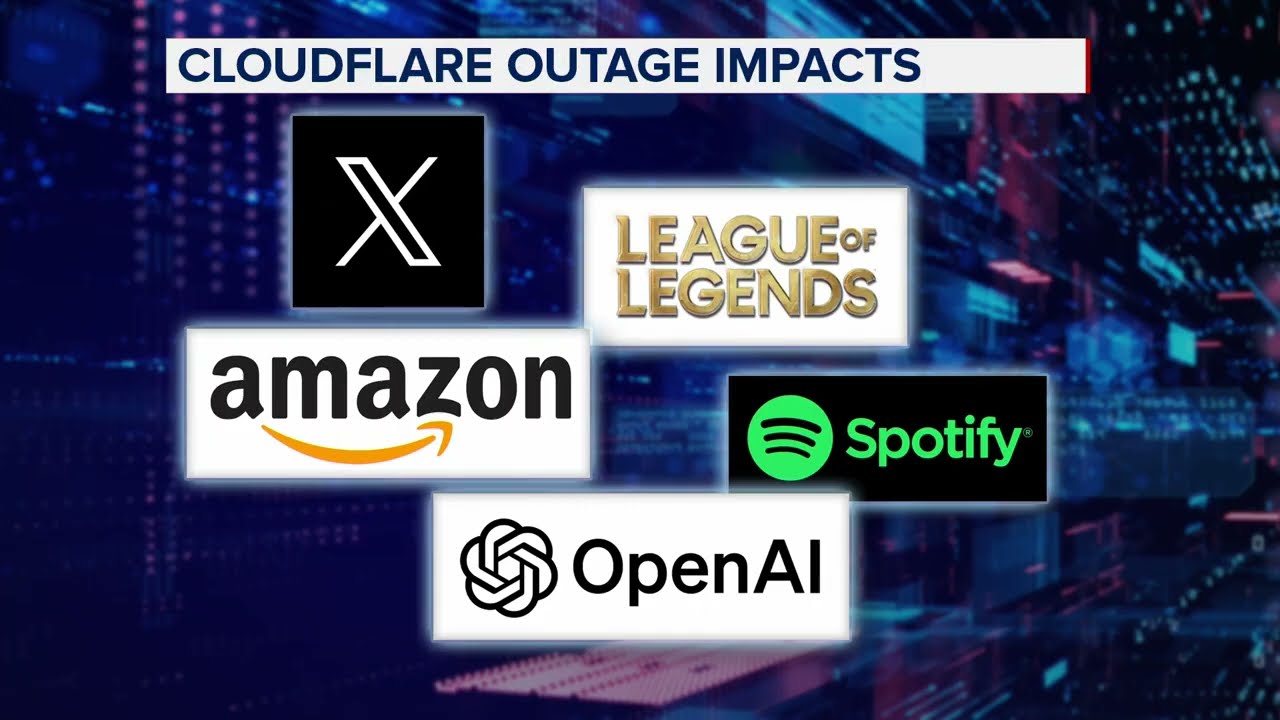

Über ChatGPT hinaus berührte das Cloudflare-Ereignis ein ganzes Marken-Universum: X, Canva, Shopify, Garmin, Claude, Verizon, Discord, T-Mobile und League of Legends gehörten zu den von Lesern genannten Fällen. Gemeinsam war diesen verschiedenartigen Diensten nicht die Branche, sondern ihre gemeinsame Abhängigkeit von einem schnellen, sicheren Edge-Netzwerk. Als das Netzwerk nachließ, divergierten Erfahrungen – soziale Feeds stoppten, Login-Prozesse brachen, und Spielsitzungen endeten mittendrin.

Der Kommunikationsstil machte einen Unterschied. Plattformen, die transparente Statushinweise an den Anfang stellten – mit Angaben zu vorgelagerten Problemen, erwarteten ETAs und empfohlenen Workarounds – verzeichneten ruhigere Communities. Andere lernten auf die harte Tour, dass Schweigen Spekulationen fördert. Teams, die alternative Abläufe dokumentierten, einschließlich der Anleitung zum Wiederherstellen des jüngsten Chat-Kontexts, entlasteten ihre Support-Leitungen.

Branchenübergreifende Schnappschüsse

- 📣 Soziale Medien: Influencer-Kampagnen pausiert; Link-Kürzer planten Posts

- 🛍️ Einzelhandel: Flash-Sale-Skripte deaktiviert; E-Mail-Erfassung priorisiert

- 🧑🎓 Bildung: Labore verschoben inference-intensive Aufgaben

- 🛰️ Mapping/IoT: Telemetrie gepuffert, bis Routen wiederhergestellt waren

- 🎧 Support-Center: Makros ersetzten KI-unterstützte Antworten

In jedem Fall verbesserte ein Prinzip die Ergebnisse: graziles Degradieren. Ob durch Bereitstellen zwischengespeicherter Shopseiten, schreibgeschützte Zeitachsen oder Einreihung von Spielern in niedrigeren Stress-Warteschlangen – die Strategie war, etwas Nützliches am Leben zu erhalten. Wenn Internetdienste zum Rückgrat des Alltags werden, ist ein Teilservice besser als keiner.

| Sektor 🧭 | Primäre Abhängigkeit 🔗 | Ausfall-Symptom 🚨 | Grazile Alternative 🕊️ |

|---|---|---|---|

| Medien | KI-unterstützte Bearbeitung | Gestoppte Entwürfe | Vorlagenbibliotheken, zeitlich gestaffelte Freigaben |

| Handel | CDN-zwischengespeicherte Assets | Checkout-Fehler | Warteseiten, Inventurreservierungen |

| Spiele | Echtzeitsitzungen | Sitzungsabbrüche | Niedriglatenz-Fallback-Warteschlangen |

| Community | Bots und Webhooks | Automationslücken | Angepinnte FAQs, manuelle Operationen |

| Support | Konversationelle KI | Verzögerte Antworten | Makros, Status-Snippets |

Für Teams, die Upgrades planen, bietet das Lesen über Zusammenarbeiten zur Härtung von KI am Edge eine Blaupause. Es geht nicht nur um Geschwindigkeit – Zuverlässigkeit muss von Tag eins an mitgedacht werden. Das ist die stille Schlagzeile hinter jedem Ausfalltag.

{“@context”:”https://schema.org”,”@type”:”FAQPage”,”mainEntity”:[{“@type”:”Question”,”name”:”Why did ChatGPT go down during the Cloudflare incident?”,”acceptedAnswer”:{“@type”:”Answer”,”text”:”The pattern of widespread 500 errors, dashboard/API issues, and synchronized spikes across platforms points to an upstream edge-layer problem at Cloudflare. Application logic was healthy in many cases, but routing, caching, or control-plane stress impaired access and responses.”}},{“@type”:”Question”,”name”:”What immediate steps help during a service disruption?”,”acceptedAnswer”:{“@type”:”Answer”,”text”:”Check status pages, avoid constant hard refreshes, switch to cached notes and archived chats, and queue work offline. Disable nonessential plugins and apply graceful backoff if using APIs.”}},{“@type”:”Question”,”name”:”Which platforms were affected besides ChatGPT?”,”acceptedAnswer”:{“@type”:”Answer”,”text”:”Reports cited X, Shopify, Discord, Garmin, Claude, Verizon, T-Mobile, and League of Legends among those experiencing issues due to the Cloudflare interruption.”}},{“@type”:”Question”,”name”:”How can teams reduce the impact of future outages?”,”acceptedAnswer”:{“@type”:”Answer”,”text”:”Adopt multi-CDN strategies, enable serve-stale modes, practice chaos drills, and maintain clear incident communications. Use ringed rollouts and automated traffic steering to contain blast radius.”}},{“@type”:”Question”,”name”:”Where can I find practical guides and tools after outages?”,”acceptedAnswer”:{“@type”:”Answer”,”text”:”Resources like catalogs of ChatGPT error codes, API key management primers, plugin audits, and file-analysis workflows help accelerate recovery and reduce rework once services stabilize.”}}]}Warum fiel ChatGPT während des Cloudflare-Vorfalls aus?

Das Muster aus weitverbreiteten 500-Fehlern, Dashboard-/API-Problemen und synchronisierten Spitzen auf verschiedenen Plattformen deutet auf ein Problem in der vorgelagerten Edge-Schicht bei Cloudflare hin. Die Applikationslogik war in vielen Fällen intakt, doch Routing-, Caching- oder Steuerungsebene-Stress beeinträchtigte den Zugriff und die Reaktionen.

Welche Sofortmaßnahmen helfen während einer Dienstunterbrechung?

Statusseiten prüfen, ständige Hard-Refreshes vermeiden, auf zwischengespeicherte Notizen und archivierte Chats wechseln und Arbeiten offline anstellen. Nicht essenzielle Plugins deaktivieren und bei Nutzung von APIs einen sanften Backoff anwenden.

Welche Plattformen waren neben ChatGPT betroffen?

Berichte nannten X, Shopify, Discord, Garmin, Claude, Verizon, T-Mobile und League of Legends als von der Cloudflare-Unterbrechung betroffene Dienste.

Wie können Teams die Auswirkungen zukünftiger Ausfälle verringern?

Multi-CDN-Strategien anwenden, Serve-Stale-Modi aktivieren, Chaos-Drills durchführen und klare Vorfallkommunikation pflegen. Ringförmige Rollouts und automatisiertes Traffic-Management nutzen, um den Schadensradius zu begrenzen.

Wo finde ich praktische Leitfäden und Tools nach Ausfällen?

Ressourcen wie Verzeichnisse der ChatGPT-Fehlercodes, API-Key-Management-Grundlagen, Plugin-Audits und Workflows zur Datei-Analyse helfen, die Erholung zu beschleunigen und Nacharbeit zu reduzieren, sobald die Dienste stabil sind.

-

KI-Modelle20 hours ago

KI-Modelle20 hours agovietnamesische Models im Jahr 2025: neue Gesichter und aufstrebende Stars, die man beobachten sollte

-

Tech8 hours ago

Tech8 hours agoEin umfassender Überblick über die Tech-Landschaft in Palo Alto bis 2025

-

17 hours ago

17 hours agoEntfesseln Sie die Kraft des ChatGPT Gruppen-Chats kostenlos: Eine Schritt-für-Schritt-Anleitung zum Einstieg

-

Tech3 days ago

Tech3 days agoIhre Karte unterstützt diesen Kaufart nicht: was das bedeutet und wie Sie das Problem lösen können

-

KI-Modelle3 days ago

KI-Modelle3 days agoOpenAI vs Tsinghua: Die Wahl zwischen ChatGPT und ChatGLM für Ihre KI-Bedürfnisse im Jahr 2025

-

6 hours ago

6 hours agoEinführung einer kostenlosen ChatGPT-Version, die speziell für Lehrkräfte entwickelt wurde