Servizio ChatGPT Interrotto: Interruzione di Cloudflare Causa Blackout Globali e Errori 500

Ondata di instabilità ha attraversato il web mentre una Interruzione di Cloudflare ha spinto i servizi core edge in turbolenza, lasciando gli Utenti a segnalare ampi Blackout per ChatGPT e altre piattaforme ad alto traffico. Il modello assomigliava a un guasto di rete a monte piuttosto che a semplici intoppi a livello applicativo, dimostrato da segnali simultanei di Interruzione Server, errori nei dashboard e risposte 500. Verso il tardo pomeriggio, le segnalazioni hanno superato gli 11.000 incidenti collegati a X, mentre i lettori del Hindustan Times descrivevano disconnessioni improvvise a metà prompt sul Chatbot AI, pannelli vuoti e messaggi di “errore di rete”.

I primi indicatori erano visibili molto prima delle timeline ufficiali. Downdetector ha tracciato un aumento da circa 15 reclami di base a 38 intorno alle 3:34 AM, seguito da picchi netti durante la giornata—classici segnali di un guasto a livello edge a monte. Cloudflare ha riconosciuto “errori 500 diffusi”, insieme a un degrado dei Servizi Internet tra cui Dashboard, API e persino il suo portale di supporto. Parallelamente, il 90% delle lamentele per il blackout riguardava ChatGPT specificamente, sottolineando quanto i flussi di lavoro AI in tempo reale dipendano ormai dalle reti edge.

Cosa hanno visto gli utenti e perché è stato importante

I sintomi si concentravano intorno a prompt scaduti, contesto scomparso e pannelli UI che si rifiutavano di caricarsi. Per i team sotto scadenza, una finestra di inferenza congelata non è solo un fastidio—blocca le pipeline decisionali in revisione codice, produzione contenuti e sintesi dati. Il problema si complica quando i tentativi di failover incontrano gli stessi colli di bottiglia a monte, trasformando normali aggiornamenti in cicli infiniti.

- 🔴 Fallimenti di sessione a metà conversazione, spesso con errori di classe 500

- ⚠️ Uscite vuote o “impossibile caricare la cronologia” durante il recupero delle chat

- 🕒 Lunghi ritardi di inferenza seguiti da disconnessioni improvvise

- 🔁 Ricariche ripetute senza recupero di contesto per attività in corso

- 🧭 Segnali di stato confusi mentre più servizi vacillavano simultaneamente

Quando comparivano codici di errore, indicavano incoerenza infrastrutturale. I team che tengono un catalogo di codici errore ChatGPT potevano rapidamente distinguere tra problemi transitori e azioni necessarie. Tuttavia, in una giornata come questa, la radice del problema stava oltre il controllo applicativo, rendendo pazienza e pianificazione delle contingenze tanto vitali quanto il debugging.

| Timestamp (locale) ⏰ | Segnale rilevato 📊 | Cosa suggeriva 🧭 | Impatto utente 😬 |

|---|---|---|---|

| 03:34 AM | 38 reclami vs ~15 baseline | Instabilità upstream precoce | Accesso intermittente a ChatGPT |

| Picco mattutino | Picchi netti multi-piattaforma | Propagazione guasto Edge/CDN | Pannelli vuoti, 500, tentativi multipli |

| Entro le 17:00 | Oltre 11.000 segnalazioni di blackout su X | Ampia diffusione tra i consumatori | Feed social e notizie bloccati |

| Tutto il giorno | Problemi Cloudflare Dashboard/API | Impatto lato provider | Ritardi nei supporti e mitigazioni lente |

Per chi si chiedeva “È colpa mia o della rete?”, la telemetria del giorno dava una risposta chiara: era un tremito a livello backbone, non un guasto singolo ad app. L’episodio ribadisce una verità del computing moderno—l’AI dipende dall’edge, e quando l’edge vacilla, la produttività vacilla con esso.

Come Utenti e Aziende Hanno Avvertito l’Interruzione Server Attraverso i Servizi Internet

La Interruzione del Servizio si è propagata nel commercio, media, educazione e logistica, dimostrando quanto siano intrecciati i Servizi Internet con i flussi di lavoro del Chatbot AI. Un marchio indipendente su Shopify ha perso conversioni nelle ore di punta a causa di ritardi nei moduli di checkout; una redazione ha visto rallentare rapidamente le bozze Q&A mentre le finestre di ChatGPT non si caricavano; un laboratorio universitario ha perso una mattina di analisi con scadenze di prompt in cascata. Quando gli strumenti front-office e le cache edge vacillano, l’impatto si manifesta gradualmente—primo in secondi, poi in fatturato.

Considera una boutique di Delhi chiamata Neem&Co. Il team utilizzava strumenti generativi per creare descrizioni di prodotto e tradurle in tempo reale. Durante il blackout, le pagine prodotto sono rimaste ferme, le chiamate ai carrelli si sono bloccate e gli script di supporto non sono stati redatti rapidamente. Parallelamente, un team fintech a Bengaluru che si affidava all’AI conversazionale per la triage dei log ha trovato il loro canale di incidenti improvvisamente silenzioso—non per mancanza di avvisi, ma per mancanza di risposte. Il recupero è arrivato solo con la stabilizzazione delle rotte.

Dove si è concentrato il dolore

- 🛒 Timeout nei moduli di checkout e ricerca e-commerce

- 📰 Redazioni che perdono modifiche e riassunti assistiti da AI

- 💼 Team HR e recruiting che sospendono workflow di screening

- 🎮 Servizi di gaming come sessioni di League interrotte a metà partita

- 💬 Piattaforme di messaggistica e comunità fronteggiano limiti di rate

Quando le pagine di stato alternavano verde e arancione, i team ricorrevano a piani di continuità. Una soluzione popolare era recuperare prompt e output precedenti da archivi locali o sincronizzati. Guide su come accedere alle conversazioni archiviate di ChatGPT si sono rivelate utili per ricostruire il contesto senza ricorrere all’inferenza live. Per team pesanti di contenuti, passare a repository di bozze o snapshot congelati minimizzava il lavoro da rifare una volta recuperati i servizi.

| Piattaforma 🌐 | Sintomo osservato 🧩 | Scala di gravità 🌡️ | Soluzione suggerita 🧰 |

|---|---|---|---|

| X | Blocchi nei feed e nelle pubblicazioni | Alto 🔴 | Usare scheduler terzi, ritardare le uscite |

| Shopify | Latenza nel checkout | Alto 🔴 | Attivare pagine in coda, catturare email |

| ChatGPT | Timeout, pannelli vuoti | Alto 🔴 | Ricostruire da archivi, batch offline |

| Discord | Comandi bot falliti | Medi 🟠 | Moderazione manuale e FAQ fissate |

| League of Legends | Interruzioni di partita | Medi 🟠 | Cooldown in coda, controlli di stato |

I giorni di blackout hanno anche evidenziato gap di competenze. I team di assunzioni che si affidavano a filtri AI per i curriculum si sono orientati verso liste di strumenti curati; risorse come strumenti gratuiti AI per curriculum hanno aiutato a mantenere il flusso una volta stabilizzato il sistema. Nel frattempo, i team social bilanciavano tempestività e accuratezza, resistendo alla tentazione di amplificare claim di stato non verificati.

Nonostante l’interruzione, un modello è rimasto: i team che avevano pre-costruito semplici switch “modalità lenta” e workflow batch hanno recuperato più rapidamente. Questo tema di resilienza prepara il playbook pratico nella sezione successiva.

Soluzioni Durante i Blackout del Chatbot AI: Mantenere i Team Produttivi

Quando un Chatbot AI come ChatGPT è ostacolato da Blackout a livello edge, la sopravvivenza dipende dalla continuità del contesto e da una gestione intelligente delle code. I team che si affidano al chatbot per sintesi, revisione codice o copy multilingue possono mitigare l’attrito passando da chiamate live a asset memorizzati nella cache e pre-elaborazione offline. L’obiettivo è modesto: ridurre la perdita di contesto in attesa che le vie di rete si normalizzino.

Innanzitutto, identificare cosa si può fare senza inferenza fresca. Molti compiti—parsing file, pulizia dati, rifinitura prompt—possono essere preparati offline e poi eseguiti quando la capacità torna. Librerie di documentazione, prompt modello e procedure operative standard devono essere su memoria locale veloce o specchio di sola lettura, non dall’altra parte di un edge congestionato.

Checklist di risposta rapida per interruzioni di servizio

- 🧭 Verificare lo stato upstream ed evitare refresh forzati ripetuti

- 📦 Passare a note memorizzate e conversazioni archiviate di ChatGPT

- 🧮 Pre-strutturare input con workflow di analisi file ChatGPT

- 🔐 Ruotare o mettere in pausa integrazioni; rivedere come gestire una chiave API ChatGPT

- 🔌 Disabilitare estensioni non essenziali; rivedere plugin che potenziano ChatGPT nel 2025

Evitare l’amnesia del contesto mantenendo una libreria interna di prompt ed esportazioni snapshot. Se la tua organizzazione usa esecuzioni a livello documentale, conserva i dati sanificati localmente e invia solo quando le rotte sono stabili. Per team di prodotto e legali, un primer conciso come comprendere l’applicazione del caso può inquadrare rischio, divulgazione e passaggi di recupero durante operazioni degradate.

| Problema 🚧 | Soluzione 🔧 | Risultato previsto ✅ | Nota rischio ⚖️ |

|---|---|---|---|

| Timeout su prompt | Mettere in coda offline; batch successivi | Riduzione retry, recupero più veloce | Input obsoleti se la fonte cambia |

| Perdita di contesto chat | Caricare da archivi; fissare prompt chiave | Continuità senza rifare | Storico parziale se l’export è lento |

| Dipendenza da plugin | Disabilitare; usare catene minime di prompt | Chiamate edge ridotte, meno 500 | Perdita di funzionalità in compiti di nicchia |

| Blocchi integrazione API | Backoff graduale con jitter | Stabilità sotto carico | Output pipeline ritardati |

Un’altra tattica sottovalutata: esercitare la “modalità manuale” per i flussi core. Un team di contenuti che pre-scrive una dozzina di formule per titoli supererà un team bloccato in attesa dell’inferenza live. Nella resilienza, la preparazione batte l’improvvisazione ogni volta.

Dentro un’Interruzione di Cloudflare: DNS, CDN e Routing Edge sotto Stress

I provider cloud raramente falliscono in modo drammatico in singoli punti; si inceppano in piccoli disallineamenti che si propagano. Un evento Cloudflare che produce “errori 500 diffusi” suggerisce pressione su più livelli—risoluzione DNS, routing Anycast, popolamento cache e logica WAF/rate-limiting. Se i piani di controllo degradano insieme ai piani dati, l’effetto si somma: i clienti non possono solo diagnosticare; faticano persino ad aprire i dashboard.

Pensa all’edge come una rete di decisioni. Il DNS deve indirizzare il client al POP sano più vicino; Anycast rende dinamica la selezione del POP; la cache deve rispettare TTL e purge; e i livelli di sicurezza devono accettare, sfidare o bloccare le richieste su larga scala. Cambiare una politica di traffico nel momento sbagliato—o propagare una configurazione mentre alcune regioni sono già in affanno—può far vacillare un sistema stabile.

Modalità di guasto che mappano i sintomi odierni

- 🌍 Deriva BGP o Anycast che invia traffico a regioni non sane

- 🛡️ Regole WAF/rate-limit che interpretano picchi come abusi

- 🧠 Lentezza del piano di controllo che ritarda rollback di configurazioni

- 📦 Mancati hit della cache che esplodono il carico origin durante purge

- 🔗 Mismatch TTL DNS che allunga i tempi di recupero

L’osservabilità è il contrappeso. Sonde sintetiche multi-regione, log edge e grafici di saturazione origin possono separare sintomo da causa. I team tecnici che investono in toggle di deploy red/green e rollout a anelli possono contenere la blast radius continuando a servire contenuti stale-ma-accettabili al margine.

| Layer 🧱 | Probabile fattore stressante 🌪️ | Sintomo visibile 👀 | Mitigazione 🧯 |

|---|---|---|---|

| DNS | Mismatch TTL/config | Risoluzione intermittente | TTL brevi, rollout controllati |

| Routing | Squilibrio Anycast/BGP | Picchi 500 regionali | Steering traffico, drenare POP non sani |

| Cache CDN | Purge massivi, hot misses | Sovraccarico origin | Serve-stale, preriscaldare asset popolari |

| Sicurezza | Regole WAF aggressive | Falsi positivi su larga scala | Regolare/disabilitare regole, deploy ad anelli |

| Piano di controllo | Lentezza API/dashboard | Rollback lenti | Toggle fuori banda, playbook |

Il panorama AI più ampio corre verso inferenza distribuita e edge più intelligenti, aumentando le scommesse sulla resilienza. Forum di settore come NVIDIA GTC Washington DC insights e iniziative in cui NVIDIA collabora con partner suggeriscono architetture che fondono inferenza a bassa latenza con routing multi-cloud. Man mano che l’AI “si sposta all’edge”, la ridondanza non può più essere un ripensamento.

In incidenti come quello di oggi, il messaggio è coerente: non si tratta solo di mantenere viva una singola app—si tratta di mantenere sano il tessuto connettivo del web.

Lezioni di Affidabilità per ChatGPT e i Servizi Internet Dopo i Blackout

Il recupero è una prova di architettura e cultura. Per ChatGPT e i suoi dipendenti, la strada da intraprendere prevede strategie multi-regione più solide, degradazione graduale e comunicazione degli incidenti che imposti aspettative senza promettere troppo. Il premio è semplice: quando si verificano guasti—e accadrà—gli Utenti dovrebbero comunque ottenere un risultato minimo valido.

Iniziare con il controllo traffico. Spostamenti progressivi del traffico, canary a anelli regionali e svuotamento automatico di POP non sani creano margine. Sul lato app, progettare per risposte “abbastanza buone” durante Interruzioni Server: servire riassunti recenti, consentire cronologie in sola lettura e mettere in coda operazioni di scrittura. Per gli ecosistemi di sviluppatori, toggle runtime che riducono le chiamate ai plugin possono ridurre la dipendenza da edge esterni.

Un playbook pratico di affidabilità

- 🧪 Esercitazioni chaos che praticano failover e politiche “serve stale”

- 🌐 Multi-CDN con selezione percorso automatica sotto stress

- 🧰 Fallback a modelli più leggeri o embedding memorizzati

- 📢 Note di status chiare che fanno riferimento ai provider upstream

- 📚 Guide pubbliche che linkano a governance e gestione chiavi API

La resilienza non è solo software. I team di procurement devono comprendere il costo organizzativo di un’eccessiva dipendenza; casi di studio come il costo di licenziare un genio tech si leggono diversamente quando un singolo esperto conosce a fondo il percorso dell’incidente. Nel frattempo, la R&D che investe in framework open-source per la robotica o inferenza distribuita può prendere in prestito modelli di resilienza per l’AI a scala web.

| Azione 📌 | Guadagno in affidabilità 📈 | Suggerimento strumenti 🧩 | Valore utente 💡 |

|---|---|---|---|

| Modalità serve-stale | Alta in caso di perdita edge | Regolazione TTL CDN, chiavi cache | Le risposte continuano a fluire ✅ |

| Rollout ad anelli | Contenere blast radius | Feature flag, deploy graduali | Meno interruzioni visibili agli utenti 🛡️ |

| Backoff graduale | Riduce effetto “gregge” | Jitter esponenziale, code | Stabilizzazione più rapida 🕒 |

| Multi-CDN | Diversità di percorso | Steering e controlli di salute | Minore varianza errori 🌐 |

| Playbook comunicazioni | Fiducia conservata | Template, cadenza status | Meno confusione 📢 |

Per i team che rilasciano estensioni e automazioni, curare un set snello di funzionalità aiuta. Articoli su plugin che supportano ChatGPT nel 2025 possono guidare su cosa è essenziale mantenere in tempi di turbolenza, mentre i centri operativi conservano link a pagine di triage e documenti di backup. La copertura di testate come il Hindustan Times dimostra perché la chiarezza conta: nei giorni di blackout, le persone vogliono direzione più che dramma.

Infine, investire in cicli di apprendimento. Postmortem che correlano telemetria edge con metriche app rendono il prossimo incidente meno grave. Quando il web è la piattaforma, la resilienza è il prodotto.

Chi è Stato Colpito e Come: Mappatura dell’Impatto Cross-Piattaforma del Blackout Cloudflare

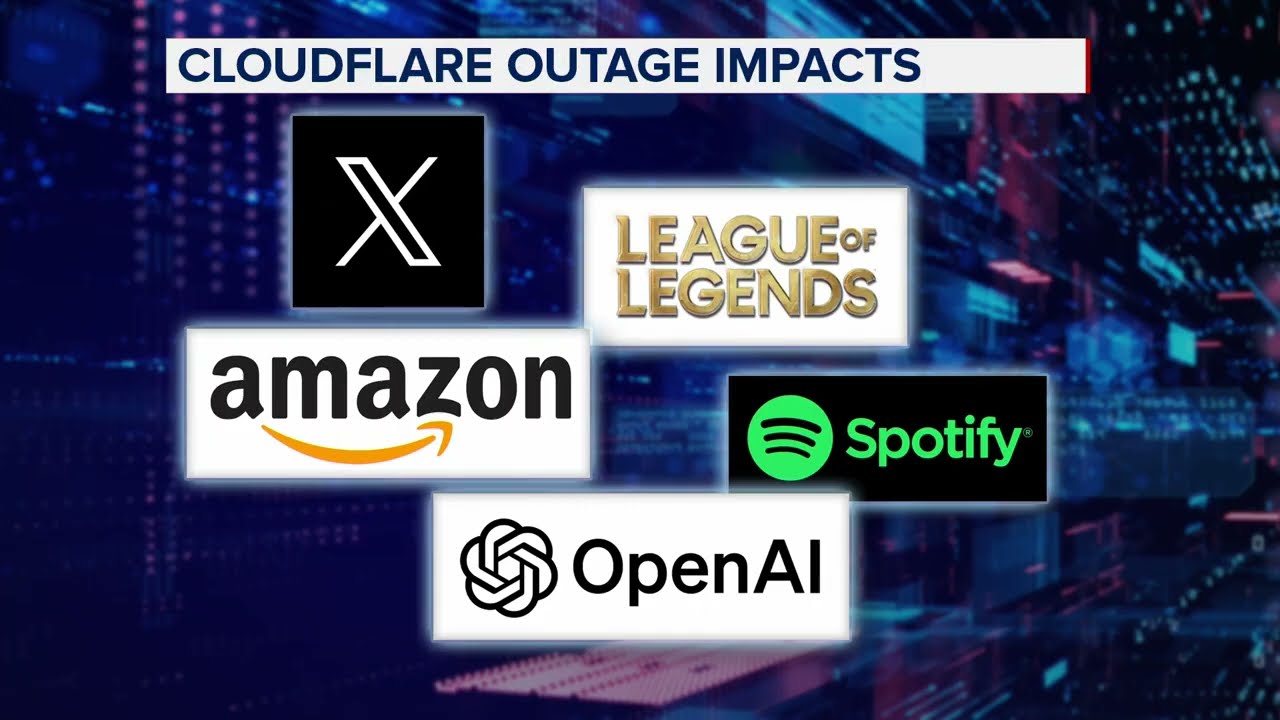

Oltre ChatGPT, l’evento Cloudflare ha toccato una costellazione di marchi: X, Canva, Shopify, Garmin, Claude, Verizon, Discord, T-Mobile e League of Legends fra quelli segnalati dai lettori. Ciò che univa questi servizi disparati non era il settore, ma la loro comune dipendenza da un tessuto edge veloce e sicuro. Con il deteriorarsi del tessuto, le esperienze si sono divise—feed social bloccati, login falliti, e sessioni di gioco terminate in mezzo alla battaglia.

Lo stile comunicativo ha fatto la differenza. Le piattaforme che hanno fornito note di status trasparenti in anticipo—segnalando problemi upstream, ETA previste e workaround suggeriti—hanno visto comunità più calme. Altri hanno imparato a fatica che il silenzio invita a speculazioni. I team che hanno documentato workflow alternativi, inclusi modi per recuperare il contesto chat recente, hanno alleggerito le linee di supporto.

Snapshot cross-industria

- 📣 Social: Campagne influencer sospese; accorciatori link in coda per i post

- 🛍️ Retail: Script per flash sale disabilitati; priorità alla cattura email

- 🧑🎓 Educazione: Laboratori che hanno riprogrammato incarichi intensivi di inferenza

- 🛰️ Mapping/IoT: Telemetria bufferizzata fino al recupero delle rotte

- 🎧 Help desk: Macro che hanno sostituito risposte AI assistite

In ciascun caso, un principio unico ha migliorato gli esiti: degradare con grazia. Che significasse servire pagine storefront in cache, offrire timeline in sola lettura o spingere i gamer verso code a basso stress, la strategia era mantenere vivo qualcosa di utile. Quando i Servizi Internet diventano la spina dorsale della vita quotidiana, un servizio parziale batte nessun servizio.

| Settore 🧭 | Dipendenza primaria 🔗 | Sintomo di guasto 🚨 | Alternativa graduale 🕊️ |

|---|---|---|---|

| Media | Modifiche assistite da AI | Bozze bloccate | Librerie di template, release temporizzate |

| Commercio | Asset in cache CDN | Errori checkout | Pagine in coda, blocchi inventario |

| Gaming | Sessioni in tempo reale | Drop di partita | Code di fallback a bassa latenza |

| Comunità | Bot e webhook | Lacune automatiche | FAQ fissate, operazioni manuali |

| Supporto | AI conversazionale | Risposte ritardate | Macro, snippet di stato |

Per i team che pianificano aggiornamenti, leggere di collaborazioni che rafforzano l’AI all’edge offre una roadmap. Non si tratta solo di velocità—l’affidabilità deve essere progettata fin dal primo giorno. Questo è il titolo silenzioso dietro ogni giorno di blackout.

{“@context”:”https://schema.org”,”@type”:”FAQPage”,”mainEntity”:[{“@type”:”Question”,”name”:”Perché ChatGPT è andato offline durante l’incidente Cloudflare?”,”acceptedAnswer”:{“@type”:”Answer”,”text”:”Il modello di errori 500 diffusi, problemi a dashboard/API e picchi sincronizzati su più piattaforme indica un problema a livello edge upstream di Cloudflare. La logica applicativa era sana in molti casi, ma routing, caching o stress sul piano di controllo hanno compromesso accessi e risposte.”}},{“@type”:”Question”,”name”:”Quali passi immediati aiutano durante un’interruzione di servizio?”,”acceptedAnswer”:{“@type”:”Answer”,”text”:”Controllare le pagine di stato, evitare refresh forzati continui, passare a note in cache e chat archiviate, e mettere in coda il lavoro offline. Disabilitare plugin non essenziali e applicare backoff graduale se si usano API.”}},{“@type”:”Question”,”name”:”Quali piattaforme sono state colpite oltre ChatGPT?”,”acceptedAnswer”:{“@type”:”Answer”,”text”:”Le segnalazioni citano X, Shopify, Discord, Garmin, Claude, Verizon, T-Mobile e League of Legends tra i servizi colpiti dall’interruzione di Cloudflare.”}},{“@type”:”Question”,”name”:”Come possono i team ridurre l’impatto di future interruzioni?”,”acceptedAnswer”:{“@type”:”Answer”,”text”:”Adottare strategie multi-CDN, abilitare modalità serve-stale, praticare esercitazioni chaos e mantenere comunicazioni chiare sugli incidenti. Usare rollout ad anelli e steering automatico del traffico per contenere la blast radius.”}},{“@type”:”Question”,”name”:”Dove posso trovare guide e strumenti pratici dopo i blackout?”,”acceptedAnswer”:{“@type”:”Answer”,”text”:”Risorse come cataloghi di codici errore ChatGPT, primer per gestione chiavi API, audit di plugin e workflow di analisi file aiutano ad accelerare il recupero e ridurre rifacimenti una volta stabilizzati i servizi.”}}]}Perché ChatGPT è andato offline durante l’incidente Cloudflare?

Il modello di errori 500 diffusi, problemi a dashboard/API e picchi sincronizzati su più piattaforme indica un problema a livello edge upstream di Cloudflare. La logica applicativa era sana in molti casi, ma routing, caching o stress sul piano di controllo hanno compromesso accessi e risposte.

Quali passi immediati aiutano durante un’interruzione di servizio?

Controllare le pagine di stato, evitare refresh forzati continui, passare a note in cache e chat archiviate, e mettere in coda il lavoro offline. Disabilitare plugin non essenziali e applicare backoff graduale se si usano API.

Quali piattaforme sono state colpite oltre ChatGPT?

Le segnalazioni citano X, Shopify, Discord, Garmin, Claude, Verizon, T-Mobile e League of Legends tra i servizi colpiti dall’interruzione di Cloudflare.

Come possono i team ridurre l’impatto di future interruzioni?

Adottare strategie multi-CDN, abilitare modalità serve-stale, praticare esercitazioni chaos e mantenere comunicazioni chiare sugli incidenti. Usare rollout ad anelli e steering automatico del traffico per contenere la blast radius.

Dove posso trovare guide e strumenti pratici dopo i blackout?

Risorse come cataloghi di codici errore ChatGPT, primer per gestione chiavi API, audit di plugin e workflow di analisi file aiutano ad accelerare il recupero e ridurre rifacimenti una volta stabilizzati i servizi.

-

Modelli di IA2 days ago

Modelli di IA2 days agoScegliere tra Google Bard e ChatGPT di OpenAI: quale soluzione AI è giusta per te nel 2025?

-

Modelli di IA21 hours ago

Modelli di IA21 hours agomodel vietnamite nel 2025: nuovi volti e stelle nascenti da seguire

-

Tecnologia8 hours ago

Tecnologia8 hours agoUna panoramica completa del panorama tecnologico di Palo Alto entro il 2025

-

Tecnologia3 days ago

Tecnologia3 days agoLa tua carta non supporta questo tipo di acquisto: cosa significa e come risolverlo

-

17 hours ago

17 hours agoSblocca il Potere della Chat di Gruppo ChatGPT Gratis: Una Guida Passo dopo Passo per Iniziare

-

Modelli di IA3 days ago

Modelli di IA3 days agoOpenAI vs Tsinghua: Scegliere tra ChatGPT e ChatGLM per le tue esigenze di IA nel 2025