Actualités

Service ChatGPT interrompue : les utilisateurs rencontrent des pannes suite à une interruption de Cloudflare | Hindustan Times

Service ChatGPT perturbé : une interruption Cloudflare déclenche des pannes mondiales et des erreurs 500

Des vagues d’instabilité ont déferlé sur le web alors qu’une interruption Cloudflare poussait les services de périphérie critiques dans la tourmente, laissant les utilisateurs signaler des pannes généralisées pour ChatGPT et d’autres plateformes à fort trafic. Le schéma ressemblait à une défaillance réseau amont plutôt qu’à des problèmes isolés de niveau application, comme en témoignaient des signaux simultanés de panne serveur, d’erreurs sur le tableau de bord et des réponses 500. En fin d’après-midi, les rapports faisaient état de plus de 11 000 incidents liés à X, tandis que les lecteurs du Hindustan Times décrivaient des déconnexions soudaines en plein prompt sur le chatbot IA, des panneaux vides et des messages d’« erreur réseau ».

Des indicateurs précoces étaient visibles bien avant que les chronologies ne s’en saisissent. Downdetector a tracé une hausse passant d’environ 15 plaintes de base à 38 vers 3h34 du matin, suivie de pics prononcés tout au long de la journée — des signatures classiques d’une défaillance de couche périphérique amont. Cloudflare a reconnu des « erreurs 500 généralisées », ainsi que la dégradation des services Internet incluant le tableau de bord, l’API et même son propre portail de support. Parallèlement, 90 % des plaintes de panne ciblaient spécifiquement ChatGPT, soulignant à quel point les flux IA en temps réel dépendent aujourd’hui des réseaux de périphérie.

Ce que les utilisateurs ont vu et pourquoi c’était important

Les symptômes se concentraient autour de prompts expirés, de contextes disparus et de panneaux UI refusant de s’afficher. Pour les équipes sous pression, une fenêtre d’inférence figée n’est pas juste une gêne — elle bloque les chaînes de prise de décision sur la revue de code, la production de contenu et le résumé de données. Le problème s’aggravait lorsque les tentatives de basculement rencontraient les mêmes goulets d’étranglement amonts, transformant les rafraîchissements ordinaires en boucles.

- 🔴 Échecs de session en pleine conversation, souvent avec erreurs de classe 500

- ⚠️ Sorties vides ou « impossible de charger l’historique » lors de la récupération des conversations

- 🕒 Longs délais d’inférence suivis de déconnexions brusques

- 🔁 Rechargements répétés sans récupération de contexte pour les tâches en cours

- 🧭 Signaux de statut déroutants alors que plusieurs services défaillaient simultanément

Lorsque des codes d’erreur apparaissaient, ils indiquaient une incohérence infrastructurelle. Les équipes qui tiennent un catalogue des codes d’erreur ChatGPT pouvaient rapidement trier ce qui était transitoire ou nécessitait une action. Pourtant, en une journée comme celle-ci, les racines du problème dépassaient le contrôle applicatif, faisant de la patience et de la planification de contingence des éléments aussi vitaux que le débogage.

| Horodatage (local) ⏰ | Signal capturé 📊 | Ce que cela suggérait 🧭 | Impact utilisateur 😬 |

|---|---|---|---|

| 03:34 AM | 38 plaintes contre ~15 de base | Instabilité amont précoce | Accès intermittent à ChatGPT |

| Pic du matin | Pics nets multi-plateformes | Propagation de défaillance Edge/CDN | Panneaux vides, erreurs 500, tentatives répétées |

| À 17h | Plus de 11 000 rapports de panne X | Portée étendue aux consommateurs | Flux sociaux et infos bloqués |

| Tout au long | Problèmes Dashboard/API Cloudflare | Dégradation côté fournisseur | Retards de support et mitigations lentes |

Pour tous ceux qui se demandaient « Est-ce moi ou le réseau ? », la télémétrie du jour offrait une réponse claire : c’était un tremblement au niveau de la colonne vertébrale, pas une panne d’application unique. L’épisode renforce une vérité de l’informatique moderne — l’IA dépend de la périphérie, et lorsque celle-ci vacille, la productivité vacille avec elle.

Comment les utilisateurs et les entreprises ont ressenti la panne serveur à travers les services Internet

La perturbation du service a impacté le commerce, les médias, l’éducation et la logistique, démontrant à quel point les services Internet sont devenus indissociables des flux chatbot IA. Une marque indépendante sur Shopify a manqué des conversions aux heures de pointe quand les modules de paiement ont ralenti ; la rédaction d’une salle de presse pour des Q&A rapides s’est bloquée lorsque les fenêtres ChatGPT ont refusé de se charger ; un laboratoire universitaire a perdu une matinée d’analyses alors que les expirations de prompts en file d’attente se sont accumulées. Lorsque les outils de première ligne et les caches de périphérie défaillent, l’impact s’étale doucement — d’abord les secondes, puis les revenus.

Prenez le cas d’une boutique de Delhi appelée Neem&Co. L’équipe utilisait des outils génératifs pour créer des descriptions produit et les traduire en temps réel. Pendant la panne, les pages produit restaient statiques, les appels au panier se bloquaient et les scripts de support ne pouvaient pas être rédigés rapidement. Parallèlement, une équipe fintech à Bengaluru, qui s’appuyait sur l’IA conversationnelle pour le tri des journaux d’incidents, a constaté un silence inhabituel sur leur canal — pas par absence d’alertes mais par absence de réponses. La reprise n’est venue qu’avec la stabilisation des routes.

Où la douleur s’est concentrée

- 🛒 Modules de paiement et de recherche e-commerce expirant

- 📰 Salles de presse perdant les éditions et résumés assistés par IA

- 💼 Équipes RH et recrutement suspendant les flux de sélection

- 🎮 Services de jeux comme League perturbés en pleine partie

- 💬 Plateformes de messagerie et communautés bloquées par des limites de taux

Lorsque les pages de statut oscillaient entre vert et orange, les équipes se tournaient vers des plans de continuité. Une solution populaire était de récupérer des prompts et résultats antérieurs depuis des archives locales ou synchronisées. Les guides sur l’accès aux conversations archivées ChatGPT se sont avérés utiles pour reconstruire le contexte sans recourir à l’inférence en direct. Pour les équipes riches en contenu, passer à des dépôts de brouillons ou à des instantanés figés minimisait le travail de reprise une fois les services rétablis.

| Plateforme 🌐 | Symptôme observé 🧩 | Échelle de gravité 🌡️ | Solution provisoire suggérée 🧰 |

|---|---|---|---|

| X | Blocages de flux et de publication | Élevé 🔴 | Utiliser des planificateurs tiers, retard des diffusions |

| Shopify | Latence au paiement | Élevé 🔴 | Activer les pages de file d’attente, capturer les e-mails |

| ChatGPT | Timeouts, panneaux vides | Élevé 🔴 | Reconstruire à partir des archives, traiter les tâches par lots hors ligne |

| Discord | Échecs de commandes bot | Moyen 🟠 | Modération manuelle et FAQ épinglées |

| League of Legends | Interruptions de parties | Moyen 🟠 | Temps de recharge en file, vérifications de statut |

Les jours de panne ont également mis en lumière des lacunes en compétences. Les équipes de recrutement qui s’appuyaient sur des filtres IA pour les CV ont basculé vers des listes d’outils sélectionnés ; des ressources comme outils gratuits de CV par IA ont aidé à maintenir le débit une fois les systèmes stabilisés. Pendant ce temps, les équipes sociales ont équilibré rapidité et précision, résistant à la tentation d’amplifier des statuts non vérifiés.

Malgré la perturbation, un schéma s’est maintenu : les équipes ayant préconstruit de simples commutateurs « mode lent » et des workflows par lots ont rebondi plus vite. Ce thème de résilience prépare le playbook pratique de la section suivante.

Solutions pendant les pannes du chatbot IA : garder les équipes productives

Quand un chatbot IA comme ChatGPT est entravé par des pannes en couche périphérique, survivre dépend de la continuité du contexte et d’une mise en file intelligente. Les équipes qui s’appuient sur le chatbot pour le résumé, la revue de code ou la rédaction multilingue peuvent atténuer les frictions en passant d’appels en direct à des contenus en cache et du prétraitement hors ligne. L’objectif est modeste : réduire la perte de contexte en attendant la normalisation des chemins réseau.

Premièrement, identifiez ce qui peut être fait sans inférence fraîche. De nombreuses tâches — analyse de fichiers, nettoyage de données, affinage de prompt — peuvent être préparées hors ligne, puis exécutées une fois la capacité revenue. Les bibliothèques documentaires, prompts modèles et procédures standard appartiennent au stockage local rapide ou à un miroir en lecture seule, pas à l’autre bout d’une périphérie congestionnée.

Checklist de réponse rapide pour la perturbation de service

- 🧭 Vérifiez le statut amont et évitez les rafraîchissements forcés répétés

- 📦 Passez aux notes en cache et aux conversations archivées ChatGPT

- 🧮 Pré-structurez les entrées avec des workflows de type analyse de fichiers ChatGPT

- 🔐 Faites tourner ou suspendez les intégrations ; consultez comment maîtriser une clé API ChatGPT

- 🔌 Désactivez les extensions non essentielles ; revisitez les plugins alimentant ChatGPT en 2025

Évitez l’amnésie contextuelle en maintenant une bibliothèque de prompts interne et des exports d’instantanés. Si votre organisation utilise des exécutions au niveau documentaire, conservez les données nettoyées localement et poussez uniquement lorsque les routes sont stables. Pour les équipes produit et juridiques, un résumé concis comme comprendre l’application des cas peut cadrer les risques, les divulgations et les étapes de reprise en cas d’opérations dégradées.

| Problème 🚧 | Solution de contournement 🔧 | Résultat attendu ✅ | Note sur les risques ⚖️ |

|---|---|---|---|

| Timeouts sur les prompts | File d’attente hors ligne ; traitement par lots ultérieur | Moins de tentatives, rattrapage plus rapide | Entrées obsolètes si la source change |

| Contexte de chat perdu | Chargement depuis les archives ; épingler les prompts clés | Continuité sans reprise | Historique partiel si les exports tardent |

| Dépendance aux plugins | Désactivation ; utilisation de chaînes de prompt minimalistes | Appels à la périphérie réduits, moins d’erreurs 500 | Perte de fonctionnalités sur tâches spécifiques |

| Blocages d’intégration API | Recul progressif avec jitter | Stabilité sous charge | Retard des sorties de pipeline |

Autre tactique sous-estimée : répéter le « mode manuel » pour les flux principaux. Une équipe de contenu qui écrit à l’avance une douzaine de formules de titres dépassera une équipe bloquée en attente de l’inférence en direct. En résilience, la préparation l’emporte toujours sur l’improvisation.

Au cœur d’une interruption Cloudflare : DNS, CDN et routage en périphérie sous tension

Les fournisseurs cloud échouent rarement sur des points uniques dramatiques ; ils flanchent sur de petites mésalignements qui se propagent en cascade. Un événement Cloudflare produisant des « erreurs 500 généralisées » indique une pression à travers plusieurs couches — résolution DNS, routage Anycast, population du cache, et logique WAF/limitation de taux. Si les plans de contrôle se dégradent en même temps que les plans de données, l’effet se cumule : les clients ne peuvent pas simplement diagnostiquer ; ils peinent même à ouvrir les tableaux de bord.

Considérez la périphérie comme un maillage de décisions. Le DNS doit diriger le client vers le POP sain le plus proche ; Anycast rend cette sélection de POP dynamique ; la mise en cache doit respecter les TTL et les purges ; et les couches de sécurité passent, challengent ou bloquent les requêtes à grande échelle. Modifier une politique de trafic au mauvais moment — ou propager une configuration alors que certaines régions sont déjà en tension — peut déstabiliser un système stable.

Modes de défaillance correspondant aux symptômes d’aujourd’hui

- 🌍 Dérive BGP ou Anycast envoyant le trafic vers des régions malsaines

- 🛡️ Règles WAF/limitation de taux classant mal les pics comme abusifs

- 🧠 Lenteur du plan de contrôle retardant les retours en arrière de configuration

- 📦 Manques de cache provoquant une surcharge d’origine pendant les purges

- 🔗 Inadéquations TTL DNS allongeant le chemin vers la reprise

L’observabilité est le contrepoids. Des sondes synthétiques multi-régions, des logs périphériques et des graphiques de saturation d’origine peuvent séparer symptômes et causes. Les équipes techniques investissant dans des toggles rouge/vert et des anneaux de déploiement peuvent contenir le rayon d’explosion tout en continuant à fournir un contenu périmé mais acceptable en périphérie.

| Couche 🧱 | Stresseur probable 🌪️ | Symptôme visible 👀 | Atténuation 🧯 |

|---|---|---|---|

| DNS | Inadéquation TTL/config | Résolution intermittente | TTLs courts, déploiements contrôlés |

| Routage | Déséquilibre Anycast/BGP | Pics régionaux 500 | Orientation du trafic, vidage des POP malsains |

| Cache CDN | Purges massives, manques chaud | Surcharge origine | Servir périmé, préchauffer les ressources populaires |

| Sécurité | Règles WAF agressives | Faux positifs à grande échelle | Affiner/désactiver les règles, déploiements en anneau |

| Plan de contrôle | Lenteur API/dashboard | Retours en arrière lents | Toggles hors bande, playbooks |

Le paysage IA plus large court vers l’inférence distribuée et des périphéries plus intelligentes, ce qui élève les enjeux de résilience. Des forums industriels comme NVIDIA GTC Washington DC insights et des initiatives où NVIDIA collabore avec des partenaires laissent entrevoir des architectures mêlant inférence basse latence et routage multi-cloud. À mesure que l’IA « se déplace vers la périphérie », la redondance ne peut plus être une réflexion après coup.

Dans les incidents comme celui d’aujourd’hui, le message est cohérent : il ne s’agit pas seulement de maintenir une seule application active — il s’agit de garder la trame connectrice du web en bonne santé.

Leçons de fiabilité pour ChatGPT et les services Internet après les pannes

La reprise est un test d’architecture et de culture. Pour ChatGPT et ses dépendants, la voie à suivre implique des stratégies multi-régions renforcées, une dégradation élégante, et une communication d’incident qui fixe les attentes sans survendre. La récompense est simple : quand les pannes surviennent — et elles surviendront — les utilisateurs doivent toujours atteindre un résultat viable minimal.

Commencez par le contrôle du trafic. Le déplacement progressif du trafic, le canari dans des anneaux régionaux, et la vidange automatique des POP malsains créent de l’espace respiratoire. Côté application, conçois des réponses « suffisamment bonnes » en période de panne serveur : servir des résumés récents, permettre un historique en lecture seule, et mettre en file les opérations d’écriture. Pour les écosystèmes développeurs, des toggles d’exécution réduisant les appels aux plugins peuvent limiter la dépendance aux périphéries externes.

Un playbook pratique de fiabilité

- 🧪 Exercices de chaos pour pratiquer la bascule et les politiques « servir périmé »

- 🌐 Multi-CDN avec sélection de chemin automatisée sous stress

- 🧰 Replis sur des modèles plus légers ou des embeddings mis en cache

- 📢 Notes de statut claires référant les fournisseurs amonts

- 📚 Guides publics reliant à la gestion des clés API et gouvernance

La résilience n’est pas que logicielle. Les équipes achats doivent comprendre le coût organisationnel de la surdépendance ; des études de cas comme le coût de licencier un génie tech prennent un sens différent quand un expert unique connaît le chemin d’incident par cœur. Pendant ce temps, la R&D investissant dans des frameworks open source pour la robotique ou l’inférence distribuée peut emprunter des modèles de résilience pour l’IA à l’échelle web.

| Action 📌 | Gain de fiabilité 📈 | Suggestion d’outil 🧩 | Valeur utilisateur 💡 |

|---|---|---|---|

| Mode servir périmé | Élevé lors de perte de périphérie | Réglage CDN TTL, clés de cache | Les réponses continuent d’arriver ✅ |

| Déploiements en anneau | Limite le rayon d’explosion | Flags fonctionnels, déploiements graduels | Moins de ruptures visibles 🛡️ |

| Recul élégant | Moins d’orage de requêtes | Jitter exponentiel, files d’attente | Stabilisation plus rapide 🕒 |

| Multi-CDN | Diversité des chemins | Orientation et vérification de santé | Moins de variance d’erreur 🌐 |

| Playbooks de communication | Confiance préservée | Modèles, cadence du statut | Moins de confusion 📢 |

Pour les équipes qui développent extensions et automatisations, composer un ensemble réduit de capacités est avantageux. Des articles sur les plugins alimentant ChatGPT en 2025 peuvent guider sur l’essentiel à garder pendant les turbulences, tandis que les centres d’opérations maintiennent les liens vers les pages de triage et la documentation de secours. La couverture de médias tels que le Hindustan Times montre pourquoi la clarté est cruciale : les jours de panne, les gens cherchent une direction plus que du drame.

Enfin, investissez dans les boucles d’apprentissage. Les postmortems corrélant la télémétrie périphérique aux métriques applicatives rendent le prochain incident plus petit. Quand le web est la plateforme, la résilience est le produit.

Qui a été touché et comment : cartographie de l’impact multi-plateformes de la panne Cloudflare

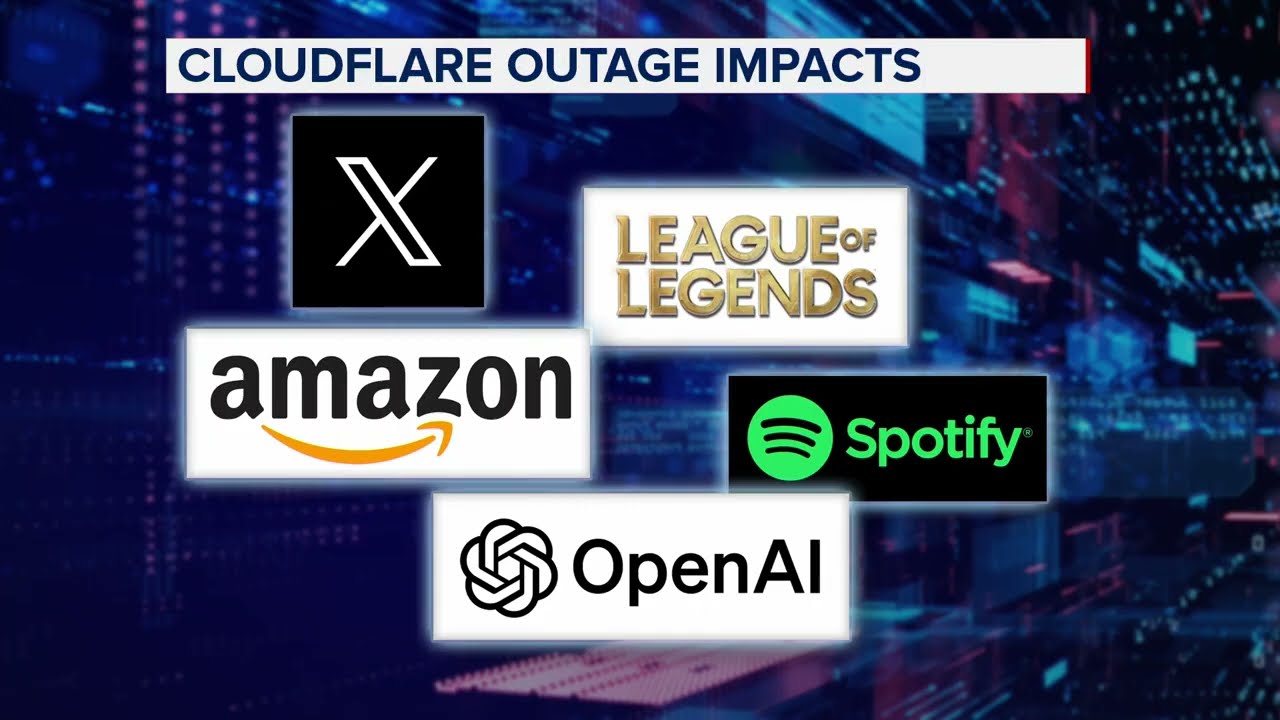

Au-delà de ChatGPT, l’événement Cloudflare a affecté une constellation de marques : X, Canva, Shopify, Garmin, Claude, Verizon, Discord, T-Mobile, et League of Legends parmi celles mentionnées par les lecteurs. Ce qui unissait ces services disparates n’était pas leur secteur, mais leur dépendance commune à une infrastructure périphérique rapide et sécurisée. À mesure que l’infrastructure se délitait, les expériences divergeaient : flux sociaux bloqués, connexions brisées, parties de jeu interrompues en pleine bataille.

Le style de communication a fait la différence. Les plateformes qui affichaient en priorité des notes de statut transparentes — signalant les problèmes amonts, les ETA attendus et les solutions alternatives suggérées — ont observé des communautés plus calmes. D’autres ont appris à la dure que le silence invite la spéculation. Les équipes documentant des workflows alternatifs, notamment comment récupérer le contexte récent du chat, ont soulagé la pression sur leurs lignes de support.

Instantanés intersectoriels

- 📣 Social : campagnes influenceurs stoppées ; les raccourcisseurs de liens ont mis en file les publications

- 🛍️ Commerce de détail : scripts de soldes flash désactivés ; capture d’emails priorisée

- 🧑🎓 Éducation : laboratoires reprogrammés pour les devoirs lourds en inférence

- 🛰️ Cartographie/IoT : télémétrie mise en tampon jusqu’à rétablissement des routes

- 🎧 Centres de support : macros ont remplacé les réponses assistées par IA

Dans chaque cas, un principe unique a amélioré les résultats : dégrader élégamment. Que cela signifiait servir des pages vitrines en cache, offrir des chronologies en lecture seule ou inciter les joueurs à rejoindre des files d’attente moins stressantes, la stratégie était de maintenir quelque chose d’utile en vie. Quand les services Internet deviennent la colonne vertébrale du quotidien, un service partiel vaut mieux que rien.

| Secteur 🧭 | Dépendance principale 🔗 | Symptôme de panne 🚨 | Alternative élégante 🕊️ |

|---|---|---|---|

| Médias | Édition assistée par IA | Brouillons bloqués | Bibliothèques de modèles, publications temporisées |

| Commerce | Ressources mises en cache par CDN | Erreurs de paiement | Pages de file d’attente, blocages d’inventaire |

| Jeux | Sessions en temps réel | Abandons de parties | Files d’attente de repli basse latence |

| Communauté | Bots et webhooks | Lacunes d’automatisation | FAQ épinglées, opérations manuelles |

| Support | IA conversationnelle | Réponses retardées | Macros, extraits de statut |

Pour les équipes planifiant des mises à niveau, lire sur les collaborations qui renforcent l’IA à la périphérie offre une feuille de route. Il ne s’agit pas seulement de vitesse — la fiabilité doit être conçue dès le premier jour. Voilà le titre discret derrière chaque journée de panne.

{« @context »: »https://schema.org », »@type »: »FAQPage », »mainEntity »:[{« @type »: »Question », »name »: »Pourquoi ChatGPT est-il tombé en panne lors de l’incident Cloudflare ? », »acceptedAnswer »:{« @type »: »Answer », »text »: »Le schéma d’erreurs 500 généralisées, de problèmes dashboard/API, et les pics synchronisés sur plusieurs plateformes indiquent un problème en couche périphérique amont chez Cloudflare. La logique applicative était saine dans de nombreux cas, mais le routage, la mise en cache ou la pression sur le plan de contrôle perturbaient l’accès et les réponses. »}},{« @type »: »Question », »name »: »Quelles sont les étapes immédiates à suivre lors d’une perturbation de service ? », »acceptedAnswer »:{« @type »: »Answer », »text »: »Consultez les pages de statut, évitez les rafraîchissements forcés constants, passez aux notes en cache et aux chats archivés, et organisez le travail en file hors ligne. Désactivez les plugins non essentiels et appliquez un recul progressif en cas d’usage d’API. »}},{« @type »: »Question », »name »: »Quelles plateformes ont été affectées en plus de ChatGPT ? », »acceptedAnswer »:{« @type »: »Answer », »text »: »Les rapports mentionnent X, Shopify, Discord, Garmin, Claude, Verizon, T-Mobile et League of Legends parmi les services impactés par l’interruption Cloudflare. »}},{« @type »: »Question », »name »: »Comment les équipes peuvent-elles réduire l’impact de futures pannes ? », »acceptedAnswer »:{« @type »: »Answer », »text »: »Adoptez des stratégies multi-CDN, activez les modes servir périmé, pratiquez des exercices de chaos, et maintenez une communication claire en cas d’incident. Utilisez des déploiements en anneau et une orientation automatique du trafic pour contenir le rayon d’explosion. »}},{« @type »: »Question », »name »: »Où puis-je trouver des guides pratiques et outils après des pannes ? », »acceptedAnswer »:{« @type »: »Answer », »text »: »Des ressources comme des catalogues de codes d’erreur ChatGPT, des guides de gestion de clés API, des audits de plugins et des workflows d’analyse de fichiers aident à accélérer la récupération et réduire le travail de reprise une fois les services stabilisés. »}}]}Pourquoi ChatGPT est-il tombé en panne lors de l’incident Cloudflare ?

Le schéma d’erreurs 500 généralisées, de problèmes dashboard/API, et les pics synchronisés sur plusieurs plateformes indiquent un problème en couche périphérique amont chez Cloudflare. La logique applicative était saine dans de nombreux cas, mais le routage, la mise en cache ou la pression sur le plan de contrôle perturbaient l’accès et les réponses.

Quelles sont les étapes immédiates à suivre lors d’une perturbation de service ?

Consultez les pages de statut, évitez les rafraîchissements forcés constants, passez aux notes en cache et aux chats archivés, et organisez le travail en file hors ligne. Désactivez les plugins non essentiels et appliquez un recul progressif en cas d’usage d’API.

Quelles plateformes ont été affectées en plus de ChatGPT ?

Les rapports mentionnent X, Shopify, Discord, Garmin, Claude, Verizon, T-Mobile et League of Legends parmi les services impactés par l’interruption Cloudflare.

Comment les équipes peuvent-elles réduire l’impact de futures pannes ?

Adoptez des stratégies multi-CDN, activez les modes servir périmé, pratiquez des exercices de chaos, et maintenez une communication claire en cas d’incident. Utilisez des déploiements en anneau et une orientation automatique du trafic pour contenir le rayon d’explosion.

Où puis-je trouver des guides pratiques et outils après des pannes ?

Des ressources comme des catalogues de codes d’erreur ChatGPT, des guides de gestion de clés API, des audits de plugins et des workflows d’analyse de fichiers aident à accélérer la récupération et réduire le travail de reprise une fois les services stabilisés.

-

Modèles d’IA21 heures ago

Modèles d’IA21 heures agomodèles vietnamiens en 2025 : nouveaux visages et étoiles montantes à suivre

-

Tech8 heures ago

Tech8 heures agoUne vue d’ensemble complète du paysage technologique de Palo Alto en 2025

-

Tech3 jours ago

Tech3 jours agoVotre carte ne prend pas en charge ce type d’achat : ce que cela signifie et comment le résoudre

-

Actualités17 heures ago

Actualités17 heures agoDéverrouillez la puissance du Chat de groupe ChatGPT gratuitement : un guide étape par étape pour commencer

-

Modèles d’IA3 jours ago

Modèles d’IA3 jours agoOpenAI vs Tsinghua : Choisir entre ChatGPT et ChatGLM pour vos besoins en IA en 2025

-

Actualités6 heures ago

Actualités6 heures agoPrésentation d’une version gratuite de ChatGPT conçue spécialement pour les enseignants