Co-diseño consciente del hardware para un entrenamiento asequible: Qué señales el artículo DeepSeek-V3 sugiere a continuación

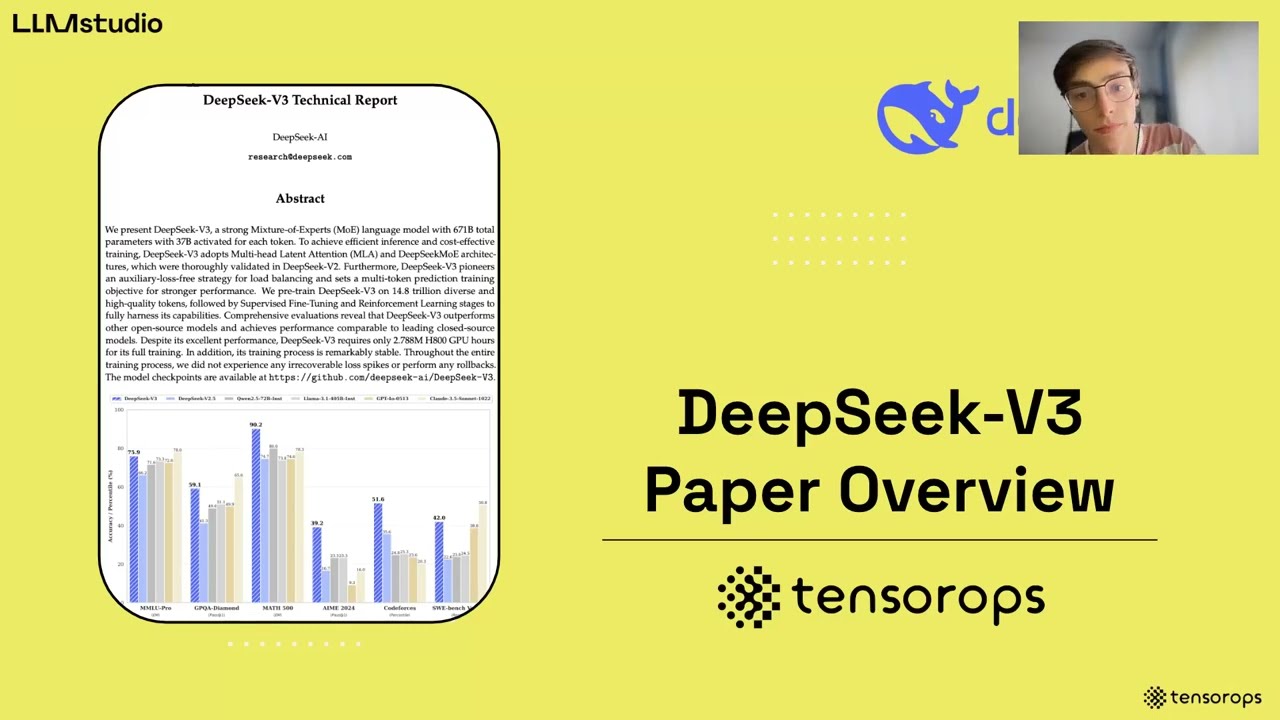

Un nuevo artículo técnico sobre co-diseño consciente del hardware alrededor de DeepSeek-V3 presenta un plan claro: arquitecturas de modelos más inteligentes combinadas con una ingeniería de sistemas deliberada pueden generar enormes ganancias en costo y velocidad sin sacrificar calidad. El equipo entrenó DeepSeek-V3 en 2048 GPUs NVIDIA H800, enfrentando un ancho de banda NVLink (~400 GB/s) limitado y una ampliación restringida por políticas — sin embargo, logró un rendimiento competitivo repensando todo, desde el enrutamiento de expertos hasta la programación de micro-lotes. En lugar de tratar los límites del hardware como techos duros, el diseño se apoya en ellos: evitando el Paralelismo de Tensores que amplifica la presión del all-reduce, enfatizando el Paralelismo de Pipeline para la continuidad del cómputo y acelerando el Paralelismo de Expertos mediante un enrutamiento consciente del ancho de banda. La ética de co-diseño se siente oportuna, ya que organizaciones desde startups hasta empresas consideran presupuestos sostenibles para IA en 2025.

Considere a Orion Labs, una empresa de robótica de mercado medio que está piloteando un asistente de razonamiento. Su clúster: cuatro nodos, cada uno con ocho H800s y red mixta. El entrenamiento tradicional denso de LLM se asfixiaría con el ancho de banda y la memoria. En cambio, MoE con enrutamiento consciente del nodo y comunicación superpuesta permite a Orion escalar dentro de sus limitaciones mientras preserva los SLOs de latencia. Esta es la diferencia pragmática entre IA aspiracional y IA desplegable.

También hay un subtexto de mercado más amplio. Con OpenAI, Google DeepMind, Anthropic, Meta AI y Microsoft Research impulsando modelos de frontera, la cuestión de la asequibilidad se ha convertido en una pregunta estratégica. Los practicantes que operan con PyTorch o TensorFlow, distribuyendo a través de herramientas respaldadas por Hugging Face, ahora necesitan estrategias que armonicen el cómputo de entrenamiento, las huellas de memoria y las realidades de interconexión. El informe DeepSeek-V3 posiciona el co-diseño no solo como una optimización, sino como una disciplina organizacional.

Movimientos clave de co-diseño que modifican la economía

- 🔧 Enrutamiento de expertos consciente del nodo: mantener la mayor parte del tráfico experto dentro del nodo para explotar un mayor ancho de banda NVLink y minimizar la contención de IB.

- 🚀 Superposición dual de micro-lotes: ocultar la latencia de comunicación detrás del cómputo desde el día uno.

- 🧠 Atención Latente Multi-cabeza (MLA): comprimir KV para reducir necesidades de memoria y mantener alto rendimiento.

- 📉 Entrenamiento en precisión mixta FP8: reducir costos computacionales mientras se preserva la calidad mediante calibración extensiva.

- 🌐 Red Multi-Plano Fat-Tree: enrutamiento consciente del plano para una expansión robusta y de baja latencia.

Para equipos que calibran el rendimiento del servicio en relación con los límites del proveedor y las expectativas de los usuarios, vale la pena revisar las restricciones prácticas. Vea este análisis conciso sobre límites de velocidad y escalamiento al dimensionar servicios respaldados por modelos que necesitan latencia consistente bajo carga.

| Palanca de co-diseño 🧩 | Realidad hardware ⚙️ | Adaptación modelo/sistema 🛠️ | Impacto 🎯 |

|---|---|---|---|

| Paralelismo de Expertos | Brecha de ancho de banda IB vs NVLink 😬 | Rutar tokens a expertos principalmente intra-nodo ✅ | Menos congestión IB, mayor rendimiento efectivo 🚀 |

| Compresión MLA KV | El crecimiento de HBM queda rezagado respecto al contexto del modelo 📦 | Comprimir KV por cabeza en vectores latentes 🧠 | Menor memoria, movimiento de caché más rápido ⚡ |

| Entrenamiento FP8 | Presupuestos de cómputo y energía 💡 | FP8 de extremo a extremo con calibración cuidadosa 🎚️ | Ahorros significativos en FLOP, calidad mantenida ✅ |

| Superposición dual de micro-lotes | Bloqueos en comunicación ⏱️ | Programación concurrente de cómputo/comunicación 🔁 | Mejor uso de GPU, latencia más suave 📈 |

En resumen: emparejar elecciones de modelo con programación consciente de la interconexión es el factor decisivo cuando el hardware es imperfecto — lo cual, en producción, siempre es así.

Eficiencia de Memoria con MLA y Compresión KV: La Ventaja de 70 KB/Token de DeepSeek-V3

La memoria es el cuello de botella silencioso de los LLM modernos. Las ventanas de contexto crecen, los prompts se alargan y el caching explota. DeepSeek-V3 replantea el problema haciendo que el caching KV sea más barato en el origen: La Atención Latente Multi-cabeza (MLA) comprime las representaciones key-value de todas las cabezas en un espacio latente conjunto aprendido con el modelo. En inferencia, el sistema almacena en caché solo el vector latente, no el KV completo de cada cabeza, desbloqueando ahorros dramáticos.

La magnitud importa. En comparación con líneas base densas grandes, el artículo destaca una huella KV por token de ~70 KB para DeepSeek-V3. Para ponerlo en perspectiva, cifras comparables citadas para modelos grandes densos pueden alcanzar ~327 KB y ~516 KB por token. En secuencias largas, esa diferencia se acumula en millones de KB ahorrados por lote activo, lo que se traduce en menos intercambios de caché, más lotes residentes y un TPS sostenido más alto.

La compresión por sí sola no cuenta toda la historia. El equipo también discute opciones como GQA/MQA (KV compartidos), caching con ventana y compresión por cuantización. El tema: ser selectivo sobre qué se recuerda y con qué precisión. Cada byte ahorrado de HBM es capacidad que puede ser redeplegada para contextos más largos o más solicitudes concurrentes.

Cómo los equipos pueden aplicar el enfoque MLA más allá de DeepSeek

- 🧮 Cuantificar costos KV por token: medir memoria por token en toda tu pila para descubrir margen oculto.

- 🔬 Probar variantes latentes KV: comenzar con cargas sintéticas para validar curvas de pérdida y compensaciones de latencia.

- 🧰 Combinar técnicas: superponer MLA con KV de ventana o GQA para buscar ganancias multiplicativas.

- 🧵 Caching consciente de la etapa: separar cachés de prellenado y decodificación para priorizar latencias de ruta crítica.

- 📊 Observar tráfico real: los prompts de producción difieren de los benchmarks — medir, no asumir.

Los equipos que ejecutan inferencias bajo limitaciones externas reconocerán el vínculo operativo: si el servicio está limitado por tasa, exprimir más trabajo útil en cada presupuesto por token ayuda. Para contexto sobre cómo los límites de tasa moldean el rendimiento práctico, explore esta profundización en límites de API y cómo interactúan con batchings, expulsión de KV y SLOs de latencia.

| Modelo 🧠 | KV por token (aprox.) 💾 | Técnicas de memoria usadas 🧪 | Efecto práctico 🚀 |

|---|---|---|---|

| DeepSeek-V3 | ~70 KB ✅ | MLA + programación consciente del enrutamiento 🔁 | Mayor residencia de lotes, TPS más estable 📈 |

| Qwen-2.5 72B | ~327 KB 😮 | Atención densa, KV clásico 📦 | Uso intenso de HBM, presión temprana de caché ⏳ |

| LLaMA-3.1 405B | ~516 KB 😵💫 | Atención densa, KV clásico 📦 | Necesidades agresivas de memoria en contexto largo 🧱 |

Curioso cómo otros presentan el trade-off memoria-latencia en prompts de contexto largo? Una búsqueda rápida suele mostrar demos y charlas que desglosan el escalado de KV bajo carga.

Una pregunta retórica para llevar a las revisiones de diseño: si la memoria fuera tu recurso más escaso, ¿cómo remodelarías la atención? La respuesta de DeepSeek — comprimir primero, caché menos — ofrece una plantilla sólida.

Economía de MoE disperso, entrenamiento FP8 e inferencia local: El manual DeepSeekMoE

La razón por la que MoE se siente inevitable en 2025 es simple: la activación dispersa reduce el cómputo sin achicar la capacidad total de parámetros. DeepSeek-V3 ejemplifica esto: ~671B parámetros totales con ~37B activos por token. Esa asimetría permite un modelo con gran amplitud representacional mientras mantiene manejables los FLOPs por token. En las comparaciones del informe, los pares densos consumen cómputo significativamente mayor porque activan todo en cada token, sin importar la especificidad de la tarea.

Esto importa más allá de las facturas en la nube. El cómputo disperso escala hacia dispositivos personales y servidores en el borde. El modelo previo de clase 236B de DeepSeek demostró que ~21B parámetros activos durante la inferencia pueden lograr ~20+ tokens/seg en una PC equipada con SoC de IA capaz — un nivel de rendimiento que modelos densos de escala similar luchan por alcanzar localmente. Para Orion Labs, esto significa que un ingeniero de campo puede ejecutar un asistente especializado offline durante una auditoría en un almacén, para luego sincronizar los insights más tarde.

El artículo también resalta el entrenamiento en precisión mixta FP8, una primicia notable a esta escala para un modelo público — aprovechando el Transformer Engine de NVIDIA con calibración rigurosa y colaboración algoritmo-infraestructura. El beneficio es tangible: menos energía, menos FLOPs y curvas de calidad ajustadas. El equipo reforzó con experimentos de baja precisión LogFMT-nBit para comunicación, reduciendo bytes en el cable durante mezclas de expertos en paralelo. El efecto combinado: menos cuellos de botella desde la memoria, red y cómputo.

Comparación de presupuestos de cómputo que aclaran la compensación

- ⚖️ MoE vs. denso: activar solo lo necesario por token; mantener el resto inactivo para ahorrar FLOPs.

- 🪫 FP8 donde importa: usar menor precisión de extremo a extremo con salvaguardas para mantener estabilidad.

- 📶 Redes comprimidas: programar tokens con metadatos FP8 para reducir a la mitad el volumen de comunicación versus BF16.

- 🧩 Enrutamiento que respeta la topología: restringir la salida de expertos para reducir la charla entre nodos.

- 🧭 Inferencia local primero: trasladar cargas selectas a dispositivos de usuario para privacidad y respuesta rápida.

| Modelo/Modo 🔬 | Parámetros activos/token 🧠 | Cómputo aprox. por token 🧮 | Implicación 📌 |

|---|---|---|---|

| DeepSeek-V3 (MoE) | ~37B ✅ | ~250 GFLOPs ⚡ | Escalabilidad costo-eficiente con calidad sólida 🚀 |

| Qwen2.5–72B (denso) | 72B 😮 | ~394 GFLOPs 🧯 | Costo de entrenamiento mayor, más difícil de escalar 📉 |

| LLaMA-3.1–405B (denso) | 405B 😵 | ~2448 GFLOPs 🧨 | Costo muy alto; requiere interconexión premium 💸 |

Si tu servicio también debe lidiar con techos de API, sujetado por reglas del proveedor o políticas internas de equidad, el manual MoE + FP8 complementa la disciplina operativa. Para un repaso rápido sobre planificación bajo restricciones externas, revisa este contexto sobre restricciones de despliegue de modelos y cómo el batching inteligente junto con la activación dispersa estabilizan la latencia para el usuario.

Otro ángulo práctico: alinear este enfoque con el ecosistema más amplio. OpenAI y Anthropic continúan explorando el escalado centrado en el razonamiento; Google DeepMind y Meta AI tienen caminos abiertos y cerrados. Independientemente de la pila — PyTorch o TensorFlow — la lección persiste: disperso donde sea posible, comprimido donde sea seguro, consciente de la topología siempre que el ancho de banda sea finito.

Rendimiento, Latencia y Superposición: De Micro-lotes Duales a IBGDA

Entrenar y servir a escala es una historia tanto de rendimiento como de latencia en la cola. DeepSeek-V3 está diseñado para alcanzar ambos. La arquitectura usa superposición dual de micro-lotes desde el inicio, organizando el cómputo para que las fases de MLA y MoE entrelacen su programación y comunicación con la ejecución continua del kernel. Es una tubería que actúa como un volante de inercia girando continuamente, diseñada para mantener las GPUs saturadas incluso cuando el tráfico all-to-all fluctúa.

En el lado del servicio, prefill y decode están separados. Prefill con lotes pesados utiliza grupos grandes en paralelo de expertos; decode sensible a la latencia recibe grupos más pequeños y ágiles. Esa separación importa bajo turbulencias—picos en la cola, tamaños mixtos de solicitudes y estructuras de prompt irregulares. Mientras tanto, IBGDA (InfiniBand GPUDirect Async) elimina la sobrecarga de proxy del CPU, permitiendo que las GPUs escriban las campanas RDMA directamente. Para patrones de tráfico con muchos paquetes pequeños — comunes en all-to-all — esto elimina una fuente persistente de jitter.

La red es el lienzo. El equipo desplegó un Multi-Plano Fat-Tree (MPFT) para aumentar robustez y balance. Cada camino GPU–NIC cae en un plano separado; las cargas de trabajo reciben aislamiento de fallas y mejor dispersión de carga. Aunque el despliegue estuvo limitado por políticas, el rendimiento medido en miles de GPUs indica que MPFT puede igualar el throughput all-to-all de multi-rail monocapa, con ganancias operativas en resiliencia.

Tácticas operativas para mantener latencia honesta

- ⏱️ Aislamiento de decode: reservar carriles más pequeños y rápidos para decodificación token a token.

- 🔄 Superposición pipeline: programar micro-lotes para que cada fase de comunicación se oculte detrás de otra de cómputo.

- 🧵 IBGDA en todas partes: permitir que las GPUs gestionen el plano de control evitando cuellos de botella del CPU.

- 🛰️ Enrutamiento consciente del plano: distribuir flujos a través de planos MPFT para amortiguar puntos calientes.

- 📈 Velocidad de salida de tokens: priorizar tokens/segundo para bucles de razonamiento y flujos de RL.

| Técnica ⚙️ | Qué apunta 🎯 | Por qué ayuda 💡 | Efecto observado 📊 |

|---|---|---|---|

| Micro-lote dual | Bloqueos en comm/cómputo 🧊 | Superpone all-to-all con kernels 🔁 | Utilización más suave, menos espacios 🚀 |

| Separación prefill/decode | Picos de latencia en cola 🐢 | Grupos EP dedicados por SLA 🛤️ | p95/p99 estable bajo carga ✅ |

| IBGDA | Sobreataque proxy de CPU 🖥️ | GPU escribe campanas directamente 🔔 | Menor jitter en microsegundos ⏱️ |

| MPFT | Congestión en plano 🚦 | Distribución multi-plano 🌐 | Robustez sin pérdida de throughput 🛡️ |

Si la planificación del servicio requiere alinear la latencia visible por el usuario con los límites de la plataforma, una guía operativa como esta visión operacional sobre límites de throughput puede conectar los puntos entre elecciones algorítmicas y SLOs en producción.

En resumen, la superposición y la conciencia topológica son los poderes silenciosos de las pilas de inferencia modernas.

Direcciones Futuras: Unificando Scale-Up y Scale-Out para la Próxima Ola de IA Asequible

Incluso con enrutamiento cuidadoso, la brecha entre NVLink (intra-nodo) e InfiniBand (inter-nodo) hace que ciertos kernels sean más difíciles de lo necesario. El artículo de DeepSeek-V3 apunta a una Estrella del Norte pragmática: converger scale-up y scale-out con una tela de comunicación unificada y coprocesadores dedicados para manejo y reenvío de mensajes. Al liberar a las unidades de SM de la GPU de la orquestación de paquetes, las pilas de software se simplifican y más chip se dedica a la matemática.

El equipo también señala la asignación dinámica de ancho de banda a través de NVLink y PCIe como condición indispensable. Cuando las búsquedas KV desde la RAM CPU colisionan con tráfico EP, aparecen bloqueos y picos. Chiplets de I/O más inteligentes, priorización nativa y un interconector CPU–GPU más ajustado reducirían la contención. Estándares emergentes como UEC y UALink, además de ideas de “bus unificado”, indican hacia dónde se dirigen los proveedores — hacia telas que tratan localidad y distribución como un solo problema.

La inteligencia de red está atrasada. Piensa en óptica co-empaquetada, mecanismos sin pérdida ajustados para all-to-all y enrutamiento adaptativo que realmente entienda los flujos MoE. Más allá, el artículo señala arquitecturas centradas en memoria — apilamiento de DRAM, integración a escala wafer y compresión/cómputo en red— que atacan la crisis del ancho de banda de memoria que alimenta modelos de contexto largo y cadena de pensamiento. La robustez también recibe atención: cheques silenciosos de corrupción de datos, recuperación más rápida y entrenamiento continuo se vuelven indispensables a escala de miles de GPUs.

Una hoja de ruta práctica para equipos y proveedores

- 🧭 Corto plazo: integrar enrutamiento consciente del nodo y rutas FP8 en tus pilas PyTorch/TensorFlow; formalizar la separación prefill/decode.

- 🏗️ Mediano plazo: adoptar MPFT o análogos multi-rail; impulsar características similares a IBGDA en flotas de aceleradores.

- 🚦 Control de tráfico: experimentar con priorización para migraciones KV; monitorear la utilización a nivel de plano en tiempo real.

- 🧪 Nuevos tipos de datos: probar LogFMT-nBit para metadatos del plano de control y reducir la charla.

- 🧱 Largo plazo: abogar por telas unificadas, coprocesadores de comunicaciones y diseños centrados en memoria con proveedores.

| Dirección 🚀 | Qué cambia en hardware 🧩 | Beneficio software 🧠 | Quién se beneficia 👫 |

|---|---|---|---|

| Tela unificada | NVLink ↔ IB coprocesamiento 🔀 | Kernels más simples; menos bloqueos ⚡ | Nubes, clústeres on-prem, startups 🌱 |

| Control de ancho de banda | Arbitraje dinámico NVLink/PCIe 🎛️ | Latencia de cola más suave 🎯 | Aplicaciones en tiempo real y empresariales 🏢 |

| Centrado en memoria | Apilamiento DRAM, escala wafer 🧱 | Contexto más largo sin intercambios 📚 | Pilas de razonamiento y agentes 🤖 |

| Redes inteligentes | Óptica co-empaquetada, enrutamiento adaptativo 🛰️ | All-to-all estable a escala 🌐 | Entrenamiento MoE y multimodal 🎨 |

Para concretar estas ideas, Orion Labs replantea su hoja de ruta: adoptar redes multi-plano hoy, impulsar telas unificadas en el próximo refresh de hardware y actualizar su despliegue basado en Hugging Face para soportar kernels de inferencia FP8 donde sea seguro. Mientras tanto, los equipos de estrategia triangulan contra líderes de la industria — OpenAI, Google DeepMind, Anthropic, Meta AI — para asegurar capacidad competitiva sin costos descontrolados. Si plataformas externas imponen límites, planificar con esta guía para navegar sistemas con rate limits ayuda a dimensionar concurrencia, batching y presupuestos de tokens antes del lanzamiento.

Finalmente, la visión duradera: el futuro de la IA asequible yace en el diseño de modelos consciente del hardware y el diseño de hardware consciente del modelo encontrándose en el medio.

Para mayor completitud, los equipos de producto también pueden considerar la estabilidad hacia el usuario: cuando los proveedores exigen techos en solicitudes, un manual de planeación como este notas prácticas sobre limitación de servicio ayudará a mantener las promesas alineadas con las realidades de infraestructura.

Diseños de Red que Escalan: MPFT vs MRFT, IB vs RoCE y Dónde Aún se Esconde la Latencia

Debajo de la elegancia de MoE hay una exigencia constante de all-to-all. La evaluación de DeepSeek compara MPFT (Multi-Plano Fat-Tree) con MRFT (Multi-Rail Fat-Tree) y profundiza en el comportamiento de latencia IB vs RoCE. La conclusión probada en campo: MPFT puede igualar el rendimiento all-to-all de MRFT mientras ofrece aislamiento de fallas y facilita la resolución de problemas. InfiniBand marca consistentemente menor latencia en microsegundos que RoCE en la generación actual — útil cuando el trabajo de decodificación es hipersensible al jitter.

El informe señala limitaciones prácticas: el bonding ideal de puertos del lado NIC y la reensamblación fuera de orden nativa entre planos no estuvieron completamente disponibles en algunas implementaciones, pero un silicio más nuevo (p. ej., ConnectX-8) avanza con soporte multi-plano. A medida que esas características llegan, el fat-tree de dos capas se vuelve aún más atractivo: escalable, consciente de costos y con latencias lo suficientemente bajas para los hambrientos patrones MoE. En paralelo, IBGDA demuestra que remover al CPU del camino de control no es un lujo, sino una necesidad.

Decisiones que moldean el comportamiento real del sistema

- 🧭 Elige IB para caminos críticos de latencia: conservar RoCE para almacenamiento o capas sensibles al costo.

- 🛤️ Adoptar MPFT para resiliencia: aislar planos para localizar fallas y balancear carga.

- 🧮 Dimensionar adecuadamente grupos EP: más pequeños para decode, mayores para prefill, ajustados por carga.

- 🧰 Habilitar IBGDA: empujar WRs desde GPU, eliminar mediadores CPU.

- 🛰️ Vigilar características multi-plano en nuevos NICs: bonding de puertos y semánticas de orden son determinantes.

| Elección 🧩 | Pros ✅ | Contras ⚠️ | Mejor para 🏁 |

|---|---|---|---|

| MPFT | Aislamiento de fallas, balance de carga, throughput similar 🚀 | Requiere operaciones y herramientas conscientes del plano 🧭 | Entrenamiento MoE a escala multi-miles de GPUs 🧠 |

| MRFT | Herramientas maduras, amplio soporte 🛠️ | Menos aislamiento; puntos calientes en plano único 🔥 | Cargas de trabajo clásicas data-paralelas 🧪 |

| IB | Latencia menor, pila RDMA fuerte ⏱️ | Riesgos de costo y bloqueo de proveedor 💸 | Decodificación, secciones críticas all-to-all 🎯 |

| RoCE | Amigable con commodity, opciones económicas 🧾 | Mayor latencia, advertencias de escalabilidad 🧯 | Almacenamiento, comunicaciones no críticas 📦 |

Dado que las pilas orientadas al cliente deben reconciliar infraestructura con realidades de producto, el plan operativo debe incluir salvaguardas de superficie. Un repaso rápido — este análisis sobre límites de tasa y escalabilidad — ayuda a calibrar concurrencia, presupuestos de tokens y reglas de modelado antes del despliegue. Así, cuando el modelo se haga más inteligente, la experiencia seguirá siendo fluida.

Conclusión final: la red ahora es parte del modelo. Trátala con la misma rigurosidad que las curvas de pérdida y los conjuntos de evaluación.

{“@context”:”https://schema.org”,”@type”:”FAQPage”,”mainEntity”:[{“@type”:”Question”,”name”:”¿Qué hace que el entrenamiento FP8 en DeepSeek-V3 sea notable por su asequibilidad?”,”acceptedAnswer”:{“@type”:”Answer”,”text”:”Es uno de los primeros entrenamientos MoE a gran escala documentados públicamente que usa FP8 de extremo a extremo en hardware de producción. El enfoque, habilitado por el Transformer Engine de NVIDIA y una calibración cuidadosa, reduce costos computacionales y energéticos mientras mantiene la calidad, lo que baja directamente los presupuestos de entrenamiento y amplía la accesibilidad.”}},{“@type”:”Question”,”name”:”¿Cómo reduce la Atención Latente Multi-cabeza la presión de memoria?”,”acceptedAnswer”:{“@type”:”Answer”,”text”:”MLA comprime los tensores key–value por cabeza en una representación latente compartida aprendida conjuntamente con el modelo. Durante inferencia, solo se almacena en caché el KV latente, reduciendo la memoria por token a aproximadamente 70 KB en DeepSeek-V3 — mucho menor que muchos pares densos — permitiendo más solicitudes concurrentes y contextos más largos.”}},{“@type”:”Question”,”name”:”¿Por qué es importante el enrutamiento experto consciente del nodo?”,”acceptedAnswer”:{“@type”:”Answer”,”text”:”El Paralelismo de Expertos puede sobrecargar los enlaces inter-nodo. Al agrupar expertos por nodo y enrutar tokens para minimizar los saltos entre nodos, DeepSeek-V3 aprovecha mayor ancho de banda intra-nodo, reduce la contención IB y sostiene el throughput bajo cargas reales.”}},{“@type”:”Question”,”name”:”¿Es MPFT mejor que MRFT para todos los despliegues?”,”acceptedAnswer”:{“@type”:”Answer”,”text”:”No siempre. MPFT ofrece fuerte aislamiento de fallas y balance por plano con throughput all-to-all similar en pruebas, pero requiere operaciones y soporte hardware conscientes del plano. Para algunos entornos, la madurez y el conjunto de herramientas de MRFT siguen siendo atractivos.”}},{“@type”:”Question”,”name”:”¿Cómo influyen los límites de tasa de servicio en las decisiones de arquitectura?”,”acceptedAnswer”:{“@type”:”Answer”,”text”:”Cuando las plataformas limitan solicitudes o throughput de tokens, los equipos deben incrementar el trabajo útil por token y suavizar la latencia. Técnicas como MLA, separación prefill/decode y MoE disperso ayudan a lograr un rendimiento constante dentro de los límites. Para un manual, vea este recurso sobre límites de tasa y planificación de throughput: https://chat-gpt-5.ai/chatgpt-rate-limits-insights.”}}]}¿Qué hace que el entrenamiento FP8 en DeepSeek-V3 sea notable por su asequibilidad?

Es uno de los primeros entrenamientos MoE a gran escala documentados públicamente que usa FP8 de extremo a extremo en hardware de producción. El enfoque, habilitado por el Transformer Engine de NVIDIA y una calibración cuidadosa, reduce costos computacionales y energéticos mientras mantiene la calidad, lo que baja directamente los presupuestos de entrenamiento y amplía la accesibilidad.

¿Cómo reduce la Atención Latente Multi-cabeza la presión de memoria?

MLA comprime los tensores key–value por cabeza en una representación latente compartida aprendida conjuntamente con el modelo. Durante inferencia, solo se almacena en caché el KV latente, reduciendo la memoria por token a aproximadamente 70 KB en DeepSeek-V3—mucho menor que muchos pares densos—permitiendo más solicitudes concurrentes y contextos más largos.

¿Por qué es importante el enrutamiento experto consciente del nodo?

El Paralelismo de Expertos puede sobrecargar los enlaces inter-nodo. Al agrupar expertos por nodo y enrutar tokens para minimizar los saltos entre nodos, DeepSeek-V3 aprovecha mayor ancho de banda intra-nodo, reduce la contención IB y sostiene el throughput bajo cargas reales.

¿Es MPFT mejor que MRFT para todos los despliegues?

No siempre. MPFT ofrece fuerte aislamiento de fallas y balance por plano con throughput all-to-all similar en pruebas, pero requiere operaciones y soporte hardware conscientes del plano. Para algunos entornos, la madurez y el conjunto de herramientas de MRFT siguen siendo atractivos.

¿Cómo influyen los límites de tasa de servicio en las decisiones de arquitectura?

Cuando las plataformas limitan solicitudes o throughput de tokens, los equipos deben incrementar el trabajo útil por token y suavizar la latencia. Técnicas como MLA, separación prefill/decode y MoE disperso ayudan a lograr un rendimiento constante dentro de los límites. Para un manual, vea este recurso sobre límites de tasa y planificación de throughput: https://chat-gpt-5.ai/chatgpt-rate-limits-insights.

-

Open Ai1 week ago

Open Ai1 week agoDesbloqueando el Poder de los Plugins de ChatGPT: Mejora Tu Experiencia en 2025

-

Open Ai6 days ago

Open Ai6 days agoDominando la Fine-Tuning de GPT: Una guía para personalizar eficazmente tus modelos en 2025

-

Open Ai7 days ago

Open Ai7 days agoComparando ChatGPT de OpenAI, Claude de Anthropic y Bard de Google: ¿Qué herramienta de IA generativa reinará suprema en 2025?

-

Open Ai6 days ago

Open Ai6 days agoPrecios de ChatGPT en 2025: Todo lo que necesitas saber sobre tarifas y suscripciones

-

Open Ai7 days ago

Open Ai7 days agoLa eliminación progresiva de los modelos GPT: qué pueden esperar los usuarios en 2025

-

Modelos de IA7 days ago

Modelos de IA7 days agoModelos GPT-4: Cómo la inteligencia artificial está transformando 2025