Actualités

Annonce Passionnante : La Prochaine Publication du Papier DeepSeek-V3 Révèle des Stratégies Innovantes pour un Entraînement Abordable de Grands Modèles via la Co-conception Sensible au Matériel

Co-conception consciente du matériel pour un entraînement abordable : ce que le papier DeepSeek-V3 annonce pour la suite

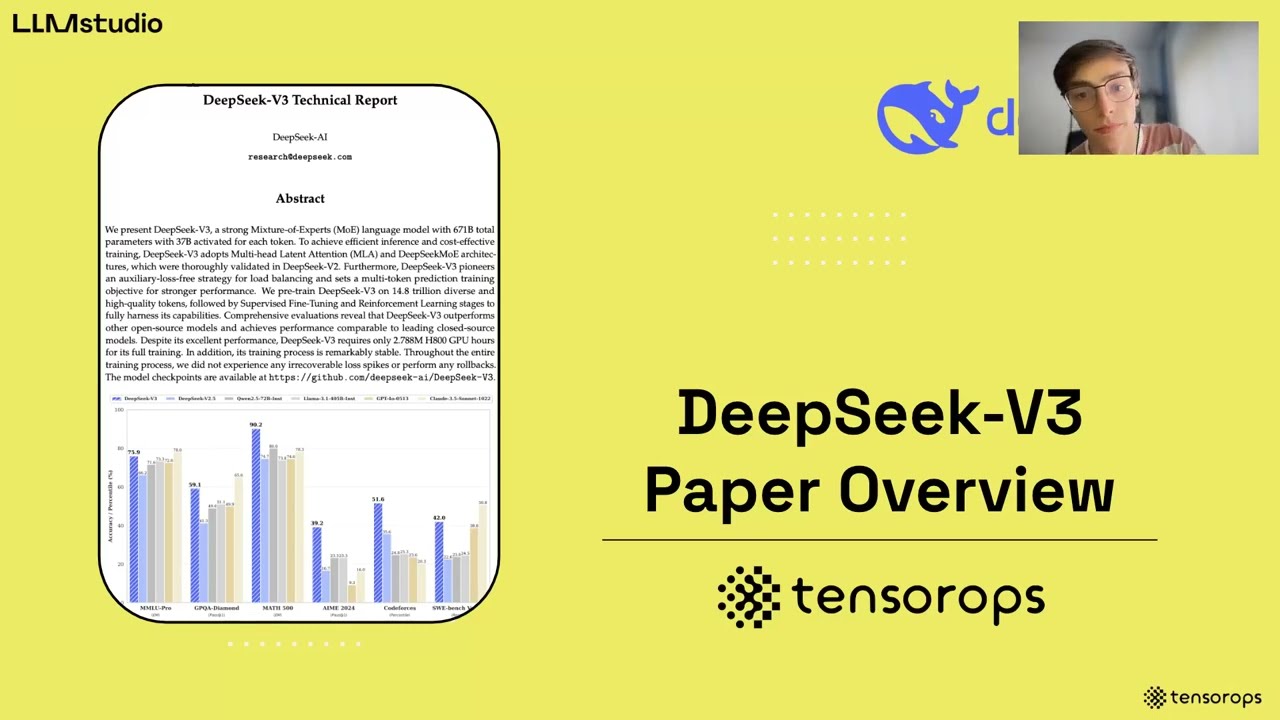

Un nouveau papier technique sur la co-conception consciente du matériel autour de DeepSeek-V3 trace un plan clair : des architectures de modèles plus intelligentes associées à une ingénierie système réfléchie peuvent générer d’importants gains de coût et de vitesse sans sacrifier la qualité. L’équipe a entraîné DeepSeek-V3 sur 2048 GPU NVIDIA H800, confrontée à une bande passante NVLink limitée (~400 GB/s) et à une extension de l’échelle restreinte par la politique — pourtant, elle a obtenu des performances compétitives en repensant tout, du routage des experts à la planification des micro-lots. Plutôt que de considérer les limites matérielles comme des plafonds stricts, la conception s’appuie sur celles-ci : éviter le parallélisme Tensoriel qui amplifie la pression sur all-reduce, mettre l’accent sur le parallélisme Pipeline pour la continuité du calcul, et accélérer le parallélisme Expert avec un routage économe en bande passante. L’éthique de la co-conception semble particulièrement pertinente alors que les organisations, des startups aux entreprises, envisagent des budgets IA durables en 2025.

Considérez Orion Labs, une société de robotique de taille moyenne testant un assistant de raisonnement. Son cluster : quatre nœuds, chacun doté de huit H800 et de réseaux mixtes. La formation classique de LLM denses aurait saturé la bande passante et la mémoire. En revanche, le MoE avec un routage conscient des nœuds et une communication chevauchée permet à Orion de monter en charge dans ses contraintes tout en préservant les SLOs de latence. C’est la différence pragmatique entre une IA aspirative et une IA déployable.

Il y a aussi une nuance plus large du marché. Avec OpenAI, Google DeepMind, Anthropic, Meta AI et Microsoft Research poussant les modèles de pointe, la question de l’abordabilité est devenue stratégique. Les praticiens utilisant PyTorch ou TensorFlow, distribuant via des outils soutenus par Hugging Face, ont désormais besoin de stratégies harmonisant calcul d’entraînement, empreintes mémoire et réalités d’interconnexion. Le rapport DeepSeek-V3 positionne la co-conception non seulement comme une optimisation, mais comme une discipline organisationnelle.

Mouvements clés de co-conception qui modifient l’économie

- 🔧 Routage expert conscient du nœud : garder la majorité du trafic expert intra-nœud pour exploiter la bande passante NVLink plus élevée et minimiser la contention IB.

- 🚀 Chevauchement dual micro-lots : masquer la latence de communication derrière le calcul dès le départ.

- 🧠 Multi-head Latent Attention (MLA) : compresser KV pour réduire les besoins en mémoire et maintenir un débit élevé.

- 📉 Entraînement en précision mixte FP8 : réduire les coûts de calcul tout en conservant la qualité grâce à une calibration approfondie.

- 🌐 Réseautage Multi-Plane Fat-Tree : routage conscient des plans pour une montée en charge robuste et à faible latence.

Pour les équipes calibrant le débit du service face aux plafonds du fournisseur et aux attentes des utilisateurs, il vaut la peine de revisiter les contraintes pratiques. Consultez cette analyse concise des limites de taux et de l’extension lors de la dimensionnement des services reposant sur des modèles qui nécessitent une latence constante sous charge.

| Levier de co-conception 🧩 | Réalité matérielle ⚙️ | Adaptation modèle/système 🛠️ | Impact 🎯 |

|---|---|---|---|

| Parallélisme Expert | Écart de bande passante IB vs NVLink 😬 | Routage des tokens principalement intra-nœud ✅ | Moins de congestion IB, débit effectif plus élevé 🚀 |

| Compression MLA KV | Croissance HBM plus lente que le contexte modèle 📦 | Compression par tête KV en vecteurs latents 🧠 | Moins de mémoire, déplacements cache plus rapides ⚡ |

| Entraînement FP8 | Budgets de calcul et énergie 💡 | FP8 de bout en bout avec calibration rigoureuse 🎚️ | Économies FLOP significatives, qualité maintenue ✅ |

| Chevauchement dual micro-lot | Blocages communication ⏱️ | Planification simultanée calc./comm 🔁 | Meilleure utilisation GPU, latence plus stable 📈 |

En résumé : associer les choix de modèle à une planification consciente de l’interconnexion fait la différence quand le matériel est imparfait—ce qu’il est toujours en production.

Efficacité mémoire avec MLA et compression KV : l’avantage de 70 KB/token de DeepSeek-V3

La mémoire est le goulet d’étranglement silencieux des LLM modernes. Les fenêtres de contexte s’agrandissent, les invites s’allongent et la mise en cache explose. DeepSeek-V3 reformule le problème en rendant le caching KV moins coûteux à la source : Multi-head Latent Attention (MLA) compresse les représentations clé-valeur de toutes les têtes dans un espace latent commun appris avec le modèle. Lors de l’inférence, seul le vecteur latent est mis en cache, pas le KV complet de chaque tête, débloquant des économies spectaculaires.

L’ampleur compte. Par rapport à des références denses larges, le papier souligne une empreinte KV par token d’environ 70 KB pour DeepSeek-V3. À titre de comparaison, les chiffres équivalents cités pour les grands modèles denses peuvent atteindre ~327 KB et ~516 KB par token. Sur de longues séquences, cet écart se cumule en millions de KB économisés par lot actif, ce qui se traduit par moins d’échanges de cache, plus de lots résidents et un TPS soutenu plus élevé.

La compression seule ne raconte pas toute l’histoire. L’équipe discute aussi d’options telles que GQA/MQA (KV partagé), mise en cache fenêtrée et compression par quantification. Le thème : être sélectif sur ce qui est mémorisé et à quelle précision. Chaque octet épargné en HBM est une capacité qui peut être redéployée vers des contextes plus longs ou plus de requêtes simultanées.

Comment les équipes peuvent appliquer la pensée MLA au-delà de DeepSeek

- 🧮 Quantifier le coût KV par token : mesurer la mémoire par token sur votre stack pour exposer les marges cachées.

- 🔬 Tester des variantes latent-KV : commencer avec des charges synthétiques pour valider les courbes de perte et les compromis de latence.

- 🧰 Combiner les techniques : superposer MLA avec KV fenêtré ou GQA pour rechercher des gains multiplicatifs.

- 🧵 Mise en cache consciente des étapes : séparer les caches préremplissage et décodage pour prioriser la latence du chemin critique.

- 📊 Observer le trafic réel : les prompts en production diffèrent des benchmarks—mesurer, ne pas supposer.

Les équipes qui font de l’inférence sous throttling externe reconnaîtront le lien opérationnel : si le service est limité en taux, il faut rentabiliser chaque token. Pour un contexte sur l’impact des plafonds de taux sur le débit pratique, consultez cette analyse approfondie des limites d’API et comment elles interagissent avec le batching, l’éviction KV et les SLOs de latence.

| Modèle 🧠 | KV par token (approx.) 💾 | Techniques mémoire utilisées 🧪 | Effet pratique 🚀 |

|---|---|---|---|

| DeepSeek-V3 | ~70 KB ✅ | MLA + planification consciente du routage 🔁 | Plus grande rétention de batch, TPS plus stable 📈 |

| Qwen-2.5 72B | ~327 KB 😮 | Attention dense, KV classique 📦 | Utilisation HBM plus lourde, pression cache plus rapide ⏳ |

| LLaMA-3.1 405B | ~516 KB 😵💫 | Attention dense, KV classique 📦 | Besoins mémoire agressifs sur longs contextes 🧱 |

Curieux de voir comment d’autres exposent le compromis mémoire-latence sur de longs prompts ? Une recherche rapide révèle souvent des démos et des conférences décomposant la montée en charge KV sous charge.

Une question rhétorique à garder en tête lors des revues de conception : si la mémoire était votre ressource la plus rare, comment remodeleriez-vous l’attention ? La réponse de DeepSeek — compresser d’abord, mettre moins en cache — offre un modèle solide.

Économie sparse MoE, entraînement FP8 et inférence locale : le playbook DeepSeekMoE

La raison pour laquelle le MoE semble inévitable en 2025 est simple : l’activation sparse réduit le calcul sans diminuer la capacité totale de paramètres. DeepSeek-V3 en est un exemple : ~671 milliards de paramètres totaux avec ~37 milliards actifs par token. Cette asymétrie permet un modèle avec une vaste portée représentationnelle tout en gardant les FLOPs par token gérables. Dans les comparaisons du rapport, les pairs denses consomment un calcul nettement plus élevé puisqu’ils activent tout sur chaque token, quelle que soit la spécificité de la tâche.

Ceci dépasse les factures de cloud training. Le modèle précédent de classe 236 milliards de DeepSeek a montré qu’avec ~21 milliards de paramètres actifs durant l’inférence, on peut atteindre ~20+ tokens/sec sur un PC équipé d’un SoC IA performant — un palier de performance que les modèles denses de taille comparable ont du mal à atteindre localement. Pour Orion Labs, cela signifie qu’un ingénieur de terrain peut exécuter un assistant spécialisé hors ligne lors d’un audit d’entrepôt, puis synchroniser les insights plus tard.

Le papier met aussi en avant l’entraînement en précision mixte FP8—une première notable à cette échelle pour un modèle public—tirant parti du Transformer Engine de NVIDIA avec calibration rigoureuse et collaboration algorithmique-infrastructure. Le bénéfice est tangible : moins de puissance, moins de FLOPs et des courbes qualité serrées. L’équipe a approfondi avec des expériences LogFMT-nBit basse précision pour la communication, réduisant les octets sur le réseau lors des mélanges expert-parallèles. L’effet cumulé : moins de goulots d’étranglement de la mémoire au réseau en passant par le calcul.

Comparaisons de budget de calcul qui clarifient le compromis

- ⚖️ MoE vs dense : activer uniquement l’indispensable par token ; garder le reste inactif pour économiser les FLOPs.

- 🪫 FP8 là où ça compte : utiliser une précision plus faible de bout en bout avec des garde-fous pour maintenir la stabilité.

- 📶 Réseautage compressé : planifier les tokens avec métadonnées FP8 pour réduire de moitié le volume commun par rapport au BF16.

- 🧩 Routage respectueux de la topologie : limiter le fan-out des experts pour réduire le bavardage inter-nœuds.

- 🧭 Inférence locale en priorité : pousser certaines charges aux appareils utilisateurs pour la confidentialité et la réactivité.

| Modèle/Mode 🔬 | Params actifs/token 🧠 | Calcul approx. par token 🧮 | Implication 📌 |

|---|---|---|---|

| DeepSeek-V3 (MoE) | ~37B ✅ | ~250 GFLOPs ⚡ | Échelle rentable avec forte qualité 🚀 |

| Qwen2.5–72B (dense) | 72B 😮 | ~394 GFLOPs 🧯 | Coût d’entraînement plus élevé, difficile à étendre 📉 |

| LLaMA-3.1–405B (dense) | 405B 😵 | ~2448 GFLOPs 🧨 | Coût très élevé ; nécessite interconnexion premium 💸 |

Si votre service doit aussi composer avec des plafonds API, le playbook MoE + FP8 complète la discipline opérationnelle. Pour un rappel rapide sur la planification sous contraintes externes, consultez ce contexte sur les contraintes de déploiement des modèles et comment le batching intelligent et l’activation sparse stabilisent la latence côté utilisateur.

Un autre angle pratique : aligner cette approche avec l’écosystème plus large. OpenAI et Anthropic continuent d’explorer l’extension centrée sur le raisonnement ; Google DeepMind et Meta AI ont des pistes ouvertes et fermées. Quel que soit le stack—PyTorch ou TensorFlow—la leçon est claire : sparse quand c’est possible, compressé quand c’est sûr, conscient de la topologie quand la bande passante est limitée.

Débit, latence et chevauchement : des doubles micro-lots à l’IBGDA

L’entraînement et le service à grande échelle racontent une histoire à la fois de débit et de latence extrême. DeepSeek-V3 est conçu pour répondre aux deux. L’architecture utilise le chevauchement dual micro-lot dès le départ, en orchestrant le calcul pour que les phases MLA et MoE alternent leur planification et communication avec l’exécution des noyaux en cours. C’est une pipeline qui agit comme un volant d’inertie tournant continuellement, conçue pour saturer les GPU même lorsque le trafic all-to-all fluctue.

Côté service, préremplissage et décodage sont séparés. Le préremplissage, chargé en batch, utilise des groupes experts-parallèles plus grands ; le décodage sensible à la latence bénéficie de groupes plus petits et agiles. Cette séparation est cruciale sous turbulences — pics de file d’attente, tailles de requêtes mixtes, structures d’invites inégales. Par ailleurs, IBGDA (InfiniBand GPUDirect Async) supprime la surcharge CPU proxy, permettant aux GPU d’écrire directement les sonnettes RDMA. Pour les trafics comportant de nombreux petits paquets — courants dans l’all-to-all — cela élimine une source persistante de jitter.

Le réseau est la toile. L’équipe a déployé un Multi-Plane Fat-Tree (MPFT) pour augmenter robustesse et équilibre. Chaque chemin GPU–NIC atterrit sur un plan distinct ; les charges bénéficient d’isolement de faute et d’une meilleure répartition. Bien que déployé sous limites politiques, la performance mesurée sur des milliers de GPU indique que MPFT peut égaler le multi-rail monoplan en débit all-to-all, avec des gains opérationnels en résilience.

Tactiques opérationnelles pour assurer la latence

- ⏱️ Isolation du décodage : réserver des voies plus petites et rapides pour le décodage token par token.

- 🔄 Chevauchement pipeline : planifier les micro-lots pour que chaque phase comm soit cachée derrière une phase de calcul.

- 🧵 IBGDA partout : laisser les GPU gérer le plan de contrôle pour éviter les goulots CPU.

- 🛰️ Routage conscient du plan : distribuer les flux à travers les plans MPFT pour atténuer les points chauds.

- 📈 Vitesse de sortie des tokens : prioriser les tokens/sec pour les boucles de raisonnement et les workflows RL.

| Technique ⚙️ | Cible 🎯 | Pourquoi ça aide 💡 | Effet observé 📊 |

|---|---|---|---|

| Dual micro-lot | Blocages comm/calcul 🧊 | Chevauche all-to-all avec noyaux 🔁 | Utilisation plus fluide, moins de creux 🚀 |

| Préremplissage/décodage séparés | Pics de latence extrême 🐢 | Groupes EP dédiés par SLA 🛤️ | p95/p99 stable sous charge ✅ |

| IBGDA | Surcharge CPU proxy 🖥️ | GPU écrit les sonnettes directement 🔔 | Moins de jitter microseconde ⏱️ |

| MPFT | Congestion plan 🚦 | Distribution multi-plane 🌐 | Robustesse sans perte de débit 🛡️ |

Si la planification de votre service nécessite d’aligner la latence visible utilisateur sur les limites de la plateforme, ce type de conseils opérationnels comme cette analyse des plafonds de débit peut faire le lien entre choix algorithmiques et SLOs en production.

En résumé, chevauchement et conscience de la topologie sont les super-pouvoirs discrets des stacks modernes d’inférence.

Directions futures : unifier Scale-Up et Scale-Out pour la prochaine vague d’IA abordable

Même avec un routage soigné, le fossé entre NVLink (intra-nœud) et InfiniBand (inter-nœud) rend certains noyaux plus difficiles que nécessaire. Le papier DeepSeek-V3 pointe une étoile polaire pragmatique : converger scale-up et scale-out avec un tissu de communication unifié et des co-processeurs dédiés pour la gestion et le transfert des messages. En déchargeant les SM GPU de l’orchestration des paquets, les stacks logiciels se simplifient et plus de puce revient aux mathématiques.

L’équipe souligne également la répartition dynamique de la bande passante entre NVLink et PCIe comme indispensable. Quand les fetchs KV depuis la RAM CPU entrent en collision avec le trafic EP, apparaissent des blocages et des pics. Des chiplets I/O plus intelligents, une priorisation native et une interconnexion CPU–GPU plus serrée réduiraient la contention. Les standards émergents comme UEC et UALink, ainsi que les idées de “bus unifié”, laissent entrevoir la direction des fournisseurs — vers des fabrics qui traitent localité et distribution comme un seul problème.

L’intelligence réseau est en retard. Pensez à l’optique co-embarquée, aux mécanismes sans perte optimisés pour l’all-to-all, et au routage adaptatif qui comprend vraiment les flux MoE. Plus loin encore, le papier met en lumière les architectures centrées mémoire — empilement DRAM, intégration à l’échelle wafer, compression/calcul sur réseau — qui attaquent la crise de bande passante mémoire impactant les modèles long-contexte et chain-of-thought. La robustesse reçoit aussi de l’attention : contrôles silencieux d’intégrité des données, rétablissement plus rapide et entraînement continu deviennent des indispensables à l’échelle multi-mille GPU.

Feuille de route pratique pour équipes et fournisseurs

- 🧭 Court terme : intégrer le routage conscient du nœud et les chemins FP8 dans vos stacks PyTorch/TensorFlow ; formaliser la séparation préremplissage/décodage.

- 🏗️ Moyen terme : adopter MPFT ou analogues multi-rail ; déployer des fonctionnalités à la IBGDA sur les flottes d’accélérateurs.

- 🚦 Contrôle de trafic : expérimenter la priorisation pour migrations KV ; surveiller l’utilisation des plans en temps réel.

- 🧪 Nouveaux types de données : tester LogFMT-nBit pour les métadonnées du plan de contrôle afin de réduire le bavardage.

- 🧱 Long terme : plaider pour des fabrics unifiés, des coprocessors de communication, et des designs centrés mémoire auprès des fournisseurs.

| Direction 🚀 | Changements matériel 🧩 | Gain logiciel 🧠 | Bénéficiaires 👫 |

|---|---|---|---|

| Tissu unifié | Co-traitement NVLink ↔ IB 🔀 | Noyaux plus simples ; moins de blocages ⚡ | Clouds, clusters sur site, startups 🌱 |

| Contrôle de bande passante | Arbitrage dynamique NVLink/PCIe 🎛️ | Latence tail plus lisse 🎯 | Apps temps réel et entreprises 🏢 |

| Centré mémoire | Empilement DRAM, wafer-scale 🧱 | Contexte plus long sans échanges 📚 | Piles de raisonnement et agents 🤖 |

| Réseaux intelligents | Optique co-embarquée, routage adaptatif 🛰️ | All-to-all stable à grande échelle 🌐 | Entraînement MoE et multimodal 🎨 |

Pour concrétiser ces idées, Orion Labs repense sa feuille de route : adopter le réseautage multi-plane dès aujourd’hui, pousser vers des fabrics unifiés lors du prochain rafraîchissement matériel, et améliorer son déploiement basé sur Hugging Face pour supporter les kernels d’inférence FP8 là où c’est sûr. Pendant ce temps, les équipes stratégiques croisent leurs vues avec les leaders du secteur—OpenAI, Google DeepMind, Anthropic, Meta AI—pour garantir une capacité compétitive sans coûts excessifs. Si les plateformes externes imposent des plafonds, ce guide pour naviguer dans les systèmes limités en taux aide à calibrer concurrence, batching et budgets tokens avant la mise en production.

Enfin, le constat durable : l’avenir de l’IA abordable réside dans la conception de modèles consciente du matériel et la conception matérielle consciente des modèles qui se rencontrent au milieu.

Pour être complets, les équipes produit peuvent aussi considérer la stabilité côté utilisateur : lorsque les fournisseurs imposent des limites de requêtes, des notes pratiques comme celles-ci sur la limitation de service permettront de tenir les promesses en phase avec les réalités d’infrastructure.

Conceptions réseau évolutives : MPFT vs. MRFT, IB vs. RoCE, et où la latence se cache encore

Sous l’élégance du MoE se cache une exigence impitoyable d’all-to-all. L’analyse mesurée de DeepSeek compare le MPFT (Multi-Plane Fat-Tree) au MRFT (Multi-Rail Fat-Tree) et scrute le comportement de latence IB vs. RoCE. La conclusion testée sur le terrain : MPFT peut égaler les performances all-to-all de MRFT tout en offrant isolation de faute et dépannage facilité. InfiniBand affiche systématiquement des latences microsecondes plus basses que RoCE pour la génération actuelle—utile quand le décodage est hypersensible au jitter.

Le rapport note des contraintes pratiques : l’agrégation idéale de ports côté NIC et la réassemblage nativement désordonné entre plans n’étaient pas toujours disponibles dans certains déploiements, mais les siliciums récents (ex. ConnectX-8) font avancer les choses avec le support multi-plane. Avec ces fonctionnalités, le fat-tree à deux couches devient encore plus attractif : scalable, économique et assez bas-latence pour les motifs gourmands du MoE. Parallèlement, l’IBGDA montre que retirer le CPU du chemin de contrôle n’est pas un luxe mais une nécessité.

Décisions qui façonnent le comportement système réel

- 🧭 Choisir IB pour les chemins sensibles à la latence : garder RoCE pour les niveaux de stockage ou sensibles au coût.

- 🛤️ Adopter MPFT pour la résilience : isoler les plans pour localiser les fautes et équilibrer les charges.

- 🧮 Dimensionner correctement les groupes EP : plus petits pour le décodage, plus grands pour le préremplissage, ajustés par charge.

- 🧰 Activer IBGDA : pousser les WR depuis le GPU, supprimer les médiateurs CPU.

- 🛰️ Surveiller les fonctionnalités multi-plane dans les nouveaux NIC : l’agrégation de ports et les sémantiques d’ordre font la différence.

| Choix 🧩 | Avantages ✅ | Inconvénients ⚠️ | Meilleur pour 🏁 |

|---|---|---|---|

| MPFT | Isolation faute, équilibre charge, débit similaire 🚀 | Nécessite des opérations et outils conscients du plan 🧭 | Entraînement MoE à l’échelle multi-mille GPU 🧠 |

| MRFT | Outils matures, large support 🛠️ | Moins d’isolation ; points chauds sur un plan unique 🔥 | Charges classiques data-parallèles 🧪 |

| IB | Latence plus basse, stack RDMA robuste ⏱️ | Coût élevé et risque d’enfermement fournisseur 💸 | Décodage, sections critiques all-to-all 🎯 |

| RoCE | Convivialité commodity, options coût 🧾 | Latence plus élevée, limitations de montée en charge 🧯 | Stockage, communications non critiques 📦 |

Comme les stacks orientés clients doivent concilier infra et réalités produit, le plan opérationnel devrait inclure des protections de surface. Ce rappel rapide — cette analyse des limites de taux et de l’extension — aide à calibrer concurrence, budgets tokens et règles de shaping avant déploiement. Ainsi, quand le modèle devient plus intelligent, l’expérience reste fluide.

Dernier constat : le réseau fait désormais partie du modèle. Traitez-le avec la même rigueur que les courbes de perte et les suites d’évaluation.

{« @context »: »https://schema.org », »@type »: »FAQPage », »mainEntity »:[{« @type »: »Question », »name »: »Qu’est-ce qui rend l’entraînement FP8 dans DeepSeek-V3 remarquable pour l’abordabilité ? », »acceptedAnswer »:{« @type »: »Answer », »text »: »Il s’agit d’un des premiers entraînements MoE à grande échelle documentés publiquement utilisant du FP8 de bout en bout sur du matériel de production. L’approche, rendue possible par le Transformer Engine de NVIDIA et une calibration rigoureuse, réduit les coûts de calcul et d’énergie tout en maintenant la qualité, ce qui diminue directement les budgets d’entraînement et élargit l’accès. »}},{« @type »: »Question », »name »: »Comment la Multi-head Latent Attention réduit-elle la pression mémoire ? », »acceptedAnswer »:{« @type »: »Answer », »text »: »La MLA compresse les tenseurs clé-valeur par tête en une représentation latente partagée appris conjointement avec le modèle. Lors de l’inférence, seul le KV latent est mis en cache, faisant tomber la mémoire par token à environ 70 KB dans DeepSeek-V3—bien moins que chez de nombreux pairs denses—permettant plus de requêtes simultanées et des contextes plus longs. »}},{« @type »: »Question », »name »: »Pourquoi le routage expert conscient du nœud est-il important ? », »acceptedAnswer »:{« @type »: »Answer », »text »: »Le parallélisme expert peut saturer les liens inter-nœuds. En regroupant les experts par nœud et en routant les tokens pour minimiser les sauts inter-nœuds, DeepSeek-V3 exploite la bande passante intra-nœud plus élevée, réduit la contention IB et soutient le débit sous des charges réelles. »}},{« @type »: »Question », »name »: »Le MPFT est-il meilleur que le MRFT pour tous les déploiements ? », »acceptedAnswer »:{« @type »: »Answer », »text »: »Pas toujours. Le MPFT offre une forte isolation de faute et un équilibrage par plan avec un débit all-to-all similaire lors des tests, mais nécessite des opérations conscientes du plan et un support matériel. Pour certains environnements, la maturité et les outils du MRFT restent attractifs. »}},{« @type »: »Question », »name »: »Comment les limites de taux de service influencent-elles les décisions architecturales ? », »acceptedAnswer »:{« @type »: »Answer », »text »: »Lorsque les plateformes plafonnent le nombre de requêtes ou le débit en tokens, les équipes doivent augmenter le travail utile par token et lisser la latence. Des techniques comme MLA, la séparation préremplissage/décodage et le MoE sparse aident à atteindre des performances stables dans ces limites. Pour une introduction, consultez cette ressource sur les plafonds de taux et la planification du débit : https://chat-gpt-5.ai/chatgpt-rate-limits-insights. »}}]}Qu’est-ce qui rend l’entraînement FP8 dans DeepSeek-V3 remarquable pour l’abordabilité ?

Il s’agit d’un des premiers entraînements MoE à grande échelle documentés publiquement utilisant du FP8 de bout en bout sur du matériel de production. L’approche, rendue possible par le Transformer Engine de NVIDIA et une calibration rigoureuse, réduit les coûts de calcul et d’énergie tout en maintenant la qualité, ce qui diminue directement les budgets d’entraînement et élargit l’accès.

Comment la Multi-head Latent Attention réduit-elle la pression mémoire ?

La MLA compresse les tenseurs clé-valeur par tête en une représentation latente partagée appris conjointement avec le modèle. Lors de l’inférence, seul le KV latent est mis en cache, faisant tomber la mémoire par token à environ 70 KB dans DeepSeek-V3—bien moins que chez de nombreux pairs denses—permettant plus de requêtes simultanées et des contextes plus longs.

Pourquoi le routage expert conscient du nœud est-il important ?

Le parallélisme expert peut saturer les liens inter-nœuds. En regroupant les experts par nœud et en routant les tokens pour minimiser les sauts inter-nœuds, DeepSeek-V3 exploite la bande passante intra-nœud plus élevée, réduit la contention IB et soutient le débit sous des charges réelles.

Le MPFT est-il meilleur que le MRFT pour tous les déploiements ?

Pas toujours. Le MPFT offre une forte isolation de faute et un équilibrage par plan avec un débit all-to-all similaire lors des tests, mais nécessite des opérations conscientes du plan et un support matériel. Pour certains environnements, la maturité et les outils du MRFT restent attractifs.

Comment les limites de taux de service influencent-elles les décisions architecturales ?

Lorsque les plateformes plafonnent le nombre de requêtes ou le débit en tokens, les équipes doivent augmenter le travail utile par token et lisser la latence. Des techniques comme MLA, la séparation préremplissage/décodage et le MoE sparse aident à atteindre des performances stables dans ces limites. Pour une introduction, consultez cette ressource sur les plafonds de taux et la planification du débit : https://chat-gpt-5.ai/chatgpt-rate-limits-insights.

-

Open Ai7 jours ago

Open Ai7 jours agoLibérer la puissance des Plugins ChatGPT : améliorez votre expérience en 2025

-

Open Ai6 jours ago

Open Ai6 jours agoMaîtriser l’ajustement fin de GPT : un guide pour personnaliser efficacement vos modèles en 2025

-

Open Ai6 jours ago

Open Ai6 jours agoComparer ChatGPT d’OpenAI, Claude d’Anthropic et Bard de Google : quel outil d’IA générative dominera en 2025 ?

-

Open Ai6 jours ago

Open Ai6 jours agoTarification de ChatGPT en 2025 : Tout ce que vous devez savoir sur les tarifs et abonnements

-

Open Ai6 jours ago

Open Ai6 jours agoLa suppression progressive des modèles GPT : à quoi les utilisateurs peuvent s’attendre en 2025

-

Modèles d’IA6 jours ago

Modèles d’IA6 jours agoModèles GPT-4 : Comment l’intelligence artificielle transforme 2025