Hardware-bewusste Co-Design für erschwingliches Training: Was das DeepSeek-V3-Papier als Nächstes signalisiert

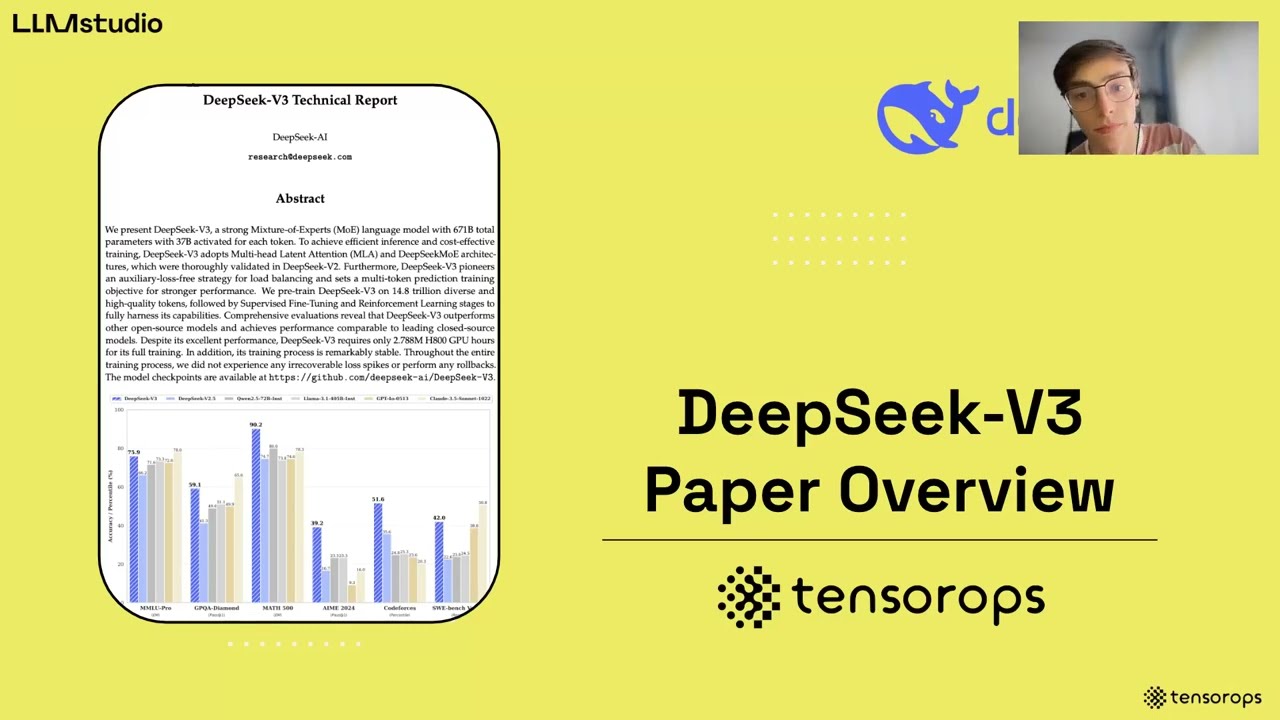

Ein frisches technisches Papier über hardware-bewusstes Co-Design rund um DeepSeek-V3 zeichnet einen klaren Plan: intelligentere Modellarchitekturen kombiniert mit gezieltem Systemengineering können massive Kosteneinsparungen und Geschwindigkeitssteigerungen erzielen, ohne Qualität einzubüßen. Das Team trainierte DeepSeek-V3 auf 2048 NVIDIA H800 GPUs und stand dabei vor begrenzter NVLink-Bandbreite (~400 GB/s) und richtlinienbedingtem Scale-Out—erreichte dennoch wettbewerbsfähige Leistungen, indem es alles von Expert Routing bis Mikro-Batch-Scheduling neu durchdachte. Anstatt Hardwaregrenzen als harte Decken zu sehen, setzt das Design auf sie: Vermeidung von Tensor-Parallelismus, der All-Reduce Druck verstärkt, Fokussierung auf Pipeline-Parallelismus für kontinuierliche Berechnung und Beschleunigung von Expert Parallelism durch bandbreitenbewusstes Routing. Die Co-Design-Philosophie ist zeitgemäß, da Organisationen von Startups bis hin zu Unternehmen nachhaltige KI-Budgets für 2025 ins Auge fassen.

Betrachten Sie Orion Labs, ein Robotikunternehmen im mittleren Marktsegment, das einen Reasoning-Assistenten testet. Sein Cluster: vier Knoten, jeder mit acht H800s und gemischtem Networking. Traditionelles dichtes LLM-Training würde an Bandbreite und Speicher ersticken. Im Gegensatz dazu ermöglicht MoE mit knotenbewusstem Routing und überlappender Kommunikation Orion, innerhalb seiner Beschränkungen zu skalieren und gleichzeitig Latenz-SLOs einzuhalten. Das ist der pragmatische Unterschied zwischen aspirativer KI und einsatzfähiger KI.

Es gibt auch einen breiteren Markthonor. Mit OpenAI, Google DeepMind, Anthropic, Meta AI und Microsoft Research, die an Spitzenmodellen arbeiten, ist die Frage der Erschwinglichkeit strategisch geworden. Praktiker, die in PyTorch oder TensorFlow arbeiten und über Hugging Face-unterstützte Tools verteilen, benötigen nun Strategien, die Trainings-Compute, Speicherbedarf und Interconnect-Realitäten harmonisieren. Der DeepSeek-V3-Bericht positioniert Co-Design nicht nur als Optimierung, sondern als organisatorische Disziplin.

Wichtige Co-Design-Maßnahmen, die die Ökonomie verändern

- 🔧 Knotenbewusstes Expert Routing: den meisten Expertenverkehr intra-knotig halten, um höhere NVLink-Bandbreite auszunutzen und IB-Kontention zu minimieren.

- 🚀 Duale Mikro-Batch-Überlappung: Kommunikationlatenz von Anfang an hinter der Berechnung verbergen.

- 🧠 Multi-head Latent Attention (MLA): KV komprimieren, um Speicherbedarf zu reduzieren und hohen Durchsatz zu bewahren.

- 📉 FP8 Mixed-Precision Training: Berechnungskosten senken und Qualität durch umfangreiche Kalibrierung bewahren.

- 🌐 Multi-Plane Fat-Tree Networking: ebenenbewusstes Routing für robustes, latenzarmes Scale-Out.

Für Teams, die den Durchsatz gegen Anbietergrenzen und Benutzererwartungen kalibrieren, lohnt sich ein Blick auf praktische Einschränkungen. Siehe diese prägnante Analyse von Rate Limits und Skalierung, wenn es darum geht, modellgestützte Dienste zu dimensionieren, die bei Last konstante Latenz benötigen.

| Co-Design-Hebel 🧩 | Hardware-Realität ⚙️ | Modell-/Systemanpassung 🛠️ | Auswirkung 🎯 |

|---|---|---|---|

| Expert Parallelism | IB vs NVLink-Bandbreitenlücke 😬 | Tokens hauptsächlich intra-knotig zu Experten routen ✅ | Weniger IB-Stau, höherer effektiver Durchsatz 🚀 |

| MLA KV-Kompression | HBM-Wachstum hinkt Modellkontext hinterher 📦 | Pro Kopf KV in latente Vektoren komprimieren 🧠 | Weniger Speicher, schnellere Cache-Bewegung ⚡ |

| FP8 Training | Rechen- und Energie-Budgets 💡 | End-to-End FP8 mit sorgfältiger Kalibrierung 🎚️ | Bedeutende FLOP-Einsparungen, Qualität erhalten ✅ |

| Duale Mikro-Batch-Überlappung | Kommunikationsstörungen ⏱️ | Gleichzeitige Berechnungs-/Kommunikationszeitpläne 🔁 | Bessere GPU-Auslastung, gleichmäßigere Latenz 📈 |

Fazit: Die Kombination aus Modellwahl und interconnect-bewusstem Scheduling ist der Unterschiedsmacher, wenn die Hardware nicht perfekt ist—was in der Produktion immer der Fall ist.

Speichereffizienz mit MLA und KV-Kompression: DeepSeek-V3s 70 KB/Token-Vorteil

Speicher ist der stille Flaschenhals moderner LLMs. Kontextfenster wachsen, Eingaben werden länger, und Caching explodiert. DeepSeek-V3 denkt das Problem neu, indem es KV-Caching an der Quelle günstiger macht: Multi-head Latent Attention (MLA) komprimiert die Schlüssel-Wert-Repräsentationen aller Köpfe in einen gemeinsamen latenten Raum, der mit dem Modell gelernt wird. Zur Inferenzzeit speichert das System nur den latenten Vektor, nicht jede einzelne KV des Kopfes, was dramatische Einsparungen ermöglicht.

Die Größenordnung ist entscheidend. Im Vergleich zu großen dichten Baselines hebt das Papier einen pro Token KV-Fußabdruck von ~70 KB für DeepSeek-V3 hervor. Zum Vergleich: Für große dichte Modelle werden Werte von bis zu ~327 KB und ~516 KB pro Token genannt. Bei langen Sequenzen summiert sich dieser Unterschied auf Millionen von KB pro aktivem Batch, was weniger Cache-Wechsel, mehr residente Batches und einen höheren nachhaltigen TPS bedeutet.

Die Kompression allein erzählt nicht die ganze Geschichte. Das Team diskutiert auch Optionen wie GQA/MQA (gemeinsames KV), fensterbasiertes Caching und Quantisierungskompression. Das Thema: selektiv entscheiden, was mit welcher Präzision gespeichert wird. Jedes Byte, das vom HBM eingespart wird, ist Kapazität, die für längere Kontexte oder mehr gleichzeitige Anfragen genutzt werden kann.

Wie Teams das MLA-Denken über DeepSeek hinaus anwenden können

- 🧮 Quantifiziere KV-Kosten pro Token: Miss den Speicher pro Token in deinem Stack, um verstecktes Potenzial aufzudecken.

- 🔬 Teste latente-KV-Varianten: Starte mit synthetischen Workloads, um Verlustkurven und Latenzkompromisse zu validieren.

- 🧰 Kombiniere Techniken: Layer MLA mit fensterbasiertem KV oder GQA, um multiplikative Gewinne zu erzielen.

- 🧵 Stage-bewusstes Caching: Separiere Prefill- und Decode-Caches, um Hot-Path-Latenz zu priorisieren.

- 📊 Beobachte realen Traffic: Produktions-Prompts unterscheiden sich von Benchmarks—messen, nicht vermuten.

Teams, die Inferenz unter externer Drosselung ausführen, erkennen den operativen Zusammenhang: Wenn der Dienst rate-limitiert ist, hilft es, pro Token mehr nützliche Arbeit hineinzupacken. Für Kontext, wie Ratenlimits den praktischen Durchsatz formen, siehe diesen deep dive zu API-Rate-Limits und wie sie mit Batching, KV-Auslagerung und Latenz-SLOs interagieren.

| Modell 🧠 | KV pro Token (ca.) 💾 | Verwendete Speichertechniken 🧪 | Praktischer Effekt 🚀 |

|---|---|---|---|

| DeepSeek-V3 | ~70 KB ✅ | MLA + Routing-bewusstes Scheduling 🔁 | Höhere Batch-Residency, stabilerer TPS 📈 |

| Qwen-2.5 72B | ~327 KB 😮 | Dichte Aufmerksamkeit, klassisches KV 📦 | Stärkerer HBM-Einsatz, früherer Cache-Druck ⏳ |

| LLaMA-3.1 405B | ~516 KB 😵💫 | Dichte Aufmerksamkeit, klassisches KV 📦 | Aggressive Speicherbedürfnisse bei langen Kontexten 🧱 |

Neugierig, wie andere den Speicher-Latenz-Trade-off bei lang-kontaktlichen Eingaben darstellen? Eine schnelle Suche bringt oft Demos und Vorträge ans Licht, die KV-Skalierung unter Last aufschlüsseln.

Eine rhetorische Frage für Design-Reviews: Wenn Speicher deine knappste Ressource wäre, wie würdest du Aufmerksamkeit umformen? DeepSeeks Antwort—zuerst komprimieren, weniger cachen—liefert eine starke Vorlage.

Spärliche MoE-Ökonomie, FP8-Training und lokale Inferenz: Das DeepSeekMoE-Handbuch

Der Grund, warum MoE 2025 unvermeidlich erscheint, ist einfach: spärliche Aktivierung reduziert Berechnung, ohne die Gesamtkapazität der Parameter zu schmälern. DeepSeek-V3 ist ein Beispiel dafür: ~671B Gesamtparameter mit ~37B aktiv pro Token. Diese Asymmetrie ermöglicht ein Modell mit großer repräsentationaler Breite, das gleichzeitig pro Token ein beherrschbares FLOP-Level hält. In den Vergleichen im Bericht verbrauchen dichte Modelle deutlich mehr Berechnung, weil sie bei jedem Token alles aktivieren, unabhängig von der Aufgabenbezogenheit.

Das ist nicht nur für Cloud-Trainingskosten relevant. Spärliche Berechnung skaliert bis zu persönlichen Geräten und Edge-Servern hinunter. DeepSeeks vorheriges 236B-Klassen-Modell zeigte, dass ~21B aktive Parameter während der Inferenz etwa ~20+ Tokens/Sekunde auf einem PC mit fähigem AI-SoC liefern können—eine Leistungsklasse, die dichte Modelle ähnlicher Größe lokal schwer erreichen. Für Orion Labs bedeutet das, dass ein Feldeinsatzingenieur offline einen spezialiserten Assistenten während einer Lagerhausprüfung ausführen und Erkenntnisse später synchronisieren kann.

Das Papier hebt außerdem FP8 Mixed-Precision Training hervor—eine bemerkenswerte Premiere in diesem Maßstab für ein öffentliches Modell—unter Nutzung von NVIDIAs Transformer Engine mit rigoroser Kalibrierung und enger Zusammenarbeit von Algorithmus und Infrastruktur. Der Gewinn ist greifbar: weniger Stromverbrauch, geringere FLOPs und stabile Qualitätskurven. Das Team intensivierte zudem Experimente mit niedrigpräzisem LogFMT-nBit für Kommunikation, reduzierte so die Bytes beim Shuffle im Expert Parallelismus. Die kombinierte Wirkung: weniger Engpässe vom Speicher bis zum Netzwerk und Berechnung.

Vergleiche des Rechenbudgets zur Klarheit des Trades

- ⚖️ MoE vs. dicht: nur das aktivieren, was pro Token benötigt wird; der Rest bleibt inaktiv, um FLOPs zu sparen.

- 🪫 FP8 dort, wo es zählt: durchgängig niedrigere Präzision mit Schutzmechanismen zur Stabilitätswahrung.

- 📶 Komprimiertes Networking: Tokens mit FP8-Metadaten steuern, um Kommunikationsvolumen gegenüber BF16 zu halbieren.

- 🧩 Routing nach Topologie: Expert-Fan-out begrenzen, um cross-node Kommunikation zu reduzieren.

- 🧭 Lokale Inferenz zuerst: ausgewählte Workloads auf Nutzergeräte verschieben für Datenschutz und Reaktionsfähigkeit.

| Modell/Modus 🔬 | Aktive Parameter/Token 🧠 | Ungefährer Compute pro Token 🧮 | Implikation 📌 |

|---|---|---|---|

| DeepSeek-V3 (MoE) | ~37B ✅ | ~250 GFLOPs ⚡ | Kosten-effiziente Skalierung mit starker Qualität 🚀 |

| Qwen2.5–72B (dicht) | 72B 😮 | ~394 GFLOPs 🧯 | Höhere Trainingskosten, schwerer skalierbar 📉 |

| LLaMA-3.1–405B (dicht) | 405B 😵 | ~2448 GFLOPs 🧨 | Sehr hohe Kosten; erfordert Premium-Interconnect 💸 |

Wenn dein Dienst außerdem mit API-Deckeln zu kämpfen hat, die durch Anbieterregeln oder interne Fairnessrichtlinien gesetzt werden, ergänzt das MoE + FP8-Handbuch operative Disziplin. Für eine schnelle Auffrischung zur Planung unter externen Einschränkungen, siehe diesen Kontext zu Modell-Einsatzbeschränkungen und wie intelligentes Batching plus spärliche Aktivierung benutzerseitige Latenz stabilisiert.

Ein weiterer praktischer Blickwinkel: die Abstimmung dieses Ansatzes mit dem breiteren Ökosystem. OpenAI und Anthropic erforschen weiterhin reasoning-zentriertes Scaling; Google DeepMind und Meta AI haben sowohl offene als auch geschlossene Entwicklungswege. Unabhängig vom Stack—PyTorch oder TensorFlow—gilt: spärlich, wo möglich; komprimiert, wo sicher; topologiebewusst, wann immer Bandbreite begrenzt ist.

Durchsatz, Latenz und Überlappung: Von Dual Micro-Batches zu IBGDA

Training und Serving im großen Maßstab ist eine Geschichte von Durchsatz und Ausreißerlatenz. DeepSeek-V3 ist darauf ausgelegt, beides zu erreichen. Die Architektur nutzt von Anfang an duale Mikro-Batch-Überlappung, die Berechnung so organisiert, dass MLA– und MoE-Phasen Ablaufplanung und Kommunikation mit laufender Kernel-Ausführung verweben. Es ist eine Pipeline wie ein kontinuierlich rotierendes Schwungrad, konzipiert, um GPUs stets ausgelastet zu halten, auch wenn All-to-All-Verkehr zu- und abnimmt.

Auf der Serve-Seite sind Prefill und Decode getrennt. Batch-lastiges Prefill nutzt größere Gruppen im Expertenparallelismus; latenzsensitive Decode erhält kleinere, wendige Gruppen. Diese Trennung ist wichtig bei Turbulenzen—Warteschlangenspitzen, gemischte Anfragegrößen und ungleichmäßige Prompt-Strukturen. Gleichzeitig eliminiert IBGDA (InfiniBand GPUDirect Async) CPU-Proxy-Overhead, lässt GPUs RDMA-Doorbells direkt schreiben. Bei Traffic mit vielen kleinen Paketen—üblich bei All-to-All—beseitigt das eine hartnäckige Quelle von Jitter.

Networking ist die Leinwand. Das Team setzte einen Multi-Plane Fat-Tree (MPFT) ein, um Robustheit und Ausgeglichenheit zu erhöhen. Jeder GPU–NIC-Pfad liegt auf einer separaten Ebene; Workloads erhalten Fehlerisolierung und verbesserte Lastverteilung. Obwohl die Implementierung durch Richtlinien begrenzt war, zeigen Leistungsmessungen an Tausenden GPUs, dass MPFT im All-to-All-Durchsatz mit Single-Plane Multi-Rail mithalten kann, mit operativen Vorteilen in der Resilienz.

Operationelle Taktiken, um Latenz ehrlich zu halten

- ⏱️ Decode-Isolation: reserviere kleinere, schnelle Spuren für tokenweise Decodierung.

- 🔄 Pipelined Overlap: Mikro-Batches so terminieren, dass jede Kommunikationsphase hinter einer Berechnungsphase verborgen wird.

- 🧵 IBGDA überall: GPUs das Steuermanagement überlassen, CPU-Bottlenecks vermeiden.

- 🛰️ Ebene-bewusstes Routing: Verteilung der Flüsse über MPFT-Ebenen zur Abschwächung von Hotspots.

- 📈 Token-Ausgabegeschwindigkeit: Tokens/Sekunde für Reasoning-Loops und RL-Workflows priorisieren.

| Technik ⚙️ | Was sie adressiert 🎯 | Warum sie hilft 💡 | Beobachteter Effekt 📊 |

|---|---|---|---|

| Duale Mikro-Batch | Kommunikations-/Berechnungsstau 🧊 | Überlappt All-to-All mit Kerneln 🔁 | Gleichmäßigere Auslastung, weniger Lücken 🚀 |

| Prefill/Decode-Split | Tail-Latenz-Spitzen 🐢 | Dedizierte EP-Gruppen durch SLAs 🛤️ | Stabile p95/p99 unter Last ✅ |

| IBGDA | CPU-Proxy-Overhead 🖥️ | GPU schreibt Doorbells direkt 🔔 | Niedrigere Mikrosekunden-Jitter ⏱️ |

| MPFT | Ebene-Stau 🚦 | Verteilung über mehrere Ebenen 🌐 | Robustheit ohne Durchsatzverlust 🛡️ |

Wenn die Dienstplanung erfordert, von nutzerseitiger Latenz auf Plattformlimits abzustimmen, kann operativer Leitfaden wie dieser Einblick in Durchsatzlimits helfen, die Verbindung zwischen algorithmischen Entscheidungen und Produktions-SLOs herzustellen.

Kurz gesagt, Überlagerung und Topologiebewusstsein sind die stillen Superkräfte moderner Inferenz-Stacks.

Zukünftige Richtungen: Vereinheitlichung von Scale-Up und Scale-Out für die nächste Welle erschwinglicher KI

Selbst bei sorgfältigem Routing macht die Kluft zwischen NVLink (innerhalb der Knoten) und InfiniBand (zwischen Knoten) bestimmte Kernel schwieriger als nötig. Das DeepSeek-V3-Papier nennt als pragmatischen Nordstern: Konvergenz von Scale-up und Scale-out mit einem einheitlichen Kommunikationsfabric und dedizierten Co-Prozessoren für Nachrichtenhandling und Weiterleitung. Durch Entlastung der GPU- SMs von Paket-Orchestrierung vereinfachen sich Software-Stacks, und mehr des Chips kehrt zur mathematischen Berechnung zurück.

Das Team hebt auch dynamische Bandbreitenzuweisung über NVLink und PCIe als unverzichtbar hervor. Wenn KV-Fetches aus CPU-RAM mit EP-Verkehr kollidieren, entstehen Staus und Spitzen. Intelligente I/O-Chipletts, native Priorisierung und ein engerer CPU-GPU-Interconnect würden die Kontention reduzieren. Neue Standards wie UEC und UALink sowie Ideen eines „einheitlichen Busses“ deuten an, wohin sich Anbieter bewegen—zu Fabrics, die Lokalität und Verteilung als ein Problem behandeln.

Netzwerk-Intelligenz ist überfällig. Denken Sie an Co-Packaged Optics, verlustfreie Mechanismen, die für All-to-All optimiert sind, und adaptive Routing-Methoden, die MoE-Flüsse wirklich verstehen. Weiter entfernt hebt das Papier speicherzentrierte Architekturen hervor—DRAM-Stapelung, Wafer-Scale-Integration und On-Network-Kompression/Berechnung—die die Speicherbandbreitenkrise adressieren, die lange Kontexte und Chain-of-Thought-Modelle nährt. Robustheit erhält ebenso Fokus: stille Datenkorruptionsprüfungen, schnellere Wiederherstellung und ununterbrochenes Training werden bei mehreren Tausend GPUs zum Standard.

Ein praktischer Fahrplan für Teams und Anbieter

- 🧭 Kurzfristig: Bake knotenbewusstes Routing und FP8-Pfade in deine PyTorch-/TensorFlow-Stacks ein; formalisier die Trennung von Prefill und Decode.

- 🏗️ Mittelfristig: Übernimm MPFT oder Multi-Rail-Analoge; treib IBGDA-ähnliche Features über Accelerator-Flotten voran.

- 🚦 Verkehrskontrolle: Experimentiere mit Priorisierung für KV-Migrationen; überwache die Ebenenauslastung in Echtzeit.

- 🧪 Neue Datentypen: Teste LogFMT-nBit für Control-Plane-Metadaten, um Kommunikationsrauschen zu reduzieren.

- 🧱 Langfristig: Setze dich für einheitliche Fabrics, Kommunikations-Co-Prozessoren und speicherzentrierte Designs bei Anbietern ein.

| Richtung 🚀 | Was sich in der Hardware ändert 🧩 | Software-Vorteil 🧠 | Wer profitiert 👫 |

|---|---|---|---|

| Vereinheitlichtes Fabric | NVLink ↔ IB Co-Processing 🔀 | Einfachere Kernel; weniger Staus ⚡ | Clouds, On-Prem-Cluster, Startups 🌱 |

| Bandbreitenkontrolle | Dynamische NVLink/PCIe-Arbitration 🎛️ | Gleichmäßigere Tail-Latenz 🎯 | Echtzeit- und Enterprise-Apps 🏢 |

| Speicherzentriert | DRAM-Stapelung, Wafer-Scale 🧱 | Längere Kontexte ohne Swaps 📚 | Reasoning- und Agent-Stacks 🤖 |

| Intelligente Netzwerke | Co-Packaged Optics, adaptives Routing 🛰️ | Stabiles All-to-All bei großem Maßstab 🌐 | MoE- und multimodales Training 🎨 |

Um diese Ideen zu untermauern, denkt Orion Labs seinen Fahrplan neu: heutiges Multi-Plane-Networking einführen, bei der nächsten Hardware-Aktualisierung für vereinheitlichte Fabrics sorgen und die Hugging Face-basierte Bereitstellung auf FP8-Inferenz-Kerne ausweiten, wenn sicher. Parallel sondieren Strategie-Teams mit Branchenführern wie OpenAI, Google DeepMind, Anthropic und Meta AI die Lage, um wettbewerbsfähig zu bleiben ohne explodierende Kosten. Wenn externe Plattformen Limits setzen, hilft eine vorausschauende Planung mit diesem Leitfaden zum Navigieren rate-limitierter Systeme, um Parallelität, Batching und Token-Budgetierung vor dem Go-Live richtig auszulegen.

Schließlich die beständige Erkenntnis: Die Zukunft erschwinglicher KI liegt im hardware-bewussten Modelldesign und modell-bewussten Hardwaredesign, die sich in der Mitte treffen.

Zur Vollständigkeit können Produktteams auch nutzerseitige Stabilität berücksichtigen: Wenn Anbieter Anfragedächer erzwingen, helfen Planungsgrundlagen wie diese praktischen Hinweise zur Servicedrosselung, Versprechen mit der Infrastruktur in Einklang zu bringen.

Netzwerkdesigns, die skalieren: MPFT vs. MRFT, IB vs. RoCE und wo Latenz noch verborgen bleibt

Unter der Eleganz von MoE liegt eine unnachgiebige All-to-All-Anforderung. DeepSeeks fundierte Einschätzung vergleicht MPFT (Multi-Plane Fat-Tree) mit MRFT (Multi-Rail Fat-Tree) und geht auf die Latenzverhalten von IB vs. RoCE ein. Das feldgetestete Fazit: MPFT kann mit der All-to-All-Leistung von MRFT mithalten und bietet dabei Fehlerisolierung und einfachere Fehlersuche. InfiniBand liefert in der aktuellen Generation zuverlässig niedrigere Mikrosekundenlatenz als RoCE—nützlich, wenn die Decode-Arbeit hypersensitiv auf Jitter reagiert.

Der Bericht nennt praktische Einschränkungen: Ideales NIC-seitiges Port-Bonding und native out-of-order Reassembly über Ebenen standen in manchen Implementierungen nicht vollständig zur Verfügung, aber neuerer Silizium (z. B. ConnectX-8) bringt mit Multi-Plane-Support Fortschritte. Wenn diese Funktionen ankommen, wird der zweischichtige Fat-Tree noch attraktiver: skalierbar, kostenbewusst und latenzarm genug für MoEs anspruchsvolle Muster. Parallel demonstriert IBGDA, dass das Entfernen der CPU aus dem Steuerpfad kein nettes Feature, sondern Pflicht ist.

Entscheidungen, die das reale Systemverhalten prägen

- 🧭 IB für latenzkritische Pfade wählen: RoCE für Speicher oder kostensensible Ebenen nutzen.

- 🛤️ MPFT für Resilienz übernehmen: Ebenen isolieren, um Fehler zu lokalisieren und Last zu balancieren.

- 🧮 EP-Gruppen größenrichtig anpassen: kleiner für Decode, größer für Prefill, je nach Workload feinjustiert.

- 🧰 IBGDA aktivieren: WRs von GPU pushen, CPU-Mediatoren entfernen.

- 🛰️ Nach Multi-Plane-Funktionen in neuen NICs Ausschau halten: Port-Bonding und Ordnungssemantik sind Game-Changer.

| Wahl 🧩 | Vorteile ✅ | Nachteile ⚠️ | Geeignet für 🏁 |

|---|---|---|---|

| MPFT | Fehlerisolierung, Lastenausgleich, vergleichbarer Durchsatz 🚀 | Erfordert ebenenbewusste Operationen und Tools 🧭 | MoE-Training bei mehreren Tausend GPUs 🧠 |

| MRFT | Ausgereifte Tools, breite Unterstützung 🛠️ | Weniger Isolation; Hotspots bei Einzelebenen 🔥 | Klassische datenparallele Workloads 🧪 |

| IB | Niedrige Latenz, starke RDMA-Unterstützung ⏱️ | Kosten- und Anbieter-Lock-in-Risiken 💸 | Decode, all-to-all-kritische Abschnitte 🎯 |

| RoCE | Commodity-freundlich, kostengünstige Optionen 🧾 | Höhere Latenz, Skalierbarkeitsprobleme 🧯 | Speicher, nicht-kritische Kommunikation 📦 |

Da kundenorientierte Stacks Infrastruktur und Produktrealitäten in Einklang bringen müssen, sollte der Betriebsplan grundlegende Schutzmechanismen umfassen. Eine kurze Auffrischung—diese Analyse von Rate Limits und Skalierung—hilft dabei, Parallelität, Token-Budgets und Shaping-Regeln vor dem Rollout präzise zu kalibrieren. So bleibt das Erlebnis auch mit intelligenteren Modellen flüssig.

Abschließende Erkenntnis: Das Netzwerk ist heute Teil des Modells. Behandle es mit derselben Sorgfalt wie Verlustkurven und Evaluierungs-Suites.

{“@context”:”https://schema.org”,”@type”:”FAQPage”,”mainEntity”:[{“@type”:”Question”,”name”:”Was macht FP8-Training in DeepSeek-V3 hinsichtlich Erschwinglichkeit bemerkenswert?”,”acceptedAnswer”:{“@type”:”Answer”,”text”:”Es ist eine der ersten öffentlich dokumentierten großskaligen MoE-Trainings, die End-to-End FP8 auf Produktionshardware verwenden. Der Ansatz, ermöglicht durch NVIDIAs Transformer Engine und sorgfältige Kalibrierung, reduziert Rechen- und Energiekosten bei Erhalt der Qualität, was Trainingsbudgets direkt senkt und die Zugänglichkeit erhöht.”}},{“@type”:”Question”,”name”:”Wie reduziert Multi-head Latent Attention den Speicherbedarf?”,”acceptedAnswer”:{“@type”:”Answer”,”text”:”MLA komprimiert pro Kopf Schlüssel-Wert-Tensoren in eine gemeinsame latente Repräsentation, die gemeinsam mit dem Modell gelernt wird. Während der Inferenz wird nur das latente KV gespeichert, wodurch der pro-Token Speicher auf etwa 70 KB in DeepSeek-V3 sinkt—deutlich weniger als bei vielen dichten Modellen—was mehr gleichzeitige Anfragen und längere Kontexte ermöglicht.”}},{“@type”:”Question”,”name”:”Warum ist knotenbewusstes Expert Routing so wichtig?”,”acceptedAnswer”:{“@type”:”Answer”,”text”:”Expert Parallelism kann Inter-Knoten-Verbindungen überlasten. Durch Gruppierung von Experten pro Knoten und Routing von Tokens, um Cross-Knoten-Sprünge zu minimieren, nutzt DeepSeek-V3 höhere Intra-Knoten-Bandbreite, reduziert IB-Kontention und hält den Durchsatz bei realen Workloads stabil.”}},{“@type”:”Question”,”name”:”Ist MPFT für alle Deployments besser als MRFT?”,”acceptedAnswer”:{“@type”:”Answer”,”text”:”Nicht immer. MPFT bietet starke Fehlerisolierung und ebenenweise Lastverteilung mit ähnlichem All-to-All-Durchsatz in Tests, benötigt aber ebenenbewusste Operationen und Hardwareunterstützung. Für manche Umgebungen sind Reife und Tools von MRFT weiterhin attraktiv.”}},{“@type”:”Question”,”name”:”Wie beeinflussen Service-Rate-Limits Architekturentscheidungen?”,”acceptedAnswer”:{“@type”:”Answer”,”text”:”Wenn Plattformen Anfrage- oder Token-Durchsätze begrenzen, müssen Teams mehr nützliche Arbeit pro Token leisten und Latenz glätten. Techniken wie MLA, Trennung von Prefill/Decode und spärliches MoE helfen, konstante Leistung innerhalb der Limits zu erreichen. Für eine Einführung siehe diese Ressource zu Rate-Caps und Durchsatzplanung: https://chat-gpt-5.ai/chatgpt-rate-limits-insights.”}}]}Was macht FP8-Training in DeepSeek-V3 hinsichtlich Erschwinglichkeit bemerkenswert?

Es ist eine der ersten öffentlich dokumentierten großskaligen MoE-Trainings, die End-to-End FP8 auf Produktionshardware verwenden. Der Ansatz, ermöglicht durch NVIDIAs Transformer Engine und sorgfältige Kalibrierung, reduziert Rechen- und Energiekosten bei Erhalt der Qualität, was Trainingsbudgets direkt senkt und die Zugänglichkeit erhöht.

Wie reduziert Multi-head Latent Attention den Speicherbedarf?

MLA komprimiert pro Kopf Schlüssel-Wert-Tensoren in eine gemeinsame latente Repräsentation, die gemeinsam mit dem Modell gelernt wird. Während der Inferenz wird nur das latente KV gespeichert, wodurch der pro-Token Speicher auf etwa 70 KB in DeepSeek-V3 sinkt—deutlich weniger als bei vielen dichten Modellen—was mehr gleichzeitige Anfragen und längere Kontexte ermöglicht.

Warum ist knotenbewusstes Expert Routing so wichtig?

Expert Parallelism kann Inter-Knoten-Verbindungen überlasten. Durch Gruppierung von Experten pro Knoten und Routing von Tokens, um Cross-Knoten-Sprünge zu minimieren, nutzt DeepSeek-V3 höhere Intra-Knoten-Bandbreite, reduziert IB-Kontention und hält den Durchsatz bei realen Workloads stabil.

Ist MPFT für alle Deployments besser als MRFT?

Nicht immer. MPFT bietet starke Fehlerisolierung und ebenenweise Lastverteilung mit ähnlichem All-to-All-Durchsatz in Tests, benötigt aber ebenenbewusste Operationen und Hardwareunterstützung. Für manche Umgebungen sind Reife und Tools von MRFT weiterhin attraktiv.

Wie beeinflussen Service-Rate-Limits Architekturentscheidungen?

Wenn Plattformen Anfrage- oder Token-Durchsätze begrenzen, müssen Teams mehr nützliche Arbeit pro Token leisten und Latenz glätten. Techniken wie MLA, Trennung von Prefill/Decode und spärliches MoE helfen, konstante Leistung innerhalb der Limits zu erreichen. Für eine Einführung siehe diese Ressource zu Rate-Caps und Durchsatzplanung: https://chat-gpt-5.ai/chatgpt-rate-limits-insights.

-

Open Ai1 week ago

Open Ai1 week agoEntfesselung der Power von ChatGPT-Plugins: Verbessern Sie Ihr Erlebnis im Jahr 2025

-

Open Ai6 days ago

Open Ai6 days agoMastering GPT Fine-Tuning: Ein Leitfaden zur effektiven Anpassung Ihrer Modelle im Jahr 2025

-

Open Ai7 days ago

Open Ai7 days agoVergleich von OpenAIs ChatGPT, Anthropics Claude und Googles Bard: Welches generative KI-Tool wird 2025 die Vorherrschaft erlangen?

-

Open Ai6 days ago

Open Ai6 days agoChatGPT-Preise im Jahr 2025: Alles, was Sie über Tarife und Abonnements wissen müssen

-

Open Ai7 days ago

Open Ai7 days agoDas Auslaufen der GPT-Modelle: Was Nutzer im Jahr 2025 erwartet

-

KI-Modelle7 days ago

KI-Modelle7 days agoGPT-4-Modelle: Wie Künstliche Intelligenz das Jahr 2025 verändert