Uncategorized

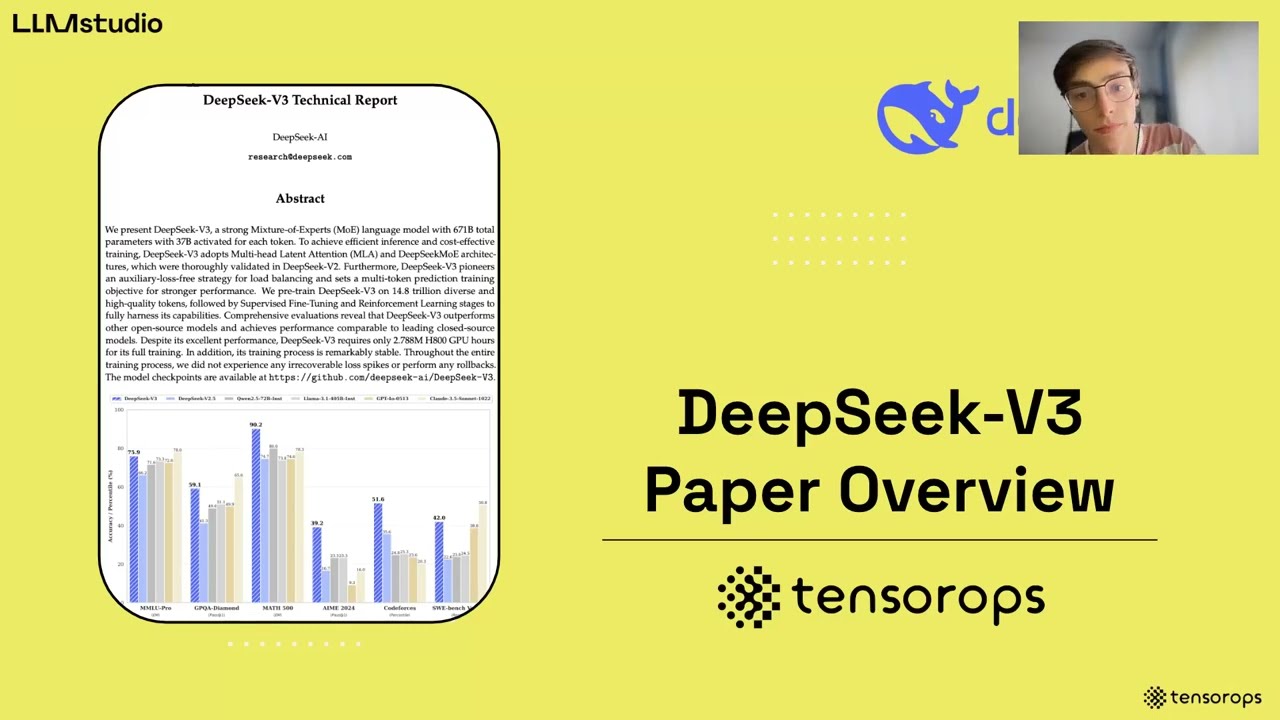

Волнительное объявление: предстоящий выход статьи DeepSeek-V3 раскрывает инновационные стратегии для доступного обучения больших моделей через аппаратно-ориентированный кодизайн

Совместная разработка с учетом аппаратного обеспечения для доступного обучения: что сигнализирует статья DeepSeek-V3

Новая техническая статья о совместной разработке с учетом аппаратного обеспечения вокруг DeepSeek-V3 предлагает четкий план: более умные архитектуры моделей в сочетании с продуманной инженерией системы могут обеспечить значительное сокращение затрат и ускорение без ущерба для качества. Команда обучала DeepSeek-V3 на 2048 NVIDIA H800 GPU, сталкиваясь с ограниченной пропускной способностью NVLink (~400 ГБ/с) и политически ограниченным масштабированием — однако по-прежнему достигла конкурентоспособных результатов, переосмыслив все — от маршрутизации экспертов до планирования микропакетов. Вместо того чтобы рассматривать аппаратные ограничения как жесткие пределы, дизайн использует их: избегая Tensor Parallelism, который увеличивает нагрузку на all-reduce, акцентируя Pipeline Parallelism для непрерывности вычислений и ускоряя Expert Parallelism с помощью маршрутизации, оптимизированной под пропускную способность. Эту философию совместной разработки можно считать актуальной, поскольку организации — от стартапов до корпораций — нацелены на устойчивые бюджеты на ИИ в 2025 году.

Рассмотрим Orion Labs, средний робототехнический компания, тестирующую помощника для рассуждений. Ее кластер: четыре узла, каждый с восемью H800 и смешанной сетью. Традиционное плотное обучение больших языковых моделей задушит пропускную способность и память. Напротив, MoE с маршрутизацией с учетом узлов и перекрывающейся коммуникацией позволяет Orion масштабироваться в пределах своих ограничений, сохраняя уровень задержки SLO. Это практическая разница между амбициозным ИИ и готовым к развертыванию ИИ.

Также есть более широкий рыночный подтекст. При том, что OpenAI, Google DeepMind, Anthropic, Meta AI и Microsoft Research продвигают передовые модели, вопрос доступности стал стратегическим. Практики, работающие в PyTorch или TensorFlow, и распространяющие с помощью инструментов, поддерживаемых Hugging Face, теперь нуждаются в стратегиях, гармонизирующих вычисления при обучении, размеры памяти и реалии межсоединений. Отчет DeepSeek-V3 позиционирует совместную разработку не просто как оптимизацию, а как организационную дисциплину.

Ключевые ходы совместной разработки, меняющие экономику

- 🔧 Маршрутизация экспертов с учетом узлов: сохраняйте большую часть трафика экспертов внутри узла для использования более высокой пропускной способности NVLink и минимизации конфликтов IB.

- 🚀 Двойное перекрытие микропакетов: скрывайте задержку коммуникации за процессом вычислений с самого начала.

- 🧠 Многошаговое латентное внимание (MLA): сжимайте ключ-значение, чтобы уменьшить потребности в памяти и сохранить высокую пропускную способность.

- 📉 Обучение со смешанной точностью FP8: сокращайте вычислительные затраты при сохранении качества благодаря тщательной калибровке.

- 🌐 Сеть Multi-Plane Fat-Tree: маршрутизация с учетом плоскостей для надежного и низкозадержечного масштабирования.

Для команд, подстраивающих производительность сервиса под ограничения провайдера и ожидания пользователей, стоит пересмотреть практические ограничения. Смотрите этот сжатый анализ лимитов скорости и масштабирования при определении размеров сервисов, основанных на моделях, которым нужна стабильная задержка под нагрузкой.

| Рычаг совместной разработки 🧩 | Реальность аппаратуры ⚙️ | Адаптация модели/системы 🛠️ | Влияние 🎯 |

|---|---|---|---|

| Expert Parallelism | Разрыв пропускной способности IB и NVLink 😬 | Маршрутизация токенов преимущественно внутри узла ✅ | Меньше перегрузки IB, выше эффективная пропускная способность 🚀 |

| Сжатие MLA KV | Рост HBM отстает от контекста модели 📦 | Сжатие per-head KV в латентные векторы 🧠 | Меньше память, быстрее кэширование ⚡ |

| Обучение FP8 | Бюджеты вычислений и энергии 💡 | FP8 end-to-end с тщательной калибровкой 🎚️ | Значительная экономия FLOP, сохранение качества ✅ |

| Двойное перекрытие микропакетов | Застои коммуникации ⏱️ | Параллельное планирование вычислений и коммуникации 🔁 | Лучшее использование GPU, более плавная задержка 📈 |

Итог: сочетание выбора моделей с учетом межсоединений — это ключевой фактор, когда аппаратное обеспечение несовершенно — а в продакшене оно всегда такое.

Эффективность памяти с MLA и сжатием KV: преимущество DeepSeek-V3 в 70 КБ на токен

Память — это скрытое узкое место современных LLM. Окна контекста растут, подсказки становятся длиннее, а кэширование стремительно увеличивается. DeepSeek-V3 переосмысливает проблему, делая кэширование KV дешевле у источника: Многошаговое латентное внимание (MLA) сжимает представления ключ-значение со всех голов в общее латентное пространство, изучаемое совместно с моделью. В режиме вывода система кэширует только латентный вектор, а не полный KV каждой головы, что обеспечивает значительную экономию.

Масштаб имеет значение. По сравнению с крупными плотными эталонами, статья подчеркивает примерно 70 КБ памяти KV на токен для DeepSeek-V3. Для сравнения, аналогичные показатели у больших плотных моделей достигают 327 КБ и 516 КБ на токен. На длинных последовательностях эта разница складывается в миллионы КБ, сохраненных на активном батче, что переводится в меньше перестановок кэша, больше постоянных батчей и более высокую устойчивую производительность TPS.

Сжатие само по себе не раскрывает всей картины. Команда также обсуждает такие опции, как GQA/MQA (совместный KV), окно кэширования и квантование сжатия. Основная идея: быть избирательным в том, что запоминается и с какой точностью. Каждый лишний байт, сэкономленный из HBM, — это емкость, которую можно использовать для более длинных контекстов или более параллельных запросов.

Как команды могут применить мышление в стиле MLA за пределами DeepSeek

- 🧮 Квантифицируйте затраты памяти KV на токен: измерьте память на токен в вашем стеке, чтобы выявить скрытый резерв.

- 🔬 Тестируйте варианты латентного KV: начните с синтетических нагрузок для проверки кривых потерь и компромиссов задержки.

- 🧰 Комбинируйте техники: накладывайте MLA с оконным KV или GQA для мультипликативных выигрышей.

- 🧵 Кэширрование с учетом этапов: разделяйте кэш предзаполнения и декодирования для приоритета задержки по горячему пути.

- 📊 Наблюдайте за реальным трафиком: производственные подсказки отличаются от бенчмарков — измеряйте, не предполагайте.

Команды, выполняющие вывод под внешним ограничением скорости, поймут операционную связь: если сервис ограничен по скорости, полезнее вписать больше работы в каждый бюджет токена. Для контекста о том, как ограничения скорости формируют практическую производительность, изучите этот подробный разбор лимитов API и их взаимодействия с батчингом, вытеснением KV и SLO задержки.

| Модель 🧠 | KV на токен (прибл.) 💾 | Используемые методы памяти 🧪 | Практический эффект 🚀 |

|---|---|---|---|

| DeepSeek-V3 | ~70 КБ ✅ | MLA + маршрутизация с учетом узлов 🔁 | Более высокая загрузка батчей, стабильный TPS 📈 |

| Qwen-2.5 72B | ~327 КБ 😮 | Плотное внимание, классический KV 📦 | Более интенсивное использование HBM, раннее давление на кэш ⏳ |

| LLaMA-3.1 405B | ~516 КБ 😵💫 | Плотное внимание, классический KV 📦 | Высокие потребности в памяти при длинных контекстах 🧱 |

Интересно, как другие представляют компромисс память-задержка на длинных подсказках? Быстрый поиск часто выводит демо и доклады, разбирающие масштабирование KV под нагрузкой.

Один риторический вопрос для дизайна: если бы память была вашим самым дефицитным ресурсом, как бы вы изменили внимание? Ответ DeepSeek — сначала сжимать, кэшировать меньше — предлагает сильный шаблон.

Экономика разреженного MoE, обучение FP8 и локальный вывод: плейбук DeepSeekMoE

Причина, по которой MoE кажется неминуемым в 2025 году, проста: разреженная активация сокращает вычисления, не уменьшая общую емкость параметров. DeepSeek-V3 является примером: ~671 млрд параметров всего с ~37 млрд активных на токен. Такая асимметрия позволяет модели иметь широкое представление, сохраняя при этом приемлемые FLOP на каждый токен. В сравнении с плотными аналогами, последние тратят значительно больше вычислений, потому что активируют все параметры на каждом токене, несмотря на специфику задачи.

Это важно не только для счетов в облаке. Разреженные вычисления масштабируются до персональных устройств и периферийных серверов. Предыдущая модель DeepSeek с 236 млрд параметров показала, что ~21 млрд активных параметров во время вывода может обеспечить ~20+ токенов в секунду на способном ПК с AI SoC — уровнем производительности, который плотные модели аналогичного масштаба сложно достичь локально. Для Orion Labs это означает, что инженер на объекте может запускать специализированного помощника офлайн во время аудита склада, а затем синхронизировать результаты позже.

В статье также подчеркивается обучение со смешанной точностью FP8 — значимый первый опыт такого масштаба для публичной модели — с использованием Transformer Engine от NVIDIA, строгой калибровкой и совместной работой алгоритмов и инфраструктуры. Выгода ощутима: меньше энергии, меньше FLOP, качественные кривые. Команда также развивала эксперименты с низкой точностью LogFMT-nBit для коммуникаций, уменьшая байты при экспертных параллельных перестановках. Общий эффект: меньше узких мест от памяти до сети и вычислений.

Сравнения бюджета вычислений, проясняющие компромисс

- ⚖️ MoE против плотных моделей: активируйте только необходимое на токен; остальное оставляйте в покое для экономии FLOP.

- 🪫 FP8 там, где важно: применяйте низкую точность end-to-end с защитой стабильности.

- 📶 Сжатая сеть: планируйте токены с FP8 метаданными, чтобы уменьшить объем коммуникаций вдвое по сравнению с BF16.

- 🧩 Маршрутизация с учетом топологии: ограничивайте разветвление экспертов для снижения межузловых помех.

- 🧭 Локальный вывод в первую очередь: перенесите выборочные нагрузки на устройства пользователей ради приватности и отзывчивости.

| Модель/Режим 🔬 | Активные параметры на токен 🧠 | Прибл. вычисления на токен 🧮 | Вывод 📌 |

|---|---|---|---|

| DeepSeek-V3 (MoE) | ~37 млрд ✅ | ~250 GFLOPs ⚡ | Экономичное масштабирование с высоким качеством 🚀 |

| Qwen2.5–72B (плотная) | 72 млрд 😮 | ~394 GFLOPs 🧯 | Более высокие затраты на обучение, сложнее масштабировать 📉 |

| LLaMA-3.1–405B (плотная) | 405 млрд 😵 | ~2448 GFLOPs 🧨 | Очень высокие затраты; требует премиального межсоединения 💸 |

Если ваш сервис сталкивается с потолками API из-за правил провайдера или внутренних политик справедливости, плейбук MoE + FP8 дополнительно укрепляет операционную дисциплину. Для быстрого освежения планирования в условиях внешних ограничений посмотрите этот контекст ограничений при развертывании моделей и как умный батчинг вместе с разреженной активацией стабилизируют задержку для пользователей.

Еще один практический аспект: согласование подхода с более широкой экосистемой. OpenAI и Anthropic продолжают исследовать масштабирование с акцентом на рассуждения; Google DeepMind и Meta AI ведут открытые и закрытые треки. Независимо от стека — PyTorch или TensorFlow — урок ясен: разреженность там, где возможно; сжатие там, где безопасно; топология в приоритете при ограниченной пропускной способности.

Пропускная способность, задержка и перекрытие: от двойных микропакетов до IBGDA

Обучение и обслуживание в масштабе — это история как пропускной способности, так и хвостовой задержки. DeepSeek-V3 сконструирован так, чтобы обеспечивать обе. Архитектура использует двойное перекрытие микропакетов с самого начала, планируя вычисления так, что MLA и MoE фазы перемежаются в расписании и коммуникации с текущим выполнением ядра. Это конвейер, работающий как постоянно вращающееся маховик, рассчитанный на постоянную загрузку GPU даже при изменениях трафика all-to-all.

На стороне обслуживания предзаполнение и декодирование разделены. Предзаполнение с большим батчем использует большие группы эксперт-параллелизма; задержкочувствительное декодирование — меньшие, быстрые группы. Это разделение важно при турбулентности — всплесках очередей, разной длине запросов и неоднородной структуре подсказок. Тем временем IBGDA (InfiniBand GPUDirect Async) устраняет накладные расходы CPU-прокси, позволяя GPU напрямую записывать RDMA doorbells. При характерных для all-to-all мелких пакетах это устраняет упорный источник дрожания.

Сеть — холст для всего. Команда внедрила Multi-Plane Fat-Tree (MPFT), чтобы повысить надежность и баланс. Каждый путь GPU–NIC расположен на отдельной плоскости; рабочие нагрузки получают изоляцию отказов и улучшенное распределение нагрузки. Хотя развертывание было ограничено политиками, измеренная на тысячах GPU производительность показывает, что MPFT может соперничать с одноплоскостным multi-rail по пропускной способности all-to-all с преимуществами устойчивости.

Операционные тактики для честной задержки

- ⏱️ Изоляция декодирования: резервируйте меньшие, быстрые каналы для покомандного декодирования.

- 🔄 Планирование с перекрытием: расписывайте микропакеты так, чтобы каждая фаза коммуникации скрывалась за вычислениями.

- 🧵 IBGDA везде: позволяйте GPU управлять управляющей плоскостью, чтобы избежать узких мест с CPU.

- 🛰️ Маршрутизация с учетом плоскостей: распределяйте потоки по плоскостям MPFT, чтобы уменьшить горячие точки.

- 📈 Скорость вывода токенов: приоритизируйте токены в секунду для циклов рассуждений и рабочих процессов RL.

| Техника ⚙️ | Что нацелено 🎯 | Почему помогает 💡 | Наблюдаемый эффект 📊 |

|---|---|---|---|

| Двойное перекрытие микропакетов | Застои коммуникации/вычислений 🧊 | Перекрывает all-to-all с ядрами 🔁 | Плавное использование, меньше пауз 🚀 |

| Разделение предзаполнения/декодирования | Всплески задержки хвоста 🐢 | Выделенные группы эксперт-параллелизма по SLA 🛤️ | Стабильный p95/p99 под нагрузкой ✅ |

| IBGDA | Накладные расходы CPU-прокси 🖥️ | GPU напрямую записывает сигналы 🔔 | Меньшее микросекундное дрожание ⏱️ |

| MPFT | Конгестия на плоскостях 🚦 | Распределение по плоскостям 🌐 | Надежность без потерь пропускной способности 🛡️ |

Если при планировании сервиса нужно согласовать видимую пользователю задержку с ограничениями платформы, операционные рекомендации вроде этого анализа ограничений пропускной способности помогут связать алгоритмические решения с производственными SLO.

Вкратце: перекрытие и топологическая осведомленность — тихие суперсилы современных стеков вывода.

Будущие направления: объединение масштабирования вверх и вширь для следующей волны доступного ИИ

Даже при тщательной маршрутизации разрыв между NVLink (внутри узла) и InfiniBand (межузловая связь) делает некоторые ядра сложнее, чем должны быть. Статья DeepSeek-V3 указывает на прагматичную Северную звезду: сближение масштабирования вверх и вширь с единым коммуникационным фреймом и специализированными сопроцессорами для обработки сообщений и пересылки. Освобождая GPU SM от оркестровки пакетов, софтстеки упрощаются, а большая часть чипа возвращается математике.

Команда также отмечает динамическое выделение пропускной способности между NVLink и PCIe как обязательное. Когда выборки KV из RAM процессора конфликтуют с трафиком EP, происходят задержки и всплески. Умные I/O чиплеты, нативное приоритезирование и более тесное межсоединение CPU–GPU могут снизить конкуренцию. Появляющиеся стандарты, такие как UEC и UALink, а также идеи «единая шина» намекают, куда идут поставщики — к фреймам, которые рассматривают локальность и распределение как единую задачу.

Сеть получает интеллект. Представьте когерентную оптику в упаковке, безпотерьные механизмы для all-to-all и адаптивную маршрутизацию, которая действительно понимает потоки MoE. В более отдаленной перспективе статья выделяет архитектуры, ориентированные на память — накопление DRAM, интеграция уровня wafer-scale и сжатие/вычисления в сети — направленные на решение кризиса пропускной способности памяти, питающего модели с длинным контекстом и цепочкой рассуждений. Надежность также на повестке: проверки бесшумных ошибок данных, быстрое восстановление и непрерывное обучение становятся обязательными при масштабе тысяч GPU.

Практическая дорожная карта для команд и поставщиков

- 🧭 Краткосрочно: внедрить маршрутизацию с учетом узлов и пути FP8 в ваши стеки PyTorch/TensorFlow; формализовать разделение предзаполнения и декодирования.

- 🏗️ Среднесрочно: принять MPFT или аналоги multi-rail; распространять функции типа IBGDA по флотам ускорителей.

- 🚦 Контроль трафика: экспериментировать с приоритизацией миграций KV; следить за загрузкой плоскостей в реальном времени.

- 🧪 Новые типы данных: пилотировать LogFMT-nBit для управляющей метадаты с целью сокращения трафика.

- 🧱 Долгосрочно: выступать за единые фреймы, сопроцессоры коммуникаций и архитектуры, ориентированные на память, совместно с поставщиками.

| Направление 🚀 | Что меняется в железе 🧩 | Выигрыш в софте 🧠 | Кому выгодно 👫 |

|---|---|---|---|

| Единый фрейм | NVLink ↔ IB сопроцессинг 🔀 | Проще ядра; меньше застоев ⚡ | Облака, локальные кластеры, стартапы 🌱 |

| Управление пропускной способностью | Динамический арбитраж NVLink/PCIe 🎛️ | Плавнее хвостовая задержка 🎯 | Реалтайм и корпоративные приложения 🏢 |

| Ориентированность на память | Накопление DRAM, wafer-scale 🧱 | Длиннее контексты без перестановок 📚 | Стеки рассуждений и агентов 🤖 |

| Интеллектуальные сети | Когерентная оптика, адаптивная маршрутизация 🛰️ | Стабильный all-to-all в масштабе 🌐 | Обучение MoE и мультимодальных моделей 🎨 |

Для закрепления этих идей Orion Labs переосмысливает свою дорожную карту: сегодня принять многоплоскостные сети, в следующем обновлении оборудования продвигать единые фреймы, а в развертывании на основе Hugging Face добавить поддержку FP8 ядрам вывода, где это безопасно. Между тем стратегические команды сравнивают себя с лидерами индустрии — OpenAI, Google DeepMind, Anthropic, Meta AI — чтобы обеспечить конкурентоспособность без чрезмерных затрат. Если внешние платформы вводят ограничения, планирование с этим руководством по системе с ограничениями скорости помогает подобрать оптимальную конкуренцию, батчи и бюджет токенов до запуска.

Наконец, ключевое наблюдение: будущее доступного ИИ лежит в модельном дизайне с учетом аппаратного обеспечения и разработке аппаратного обеспечения с осознанием модели, встречающихся посередине.

Для полноты команды продуктов могут также учитывать стабильность для пользователей: когда провайдеры устанавливают лимиты запросов, планирование с помощью такого практического пособия по ограничению сервисов поможет сохранить обещания в соответствии с инфраструктурой.

Дизайны сетей, которые масштабируются: MPFT против MRFT, IB против RoCE и где все еще прячется задержка

За элегантностью MoE скрывается безжалостное требование all-to-all. Взвешенный взгляд DeepSeek сравнивает MPFT (Multi-Plane Fat-Tree) с MRFT (Multi-Rail Fat-Tree) и анализирует латентность IB против RoCE. Практический вывод: MPFT может соперничать с MRFT по производительности all-to-all, при этом обеспечивает изоляцию отказов и упрощенное устранение неполадок. InfiniBand устойчиво демонстрирует более низкую микросекундную задержку, чем RoCE в текущем поколении — что важно при сверхчувствительном к дрожанию декодировании.

В отчете отмечаются практические ограничения: идеальное объединение портов на стороне NIC и поддержка порядка вне очереди между плоскостями не были полностью доступны в некоторых случаях, но новое оборудование (например, ConnectX-8) улучшает ситуацию с поддержкой мультиплоскостей. По мере появления этих возможностей двухслойный fat-tree становится еще более привлекательным: масштабируемым, экономичным и задержечно подходящим для насыщенных паттернов MoE. Параллельно IBGDA демонстрирует, что удаление CPU из управляющего пути — не просто приятная опция, а необходимость.

Решения, влияющие на поведение реальных систем

- 🧭 Выбирайте IB для критически важных по задержке путей: RoCE оставляйте для хранилищ или менее чувствительных уровней.

- 🛤️ Применяйте MPFT для устойчивости: изолируйте плоскости для локализации сбоев и балансировки нагрузки.

- 🧮 Подгоняйте размеры групп EP: меньше для декодирования, больше для предзаполнения, настраивайте по нагрузке.

- 🧰 Включайте IBGDA: передавайте операции записи с GPU, устраняя CPU-посредников.

- 🛰️ Отслеживайте новые возможности мультиплоскостей в новых NIC: объединение портов и семантика порядка — ключевые факторы.

| Выбор 🧩 | Плюсы ✅ | Минусы ⚠️ | Лучше всего для 🏁 |

|---|---|---|---|

| MPFT | Изоляция отказов, баланс нагрузки, похожая пропускная способность 🚀 | Требует операций и инструментов с учетом плоскостей 🧭 | Обучение MoE на тысячах GPU 🧠 |

| MRFT | Зрелые инструменты, широкая поддержка 🛠️ | Меньше изоляции; горячие точки на одиночной плоскости 🔥 | Классические задачи data-parallel 🧪 |

| IB | Низкая задержка, сильный стек RDMA ⏱️ | Риски стоимости и зависимости от поставщика 💸 | Декодирование, критичные разделы all-to-all 🎯 |

| RoCE | Доступность, стоимость 🧾 | Более высокая задержка, ограничения масштабируемости 🧯 | Хранилища, некритичные коммуникации 📦 |

Поскольку стеки с ориентацией на клиента должны согласовывать инфраструктуру с продуктовой реальностью, план операций должен включать базовые меры безопасности. Быстрое освежение памяти — этот анализ лимитов скорости и масштабирования — поможет откалибровать конкуренцию, бюджеты токенов и правила формирования перед запуском. Так, когда модель станет умнее, опыт останется плавным.

Заключительный инсайт: сеть теперь — часть модели. Относитесь к ней с той же строгостью, что и к кривым потерь и наборам оценок.

{“@context”:”https://schema.org”,”@type”:”FAQPage”,”mainEntity”:[{“@type”:”Question”,”name”:”Что делает обучение FP8 в DeepSeek-V3 заметным для доступности?”,”acceptedAnswer”:{“@type”:”Answer”,”text”:”Это одно из первых публично документированных масштабных обучений MoE с использованием end-to-end FP8 на производственном оборудовании. Подход, основанный на Transformer Engine NVIDIA и тщательной калибровке, снижает вычислительные и энергетические затраты при сохранении качества, что напрямую уменьшает бюджеты обучения и расширяет доступность.”}},{“@type”:”Question”,”name”:”Как многошаговое латентное внимание снижает давление на память?”,”acceptedAnswer”:{“@type”:”Answer”,”text”:”MLA сжимает ключ–значение по головам в общее латентное представление, изучаемое совместно с моделью. Во время вывода кэшируется только латентный KV, уменьшая память на токен примерно до 70 КБ в DeepSeek-V3 — гораздо меньше, чем у плотных моделей, что позволяет обрабатывать больше запросов одновременно и использовать более длинные контексты.”}},{“@type”:”Question”,”name”:”Почему маршрутизация экспертов с учетом узлов важна?”,”acceptedAnswer”:{“@type”:”Answer”,”text”:”Expert Parallelism может перегружать межузловые связи. Группируя экспертов по узлам и маршрутизируя токены, чтобы минимизировать переходы между узлами, DeepSeek-V3 использует более высокую пропускную способность внутри узла, снижает конфликт IB и поддерживает throughput при реальных нагрузках.”}},{“@type”:”Question”,”name”:”Всегда ли MPFT лучше MRFT для всех развертываний?”,”acceptedAnswer”:{“@type”:”Answer”,”text”:”Не всегда. MPFT обеспечивает сильную изоляцию отказов и балансировку по плоскостям при сопоставимой производительности all-to-all в тестах, но требует операций с учетом плоскостей и поддержки оборудования. В некоторых средах зрелость и инструменты MRFT остаются привлекательными.”}},{“@type”:”Question”,”name”:”Как лимиты скорости сервиса влияют на архитектурные решения?”,”acceptedAnswer”:{“@type”:”Answer”,”text”:”Когда платформы ограничивают количество запросов или токенов, командам нужно увеличить полезную работу на токен и сгладить задержку. Такие техники, как MLA, разделение предзаполнения и декодирования и разреженный MoE помогают поддерживать стабильную производительность в рамках ограничений. Для введения смотрите этот ресурс по лимитам скорости и планированию throughput: https://chat-gpt-5.ai/chatgpt-rate-limits-insights.”}}]}Что делает обучение FP8 в DeepSeek-V3 заметным для доступности?

Это одно из первых публично документированных масштабных обучений MoE с использованием end-to-end FP8 на производственном оборудовании. Подход, основанный на Transformer Engine NVIDIA и тщательной калибровке, снижает вычислительные и энергетические затраты при сохранении качества, что напрямую уменьшает бюджеты обучения и расширяет доступность.

Как многошаговое латентное внимание снижает давление на память?

MLA сжимает ключ–значение по головам в общее латентное представление, изучаемое совместно с моделью. Во время вывода кэшируется только латентный KV, уменьшая память на токен примерно до 70 КБ в DeepSeek-V3 — гораздо меньше, чем у плотных моделей, что позволяет обрабатывать больше запросов одновременно и использовать более длинные контексты.

Почему маршрутизация экспертов с учетом узлов важна?

Expert Parallelism может перегружать межузловые связи. Группируя экспертов по узлам и маршрутизируя токены, чтобы минимизировать переходы между узлами, DeepSeek-V3 использует более высокую пропускную способность внутри узла, снижает конфликт IB и поддерживает throughput при реальных нагрузках.

Всегда ли MPFT лучше MRFT для всех развертываний?

Не всегда. MPFT обеспечивает сильную изоляцию отказов и балансировку по плоскостям при сопоставимой производительности all-to-all в тестах, но требует операций с учетом плоскостей и поддержки оборудования. В некоторых средах зрелость и инструменты MRFT остаются привлекательными.

Как лимиты скорости сервиса влияют на архитектурные решения?

Когда платформы ограничивают количество запросов или токенов, командам нужно увеличить полезную работу на токен и сгладить задержку. Такие техники, как MLA, разделение предзаполнения и декодирования и разреженный MoE помогают поддерживать стабильную производительность в рамках ограничений. Для введения смотрите этот ресурс по лимитам скорости и планированию throughput: https://chat-gpt-5.ai/chatgpt-rate-limits-insights.

-

Open Ai6 days ago

Open Ai6 days agoGPT-4 Turbo 128k: Раскрывая инновации и преимущества 2025 года

-

Инструменты2 weeks ago

Инструменты2 weeks agoОткройте лучшие инструменты для генерации имен гномов для уникальных фэнтезийных имен

-

Open Ai1 week ago

Open Ai1 week agoОткрывая возможности плагинов ChatGPT: улучшите свой опыт в 2025 году

-

Open Ai6 days ago

Open Ai6 days agoОсвоение тонкой настройки GPT: руководство по эффективной кастомизации ваших моделей в 2025 году

-

Модели ИИ6 days ago

Модели ИИ6 days agoМодели GPT-4: Как искусственный интеллект преобразует 2025 год

-

Open Ai7 days ago

Open Ai7 days agoСравнивая ChatGPT от OpenAI, Claude от Anthropic и Bard от Google: какой инструмент генеративного ИИ будет доминировать в 2025 году?