Gemini 3 vs ChatGPT 5.1: Architektur, Kontext-Verarbeitung und zentrale KI-Fähigkeiten

Diese Technologieübersicht konzentriert sich darauf, wie sich Google Gemini 3 und ChatGPT (gestützt durch GPT-5.1) unter der Haube unterscheiden, denn Architektur bestimmt Funktionen, Leistung und letztlich reale Ergebnisse. Google positioniert seine neueste Version als ein einheitliches, agentenorientiertes System, das multimodale Wahrnehmung mit langfristiger Planung verbindet. Es übernimmt agentische Ideen aus früheren Iterationen und hebt diese mit einem konsolidierten Ansatz für maschinelles Lernen hervor, der die Ketten des Denkens über sehr große Kontexte hinweg intakt hält. Im Gegensatz dazu legt OpenAIs neueste Version Wert auf einen flüssigen Dialogfluss, festere Befolgung von Anweisungen und eine dynamische „Denk“-Tiefe, die sich je nach Aufgabenkomplexität verändert.

Die Kontextgröße ist das pulsierende Herz langfristiger Arbeit. Das Google-Modell erweitert sich auf sehr große Fenster – Hunderttausende von Tokens –, sodass Forschungssummaries, Compliance-Digests und filmische Drehbuchmontagen in einer einzigen Sitzung ohne Fragmentierung verbleiben können. Das ist wichtig, wenn Teams Kontinuität benötigen. OpenAIs Sprachmodelle sind auf Agilität und schnelles Wechseln optimiert; die natürliche Sprachverarbeitung wirkt flüssig, und das System kann mit Ton- und Persona-Steuerungen gelenkt werden, die Unternehmensassistenten standardmäßig markenkonform klingen lassen.

Das Denken ist eine weitere Bruchlinie. Googles Ergänzung eines Deep Think-Modus zielt direkt auf mehrstufige Logik und Planung ab. Es ist der Schalter für den „Schwierigkeitsgrad“, nützlich für Strategie, Simulation und komplexe Datenfusion. OpenAI kontert mit zwei Modi – „Instant“ und „Thinking“ –, die die Überlegung modulieren, um bei Bedarf Geschwindigkeit gegen Tiefe zu tauschen. Für viele Teams übersetzt sich diese Dualität in weniger Prompt-Gymnastik, um das gewünschte Tempo oder die Präzision zu erreichen. Die Wahl spiegelt einen breiteren KI-Vergleich wider, der in der Branche zu sehen ist: Ein Technologie-Stack ist für Weite und Synthese gebaut, der andere für konsistente, persönliche Interaktion.

Um dies in der Realität zu verankern, betrachten Sie Nimbus Labs, einen Mid-Market-SaaS-Anbieter, der einen Customer Success Copilot entwickelt. Ihr Blueprint verlangte: (1) das Parsen langer Gesprächstranskripte; (2) das Verfassen einfühlsamer Follow-ups; und (3) das Erstellen von Playbooks, die Text, Metriken und UI-Screenshots mischen. Mit dem Google-System hielten sie 180.000 Tokens an kundenübergreifender Historie aktiv, was dem Bot ermöglichte, spezielle Randfälle ohne erneutes Hochladen von Materialien abzurufen. Mit OpenAIs System stellten sie Stimme und Temperatur so ein, dass sie den Markenvorgaben entsprachen, wodurch jede Antwort wie von einem erfahrenen CSM klang. Entscheidender Faktor war, ob Kontinuität bei extremer Länge die Konversations-Finesse in der täglichen Ansprache überwiegt.

Über Dialog und Kontext hinaus verdient Googles Antigravity-Entwicklerplattform Erwähnung. Sie legt Wert auf agentische Werkzeuge, Orchestrierung und planungsintensive Arbeitsabläufe. OpenAI verbessert die Zuverlässigkeit bei der Befolgung von Anweisungen und ermöglicht es Teams, Persona-Voreinstellungen über Threads hinweg zu sperren, sodass Stilabweichungen bei längerer Nutzung minimal bleiben. Jede Richtung repräsentiert eine Philosophie: Bau eines All-in-One-Kognitionsagenten oder Schärfung des besten Kollaborateurs der Welt.

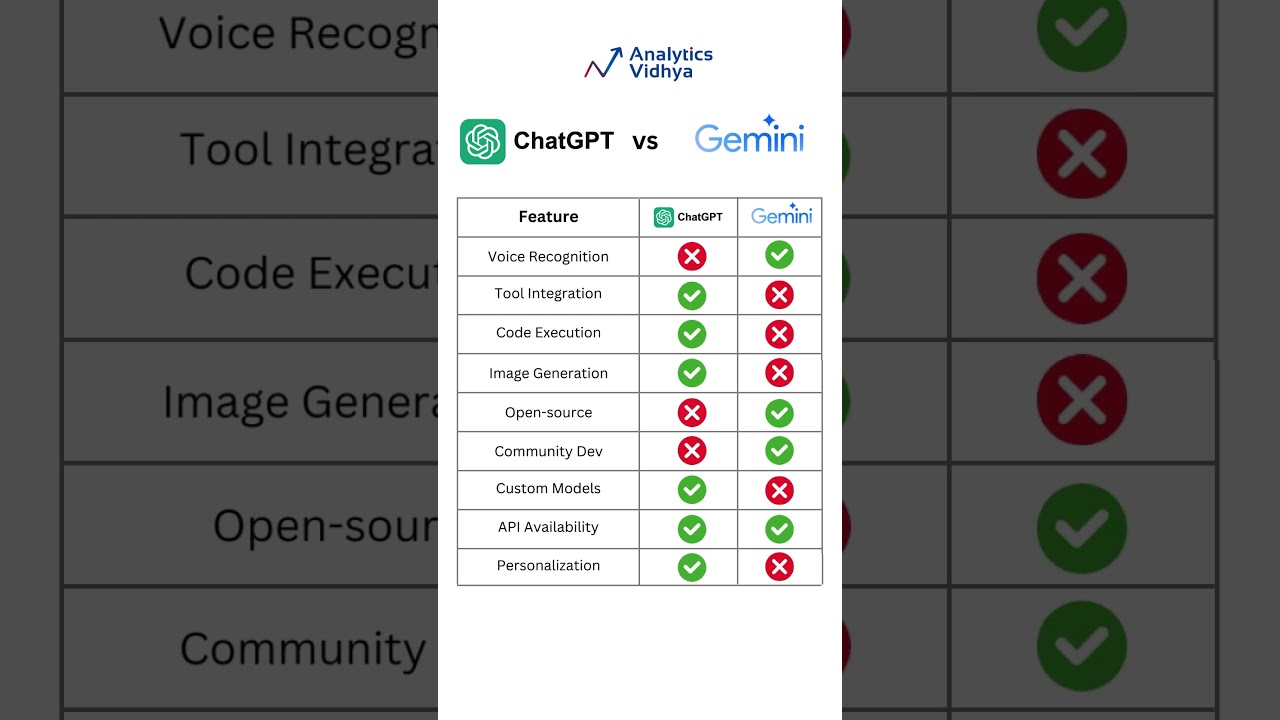

Für Leser, die über diese beiden hinaus weitere Vergleiche suchen, helfen Ressourcen wie der Google Gemini vs ChatGPT Guide und ein ausgewogener ChatGPT vs Gemini 2025 Überblick, um Stärken ohne Marketing-Spin einzuordnen. In einem überfüllten Feld zählt die Perspektive.

Schlüsselunterschiede, die Ergebnisse formen

- 🧠 Tiefes Denken vs agiler Dialog: Deep Think priorisiert Planung; OpenAIs Dual-Modi balancieren Geschwindigkeit und Tiefe.

- 🧾 Kontextlängen-Kommunitionen: extreme Fenster eignen sich für Forschungsberichte; kompakte, reaktionsschnelle Kontexte bevorzugen kundenorientierte Aufgaben.

- 🖼️ Multimodale Flüssigkeit: das Google-Modell verbindet Text, Bilder und Code in einem Fluss; OpenAI konzentriert sich auf makellose Gesprächskontrolle.

- 🛠️ Erfahrung der Entwickler: Antigravity ermöglicht agentische Orchestrierung; OpenAI vereinfacht Ton, Persona und Anweisungsverlässlichkeit.

- 📈 Unternehmens-Fit: Planungs-Engines gedeihen in F&E; Gesprächs-Engines glänzen im Support, Marketing und Vertrieb.

| Aspekt ⚙️ | Gemini 3 Highlight 🌐 | GPT‑5.1 Highlight 💬 |

|---|---|---|

| Denken | Deep Think für mehrstufige Pläne | Instant/Thinking Modi für adaptive Tiefe |

| Kontextfenster | Sehr groß, langfristige Kontinuität | Optimiert für schnelle, kohärente Wechsel |

| Modalität | Nahtlos Text + Bilder + Code | Textfokussiert mit starker Ausarbeitung |

| Entwicklerwerkzeuge | Antigravity Agentenplattform | Persona- und Tonvorgaben |

| Anwendungs-Fit | Forschung, Planung, technische Synthese | Support, Texte, interaktive Hilfe |

Fazit: Architektur bedeutet Vorteil – entscheiden Sie, ob Langzeit-Synthese oder gesprächliche Präzision für Ihre Roadmap den größten Unterschied macht.

Der nächste Abschnitt widmet sich der Ökonomie, denn großartige Architektur funktioniert nur, wenn auch die Mathematik stimmt.

Preisgestaltung, Token-Ökonomie und Wert für Entwickler und Teams

Für viele Entscheidungsträger ist das Preis-Leistungs-Verhältnis entscheidend. OpenAIs GPT‑5.1 API kostet knapp 1,25 $ pro 1M Eingabetokens und 10 $ pro 1M Ausgabetokens. Googles Flaggschiff listet etwa 2 $ Eingabe / 12 $ Ausgabe pro 1M Tokens für mittlere Kontexte (ca. bis 200k Tokens), mit höheren Stufen bei etwa 4 $ / 18 $ für deutlich größere Spannen. Im Konsumentenbereich bietet Google eine Pro-Stufe für rund 19,99 $/Monat und eine Enterprise-Stufe mit individueller Preisgestaltung – weithin berichtet bis zu ~250 $/Monat für volle Funktionalität. OpenAIs Endverbraucherpaket beginnt typischerweise bei etwa 20 $/Monat, mit höheren Limits und Features darüber.

Das Token-Mathematik ändert die Strategie. Ein Marketingteam, das 40 Landingpages generiert, achtet eher auf Ausgabepreise; ein Analyst, der Prüfungs-PDFs verarbeitet, priorisiert Eingabekosten. Deshalb gibt es keinen universellen Gewinner. Einige Käufer modellieren Workloads wöchentlich und wählen einen Anbieter basierend auf der erwarteten Aufteilung zwischen Lesen und Schreiben. Andere optimieren für Entwicklerergonomie – wenn eine API weniger verschwendete Aufrufe dank besserer Befolgung von Anweisungen ermöglicht, kann das mehr sparen als ein günstigerer Listenpreis vermuten lässt.

Integrationsdetails sind ebenfalls wichtig. Teams, die Geheimnisse zentralisieren müssen, können die ChatGPT-API-Key-Einrichtung meistern, um das Onboarding zu beschleunigen. Wer große Wissenssammlungen plant, sollte Strategien zum Ändern des Kontextfensters in ihren Tools erkunden, um Tokenexplosionen zu vermeiden. Und wenn jeder Prompt eine Budgetentscheidung ist, reduzieren Prompt-Optimierungsstrategien Wiederholungen und senken die Ausgaben erheblich.

Wann welches Preismodell glänzt

- 💡 Hochproduzierende Textfabriken: niedrigere Ausgabepreise machen OpenAI attraktiv für Content-Mills und Newsletter-Workflows.

- 📚 Forschungsarchive: größere Fenster helfen dem Google-Modell, Kontinuität bei langen Eingaben zu bewahren und Chunking-Aufwand zu reduzieren.

- 🤝 Kundensupport: konsistente Tonkontrollen und verlässliche Befolgung von Anweisungen verbessern die Erstkontaktlösung.

- 🧪 Prototyping: welche API weniger Fehlschläge oder Nachpromptings verursacht, gewinnt oft bei den effektiven Kosten pro Lösung.

- 📊 Unternehmensführung: planbare Monatsstufen und konsolidierte Abrechnung schlagen oft kleine Token-Deltas.

| Plan 💼 | Google Gemini 3 Kosten 💸 | GPT‑5.1 Kosten 💸 | Am besten für ✅ |

|---|---|---|---|

| API (mittlerer Kontext) | 2 $ Eingabe / 12 $ Ausgabe pro 1M | 1,25 $ Eingabe / 10 $ Ausgabe pro 1M | Ausgewogenes F&E vs Inhalt |

| API (großer Kontext) | 4 $ Eingabe / 18 $ Ausgabe pro 1M | Variiert je nach Stufe | Lange Dokumente, Compliance |

| Konsumenten | ~19,99 $/Monat; Enterprise bis ~250 $ | ~20 $/Monat und aufwärts | Einzelpersonen, Teams, Betrieb |

| Gesamtkostenperspektive | Stärker bei Langzeiteingaben | Besser bei großen Ausgaben | Arbeitslast-spezifische Mathematik |

Wenn Preisdetails für Endnutzer Priorität haben, sehen Sie ChatGPT-Preise 2025 ein und vergleichen Sie intern mit Nutzungsmodellen, um eine sinnvolle Obergrenze zu setzen.

Preisgestaltung ist nur die halbe Gleichung; die andere Hälfte ist, was diese Tokens leisten können, wenn Text auf Bilder, Code und Planung trifft.

Multimodale Arbeitsabläufe und Long-Context-Fallstudien, die beide Modelle auf die Probe stellen

Multimodale Fähigkeiten unterscheiden gelegentliche Assistenten von echten Arbeitsplatz-Copiloten. Die Google-Version bringt eine einheitliche Handhabung von Text, Bildern und Code in einem Fluss und baut auf früheren multimodalen Experimenten auf, indem sie Kontinuität vorantreibt. Für komplexe Aufgaben – denken Sie an Architekturdiagramme, Produktfotos und Skripte – ist die Fähigkeit, visuelle Details beim Schreiben oder Debuggen zu referenzieren, ein Beschleuniger. OpenAIs neueste Version betont sprachliche Kompositionsklarheit, aber unabhängige Tests deuten darauf hin, dass sie dem Google-Stack in Bezug auf Modalitätsbreite und anhaltendes Langform-Denken hinterherhinkt.

Nehmen wir nochmals Nimbus Labs. Ihr Produktlaunch-Playbook verlangte: (a) Analyse von Konkurrenz-Screenshots; (b) Verfassen einer 12-teiligen Email-Nurture-Serie; (c) Erzeugen von SDK-Snippets; und (d) Zusammenstellung eines 40-seitigen Feldhandbuchs. Mit dem Google-System schickten sie annotierte Bilder und Textblöcke in einer durchgehenden Sitzung. Der Assistent generierte Codebeispiele, die mit UI-Elementen in den Screenshots übereinstimmten – kein Hin und Her zur Klärung von Beschriftungen. Mit OpenAI glänzte das Team darin, die Outreach-Sequenz wie einen menschlichen Strategen lesbar zu machen, dank stärkerer Tonkontrollen und Persona-Sperrung. Das Ergebnis: Sie teilten die Arbeitslast – visuelle und technische Synthese auf der einen Seite, personalisierte Botschaften auf der anderen.

Wenn Dokumente typische Grenzen überschreiten, kann das Aufteilen in Abschnitte Kontextverlust verursachen. Googles langer Kontextrahmen macht eine einzelne durchgehende „Erinnerung“ wahrscheinlicher und verringert das Risiko von Widersprüchen. OpenAI-Nutzer kompensieren oft durch sorgfältige Abrufstrategien und Metadaten-Disziplin. Falls das Ihr Weg ist, erkunden Sie Tipps für Dateianalyse-Workflows und integrieren Sie einen Vektorindex, um das System über Sitzungen hinweg fundiert zu halten.

Um weitere Vergleiche abzudecken, prüfen Käufer auch angrenzende Tools. Siehe ChatGPT vs Perplexity AI für forschungsintensive Aufgaben oder Überprüfungen wie ChatGPT vs GitHub Copilot, wenn Programmierhilfe zentral ist.

Blueprints für multimodale Erfolge

- 🖼️ Verankern Sie visuelle Elemente: Stellen Sie sicher, dass Screenshots oder Diagramme explizite Hervorhebungen haben; das Google-Modell stimmt Ausgaben gut auf Bildelemente ab.

- 🗂️ Behalten Sie eine einzige Quelle: Laden Sie, wenn möglich, den gesamten Kontext einmalig; große Fenster reduzieren Fehler beim Zusammenfügen von Sitzungen.

- 🧩 Abruf-Disziplin: Für kleinere Fenster investieren Sie in Embeddings und Retrieval, um Kontinuität zu simulieren.

- 🧪 Testen Sie mit echten Daten: Mock-Daten verbergen Randfälle; echte PDFs und Bilder decken den tatsächlichen Reibungsverlust auf.

- 🧭 Rollen zuweisen: Routen Sie visuell-technische Synthese an den multimodalen Leiter; routen Sie empathische Texte an den Konversationsspezialisten.

| Arbeitsablauf 🧭 | Besser geeignet: Google 🌟 | Besser geeignet: OpenAI 🚀 | Grund 🔍 |

|---|---|---|---|

| Visuelle + Text-Synthese | Ja | Situationsabhängig | Multimodale Kontinuität über lange Spannen |

| Persona-perfekte Ansprache | Situationsabhängig | Ja | Fein abgestimmte Tonkontrollen und Anweisungsverlässlichkeit |

| Große Forschungs-Dossiers | Ja | Situationsabhängig | Weniger Aufteilungen; weniger Widersprüche |

| Schnelles Q&A | Situationsabhängig | Ja | Reaktionsschneller Dialog und kohärente kurze Wechsel |

Für eine End-to-End-Perspektive, wie GPT-basierte Tools sich zu heutigen Assistenten entwickelten, ist der Überblick über ChatGPTs KI-Evolution eine hilfreiche Ergänzung.

Nachdem multimodale Stärken kartiert sind, bewertet der nächste Abschnitt Gesprächsqualität und Befolgung von Anweisungen – entscheidend für Teams, die den ganzen Tag im Chat leben.

Befolgung von Anweisungen, Tonkontrollen und Gesprächsqualität im täglichen Einsatz

OpenAIs neueste Version priorisiert den Gesprächsfluss. Zwei einstellbare Modi – Instant und Thinking – lassen Entwickler Geschwindigkeit gegen Überlegung tauschen, ohne komplexe Prompts. Es folgt Anweisungen konsequenter und fügt Regler für Persönlichkeit, Höflichkeit und Formalität hinzu. Diese Kombination gibt Helpdesks, Marketing-Teams und HR-Abteilungen eine verlässliche „Stimme“. Für technische Teams reduziert Konsistenz Nacharbeit: weniger Erinnerungen an Kürze, geringere Stilabweichung in langen Threads und sauberere Übergaben an menschliche Prüfer.

Googles neueste Version setzt Pragmatismus durch Planung und langes Gedächtnis um, aber der Dialog ist im Vergleich zu früheren Modellen auch geschlossener geworden. Bei mehrstufigen Ausgaben – etwa einem Outreach-Plan mit Nachrichtenvariationen nach Persona und Phase – hält sie die Struktur tendenziell intakt. Die Unterschiede treten in tonempfindlichen Aufgaben am stärksten zutage. OpenAIs Technologie erleichtert es angenehm, Freundlichkeit, Humor und markenspezifische Phrasen einzustellen. Wenn es darum geht, 300 nuancierte Kundenmails pro Tag zu beantworten, kumuliert sich diese Konsistenz schnell.

Da die Prompt-Gestaltung Kosten und Qualität beeinflusst, lohnt es sich, die Technik zu schärfen. Eine ausgezeichnete Ressource sind Prompt-Optimierungsstrategien, die Leitplanken, Paritätstests und deterministische Baselines abdecken. Für Betriebsteams, die Piloten starten, gibt der praktische ChatGPT 2025 Testbericht ein Gefühl dafür, wo das Modell Stärke zeigt. Und für alle, die globalen Zugang verteilen, speziell in Wachstumsmärkten, bietet die Einführung zu kostenlosem ChatGPT-Zugang in Indien regionale Überlegungen zur Einführung.

Muster für Gespräche hoher Qualität

- 🧭 Legen Sie eine Standardpersona fest: Sperren Sie Ton, Kürze und Formatierung zu Beginn jeder Sitzung für vorhersehbare Qualität.

- ✍️ Nutzen Sie Ausgabe-Schemas: Überschriften, Aufzählungen und JSON reduzieren Mehrdeutigkeit und verbessern die Befolgung von Anweisungen.

- 🧪 Führen Sie A/B-Tests durch: Vergleichen Sie Instant vs Thinking oder kurze vs ausführliche Prompts, um Ihr ideales Antwortmuster zu finden.

- 📣 Feedback-Schleifen: Erfassen Sie Nutzerkorrekturen und füttern Sie diese als Stilbeispiele zurück, um künftige Abweichungen zu minimieren.

- 🔐 Leitplanken: Definieren Sie Tabuthemen, Eskalationsregeln und Compliance-Tags zum Schutz von Marke und Nutzern.

| Steuerung 🎛️ | OpenAI Stärke 💬 | Google Stärke 🌐 | Praktische Wirkung ✅ |

|---|---|---|---|

| Tonvorgaben | Fein abgestimmt und beständig | Verbessert, solide | Markenkonforme Antworten |

| Anweisungs-Genauigkeit | Hoch | Hoch, besonders bei strukturierten Plänen | Weniger Nachprompting |

| Geschwindigkeit vs Tiefe | Instant/Thinking-Umschalter | Deep Think-Schalter | Passender Kompromiss je Aufgabe |

| Lange Threads | Stabile Persona | Stabile Struktur | Kohärente Multi-Turn-Sitzungen |

Teams, die sich auf Stimme und Klarheit einigen, tendieren wahrscheinlich zum System mit den intuitivsten Persona-Kontrollen; jene, die komplexe Pläne liefern, neigen eher zu planerischer struktureller Disziplin.

Benchmarks, Ranglisten und realweltliche Leistungssignale, denen Sie vertrauen können

Benchmarks erzählen nur einen Teil der Geschichte, doch die aktuelle Rangliste ist aufschlussreich. Auf dem Community-getriebenen Chart von LMArena erzielt Gemini 3 eine Spitzenwertung von etwa 1324, vor Gemini 2.5 Pro bei etwa 1249. GPT‑5.1 (aufgeführt als GPT‑5‑chat) liegt knapp bei 1222, zusammen mit früheren OpenAI-Generationen und anderen Spitzenmodellen. Die Botschaft von Tausenden Stimmen ist klar: Googles neuester Eintrag hat Hitze, während OpenAIs Veröffentlichung eine starke, respektierte Position in der oberen Liga behält.

Synthetische Tests verstärken oft diese Verteilung. Berichte vermerken Googles Vorteil bei erweitertem Denken und multimodaler Breite, während OpenAIs Modell bei kohärenten Kurzform-Ausgaben und Anweisungsbefolgung punktet. Tom’s Guide-artige Herausforderungen, die sich auf Ton und Persona konzentrieren, bevorzugen meist OpenAI; bildintegriertes Denken oder langzeitige Kontext-Synthese Bevorzugen Googles Engine. Das entspricht dem breiteren Marktrauschen: Was „intelligenter“ wirkt, hängt stark vom Maßstab ab – emotional abgestimmter Dialog oder langfristige Kognition.

Für eine umfassendere Perspektive helfen vergleichende Ressourcen wie der OpenAI vs Anthropic Vergleich und historische Übersichten wie GPT‑4, Claude 2 und Llama-Ära Zusammenfassungen, um heutige Konkurrenten einzuordnen. Leser, die einen plattformübergreifenden Vergleich wollen, können auch Microsoft Copilot vs ChatGPT studieren, um zu verstehen, wie Modellentscheidungen die Produkterfahrungen beeinflussen.

Was Ranglisten aussagen – und was nicht

- 🏁 Bestenlisten spiegeln Community-Stimmung wider; sie sind nützlich, aber nicht zwingend für Ihre spezifische Arbeitslast.

- 🧪 Labortests betonen Extreme; reale Produktion mischt Latenz, Leitplanken und Tooling-Beschränkungen.

- 🧰 Technologiepassung zählt: Datenpipelines, Abruf-Mechanismen und Prompt-Hygiene können Ergebnisse stärker beeinflussen als rohe IQ-Werte.

- 📐 Definieren Sie Erfolgsmessgrößen früh: Genauigkeit, Entwurfszeit und Prüflasten sollten pro Team gemessen werden.

- 🔄 Iterieren: Kleine Prompt- und Workflow-Anpassungen verwandeln ein „Unentschieden“ oft in einen klaren Gewinner für Ihre Organisation.

| Signal 📊 | Beobachtung 🔎 | Implikation 💡 | Gewinner heute 🏆 |

|---|---|---|---|

| LMArena Score | 1324 vs ~1222 Bereich | Community bevorzugt Googles Modell | Google 🌟 |

| Langzeit-Kontextaufgaben | Weniger Unterbrechungen, reichere Kontinuität | Bessere Forschung und Synthese | Google 🌟 |

| Persona-Kontrolle | Feiner abgestimmter Ton und Stil | Markenkonforme Chat-Erlebnisse | OpenAI 🚀 |

| Kurzform-Texte | Klar, direkt, wenig Drift | Schnellere Prüfzyklen | OpenAI 🚀 |

Für eine breitere Übersicht über Marktoptionen erkunden Sie diese kuratierte Liste der Top-Schreib-KI 2025, um zu sehen, wo diese beiden im Vergleich zu spezialisierten Tools stehen.

Ranglisten lenken den Blick; Live-Piloten enthüllen die Wahrheit, die für Ihr Team zählt.

Entwicklererfahrung, Sicherheit und Ökosystem: Vom ersten Prompt bis zur Produktion

Die Auslieferung eines Assistenten ist mehr als cleverer Text. Es geht um Onboarding, Ratenbegrenzungen, Beobachtbarkeit und Sicherheit. OpenAIs Entwicklererfahrung betont schnelle Starts mit klaren Persona-Voreinstellungen, Leitplanken und strukturierten Ausgaben. Googles Stack legt Wert auf Orchestrierung via Antigravity und ermutigt Entwickler, mehrstufige Agenten zu gestalten, die planen, Werkzeuge aufrufen und den Zustand über lange Sitzungen bewahren. Beide Wege können funktionieren; die richtige Wahl hängt davon ab, ob Ihr Produkt ein persönlicher Gesprächspartner oder ein autonomer Planer mit Aufsicht ist.

In puncto Sicherheit verstärken beide Anbieter weiterhin Filter und Eskalationspfade. Teams sollten definieren, was „gut“ bedeutet, und messbare Checks implementieren: Ablehnungsbehandlung, geschützte Kategorien und Audit-Trails. Betriebsleiter pflegen oft ein „Golden Set“ an Prompts und erwarteten Ausgaben für Regressionstests. Zudem erfordern Nutzungssteuerungen Beachtung; wenn gleichzeitige Zugriffe wichtig sind, prüfen Sie praktische Grenzen und Gegenmaßnahmen, erläutert in Community-Guides wie Ratenbegrenzungs-Insights. Für jene, die breitere Ökosysteme vergleichen, hilft ein Querschnitt wie ChatGPTs neue Intelligenz bei der Erfassung von Fähigkeitsverschiebungen, die Roadmap-Planung beeinflussen.

Entwicklerbefähigung umfasst auch Dokumentationen, SDKs und Drittanbieter-Inhalte. Tutorials, die Persona-Frameworks, Abruf-Pattern und Evaluierungshilfen kodifizieren, sind ihr Gewicht in Betriebszeit wert. Ziehen Sie das Verpacken von wiederverwendbaren Prompt-Bibliotheken und Test-Suiten in Betracht, damit jedes Team nicht das Rad neu erfinden muss. Wo Programmier-Copiloten zentral sind, benchmarken Sie gegen angrenzende Angebote und studieren Sie Microsoft Copilot vs ChatGPT Nuancen in der IDE-Erfahrung, um Entwicklererwartungen vorauszusehen.

Vom Prototyp zur Produktionsreife

- 🧱 Bauen Sie einen minimalen End-to-End-Schnitt: mit minimalem Umfang, einschließlich Logging und Evaluation, bevor Sie skalieren.

- 🛰️ Disziplin bei Funktionsaufrufen: Definieren Sie Verträge für Funktionen; validieren Sie Ein- und Ausgaben, um stille Fehler zu vermeiden.

- 🧭 Persona-Spezifikation: Dokumentieren Sie Ton, Formatierung, Ablehnungspolitik und Eskalationsregeln.

- 🧯 Sicherheitsübungen: Führen Sie vierteljährliche Red-Team-Prompts durch; verfolgen Sie Deltas über Bibliotheks- und Modell-Updates.

- 📈 Beobachtbarkeit: Protokollieren Sie Token-Ausgaben, Latenz und Genauigkeit, um Rückschritte früh zu erkennen.

| Dimension 🧩 | OpenAI Vorteil 💬 | Google Vorteil 🌐 | Entwickler-Schlussfolgerung 🛠️ |

|---|---|---|---|

| Schneller Start | Persona- und Tonvorgaben | Agentische Gerüster | Wählen Sie je nach erstem Meilenstein |

| Sicherheitsbetrieb | Ausgereifte Ablehnungsmuster | Robuste Planungsleitplanken | Abstimmung auf Risikoprofil |

| Werkzeugnutzung | Saubere Funktionsaufrufe | Mehrstufige Orchestrierung | Abbildung der Komplexität des Arbeitsablaufs |

| Dokumentation & Ökosystem | Reiche Muster und Beispiele | Wachsende Agenten-Frameworks | Nutzen Sie Community-Code |

Wenn Sie sich noch nicht entschieden haben, liefern Meta-Vergleiche wie ChatGPT vs Bard Geschichte und Anbieter-Duells wie Google Gemini vs ChatGPT Guide Perspektiven, die sonst übersehen werden könnten.

Wählen Sie den Stack, der Ihre nächste Veröffentlichung mit den wenigsten Umgehungen beschleunigt; Geschwindigkeit ist der wahre Burggraben.

{“@context”:”https://schema.org”,”@type”:”FAQPage”,”mainEntity”:[{“@type”:”Question”,”name”:”Welches Modell ist besser für lange Forschungsdokumente und gemischte Medien?”,”acceptedAnswer”:{“@type”:”Answer”,”text”:”Googles neuestes Modell gewinnt tendenziell, wenn große Kontextfenster und multimodale Synthese entscheidend sind. Teams können lange PDFs, Screenshots und Notizen in einem Fluss behalten, was Fragmentierung reduziert und Genauigkeit über Abschnitte bewahrt.”}},{“@type”:”Question”,”name”:”Welches Modell bietet die stärkste Gesprächskontrolle und Tonkonsistenz?”,”acceptedAnswer”:{“@type”:”Answer”,”text”:”OpenAIs GPT‑5.1 zeichnet sich durch Anweisungsgenauigkeit und Persona-Kontrollen aus. Es hält Stimme, Formalität und Struktur über viele Wechsel konsistent, ideal für Support, Marketingtexte und Coaching-Assistenten.”}},{“@type”:”Question”,”name”:”Wie sollten Teams basierend auf Kosten entscheiden?”,”acceptedAnswer”:{“@type”:”Answer”,”text”:”Modellieren Sie die tatsächlichen Kosten nach Arbeitslast: Wenn Eingaben dominieren, kann lange Kontext-Effizienz Googles Preis rechtfertigen; wenn Ausgaben dominieren, sind OpenAIs Tarife eventuell günstiger. Prompt-Optimierung und Retrieval-Design sparen oft mehr als rohe Token-Differenzen.”}},{“@type”:”Question”,”name”:”Gibt es Ressourcen zum Vergleichen und Verbessern von Prompts?”,”acceptedAnswer”:{“@type”:”Answer”,”text”:”Ja. Beginnen Sie mit Leitfäden zum Prompt-Engineering wie Prompt-Optimierungsstrategien, sowie praktischen Berichten wie dem ChatGPT 2025 Review. Diese helfen Teams, Wiederholungen zu reduzieren, Genauigkeit zu verbessern und den Ton markenkonform zu halten.”}},{“@type”:”Question”,”name”:”Wo kann ich weitere Head-to-Head-Vergleiche finden?”,”acceptedAnswer”:{“@type”:”Answer”,”text”:”Für breiteren Kontext lesen Sie ChatGPT vs Gemini 2025, Google Gemini vs ChatGPT Guides, und Vergleiche mit Perplexity, Copilot und anderen, um Eignung nach Aufgaben und Ökosystem zu verstehen.”}}]}Welches Modell ist besser für lange Forschungsdokumente und gemischte Medien?

Googles neuestes Modell gewinnt tendenziell, wenn große Kontextfenster und multimodale Synthese entscheidend sind. Teams können lange PDFs, Screenshots und Notizen in einem Fluss behalten, was Fragmentierung reduziert und Genauigkeit über Abschnitte bewahrt.

Welches Modell bietet die stärkste Gesprächskontrolle und Tonkonsistenz?

OpenAIs GPT‑5.1 zeichnet sich durch Anweisungsgenauigkeit und Persona-Kontrollen aus. Es hält Stimme, Formalität und Struktur über viele Wechsel konsistent, ideal für Support, Marketingtexte und Coaching-Assistenten.

Wie sollten Teams basierend auf Kosten entscheiden?

Modellieren Sie die tatsächlichen Kosten nach Arbeitslast: Wenn Eingaben dominieren, kann lange Kontext-Effizienz Googles Preis rechtfertigen; wenn Ausgaben dominieren, sind OpenAIs Tarife eventuell günstiger. Prompt-Optimierung und Retrieval-Design sparen oft mehr als rohe Token-Differenzen.

Gibt es Ressourcen zum Vergleichen und Verbessern von Prompts?

Ja. Beginnen Sie mit Leitfäden zum Prompt-Engineering wie Prompt-Optimierungsstrategien, sowie praktischen Berichten wie dem ChatGPT 2025 Review. Diese helfen Teams, Wiederholungen zu reduzieren, Genauigkeit zu verbessern und den Ton markenkonform zu halten.

Wo kann ich weitere Head-to-Head-Vergleiche finden?

Für breiteren Kontext lesen Sie ChatGPT vs Gemini 2025, Google Gemini vs ChatGPT Guides, und Vergleiche mit Perplexity, Copilot und anderen, um Eignung nach Aufgaben und Ökosystem zu verstehen.

-

Tech2 days ago

Tech2 days agoIhre Karte unterstützt diesen Kaufart nicht: was das bedeutet und wie Sie das Problem lösen können

-

KI-Modelle1 day ago

KI-Modelle1 day agoOpenAI vs Tsinghua: Die Wahl zwischen ChatGPT und ChatGLM für Ihre KI-Bedürfnisse im Jahr 2025

-

Internet24 hours ago

Internet24 hours agoDie Zukunft erkunden: Was Sie über internetfähiges ChatGPT im Jahr 2025 wissen müssen

-

Tech3 hours ago

Tech3 hours agowird Null als rationale Zahl betrachtet? Einfach erklärt

-

KI-Modelle1 day ago

KI-Modelle1 day agoDie Wahl Ihres KI-Forschungspartners im Jahr 2025: OpenAI vs. Phind

-

Tech11 hours ago

Tech11 hours agoDas Verständnis von hart degeneriert: was es bedeutet und warum es 2025 wichtig ist