Gemini 3 vs ChatGPT 5.1: Arquitectura, Manejo de Contexto y Capacidades Básicas de IA

Esta revisión tecnológica se centra en cómo Google Gemini 3 y ChatGPT (impulsado por GPT-5.1) difieren bajo el capó, porque la arquitectura impulsa funciones, rendimiento y, en última instancia, resultados en el mundo real. Google posiciona su última versión como un sistema único, orientado a agentes, que fusiona percepción multimodal con planificación a largo plazo. Hereda ideas agénticas de iteraciones anteriores y las eleva con un enfoque consolidado de aprendizaje automático que mantiene las cadenas de razonamiento intactas sobre contextos muy amplios. En contraste, la última versión de OpenAI prioriza un flujo de diálogo pulido, un seguimiento de instrucciones más firme y una profundidad dinámica de “pensamiento” que cambia según la complejidad de la tarea.

El tamaño del contexto es el corazón palpitante del trabajo largo. El modelo de Google se extiende a ventanas muy grandes — cientos de miles de tokens — para que resúmenes de investigación, resúmenes de cumplimiento y ensamblajes de guiones cinematográficos puedan permanecer en una sola sesión sin fragmentación. Eso es importante cuando los equipos necesitan continuidad. Los modelos de lenguaje de OpenAI están optimizados para la agilidad y el turno rápido; el procesamiento de lenguaje natural se siente fluido, y el sistema puede ser dirigido con controles de tono y personalidad que hacen que los asistentes corporativos suenen acorde con la marca por defecto.

El razonamiento es otra línea de falla. La adición de modo Deep Think de Google apunta directamente a la lógica y planificación en múltiples pasos. Es el interruptor para el “modo difícil”, útil para estrategia, simulación y fusión compleja de datos. OpenAI responde con dos modos — “Instant” y “Thinking” — que modulan la deliberación para intercambiar velocidad por profundidad cuando es necesario. Para muchos equipos, esta dualidad se traduce en menos acrobacias con los prompts para obtener el ritmo o precisión deseados. La elección refleja una comparación más amplia de IA vista en toda la industria: una pila está construida para expansión y síntesis, la otra para interacción consistente y amable.

Para anclar esto en la realidad, considere Nimbus Labs, un proveedor SaaS de mercado medio que construye un copiloto para éxito del cliente. Su plan requería: (1) analizar largas transcripciones de llamadas; (2) redactar seguimientos empáticos; y (3) generar manuales que combinan texto, métricas y capturas de pantalla de UI. Con el sistema de Google, mantuvieron 180,000 tokens de historial cruzado de clientes activos, lo que permitió que el bot recordara casos marginales específicos sin volver a cargar materiales. Con el sistema de OpenAI, ajustaron la voz y la temperatura para que coincidieran con las directrices de la marca, asegurando que cada respuesta sonara como un CSM experimentado. El factor decisivo fue si la continuidad en contextos extremos superaba la fineza conversacional en el alcance diario.

Más allá del diálogo y el contexto, la plataforma de desarrollo Antigravity de la pila de Google merece mención. Enfatiza herramientas agénticas, orquestación y flujos de trabajo pesados en planificación. El lado de OpenAI avanza en confiabilidad en el cumplimiento de instrucciones y permite a los equipos bloquear ajustes preestablecidos de personajes a través de hilos, para que la desviación del estilo sea mínima durante el uso prolongado. Cada dirección representa una filosofía: construir un agente cognitivo todo-en-uno o afinar el mejor colaborador del mundo.

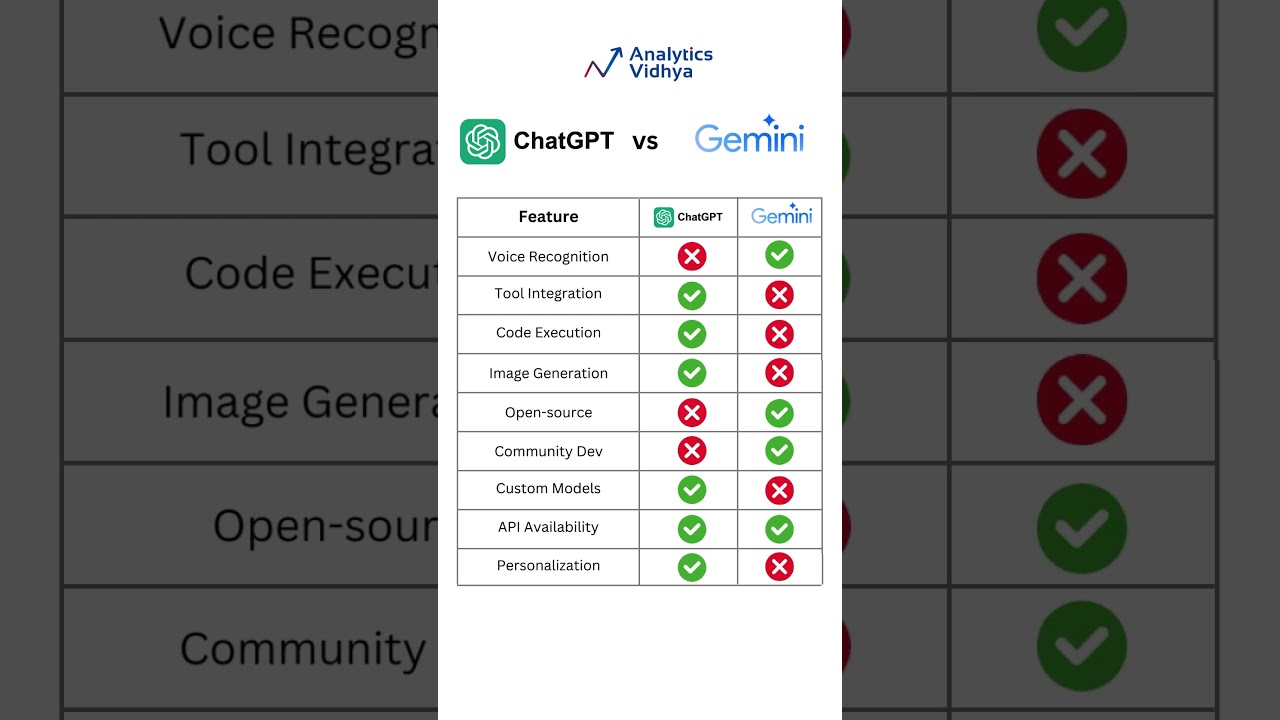

Para los lectores que buscan más comparaciones más allá de estos dos, recursos como la guía Google Gemini vs ChatGPT y una visión equilibrada de ChatGPT vs Gemini 2025 ayudan a enmarcar fortalezas sin sesgos de marketing. En un campo saturado, la perspectiva importa.

Diferencias clave que moldean resultados

- 🧠 Razonamiento profundo vs diálogo ágil: Deep Think prioriza la planificación; los modos duales de OpenAI equilibran velocidad y profundidad.

- 🧾 Compensaciones en longitud de contexto: ventanas extremas son adecuadas para informes de investigación; contextos compactos y receptivos favorecen tareas de atención al cliente.

- 🖼️ Fluidez multimodal: el modelo de Google combina texto, imágenes y código en un solo flujo; OpenAI se enfoca en control conversacional impecable.

- 🛠️ Experiencia del constructor: Antigravity permite orquestación agéntica; OpenAI simplifica tono, personalidad y fidelidad a instrucciones.

- 📈 Adecuación empresarial: los motores de planificación prosperan en I+D; los motores conversacionales destacan en soporte, marketing y ventas.

| Aspecto ⚙️ | Destacado de Gemini 3 🌐 | Destacado de GPT‑5.1 💬 |

|---|---|---|

| Razonamiento | Deep Think para planes multi-pasos | Modos Instant/Thinking para profundidad adaptativa |

| Ventana de Contexto | Muy grande, continuidad a largo plazo | Optimizado para turnos rápidos y coherentes |

| Modalidad | Texto + imágenes + código sin interrupciones | Primero texto con acabado y herramientas fuertes |

| Herramientas para Constructores | Plataforma Antigravity para agentes | Ajustes preestablecidos de personalidad y tono |

| Ajuste de Caso de Uso | Investigación, planes, síntesis técnica | Soporte, redacción, ayuda interactiva |

Conclusión: la arquitectura equivale a ventaja — decida si la síntesis de contexto largo o la precisión conversacional mueve más la aguja para su hoja de ruta.

La siguiente sección se enfoca en economía, porque una gran arquitectura solo funciona si las matemáticas también cuadran.

Precios, Economía de Tokens y Valor para Constructores y Equipos

Para muchos tomadores de decisiones, la relación precio-rendimiento es decisiva. La API de GPT‑5.1 de OpenAI cuesta cerca de $1.25 por 1M de tokens de entrada y $10 por 1M de tokens de salida. La oferta principal de Google lista aproximadamente $2 entrada / $12 salida por 1M de tokens para contextos de rango medio (aprox. hasta 200k tokens), con niveles superiores alrededor de $4 / $18 para ventanas mucho mayores. En planes de consumo, Google ofrece un nivel Pro alrededor de $19.99/mes y un nivel empresarial con precios personalizados — ampliamente reportado hasta ~$250/mes para capacidades completas. El paquete de consumo de OpenAI típicamente comienza cerca de $20/mes, con mayores asignaciones y funciones por encima de esa línea.

Las matemáticas de tokens cambian la estrategia. Un equipo de marketing que genera 40 páginas de aterrizaje podría preocuparse más por el precio de salida; un analista que ingiere PDFs de auditoría prioriza costos de entrada. Por eso el ganador no es universal. Algunos compradores modelan cargas de trabajo semanales y eligen proveedor basado en la proporción esperada entre lectura y escritura. Otros optimizan la ergonomía del desarrollador — si una API reduce llamadas desperdiciadas gracias a un mejor seguimiento de instrucciones, puede ahorrar más que un precio más barato sugiere.

Los detalles de integración también importan. Los equipos que necesitan centralizar secretos pueden dominar la configuración de la clave API de ChatGPT para acelerar la incorporación. Mientras tanto, cualquiera que planee grandes corpus de conocimiento debería explorar estrategias para cambiar la ventana de contexto en sus herramientas para evitar explosiones de tokens. Y cuando cada prompt es una decisión presupuestaria, las estrategias de optimización de prompts reducen reintentos y recortan significativamente el gasto.

Cuándo brilla cada modelo de precios

- 💡 Fábricas de copias de alta producción: tarifas más bajas en salida hacen a OpenAI atractivo para fábricas de contenido y flujos de trabajo de boletines.

- 📚 Repositorios de investigación: ventanas más grandes ayudan al modelo de Google a mantener continuidad a lo largo de entradas extensas, reduciendo la fragmentación.

- 🤝 Soporte al cliente: controles de tono consistentes y seguimiento de instrucciones confiable mejoran la resolución al primer contacto.

- 🧪 Prototipado: la API que genere menos llamadas fallidas o reintentos suele ganar en costo real por solución.

- 📊 Gobernanza empresarial: niveles mensuales predecibles y facturación consolidada suelen superar pequeñas diferencias en tokens.

| Plan 💼 | Costo Google Gemini 3 💸 | Costo GPT‑5.1 💸 | Mejor Para ✅ |

|---|---|---|---|

| API (contexto medio) | $2 entrada / $12 salida por 1M | $1.25 entrada / $10 salida por 1M | Equilibrio I+D vs contenido |

| API (contexto grande) | $4 entrada / $18 salida por 1M | Varía por nivel | Documentos largos, cumplimiento |

| Consumo | ~$19.99/mes; empresa hasta ~$250 | ~$20/mes en adelante | Individuos, equipos, operaciones |

| Visión de costo total | Más fuerte en entradas largas | Favorables para salidas grandes | Matemáticas específicas de carga |

Si los detalles de precios para usuarios finales son prioritarios, consulte Precios de ChatGPT en 2025 y compare internamente con modelos de uso para fijar un techo sensato.

El precio es solo la mitad de la ecuación; la otra mitad es lo que esos tokens pueden hacer cuando el texto se encuentra con imágenes, código y planificación.

Flujos de Trabajo Multimodales y Estudios de Caso de Contexto Largo Que Ponen a Prueba Ambos Modelos

La capacidad multimodal diferencia asistentes casuales de copilotos verdaderos en el trabajo. El lanzamiento de Google aporta manejo unificado de texto, imágenes y código en un solo flujo, construyendo sobre experimentos multimodales previos y avanzando en continuidad. Para tareas complejas — piense en diagramas arquitectónicos, fotos de productos y guiones — la capacidad de referenciar detalles visuales mientras se escribe o depura es un acelerador. La última versión de OpenAI enfatiza la claridad composicional en lenguaje, pero pruebas independientes han sugerido que queda detrás de la pila de Google en amplitud de modalidad y razonamiento sostenido a largo plazo.

Tomemos nuevamente a Nimbus Labs. Su manual de lanzamiento de producto requería: (a) analizar capturas de pantalla de competidores; (b) redactar una serie de 12 correos electrónicos de nutrición; (c) producir fragmentos de SDK; y (d) armar una guía de campo de 40 páginas. Con el sistema de Google, enviaron imágenes anotadas y bloques de texto en una sesión continua. El asistente produjo muestras de código alineadas con elementos de UI visibles en las capturas de pantalla — sin idas y vueltas para aclarar etiquetas. Con OpenAI, el equipo destacó en hacer que la secuencia de alcance sonara como un estratega humano, gracias a controles de tono más fuertes y bloqueo de personalidad. El resultado: dividieron cargas de trabajo — síntesis visual + técnica de un lado, mensajes de alto contacto del otro.

Cuando los documentos superan los límites típicos, dividir contenido en fragmentos puede causar pérdida de contexto. La extensión larga de Google hace que una “memoria” continua única sea más factible, reduciendo el riesgo de contradicciones. Los usuarios de OpenAI a menudo compensan con estrategias cuidadosas de recuperación y disciplina en metadatos. Si ese es su camino, explore consejos para flujo de trabajo de análisis de archivos e integre un índice vectorial para mantener el sistema anclado entre sesiones.

Para cubrir más comparaciones, los compradores también revisan herramientas adyacentes. Vea ChatGPT vs Perplexity AI para tareas con mucha investigación, o revise ChatGPT vs GitHub Copilot cuando la asistencia de codificación sea central en la decisión.

Planos para triunfos multimodales

- 🖼️ Anclar visuales: asegure que capturas de pantalla o diagramas tengan llamados explícitos; el modelo de Google alinea bien las salidas con elementos en imagen.

- 🗂️ Mantener una única fuente: cuando sea posible, cargue el contexto completo una vez; ventanas enormes reducen errores por unir sesiones.

- 🧩 Disciplina de recuperación: para ventanas más pequeñas, invierta en incrustaciones y recuperación para simular continuidad.

- 🧪 Pruebe con activos reales: datos simulados ocultan casos marginales; PDFs e imágenes reales exponen la verdadera fricción.

- 🧭 Asigne roles: dirija síntesis visual-técnica al líder multimodal; dirija copia empática al especialista en conversación.

| Flujo de Trabajo 🧭 | Ajuste Más Fuerte: Google 🌟 | Ajuste Más Fuerte: OpenAI 🚀 | Razón 🔍 |

|---|---|---|---|

| Síntesis visual + texto | Sí | Situacional | Continuidad multimodal a través de largos lapsos |

| Alcance perfecto con personalidad | Situacional | Sí | Controles finos de tono y fidelidad a instrucciones |

| Grandes dossiers de investigación | Sí | Situacional | Menor fragmentación; menos contradicciones |

| Preguntas y respuestas rápidas | Situacional | Sí | Diálogo receptivo y turnos cortos coherentes |

Para una perspectiva integral de cómo las herramientas basadas en GPT evolucionaron hasta los asistentes actuales, la visión general de la evolución de la IA de ChatGPT es una lectura complementaria útil.

Habiendo mapeado fortalezas multimodales, la siguiente sección evalúa la calidad de conversación y seguimiento de instrucciones — críticas para equipos que viven en chat todo el día.

Seguimiento de Instrucciones, Controles de Tono y Calidad Conversacional en el Uso Diario

La última versión de OpenAI prioriza el flujo de conversación. Dos modos ajustables — Instant y Thinking — permiten a los desarrolladores intercambiar velocidad por deliberación sin prompts elaborados. Sigue instrucciones de modo más consistente y añade controles para personalidad, cortesía y formalidad. Esa combinación da a los centros de ayuda, equipos de marketing y recursos humanos una “voz” confiable. Para equipos técnicos, la consistencia reduce retrabajos: menos recordatorios para ser conciso, menor desviación de estilo en hilos largos y transiciones más limpias a revisores humanos.

La última versión de Google se enfoca en pragmatismo a través de planificación y memoria larga, aunque su diálogo también se ha ajustado comparado con modelos previos. Al pedirle producir salidas en varios pasos — como un plan de alcance con variaciones de mensajes por persona y etapa — tiende a mantener la estructura intacta. Las diferencias se manifiestan más en tareas sensibles al tono. La pila de OpenAI facilita establecer amabilidad, humor y frases específicas de marca. Si la tarea es responder 300 correos electrónicos de clientes matizados por día, esa consistencia se multiplica rápidamente.

Dado que la destreza en prompts influye en costo y calidad, vale la pena afinar la técnica. Un recurso excelente es estrategias de optimización de prompts que cubre guardarraíles, pruebas de paridad y bases deterministas. Para equipos operativos que lanzan pilotos, la revisión práctica de ChatGPT 2025 da una idea real de dónde brilla el modelo. Y para quienes distribuyen acceso globalmente, especialmente en mercados emergentes, el resumen sobre acceso gratuito a ChatGPT en India detalla consideraciones regionales para despliegues.

Patrones para conversaciones de alta calidad

- 🧭 Establezca una personalidad predeterminada: bloquee tono, brevedad y formato al inicio de cada sesión para calidad predecible.

- ✍️ Use esquemas de salida: encabezados, viñetas y JSON reducen la ambigüedad y mejoran la adherencia a instrucciones.

- 🧪 Ejecute guiones A/B: compare Instant vs Thinking o prompts cortos vs detallados para encontrar su patrón óptimo de respuesta.

- 📣 Bucles de retroalimentación: capture correcciones de usuario y retroaliméntelas como ejemplos de estilo para minimizar desviaciones futuras.

- 🔐 Guardarraíles: defina temas tabú, reglas de escalación y etiquetas de cumplimiento para proteger marca y usuarios.

| Control 🎛️ | Fortaleza de OpenAI 💬 | Fortaleza de Google 🌐 | Impacto Práctico ✅ |

|---|---|---|---|

| Ajustes de tono | Granular y fijo | Mejorado, sólido | Respuestas consistentes con la marca |

| Fidelidad a instrucciones | Alta | Alta, especialmente para planes estructurados | Menos reintentos |

| Velocidad vs profundidad | Interruptor Instant/Thinking | Interruptor Deep Think | Compensación adecuada por tarea |

| Hilos largos | Personalidad estable | Estructura estable | Sesiones multi-turno coherentes |

Los equipos alineados en voz y claridad probablemente se inclinarán por el sistema con los controles de personalidad más intuitivos; quienes envían planes complejos pueden preferir la disciplina estructural del planificador.

Benchmarks, Rankings y Señales de Rendimiento en el Mundo Real en las que Puede Confiar

Los benchmarks cuentan solo parte de la historia, pero la tabla actual es reveladora. En la tabla comunitaria de LMArena, Gemini 3 tiene una puntuación alta cercana a 1324, por delante de Gemini 2.5 Pro alrededor de 1249. GPT‑5.1 (listado como GPT‑5‑chat) está cerca de 1222, junto a generaciones previas de OpenAI y otros modelos de frontera. El mensaje de miles de votos es claro: la última entrada de Google tiene fuerza, mientras que el lanzamiento de OpenAI mantiene una posición fuerte y respetada en el nivel superior.

Las pruebas sintéticas a menudo refuerzan esa diferencia. Los informes han notado la ventaja de Google en razonamiento extendido y amplitud multimodal, mientras que el modelo de OpenAI sobresale en salidas coherentes de forma corta y obediencia a instrucciones. Desafíos al estilo Tom’s Guide enfocados en tono y personalidad suelen favorecer a OpenAI; el razonamiento con imágenes o la síntesis en contexto largo favorecen al motor de Google. Eso se alinea con el ruido del mercado más amplio: lo que parece “más inteligente” depende mucho de la regla de medición — diálogo sintonizado emocionalmente o cognición a largo plazo.

Para ampliar la perspectiva, recursos comparativos como Comparación OpenAI vs Anthropic y reseñas históricas como resúmenes de GPT‑4, Claude 2 y era Llama ayudan a situar a los contendientes actuales en contexto. Los lectores interesados en enfrentamientos cruzados también pueden estudiar Microsoft Copilot vs ChatGPT para entender cómo las elecciones de modelo repercuten en experiencias de producto.

Lo que dicen los rankings — y lo que no dicen

- 🏁 Las tablas de clasificación capturan el sentimiento comunitario; son útiles, pero no definitivas para su carga única de trabajo.

- 🧪 Las pruebas de laboratorio destacan los extremos; la realidad productiva mezcla latencia, guardarraíles y limitaciones de herramientas.

- 🧰 El ajuste del stack importa: los pipelines de datos, recuperación y limpieza de prompts pueden influir más que el coeficiente intelectual bruto.

- 📐 Defina métricas de éxito temprano: precisión, tiempo para redactar y carga de revisión deben medirse por equipo.

- 🔄 Iterar: pequeños ajustes en prompts y flujos a menudo convierten un “empate” en ganador claro para su organización.

| Señal 📊 | Observación 🔎 | Implicación 💡 | Ganador Hoy 🏆 |

|---|---|---|---|

| Puntuación LMArena | 1324 vs rango ~1222 | La comunidad favorece el modelo de Google | Google 🌟 |

| Tareas de contexto largo | Menos interrupciones, continuidad más rica | Mejor investigación y síntesis | Google 🌟 |

| Control de personalidad | Tono y estilo más finos | Chat coherente con la marca | OpenAI 🚀 |

| Escritura de forma corta | Limpio, directo, con baja deriva | Ciclos de revisión más rápidos | OpenAI 🚀 |

Para una recopilación más amplia de selecciones del mercado, explore esta lista curada de principales IAs para escritura en 2025 para ver dónde se ubican estos dos entre herramientas especializadas.

Los rankings guían la mirada; los pilotos en vivo revelan la verdad que importa para su equipo.

Experiencia de Desarrollador, Seguridad y Ecosistema: Desde el Primer Prompt Hasta la Producción

Enviar un asistente es más que solo texto ingenioso. Es incorporación, límites de tasa, observabilidad y seguridad. La experiencia de desarrollador de OpenAI enfatiza arranques rápidos con ajustes claros de personalidad, guardarraíles y salidas estructuradas. La pila de Google enfatiza orquestación vía Antigravity, animando a los desarrolladores a diseñar agentes multi-pasos que puedan planificar, llamar herramientas y mantener estado a lo largo de sesiones largas. Ambos caminos pueden funcionar; la elección correcta depende de si su producto es un conversador amable o un planificador autónomo con supervisión.

En seguridad, ambos proveedores continúan robusteciendo filtros y vías de escalación. Los equipos deberían definir cómo es un “buen” resultado, luego implementar chequeos medibles: manejo de rechazos, categorías protegidas y registros de auditoría. Los líderes de operaciones suelen mantener un “set dorado” de prompts y salidas esperadas para pruebas de regresión. Además, los límites de uso requieren atención; si los picos en concurrencia importan, revise los límites prácticos y estrategias de mitigación explicadas en guías comunitarias como insights sobre límites de tasa. Para quienes comparan ecosistemas amplios, un análisis cruzado como la nueva inteligencia de ChatGPT ayuda a capturar cambios de capacidades que afectan la planificación de la hoja de ruta.

La habilitación del desarrollador también incluye documentación, SDKs y contenido de terceros. Los tutoriales que codifican marcos de personalidad, patrones de recuperación y arneses de evaluación valen su peso en tiempo activo. Considere empaquetar bibliotecas reutilizables de prompts y suites de prueba para que cada equipo no tenga que reinventar la rueda. Donde los copilotos de codificación son centrales, compare con ofertas adyacentes y vea las diferencias en experiencia IDE en Microsoft Copilot vs ChatGPT para anticipar expectativas de desarrolladores.

De prototipo a preparación para producción

- 🧱 Construya un segmento mínimo: de extremo a extremo con alcance mínimo, incluyendo registro y evaluaciones, antes de escalar.

- 🛰️ Disciplina en llamada de herramientas: defina contratos para funciones; valide entradas/salidas para evitar fallos silenciosos.

- 🧭 Especificación de personalidad: documente tono, formato, política de rechazo y desencadenantes de escalación.

- 🧯 Simulacros de seguridad: ejecute prompts de red-team trimestralmente; rastree cambios en biblioteca y actualizaciones de modelo.

- 📈 Observabilidad: registre gasto de tokens, latencia y precisión para detectar regresiones temprano.

| Dimensión 🧩 | Ventaja OpenAI 💬 | Ventaja Google 🌐 | Consejo para Constructores 🛠️ |

|---|---|---|---|

| Inicio rápido | Personalidad/tonos preestablecidos | Andamiaje agéntico | Elija según el primer hito |

| Operaciones de seguridad | Patrones maduros de rechazo | Guardarraíles robustos de planificación | Alinee con el perfil de riesgo |

| Uso de herramientas | Llamadas de función limpias | Orquestación multi-pasos | Mapee a la complejidad del flujo |

| Documentación y ecosistema | Patrones y ejemplos abundantes | Marcos de agentes en crecimiento | Apóyese en código comunitario |

Si aún está sopesando ambos, meta-comparaciones como Historia de ChatGPT vs Bard y comparativas directas como Guía Google Gemini vs ChatGPT revelan ángulos que podrían pasar inadvertidos.

Elija la pila que acelere su próximo lanzamiento con menos soluciones improvisadas; la velocidad es la verdadera fortaleza.

{“@context”:”https://schema.org”,”@type”:”FAQPage”,”mainEntity”:[{“@type”:”Question”,”name”:”Which model is better for long research documents and mixed media?”,”acceptedAnswer”:{“@type”:”Answer”,”text”:”Googleu2019s latest model tends to win when large context windows and multimodal synthesis are vital. Teams can keep long PDFs, screenshots, and notes in one flow, reducing fragmentation and preserving accuracy across sections.”}},{“@type”:”Question”,”name”:”Which model offers the strongest conversational control and tone consistency?”,”acceptedAnswer”:{“@type”:”Answer”,”text”:”OpenAIu2019s GPTu20115.1 stands out for instruction fidelity and persona controls. It keeps voice, formality, and structure consistent over many turns, which is ideal for support, marketing copy, and coaching assistants.”}},{“@type”:”Question”,”name”:”How should teams decide based on cost?”,”acceptedAnswer”:{“@type”:”Answer”,”text”:”Model true cost by workload: if inputs dominate, long-context efficiency can justify Googleu2019s pricing; if outputs dominate, OpenAIu2019s rates may be preferable. Prompt optimization and retrieval design often save more than raw token deltas.”}},{“@type”:”Question”,”name”:”Are there resources to compare and improve prompts?”,”acceptedAnswer”:{“@type”:”Answer”,”text”:”Yes. Start with prompt engineering guides such as prompt optimization strategies, plus hands-on reports like the ChatGPT 2025 review. These help teams reduce retries, improve accuracy, and keep tone on-brand.”}},{“@type”:”Question”,”name”:”Where can I explore more head-to-head matchups?”,”acceptedAnswer”:{“@type”:”Answer”,”text”:”For broader context, read ChatGPT vs Gemini 2025, Google Gemini vs ChatGPT guides, and comparisons with Perplexity, Copilot, and others to understand fit by task and ecosystem.”}}]}¿Qué modelo es mejor para documentos largos de investigación y medios mixtos?

El último modelo de Google tiende a ganar cuando ventanas de contexto grandes y síntesis multimodal son vitales. Los equipos pueden mantener PDFs largos, capturas de pantalla y notas en un solo flujo, reduciendo la fragmentación y preservando la precisión a través de las secciones.

¿Qué modelo ofrece el control conversacional más fuerte y coherencia de tono?

GPT‑5.1 de OpenAI se destaca por la fidelidad a las instrucciones y controles de personalidad. Mantiene la voz, formalidad y estructura consistentes a lo largo de múltiples turnos, lo cual es ideal para soporte, copias de marketing y asistentes de coaching.

¿Cómo deberían decidir los equipos basándose en el costo?

Modele el costo verdadero según la carga de trabajo: si dominan las entradas, la eficiencia del contexto largo puede justificar el precio de Google; si dominan las salidas, las tarifas de OpenAI pueden ser preferibles. La optimización de prompts y el diseño de recuperación a menudo ahorran más que las diferencias brutas en tokens.

¿Existen recursos para comparar y mejorar los prompts?

Sí. Comience con guías de ingeniería de prompts como estrategias de optimización de prompts, además de informes prácticos como la revisión de ChatGPT 2025. Estos ayudan a los equipos a reducir reintentos, mejorar la precisión y mantener el tono acorde con la marca.

¿Dónde puedo explorar más enfrentamientos directos?

Para un contexto más amplio, lea ChatGPT vs Gemini 2025, guías Google Gemini vs ChatGPT y comparaciones con Perplexity, Copilot y otros para entender adecuación según la tarea y el ecosistema.

-

Tecnologia2 days ago

Tecnologia2 days agoSu tarjeta no admite este tipo de compra: qué significa y cómo solucionarlo

-

Modelos de IA1 day ago

Modelos de IA1 day agoOpenAI vs Tsinghua: Elegir entre ChatGPT y ChatGLM para tus necesidades de IA en 2025

-

Internet23 hours ago

Internet23 hours agoExplorando el Futuro: Lo Que Necesita Saber Sobre Internet-Enabled ChatGPT en 2025

-

Tecnologia2 hours ago

Tecnologia2 hours ago¿Se considera el cero un número racional? Explicado de manera sencilla

-

Modelos de IA1 day ago

Modelos de IA1 day agoElegir tu compañero de investigación en IA en 2025: OpenAI vs. Phind

-

Tecnologia11 hours ago

Tecnologia11 hours agoComprendiendo la degeneración dura: qué significa y por qué importa en 2025