Actualités

Google Gemini 3 vs ChatGPT : une comparaison complète des fonctionnalités et des performances

Gemini 3 vs ChatGPT 5.1 : Architecture, gestion du contexte et capacités fondamentales de l’IA

Cette revue technologique se concentre sur la façon dont Google Gemini 3 et ChatGPT (alimenté par GPT-5.1) diffèrent en interne, car l’architecture détermine les fonctionnalités, la performance et, ultimement, les résultats dans le monde réel. Google présente sa dernière version comme un système unique orienté agent qui fusionne la perception multimodale avec une planification à long terme. Il hérite des idées agentiques des versions précédentes et les élève avec une approche consolidée de l’apprentissage automatique qui conserve les chaînes de raisonnement intactes sur des contextes très étendus. En revanche, la dernière version d’OpenAI privilégie un flux de dialogue soigné, un respect plus rigoureux des instructions et une profondeur de « réflexion » dynamique qui varie selon la complexité des tâches.

La taille du contexte est le cœur battant du travail de longue durée. Le modèle de Google s’étend à des fenêtres très larges — des centaines de milliers de tokens — ce qui permet aux synthèses de recherche, aux résumés de conformité et aux assemblages de scénarios cinématographiques de rester dans une seule session sans fragmentation. Cela compte lorsque les équipes ont besoin de continuité. Les modèles de langage d’OpenAI sont optimisés pour l’agilité et l’échange rapide ; le traitement du langage naturel paraît fluide, et le système peut être orienté grâce à des contrôles de ton et de persona qui rendent les assistants d’entreprise cohérents par défaut.

Le raisonnement est une autre ligne de faille. L’ajout par Google d’un mode Deep Think cible directement la logique et la planification en plusieurs étapes. C’est l’interrupteur pour un « mode difficile », utile pour la stratégie, la simulation et la fusion de données complexes. OpenAI répond avec deux modes — « Instant » et « Thinking » — qui modulant la réflexion pour échanger rapidité contre profondeur selon les besoins. Pour de nombreuses équipes, cette dualité se traduit par moins de gymnastique dans les prompts pour obtenir le rythme ou la précision désirés. Ce choix reflète une plus large comparaison IA observée dans l’industrie : une pile est conçue pour l’expansion et la synthèse, l’autre pour une interaction cohérente et personnalisée.

Pour ancrer cela dans la réalité, considérons Nimbus Labs, un fournisseur SaaS de taille moyenne construisant un copilote de réussite client. Leur plan nécessitait : (1) analyser de longs transcrits d’appels ; (2) rédiger des suivis empathiques ; et (3) générer des playbooks mêlant texte, métriques et captures d’écran UI. Avec le système Google, ils ont conservé en live 180 000 tokens d’historique entre clients, permettant au bot de se souvenir de cas marginaux sans rechargement des matériaux. Avec le système OpenAI, ils ont ajusté la voix et la température pour respecter les directives de la marque, garantissant que chaque réponse sonnait comme un CSM expérimenté. Le facteur décisif fut de savoir si la continuité à très longue échelle l’emportait sur la finesse conversationnelle dans la prospection quotidienne.

Au-delà du dialogue et du contexte, la plateforme développeur Antigravity du stack Google mérite une mention. Elle met l’accent sur les outils agentiques, l’orchestration et les flux de travail centrés sur la planification. Le côté OpenAI améliore la fiabilité dans le respect des instructions et permet aux équipes de verrouiller des préréglages de persona dans les threads, limitant ainsi la dérive de style lors d’utilisations prolongées. Chaque orientation représente une philosophie : construire un agent cognitif tout-en-un, ou affûter le meilleur collaborateur mondial.

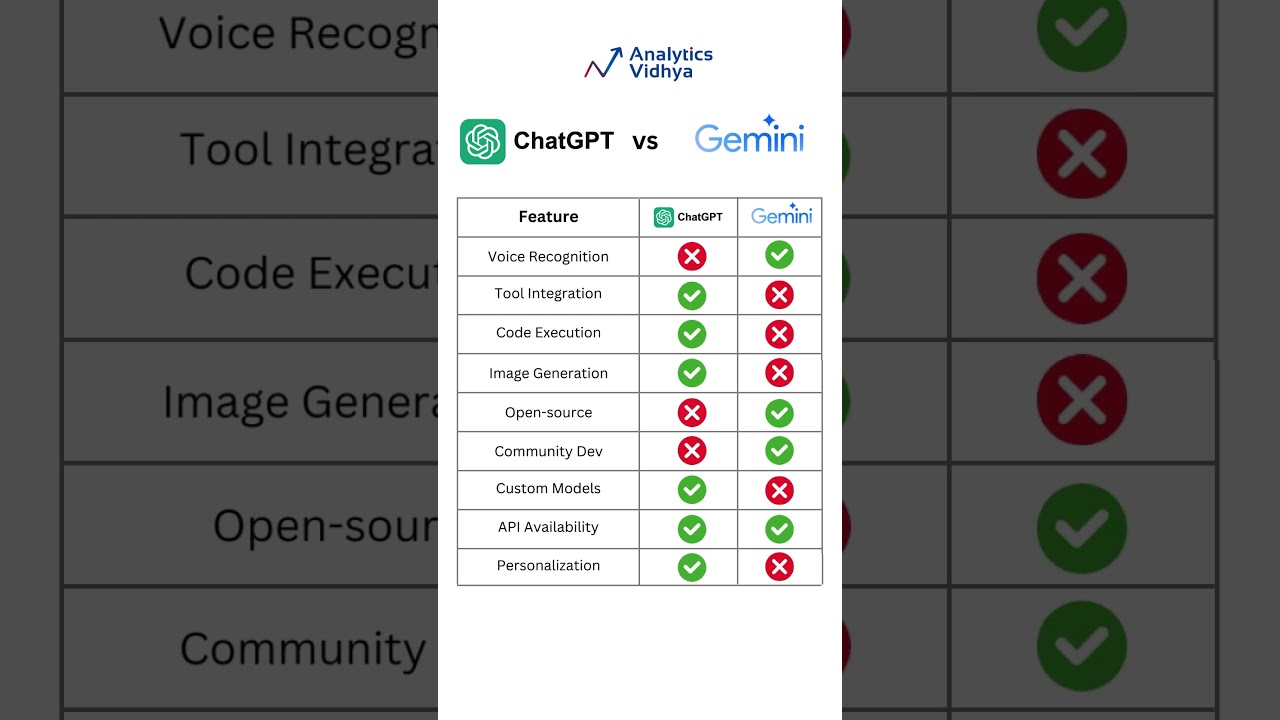

Pour les lecteurs cherchant plus de comparaisons au-delà de ces deux-là, des ressources comme le guide Google Gemini vs ChatGPT et un aperçu équilibré ChatGPT vs Gemini 2025 aident à cadrer les forces sans discours marketing. Dans un domaine très concurrentiel, la perspective est importante.

Différences clés qui façonnent les résultats

- 🧠 Raisonnement profond vs dialogue agile : Deep Think priorise la planification ; les modes doubles d’OpenAI équilibrent vitesse et profondeur.

- 🧾 Compromis sur la longueur du contexte : des fenêtres extrêmes conviennent aux rapports de recherche ; des contextes compacts et réactifs favorisent les tâches orientées client.

- 🖼️ Fluidité multimodale : le modèle Google fusionne texte, images et code dans un seul flux ; OpenAI se concentre sur un contrôle conversationnel impeccable.

- 🛠️ Expérience constructeur : Antigravity permet l’orchestration agentique ; OpenAI simplifie le ton, la persona et la fidélité aux instructions.

- 📈 Adéquation entreprise : les moteurs de planification prospèrent en R&D ; les moteurs conversationnels excellent en support, marketing et ventes.

| Aspect ⚙️ | Point fort Gemini 3 🌐 | Point fort GPT‑5.1 💬 |

|---|---|---|

| Raisonnement | Deep Think pour plans multi-étapes | Modes Instant/Thinking pour profondeur adaptative |

| Fenêtre de contexte | Très grande, continuité à long terme | Optimisé pour tours rapides et cohérents |

| Modalité | Texte + images + code sans accroc | Finition textuelle avec outils solides |

| Outils de construction | Plateforme agent Antigravity | Préréglages persona et ton |

| Adéquation cas d’usage | Recherche, plans, synthèse technique | Support, rédaction, aide interactive |

En résumé : l’architecture est un avantage — décidez si la synthèse sur long contexte ou la précision conversationnelle influencent le plus votre feuille de route.

La section suivante aborde l’économie, car une grande architecture ne fonctionne que si les chiffres suivent aussi.

Tarification, économie des tokens et valeur pour les développeurs et équipes

Pour de nombreux décideurs, le rapport qualité-prix est décisif. L’API GPT‑5.1 d’OpenAI tourne autour de 1,25 $ par million de tokens d’entrée et de 10 $ par million de tokens de sortie. Le produit phare de Google est listé à environ 2 $ pour l’entrée / 12 $ pour la sortie par million de tokens pour des contextes moyens (jusqu’à environ 200k tokens), avec des paliers supérieurs à 4 $ / 18 $ pour des étendues bien plus grandes. Sur les plans consommateurs, Google propose un niveau Pro autour de 19,99 $/mois et un palier Enterprise avec tarifs personnalisés — largement rapporté jusqu’à ~250 $/mois pour toutes les capacités. Le pack consommateur d’OpenAI débute typiquement près de 20 $/mois, avec des plafonds et fonctionnalités supérieurs.

La gestion des tokens change la stratégie. Une équipe marketing générant 40 pages de destination pourrait se soucier davantage du prix de sortie ; un analyste ingérant des PDF d’audit privilégie les coûts d’entrée. C’est pourquoi le vainqueur n’est pas universel. Certains acheteurs modélisent les charges hebdomadaires et choisissent un fournisseur selon la répartition attendue lecture/écriture. D’autres optimisent l’ergonomie développeur — si une API réduit les appels inutiles grâce à un meilleur suivi des instructions, elle peut économiser davantage que ce qu’un prix brut suggère.

Les détails d’intégration comptent aussi. Les équipes qui doivent centraliser les secrets peuvent maîtriser la configuration de la clé API ChatGPT pour accélérer l’intégration. Par ailleurs, toute personne planifiant d’importants corpus de connaissance devrait explorer les stratégies de changement de fenêtre de contexte dans leurs outils afin d’éviter l’explosion des tokens. Et lorsque chaque prompt est une décision budgétaire, les stratégies d’optimisation des prompts réduisent les retours et coupent significativement les dépenses.

Quand chaque modèle de tarification brille

- 💡 Usines à contenu à haut volume : des taux de sortie plus bas rendent OpenAI attractif pour les fermes de contenu et les workflows de newsletter.

- 📚 Répertoires de recherche : les grandes fenêtres aident le modèle de Google à conserver la continuité sur de longs inputs, réduisant les frais de segmentation.

- 🤝 Support client : un contrôle ton stable et un respect fiable des instructions améliorent la résolution au premier contact.

- 🧪 Prototypage : l’API qui génère le moins d’échecs d’appels ou de re-prompts gagne souvent en coût réel par solution.

- 📊 Gouvernance entreprise : des paliers mensuels prévisibles et une facturation consolidée l’emportent souvent sur de petites différences de tokens.

| Plan 💼 | Coût Google Gemini 3 💸 | Coût GPT‑5.1 💸 | Idéal pour ✅ |

|---|---|---|---|

| API (contexte moyen) | 2 $ entrée / 12 $ sortie par million | 1,25 $ entrée / 10 $ sortie par million | Équilibre R&D vs contenu |

| API (grand contexte) | 4 $ entrée / 18 $ sortie par million | Varie selon le palier | Documents longs, conformité |

| Consommateur | ~19,99 $/mois ; entreprise jusqu’à ~250 $ | ~20 $/mois et plus | Individus, équipes, opérations |

| Vue coût total | Plus avantageux pour longs inputs | Préférable pour sorties lourdes | Mathématiques spécifiques au workload |

Si les détails de tarification pour les utilisateurs finaux sont prioritaires, consultez la tarification ChatGPT en 2025 et croisez avec les modèles d’utilisation internes pour définir un plafond raisonnable.

La tarification n’est que la moitié de l’équation ; l’autre moitié est ce que ces tokens peuvent faire quand texte, images, code et planification se rencontrent.

Flux de travail multimodaux et études de cas long contexte qui soumettent les deux modèles à rude épreuve

La capacité multimodale sépare les assistants occasionnels des vrais copilotes en milieu professionnel. La sortie Google apporte une gestion unifiée du texte, des images et du code dans un seul flux, s’appuyant sur des expériences multimodales antérieures et poussant la continuité en avant. Pour des missions complexes — pensez schémas d’architecture, photos produits et scripts — la capacité à référencer des détails visuels tout en écrivant ou déboguant est un accélérateur. La dernière version d’OpenAI met l’accent sur la clarté compositionnelle dans le langage, mais des tests indépendants ont suggéré qu’elle reste derrière le stack Google en termes d’étendue de modalité et de raisonnement soutenu sur le long terme.

Reprenons Nimbus Labs. Leur playbook de lancement produit demandait : (a) analyser des captures d’écran de concurrents ; (b) rédiger une série de 12 emails de nurturing ; (c) produire des extraits SDK ; et (d) assembler un guide terrain de 40 pages. Avec le système Google, ils ont envoyé images annotées et blocs de texte dans une session continue. L’assistant a produit des exemples de code alignés sur les éléments UI visibles dans les captures d’écran — pas d’aller-retour pour clarifier les étiquettes. Avec OpenAI, l’équipe excellait à faire ressembler la séquence d’approche à un stratège humain, grâce à de meilleurs contrôles de ton et de verrouillage de persona. Le résultat : ils ont réparti les charges — synthèse visuelle + technique d’un côté, messagerie hautement personnalisée de l’autre.

Quand les documents dépassent les limites typiques, diviser le contenu en morceaux peut entraîner une perte de contexte. La longue portée de Google rend une « mémoire » continue plus réalisable, réduisant le risque de contradictions. Les utilisateurs OpenAI compensent souvent par des stratégies de récupération minutieuses et une discipline métadonnée. Si c’est votre voie, explorez les astuces du flux d’analyse de fichiers et intégrez un index vectoriel pour ancrer le système sur les sessions.

Pour couvrir plus de comparaisons, les acheteurs vérifient aussi les outils adjacents. Voir ChatGPT vs Perplexity AI pour les tâches recherche lourdes, ou consulter ChatGPT vs GitHub Copilot quand l’aide au codage est centrale.

Plans pour remporter la multimodalité

- 🖼️ Ancrez les visuels : assurez-vous que captures d’écran ou diagrammes ont des appels explicites ; le modèle Google aligne bien les sorties sur les éléments d’image.

- 🗂️ Gardez une source unique : chargez le contexte complet une fois, si possible ; les grandes fenêtres réduisent les erreurs de couture entre sessions.

- 🧩 Discipline de récupération : pour les fenêtres plus petites, investissez dans les embeddings et la récupération pour simuler la continuité.

- 🧪 Testez avec des actifs réels : les données factices cachent les cas marginaux ; vrais PDF et images exposent la vraie friction.

- 🧭 Assignez des rôles : orientez la synthèse visuelle-technique vers le leader multimodal ; orientez les copies empathiques vers le spécialiste conversationnel.

| Flux de travail 🧭 | Adéquation plus forte : Google 🌟 | Adéquation plus forte : OpenAI 🚀 | Raison 🔍 |

|---|---|---|---|

| Synthèse visuelle + texte | Oui | Situatif | Continuité multimodale sur longues durées |

| Approche persona-parfaite | Situatif | Oui | Contrôles tonaux précis et fidélité aux instructions |

| Grands dossiers de recherche | Oui | Situatif | Réduction du fractionnement ; moins de contradictions |

| Questions-réponses rapides | Situatif | Oui | Dialogue réactif et tours courts cohérents |

Pour une perspective de bout en bout sur l’évolution des outils GPT vers les assistants d’aujourd’hui, l’aperçu de l’évolution IA de ChatGPT est une lecture utile.

Après avoir cartographié les forces multimodales, la section suivante évalue la qualité du dialogue et le respect des instructions — essentiels pour les équipes qui vivent en chat toute la journée.

Respect des instructions, contrôles de ton et qualité conversationnelle en usage quotidien

La dernière version d’OpenAI privilégie le flux conversationnel. Deux modes ajustables — Instant et Thinking — permettent aux développeurs d’échanger rapidité contre réflexion sans prompts complexes. Il suit les instructions plus régulièrement et ajoute des commandes pour personnalité, politesse et formalité. Cette combinaison offre aux services d’assistance, équipes marketing et RH une « voix » fiable. Pour les équipes techniques, la constance réduit le retravail : moins de rappels pour rester concis, moins de dérive de style sur de longs fils, et des relais plus nets aux réviseurs humains.

La dernière version de Google mise sur le pragmatisme via la planification et la mémoire longue, mais son dialogue s’est aussi resserré par rapport aux modèles précédents. Lorsqu’on lui demande des sorties multi-étapes — comme un plan d’approche avec variantes par persona et étape — il tend à garder la structure intacte. Les différences apparaissent surtout dans les tâches sensibles au ton. Le stack OpenAI rend facile le réglage de la cordialité, de l’humour et des phrases spécifiques à la marque. Si le travail est de répondre à 300 emails clients nuancés par jour, cette constance s’accumule rapidement.

Parce que la maîtrise du prompt influence coût et qualité, il vaut la peine d’affiner la technique. Une excellente ressource est les stratégies d’optimisation des prompts couvrant balises de sécurité, tests de parité et bases déterministes. Pour les équipes opérations lançant des pilotes, le test pratique ChatGPT 2025 donne un aperçu concret des points forts du modèle. Et pour ceux qui distribuent l’accès globalement, surtout dans les marchés émergents, le guide sur l’accès gratuit à ChatGPT en Inde détaille les considérations régionales pour le déploiement.

Schémas pour des conversations de haute qualité

- 🧭 Définir une persona par défaut : verrouillez ton, concision et formatage dès le début de chaque session pour une qualité prévisible.

- ✍️ Utiliser des schémas de sortie : titres, listes à puces et JSON réduisent l’ambiguïté et améliorent la conformité aux instructions.

- 🧪 Lancer des scripts A/B : confrontez Instant vs Thinking ou prompts courts vs détaillés pour trouver le profil de réponse optimal.

- 📣 Boucles de feedback : capturez les corrections utilisateurs et réinjectez-les comme exemples de style pour minimiser la dérive future.

- 🔐 Balises de sécurité : définissez sujets tabous, règles d’escalade et tags de conformité pour protéger marque et utilisateurs.

| Contrôle 🎛️ | Force OpenAI 💬 | Force Google 🌐 | Impact pratique ✅ |

|---|---|---|---|

| Préréglages de ton | Granulaires et persistants | Améliorés, solides | Réponses cohérentes à la marque |

| Fidélité aux instructions | Élevée | Élevée, surtout pour les plans structurés | Moins de re-prompts |

| Vitesse vs profondeur | Basculant Instant/Thinking | Interrupteur Deep Think | Compromis adapté par tâche |

| Fils longs | Persona stable | Structure stable | Sessions multi-tours cohérentes |

Les équipes alignées sur la voix et la clarté gravitent probablement vers le système avec les contrôles de persona les plus intuitifs ; celles qui déploient des plans complexes penchent vers la rigueur structurelle du planificateur.

Benchmarks, classements et signaux de performance dans le monde réel auxquels vous pouvez faire confiance

Les benchmarks ne racontent qu’une partie de l’histoire, mais le tableau actuel est révélateur. Sur le classement communautaire LMArena, Gemini 3 détient un score élevé autour de 1324, devant Gemini 2.5 Pro autour de 1249. GPT‑5.1 (listé comme GPT‑5‑chat) est proche de 1222, aux côtés des générations OpenAI précédentes et autres modèles de pointe. Le message de milliers de votes est clair : la dernière entrée de Google fait sensation, tandis que la sortie d’OpenAI garde une position forte et respectée dans le haut du classement.

Les tests synthétiques confirment souvent cet écart. Les rapports ont noté l’avantage de Google en raisonnement étendu et en étendue multimodale, tandis que le modèle OpenAI excelle dans les sorties courtes cohérentes et l’obéissance aux instructions. Les défis de type Tom’s Guide axés sur le ton et la persona favorisent généralement OpenAI ; le raisonnement infusé d’image ou la synthèse long contexte favorisent le moteur de Google. Cela s’aligne sur le bruissement du marché plus large : ce qui semble « plus intelligent » dépend fortement de la mesure — dialogue émotionnellement ajusté ou cognition à long terme.

Pour élargir la perspective, des ressources comparatives comme OpenAI vs Anthropic et des vues historiques comme les résumés GPT‑4, Claude 2, et ère Llama aident à situer les concurrents d’aujourd’hui. Les lecteurs souhaitant un duel transversal peuvent aussi étudier Microsoft Copilot vs ChatGPT pour comprendre comment les choix de modèle influencent les expériences produit.

Ce que disent les classements — et ce qu’ils ne disent pas

- 🏁 Les leaderboards capturent le sentiment communautaire ; ils sont utiles, mais pas définitifs pour votre charge de travail unique.

- 🧪 Les tests en laboratoire soulignent les extrêmes ; la réalité de production mêle latence, balises de sécurité et contraintes des outils.

- 🧰 L’adéquation au stack compte : pipelines de données, récupération, et hygiène des prompts peuvent influencer davantage que le QI brut.

- 📐 Définissez tôt les métriques de succès : exactitude, temps pour rédiger, et charge de relecture doivent être mesurés par équipe.

- 🔄 Itérez : petites améliorations des prompts et workflows transforment souvent un « match nul » en gagnant clair pour votre organisation.

| Signal 📊 | Observation 🔎 | Implication 💡 | Gagnant aujourd’hui 🏆 |

|---|---|---|---|

| Score LMArena | 1324 vs ~1222 | La communauté favorise le modèle Google | Google 🌟 |

| Tâches long-contexte | Moins d’interruptions, continuité plus riche | Meilleure recherche et synthèse | Google 🌟 |

| Contrôle de persona | Ton et style plus fins | Chat cohérent avec la marque | OpenAI 🚀 |

| Écriture court format | Clair, direct, faible dérive | Cycles de relecture plus rapides | OpenAI 🚀 |

Pour un panorama plus large des choix du marché, explorez cette liste triée des meilleures IA d’écriture en 2025 pour voir où ces deux se situent parmi les outils spécialisés.

Les classements guident le regard ; les pilotes en conditions réelles révèlent la vérité importante pour votre équipe.

Expérience développeur, sécurité et écosystème : du premier prompt à la production

Lancement d’un assistant ne se limite pas à un texte intelligent. C’est aussi onboarding, limites de débit, observabilité et sécurité. L’expérience développeur d’OpenAI privilégie des démarrages rapides avec des préréglages de persona clairs, des balises de sécurité et des sorties structurées. Le stack Google met l’accent sur l’orchestration via Antigravity, encourageant les développeurs à concevoir des agents multi-étapes capables de planifier, appeler des outils, et garder l’état sur de longues sessions. Les deux chemins peuvent fonctionner ; le bon choix dépend si votre produit est un conversateur sympathique ou un planificateur autonome avec supervision.

Sur la sécurité, les deux fournisseurs continuent de renforcer les filtres et les voies d’escalade. Les équipes doivent définir ce qu’est le « bon » puis mettre en œuvre des contrôles mesurables : gestion des refus, catégories protégées, et pistes d’audit. Les responsables opérationnels maintiennent souvent un « jeu d’or » de prompts et sorties attendues pour les tests de régression. De plus, les plafonds d’usage nécessitent une attention ; si les pics de simultanéité comptent, consultez les limites et stratégies d’atténuation expliquées dans des guides communautaires comme les insights sur les limites. Pour ceux qui comparent les écosystèmes larges, un panorama comme la nouvelle intelligence de ChatGPT aide à saisir les évolutions impactant la feuille de route.

L’activation développeur inclut aussi documentation, SDKs et contenus tiers. Les tutoriels qui codifient cadres persona, modèles de récupération, et outils d’évaluation valent leur pesant en temps de disponibilité. Pensez à empaqueter des bibliothèques de prompts réutilisables et suites de tests pour éviter que chaque équipe ne réinvente la roue. Là où les copilotes de codage sont centraux, comparez avec les offres adjacentes et consultez les différences Microsoft Copilot vs ChatGPT dans l’expérience IDE pour anticiper les attentes développeur.

Du prototype à la production prête à l’emploi

- 🧱 Construisez un échantillon minimal : un bout en bout avec périmètre restreint, incluant journaux et évaluations, avant de monter en charge.

- 🛰️ Discipline d’appel d’outils : définissez les contrats pour fonctions ; validez entrées/sorties pour éviter les erreurs silencieuses.

- 🧭 Spécification persona : documentez ton, formatage, politique de refus, et déclencheurs d’escalade.

- 🧯 Exercices de sécurité : lancez des tests red-team trimestriels ; suivez les écarts suite aux mises à jour des bibliothèques et modèles.

- 📈 Observabilité : enregistrez dépenses de tokens, latence et exactitude pour détecter rapidement les régressions.

| Dimension 🧩 | Avantage OpenAI 💬 | Avantage Google 🌐 | Conseil pour développeurs 🛠️ |

|---|---|---|---|

| Démarrage rapide | Préréglages persona/ton | Armature agentique | Choisir selon premier jalon |

| Opérations sécurité | Modèles de refus mûrs | Balises robustes de planification | Aligner au profil risque |

| Usage des outils | Appels de fonctions propres | Orchestration multi-étapes | Cartographier selon complexité du workflow |

| Docs & écosystème | Modèles riches et exemples | Croissance des frameworks agents | Exploiter le code communautaire |

Si vous hésitez encore entre les deux, des méta-comparaisons comme ChatGPT vs Bard historique et des confrontations directes telles que Google Gemini vs ChatGPT guide révèlent des angles qu’on pourrait autrement manquer.

Choisissez la pile qui accélère votre prochaine sortie avec le moins de contournements ; la vélocité est le véritable fossé.

{« @context »: »https://schema.org », »@type »: »FAQPage », »mainEntity »:[{« @type »: »Question », »name »: »Which model is better for long research documents and mixed media? », »acceptedAnswer »:{« @type »: »Answer », »text »: »Googleu2019s latest model tends to win when large context windows and multimodal synthesis are vital. Teams can keep long PDFs, screenshots, and notes in one flow, reducing fragmentation and preserving accuracy across sections. »}},{« @type »: »Question », »name »: »Which model offers the strongest conversational control and tone consistency? », »acceptedAnswer »:{« @type »: »Answer », »text »: »OpenAIu2019s GPTu20115.1 stands out for instruction fidelity and persona controls. It keeps voice, formality, and structure consistent over many turns, which is ideal for support, marketing copy, and coaching assistants. »}},{« @type »: »Question », »name »: »How should teams decide based on cost? », »acceptedAnswer »:{« @type »: »Answer », »text »: »Model true cost by workload: if inputs dominate, long-context efficiency can justify Googleu2019s pricing; if outputs dominate, OpenAIu2019s rates may be preferable. Prompt optimization and retrieval design often save more than raw token deltas. »}},{« @type »: »Question », »name »: »Are there resources to compare and improve prompts? », »acceptedAnswer »:{« @type »: »Answer », »text »: »Yes. Start with prompt engineering guides such as prompt optimization strategies, plus hands-on reports like the ChatGPT 2025 review. These help teams reduce retries, improve accuracy, and keep tone on-brand. »}},{« @type »: »Question », »name »: »Where can I explore more head-to-head matchups? », »acceptedAnswer »:{« @type »: »Answer », »text »: »For broader context, read ChatGPT vs Gemini 2025, Google Gemini vs ChatGPT guides, and comparisons with Perplexity, Copilot, and others to understand fit by task and ecosystem. »}}]}Which model is better for long research documents and mixed media?

Google’s latest model tends to win when large context windows and multimodal synthesis are vital. Teams can keep long PDFs, screenshots, and notes in one flow, reducing fragmentation and preserving accuracy across sections.

Which model offers the strongest conversational control and tone consistency?

OpenAI’s GPT‑5.1 stands out for instruction fidelity and persona controls. It keeps voice, formality, and structure consistent over many turns, which is ideal for support, marketing copy, and coaching assistants.

How should teams decide based on cost?

Model true cost by workload: if inputs dominate, long-context efficiency can justify Google’s pricing; if outputs dominate, OpenAI’s rates may be preferable. Prompt optimization and retrieval design often save more than raw token deltas.

Are there resources to compare and improve prompts?

Yes. Start with prompt engineering guides such as prompt optimization strategies, plus hands-on reports like the ChatGPT 2025 review. These help teams reduce retries, improve accuracy, and keep tone on-brand.

Where can I explore more head-to-head matchups?

For broader context, read ChatGPT vs Gemini 2025, Google Gemini vs ChatGPT guides, and comparisons with Perplexity, Copilot, and others to understand fit by task and ecosystem.

-

Tech1 jour ago

Tech1 jour agoVotre carte ne prend pas en charge ce type d’achat : ce que cela signifie et comment le résoudre

-

Modèles d’IA1 jour ago

Modèles d’IA1 jour agoOpenAI vs Tsinghua : Choisir entre ChatGPT et ChatGLM pour vos besoins en IA en 2025

-

Internet19 heures ago

Internet19 heures agoExplorer le futur : Ce que vous devez savoir sur ChatGPT connecté à Internet en 2025

-

Modèles d’IA1 jour ago

Modèles d’IA1 jour agoChoisir votre compagnon de recherche en IA en 2025 : OpenAI vs. Phind

-

Tech8 heures ago

Tech8 heures agoComprendre le dur dégénéré : ce que cela signifie et pourquoi cela compte en 2025

-

Gaming14 heures ago

Gaming14 heures agoGratuit pour tous le combat nyt : stratégies pour maîtriser la bataille ultime