Uncategorized

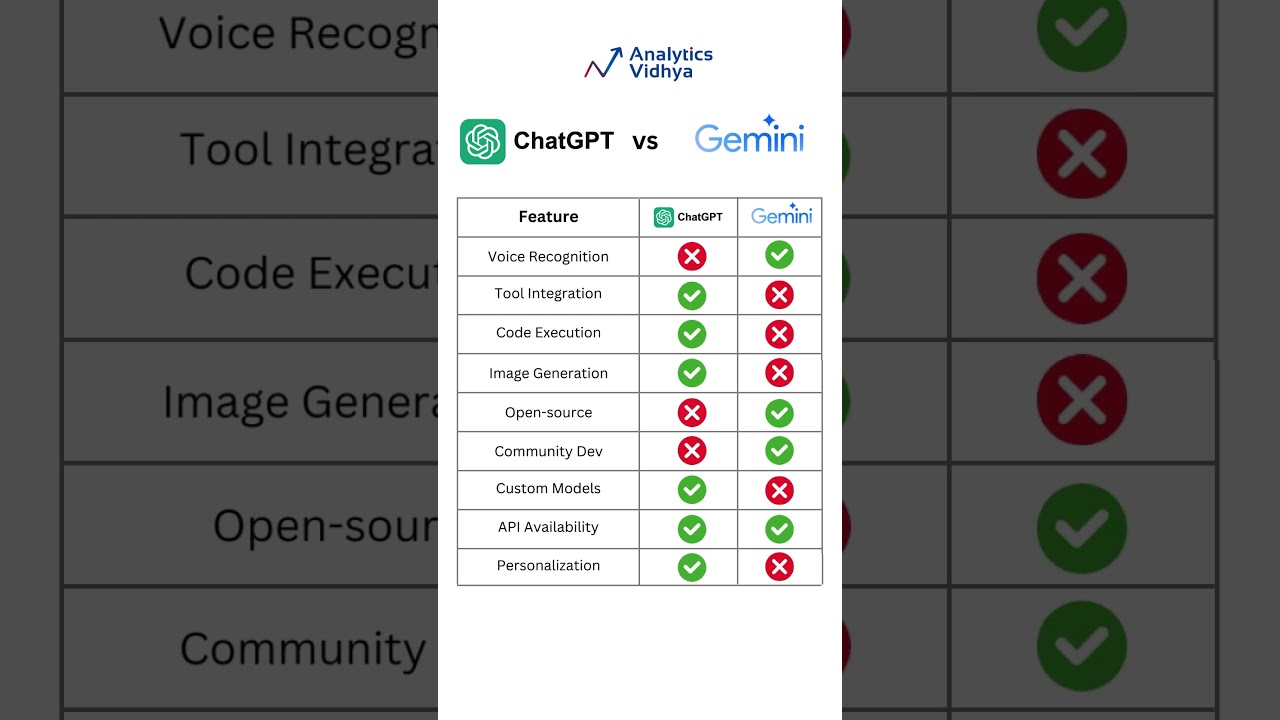

Google Gemini 3 vs ChatGPT: Uma Comparação Abrangente de Recursos e Desempenho

Gemini 3 vs ChatGPT 5.1: Arquitetura, Manuseio de Contexto e Capacidades Centrais de IA

Esta análise tecnológica foca em como Google Gemini 3 e ChatGPT (alimentado pelo GPT-5.1) diferem internamente, pois a arquitetura determina funcionalidades, desempenho e, em última análise, os resultados no mundo real. O Google posiciona seu lançamento mais recente como um sistema único, orientado a agentes, que funde percepção multimodal com planejamento de longo alcance. Herdando ideias agentivas de iterações anteriores, ele as eleva com uma abordagem consolidada de machine learning que mantém cadeias de raciocínio intactas em contextos muito grandes. Em contraste, a última versão da OpenAI prioriza um fluxo de diálogo polido, adesão mais firme a instruções e uma “profundidade de pensamento” dinâmica que varia conforme a complexidade da tarefa.

O tamanho do contexto é o coração pulsante do trabalho de longa duração. O modelo do Google se estende a janelas muito grandes — centenas de milhares de tokens — permitindo que resumos de pesquisa, digests de conformidade e montagens de roteiros cinematográficos permaneçam em uma única sessão sem fragmentação. Isso importa quando as equipes precisam de continuidade. Os modelos de linguagem da OpenAI são otimizados para agilidade e troca rápida de turnos; o processamento de linguagem natural parece fluido, e o sistema pode ser guiado com controles de tom e persona que fazem com que assistentes corporativos soem alinhados à marca por padrão.

O raciocínio é outra linha de falha. A adição do Google de um modo Deep Think aponta diretamente para lógica e planejamento em múltiplos passos. É o interruptor para o “modo difícil,” útil para estratégia, simulação e fusão complexa de dados. A OpenAI revida com dois modos — “Instant” e “Thinking” — que modulam a deliberação para trocar velocidade por profundidade quando necessário. Para muitas equipes, essa dualidade se traduz em menos acrobacias para obter o ritmo ou precisão desejados. Essa escolha ecoa uma comparação de IA mais ampla vista na indústria: uma pilha é construída para expansão e síntese, a outra para interação consistente e pessoal.

Para ancorar isso na realidade, considere a Nimbus Labs, uma fornecedora SaaS de médio porte construindo um copiloto de sucesso do cliente. O modelo deles exigia: (1) analisar longas transcrições de chamadas; (2) redigir acompanhamentos empáticos; e (3) gerar playbooks que mesclam texto, métricas e capturas de tela da interface. Com o sistema do Google, mantiveram vivo um histórico entre clientes de 180.000 tokens, permitindo que o bot recordasse casos de borda sem reenviar materiais. Com o sistema da OpenAI, eles ajustaram voz e temperatura para combinar com diretrizes da marca, assegurando que cada resposta soasse como um CSM experiente. O fator decisivo tornou-se se a continuidade em extensão extrema superava a finesse conversacional na abordagem diária.

Além do diálogo e contexto, a plataforma desenvolvedora Antigravity da pilha Google merece menção. Ela enfatiza ferramentas agentivas, orquestração e fluxos de trabalho fortemente baseados em planejamento. O lado da OpenAI avança em confiabilidade na conformidade instrucional e permite que equipes fixem presets de persona ao longo dos tópicos, minimizando a deriva de estilo durante uso prolongado. Cada direção representa uma filosofia: construir um agente cognitivo tudo-em-um, ou aprimorar o melhor colaborador do mundo.

Para leitores buscando comparações além desses dois, recursos como Guia Google Gemini vs ChatGPT e uma visão equilibrada ChatGPT vs Gemini 2025 ajudam a enquadrar pontos fortes sem spin de marketing. Em um campo saturado, a perspectiva importa.

Principais diferenças que moldam os resultados

- 🧠 Raciocínio profundo vs diálogo ágil: Deep Think prioriza planejamento; os modos duais da OpenAI equilibram velocidade e profundidade.

- 🧾 Compromissos de comprimento do contexto: janelas extremas servem a relatórios de pesquisa; contextos compactos e responsivos favorecem tarefas de atendimento ao cliente.

- 🖼️ Fluência multimodal: o modelo Google mescla texto, imagens e código em um único fluxo; a OpenAI foca no controle conversacional impecável.

- 🛠️ Experiência do construtor: Antigravity habilita orquestração agentiva; OpenAI simplifica tom, persona e fidelidade à instrução.

- 📈 Ajuste para empresas: motores de planejamento prosperam em P&D; motores conversacionais brilham em suporte, marketing e vendas.

| Aspecto ⚙️ | Destaque Gemini 3 🌐 | Destaque GPT‑5.1 💬 |

|---|---|---|

| Raciocínio | Deep Think para planos multi-etapas | Modos Instant/Thinking para profundidade adaptativa |

| Janela de Contexto | Muito grande, continuidade de longo alcance | Otimizado para turnos rápidos e coerentes |

| Modalidade | Texto + imagens + código integrados | Polimento texto-primário com ferramentas fortes |

| Ferramentas do Construtor | Plataforma agentiva Antigravity | Presets de persona e tom |

| Ajuste ao Caso de Uso | Pesquisa, planos, síntese técnica | Suporte, copy, ajuda interativa |

Conclusão: arquitetura é vantagem — decida se a síntese de longo contexto ou a precisão conversacional movem mais o ponteiro para seu roadmap.

A próxima seção aborda economia, porque uma ótima arquitetura só funciona se a matemática também funcionar.

Precificação, Economia de Tokens e Valor para Construtores e Equipes

Para muitos tomadores de decisão, custo-benefício é decisivo. A API GPT‑5.1 da OpenAI custa cerca de $1,25 por 1M de tokens de entrada e $10 por 1M de tokens de saída. O carro-chefe do Google custa cerca de $2 entrada / $12 saída por 1M de tokens para contextos de médio porte (aproximadamente até 200k tokens), com níveis maiores por volta de $4 / $18 para janelas muito maiores. Nos planos para consumidores, o Google oferece um nível Pro em torno de $19,99/mês e um nível Enterprise com preços personalizados — amplamente reportados em até ~$250/mês para recursos completos. O pacote consumidor da OpenAI normalmente começa em $20/mês, com maiores limites e recursos acima dessa faixa.

A matemática dos tokens muda a estratégia. Uma equipe de marketing que gera 40 páginas de destino pode se importar mais com o preço de saída; um analista que ingere PDFs de auditoria prioriza custos de entrada. Por isso, o vencedor não é universal. Alguns compradores modelam cargas de trabalho semanalmente e escolhem o provedor com base na divisão esperada entre leitura e escrita. Outros otimizam para ergonomia do desenvolvedor — se uma API reduz chamadas desperdiçadas por meio de melhor adesão a instruções, pode economizar mais do que um preço mais barato sugere.

Detalhes de integração também importam. Equipes que precisam centralizar segredos podem dominar a configuração da chave API do ChatGPT para acelerar a integração. Enquanto isso, quem planeja grandes corpora de conhecimento deve explorar estratégias de alteração da janela de contexto em suas ferramentas para evitar estouros de tokens. E quando cada prompt é uma decisão orçamentária, estratégias de otimização de prompt reduzem repetições e cortam gastos significativamente.

Quando cada modelo de precificação brilha

- 💡 Fábricas de cópia de alta produção: taxas mais baixas na saída tornam OpenAI atraente para produtores de conteúdo e fluxos de newsletters.

- 📚 Repositórios de pesquisa: janelas maiores ajudam o modelo do Google a manter continuidade em entradas extensas, reduzindo custos de fragmentação.

- 🤝 Suporte ao cliente: controles de tom consistentes e adesão confiável a instruções melhoram resolução no primeiro contato.

- 🧪 Prototipagem: seja qual for a API que renderiza menos chamadas falhadas ou re-prompts geralmente vence em custo real por solução.

- 📊 Governança empresarial: níveis mensais previsíveis e faturamento consolidado geralmente superam pequenas diferenças de tokens.

| Plano 💼 | Custo Google Gemini 3 💸 | Custo GPT‑5.1 💸 | Melhor Para ✅ |

|---|---|---|---|

| API (contexto médio) | $2 entrada / $12 saída por 1M | $1,25 entrada / $10 saída por 1M | Equilíbrio P&D vs conteúdo |

| API (contexto grande) | $4 entrada / $18 saída por 1M | Varia por nível | Documentos longos, conformidade |

| Consumidor | ~$19,99/mês; enterprise até ~$250 | ~$20/mês ou mais | Indivíduos, equipes, operações |

| Visão Total de Custos | Mais forte em entradas longas | Favorável para saídas pesadas | Matemática para cargas específicas |

Se detalhes de precificação para usuários finais forem prioridade, veja Precificação do ChatGPT em 2025 e compare internamente com modelos de uso para estabelecer um teto sensato.

Precificação é apenas metade da equação; a outra metade é o que esses tokens podem fazer quando texto encontra imagens, código e planejamento.

Fluxos de Trabalho Multimodais e Casos de Uso com Longo Contexto que Testam Ambos os Modelos

A capacidade multimodal separa assistentes casuais de verdadeiros copilotos de trabalho. O lançamento do Google traz manuseio unificado de texto, imagens e código em um único fluxo, ampliando experimentos multimodais anteriores e avançando continuidade. Para tarefas complexas — pense em diagramas arquitetônicos, fotos de produtos e roteiros — a habilidade de referenciar detalhes visuais enquanto escreve ou depura é um acelerador. A última versão da OpenAI enfatiza clareza composicional na linguagem, mas testes independentes sugerem que fica atrás da pilha do Google em amplitude de modalidade e raciocínio sustentável de longa duração.

Volte à Nimbus Labs. O playbook de lançamento do produto exigia: (a) analisar capturas de tela de concorrentes; (b) redigir uma série nurture de 12 e-mails; (c) produzir trechos de SDK; e (d) montar um guia de campo de 40 páginas. Com o sistema do Google, enviaram imagens anotadas e blocos de texto em uma sessão contínua. O assistente produziu amostras de código alinhadas a elementos da interface visíveis nas capturas — sem necessidade de idas e vindas para reesclarecer rótulos. Com a OpenAI, a equipe se destacou em fazer a sequência de alcance soar como um estrategista humano, graças a controles de tom e bloqueio de persona mais fortes. O resultado: dividiram cargas — síntese visual + técnica de um lado, mensagens de alto contato do outro.

Quando documentos excedem limites típicos, dividir conteúdo em pedaços pode causar perda de contexto. A longa extensão do Google torna uma “memória” contínua viável, reduzindo o risco de contradições. Usuários da OpenAI frequentemente compensam com estratégias cuidadosas de recuperação e disciplina de metadados. Se esse for seu caminho, explore dicas de fluxo de análise de arquivos e integre um índice vetorial para manter o sistema fundamentado entre sessões.

Para ampliar comparações, compradores também conferem ferramentas adjacentes. Veja ChatGPT vs Perplexity AI para tarefas pesadas em pesquisa, ou revise ChatGPT vs GitHub Copilot quando assistência em programação é central para a decisão.

Modelos para vitórias multimodais

- 🖼️ Ancore visuais: assegure que capturas ou diagramas tenham destaques explícitos; o modelo do Google alinha saídas bem a elementos na imagem.

- 🗂️ Mantenha uma fonte única: quando possível, carregue o contexto completo uma vez; janelas enormes reduzem erros de costura de sessão.

- 🧩 Disciplina de recuperação: para janelas menores, invista em embeddings e recuperação para simular continuidade.

- 🧪 Teste com ativos reais: dados simulados escondem casos de borda; PDFs e imagens reais expõem o verdadeiro atrito.

- 🧭 Atribua papéis: encaminhe síntese visual-técnica para o líder multimodal; encaminhe copy empático para o especialista em conversação.

| Fluxo de Trabalho 🧭 | Ajuste Mais Forte: Google 🌟 | Ajuste Mais Forte: OpenAI 🚀 | Razão 🔍 |

|---|---|---|---|

| Síntese visual + texto | Sim | Situacional | Continuidade multimodal em longas extensões |

| Abordagem com persona perfeita | Situacional | Sim | Controles finos de tom e fidelidade à instrução |

| Grandes dossiês de pesquisa | Sim | Situacional | Redução de fragmentações; menos contradições |

| Perguntas e respostas rápidas | Situacional | Sim | Diálogo responsivo e turnos curtos coerentes |

Para uma perspectiva de ponta a ponta sobre como as ferramentas baseadas em GPT evoluíram até os assistentes de hoje, o panorama da evolução da IA do ChatGPT é uma leitura complementar útil.

Tendo mapeado forças multimodais, a próxima seção avalia qualidade da conversa e aderência a instruções — crítico para equipes que vivem em chat o dia todo.

Aderência a Instruções, Controles de Tom e Qualidade Conversacional no Uso Diário

A última versão da OpenAI prioriza fluxo de conversa. Dois modos ajustáveis — Instant e Thinking — permitem que construtores troquem velocidade por deliberação sem prompts elaborados. Segue instruções com mais consistência e adiciona controles para personalidade, polidez e formalidade. Essa combinação dá a help desks, equipes de marketing e RH uma “voz” confiável. Para equipes técnicas, a consistência reduz retrabalho: menos lembretes para manter concisão, menos deriva de estilo em longas sessões e repasses mais limpos para revisores humanos.

O último lançamento do Google foca em pragmatismo via planejamento e memória longa, porém seu diálogo também se tornou mais enxuto em comparação a modelos anteriores. Quando solicitado a entregar saídas multi-etapas — como um plano de alcance com variações de mensagem por persona e estágio — tende a manter a estrutura intacta. As diferenças aparecem mais em tarefas sensíveis ao tom. A pilha da OpenAI torna agradável e fácil configurar simpatia, humor e frases específicas da marca. Se o trabalho é responder 300 e-mails complexos de clientes por dia, essa consistência se multiplica rapidamente.

Como o trabalho com prompts influencia custo e qualidade, vale a pena lapidar a técnica. Um recurso excelente é o guia de estratégias de otimização de prompt que cobre diretrizes, testes de paridade e bases determinísticas. Para equipes de operações lançando pilotos, a análise prática do ChatGPT 2025 oferece uma sensação prática de onde o modelo brilha. E para quem distribui acesso globalmente, especialmente em mercados em crescimento, o manual sobre acesso gratuito ao ChatGPT na Índia delineia considerações regionais para implantação.

Padrões para conversas de alta qualidade

- 🧭 Defina uma persona padrão: bloqueie tom, brevidade e formatação no início de cada sessão para qualidade previsível.

- ✍️ Use esquemas de saída: títulos, marcadores e JSON reduzem ambiguidade e melhoram aderência às instruções.

- 🧪 Rode roteiros A/B: compare Instant vs Thinking ou prompts curtos vs detalhados para encontrar o padrão ideal de resposta.

- 📣 Ciclos de feedback: capture correções dos usuários e reinjete como exemplos de estilo para minimizar deriva futura.

- 🔐 Diretrizes: defina tópicos tabus, regras de escalonamento e tags de conformidade para proteger marca e usuários.

| Controle 🎛️ | Força OpenAI 💬 | Força Google 🌐 | Impacto Prático ✅ |

|---|---|---|---|

| Presets de tom | Granulares e persistentes | Melhorados, sólidos | Respostas alinhadas à marca |

| Fidelidade à instrução | Alta | Alta, especialmente para planos estruturados | Menos re-prompts |

| Velocidade vs profundidade | Toggle Instant/Thinking | Interruptor Deep Think | Trade-off certo por tarefa |

| Tópicos longos | Persona estável | Estrutura estável | Sessões multitransação coerentes |

Equipes alinhadas em voz e clareza provavelmente gravitarão para o sistema com os controles de persona mais intuitivos; aquelas que entregam planos complexos podem se inclinar para a disciplina estrutural do planejador.

Benchmarks, Rankings e Sinais de Desempenho no Mundo Real que Você Pode Confiar

Benchmarks contam apenas parte da história, mas o placar atual é revelador. No gráfico comunitário do LMArena, Gemini 3 mantém uma pontuação alta próxima de 1324, à frente do Gemini 2.5 Pro por volta de 1249. GPT‑5.1 (listado como GPT‑5‑chat) está próximo de 1222, junto a gerações anteriores da OpenAI e outros modelos de ponta. A mensagem de milhares de votos é clara: a entrada mais recente do Google tem força, enquanto o lançamento da OpenAI mantém uma posição forte e respeitada no topo.

Testes sintéticos frequentemente reforçam essa disparidade. Relatórios destacam a vantagem do Google em raciocínio prolongado e amplitude multimodal, enquanto o modelo da OpenAI se destaca em saídas coerentes de curta duração e obediência a instruções. Desafios no estilo Tom’s Guide, focados em tom e persona, geralmente favorecem OpenAI; raciocínio com imagens ou síntese de longo contexto favorecem o motor do Google. Isso se alinha ao discurso de mercado mais amplo: o que parece “mais inteligente” depende fortemente da régua — diálogo emocionalmente sintonizado ou cognição de longo alcance.

Para ampliar a lente, recursos comparativos como comparação OpenAI vs Anthropic e panoramas históricos como resumos GPT‑4, Claude 2 e era Llama ajudam a contextualizar os concorrentes atuais. Leitores buscando confronto entre fornecedores também podem estudar Microsoft Copilot vs ChatGPT para entender como escolhas de modelo reverberam na experiência do produto.

O que os rankings dizem — e o que não dizem

- 🏁 Rankings capturam sentimento comunitário; são úteis, mas não definitivos para sua carga de trabalho única.

- 🧪 Testes de laboratório destacam extremos; a realidade de produção mistura latência, diretrizes e limitações de ferramentas.

- 🧰 Ajuste da pilha importa: pipelines de dados, recuperação e higiene de prompt podem influenciar mais que o QI bruto.

- 📐 Defina métricas de sucesso cedo: precisão, tempo para rascunho e carga de revisão devem ser medidos por equipe.

- 🔄 Itere: pequenos ajustes em prompts e fluxos muitas vezes transformam “empate” em um vencedor claro para sua organização.

| Sinal 📊 | Observação 🔎 | Implicação 💡 | Vencedor Hoje 🏆 |

|---|---|---|---|

| Pontuação LMArena | 1324 vs ~1222 na faixa | Comunidade favorece o modelo do Google | Google 🌟 |

| Tarefas de longo contexto | Menos pausas, continuidade mais rica | Melhor para pesquisa e síntese | Google 🌟 |

| Controle de persona | Tom e estilo mais refinados | Bate-papo alinhado à marca | OpenAI 🚀 |

| Escrita de curto prazo | Limpo, direto, pouca deriva | Ciclos de revisão mais rápidos | OpenAI 🚀 |

Para um resumo mais amplo das escolhas de mercado, explore esta lista curada de principais IAs de escrita em 2025 para ver onde estes dois se situam entre ferramentas especializadas.

Rankings guiam o olhar; pilotos reais revelam a verdade que importa para sua equipe.

Experiência do Desenvolvedor, Segurança e Ecossistema: Do Primeiro Prompt à Produção

Enviar um assistente é mais que texto inteligente. É integração, limites de taxa, observabilidade e segurança. A experiência do desenvolvedor da OpenAI enfatiza inícios rápidos com presets claros de persona, diretrizes e saídas estruturadas. A pilha do Google enfatiza orquestração via Antigravity, encorajando construtores a projetar agentes multi-etapas que possam planejar, chamar ferramentas e manter estado em sessões longas. Ambos os caminhos funcionam; a escolha certa depende se seu produto é um conversador pessoal ou um planejador autônomo com supervisão.

Sobre segurança, ambos os fornecedores continuam a endurecer filtros e caminhos de escalonamento. Equipes devem definir o que “bom” significa, então implementar verificações mensuráveis: manejo de recusas, categorias protegidas e trilhas de auditoria. Líderes de operações costumam manter um “conjunto dourado” de prompts e saídas esperadas para testes de regressão. Além disso, limites de uso requerem atenção; se picos de simultaneidade importam, reveja limites práticos e estratégias de mitigação explicadas em guias comunitários como insights de limites de taxa. Para quem compara ecossistemas amplos, um panorama como a nova inteligência do ChatGPT ajuda a capturar mudanças de capacidade que afetam planejamento de roadmap.

Ativação de desenvolvedores também inclui documentação, SDKs e conteúdo de terceiros. Tutoriais que codificam frameworks de persona, padrões de recuperação e ferramentas de avaliação valem ouro em uptime. Considere empacotar bibliotecas reutilizáveis de prompt e suítes de teste para evitar reinventar a roda em cada equipe. Onde copilotos de código são centrais, faça benchmarks contra ofertas adjacentes e veja nuances em Microsoft Copilot vs ChatGPT na experiência em IDE para antecipar expectativas do desenvolvedor.

Do protótipo à prontidão para produção

- 🧱 Construa um slice fino: ponta a ponta com escopo mínimo, incluindo registro e avaliações, antes de escalar.

- 🛰️ Disciplina no uso de chamadas de ferramenta: defina contratos para funções; valide entradas/saídas para evitar falhas silenciosas.

- 🧭 Especificação de persona: documente tom, formatação, política de recusas e gatilhos de escalonamento.

- 🧯 Exercícios de segurança: realize prompts red-team trimestrais; acompanhe deltas durante atualizações de biblioteca e modelo.

- 📈 Observabilidade: registre gasto de tokens, latência e precisão para detectar regressões cedo.

| Dimensão 🧩 | Vantagem OpenAI 💬 | Vantagem Google 🌐 | Resumo para Construtor 🛠️ |

|---|---|---|---|

| Início rápido | Presets de persona/tom | Estruturas agentivas | Escolha com base no primeiro marco |

| Operações de segurança | Padrões maduros de recusa | Diretrizes robustas para planejamento | Alinhe ao perfil de risco |

| Uso de ferramentas | Chamada limpa de funções | Orquestração multi-etapas | Mapeie para complexidade do fluxo |

| Documentação e ecossistema | Padrões e exemplos ricos | Frameworks agentivos em crescimento | Aproveite código comunitário |

Se você ainda está avaliando os dois, meta-comparações como Histórico ChatGPT vs Bard e confrontos diretos de fornecedores como Guia Google Gemini vs ChatGPT revelam ângulos que poderiam passar despercebidos.

Escolha a pilha que acelere seu próximo lançamento com o menor número de soluções paliativas; velocidade é o verdadeiro fosso competitivo.

{“@context”:”https://schema.org”,”@type”:”FAQPage”,”mainEntity”:[{“@type”:”Question”,”name”:”Which model is better for long research documents and mixed media?”,”acceptedAnswer”:{“@type”:”Answer”,”text”:”Googleu2019s latest model tends to win when large context windows and multimodal synthesis are vital. Teams can keep long PDFs, screenshots, and notes in one flow, reducing fragmentation and preserving accuracy across sections.”}},{“@type”:”Question”,”name”:”Which model offers the strongest conversational control and tone consistency?”,”acceptedAnswer”:{“@type”:”Answer”,”text”:”OpenAIu2019s GPTu20115.1 stands out for instruction fidelity and persona controls. It keeps voice, formality, and structure consistent over many turns, which is ideal for support, marketing copy, and coaching assistants.”}},{“@type”:”Question”,”name”:”How should teams decide based on cost?”,”acceptedAnswer”:{“@type”:”Answer”,”text”:”Model true cost by workload: if inputs dominate, long-context efficiency can justify Googleu2019s pricing; if outputs dominate, OpenAIu2019s rates may be preferable. Prompt optimization and retrieval design often save more than raw token deltas.”}},{“@type”:”Question”,”name”:”Are there resources to compare and improve prompts?”,”acceptedAnswer”:{“@type”:”Answer”,”text”:”Yes. Start with prompt engineering guides such as prompt optimization strategies, plus hands-on reports like the ChatGPT 2025 review. These help teams reduce retries, improve accuracy, and keep tone on-brand.”}},{“@type”:”Question”,”name”:”Where can I explore more head-to-head matchups?”,”acceptedAnswer”:{“@type”:”Answer”,”text”:”For broader context, read ChatGPT vs Gemini 2025, Google Gemini vs ChatGPT guides, and comparisons with Perplexity, Copilot, and others to understand fit by task and ecosystem.”}}]}Which model is better for long research documents and mixed media?

Google’s latest model tends to win when large context windows and multimodal synthesis are vital. Teams can keep long PDFs, screenshots, and notes in one flow, reducing fragmentation and preserving accuracy across sections.

Which model offers the strongest conversational control and tone consistency?

OpenAI’s GPT‑5.1 stands out for instruction fidelity and persona controls. It keeps voice, formality, and structure consistent over many turns, which is ideal for support, marketing copy, and coaching assistants.

How should teams decide based on cost?

Model true cost by workload: if inputs dominate, long-context efficiency can justify Google’s pricing; if outputs dominate, OpenAI’s rates may be preferable. Prompt optimization and retrieval design often save more than raw token deltas.

Are there resources to compare and improve prompts?

Yes. Start with prompt engineering guides such as prompt optimization strategies, plus hands-on reports like the ChatGPT 2025 review. These help teams reduce retries, improve accuracy, and keep tone on-brand.

Where can I explore more head-to-head matchups?

For broader context, read ChatGPT vs Gemini 2025, Google Gemini vs ChatGPT guides, and comparisons with Perplexity, Copilot, and others to understand fit by task and ecosystem.

-

Tecnologia1 day ago

Tecnologia1 day agoSeu cartão não suporta este tipo de compra: o que significa e como resolver

-

Modelos de IA1 day ago

Modelos de IA1 day agoOpenAI vs Tsinghua: Escolhendo Entre ChatGPT e ChatGLM para Suas Necessidades de IA em 2025

-

Internet23 hours ago

Internet23 hours agoExplorando o Futuro: O Que Você Precisa Saber Sobre o ChatGPT com Internet em 2025

-

Tecnologia2 hours ago

Tecnologia2 hours ago0 é considerado um número racional? explicado de forma simples

-

Modelos de IA1 day ago

Modelos de IA1 day agoEscolhendo Seu Companheiro de Pesquisa em IA em 2025: OpenAI vs. Phind

-

Tecnologia11 hours ago

Tecnologia11 hours agoCompreendendo hard degenerate: o que significa e por que importa em 2025