Gemini 3 vs ChatGPT 5.1: Architettura, Gestione del Contesto e Capacità Core dell’IA

Questa recensione tecnologica si concentra su come Google Gemini 3 e ChatGPT (alimentato da GPT-5.1) differiscano “sotto il cofano”, perché è l’architettura a guidare funzionalità, prestazioni e, infine, risultati concreti nel mondo reale. Google presenta la sua ultima versione come un sistema unico, orientato agli agenti, che fonde percezione multimodale con pianificazione a lungo termine. Eredita idee agentiche dalle iterazioni precedenti e le eleva con un approccio consolidato al machine learning che mantiene intatte le catene di ragionamento su contesti molto ampi. Al contrario, l’ultima versione di OpenAI dà priorità a un flusso di dialogo raffinato, a un miglior rispetto delle istruzioni e a una profondità di “pensiero” dinamica che varia in base alla complessità del compito.

La dimensione del contesto è il cuore pulsante del lavoro a lungo termine. Il modello Google si estende a finestre molto grandi—centinaia di migliaia di token—così i sommari di ricerca, i digest di conformità e le composizioni di sceneggiature cinematografiche possono rimanere in una singola sessione senza frammentazione. Questo è importante quando i team necessitano di continuità. I modelli linguistici di OpenAI sono ottimizzati per agilità e rapide interazioni; il natural language processing risulta fluido e il sistema può essere guidato con controlli di tono e personalità che fanno sembrare gli assistenti aziendali aderenti al brand di default.

Il ragionamento è un’altra linea di frattura. L’aggiunta di Google di una modalità Deep Think punta direttamente alla logica e alla pianificazione multi-step. È l’interruttore per la “modalità difficile”, utile per strategia, simulazione e fusione complessa di dati. OpenAI risponde con due modalità—“Instant” e “Thinking”—che modulano la deliberazione per bilanciare velocità e profondità quando necessario. Per molti team, questa dualità si traduce in meno acrobazie nei prompt per ottenere il ritmo o la precisione desiderati. La scelta riflette una più ampia comparazione di IA vista nell’industria: uno stack è costruito per espansione e sintesi, l’altro per un’interazione costante e amichevole.

Per ancorare questo alla realtà, considerate Nimbus Labs, un fornitore SaaS di mercato medio che sviluppa un copilota per il successo del cliente. Il loro schema richiedeva: (1) l’analisi di lunghe trascrizioni di chiamate; (2) la redazione di follow-up empatici; e (3) la generazione di playbook che combinano testo, metriche e screenshot dell’interfaccia utente. Con il sistema Google, hanno mantenuto 180.000 token di storia incrociata tra clienti vivi, permettendo al bot di ricordare casi limite di nicchia senza ricaricare materiali. Con il sistema OpenAI, hanno regolato voce e temperatura per rispecchiare le linee guida del brand, assicurando che ogni risposta suonasse come quella di un CSM esperto. Il fattore decisivo è stato se la continuità su lunghezze estreme superasse la raffinatezza conversazionale nelle attività quotidiane.

Oltre al dialogo e al contesto, la piattaforma per sviluppatori Antigravity dello stack Google merita una menzione. Essa enfatizza strumenti agentici, orchestrazione e flussi di lavoro orientati alla pianificazione. Il lato OpenAI avanza nell’affidabilità nel rispetto delle istruzioni e permette ai team di bloccare preset di personalità nelle conversazioni, così il drift stilistico è minimo durante l’uso prolungato. Ogni direzione rappresenta una filosofia: costruire un agente cognitivo tutto-in-uno, oppure affinare il miglior collaboratore al mondo.

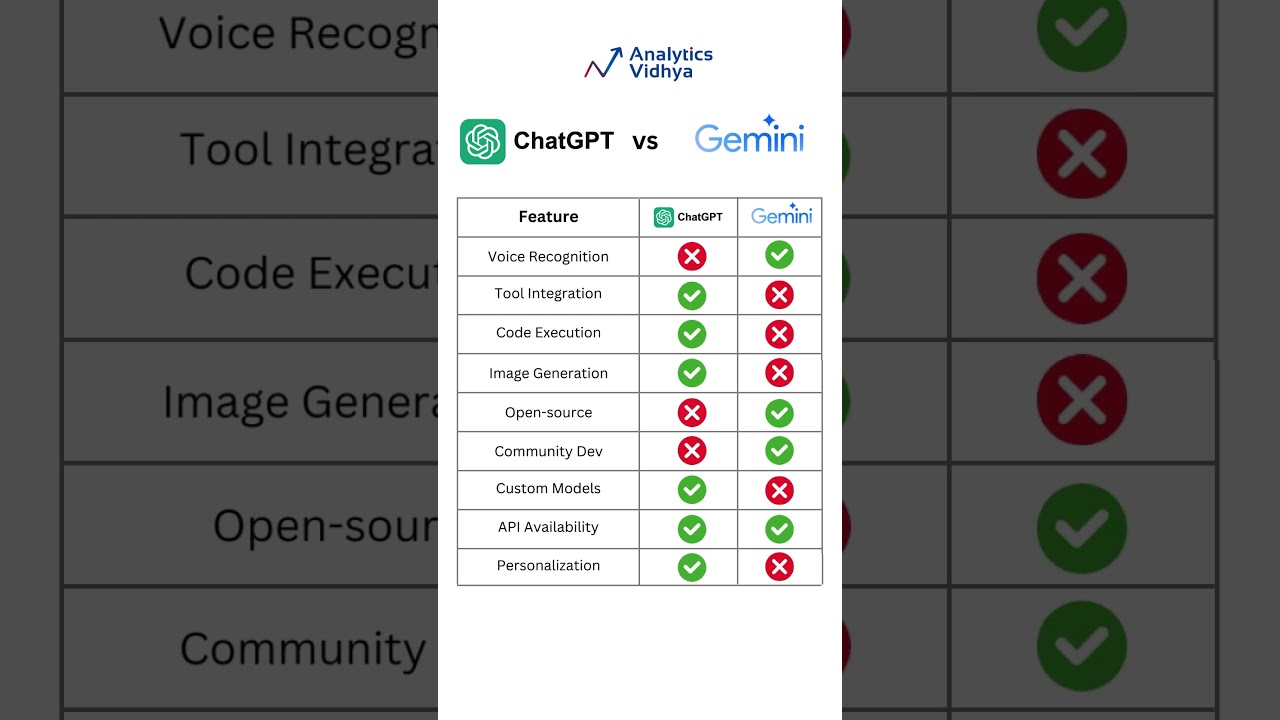

Per i lettori che cercano ulteriori confronti oltre questi due, risorse come la guida Google Gemini vs ChatGPT e una panoramica equilibrata ChatGPT vs Gemini 2025 aiutano a incorniciare i punti di forza senza spin di marketing. In un campo affollato, la prospettiva conta.

Differenze chiave che plasmano i risultati

- 🧠 Ragionamento profondo vs dialogo agile: Deep Think dà priorità alla pianificazione; le due modalità di OpenAI bilanciano velocità e profondità.

- 🧾 Compromessi sulla lunghezza del contesto: finestre estreme adatte per rapporti di ricerca; contesti compatti e reattivi preferibili nelle attività a contatto con il cliente.

- 🖼️ Fluidità multimodale: il modello Google fonde testo, immagini e codice in un unico flusso; OpenAI si concentra su un controllo conversazionale impeccabile.

- 🛠️ Esperienza da costruttore: Antigravity consente l’orchestrazione agentica; OpenAI semplifica tono, personalità e fedeltà alle istruzioni.

- 📈 Adattamento aziendale: i motori di pianificazione prosperano in R&S; i motori conversazionali brillano in supporto, marketing e vendite.

| Aspetto ⚙️ | Punto di Forza Gemini 3 🌐 | Punto di Forza GPT‑5.1 💬 |

|---|---|---|

| Ragionamento | Deep Think per piani multi-step | Modalità Instant/Thinking per profondità adattativa |

| Finestra di Contesto | Molto ampia, continuità a lungo termine | Ottimizzata per turni rapidi e coerenti |

| Modalità | Testo + immagini + codice integrati | Polish testuale con strumenti avanzati |

| Strumenti per Costruttori | Piattaforma agentica Antigravity | Preset di personalità e tono |

| Adattamento per Caso d’Uso | Ricerca, piani, sintesi tecnica | Supporto, copy, aiuto interattivo |

In sintesi: architettura equivale a vantaggio—decidete se la sintesi a lungo contesto o la precisione conversazionale spostano maggiormente l’ago per la vostra roadmap.

La sezione successiva si concentra sull’economia, perché una grande architettura funziona solo se anche i numeri tornano.

Prezzi, Economia dei Token e Valore per Costruttori e Team

Per molti decisori, il rapporto prezzo-prestazioni è determinante. L’API GPT‑5.1 di OpenAI ha un costo vicino a $1,25 per 1M di token in ingresso e $10 per 1M di token in uscita. Il prodotto di punta di Google si assesta intorno a $2 in ingresso / $12 in uscita per 1M di token per contesti di media dimensione (circa fino a 200k token), con fasce più alte intorno a $4 / $18 per finestre molto più ampie. Nei piani consumer, Google offre un livello Pro intorno a $19,99/mese e un livello Enterprise con prezzi personalizzati—ampiamente riportato fino a ~$250/mese per tutte le capacità. Il pacchetto consumer di OpenAI in genere parte da circa $20/mese, con maggiori allocazioni e funzionalità oltre questa soglia.

I calcoli sui token cambiano la strategia. Un team marketing che genera 40 landing page potrebbe curarsi maggiormente del prezzo in uscita; un analista che ingerisce PDF di audit dà priorità ai costi in ingresso. Per questo il vincitore non è universale. Alcuni acquirenti modellano i carichi di lavoro settimanalmente e scelgono un fornitore basandosi sulla divisione attesa tra lettura e scrittura. Altri ottimizzano per l’ergonomia degli sviluppatori—se un’API riduce le chiamate inutili grazie a un più forte rispetto delle istruzioni, può risparmiare più di quanto suggerisca un prezzo base inferiore.

I dettagli dell’integrazione contano anche. I team che devono centralizzare segreti possono gestire la configurazione della chiave API ChatGPT per accelerare l’onboarding. Nel frattempo, chi pianifica grandi archivi di conoscenza dovrebbe esplorare strategie per modificare la finestra di contesto nel proprio tooling per evitare esplosioni di token. E quando ogni prompt è una decisione di budget, strategie di ottimizzazione dei prompt riducono i tentativi e tagliano significativamente la spesa.

Quando ogni modello di prezzo brilla

- 💡 Fabbriche di contenuti ad alto output: tariffe più basse in output rendono OpenAI attraente per content mill e flussi newsletter.

- 📚 Archivi di ricerca: finestre ampie aiutano il modello Google a mantenere continuità su input lunghi, riducendo la segmentazione.

- 🤝 Supporto clienti: controlli di tono consistenti e rispetto affidabile delle istruzioni migliorano la risoluzione al primo contatto.

- 🧪 Prototipazione: l’API che genera meno chiamate fallite o re-prompt vince spesso sul costo reale per soluzione.

- 📊 Governance aziendale: fasce mensili prevedibili e fatturazione consolidata spesso prevalgono su piccole differenze di costo token.

| Piano 💼 | Costo Google Gemini 3 💸 | Costo GPT‑5.1 💸 | Migliore per ✅ |

|---|---|---|---|

| API (contesto medio) | $2 in ingresso / $12 in uscita per 1M | $1,25 in ingresso / $10 in uscita per 1M | Bilanciato R&S vs contenuti |

| API (contesto ampio) | $4 in ingresso / $18 in uscita per 1M | Varie per fascia | Documenti lunghi, conformità |

| Consumer | ~$19,99/mese; enterprise fino a ~$250 | ~$20/mese e oltre | Individui, team, operazioni |

| Visione Costo Totale | Più forte per input lunghi | Conveniente per output intensi | Matematica specifica per carico |

Se i dettagli di prezzo per gli utenti finali sono una priorità, consultate prezzi ChatGPT nel 2025 e confrontateli con i modelli interni di utilizzo per stabilire un tetto sensato.

I prezzi rappresentano solo metà dell’equazione; l’altra metà è ciò che quei token possono fare quando testo incontra immagini, codice e pianificazione.

Flussi di Lavoro Multimodali e Casi di Studio a Lungo Contesto che Stressano Entrambi i Modelli

La capacità multimodale distingue gli assistenti casuali dai veri copiloti per il lavoro. La versione Google porta alla gestione unificata di testo, immagini e codice in un unico flusso, costruendo sulle sperimentazioni multimodali precedenti e spingendo avanti la continuità. Per incarichi complessi—come diagrammi architettonici, foto prodotto e sceneggiature—la capacità di fare riferimento a dettagli visivi mentre si scrive o si effettua il debug è un accelerante. L’ultima versione di OpenAI enfatizza la chiarezza compositiva nel linguaggio, ma test indipendenti hanno suggerito che è inferiore allo stack Google per ampiezza di modalità e ragionamento sostenuto a lungo termine.

Riprendiamo Nimbus Labs. Il loro playbook di lancio prodotto richiedeva: (a) analizzare screenshot di concorrenti; (b) redigere una serie educativa di 12 email; (c) produrre snippet SDK; e (d) assemblare una guida sul campo di 40 pagine. Con il sistema Google, hanno inviato immagini annotate e blocchi di testo in una singola sessione continua. L’assistente ha prodotto esempi di codice allineati agli elementi UI visibili negli screenshot—senza necessità di chiarimenti continui. Con OpenAI, il team ha eccelso nel far sembrare la sequenza di outreach costruita da un stratega umano, grazie a controlli di tono più forti e al blocco della personalità. Il risultato: hanno diviso i carichi di lavoro—sintesi visiva + tecnica da un lato, messaggistica ad alta cura dall’altro.

Quando i documenti superano i limiti tipici, dividere il contenuto in blocchi può causare perdita di contesto. La lunga estensione di Google rende più fattibile una “memoria” continua unica, riducendo il rischio di contraddizioni. Gli utenti OpenAI spesso compensano con strategie accurate di recupero e disciplina dei metadati. Se questa è la vostra strada, esplorate consigli sul workflow di analisi file e integrate un indice vettoriale per mantenere il sistema ancorato tra le sessioni.

Per maggiori confronti, gli acquirenti valutano anche strumenti adiacenti. Consultate ChatGPT vs Perplexity AI per compiti a forte contenuto di ricerca, o rivedete ChatGPT vs GitHub Copilot quando l’assistenza al coding è centrale nella decisione.

Linee guida per vittorie multimodali

- 🖼️ Ancorare i visual: assicuratevi che screenshot o diagrammi abbiano callout espliciti; il modello Google allinea bene gli output agli elementi nelle immagini.

- 🗂️ Mantenere una sola fonte: ove possibile, caricate il contesto completo una volta; finestre ampie riducono gli errori da cucitura della sessione.

- 🧩 Disciplina nel recupero: per finestre più piccole, investite in embedding e recupero per simulare continuità.

- 🧪 Testare con asset reali: dati fittizi nascondono i casi limite; PDF reali e immagini espongono le vere difficoltà.

- 🧭 Assegnare ruoli: indirizzate sintesi visivo-tecnica al leader multimodale; indirizzate la copia empatica allo specialista della conversazione.

| Flusso di Lavoro 🧭 | Adattamento Forte: Google 🌟 | Adattamento Forte: OpenAI 🚀 | Motivo 🔍 |

|---|---|---|---|

| Sintesi visivo + testuale | Sì | Situazionale | Continuità multimodale su lunghe estensioni |

| Outreach con personalità perfetta | Situazionale | Sì | Controlli di tono e rispetto istruzioni dettagliati |

| Grossi dossier di ricerca | Sì | Situazionale | Minore segmentazione; meno contraddizioni |

| Q&A rapido | Situazionale | Sì | Dialogo reattivo e turni corti coerenti |

Per una prospettiva end-to-end su come gli strumenti basati su GPT si sono evoluti fino agli assistenti odierni, la panoramica sull’evoluzione AI di ChatGPT è una lettura utile.

Dopo aver mappato i punti di forza multimodali, la sezione seguente valuta qualità di conversazione e rispetto delle istruzioni—fondamentale per i team che vivono in chat tutto il giorno.

Rispetto delle Istruzioni, Controlli di Tono e Qualità Conversazionale nell’Uso Quotidiano

L’ultima versione di OpenAI dà priorità al flusso di conversazione. Due modalità regolabili—Instant e Thinking—permettono ai costruttori di scambiare velocità con deliberazione senza prompt elaborati. Segue le istruzioni in modo più coerente e aggiunge regolatori per personalità, cortesia e formalità. Questa combinazione dà ai help desk, squadre marketing e team HR una “voce” affidabile. Per i team tecnici, la coerenza riduce il rifacimento: meno promemoria per restare concisi, meno drift stilistico in thread lunghi e passaggi più puliti ai revisori umani.

L’ultima versione Google si concentra sul pragmatismo attraverso pianificazione e memoria a lungo termine, ma il dialogo si è anche affinato rispetto ai modelli precedenti. Quando gli viene chiesto di fornire output multi-step—come un piano di outreach con variazioni di messaggi per persona e fase—tende a mantenere intatta la struttura. Le differenze emergono maggiormente in compiti sensibili al tono. Lo stack OpenAI rende piacevolmente facile impostare cordialità, umorismo e frasi specifiche del brand. Se il lavoro è rispondere a 300 email clienti sfumate al giorno, quella coerenza si accumula rapidamente.

Poiché la cura del prompt influisce su costo e qualità, vale la pena affinare la tecnica. Una risorsa eccellente sono le strategie di ottimizzazione dei prompt che coprono barriere, test di parità e basali deterministici. Per i team operativi che lanciano piloti, la review pratica di ChatGPT 2025 offre un senso tangibile degli ambiti in cui il modello brilla. E per chi distribuisce accesso globalmente, specialmente in mercati in crescita, il primer su accesso gratuito a ChatGPT in India delinea considerazioni regionali per il rollout.

Modelli per conversazioni di alta qualità

- 🧭 Impostare una personalità predefinita: bloccare tono, brevità e formattazione all’inizio di ogni sessione per qualità prevedibile.

- ✍️ Usare schemi di output: titoli, punti elenco e JSON riducono ambiguità e migliorano l’adesione alle istruzioni.

- 🧪 Sperimentare script A/B: confrontare Instant vs Thinking o prompt brevi vs dettagliati per trovare il modello di risposta ottimale.

- 📣 Cicli di feedback: catturare correzioni utente e reinserirle come esempi di stile per minimizzare i drift futuri.

- 🔐 Barriere: definire argomenti tabù, regole di escalation e tag di conformità per proteggere brand e utenti.

| Controllo 🎛️ | Forza OpenAI 💬 | Forza Google 🌐 | Impatto Pratico ✅ |

|---|---|---|---|

| Preset di tono | Dettagliati e persistenti | Migliorati, solidi | Risposte coerenti col brand |

| Fedeltà alle istruzioni | Alta | Alta, specialmente per piani strutturati | Meno richieste di ripetizione |

| Velocità vs profondità | Interruttore Instant/Thinking | Interruttore Deep Think | Bilanciamento giusto per ogni compito |

| Thread lunghi | Personalità stabile | Struttura stabile | Sessioni multi-turno coerenti |

I team allineati su voce e chiarezza probabilmente si orienteranno verso il sistema con i controlli di personalità più intuitivi; quelli che consegnano piani complessi potrebbero apprezzare la disciplina strutturale del pianificatore.

Benchmark, Classifiche e Segnali di Prestazioni nel Mondo Reale di Cui Fidarsi

I benchmark raccontano solo parte della storia, eppure la classifica attuale è rivelatrice. Nel grafico comunitario di LMArena, Gemini 3 detiene un punteggio alto vicino a 1324, davanti a Gemini 2.5 Pro circa 1249. GPT‑5.1 (elencato come GPT‑5‑chat) si attesta vicino a 1222, insieme alle generazioni precedenti OpenAI e ad altri modelli di punta. Il messaggio proveniente da migliaia di voti è chiaro: la più recente entrata di Google ha impatto, mentre il rilascio di OpenAI mantiene una posizione forte e rispettata nel livello superiore.

I test sintetici spesso confermano questa disparità. I report hanno annotato il vantaggio di Google nel ragionamento esteso e nell’ampiezza multimodale, mentre il modello OpenAI eccelle in output coerenti di breve durata e obbedienza alle istruzioni. Le sfide in stile Tom’s Guide focalizzate su tono e personalità favoriscono tipicamente OpenAI; ragionamento con immagini o sintesi a lungo contesto favoriscono il motore Google. Questo si allinea al discorso di mercato più ampio: ciò che sembra “più intelligente” dipende fortemente dal metro di misura—dialogo emozionalmente sintonizzato o cognizione a lungo termine.

Per ampliare la visuale, risorse comparative come la comparazione OpenAI vs Anthropic e panoramiche storiche come i sommari GPT‑4, Claude 2 e Llama-era aiutano a collocare i contendenti odierni nel contesto. I lettori che desiderano un match cross-vendor possono anche studiare Microsoft Copilot vs ChatGPT per capire come le scelte del modello si riflettono nelle esperienze prodotto.

Cosa dicono (e cosa non dicono) le classifiche

- 🏁 Le classifiche catturano il sentimento della comunità; sono utili, ma non definitive per il vostro carico di lavoro unico.

- 🧪 I test di laboratorio evidenziano gli estremi; la realtà di produzione miscela latenza, barriere e vincoli di tooling.

- 🧰 Il fit dello stack conta: pipeline dati, recupero e igiene dei prompt possono influenzare i risultati più del QI grezzo.

- 📐 Definite presto metriche di successo: accuratezza, tempo alla bozza e carico di revisione dovrebbero essere misurati per team.

- 🔄 Iterate: piccole modifiche ai prompt e ai flussi di lavoro spesso trasformano un “pareggio” in un vincitore chiaro per la vostra organizzazione.

| Segnale 📊 | Osservazione 🔎 | Implicazione 💡 | Vincitore Oggi 🏆 |

|---|---|---|---|

| Punteggio LMArena | 1324 vs ~1222 intervallo | La comunità preferisce il modello Google | Google 🌟 |

| Compiti a lungo contesto | Meno interruzioni, continuità più ricca | Miglior ricerca e sintesi | Google 🌟 |

| Controllo della personalità | Tono e stile più dettagliati | Chat coerente con il brand | OpenAI 🚀 |

| Scrittura a breve termine | Pulita, diretta, basso drift | Cicli di revisione più veloci | OpenAI 🚀 |

Per una panoramica più ampia delle scelte di mercato, esplorate questa lista curata dei top writing AI nel 2025 per vedere dove si posizionano i due tra gli strumenti specializzati.

Le classifiche guidano lo sguardo; i piloti live rivelano la verità che conta per il vostro team.

Esperienza dello Sviluppatore, Sicurezza ed Ecosistema: Dal Primo Prompt alla Produzione

Distribuire un assistente è più che testo intelligente. È onboarding, limiti di velocità, osservabilità e sicurezza. L’esperienza sviluppatore di OpenAI enfatizza avvii rapidi con preset chiari di personalità, barriere e output strutturati. Lo stack Google enfatizza l’orchestrazione tramite Antigravity, incoraggiando i creatori a progettare agenti multi-step che possono pianificare, chiamare strumenti e mantenere stato in sessioni lunghe. Entrambi i percorsi funzionano; la scelta giusta dipende se il vostro prodotto è un conversatore personale o un pianificatore autonomo con supervisione.

Sulla sicurezza, entrambi i fornitori continuano a rafforzare filtri e percorsi di escalation. I team devono definire cosa significa “buono”, poi implementare controlli misurabili: gestione dei rifiuti, categorie protette e tracciabilità di audit. I responsabili delle operazioni spesso mantengono un “set d’oro” di prompt e output attesi per test di regressione. Inoltre, va dato attenzione ai limiti d’uso; se i picchi di concorrenza contano, esaminate limiti pratici e strategie di mitigazione spiegati in guide comunitarie come rate limits insights. Per chi confronta ecosistemi ampi, una sintesi come la nuova intelligenza di ChatGPT aiuta a cogliere cambiamenti di capacità che influenzano la pianificazione della roadmap.

Il supporto allo sviluppo include anche documentazione, SDK e contenuti di terze parti. Tutorial che codificano framework di personalità, schemi di recupero e strumenti di valutazione valgono il loro peso in uptime. Considerate di pacchettizzare librerie di prompt riutilizzabili e suite di test così ogni team non deve reinventare la ruota. Dove i copiloti per il coding sono centrali, valutate benchmark rispetto a offerte adiacenti e vedete le sfumature di Microsoft Copilot vs ChatGPT nell’esperienza IDE per anticipare le aspettative degli sviluppatori.

Da prototipo a prontezza per la produzione

- 🧱 Costruire una fetta sottile: end-to-end con ambito minimo, incluso logging e valutazioni, prima di scalare.

- 🛰️ Disciplina nella chiamata degli strumenti: definire contratti per funzioni; validare input/output per evitare fallimenti silenziosi.

- 🧭 Specifica di personalità: documentare tono, formattazione, politica di rifiuto e trigger di escalation.

- 🧯 Esercitazioni di sicurezza: eseguire prompt red-team trimestralmente; monitorare variazioni su librerie e aggiornamenti del modello.

- 📈 Osservabilità: registrare spesa token, latenza e accuratezza per rilevare regressioni precoci.

| Dimensione 🧩 | Vantaggio OpenAI 💬 | Vantaggio Google 🌐 | Indicazione per il Costruttore 🛠️ |

|---|---|---|---|

| Avvio rapido | Preset personalità/tono | Impianto agentico | Scegliere in base al primo traguardo |

| Operazioni di sicurezza | Modelli maturi di rifiuto | Barriere robuste alla pianificazione | Allinearsi al profilo di rischio |

| Uso degli strumenti | Chiamate di funzione pulite | Orchestrazione multi-step | Adattarsi alla complessità del flusso |

| Documentazione & ecosistema | Pattern e esempi ricchi | Framework agentici in crescita | Sfruttare codice comunitario |

Se siete ancora indecisi, meta-comparazioni come ChatGPT vs Bard history e scontri diretti tra fornitori quali la guida Google Gemini vs ChatGPT mettono in luce aspetti altrimenti trascurati.

Scegliete lo stack che accelera la vostra prossima release con meno workaround; la velocità è il vero fossato competitivo.

{“@context”:”https://schema.org”,”@type”:”FAQPage”,”mainEntity”:[{“@type”:”Question”,”name”:”Quale modello è migliore per lunghi documenti di ricerca e media misti?”,”acceptedAnswer”:{“@type”:”Answer”,”text”:”L’ultimo modello di Google tende a vincere quando finestre di contesto ampie e sintesi multimodale sono cruciali. I team possono mantenere PDF lunghi, screenshot e note in un unico flusso, riducendo la frammentazione e preservando l’accuratezza tra le sezioni.”}},{“@type”:”Question”,”name”:”Quale modello offre il controllo conversazionale più forte e la consistenza del tono?”,”acceptedAnswer”:{“@type”:”Answer”,”text”:”GPT-5.1 di OpenAI si distingue per fedeltà alle istruzioni e controlli di personalità. Mantiene voce, formalità e struttura coerenti su molti turni, ideale per supporto, copy marketing e assistenti di coaching.”}},{“@type”:”Question”,”name”:”Come dovrebbero decidere i team in base al costo?”,”acceptedAnswer”:{“@type”:”Answer”,”text”:”Modellate il costo reale in base al carico di lavoro: se dominano gli input, l’efficienza del lungo contesto può giustificare i prezzi di Google; se dominano gli output, le tariffe di OpenAI possono essere preferibili. L’ottimizzazione dei prompt e la progettazione del recupero spesso fanno risparmiare più di quanto suggeriscano le differenze di token.”}},{“@type”:”Question”,”name”:”Ci sono risorse per confrontare e migliorare i prompt?”,”acceptedAnswer”:{“@type”:”Answer”,”text”:”Sì. Iniziate con guide di prompt engineering come strategie di ottimizzazione dei prompt e report pratici come la review ChatGPT 2025. Questi aiutano i team a ridurre i retry, migliorare l’accuratezza e mantenere il tono coerente col brand.”}},{“@type”:”Question”,”name”:”Dove posso esplorare più confronti testa a testa?”,”acceptedAnswer”:{“@type”:”Answer”,”text”:”Per un contesto più ampio, leggete ChatGPT vs Gemini 2025, le guide Google Gemini vs ChatGPT, e confronti con Perplexity, Copilot e altri per capire l’adattamento per compito ed ecosistema.”}}]}Quale modello è migliore per lunghi documenti di ricerca e media misti?

L’ultimo modello di Google tende a vincere quando finestre di contesto ampie e sintesi multimodale sono cruciali. I team possono mantenere PDF lunghi, screenshot e note in un unico flusso, riducendo la frammentazione e preservando l’accuratezza tra le sezioni.

Quale modello offre il controllo conversazionale più forte e la consistenza del tono?

GPT‑5.1 di OpenAI si distingue per fedeltà alle istruzioni e controlli di personalità. Mantiene voce, formalità e struttura coerenti su molti turni, ideale per supporto, copy marketing e assistenti di coaching.

Come dovrebbero decidere i team in base al costo?

Modellate il costo reale in base al carico di lavoro: se dominano gli input, l’efficienza del lungo contesto può giustificare i prezzi di Google; se dominano gli output, le tariffe di OpenAI possono essere preferibili. L’ottimizzazione dei prompt e la progettazione del recupero spesso fanno risparmiare più di quanto suggeriscano le differenze di token.

Ci sono risorse per confrontare e migliorare i prompt?

Sì. Iniziate con guide di prompt engineering come strategie di ottimizzazione dei prompt e report pratici come la review ChatGPT 2025. Questi aiutano i team a ridurre i retry, migliorare l’accuratezza e mantenere il tono coerente col brand.

Dove posso esplorare più confronti testa a testa?

Per un contesto più ampio, leggete ChatGPT vs Gemini 2025, le guide Google Gemini vs ChatGPT, e confronti con Perplexity, Copilot e altri per capire l’adattamento per compito ed ecosistema.

-

Tecnologia1 day ago

Tecnologia1 day agoLa tua carta non supporta questo tipo di acquisto: cosa significa e come risolverlo

-

Modelli di IA1 day ago

Modelli di IA1 day agoOpenAI vs Tsinghua: Scegliere tra ChatGPT e ChatGLM per le tue esigenze di IA nel 2025

-

Internet19 hours ago

Internet19 hours agoEsplorando il Futuro: Cosa Devi Sapere su Internet-Enabled ChatGPT nel 2025

-

Modelli di IA1 day ago

Modelli di IA1 day agoScegliere il tuo compagno di ricerca AI nel 2025: OpenAI vs. Phind

-

Tecnologia7 hours ago

Tecnologia7 hours agoComprendere hard degenerate: cosa significa e perché è importante nel 2025

-

Modelli di IA1 day ago

Modelli di IA1 day agoOpenAI vs PrivateGPT: Quale Soluzione AI Si Adatterà Meglio Alle Tue Esigenze Nel 2025?