Innovación

PSU y los investigadores de Duke revelan un innovador sistema automatizado de atribución de fallos para sistemas multiagente

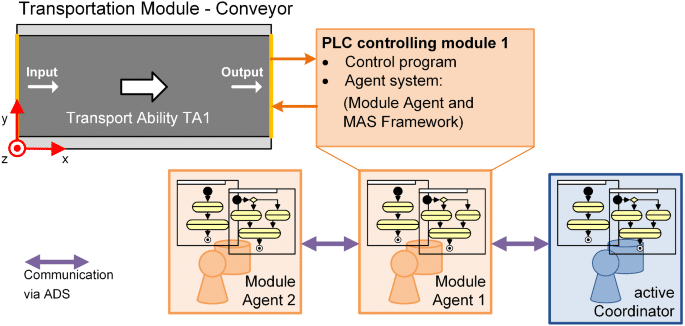

Investigadores de PSU y la Universidad Duke, junto con colaboradores de Google DeepMind y otros Laboratorios de Investigación, han formalizado un nuevo problema en Inteligencia Artificial: Atribución Automática de Fallos para Sistemas Multi-Agente impulsados por LLM. El trabajo presenta el benchmark Who&When, un conjunto de datos y una suite de evaluación diseñados para identificar qué agente causó una falla y en qué paso. Este esfuerzo llega en un momento oportuno, ya que los Sistemas Autónomos escalan y la depuración requiere herramientas de diagnóstico más ágiles y rápidas.

| ¿Con prisa? Esto es lo importante: |

|---|

| • 🔎 Nueva tarea: Automatizar “quién falló” y “cuándo ocurrió” en Sistemas Multi-Agente. |

| • 🧪 Benchmark Who&When: Registros anotados por humanos de 127 sistemas que permiten pruebas estandarizadas. |

| • 📉 Resultados desafiantes: ~53.5% en “quién” y ~14.2% en “cuándo”; los métodos actuales fallan con registros largos. |

| • 🧰 Próximos pasos accionables: Prueba estrategias híbridas y prompts estructurados; consulta una guía práctica sobre causas raíz de fallos en tareas 🔧 |

Por qué importa la Atribución Automática de Fallos en Sistemas Multi-Agente: Avance de Investigadores de PSU y Duke

A medida que los Sistemas Multi-Agente impulsados por LLM escalan, los desarrolladores a menudo enfrentan una paradoja: una avalancha de mensajes de agentes, herramientas activándose, razonamiento en cadena, y aun así la tarea falla. En términos de Ciencias de la Computación, el problema cambia de “¿cuál fue la respuesta correcta?” a “¿dónde en la cadena colaborativa ocurrió la falla?” Esa es precisamente la brecha que el equipo de PSU y Duke University aborda con la Atribución Automática de Fallos. El objetivo: convertir horas de revisión de registros en un paso diagnóstico transparente y estructurado.

Considera a Ava, una ingeniera de plataforma en una startup fintech. Su equipo de Sistemas Autónomos utiliza cuatro agentes especializados: planificador, investigador, programador y tester. Una consulta de cliente falla tras 23 interacciones. Sin atribución, diagnosticar la causa raíz es ambiguo: ¿falló el planificador al especificar subobjetivos, el investigador pasó por alto una API clave, o el tester interpretó mal la salida? La atribución actúa como una grabadora de caja negra para la coordinación, identificando el agente responsable y el paso decisivo donde el error desencadenó la falla.

El cuello de botella en la depuración que enfrentan los desarrolladores

Los flujos de trabajo modernos de IA frecuentemente se detienen por la falta de observabilidad, no por capacidad de modelado. Incluso con modelos de Machine Learning potentes, las líneas de responsabilidad poco claras complican los ciclos de iteración y la gobernanza. La formulación liderada por PSU lo formaliza como una tarea distinta, alineando la depuración con la evaluación, un paso atrasado para la Automatización a gran escala.

- 🧵 Cadenas largas de interacción dificultan ver la causalidad entre registros extensos y verbosos.

- 🧭 Roles ambiguos de los agentes confunden quién tomó o propagó una decisión.

- ⏱️ El tiempo para el diagnóstico se dispara cuando cada falla requiere detectiveo humano.

- 🔐 Presión de cumplimiento exige auditabilidad en Laboratorios de Investigación y entornos de producción.

El benchmark Who&When aborda este problema estandarizando anotaciones de “quién” y “cuándo”, permitiendo evaluación cuantitativa. También crea un lenguaje común entre equipos: un bug no es solo una falla, sino un error específico de agente y paso, rastreable y corregible.

| Desafío 🚧 | Por qué duele 💥 | Beneficio de la atribución ✅ |

|---|---|---|

| Colaboración opaca entre agentes | Culpa errónea o arreglos imprecisos | “Quién” preciso señala la responsabilidad 🔍 |

| Registros largos y límites de contexto | Se pierde paso crítico en el ruido | “Cuándo” exacto reduce la ventana de búsqueda ⏳ |

| Arqueología manual de registros | Iteraciones lentas y agotamiento | Triaje automatizado acelera ciclo de corrección 🚀 |

| Requisitos de cumplimiento / auditoría | Post-mortems inconsistentes | Evidencia estandarizada y reproducible 📚 |

Para equipos gestionando despliegues complejos de IA, la idea clave es simple: la atribución convierte el caos en responsabilidad, creando un flujo de trabajo que apoya directamente la confiabilidad.

Dentro del Benchmark Who&When: Diseño de Datos, Anotaciones y Cobertura para la Atribución de Fallos

El benchmark Who&When agrega registros de fallos a través de 127 Sistemas Multi-Agente que abarcan tareas variadas, uso de herramientas y patrones de coordinación. Algunos registros son generados algorítmicamente para estresar modos de error específicos; otros son elaborados a mano por expertos para reflejar historias realistas de fallas. Cada registro incluye tres anotaciones críticas: Quién causó la falla, Cuándo ocurrió el paso decisivo, y Por qué sucedió en lenguaje natural.

Este trío es crucial. “Quién” establece responsabilidad; “Cuándo” ofrece un ancla temporal; “Por qué” proporciona razonamiento causal que guía un parche correctivo. Juntos hacen que la falla no solo sea detectable sino explicable—un requisito para una Automatización sostenible en entornos productivos. La estandarización también permite a los Laboratorios de Investigación comparar métodos de forma homogénea, evitando métricas aisladas que ocultan brechas de generalización.

Qué se anota y por qué importa

Las guías de anotación aseguran que casos límite complejos—como errores en cadena o desviaciones silenciosas—se manejen consistentemente. Cuando varios agentes contribuyen a una falla, los anotadores señalan el punto decisivo donde el éxito se volvió inalcanzable. Esto es especialmente útil en pipelines de planificación, donde una mala especificación temprana puede condenar pasos posteriores aunque parezcan correctos aisladamente.

- 🧩 Identidad del rol: planificador, crítico, ejecutor, invocador de herramientas, verificador, etc.

- 🕰️ Índice del paso: el momento decisivo que cambió el resultado.

- 🗣️ Justificación en lenguaje natural: explicación concisa del vínculo causal.

- 🧪 Metadatos de la tarea: dominio, herramientas usadas, disponibilidad de verdad de tierra.

La amplitud del benchmark soporta estudios en múltiples dominios—asistencia de codificación, análisis de datos, planificación de contenidos y soporte a decisiones en el mundo real. También habilita ablaciones controladas: ¿la atribución se mantiene cuando cambia la lista de agentes o cuando las herramientas fallan intermitentemente?

| Campo de Anotación 📝 | Definición 📘 | Valor para depuración 🧯 |

|---|---|---|

| Quién | Agente responsable del error decisivo | Dirige la remediación al módulo correcto 🎯 |

| Cuándo | Paso específico donde ocurrió el error fatal | Reduce dramáticamente el espacio de búsqueda 🔍 |

| Por qué | Explicación en lenguaje natural de la causalidad | Guía diseño de parche y casos de prueba 🧪 |

| Contexto | Tipo de tarea, herramientas y estado de la verdad de tierra | Permite comparaciones justas de métodos ⚖️ |

Para equipos que quieran practicar post-mortems antes de incidentes, un punto de partida práctico es una lista de verificación basada en Who&When. Un recurso complementario útil es esta guía concisa sobre rastrear causas raíz de fallos en sistemas de IA, que complementa la depuración basada en el benchmark.

Los desarrolladores suelen preguntar si una herramienta automatizada puede “simplemente decirme qué arreglar.” La atribución no reemplaza el juicio ingenieril, pero proporciona la ruta de evidencia que permite decisiones rápidas y defendibles. La conclusión: el conjunto de datos convierte el análisis de fallos en una habilidad repetible y enseñable.

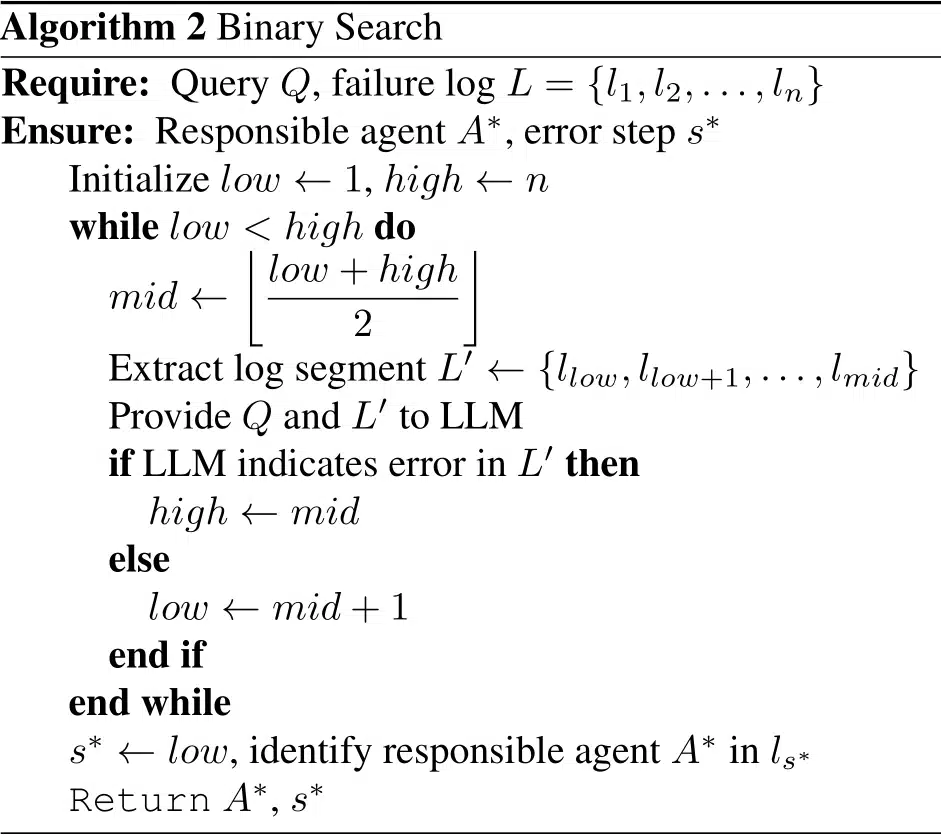

Métodos Comparados: Estrategias All-at-Once, Paso a Paso y Búsqueda Binaria de PSU y Duke

Usando Who&When, los investigadores evaluaron tres estrategias para la Atribución Automática de Fallos. Cada método equilibra costo, precisión y robustez frente a contextos largos. En lugar de un único campeón, el estudio enfatiza un enfoque de caja de herramientas: elige el método que se alinee con tu presupuesto y superficie de error.

Tres estrategias, tres mentalidades

All-at-Once lee todo el registro de fallos y produce el agente responsable y el paso decisivo en un solo pase. Es eficiente en registros cortos y suele ser mejor en “quién,” pero puede errar en “cuándo” a medida que crece el contexto. Paso a Paso replica el detectiveo humano: recorre el registro, evaluando cada paso. Esto mejora la localización pero puede acumular errores previos y aumenta el costo en tokens. Búsqueda Binaria equilibra al dividir recursivamente el registro y preguntar en qué mitad está el error, balanceando costo y precisión.

- ⚡ All-at-Once: rápido, grueso, sólido para “quién.”

- 🪜 Paso a Paso: meticuloso, mayor costo, mejor para “cuándo.”

- 🔍 Búsqueda Binaria: pragmático, buen compromiso promedio.

- 🧩 Cadenas híbridas: combinan fortalezas a costa de más cómputo.

El estudio también midió desempeño con y sin conocimiento de la verdad de tierra de la tarea subyacente. Cuando la verdad está disponible, los métodos pueden verificar resultados para mejorar confianza; sin ella, deben inferir solo a partir de la dinámica de interacción—más cercano a condiciones reales de producción. En ambos casos, contextos más largos degradan la precisión, especialmente en “cuándo.”

| Método 🧭 | Fortalezas 💪 | Debilidades ⚠️ | Mejor Caso de Uso 🧰 |

|---|---|---|---|

| All-at-Once | Bajo costo; fuerte en “quién” en registros cortos 🙂 | Dificultades con contextos largos; débil en “cuándo” 😵 | Triaje rápido en trazas concisas ⏱️ |

| Paso a Paso | “Cuándo” preciso; razonamiento transparente 🧠 | Alto uso de tokens; acumulación de errores 📈 | Post-mortems para incidentes críticos 🧯 |

| Búsqueda Binaria | Balanceado; escalable en registros largos ⚖️ | Puede perder pistas sutiles entre pasos 🧩 | Triaje rutinario en producción 🔄 |

Los equipos pueden encadenar métodos: usar All-at-Once para preseleccionar al agente, luego cambiar a Paso a Paso para localizar el paso decisivo. Para un plano de implementación práctico, este recorrido sobre rastrear causas raíz de fallos en agentes muestra cómo estructurar prompts y registros.

En todas las estrategias, el razonamiento explícito ayuda. Los prompts que exigen una justificación, citas de evidencia y una decisión final tienden a mejorar la consistencia. El principio guía: forzar al modelo a mostrar su trabajo y citar turnos específicos, un cambio pequeño que se acumula en confiabilidad.

Qué Revelan los Resultados: Límites, Costos y Oportunidades en la Depuración de IA

En Who&When, incluso los modelos de primer nivel enfrentaron una realidad dura. El mejor método único logró aproximadamente 53.5% en identificar “quién” causó la falla y cerca de 14.2% en el “cuándo” exacto. Algunos métodos quedaron por debajo de lineas base aleatorias en escenarios difíciles, subrayando que la atribución exige razonamiento causal más fuerte que tareas típicas de QA o resumen.

Los resultados también se dividieron según si el modelo conoce la respuesta verdadera de la tarea. Con verdad de tierra, la atribución puede triangular contradicciones (“el plan del planificador es incompatible con la respuesta correcta”). Sin ella, debe diagnosticar solo con dinámicas conversacionales y trazas de herramientas—una visión más auténtica de producción. En ambos casos, contextos largos degradan precisión, especialmente para “cuándo.”

Hallazgos clave para que los desarrolladores actúen

Varios patrones ofrecen guía inmediata para equipos que estandarizan flujos de trabajo de atribución. Primero, la ingeniería de prompts importa: prompts estructurados y con justificación mejoraron consistentemente la concordancia con anotaciones humanas. Segundo, las cadenas híbridas superan ejecuciones individuales, aunque sube el costo. Tercero, diseños conscientes de la longitud—como ventanas deslizantes o resúmenes por secciones—ayudan a contrarrestar la fatiga del contexto.

- 🧠 Justificaciones explícitas elevan los juicios de “quién” y “cuándo.”

- 🧮 Flujos híbridos intercambian tokens por calidad—presupuesta adecuadamente.

- 🧾 Gestión de contexto (ventanas, destacados) ralentiza la caída de precisión.

- 🧰 La elección del modelo no es la solución definitiva; incluso los razonadores avanzados luchan.

| Dimensión 📏 | Observación 🔭 | Implicación 🧩 | Acción ☑️ |

|---|---|---|---|

| Quién vs. Cuándo | “Quién” más fácil; “Cuándo” notablemente más difícil | La localización temporal es el cuello de botella ⛔ | Adopta razonamiento paso-local y citas de evidencia 🗂️ |

| Métodos híbridos | Mayor precisión a mayor costo | Útil para incidentes de alta severidad 🔥 | Escala de baratos a detallados progresivamente 📶 |

| Longitud del contexto | El rendimiento decrece con registros más largos | Solo resumir no basta 🧱 | Usa búsqueda binaria y predictores de pasos críticos 🧭 |

| Escala del modelo | Más grande ≠ siempre mejor | Razonamiento > capacidad bruta aquí 🧠 | Entrena patrones de prompt; añade heurísticas 📐 |

Para una comparación pragmática respecto al día a día en resolución de problemas, esta guía sobre causas raíz de fallos en tareas de IA complementa bien los resultados empíricos de Who&When, ayudando a conectar métricas con estrategias de corrección.

La conclusión central es estratégica: convierte la atribución en una etapa de primera clase en tu pipeline, no en un pensamiento posterior. Cuando se integra en el ciclo construir-probar-desplegar, la confiabilidad mejora de forma continua, no esporádica.

Manual Práctico: Poniendo a Trabajar la Atribución Automática de Fallos en Laboratorios de Investigación y Producción

Convertir la investigación en práctica habitual comienza con instrumentación. Los equipos pueden agregar la atribución sobre frameworks de orquestación existentes, registrando turnos estructurados con roles de agentes, invocaciones de herramientas y juicios intermedios. El resultado es un rastro reproducible que soporta tanto triaje en tiempo real como revisiones post-incidente, ya sea en una startup o en un equipo de plataforma grande.

Plantilla de flujo de trabajo validada en campo

El siguiente manual refleja cómo equipos con alta madurez abordan el análisis de fallos manteniendo los costos manejables. Combina selección de método, patrones de prompts y limpieza de registros en una práctica sostenible para grupos de Machine Learning e Ingeniería de Software.

- 🧾 Estructura de registros: etiqueta cada turno con rol, intención, evidencia citada y efectos de herramientas.

- 🗂️ Pase de triaje: ejecuta All-at-Once para “quién” rápido en trazas cortas.

- 🧭 Perforación: para casos complejos, cambia a Búsqueda Binaria o Paso a Paso.

- 🧪 Prompts de justificación: exige explicaciones y cita turnos específicos.

- 🧯 Reglas de escalamiento: usa híbridos solo para incidentes de alta severidad o recurrentes.

| Etapa 🛠️ | Meta 🎯 | Mezcla de Métodos 🧪 | Consejo Operativo 🧭 |

|---|---|---|---|

| Instrumentación | Captura registros accionables | Etiquetas de rol + trazas de herramientas | Aplica esquemas en CI ✅ |

| Triaje rápido | Encuentra el agente probable | All-at-Once | Limita contexto a turnos críticos ✂️ |

| Localización | Identifica el paso decisivo | Búsqueda Binaria → Paso a Paso | Cita evidencia del registro 🔎 |

| Remediación | Aplica corrección dirigida | Actualizaciones de especificación, pruebas, barreras | Prueba retrospectiva con fallos similares ♻️ |

Para ayudar a los equipos a comenzar, varios explicadores concisos ilustran el camino desde el síntoma hasta la causa raíz. Esta visión general sobre cómo identificar causas raíz en flujos de agentes es útil para la incorporación, mientras esta nota complementaria sobre depuración de transferencias entre agentes profundiza en fallas de coordinación. Para gerentes de ingeniería de confiabilidad, un manual sobre diseñar SLOs informados por atribución conecta métricas con compromisos operativos. Equipos que estandarizan en dominios regulados pueden adaptar las mismas ideas para rastros de auditoría: consulta esta guía sobre documentación de causalidad de incidentes. Y para lectura profunda, un análisis práctico sobre análisis de causa raíz encaja bien con el esquema de Who&When.

Dos notas finales para el despliegue. Primero, la atribución debe ser agnóstica al modelo y centrada en registros: aplica un esquema para que cualquier modelo pueda participar. Segundo, controla costos explícitamente; usa híbridos solo cuando la severidad lo justifique. La regla práctica es clara: optimiza para correcciones rápidas y explicables, luego escala la sofisticación a medida que madura tu taxonomía de incidentes.

De la Investigación a la Hoja de Ruta: Lo que el Trabajo de PSU y Duke Significa para la Próxima Ola de Sistemas Autónomos

Al formalizar la Atribución Automática de Fallos, el equipo de PSU y Duke University replantea la depuración como una capacidad medible dentro de sistemas de Inteligencia Artificial, no como una habilidad artesanal. Este cambio beneficia a investigadores, equipos de plataforma y líderes de producto por igual. Es un puente entre evaluación y mejora—el eslabón perdido que hace sistemática la iteración.

Hacia dónde va esto

El camino probablemente incluirá señales causales más ricas (por ejemplo, semántica de herramientas), predicción de pasos críticos y políticas aprendidas para selección de método bajo restricciones de costo. Se espera una integración más estrecha con frameworks de orquestación, pruebas contractuales para APIs inter-agente y paneles donde “quién” y “cuándo” se integren en plantillas de remediación. A medida que la atribución madura, los Sistemas Multi-Agente serán menos frágiles y sus fallos menos misteriosos.

- 🧭 Señales causales: integra resultados de herramientas y diferencias de estado en prompts del atribuidor.

- 🧱 Agentes con barreras: añade chequeos que se disparen por patrones riesgosos de “quién/cuándo.”

- 📊 Visibilidad operacional: muestra métricas de atribución en scorecards de confiabilidad.

- 🧑⚖️ Gobernanza: mantiene narrativas listas para auditorías en revisiones de incidentes.

| Interesado 👥 | Valor de la Atribución 💡 | Primer Paso 🪜 | Señal a Observar 👁️ |

|---|---|---|---|

| Laboratorios de Investigación | Líneas base comparables entre métodos | Adopta divisiones Who&When | Diferencia entre “quién” y “cuándo” 📉 |

| Equipos de plataforma | Resolución más rápida de incidentes | Registros con esquema obligatorio | Tiempo promedio hasta atribución ⏱️ |

| Propietarios de producto | Ciclos de iteración predecibles | Manual de triaje | Tasa de regresión tras correcciones 🔁 |

| Cumplimiento | Post-mortems listos para auditoría | Narrativas plantilla | Cobertura de justificaciones “por qué” 📚 |

Antes la depuración era un arte. Con la atribución, se convierte en una capacidad operativa para productos de IA. La dirección es inequívoca: confiabilidad a través de un razonamiento basado en evidencia, con la contribución de PSU y Duke marcando un paso crucial.

{“@context”:”https://schema.org”,”@type”:”FAQPage”,”mainEntity”:[{“@type”:”Question”,”name”:”¿Qué es exactamente la Atribución Automática de Fallos?”,”acceptedAnswer”:{“@type”:”Answer”,”text”:”Es una tarea formal que identifica qué agente es responsable de una falla (‘quién’) y el paso decisivo del error (‘cuándo’) en Sistemas Multi-Agente LLM. El equipo de PSU y la Universidad Duke definieron la tarea y liberaron el benchmark Who&When con anotaciones humanas para quién, cuándo y por qué.”}},{“@type”:”Question”,”name”:”¿Por qué los métodos actuales solo alcanzan alrededor de 53.5% para ‘quién’ y 14.2% para ‘cuándo’?”,”acceptedAnswer”:{“@type”:”Answer”,”text”:”La atribución requiere razonamiento causal sobre registros largos y ruidosos. Los modelos deben aislar el paso decisivo que garantizó la falla, lo cual es más difícil que las tareas típicas de QA. La longitud del contexto, transferencias sutiles y errores compuestos hacen que “cuándo” sea particularmente desafiante.”}},{“@type”:”Question”,”name”:”¿Cómo deben los equipos empezar a usar atribución en producción?”,”acceptedAnswer”:{“@type”:”Answer”,”text”:”Instrumenta los registros con etiquetas de rol y trazas de herramientas, ejecuta un triaje rápido All-at-Once, luego escala a Búsqueda Binaria o Paso a Paso para incidentes difíciles. Requiere justificaciones explícitas en los prompts y controla costos para que los híbridos se usen solo cuando la severidad lo justifique.”}},{“@type”:”Question”,”name”:”¿Esto reemplaza pruebas unitarias y evaluaciones?”,”acceptedAnswer”:{“@type”:”Answer”,”text”:”No. La atribución complementa pruebas y evaluaciones explicando la causalidad de la falla. Conecta “qué falló” con “por qué falló”, permitiendo correcciones dirigidas y mejores pruebas de regresión.”}},{“@type”:”Question”,”name”:”¿Dónde puedo aprender técnicas prácticas de causa raíz para agentes?”,”acceptedAnswer”:{“@type”:”Answer”,”text”:”Un punto de partida conciso y aplicable es esta guía para rastrear fallos: consulta el recurso sobre causas raíz de fallos de tareas aquí: https://chat-gpt-5.ai/task-failure-root-causes.”}}]}¿Qué es exactamente la Atribución Automática de Fallos?

Es una tarea formal que identifica qué agente es responsable de una falla (‘quién’) y el paso decisivo del error (‘cuándo’) en Sistemas Multi-Agente LLM. El equipo de PSU y la Universidad Duke definieron la tarea y liberaron el benchmark Who&When con anotaciones humanas para quién, cuándo y por qué.

¿Por qué los métodos actuales solo alcanzan alrededor de 53.5% para ‘quién’ y 14.2% para ‘cuándo’?

La atribución requiere razonamiento causal sobre registros largos y ruidosos. Los modelos deben aislar el paso decisivo que garantizó la falla, lo cual es más difícil que las tareas típicas de QA. La longitud del contexto, transferencias sutiles y errores compuestos hacen que “cuándo” sea particularmente desafiante.

¿Cómo deben los equipos empezar a usar atribución en producción?

Instrumenta los registros con etiquetas de rol y trazas de herramientas, ejecuta un triaje rápido All-at-Once, luego escala a Búsqueda Binaria o Paso a Paso para incidentes difíciles. Requiere justificaciones explícitas en los prompts y controla costos para que los híbridos se usen solo cuando la severidad lo justifique.

¿Esto reemplaza pruebas unitarias y evaluaciones?

No. La atribución complementa pruebas y evaluaciones explicando la causalidad de la falla. Conecta “qué falló” con “por qué falló”, permitiendo correcciones dirigidas y mejores pruebas de regresión.

¿Dónde puedo aprender técnicas prácticas de causa raíz para agentes?

Un punto de partida conciso y aplicable es esta guía para rastrear fallos: consulta el recurso sobre causas raíz de fallos de tareas aquí: https://chat-gpt-5.ai/task-failure-root-causes.

-

Open Ai1 week ago

Open Ai1 week agoDesbloqueando el Poder de los Plugins de ChatGPT: Mejora Tu Experiencia en 2025

-

Open Ai6 days ago

Open Ai6 days agoDominando la Fine-Tuning de GPT: Una guía para personalizar eficazmente tus modelos en 2025

-

Open Ai7 days ago

Open Ai7 days agoComparando ChatGPT de OpenAI, Claude de Anthropic y Bard de Google: ¿Qué herramienta de IA generativa reinará suprema en 2025?

-

Open Ai6 days ago

Open Ai6 days agoPrecios de ChatGPT en 2025: Todo lo que necesitas saber sobre tarifas y suscripciones

-

Open Ai7 days ago

Open Ai7 days agoLa eliminación progresiva de los modelos GPT: qué pueden esperar los usuarios en 2025

-

Modelos de IA6 days ago

Modelos de IA6 days agoModelos GPT-4: Cómo la inteligencia artificial está transformando 2025