Inovação

PSU e Pesquisadores da Duke Revelam Atribuição Automática Revolucionária de Falhas para Sistemas Multiagente

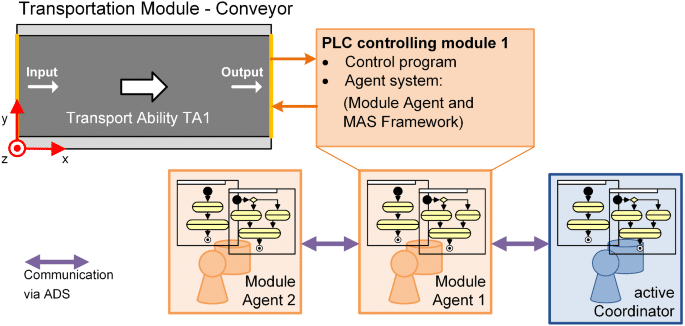

Pesquisadores da PSU e da Duke University, junto com colaboradores do Google DeepMind e outros Laboratórios de Pesquisa, formalizaram um novo problema em Inteligência Artificial: Atribuição Automática de Falhas para Sistemas Multiagente conduzidos por LLM. O trabalho apresenta o benchmark Who&When, um conjunto de dados e suíte de avaliação projetados para identificar qual agente causou uma falha e em qual etapa isso ocorreu. O esforço chega em um momento oportuno, com a escala dos Sistemas Autônomos e a demanda por ferramentas de diagnóstico mais rápidas e precisas para depuração.

| Com pressa? Aqui está o que importa: |

|---|

| • 🔎 Nova tarefa: Automatizar “quem falhou” e “quando aconteceu” em Sistemas Multiagente. |

| • 🧪 Who&When benchmark: Logs anotados por humanos de 127 sistemas permitem testes padronizados. |

| • 📉 Resultados desafiadores: ~53,5% em “quem” e ~14,2% em “quando”; métodos atuais falham em logs longos. |

| • 🧰 Próximos passos acionáveis: Experimente estratégias híbridas e prompts estruturados; veja um guia prático sobre causas raiz de falhas em tarefas 🔧 |

Por que a Atribuição Automática de Falhas é Importante em Sistemas Multiagente: Avanço dos Pesquisadores da PSU e Duke

À medida que Sistemas Multiagente movidos a LLM escalam, os desenvolvedores frequentemente encontram um paradoxo: uma enxurrada de mensagens dos agentes, ferramentas disparando, raciocínio em cadeia — e ainda assim a tarefa falha. Em termos de Ciência da Computação, o problema muda de “qual foi a resposta certa?” para “em que ponto do pipeline de colaboração ocorreu a falha?” É exatamente essa lacuna que a equipe da PSU e da Duke University mira com a Atribuição Automática de Falhas. O objetivo: transformar horas de análise de logs em um passo diagnóstico transparente e estruturado.

Considere Ava, engenheira de plataforma em uma startup fintech. Sua equipe de Sistemas Autônomos usa quatro agentes especializados — planejador, pesquisador, programador e testador. Uma consulta de cliente falha após 23 interações. Sem atribuição, diagnosticar a causa raiz é incerto: o planejador especificou mal os subobjetivos? O pesquisador perdeu uma API crítica? Ou o testador interpretou incorretamente a saída? A atribuição age como uma caixa preta para coordenação, identificando o agente responsável e a etapa decisiva onde o erro desencadeou a falha.

O gargalo de depuração que os desenvolvedores enfrentam

Fluxos modernos de trabalho em IA frequentemente têm gargalos na observabilidade, não na capacidade de modelagem. Mesmo com modelos sólidos de Aprendizado de Máquina, linhas de responsabilidade pouco claras complicam ciclos de iteração e governança. A formalização feita pela PSU enquadra isso como uma tarefa distinta, alinhando depuração com avaliação — um movimento atrasado para Automação em escala.

- 🧵 Longas cadeias de interação dificultam ver causalidade em logs prolixos.

- 🧭 Papéis ambíguos dos agentes confundem quem tomou decisões versus quem as propagou.

- ⏱️ Tempo de diagnóstico cresce quando cada falha requer investigação humana.

- 🔐 Pressão por conformidade exige auditabilidade em Laboratórios de Pesquisa e stacks de produção.

O benchmark Who&When atende a essa necessidade padronizando anotações de “quem” e “quando”, permitindo avaliação quantitativa. Ele também cria uma linguagem comum entre equipes: um bug não é só uma falha, mas um erro específico do agente em uma etapa, rastreável e corrigível.

| Desafio 🚧 | Por que dói 💥 | Benefício da Atribuição ✅ |

|---|---|---|

| Colaboração opaca do agente | Culpa mal direcionada ou correções desfocadas | “Quem” preciso identifica responsabilidade 🔍 |

| Logs longos e limites contextuais | Etapa crítica perdida no meio do ruído | “Quando” exato restringe janela de busca ⏳ |

| Análise manual de logs | Iterações lentas e exaustão | Triagem automatizada acelera o ciclo de correção 🚀 |

| Requisitos de conformidade/auditoria | Pós-mortems inconsistentes | Provas padronizadas e reproduzíveis 📚 |

Para equipes que gerenciam implantações complexas de IA, o insight chave é simples: a atribuição converte caos em responsabilidade, criando um fluxo de trabalho que apoia diretamente a confiabilidade.

Dentro do Benchmark Who&When: Design de Dados, Anotações e Cobertura para Atribuição de Falhas

O benchmark Who&When agrega logs de falhas de 127 Sistemas Multiagente cobrindo tarefas variadas, uso de ferramentas e padrões de coordenação. Alguns logs são gerados algoritmicamente para estressar modos de erro específicos; outros são produzidos manualmente por especialistas para refletir falhas realistas. Cada log inclui três anotações críticas: Quem causou a falha, Quando a etapa decisiva ocorreu e Por quê isso aconteceu em linguagem natural.

Essa tríade é importante. “Quem” estabelece responsabilidade; “Quando” fornece uma âncora temporal; “Por quê” oferece raciocínio causal que orienta a correção. Juntos, eles fazem a falha não só detectável, mas explicável — pré-requisito para Automação sustentável em ambientes de produção. A padronização também permite que Laboratórios de Pesquisa comparem métodos de forma justa, evitando métricas isoladas que mascaram lacunas de generalização.

O que é anotado e por que importa

Diretrizes de anotação garantem que casos difíceis — como erros em cadeia ou desvios silenciosos — sejam tratados consistentemente. Quando múltiplos agentes contribuem para a falha, os anotadores marcam o ponto decisivo onde o sucesso se tornou inalcançável. Isso é especialmente útil em pipelines de planejamento, onde uma má especificação inicial pode comprometer etapas posteriores, mesmo que pareçam corretas isoladamente.

- 🧩 Identidade do papel: planejador, crítico, executor, invocador de ferramenta, verificador, etc.

- 🕰️ Índice da etapa: o momento decisivo que mudou o resultado.

- 🗣️ Justificativa em linguagem natural: explicação concisa do vínculo causal.

- 🧪 Metadados da tarefa: domínio, ferramentas usadas, disponibilidade da verdade fundamental.

A abrangência do benchmark apoia estudos em domínios diversos — auxílio em programação, análise de dados, planejamento de conteúdo e suporte à decisão no mundo real. Também permite ablações controladas: a atribuição se mantém quando o elenco de agentes muda ou as ferramentas falham intermitentemente?

| Campo de Anotação 📝 | Definição 📘 | Valor para Depuração 🧯 |

|---|---|---|

| Quem | Agente responsável pelo erro decisivo | Foca a remediação no módulo correto 🎯 |

| Quando | Etapa específica em que ocorreu o erro fatal | Reduz drasticamente o espaço de busca nos logs 🔍 |

| Por quê | Explicação em linguagem natural da causalidade | Guia o desenho de correções e casos de teste 🧪 |

| Contexto | Tipo de tarefa, ferramentas e status da verdade fundamental | Permite comparações justas entre métodos ⚖️ |

Para equipes que querem ensaiar análises postmortem antes de incidentes, um ponto de partida prático é um checklist baseado no Who&When. Um recurso complementar útil é este guia conciso sobre rastreamento das causas raiz de falhas em sistemas de IA, que complementa a depuração baseada no benchmark.

Desenvolvedores frequentemente perguntam se uma ferramenta automática pode “simplesmente me dizer o que corrigir.” A atribuição não substitui o julgamento de engenharia, mas fornece a trilha de evidências que permite decisões rápidas e defendáveis. O resultado: o conjunto de dados transforma análise de falhas em uma habilidade repetível e ensinável.

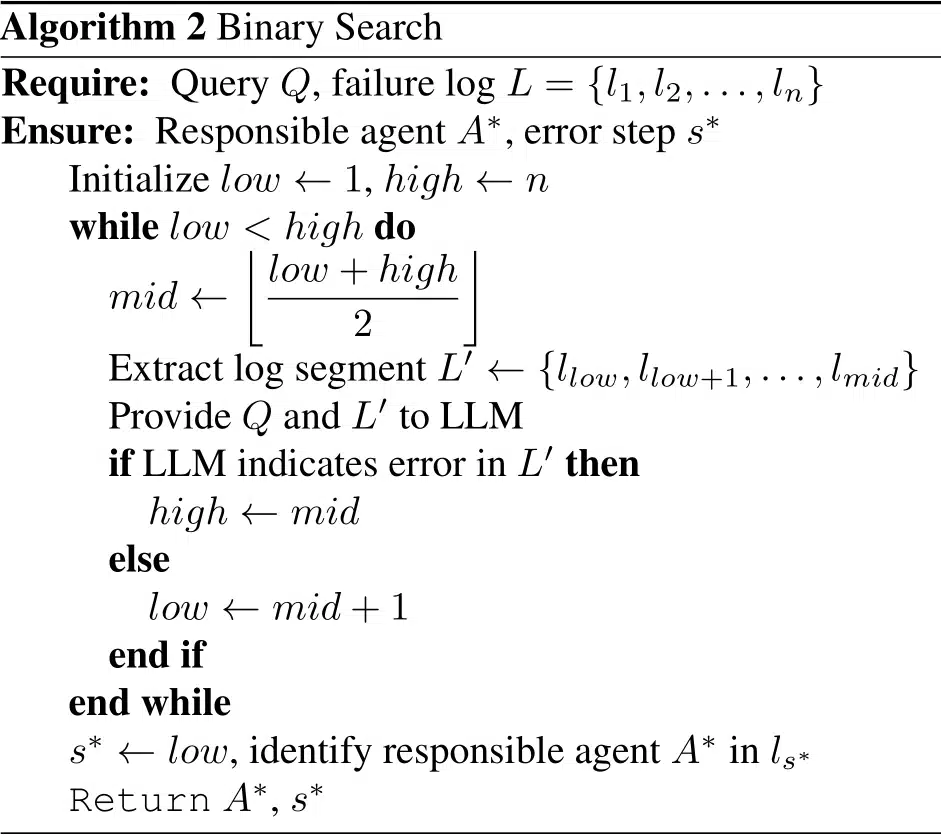

Métodos Comparados: Estratégias All-at-Once, Step-by-Step e Binary Search da PSU e Duke

Usando Who&When, os pesquisadores avaliaram três estratégias para Atribuição Automática de Falhas. Cada método negocia custo, precisão e robustez a contextos longos. Em vez de um único campeão, o estudo enfatiza uma abordagem de kit de ferramentas: escolha o método que se alinha ao seu orçamento e superfície de erro.

Três estratégias, três mentalidades

All-at-Once lê todo o log de falha e entrega o agente responsável e a etapa decisiva em uma única passagem. É eficiente em logs curtos e muitas vezes melhor em “quem”, mas pode errar em “quando” conforme o contexto cresce. Step-by-Step espelha a investigação humana: percorre o log, avaliando cada passo. Isso aprimora a localização, mas pode acumular erros anteriores e aumenta o custo de tokens. Binary Search divide a diferença ao cortar o log recursivamente ao meio e perguntar qual metade esconde o erro, equilibrando custo e precisão.

- ⚡ All-at-Once: rápido, granularidade grosseira, sólido para “quem.”

- 🪜 Step-by-Step: meticuloso, custo maior, melhor para “quando.”

- 🔍 Binary Search: pragmático, bom trade-off médio.

- 🧩 Correntes híbridas: combinam forças ao custo de mais computação.

O estudo também mediu desempenho com e sem conhecimento da verdade fundamental da tarefa subjacente. Quando a verdade fundamental está disponível, métodos podem cruzar resultados para melhorar a confiança; sem ela, devem inferir apenas pela dinâmica de interação — mais próximo das condições reais de produção. Em ambos os cenários, contextos mais longos degradam a precisão, especialmente em “quando.”

| Método 🧭 | Forças 💪 | Fraquezas ⚠️ | Melhor Caso de Uso 🧰 |

|---|---|---|---|

| All-at-Once | Baixo custo; forte em “quem” em logs curtos 🙂 | Dificuldade com contextos longos; fraco em “quando” 😵 | Triagem rápida em rastros concisos ⏱️ |

| Step-by-Step | “Quando” preciso; raciocínio transparente 🧠 | Uso alto de tokens; acumulação de erros 📈 | Postmortems para incidentes críticos 🧯 |

| Binary Search | Balanceado; escalável em logs longos ⚖️ | Pode perder pistas sutis entre etapas 🧩 | Triagem rotineira em produção 🔄 |

Equipes podem encadear métodos: usar All-at-Once para selecionar o agente em potencial, depois pivotar para Step-by-Step para localizar a etapa decisiva. Para um roteiro prático, este guia sobre rastreamento da causa raiz de falhas de agentes mostra como estruturar prompts e logs.

Entre as estratégias, raciocínio explícito ajuda. Prompts que pedem uma justificativa, citações de evidências e decisão final tendem a aumentar a consistência. O princípio orientador: force o modelo a mostrar seu trabalho e citar interações específicas — uma pequena mudança que se torna grande em confiabilidade.

O que os Resultados Revelam: Limites, Custos e Oportunidades na Depuração de IA

No Who&When, até os modelos topo de linha receberam um choque de realidade. O melhor método único alcançou cerca de 53,5% na identificação de “quem” causou a falha e cerca de 14,2% no “quando” exato. Alguns métodos ficaram atrás de baselines aleatórios em cenários difíceis, sublinhando que atribuição exige raciocínio causal mais forte do que tarefas típicas de QA ou sumarização.

Os resultados também foram divididos entre o modelo conhecer ou não a resposta verdadeira da tarefa. Com a verdade fundamental, a atribuição pode triangular contradições (“o plano do planejador é incompatível com a resposta correta”). Sem ela, o modelo deve diagnosticar pela dinâmica do diálogo e rastros das ferramentas — visão mais autêntica da produção. Em ambos os casos, contextos mais longos degradam a precisão, principalmente em “quando.”

Principais descobertas para equipes de desenvolvimento

Vários padrões oferecem orientação imediata para equipes que padronizam fluxos de atribuição. Primeiro, a engenharia de prompts importa: prompts estruturados e centrados em justificativas melhoram consistentemente o acordo com anotações humanas. Segundo, cadeias híbridas superam execuções isoladas, embora o custo aumente. Terceiro, designs conscientes do tamanho do contexto — como janelas deslizantes ou resumos seccionais — ajudam a compensar a fadiga contextual.

- 🧠 Justificativas explícitas elevam julgamento de “quem” e “quando.”

- 🧮 Pipeline híbrido troca tokens por qualidade — orce apropriadamente.

- 🧾 Gestão de contexto (janelas, destaques) diminui a queda de precisão.

- 🧰 Escolha do modelo não é bala de prata; até raciocinadores avançados enfrentam dificuldades.

| Dimensão 📏 | Observação 🔭 | Implicação 🧩 | Ação ☑️ |

|---|---|---|---|

| Quem vs. Quando | “Quem” é mais fácil; “Quando” notavelmente mais difícil | Localização temporal é o gargalo ⛔ | Adote raciocínio passo a passo e citações de evidências 🗂️ |

| Métodos híbridos | Maior precisão a custo maior | Útil em incidentes de alta severidade 🔥 | Escale de passes baratos para ricos progressivamente 📶 |

| Comprimento do contexto | Desempenho decai com logs mais longos | Resumo sozinho não basta 🧱 | Use busca binária e preditores de etapas críticas 🧭 |

| Escala do modelo | Maior ≠ sempre melhor | Raciocínio > capacidade bruta aqui 🧠 | Treine padrões de prompt; adicione heurísticas 📐 |

Para comparação pragmática com a resolução diária de problemas, este guia sobre causas raiz de falhas em tarefas de IA casa bem com os resultados empíricos do Who&When, ajudando equipes a conectar métricas a estratégias de correção.

A principal lição é estratégica: faça da atribuição uma etapa de primeira classe em seu pipeline, não um pensamento tardio. Quando ela faz parte do ciclo construir-testar-implantar, a confiabilidade melhora de forma constante, não esporádica.

Manual Prático: Colocando a Atribuição Automática de Falhas em Prática em Laboratórios de Pesquisa e Produção

Transformar pesquisa em prática rotineira começa com instrumentação. Equipes podem sobrepor atribuição em frameworks de orquestração existentes, registrando turnos estruturados com papéis de agentes, invocações de ferramentas e julgamentos preliminares. O resultado é uma trilha reproduzível que apoia tanto a triagem em tempo real quanto análises postmortem, seja em startups ou grandes equipes de plataforma.

Um modelo de fluxo de trabalho testado no campo

O seguinte manual imita como equipes de alta maturidade abordam análise de falhas mantendo os custos gerenciáveis. Ele mistura seleção de métodos, padrões de prompt e higiene de logs em uma prática sustentável para grupos de Aprendizado de Máquina e Engenharia de Software.

- 🧾 Estrutura do log: rotule cada turno com papel, intenção, evidência citada e efeitos das ferramentas.

- 🗂️ Passagem de triagem: execute All-at-Once para “quem” rápido em rastros curtos.

- 🧭 Aprofundamento: para casos complexos, pivote para Binary Search ou Step-by-Step.

- 🧪 Prompts de justificativa: exija explicações e citação de turns específicos.

- 🧯 Regras de escalonamento: use híbridos somente para incidentes graves ou repetidos.

| Etapa 🛠️ | Objetivo 🎯 | Mistura de Métodos 🧪 | Dica Operacional 🧭 |

|---|---|---|---|

| Instrumentação | Capturar logs acionáveis | Tags de papel + rastros de ferramentas | Imponha esquema em CI ✅ |

| Triagem rápida | Encontrar agente provável | All-at-Once | Limite contexto a turns críticos ✂️ |

| Localização | Apontar etapa decisiva | Binary Search → Step-by-Step | Cite evidências dos logs 🔎 |

| Remediação | Aplicar correção direcionada | Atualizações de especificação, testes, guardrails | Reteste contra falhas similares ♻️ |

Para ajudar as equipes a começarem, vários resumos concisos ilustram o caminho do sintoma à causa raiz. Esta visão geral sobre como identificar causas raiz em fluxos de agentes é útil para onboarding, enquanto esta nota complementar sobre depuração de handoffs entre agentes aprofunda armadilhas de coordenação. Para gerentes de engenharia de confiabilidade, um manual sobre design de SLOs informados por atribuição conecta métricas a compromissos operacionais. Equipes em domínios regulamentados podem adaptar as mesmas ideias para trilhas de auditoria: veja as orientações sobre documentação de causalidade de incidentes. E para leituras aprofundadas, um mergulho prático na análise de causa raiz alinha-se bem ao esquema do Who&When.

Duvas notas finais para implantação. Primeiro, a atribuição deve ser agnóstica ao modelo e centrada em logs: imponha um esquema para que qualquer modelo possa participar. Segundo, monitore custos explicitamente; escolha híbridos apenas quando a severidade justificar. A regra prática é clara: otimize para correções rápidas e explicáveis, depois aumente a sofisticação conforme a taxonomia de incidentes amadurece.

Da Pesquisa ao Roadmap: O que o Trabalho da PSU e Duke Significa para a Próxima Onda de Sistemas Autônomos

Ao formalizar a Atribuição Automática de Falhas, a equipe da PSU e Duke University redefinem a depuração como uma capacidade mensurável em sistemas de Inteligência Artificial, não uma habilidade artesanal. Essa mudança beneficia pesquisadores, equipes de plataforma e líderes de produto igualmente. É uma ponte entre avaliação e melhoria — o elo perdido que torna a iteração sistemática.

Para onde isso vai

O caminho à frente provavelmente apresentará sinais causais mais ricos (por exemplo, semântica das ferramentas), previsão de etapas críticas e políticas aprendidas para seleção de métodos sob restrições de custo. Espere integração mais apertada com frameworks de orquestração, testes de contratos para APIs entre agentes e dashboards onde “quem” e “quando” fluem para templates de remediação. À medida que a atribuição amadurece, Sistemas Multiagente se tornarão menos frágeis e suas falhas menos misteriosas.

- 🧭 Sinais causais: integre resultados de ferramentas e diferenças de estado nos prompts do atribuidor.

- 🧱 Agentes com guardrails: adicione verificações ativadas por padrões de “quem/quando” arriscados.

- 📊 Visibilidade operacional: destaque métricas de atribuição em scorecards de confiabilidade.

- 🧑⚖️ Governança: mantenha narrativas prontas para auditoria para revisões de incidentes.

| Interessado 👥 | Valor da Atribuição 💡 | Primeiro Passo 🪜 | Sinal a Observar 👁️ |

|---|---|---|---|

| Laboratórios de Pesquisa | Baselines comparáveis entre métodos | Adoção das divisões Who&When | Lacuna entre “quem” e “quando” 📉 |

| Equipes de Plataforma | Resolução mais rápida de incidentes | Logs com esquema obrigatório | Tempo médio até atribuição ⏱️ |

| Proprietários de Produto | Ciclos de iteração previsíveis | Manual de triagem | Taxa de regressão após correções 🔁 |

| Conformidade | Postmortems prontos para auditoria | Narrativas templateadas | Cobertura das justificativas “por quê” 📚 |

Antes a depuração era uma arte. Com a atribuição, ela se torna um recurso do sistema operacional para produtos de IA. A direção é inequívoca: confiabilidade através de raciocínio baseado em evidências, com a contribuição da PSU e Duke marcando um passo decisivo.

{“@context”:”https://schema.org”,”@type”:”FAQPage”,”mainEntity”:[{“@type”:”Question”,”name”:”O que exatamente é Atribuição Automática de Falhas?”,”acceptedAnswer”:{“@type”:”Answer”,”text”:”É uma tarefa formal que identifica qual agente é responsável por uma falha (‘quem’) e a etapa de erro decisiva (‘quando’) em Sistemas Multiagente LLM. A equipe da PSU e Duke University definiu a tarefa e lançou o benchmark Who&When com anotações humanas para quem, quando e por quê.”}},{“@type”:”Question”,”name”:”Por que os métodos atuais têm apenas cerca de 53,5% para ‘quem’ e 14,2% para ‘quando’?”,”acceptedAnswer”:{“@type”:”Answer”,”text”:”A atribuição requer raciocínio causal sobre logs longos e ruidosos. Modelos devem isolar a etapa decisiva que garantiu a falha, o que é mais difícil que o QA típico. Comprimento do contexto, repasses sutis e erros cumulativos tornam ‘quando’ particularmente desafiador.”}},{“@type”:”Question”,”name”:”Como as equipes devem começar a usar atribuição em produção?”,”acceptedAnswer”:{“@type”:”Answer”,”text”:”Instrumente logs com tags de papéis e rastros de ferramentas, execute triagem rápida All-at-Once e depois escale para Binary Search ou Step-by-Step em incidentes difíceis. Exija justificativas explícitas nos prompts e monitore custo para usar híbridos só quando a severidade justificar.”}},{“@type”:”Question”,”name”:”Isso substitui testes unitários e avaliações?”,”acceptedAnswer”:{“@type”:”Answer”,”text”:”Não. Atribuição complementa testes e avaliações explicando a causalidade da falha. Conecta ‘o que falhou’ a ‘por que falhou’, permitindo correções direcionadas e melhores testes de regressão.”}},{“@type”:”Question”,”name”:”Onde posso aprender técnicas práticas de análise de causa raiz para agentes?”,”acceptedAnswer”:{“@type”:”Answer”,”text”:”Um ponto de partida conciso e aplicável é este guia sobre rastreamento de falhas: veja o recurso sobre causas raiz de falhas em tarefas aqui: https://chat-gpt-5.ai/task-failure-root-causes.”}}]}O que exatamente é Atribuição Automática de Falhas?

É uma tarefa formal que identifica qual agente é responsável por uma falha (‘quem’) e a etapa de erro decisiva (‘quando’) em Sistemas Multiagente LLM. A equipe da PSU e Duke University definiu a tarefa e lançou o benchmark Who&When com anotações humanas para quem, quando e por quê.

Por que os métodos atuais têm apenas cerca de 53,5% para ‘quem’ e 14,2% para ‘quando’?

A atribuição requer raciocínio causal sobre logs longos e ruidosos. Modelos devem isolar a etapa decisiva que garantiu a falha, o que é mais difícil que o QA típico. Comprimento do contexto, repasses sutis e erros cumulativos tornam ‘quando’ particularmente desafiador.

Como as equipes devem começar a usar atribuição em produção?

Instrumente logs com tags de papéis e rastros de ferramentas, execute triagem rápida All-at-Once e depois escale para Binary Search ou Step-by-Step em incidentes difíceis. Exija justificativas explícitas nos prompts e monitore custo para usar híbridos só quando a severidade justificar.

Isso substitui testes unitários e avaliações?

Não. Atribuição complementa testes e avaliações explicando a causalidade da falha. Conecta ‘o que falhou’ a ‘por que falhou’, permitindo correções direcionadas e melhores testes de regressão.

Onde posso aprender técnicas práticas de análise de causa raiz para agentes?

Um ponto de partida conciso e aplicável é este guia sobre rastreamento de falhas: veja o recurso sobre causas raiz de falhas em tarefas aqui: https://chat-gpt-5.ai/task-failure-root-causes.

-

Open Ai1 week ago

Open Ai1 week agoDesbloqueando o Poder dos Plugins do ChatGPT: Melhore Sua Experiência em 2025

-

Open Ai6 days ago

Open Ai6 days agoDominando o Fine-Tuning do GPT: Um Guia para Customizar Eficazmente Seus Modelos em 2025

-

Open Ai7 days ago

Open Ai7 days agoComparando o ChatGPT da OpenAI, o Claude da Anthropic e o Bard do Google: Qual Ferramenta de IA Generativa Reinará Suprema em 2025?

-

Open Ai6 days ago

Open Ai6 days agoPreços do ChatGPT em 2025: Tudo o Que Você Precisa Saber Sobre Tarifas e Assinaturas

-

Open Ai7 days ago

Open Ai7 days agoO Fim Gradual dos Modelos GPT: O que os Usuários Podem Esperar em 2025

-

Modelos de IA6 days ago

Modelos de IA6 days agoModelos GPT-4: Como a Inteligência Artificial está Transformando 2025