Innovation

PSU und Duke-Forscher stellen bahnbrechende automatisierte Fehlerzuordnung für Multi-Agenten-Systeme vor

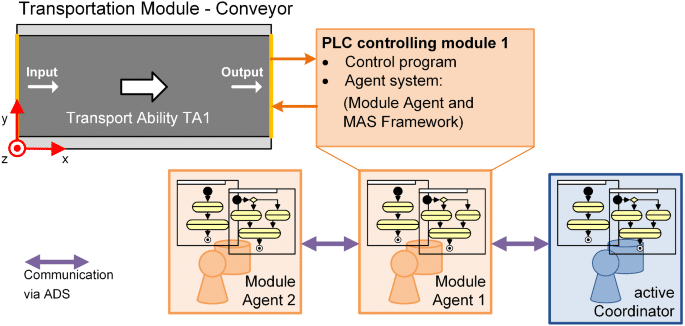

Forscher von PSU und der Duke University haben zusammen mit Mitarbeitern von Google DeepMind und anderen Forschungslaboren ein neues Problem in der Künstlichen Intelligenz formalisiert: Automatisierte Fehlerzuordnung für LLM-gesteuerte Multi-Agenten-Systeme. Die Arbeit führt den Who&When-Benchmark ein, einen Datensatz und eine Evaluierungssuite, die darauf ausgelegt sind, zu identifizieren, welcher Agent einen Ausfall verursacht hat und in welchem Schritt. Der Ansatz kommt zu einem günstigen Zeitpunkt, da autonome Systeme skalieren und Debugging schnellere, präzisere Diagnosewerkzeuge erfordern.

| In Eile? Das Wichtigste im Überblick: |

|---|

| • 🔎 Neue Aufgabe: Automatisieren von „wer gescheitert ist“ und „wann es passiert ist“ in Multi-Agenten-Systemen. |

| • 🧪 Who&When-Benchmark: Menschlich annotierte Logs von 127 Systemen ermöglichen standardisierte Tests. |

| • 📉 Herausfordernde Ergebnisse: ~53,5 % bei „wer“ und ~14,2 % bei „wann“; aktuelle Methoden scheitern bei langen Logs. |

| • 🧰 Umsetzbare nächste Schritte: Testen Sie hybride Strategien und strukturierte Prompts; sehen Sie einen praktischen Leitfaden zu Ursachen für Aufgabenausfälle 🔧 |

Warum automatisierte Fehlerzuordnung in Multi-Agenten-Systemen wichtig ist: Durchbruch der PSU- und Duke-Forscher

Mit der Skalierung der von LLM angetriebenen Multi-Agenten-Systeme stoßen Entwickler oft auf ein Paradoxon: eine Flut von Agenten-Nachrichten, aktiven Tools, Chain-of-Thought-Reasoning – dennoch schlägt die Aufgabe fehl. Im Sinne der Informatik verschiebt sich das Problem von „Was war die richtige Antwort?“ zu „An welcher Stelle im Kollaborationsprozess trat der Fehler auf?“ Genau diese Lücke adressiert das Team von PSU und Duke mit automatisierter Fehlerzuordnung. Das Ziel: Stundenlanges Durchsuchen von Logs in einen transparenten, strukturierten Diagnose-Schritt verwandeln.

Betrachten Sie Ava, eine Plattformingenieurin bei einem Fintech-Startup. Ihr Team für autonome Systeme verwendet vier spezialisierte Agenten – Planer, Forscher, Programmierer und Tester. Eine Kundenanfrage schlägt nach 23 Interaktionen fehl. Ohne Zuordnung ist die Ursachenanalyse unklar: Hat der Planer Teilziele falsch definiert, hat der Forscher eine wichtige API übersehen oder hat der Tester die Ausgabe falsch interpretiert? Die Fehlerzuordnung fungiert wie ein Blackbox-Rekorder für die Koordination, der den verantwortlichen Agenten und den entscheidenden Schritt identifiziert, bei dem der Fehler die Fehlfunktion ausgelöst hat.

Das Debugging-Engpass, dem Entwickler gegenüberstehen

Moderne KI-Workflows stoßen häufig an die Grenzen der Beobachtbarkeit, nicht an die Modellierungsfähigkeit. Selbst mit starken Machine-Learning-Modellen erschweren unklare Verantwortungsbereiche Iterationszyklen und Governance. Die von PSU angeführte Formulierung formalisiert dies als eigenständige Aufgabe, die Debugging mit Evaluation verbindet – ein überfälliger Schritt für Automatisierung im großen Maßstab.

- 🧵 Lange Interaktionsketten erschweren das Erkennen von Kausalität durch ausführliche Logs.

- 🧭 Mehrdeutige Agentenrollen verwischen, wer eine Entscheidung traf und wer sie weiterleitete.

- ⏱️ Diagnosezeiten steigen, wenn jeder Fehler menschliches Detektivspiel verlangt.

- 🔐 Compliance-Druck verlangt Nachvollziehbarkeit über Forschungslabore und Produktionsstacks hinweg.

Der Who&When-Benchmark begegnet diesem Problem, indem er „wer“ und „wann“ standardisiert annotiert und quantitative Bewertung ermöglicht. Gleichzeitig schafft er eine gemeinsame Sprache zwischen Teams: Ein Fehler ist nicht einfach ein Fehlschlag, sondern ein spezifischer Agenten-Schritt-Fehler, der nachvollziehbar und korrigierbar ist.

| Herausforderung 🚧 | Warum es schmerzt 💥 | Nutzen der Zuordnung ✅ |

|---|---|---|

| Undurchsichtige Agenten-Kooperation | Fehlplatzierte Schuldzuweisungen oder unscharfe Korrekturen | Präzises „Wer“ zeigt die Verantwortung 🔍 |

| Lange Logs und Kontextgrenzen | Wichtiger Schritt geht im Rauschen unter | Exaktes „Wann“ schränkt Suchfenster ein ⏳ |

| Manuelle Log-Archäologie | Langsame Iterationen und Burnout | Automatisierte Sortierung beschleunigt Bugfix-Zyklen 🚀 |

| Compliance-/Audit-Anforderungen | Uneinheitliche Postmortems | Standardisierte, reproduzierbare Nachweise 📚 |

Für Teams, die komplexe KI-Deployments betreuen, ist der Kern einfach: Zurechenbarkeit verwandelt Chaos in Verantwortlichkeit und schafft einen Workflow, der direkt die Zuverlässigkeit unterstützt.

Inside the Who&When Benchmark: Datenentwurf, Annotationen und Abdeckung für Fehlerzuordnung

Der Who&When-Benchmark bündelt Fehlerlogs aus 127 Multi-Agenten-Systemen, die unterschiedliche Aufgaben, Tool-Einsätze und Kooperationsmuster abdecken. Einige Logs werden algorithmisch erzeugt, um bestimmte Fehlermodi zu belasten; andere sind von Experten handgefertigt und spiegeln realistische Fehlerszenarien wider. Jeder Log enthält drei wichtige Annotationen: Wer den Fehler verursachte, Wann der entscheidende Schritt stattfand, und Warum dies in natürlicher Sprache passierte.

Dieses Dreigestirn ist entscheidend. „Wer“ schafft Verantwortlichkeit; „Wann“ liefert einen zeitlichen Anker; „Warum“ bietet kausale Begründung, die einen Korrektur-Patch lenkt. Zusammengenommen machen sie Fehler nicht nur erkennbar, sondern erklärbar – eine Voraussetzung für nachhaltige Automatisierung in Produktionsumgebungen. Standardisierung ermöglicht zudem faire Vergleiche zwischen Forschungslaboren und vermeidet Einzelfallmetriken, die Generalisierungslücken verschleiern.

Was annotiert wird und warum es wichtig ist

Die Annotation-Richtlinien sorgen dafür, dass schwierige Randfälle – wie Kettenfehler oder stille Drift – konsistent behandelt werden. Wenn mehrere Agenten zu einem Ausfall beitragen, markieren die Annotatoren den entscheidenden Punkt, an dem Erfolg unerreichbar wurde. Das ist besonders nützlich in Planungspipelines, wo eine frühe Fehlspezifikation spätere Schritte trotz isoliert korrektem Aussehen zum Scheitern bringt.

- 🧩 Rollenidentität: Planer, Kritiker, Ausführer, Tool-Aufrufer, Prüfer usw.

- 🕰️ Schrittindex: der entscheidende Moment, der das Ergebnis kippt.

- 🗣️ Rationale in natürlicher Sprache: eine knappe Erklärung des kausalen Zusammenhangs.

- 🧪 Aufgaben-Metadaten: Domäne, eingesetzte Tools, Verfügbarkeit der Ground-Truth.

Die Breite des Benchmarks unterstützt Studien über Domänen hinweg – Programmierhilfe, Datenanalyse, Content-Planung und reale Entscheidungsunterstützung. Es ermöglicht auch kontrollierte Ablationen: Hält die Zuordnung, wenn sich die Agentenbesetzung ändert oder Tools intermittierend ausfallen?

| Annotationsfeld 📝 | Definition 📘 | Debugging-Wert 🧯 |

|---|---|---|

| Wer | Agent verantwortlich für den entscheidenden Fehler | Fokussiert die Behebung auf das richtige Modul 🎯 |

| Wann | Spezifischer Schritt, an dem der fatale Fehler auftrat | Reduziert den Suchraum im Log drastisch 🔍 |

| Warum | Erklärung in natürlicher Sprache für die Kausalität | Leitet Patch-Design und Testfälle an 🧪 |

| Kontext | Aufgabentyp, Tools und Status der Ground-Truth | Ermöglicht faire Methodenvergleiche ⚖️ |

Für Teams, die Postmortems vor Vorfällen einüben wollen, ist ein praktischer Einstieg eine Checkliste, die vom Who&When-Benchmark informiert ist. Eine hilfreiche Begleitressource ist dieser knappe Leitfaden zum Aufspüren von Aufgabenausfall-Ursachen in KI-Systemen, der benchmarkgestütztes Debugging ergänzt.

Entwickler fragen oft, ob ein automatisches Tool „mir einfach sagen kann, was zu beheben ist“. Attribution ersetzt keine ingenieurmäßige Einschätzung, liefert aber die Beweiskette, die schnelle und nachvollziehbare Entscheidungen ermöglicht. Das Ergebnis: Der Datensatz macht Fehleranalyse zu einer wiederholbaren, lehrbaren Fähigkeit.

Vergleich der Methoden: All-at-Once, Schritt-für-Schritt und Binary-Search-Strategien von PSU und Duke

Mit Who&When bewerteten die Forscher drei Strategien für automatische Fehlerzuordnung. Jede Methode balanciert Kosten, Genauigkeit und Robustheit bei langen Kontexten. Anstatt eines einzigen Champions hebt die Studie das Toolkit-Konzept hervor: Wählen Sie die Methode passend zu Budget und Fehlersituation.

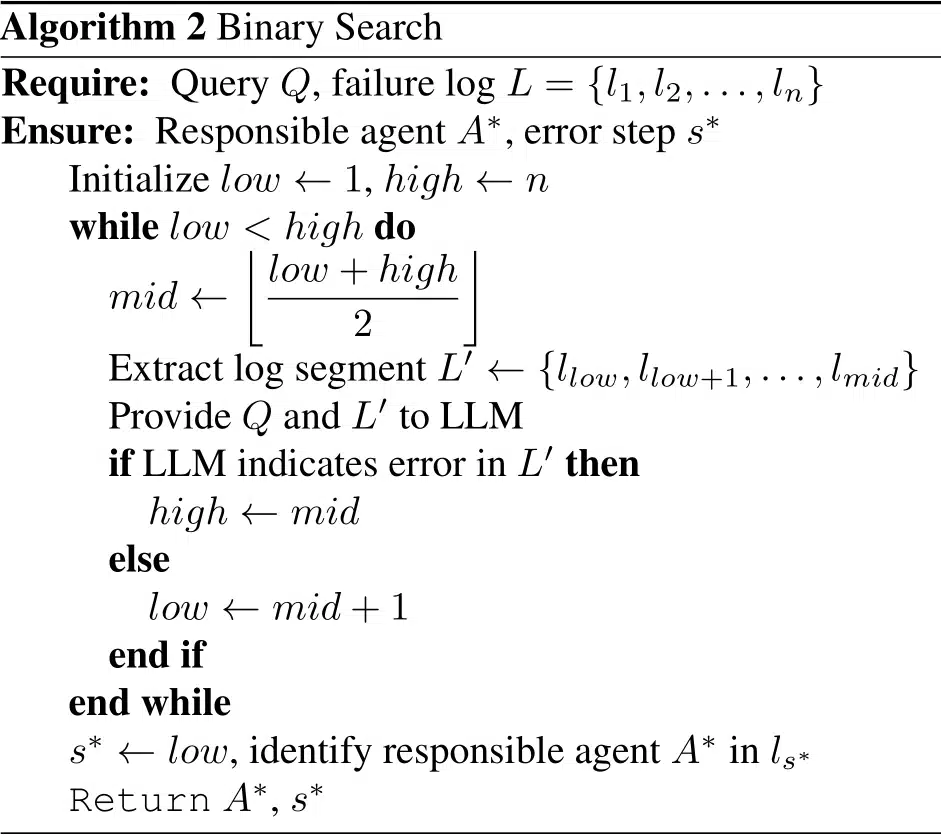

Drei Strategien, drei Denkweisen

All-at-Once liest das gesamte Fehlerprotokoll und gibt den verantwortlichen Agenten und den entscheidenden Schritt in einem Durchlauf aus. Effizient bei kurzen Logs und oft besser bei „wer“, kann aber das „wann“ mit steigendem Kontext falsch zuordnen. Schritt-für-Schritt spiegelt menschliches Detektivarbeit wider: Es betrachtet jeden Schritt einzeln. Das verbessert die Lokalisierung, kann aber frühere Beurteilungsfehler verstärken und erhöht die Token-Kosten. Binary Search geht einen Mittelweg, indem es das Log rekursiv halbiert und fragt, in welcher Hälfte sich der Fehler verbirgt, und so Kosten und Präzision ausbalanciert.

- ⚡ All-at-Once: schnell, grob, solide für „wer“.

- 🪜 Schritt-für-Schritt: sorgfältig, kostenintensiver, besser für „wann“.

- 🔍 Binary Search: pragmatisch, guter Durchschnitts-Trade-off.

- 🧩 Hybride Ketten: kombinieren Stärken zu höheren Rechenkosten.

Die Studie testete die Performance mit und ohne Wissen über die zugrundeliegende Aufgabe. Mit Ground-Truth können Methoden Widersprüche („Der Plan des Planers passt nicht zur richtigen Antwort“) prüfen und die Sicherheit erhöhen; ohne Ground-Truth müssen sie nur anhand der Interaktionsdynamik und Tool-Nutzung diagnostizieren – näher an realen Produktionsbedingungen. In beiden Fällen nimmt die Genauigkeit mit längerem Kontext besonders bei „wann“ ab.

| Methode 🧭 | Stärken 💪 | Schwächen ⚠️ | Beste Einsatzgebiete 🧰 |

|---|---|---|---|

| All-at-Once | Niedrige Kosten; stark bei „wer“ in kurzen Logs 🙂 | Probleme bei langem Kontext; schwächer bei „wann“ 😵 | Schnelle Abklärung bei kurzen Abläufen ⏱️ |

| Schritt-für-Schritt | Präzises „wann“; transparente Begründung 🧠 | Hoher Tokenverbrauch; Fehlerakkumulation 📈 | Postmortems bei kritischen Vorfällen 🧯 |

| Binary Search | Ausgewogen; skaliert bei längeren Logs ⚖️ | Könnte subtile Querverbindungen übersehen 🧩 | Routine-Triage in der Produktion 🔄 |

Teams können Methoden kombinieren: All-at-Once zur Eingrenzung des Agenten, dann Schritt-für-Schritt, um den entscheidenden Schritt präzise zu bestimmen. Für eine praktische Implementierungsanleitung zeigt dieses Tutorial zu Ursachenermittlung bei Agentenausfällen, wie man Prompts und Logs strukturiert.

Explizite Begründungen fördern durchgängig die Performance. Prompts, die eine rationale Erklärung, Beweiszitate und eine abschließende Entscheidung verlangen, steigern die Konsistenz. Die Leitlinie: Erzwingen Sie, dass das Modell seine Arbeit zeigt und bestimmte Schritte zitiert – eine kleine Änderung, die sich in der Zuverlässigkeit summiert.

Was die Ergebnisse zeigen: Grenzen, Kosten und Chancen beim KI-Debugging

Im Who&When-Benchmark mussten selbst Spitzenmodelle eine Ernüchterung erleben. Die beste Einzelmethode erreichte rund 53,5% bei der Identifikation von „wer“ den Fehler verursachte und circa 14,2% bei der exakten Bestimmung des „wann“. Einige Methoden schnitten bei schwierigen Einstellungen schlechter als zufällige Baselines ab, was verdeutlicht, dass Attribution stärkere kausale Schlussfolgerungen verlangt als typische QA- oder Zusammenfassungsaufgaben.

Die Ergebnisse differenzieren auch danach, ob das Modell die wahre Aufgabe kennt. Mit Ground-Truth kann Attribution Widersprüche triangulieren („Der Plan des Planers stimmt nicht mit der korrekten Antwort überein“). Ohne Ground-Truth muss das Modell allein anhand der Dynamik der Interaktionen und Tool-Nutzung diagnostizieren – eine authentischere Sicht auf Produktion. In beiden Fällen verschlechtert sich die Genauigkeit bei länger werdenden Kontexten, insbesondere für „wann“.

Schlüsselerkenntnisse für Entwickler

Mehrere Muster bieten sofortige Handlungsempfehlungen für Ingenieurteams, die Attribution-Workflows standardisieren. Erstens: Prompt-Engineering ist entscheidend – strukturierte, rationale-erst Prompts verbessern die Übereinstimmung mit menschlichen Annotationen. Zweitens: hybride Methodenketten übertreffen Einzelmethoden, obwohl die Kosten steigen. Drittens: längenbewusste Entwürfe – wie gleitende Fenster oder Abschnittszusammenfassungen – helfen, Kontext-Erschöpfung auszugleichen.

- 🧠 Explizite Begründungen verbessern sowohl „wer“ als auch „wann“.

- 🧮 Hybride Pipelines tauschen Token gegen Qualität – Budget entsprechend planen.

- 🧾 Kontext-Management (Fenster, Hervorhebungen) verlangsamt Genauigkeitsverlust.

- 🧰 Die Wahl des Modells ist kein Allheilmittel; selbst fortschrittliche Reasoner kämpfen.

| Dimension 📏 | Beobachtung 🔭 | Implikation 🧩 | Maßnahme ☑️ |

|---|---|---|---|

| Wer vs. Wann | „Wer“ leichter; „Wann“ deutlich schwieriger | Zeitliche Lokalisierung ist der Engpass ⛔ | Nutzen Sie schrittweise Argumentation und Beweiszitate 🗂️ |

| Hybride Methoden | Höhere Genauigkeit bei größeren Kosten | Nützlich bei schweren Vorfällen 🔥 | Stufenweise von kostengünstig zu aufwändig eskalieren 📶 |

| Kontextlänge | Performance sinkt bei längeren Logs | Zusammenfassung allein reicht nicht 🧱 | Verwenden Sie Binary Search und prädiktive kritische Schritte 🧭 |

| Modellgröße | Größer ≠ immer besser | Reasoning > reine Kapazität hier 🧠 | Trainieren Sie Prompt-Muster; ergänzen Sie Heuristiken 📐 |

Für einen pragmatischen Vergleich mit Alltagstroubleshooting passt dieser Leitfaden zu KI-Aufgabenausfall-Ursachen gut zu den empirischen Ergebnissen von Who&When und hilft Teams, Metriken mit Fixstrategien zu verbinden.

Die zentrale Erkenntnis ist strategisch: machen Sie Attribution zu einer vorrangigen Stufe in Ihrer Pipeline und nicht zu einem Nachgedanken. Wenn sie Teil des Build-Test-Deploy-Zyklus wird, verbessert sich die Zuverlässigkeit stetig statt sporadisch.

Praktisches Playbook: Automatisierte Fehlerzuordnung in Forschungslabors und Produktion einsetzen

Der Weg von der Forschung zur Routine beginnt mit Instrumentierung. Teams können Attribution auf bestehende Orchestrierungs-Frameworks legen, strukturierte Schritte mit Agentenrollen, Tool-Aufrufen und Zwischenurteilen protokollieren. Ergebnis ist eine reproduzierbare Spur, die sowohl Echtzeit-Triage als auch Post-Vorfall-Reviews unterstützt – egal ob im Startup oder einem großen Plattformteam.

Ein erprobtes Workflow-Template

Das folgende Playbook spiegelt wider, wie Teams mit hoher Reife Fehleranalyse angehen und dabei die Kosten im Griff behalten. Es verbindet die Methodenauswahl, Prompt-Patterns und Loghygiene zu einer nachhaltigen Praxis für Machine Learning und Software Engineering-Teams.

- 🧾 Log-Struktur: Markieren Sie jeden Schritt mit Rolle, Absicht, Beweiszitat und Toe-Effekten.

- 🗂️ Triage-Durchlauf: Führen Sie All-at-Once für eine schnelle „Wer“-Bestimmung bei kurzen Ablaufprotokollen durch.

- 🧭 Tiefenanalyse: Bei komplexen Fällen auf Binary Search oder Schritt-für-Schritt umschwenken.

- 🧪 Begründungs-Prompts: Erklären lassen und konkrete Schritte zitieren.

- 🧯 Eskalationsregeln: Hybride nur für schwere oder wiederholte Vorfälle nutzen.

| Phase 🛠️ | Ziel 🎯 | Methode Mix 🧪 | Praxis-Tipp 🧭 |

|---|---|---|---|

| Instrumentierung | Handhabbare Logs erfassen | Rollen-Tags + Tool-Spuren | Schemata in CI erzwingen ✅ |

| Schnelle Triage | Wahrscheinlichen Agenten finden | All-at-Once | Kontext auf kritische Schritte beschränken ✂️ |

| Lokalisierung | Entscheidenden Schritt identifizieren | Binary Search → Schritt-für-Schritt | Zitiere Belege aus dem Log 🔎 |

| Behebung | Zielgerichteten Fix anwenden | Spezifikations-Updates, Tests, Schutzmechanismen | Rücktesten mit ähnlichen Fehlern ♻️ |

Um Teams den Einstieg zu erleichtern, veranschaulichen mehrere kurze Erklärungen den Weg vom Symptom zur Wurzelursache. Diese Übersicht zu Aufspüren von Ursachen in Agenten-Workflows ist nützlich für Onboarding, während diese Begleitnotiz zu Debugging von Agentenübergaben Koordinationsfallen beleuchtet. Für Verlässlichkeit-Engineering-Manager verbindet ein Playbook zu design von attributionsbasierten SLOs Metriken mit operativen Verpflichtungen. Teams, die in regulierten Domänen standardisieren, können dieselben Ideen für Audit-Artefakte adaptieren: Siehe die Anleitung zu Dokumentation von Vorfallkausalitäten. Für tiefere Hintergrundlektüre passt ein praxisnaher Deep Dive in Root Cause Analysis gut zum Schema von Who&When.

Zwei abschließende Hinweise zur Umsetzung: Erstens sollte Attribution modellagnostisch und log-zentriert sein: Erzwingen Sie ein Schema, so dass jedes Modell mitmachen kann. Zweitens: Verfolgen Sie die Kosten explizit; Hybride nur verwenden, wenn die Schwere es rechtfertigt. Die praktische Regel ist klar: Optimieren Sie für schnelle, erklärbare Behebungen und skalieren Sie die Komplexität, wenn Ihre Vorfall-Taxonomie reift.

Von der Forschung zur Roadmap: Was die Arbeit von PSU und Duke für die nächste Welle autonomer Systeme bedeutet

Durch die Formalisierung der automatisierten Fehlerzuordnung rahmen das PSU- und Duke-Team Debugging als messbare Fähigkeit innerhalb von KI-Systemen und nicht als handwerkliches Können neu. Dieser Wandel nützt Forschern, Plattformteams und Produktleitern gleichermaßen. Er ist eine Brücke zwischen Evaluierung und Verbesserung – das fehlende Bindeglied, das Iteration systematisch macht.

Wohin die Reise geht

Der Weg nach vorn wird wahrscheinlich reichhaltigere kausale Signale (z. B. Tool-Semantik), Vorhersagen kritischer Schritte und gelernte Richtlinien für die Methodenauswahl unter Kostenbeschränkungen bieten. Man erwartet eine engere Integration mit Orchestrierungs-Frameworks, Vertragstests für Agenten-APIs und Dashboards, in denen „wer“ und „wann“ in Behebungs-Templates einfließen. Mit fortschreitender Reife der Fehlerzuordnung werden Multi-Agenten-Systeme weniger anfällig und ihre Ausfälle weniger mysteriös.

- 🧭 Kausale Hinweise: Integration von Tool-Ergebnissen und Zustandsdifferenzen in Zuordnungs-Prompts.

- 🧱 Schutzgepanzerte Agenten: Fügen Sie Prüfungen hinzu, die bei riskanten „wer/wann“-Mustern auslösen.

- 📊 Sichtbarkeit für den Betrieb: Visualisieren Sie Zuordnungsmetriken in Zuverlässigkeits-Scorecards.

- 🧑⚖️ Governance: Pflegen Sie prüffähige Narrative für Vorfall-Reviews.

| Stakeholder 👥 | Mehrwert der Zuordnung 💡 | Erster Schritt 🪜 | Signal zum Beobachten 👁️ |

|---|---|---|---|

| Forschungslabore | Vergleichbare Benchmarks zwischen Methoden | Wer&Wann-Splits übernehmen | Unterschied zwischen „wer“ und „wann“ 📉 |

| Plattform-Teams | Schnellere Vorfallbehebung | Schematisierte Logs | Mittlere Zeit bis zur Zuordnung ⏱️ |

| Produktverantwortliche | Vorhersehbare Iterationszyklen | Triage-Playbook | Regressionsrate nach Fixes 🔁 |

| Compliance | Prüffähige Postmortems | Vorlagen-Narrative | Abdeckung der „Warum“-Begründungen 📚 |

Debugging war früher ein Handwerk. Mit Attribution wird es zur Betriebssystem-Fähigkeit für KI-Produkte. Die Richtung ist unmissverständlich: Zuverlässigkeit durch evidenzbasiertes Schlussfolgern, wobei der Beitrag von PSU und Duke einen entscheidenden Schritt markiert.

{“@context”:”https://schema.org”,”@type”:”FAQPage”,”mainEntity”:[{“@type”:”Question”,”name”:”Was genau ist automatisierte Fehlerzuordnung?”,”acceptedAnswer”:{“@type”:”Answer”,”text”:”Es ist eine formale Aufgabe, die identifiziert, welcher Agent für einen Fehler (‘wer’) und welcher entscheidende Fehler-Schritt (‘wann’) in LLM-Multi-Agenten-Systemen verantwortlich ist. Das PSU- und Duke-Team hat die Aufgabe definiert und den Who&When-Benchmark mit menschlichen Annotationen für wer, wann und warum veröffentlicht.”}},{“@type”:”Question”,”name”:”Warum erreichen aktuelle Methoden nur etwa 53,5 % für ‘wer’ und 14,2 % für ‘wann’?”,”acceptedAnswer”:{“@type”:”Answer”,”text”:”Die Zuordnung erfordert kausales Denken über lange, verrauschte Logs. Modelle müssen den entscheidenden Schritt isolieren, der den Fehler garantiert hat, was schwieriger ist als typische QA. Kontextlänge, subtile Übergaben und kumulative Fehler machen das ‘wann’ besonders herausfordernd.”}},{“@type”:”Question”,”name”:”Wie sollten Teams mit der Nutzung von Attribution in der Produktion beginnen?”,”acceptedAnswer”:{“@type”:”Answer”,”text”:”Instrumentieren Sie Logs mit Rollen-Tags und Tool-Spuren, führen Sie eine schnelle All-at-Once-Triage durch und eskalieren Sie dann bei schwierigen Vorfällen zu Binary Search oder Schritt-für-Schritt. Fordern Sie explizite Begründungen in Prompts und verfolgen Sie die Kosten, sodass Hybride nur bei entsprechender Schwere eingesetzt werden.”}},{“@type”:”Question”,”name”:”Ersetzt dies Unit-Tests und Evaluierungen?”,”acceptedAnswer”:{“@type”:”Answer”,”text”:”Nein. Attribution ergänzt Tests und Evaluierungen, indem sie die Fehlerursache erklärt. Sie verbindet ‘was schiefgelaufen ist’ mit ‘warum es schiefgelaufen ist’ und ermöglicht gezielte Korrekturen und bessere Regressionstests.”}},{“@type”:”Question”,”name”:”Wo kann ich praktische Techniken zur Ursachenanalyse für Agenten lernen?”,”acceptedAnswer”:{“@type”:”Answer”,”text”:”Ein knapper, anwendbarer Einstieg ist dieser Leitfaden zur Fehlernachverfolgung: sehen Sie die Ressource zu Aufgabenausfall-Ursachen hier: https://chat-gpt-5.ai/task-failure-root-causes.”}}]}Was genau ist automatisierte Fehlerzuordnung?

Es ist eine formale Aufgabe, die identifiziert, welcher Agent für einen Fehler (‘wer’) und welcher entscheidende Fehler-Schritt (‘wann’) in LLM-Multi-Agenten-Systemen verantwortlich ist. Das PSU- und Duke-Team hat die Aufgabe definiert und den Who&When-Benchmark mit menschlichen Annotationen für wer, wann und warum veröffentlicht.

Warum erreichen aktuelle Methoden nur etwa 53,5 % für ‘wer’ und 14,2 % für ‘wann’?

Die Zuordnung erfordert kausales Denken über lange, verrauschte Logs. Modelle müssen den entscheidenden Schritt isolieren, der den Fehler garantiert hat, was schwieriger ist als typische QA. Kontextlänge, subtile Übergaben und kumulative Fehler machen das ‘wann’ besonders herausfordernd.

Wie sollten Teams mit der Nutzung von Attribution in der Produktion beginnen?

Instrumentieren Sie Logs mit Rollen-Tags und Tool-Spuren, führen Sie eine schnelle All-at-Once-Triage durch und eskalieren Sie dann bei schwierigen Vorfällen zu Binary Search oder Schritt-für-Schritt. Fordern Sie explizite Begründungen in Prompts und verfolgen Sie die Kosten, sodass Hybride nur bei entsprechender Schwere eingesetzt werden.

Ersetzt dies Unit-Tests und Evaluierungen?

Nein. Attribution ergänzt Tests und Evaluierungen, indem sie die Fehlerursache erklärt. Sie verbindet ‘was schiefgelaufen ist’ mit ‘warum es schiefgelaufen ist’ und ermöglicht gezielte Korrekturen und bessere Regressionstests.

Wo kann ich praktische Techniken zur Ursachenanalyse für Agenten lernen?

Ein knapper, anwendbarer Einstieg ist dieser Leitfaden zur Fehlernachverfolgung: sehen Sie die Ressource zu Aufgabenausfall-Ursachen hier: https://chat-gpt-5.ai/task-failure-root-causes.

-

Open Ai1 week ago

Open Ai1 week agoEntfesselung der Power von ChatGPT-Plugins: Verbessern Sie Ihr Erlebnis im Jahr 2025

-

Open Ai6 days ago

Open Ai6 days agoMastering GPT Fine-Tuning: Ein Leitfaden zur effektiven Anpassung Ihrer Modelle im Jahr 2025

-

Open Ai7 days ago

Open Ai7 days agoVergleich von OpenAIs ChatGPT, Anthropics Claude und Googles Bard: Welches generative KI-Tool wird 2025 die Vorherrschaft erlangen?

-

Open Ai6 days ago

Open Ai6 days agoChatGPT-Preise im Jahr 2025: Alles, was Sie über Tarife und Abonnements wissen müssen

-

Open Ai7 days ago

Open Ai7 days agoDas Auslaufen der GPT-Modelle: Was Nutzer im Jahr 2025 erwartet

-

KI-Modelle6 days ago

KI-Modelle6 days agoGPT-4-Modelle: Wie Künstliche Intelligenz das Jahr 2025 verändert