Innovation

Les chercheurs de PSU et Duke dévoilent une attribution automatisée révolutionnaire des défaillances pour les systèmes multi-agents

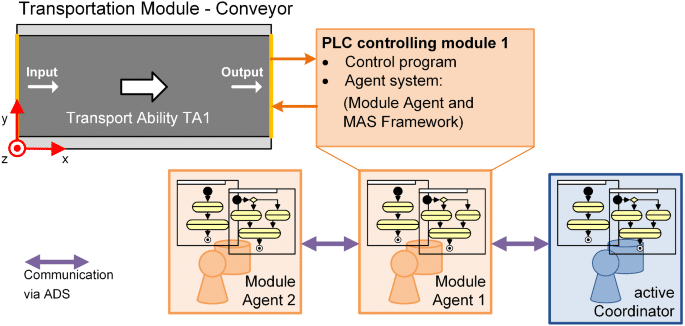

Les chercheurs de PSU et de l’Université Duke, ainsi que des collaborateurs de Google DeepMind et d’autres laboratoires de recherche, ont formalisé un nouveau problème en intelligence artificielle : l’attribution automatique des échecs pour les systèmes multi-agents pilotés par LLM. Ce travail présente le benchmark Who&When, un ensemble de données et un ensemble d’évaluation conçus pour identifier quel agent a causé une panne et à quelle étape. Cette initiative arrive à un moment opportun, alors que les systèmes autonomes se développent et que le débogage exige des outils de diagnostic plus précis et plus rapides.

| Pressé ? Voici l’essentiel : |

|---|

| • 🔎 Nouvelle tâche : automatiser « qui a échoué » et « quand cela s’est produit » dans les systèmes multi-agents. |

| • 🧪 Benchmark Who&When : des journaux annotés par des humains provenant de 127 systèmes permettent des tests standardisés. |

| • 📉 Résultats difficiles : environ 53,5 % pour « qui » et environ 14,2 % pour « quand » ; les méthodes actuelles échouent sur les journaux longs. |

| • 🧰 Actions concrètes suivantes : essayez des stratégies hybrides et des invites structurées ; consultez un guide pratique sur les causes profondes des échecs de tâches 🔧 |

Pourquoi l’attribution automatique des échecs est importante dans les systèmes multi-agents : la percée des chercheurs de PSU et Duke

À mesure que les systèmes multi-agents alimentés par LLM se développent, les développeurs rencontrent souvent un paradoxe : un flot de messages d’agents, des outils qui s’activent, un raisonnement en chaîne, mais la tâche échoue quand même. En termes d’informatique, le problème passe de « quelle était la bonne réponse ? » à « où, dans la chaîne de collaboration, la panne est-elle survenue ? ». C’est précisément ce fossé que l’équipe de PSU et de l’Université Duke cible avec l’attribution automatique des échecs. L’objectif : transformer des heures de fouille de journaux en une étape de diagnostic transparente et structurée.

Considérons Ava, ingénieure plateforme dans une startup fintech. Son équipe de systèmes autonomes utilise quatre agents spécialisés — planificateur, chercheur, programmeur et testeur. Une requête client échoue après 23 interactions. Sans attribution, diagnostiquer la cause racine est flou : le planificateur a-t-il mal spécifié les sous-objectifs, le chercheur a-t-il manqué une API clé, ou le testeur a-t-il mal interprété la sortie ? L’attribution agit comme un enregistreur de boîte noire pour la coordination, identifiant l’agent responsable et l’étape décisive où l’erreur a déclenché la panne.

Le goulot d’étranglement du débogage auquel font face les développeurs

Les flux de travail IA modernes se heurtent souvent à un goulot d’étranglement en termes d’observabilité, pas de capacité de modélisation. Même avec de puissants modèles d’apprentissage automatique, des responsabilités floues compliquent les cycles d’itération et la gouvernance. La formulation menée par PSU formalise cela comme une tâche distincte, ce qui aligne le débogage sur l’évaluation — un mouvement attendu depuis longtemps pour l’automatisation à grande échelle.

- 🧵 Chaînes d’interactions longues qui rendent difficile la perception de la causalité à travers des journaux bavards.

- 🧭 Rôles d’agents ambigus qui brouillent qui était propriétaire d’une décision versus qui l’a propagée.

- ⏱️ Le temps de diagnostic explose quand chaque échec nécessite une enquête humaine.

- 🔐 Pression de conformité exigeant une auditabilité dans les laboratoires de recherche et les environnements de production.

Le benchmark Who&When répond à cette problématique en standardisant les annotations « qui » et « quand », permettant une évaluation quantitative. Il crée aussi un langage commun entre équipes : un bug n’est pas simplement une panne mais une erreur agent-étape spécifique, traçable et corrigeable.

| Défi 🚧 | Pourquoi c’est problématique 💥 | Apport de l’attribution ✅ |

|---|---|---|

| Collaboration opaque entre agents | Blâme mal placé ou correctifs vagues | Un « qui » précis cible la responsabilité 🔍 |

| Journaux longs et limites contextuelles | Étape critique perdue dans le bruit | Un « quand » exact restreint la fenêtre de recherche ⏳ |

| Archéologie manuelle des journaux | Itérations lentes et épuisement | Le triage automatisé accélère le cycle de correction des bugs 🚀 |

| Exigences conformité/audit | Post-mortems inconsistants | Preuves standardisées et reproductibles 📚 |

Pour les équipes gérant des déploiements complexes d’IA, l’idée clé est simple : l’attribution transforme le chaos en responsabilité, créant un workflow qui soutient directement la fiabilité.

À l’intérieur du benchmark Who&When : conception des données, annotations et couverture pour l’attribution des échecs

Le benchmark Who&When agrège des journaux d’échecs provenant de 127 systèmes multi-agents couvrant diverses tâches, usages d’outils et schémas de coordination. Certains journaux sont générés algorithmiquement pour solliciter des modes d’erreur spécifiques ; d’autres sont créés à la main par des experts afin de refléter des histoires d’échecs réalistes. Chaque journal inclut trois annotations critiques : Qui a causé l’échec, Quand l’étape décisive a eu lieu, et Pourquoi cela s’est produit en langage naturel.

Cette triade est essentielle. « Qui » établit la responsabilité ; « Quand » offre une ancre temporelle ; « Pourquoi » fournit un raisonnement causal qui guide un correctif. Ensemble, elles rendent l’échec non seulement détectable mais explicable — prérequis pour une automatisation durable dans les environnements de production. La standardisation permet aussi aux laboratoires de recherche de comparer les méthodes de manière équitable, évitant des métriques ponctuelles qui masquent les lacunes de généralisation.

Ce qui est annoté et pourquoi c’est important

Les directives d’annotation assurent le traitement cohérent des cas difficiles — comme les erreurs en chaîne ou les dérives silencieuses. Lorsque plusieurs agents contribuent à une panne, les annotateurs marquent le point décisif où la réussite est devenue impossible. Cela est particulièrement utile dans les pipelines de planification, où une mauvaise spécification précoce peut condamner les étapes suivantes, même si elles paraissent correctes isolément.

- 🧩 Identité du rôle : planificateur, critique, exécuteur, appelant d’outil, vérificateur, etc.

- 🕰️ Indice d’étape : le moment décisif qui a fait basculer le résultat.

- 🗣️ Justification en langage naturel : une explication concise du lien causal.

- 🧪 Métadonnées de la tâche : domaine, outils invoqués, disponibilité de la vérité terrain.

La portée du benchmark supporte l’étude à travers des domaines — assistance à la programmation, analyse de données, planification de contenu et aide à la décision dans le monde réel. Elle permet aussi des ablations contrôlées : l’attribution tient-elle quand la liste des agents change, ou quand les outils échouent de façon intermittente ?

| Champ d’annotation 📝 | Définition 📘 | Valeur pour le débogage 🧯 |

|---|---|---|

| Qui | Agent responsable de l’erreur décisive | Cible la correction vers le bon module 🎯 |

| Quand | Étape spécifique où l’erreur fatale est survenue | Réduit considérablement l’espace de recherche dans les journaux 🔍 |

| Pourquoi | Explication en langage naturel de la causalité | Guide la conception des patchs et des cas de test 🧪 |

| Contexte | Type de tâche, outils, et statut de vérité terrain | Permet des comparaisons de méthodes équitables ⚖️ |

Pour les équipes souhaitant simuler des post-mortems avant incidents, un point de départ pratique est une liste de contrôle basée sur Who&When. Une ressource compagnon utile est ce guide concis sur la traçabilité des causes profondes des échecs de tâches dans les systèmes IA, qui complète le débogage basé sur le benchmark.

Les développeurs demandent souvent si un outil automatisé peut « simplement me dire quoi corriger ». L’attribution ne remplace pas le jugement technique, mais elle fournit la piste de preuves qui permet des décisions rapides et défendables. L’essentiel : le jeu de données transforme l’analyse des échecs en une compétence répétable et enseignable.

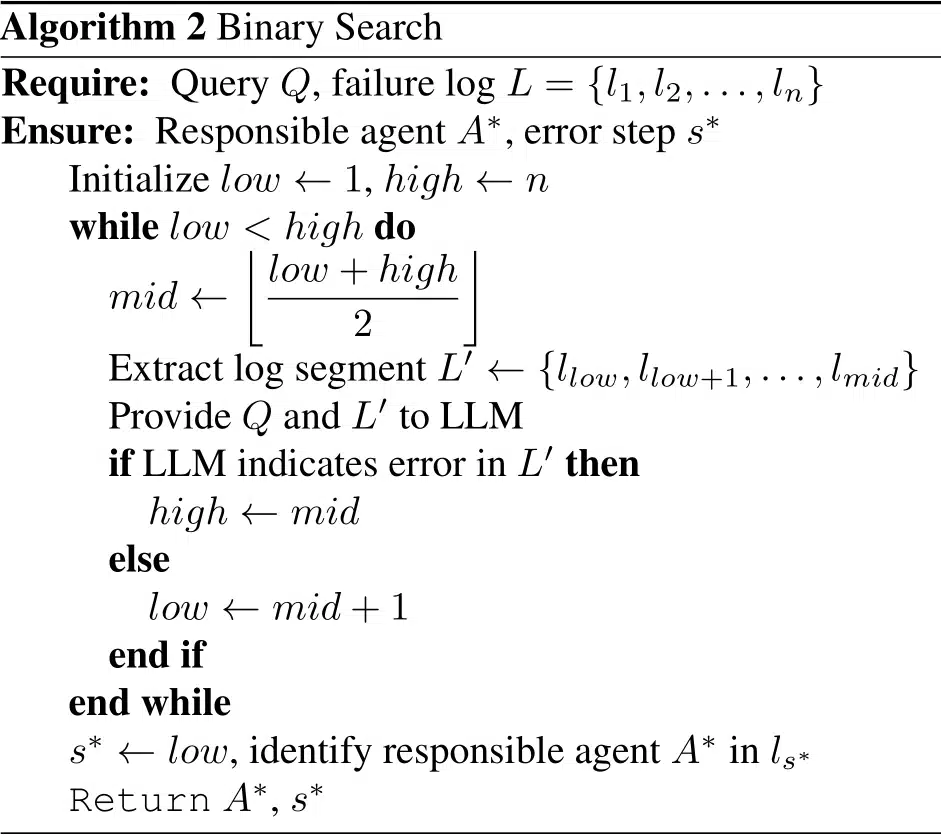

Méthodes comparées : stratégies Tout-en-Un, Étape par Étape, et Recherche Binaire par PSU et Duke

Avec Who&When, les chercheurs ont évalué trois stratégies pour l’attribution automatique des échecs. Chaque méthode équilibre coût, précision et robustesse aux contextes longs. Plutôt qu’un champion unique, l’étude met en avant une approche « boîte à outils » : choisissez la méthode qui correspond à votre budget et à votre surface d’erreur.

Trois stratégies, trois mentalités

Tout-en-Un lit l’intégralité du journal d’échec et produit en une seule passe l’agent responsable et l’étape décisive. Efficace sur les journaux courts, elle est souvent meilleure pour le « qui », mais peut mal situer le « quand » à mesure que le contexte s’allonge. Étape par Étape reflète le raisonnement humain : il parcourt le journal, jugeant chaque étape. Cela améliore la localisation mais peut cumuler les erreurs précédentes et augmente le coût en tokens. La Recherche Binaire divise la différence en divisant récursivement le journal en deux et en demandant dans quelle moitié se trouve l’erreur, équilibrant coût et précision.

- ⚡ Tout-en-Un : rapide, grossier, performant sur le « qui ».

- 🪜 Étape par Étape : méticuleux, coûteux, meilleur sur le « quand ».

- 🔍 Recherche Binaire : pragmatique, bon compromis en moyenne.

- 🧩 Chaînes hybrides : combinent les forces au prix d’une plus grande consommation.

L’étude a également mesuré la performance avec ou sans connaissance de la vérité terrain de la tâche sous-jacente. Lorsque la vérité terrain est disponible, les méthodes peuvent recouper les résultats pour améliorer la confiance ; sans elle, elles doivent inférer à partir de la dynamique des interactions seules — plus proche des conditions réelles de production.

| Méthode 🧭 | Points forts 💪 | Faiblesses ⚠️ | Cas d’usage idéal 🧰 |

|---|---|---|---|

| Tout-en-Un | Coût faible ; bon pour le « qui » sur journaux courts 🙂 | Peine avec les contextes longs ; plus faible sur le « quand » 😵 | Tri rapide sur traces concises ⏱️ |

| Étape par Étape | Précis sur le « quand » ; raisonnement transparent 🧠 | Usage élevé de tokens ; accumulation d’erreurs 📈 | Post-mortems pour incidents critiques 🧯 |

| Recherche Binaire | Équilibré ; évolutif sur journaux longs ⚖️ | Peut manquer des indices subtils entre étapes 🧩 | Triage de production courant 🔄 |

Les équipes peuvent chaîner les méthodes : utiliser Tout-en-Un pour présélectionner l’agent, puis pivoter vers Étape par Étape pour localiser précisément l’étape décisive. Pour un guide d’implémentation pratique, ce tutoriel sur la traçabilité des causes racines des échecs d’agents montre comment structurer les invites et les journaux.

Dans toutes les stratégies, un raisonnement explicite aide. Les invites demandant une justification, des citations d’évidence et une décision finale tendent à améliorer la cohérence. Le principe directeur : forcer le modèle à montrer son travail et à citer des tours spécifiques — un petit changement qui amplifie la fiabilité.

Ce que révèlent les résultats : limites, coûts et opportunités dans le débogage IA

Sur Who&When, même les modèles de premier plan ont subi une mise au point. La meilleure méthode unique a obtenu environ 53,5 % pour identifier « qui » a causé l’échec et environ 14,2 % pour le « quand » exact. Certaines méthodes ont fait pire que des bases aléatoires dans des contextes difficiles, soulignant que l’attribution exige un raisonnement causal plus fort que les tâches classiques de QA ou de résumé.

Les résultats se distinguent aussi selon que le modèle connaît ou non la véritable réponse de la tâche. Avec la vérité terrain, l’attribution peut trianguler des contradictions (« le plan du planificateur est incompatible avec la bonne réponse »). Sans elle, le modèle doit diagnostiquer uniquement par la dynamique de la conversation et les traces d’outils — une perspective plus authentique de la production. Dans les deux cas, l’allongement des contextes diminue la précision, surtout pour le « quand ».

Constats clés sur lesquels les développeurs peuvent agir

Plusieurs tendances offrent des conseils immédiats aux équipes d’ingénierie standardisant les workflows d’attribution. Premièrement, l’ingénierie des invites compte : des invites structurées avec justification d’abord améliorent systématiquement l’accord avec les annotations humaines. Deuxièmement, les chaînes hybrides surpassent les exécutions seules, bien que le coût augmente. Troisièmement, les conceptions sensibles à la longueur — comme les fenêtres glissantes ou les résumés de section — aident à compenser la fatigue contextuelle.

- 🧠 Justifications explicites améliorent à la fois les jugements « qui » et « quand ».

- 🧮 Chaînes hybrides échangent tokens contre qualité — budgétez en conséquence.

- 🧾 Gestion du contexte (fenêtres, points forts) ralentit la baisse de précision.

- 🧰 Le choix du modèle n’est pas une solution miraculeuse ; même les raisonneurs avancés peinent.

| Dimension 📏 | Observation 🔭 | Implication 🧩 | Action ☑️ |

|---|---|---|---|

| Qui vs. Quand | « Qui » plus facile ; « Quand » nettement plus difficile | La localisation temporelle est le goulot d’étranglement ⛔ | Adopter un raisonnement local étape par étape et des citations d’évidence 🗂️ |

| Méthodes hybrides | Précision plus élevée, coût plus important | Utile pour incidents graves 🔥 | Escalader progressivement de passes économiques à riches 📶 |

| Longueur du contexte | La performance décline avec la longueur des journaux | Le résumé seul ne suffit pas 🧱 | Utiliser la recherche binaire et des prédicteurs d’étape critique 🧭 |

| Échelle du modèle | Plus grand ≠ toujours meilleur | Le raisonnement > la capacité brute 🧠 | Entraîner les patrons d’invites; ajouter des heuristiques 📐 |

Pour une comparaison pragmatique avec le dépannage quotidien, ce guide sur les causes profondes des échecs de tâches IA complète bien les résultats empiriques de Who&When, aidant les équipes à relier métriques et stratégies de correction.

L’idée centrale est stratégique : faire de l’attribution une étape primordiale dans votre pipeline, pas une réflexion après coup. Quand elle fait partie du cycle build-test-deploy, la fiabilité s’améliore de façon régulière plutôt que sporadique.

Manuel pratique : mettre l’attribution automatique des échecs au travail dans les laboratoires de recherche et en production

Transformer la recherche en pratique courante commence par l’instrumentation. Les équipes peuvent superposer l’attribution sur les cadres d’orchestration existants, enregistrant des tours structurés avec rôles d’agents, invocations d’outils et jugements intermédiaires. Le résultat est une piste reproductible qui soutient à la fois le triage en temps réel et les revues post-incident, que ce soit dans une startup ou une grande équipe plateforme.

Un modèle de workflow éprouvé

Le manuel suivant reflète la manière dont les équipes à maturité élevée abordent l’analyse des échecs tout en maîtrisant les coûts. Il combine sélection de méthode, modèles d’invites et hygiène des journaux en une pratique durable pour les groupes de Machine Learning et d’ingénierie logicielle.

- 🧾 Structure des journaux : étiquetez chaque tour avec rôle, intention, citations d’évidence et effets d’outils.

- 🗂️ Passage de triage : exécutez Tout-en-Un pour un rapide « qui » sur traces courtes.

- 🧭 Approfondissement : pour les cas complexes, pivotez vers Recherche Binaire ou Étape par Étape.

- 🧪 Invites de justification : exigez des explications et des citations de tours spécifiques.

- 🧯 Règles d’escalade : utilisez les hybrides uniquement pour incidents graves ou récurrents.

| Étape 🛠️ | Objectif 🎯 | Mélange de méthodes 🧪 | Astuce opérationnelle 🧭 |

|---|---|---|---|

| Instrumentation | Capturer des journaux exploitables | Étiquettes de rôle + traces d’outils | Imposer un schéma dans l’intégration continue ✅ |

| Tri rapide | Trouver l’agent probable | Tout-en-Un | Limiter le contexte aux tours critiques ✂️ |

| Localisation | Identifier l’étape décisive | Recherche Binaire → Étape par Étape | Citer les preuves issues du journal 🔎 |

| Correction | Appliquer une correction ciblée | Mises à jour des spécifications, tests, gardes-fous | Tester rétroactivement sur échecs similaires ♻️ |

Pour aider les équipes à démarrer, plusieurs explications concises illustrent le chemin du symptôme à la cause racine. Cette vue d’ensemble sur comment identifier la cause racine dans les workflows d’agents est utile pour l’intégration, tandis que cette note compagnon sur le débogage des transferts entre agents explore les pièges de la coordination. Pour les responsables de l’ingénierie fiabilité, un manuel sur la conception de SLO informés par l’attribution relie métriques et engagements opérationnels. Les équipes standardisant dans des domaines réglementés peuvent adapter les mêmes idées pour les pistes d’audit : voir ce guide sur la documentation de la causalité des incidents. Et pour une lecture approfondie, un plongeon pratique dans l’analyse de cause racine complète la structure Who&When.

Deux notes finales pour le déploiement. Premièrement, l’attribution doit être agnostique au modèle et centrée sur les journaux : imposez un schéma afin que tout modèle puisse participer. Deuxièmement, suivez explicitement les coûts ; n’utilisez les hybrides que lorsque la gravité le justifie. La règle pratique est claire : optimisez pour des corrections rapides et explicables, puis augmentez la sophistication à mesure que votre taxonomie d’incidents mûrit.

De la recherche à la feuille de route : ce que le travail de PSU et Duke signifie pour la prochaine vague de systèmes autonomes

En formalisant l’attribution automatique des échecs, l’équipe de PSU et de l’Université Duke requalifie le débogage comme une capacité mesurable au sein des systèmes d’intelligence artificielle, et non comme une compétence artisanale. Ce changement bénéficie aux chercheurs, aux équipes plateformes et aux leaders produits. C’est un pont entre évaluation et amélioration — le chaînon manquant qui rend l’itération systématique.

Ce qui vient ensuite

Le chemin à venir inclura probablement des signaux causaux plus riches (par exemple, la sémantique des outils), la prédiction d’étape critique, et des politiques apprises pour la sélection de méthode sous contraintes de coût. Attendez-vous à une intégration plus étroite avec les cadres d’orchestration, des tests contractuels pour les API inter-agents, et des tableaux de bord où « qui » et « quand » alimentent des modèles de correction. À mesure que l’attribution mûrit, les systèmes multi-agents deviendront moins fragiles et leurs échecs moins mystérieux.

- 🧭 Indices causaux : intégrer les résultats d’outils et les différences d’état dans les invites d’attribution.

- 🧱 Agents sécurisés par gardes-fous : ajouter des contrôles déclenchés par des motifs à risque « qui/quand ».

- 📊 Visibilité opérationnelle : mettre en valeur les métriques d’attribution dans les tableaux de bord de fiabilité.

- 🧑⚖️ Gouvernance : maintenir des récits prêts pour audits lors des revues d’incidents.

| Parties prenantes 👥 | Valeur de l’attribution 💡 | Premier pas 🪜 | Signal à surveiller 👁️ |

|---|---|---|---|

| Laboratoires de recherche | Baselines comparables entre méthodes | Adopter les découpages Who&When | Écart entre « qui » et « quand » 📉 |

| Équipes plateformes | Résolution d’incidents plus rapide | Journaux avec schéma imposé | Temps moyen jusqu’à attribution ⏱️ |

| Propriétaires produits | Cycles d’itération prévisibles | Manuel de triage | Taux de régression après corrections 🔁 |

| Conformité | Post-mortems prêts pour audits | Modèles de récits | Couverture des justifications « pourquoi » 📚 |

Le débogage était un artisanat. Avec l’attribution, il devient une capacité système d’exploitation pour les produits IA. La direction est claire : la fiabilité par un raisonnement basé sur les preuves, la contribution de PSU et Duke marquant une étape majeure.

{« @context »: »https://schema.org », »@type »: »FAQPage », »mainEntity »:[{« @type »: »Question », »name »: »Qu’est-ce que l’attribution automatique des échecs exactement ? », »acceptedAnswer »:{« @type »: »Answer », »text »: »Il s’agit d’une tâche formelle qui identifie quel agent est responsable d’un échec (‘qui’) et l’étape d’erreur décisive (‘quand’) dans les systèmes multi-agents LLM. L’équipe de PSU et de l’Université Duke a défini la tâche et publié le benchmark Who&When avec des annotations humaines pour qui, quand et pourquoi. »}},{« @type »: »Question », »name »: »Pourquoi les méthodes actuelles obtiennent-elles seulement environ 53,5 % pour « qui » et 14,2 % pour « quand » ? », »acceptedAnswer »:{« @type »: »Answer », »text »: »L’attribution exige un raisonnement causal sur des journaux longs et bruités. Les modèles doivent isoler l’étape décisive qui a garanti l’échec, ce qui est plus difficile que la QA typique. La longueur du contexte, les transferts subtils et les erreurs cumulées rendent le « quand » particulièrement difficile. »}},{« @type »: »Question », »name »: »Comment les équipes devraient-elles commencer à utiliser l’attribution en production ? », »acceptedAnswer »:{« @type »: »Answer », »text »: »Instrumenter les journaux avec des étiquettes de rôle et des traces d’outil, effectuer un triage rapide Tout-en-Un, puis escalader vers Recherche Binaire ou Étape par Étape pour les incidents difficiles. Exiger des justifications explicites dans les invites et suivre les coûts pour n’utiliser les hybrides que lorsque la gravité le justifie. »}},{« @type »: »Question », »name »: »Cela remplace-t-il les tests unitaires et les évaluations ? », »acceptedAnswer »:{« @type »: »Answer », »text »: »Non. L’attribution complète les tests et évaluations en expliquant la causalité des échecs. Elle relie « ce qui a échoué » à « pourquoi cela a échoué », permettant des corrections ciblées et de meilleurs tests de régression. »}},{« @type »: »Question », »name »: »Où puis-je apprendre des techniques pratiques pour les causes racines des agents ? », »acceptedAnswer »:{« @type »: »Answer », »text »: »Un point de départ concis et applicable est ce guide sur la traçabilité des échecs : consultez la ressource sur les causes racines des échecs de tâches ici : https://chat-gpt-5.ai/task-failure-root-causes. »}}]}Qu’est-ce que l’attribution automatique des échecs exactement ?

Il s’agit d’une tâche formelle qui identifie quel agent est responsable d’un échec (‘qui’) et l’étape d’erreur décisive (‘quand’) dans les systèmes multi-agents LLM. L’équipe de PSU et de l’Université Duke a défini la tâche et publié le benchmark Who&When avec des annotations humaines pour qui, quand et pourquoi.

Pourquoi les méthodes actuelles obtiennent-elles seulement environ 53,5 % pour « qui » et 14,2 % pour « quand » ?

L’attribution exige un raisonnement causal sur des journaux longs et bruités. Les modèles doivent isoler l’étape décisive qui a garanti l’échec, ce qui est plus difficile que la QA typique. La longueur du contexte, les transferts subtils et les erreurs cumulées rendent le « quand » particulièrement difficile.

Comment les équipes devraient-elles commencer à utiliser l’attribution en production ?

Instrumenter les journaux avec des étiquettes de rôle et des traces d’outil, effectuer un triage rapide Tout-en-Un, puis escalader vers Recherche Binaire ou Étape par Étape pour les incidents difficiles. Exiger des justifications explicites dans les invites et suivre les coûts pour n’utiliser les hybrides que lorsque la gravité le justifie.

Cela remplace-t-il les tests unitaires et les évaluations ?

Non. L’attribution complète les tests et évaluations en expliquant la causalité des échecs. Elle relie « ce qui a échoué » à « pourquoi cela a échoué », permettant des corrections ciblées et de meilleurs tests de régression.

Où puis-je apprendre des techniques pratiques pour les causes racines des agents ?

Un point de départ concis et applicable est ce guide sur la traçabilité des échecs : consultez la ressource sur les causes racines des échecs de tâches ici : https://chat-gpt-5.ai/task-failure-root-causes.

-

Open Ai7 jours ago

Open Ai7 jours agoLibérer la puissance des Plugins ChatGPT : améliorez votre expérience en 2025

-

Open Ai6 jours ago

Open Ai6 jours agoMaîtriser l’ajustement fin de GPT : un guide pour personnaliser efficacement vos modèles en 2025

-

Open Ai6 jours ago

Open Ai6 jours agoComparer ChatGPT d’OpenAI, Claude d’Anthropic et Bard de Google : quel outil d’IA générative dominera en 2025 ?

-

Open Ai6 jours ago

Open Ai6 jours agoTarification de ChatGPT en 2025 : Tout ce que vous devez savoir sur les tarifs et abonnements

-

Open Ai6 jours ago

Open Ai6 jours agoLa suppression progressive des modèles GPT : à quoi les utilisateurs peuvent s’attendre en 2025

-

Modèles d’IA6 jours ago

Modèles d’IA6 jours agoModèles GPT-4 : Comment l’intelligence artificielle transforme 2025