Innovazione

PSU e ricercatori di Duke presentano un rivoluzionario sistema automatizzato di attribuzione dei guasti per sistemi multi-agente

Ricercatori di PSU e Duke University, insieme a collaboratori di Google DeepMind e altri laboratori di ricerca, hanno formalizzato un nuovo problema nell’Intelligenza Artificiale: l’Attribuzione Automatica dei Guasti per Sistemi Multi-Agente guidati da LLM. Il lavoro introduce il benchmark Who&When, un set di dati e una suite di valutazione progettata per identificare quale agente ha causato un malfunzionamento e in quale passaggio. Lo sforzo arriva in un momento opportuno, mentre i Sistemi Autonomi si espandono e il debugging richiede strumenti diagnostici più incisivi e rapidi.

| Di fretta? Ecco cosa conta: |

|---|

| • 🔎 Nuovo compito: Automatizzare “chi ha fallito” e “quando è successo” nei Sistemi Multi-Agente. |

| • 🧪 Benchmark Who&When: Log annotati manualmente da 127 sistemi per test standardizzati. |

| • 📉 Risultati sfidanti: ~53,5% su “chi” e ~14,2% su “quando”; i metodi attuali faticano su log lunghi. |

| • 🧰 Prossimi passi attuabili: Provare strategie ibride e prompt strutturati; consulta una guida pratica su cause radice dei fallimenti di task 🔧 |

Perché l’Attribuzione Automatica dei Guasti conta nei Sistemi Multi-Agente: la scoperta di PSU e Duke

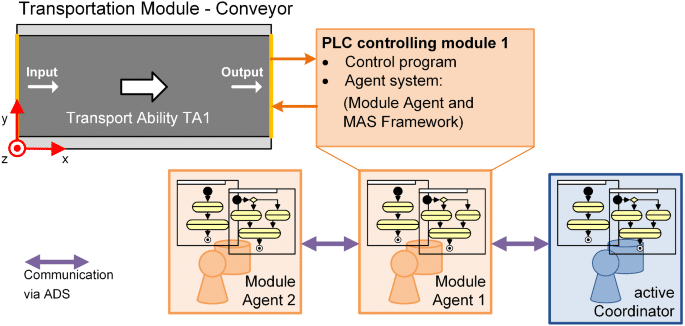

Man mano che i Sistemi Multi-Agente potenziati da LLM si espandono, gli sviluppatori incontrano spesso un paradosso: una raffica di messaggi tra agenti, strumenti attivati, ragionamenti a catena—eppure il task fallisce. In termini di Informatica, il problema si sposta da “qual era la risposta giusta?” a “in quale punto della pipeline collaborativa si è verificato il guasto?” È esattamente il vuoto che il team di PSU e Duke University mira a colmare con l’Attribuzione Automatica dei Guasti. L’obiettivo: trasformare ore di analisi dei log in uno step diagnostico trasparente e strutturato.

Prendiamo Ava, ingegnere di piattaforma in una startup fintech. Il suo team di Sistemi Autonomi usa quattro agenti specializzati—pianificatore, ricercatore, programmatore e tester. Una richiesta cliente fallisce dopo 23 interazioni. Senza attribuzione, è difficile diagnosticare la causa principale: il pianificatore ha specificato male i sub-obiettivi, il ricercatore ha perso un’API chiave o il tester ha interpretato male l’output? L’attribuzione agisce come una scatola nera per il coordinamento, identificando l’agente responsabile e il passo decisivo dove l’errore ha innescato il fallimento.

Il collo di bottiglia del debugging che gli sviluppatori affrontano

I flussi di lavoro AI moderni spesso incontrano un collo di bottiglia nell’osservabilità, non nella capacità di modellazione. Anche con modelli di Machine Learning potenti, linee di responsabilità poco chiare complicano i cicli di iterazione e la governance. Il quadro proposto da PSU formalizza questo come un compito distinto, allineando il debugging alla valutazione—una mossa da tempo necessaria per l’automazione su larga scala.

- 🧵 Catene di interazione lunghe rendono difficile vedere la causalità attraverso log verbosi.

- 🧭 Ruoli degli agenti ambigui sfumano chi ha preso una decisione rispetto a chi l’ha propagata.

- ⏱️ Il tempo per la diagnosi si allunga quando ogni errore richiede indagini manuali.

- 🔐 Pressione di conformità impone tracciabilità in Research Labs e sistemi di produzione.

Il benchmark Who&When risponde a questo problema standardizzando le annotazioni “chi” e “quando”, consentendo valutazioni quantitative. Crea inoltre un linguaggio condiviso tra i team: un bug non è solo un fallimento ma un errore specifico agente-passo, tracciabile e correggibile.

| Sfida 🚧 | Perché è problematica 💥 | Vantaggio dell’attribuzione ✅ |

|---|---|---|

| Collaborazione agente opaca | Colpevolizzazioni errate o correzioni confusive | “Chi” preciso individua la responsabilità 🔍 |

| Log lunghi e limiti di contesto | Passaggi critici persi nel rumore | “Quando” esatto restringe la finestra di ricerca ⏳ |

| Archeologia manuale dei log | Iterazioni lente e burnout | Triage automatico accelera il ciclo di correzione 🚀 |

| Requisiti di conformità/audit | Post-mortem incoerenti | Evidenze standardizzate e riproducibili 📚 |

Per i team che gestiscono implementazioni AI complesse, l’intuizione chiave è semplice: l’attribuzione trasforma il caos in responsabilità, creando un flusso di lavoro che supporta direttamente l’affidabilità.

Dentro il Benchmark Who&When: progettazione dati, annotazioni e copertura per l’Attribuzione dei Guasti

Il benchmark Who&When aggrega i log di guasto di 127 Sistemi Multi-Agente che coprono compiti, strumenti e modelli di coordinamento vari. Alcuni log sono generati algoritmicamente per stressare specifiche modalità di errore; altri sono creati a mano da esperti per rappresentare storie di guasti realistiche. Ogni log include tre annotazioni critiche: Chi ha causato il guasto, Quando si è verificato il passo decisivo e Perché è successo in linguaggio naturale.

Questa triade è importante. “Chi” stabilisce la responsabilità; “Quando” fornisce un ancoraggio temporale; “Perché” offre una spiegazione causale che guida una correzione. Insieme, rendono il guasto non solo rilevabile ma spiegabile—un prerequisito per un’Automazione sostenibile in ambienti di produzione. La standardizzazione permette anche ai Research Labs di confrontare i metodi in modo omogeneo, evitando metriche isolate che nascondono gap di generalizzazione.

Cosa viene annotato e perché conta

Le linee guida per l’annotazione assicurano che i casi limite difficili—come errori a catena o derive silenziose—siano gestiti in modo coerente. Quando più agenti contribuiscono a un guasto, gli annotatori segnano il punto decisivo in cui il successo è diventato impossibile. Questo è particolarmente utile nelle pipeline di pianificazione, dove una specifica precoce errata può compromettere i passaggi successivi anche se appaiono corretti isolatamente.

- 🧩 Identità del ruolo: pianificatore, critico, esecutore, chiamante strumenti, verificatore, ecc.

- 🕰️ Indice del passo: il momento decisivo che ha capovolto l’esito.

- 🗣️ Motivazione in linguaggio naturale: una spiegazione concisa del legame causale.

- 🧪 Metadati del task: dominio, strumenti invocati, disponibilità della verità a terra.

La vasta copertura del benchmark supporta lo studio in vari domini—assistenza al coding, analisi dati, pianificazione contenuti e supporto decisionale nel mondo reale. Permette anche ablazioni controllate: l’attribuzione regge quando cambia il roster degli agenti o quando gli strumenti falliscono in modo intermittente?

| Campo di annotazione 📝 | Definizione 📘 | Valore per il debugging 🧯 |

|---|---|---|

| Chi | Agente responsabile per l’errore decisivo | Mirare la correzione al modulo giusto 🎯 |

| Quando | Passo specifico in cui si è verificato l’errore fatale | Riduce drasticamente lo spazio di ricerca nel log 🔍 |

| Perché | Spiegazione in linguaggio naturale della causalità | Guida la progettazione delle patch e dei test 🧪 |

| Contesto | Tipo di task, strumenti e stato della verità a terra | Consente paragoni equi tra metodi ⚖️ |

Per i team che vogliono svolgere post-mortem prima degli incidenti, un punto di partenza pratico è una checklist basata su Who&When. Una risorsa utile è questa guida sintetica a tracciare le cause radice dei fallimenti di task in sistemi AI, che integra il debugging guidato dal benchmark.

Gli sviluppatori chiedono spesso se uno strumento automatico possa “semplicemente dirmi cosa correggere”. L’attribuzione non sostituisce il giudizio ingegneristico, ma fornisce la traccia di evidenze che permette decisioni rapide e difendibili. Il risultato: il dataset trasforma l’analisi dei guasti in una competenza ripetibile e insegnabile.

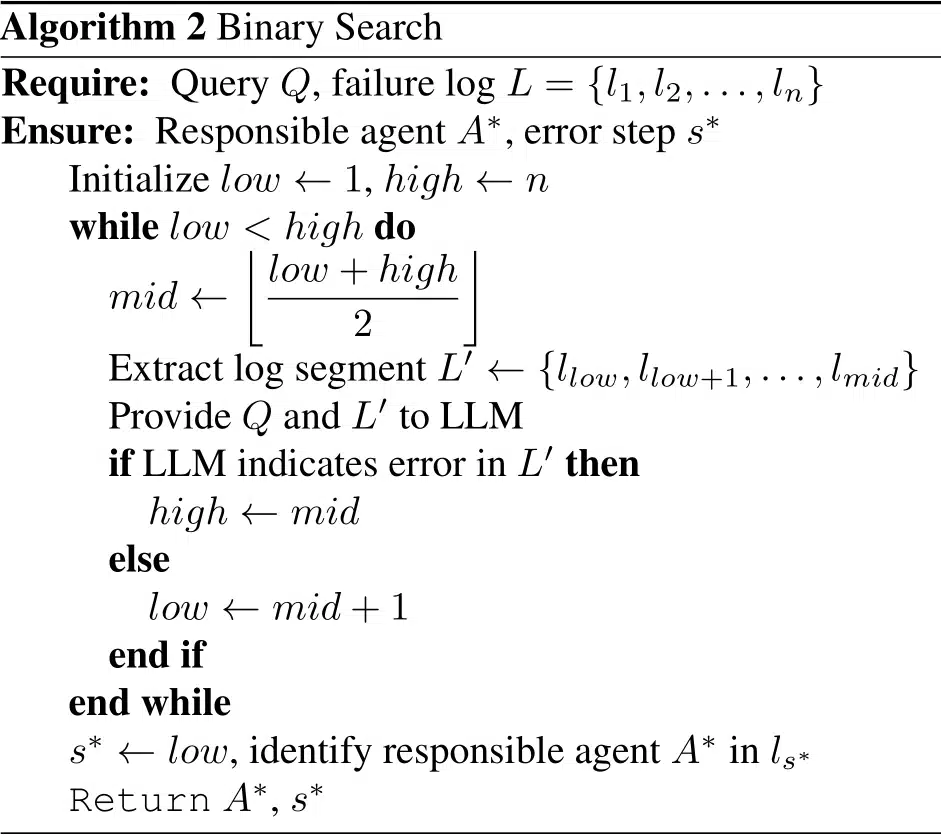

Metodi a Confronto: Strategie All-at-Once, Passo-Passo e Ricerca Binaria da PSU e Duke

Utilizzando Who&When, i ricercatori hanno valutato tre strategie per l’Attribuzione Automatica dei Guasti. Ogni metodo bilancia costo, accuratezza e robustezza ai contesti lunghi. Piuttosto che un singolo vincitore, lo studio sottolinea un approccio toolkit: scegliere il metodo che si allinea al proprio budget e superficie di errore.

Tre strategie, tre mentalità

All-at-Once legge tutto il log di errore e in un unico passaggio restituisce agente responsabile e passo decisivo. È efficiente su log brevi e spesso migliore su “chi”, ma può sbagliare “quando” col crescere del contesto. Passo-Passo imita l’investigazione umana: analizza il log giudicando ogni passaggio. Migliora la localizzazione ma può accumulare errori precedenti e aumenta il costo in token. Ricerca Binaria splitta il log dimezzandolo ricorsivamente e chiedendo in quale metà si nasconde l’errore, bilanciando costo e precisione.

- ⚡ All-at-Once: veloce, grossolano, solido per “chi.”

- 🪜 Passo-Passo: meticoloso, più costoso, migliore per “quando.”

- 🔍 Ricerca Binaria: pragmatico, buon compromesso medio.

- 🧩 Catene ibride: combinano punti di forza a costo di maggiore calcolo.

Lo studio ha misurato le prestazioni con e senza conoscenza della verità a terra del task sottostante. Quando disponibile, i metodi possono incrociare i risultati per aumentare la fiducia; senza, devono dedurre solo da dinamiche conversazionali e tracce degli strumenti—più vicino alle condizioni reali di produzione.

| Metodo 🧭 | Punti di forza 💪 | Punti deboli ⚠️ | Uso ideale 🧰 |

|---|---|---|---|

| All-at-Once | Basso costo; forte su “chi” in log brevi 🙂 | Fatica con contesti lunghi; debole su “quando” 😵 | Triaging veloce su tracce concise ⏱️ |

| Passo-Passo | Preciso su “quando”; ragionamento trasparente 🧠 | Alto consumo di token; accumulo errori 📈 | Post-mortem per incidenti critici 🧯 |

| Ricerca Binaria | Bilanciato; scalabile su log lunghi ⚖️ | Può perdere segnali sottili tra i passaggi 🧩 | Triaging di routine in produzione 🔄 |

I team possono concatenare i metodi: usare All-at-Once per selezionare l’agente, poi passare a Passo-Passo per localizzare il passo decisivo. Per uno schema di implementazione pratico, questo walkthrough su traccia delle cause radice per guasti agenti mostra come strutturare prompt e log.

Tra le strategie, il ragionamento esplicito aiuta. Prompt che richiedono motivazioni, citazioni di prove e una decisione finale tendono a migliorare la coerenza. Il principio guida: costringere il modello a mostrare il suo lavoro e citare turni specifici—un piccolo cambiamento che moltiplica l’affidabilità.

Cosa rivelano i risultati: limiti, costi e opportunità nel debugging AI

Su Who&When, anche i modelli di punta hanno subìto una verifica della realtà. Il migliore metodo singolo ha ottenuto circa 53,5% nell’identificazione di “chi” ha causato il fallimento e circa 14,2% sul “quando” esatto. Alcuni metodi hanno fatto peggio di baseline casuali in scenari difficili, evidenziando come l’attribuzione richieda un ragionamento causale più forte rispetto ai tipici task di QA o sommario.

I risultati si sono ulteriormente divisi tra modelli che conoscono la risposta vera del task o meno. Con la verità a terra, l’attribuzione può triangolare contraddizioni (“il piano del pianificatore è incompatibile con la risposta corretta”). Senza, il modello deve diagnosticare solo da dinamiche di interazione e tracce degli strumenti—una vista più autentica della produzione. In entrambi i casi, i contesti lunghi degradano l’accuratezza, specialmente per “quando.”

Risultati chiave su cui gli sviluppatori possono agire

Diversi pattern offrono indicazioni immediate per i team ingegneristici che standardizzano flussi di lavoro con attribuzione. Primo, il prompt engineering conta: prompt strutturati e con motivazioni prima migliorano l’accordo con annotazioni umane. Secondo, le catene ibride superano le esecuzioni singole, anche se a costo più elevato. Terzo, progettazioni consapevoli della lunghezza—come finestre mobili o sommari di sezioni—attenuano la fatica del contesto.

- 🧠 Motivazioni esplicite migliorano sia i giudizi su “chi” che su “quando.”

- 🧮 Pipeline ibride scambiano token per qualità—prevedi il budget.

- 🧾 Gestione del contesto (finestre, evidenziazioni) rallenta il decadimento di accuratezza.

- 🧰 La scelta del modello non è risolutiva; anche i ragionatori avanzati faticano.

| Dimensione 📏 | Osservazione 🔭 | Implicazione 🧩 | Azione ☑️ |

|---|---|---|---|

| Chi vs. Quando | “Chi” più facile; “Quando” decisamente più difficile | La localizzazione temporale è il collo di bottiglia ⛔ | Adottare ragionamento locale per passo e citazioni evidenze 🗂️ |

| Metodi ibridi | Maggiore accuratezza a costo più alto | Utile per incidenti di alta gravità 🔥 | Escalare da passaggi economici a ricchi progressivamente 📶 |

| Lunghezza del contesto | Il rendimento cala con log più lunghi | La sola sintesi non basta 🧱 | Usare ricerca binaria e predittori di passi critici 🧭 |

| Scala del modello | Più grande ≠ sempre meglio | Qui conta il ragionamento > la pura capacità 🧠 | Allenare pattern di prompt; aggiungere euristiche 📐 |

Per un confronto pragmatico con la risoluzione quotidiana, questa guida alle cause radice dei fallimenti di task AI si abbina bene ai risultati empirici di Who&When, aiutando i team a connettere metriche e strategie di correzione.

Il punto centrale è strategico: rendere l’attribuzione uno step di prim’ordine nella pipeline, non un ripensamento. Quando diventa parte del ciclo build-test-deploy, l’affidabilità migliora in modo costante anziché sporadico.

Playbook Pratico: mettere l’attribuzione automatica dei guasti al lavoro in Research Labs e produzione

Trasformare la ricerca in pratica routinaria inizia con l’instrumentazione. I team possono sovrapporre l’attribuzione ai framework di orchestrazione esistenti, registrando turni strutturati con ruoli agenti, invocazioni di strumenti e giudizi intermedi. Il risultato è una traccia riproducibile che supporta sia il triage in tempo reale sia le revisioni post-incidente, sia in startup che in team piattaforma di grandi dimensioni.

Un modello di flusso di lavoro collaudato sul campo

Il playbook che segue rispecchia come i team ad alta maturità affrontano l’analisi dei guasti mantenendo i costi gestibili. Combina selezione metodi, pattern di prompt e igiene dei log in una pratica sostenibile per gruppi di Machine Learning e Ingegneria Software.

- 🧾 Struttura log: etichettare ogni turno con ruolo, intento, citazioni prove ed effetti degli strumenti.

- 🗂️ Passaggio di triage: eseguire All-at-Once per un rapido “chi” su tracce brevi.

- 🧭 Approfondimento: per casi complessi, passare a Ricerca Binaria o Passo-Passo.

- 🧪 Prompt di motivazione: richiedere spiegazioni e citare turni specifici.

- 🧯 Regole di escalation: usare ibridi solo per incidenti di alta gravità o ricorrenti.

| Fase 🛠️ | Obiettivo 🎯 | Mix di metodi 🧪 | Consiglio operativo 🧭 |

|---|---|---|---|

| Instrumentazione | Captura log azionabili | Tag ruolo + tracce strumenti | Far rispettare lo schema in CI ✅ |

| Triaging rapido | Trovare l’agente probabile | All-at-Once | Limitare il contesto ai turni critici ✂️ |

| Localizzazione | Individuare il passo decisivo | Ricerca Binaria → Passo-Passo | Citare prove dal log 🔎 |

| Correzione | Applicare una fix mirata | Aggiornamenti spec, test, guardrail | Backtest su fallimenti simili ♻️ |

Per aiutare i team ad iniziare, diversi spiegatori sintetici illustrano il percorso da sintomo a causa radice. Questa panoramica su come individuare le cause radice nei flussi agenti è utile per l’onboarding, mentre questa nota complementare su debugging dei passaggi tra agenti approfondisce i problemi di coordinamento. Per i manager dell’ingegneria dell’affidabilità, un playbook su progettare SLO informati dall’attribuzione collega metriche agli impegni operativi. I team in settori regolamentati possono adattare le stesse idee per tracce di audit: vedi questa guida su documentare la causalità degli incidenti. E per approfondimenti, un deep dive pratico sull’analisi delle cause radice si allinea bene con lo schema di Who&When.

Due note finali per la distribuzione. Primo, l’attribuzione deve essere model-agnostic e centrata sui log: imporre uno schema affinché qualsiasi modello possa partecipare. Secondo, monitorare esplicitamente i costi; usare gli ibridi solo quando la gravità lo giustifica. La regola pratica è chiara: ottimizzare per correzioni rapide e spiegabili, quindi scalare la sofisticazione man mano che la tassonomia degli incidenti matura.

Dalla Ricerca alla Roadmap: cosa significa il lavoro di PSU e Duke per la prossima ondata di Sistemi Autonomi

Formalizzando l’Attribuzione Automatica dei Guasti, il team di PSU e Duke University ridefinisce il debugging come una capacità misurabile all’interno dei sistemi di Intelligenza Artificiale, non più una competenza artigianale. Questo cambiamento avvantaggia ricercatori, team piattaforma e leader di prodotto. È un ponte tra valutazione e miglioramento—l’anello mancante che rende sistematica l’iterazione.

Dove andrà a finire

Il percorso futuro probabilmente presenterà segnali causali più ricchi (es. semantica dello strumento), predizione di passi critici e politiche apprese per la selezione del metodo sotto vincoli di costo. Si prevede un’integrazione più stretta coi framework di orchestrazione, test di contratto per API inter-agente e dashboard dove “chi” e “quando” confluiscono in template di correzione. Con la maturazione dell’attribuzione, i Sistemi Multi-Agente diventeranno meno fragili e i loro guasti meno misteriosi.

- 🧭 Segnali causali: integrare risultati strumenti e differenze di stato nei prompt dell’attributore.

- 🧱 Agenti guardrail: aggiungere controlli attivati da pattern rischiosi “chi/quando”.

- 📊 Visibilità operativa: mostrare metriche di attribuzione nei scorecard di affidabilità.

- 🧑⚖️ Governance: mantenere narrazioni pronte per audit sui revisione degli incidenti.

| Stakeholder 👥 | Valore dall’attribuzione 💡 | Primo passo 🪜 | Segnale da monitorare 👁️ |

|---|---|---|---|

| Research Labs | Baseline comparabili tra i metodi | Adottare le suddivisioni Who&When | Gap tra “chi” e “quando” 📉 |

| Team piattaforma | Risoluzione incidenti più rapida | Log con schema imposto | Tempo medio per l’attribuzione ⏱️ |

| Product owner | Cicli di iterazione prevedibili | Playbook di triage | Indice di regressione dopo le fix 🔁 |

| Conformità | Post-mortem pronti per audit | Narrazioni template | Copertura delle motivazioni “perché” 📚 |

Il debugging era un mestiere. Con l’attribuzione, diventa una capacità del sistema operativo per prodotti AI. La direzione è chiara: affidabilità attraverso un ragionamento basato su evidenze, con il contributo di PSU e Duke che segna un passo cruciale.

{“@context”:”https://schema.org”,”@type”:”FAQPage”,”mainEntity”:[{“@type”:”Question”,”name”:”Che cos’è esattamente l’Attribuzione Automatica dei Guasti?”,”acceptedAnswer”:{“@type”:”Answer”,”text”:”È un compito formale che identifica quale agente è responsabile per un guasto (‘chi’) e il passo decisivo dell’errore (‘quando’) nei Sistemi Multi-Agente LLM. Il team di PSU e Duke University ha definito il compito e rilasciato il benchmark Who&When con annotazioni umane per chi, quando e perché.”}},{“@type”:”Question”,”name”:”Perché i metodi attuali sono solo intorno al 53,5% per ‘chi’ e al 14,2% per ‘quando’?”,”acceptedAnswer”:{“@type”:”Answer”,”text”:”L’attribuzione richiede ragionamento causale su log lunghi e rumorosi. I modelli devono isolare il passo decisivo che ha garantito il fallimento, cosa più difficile rispetto a tipici compiti di QA. La lunghezza del contesto, passaggi sottili e errori cumulativi rendono “quando” particolarmente impegnativo.”}},{“@type”:”Question”,”name”:”Come dovrebbero iniziare i team a usare l’attribuzione in produzione?”,”acceptedAnswer”:{“@type”:”Answer”,”text”:”Strutturare i log con tag ruolo e tracce strumenti, eseguire un triage veloce All-at-Once, poi passare a Ricerca Binaria o Passo-Passo per incidenti difficili. Richiedere motivazioni esplicite nei prompt e monitorare i costi per usare ibridi solo quando la gravità lo richiede.”}},{“@type”:”Question”,”name”:”Questo sostituisce i test unitari e le valutazioni?”,”acceptedAnswer”:{“@type”:”Answer”,”text”:”No. L’attribuzione integra test e valutazioni spiegando la causalità del guasto. Collega “cosa è fallito” a “perché è fallito”, permettendo correzioni mirate e test di regressione migliori.”}},{“@type”:”Question”,”name”:”Dove posso imparare tecniche pratiche di analisi delle cause radice per agenti?”,”acceptedAnswer”:{“@type”:”Answer”,”text”:”Un punto di partenza sintetico e applicabile è questa guida a tracciare i guasti: consulta la risorsa sulle cause radice dei fallimenti di task qui: https://chat-gpt-5.ai/task-failure-root-causes.”}}]}Che cos’è esattamente l’Attribuzione Automatica dei Guasti?

È un compito formale che identifica quale agente è responsabile per un guasto (‘chi’) e il passo decisivo dell’errore (‘quando’) nei Sistemi Multi-Agente LLM. Il team di PSU e Duke University ha definito il compito e rilasciato il benchmark Who&When con annotazioni umane per chi, quando e perché.

Perché i metodi attuali sono solo intorno al 53,5% per ‘chi’ e al 14,2% per ‘quando’?

L’attribuzione richiede ragionamento causale su log lunghi e rumorosi. I modelli devono isolare il passo decisivo che ha garantito il fallimento, cosa più difficile rispetto a tipici compiti di QA. La lunghezza del contesto, passaggi sottili e errori cumulativi rendono “quando” particolarmente impegnativo.

Come dovrebbero iniziare i team a usare l’attribuzione in produzione?

Strutturare i log con tag ruolo e tracce strumenti, eseguire un triage veloce All-at-Once, poi passare a Ricerca Binaria o Passo-Passo per incidenti difficili. Richiedere motivazioni esplicite nei prompt e monitorare i costi per usare ibridi solo quando la gravità lo richiede.

Questo sostituisce i test unitari e le valutazioni?

No. L’attribuzione integra test e valutazioni spiegando la causalità del guasto. Collega “cosa è fallito” a “perché è fallito”, permettendo correzioni mirate e test di regressione migliori.

Dove posso imparare tecniche pratiche di analisi delle cause radice per agenti?

Un punto di partenza sintetico e applicabile è questa guida a tracciare i guasti: consulta la risorsa sulle cause radice dei fallimenti di task qui: https://chat-gpt-5.ai/task-failure-root-causes.

-

Open Ai1 week ago

Open Ai1 week agoSbloccare il Potere dei Plugin di ChatGPT: Migliora la Tua Esperienza nel 2025

-

Open Ai6 days ago

Open Ai6 days agoPadroneggiare il Fine-Tuning di GPT: Una guida per personalizzare efficacemente i tuoi modelli nel 2025

-

Open Ai7 days ago

Open Ai7 days agoConfronto tra ChatGPT di OpenAI, Claude di Anthropic e Bard di Google: quale strumento di IA generativa dominerà nel 2025?

-

Open Ai6 days ago

Open Ai6 days agoTariffe di ChatGPT nel 2025: Tutto quello che devi sapere su prezzi e abbonamenti

-

Open Ai7 days ago

Open Ai7 days agoLa Fase di Eliminazione dei Modelli GPT: Cosa Possono Aspettarsi gli Utenti nel 2025

-

Modelli di IA6 days ago

Modelli di IA6 days agoModelli GPT-4: Come l’Intelligenza Artificiale sta Trasformando il 2025