Инновации

Исследователи PSU и Duke представляют революционный автоматизированный метод определения причин сбоев в системах с множеством агентов

Исследователи из PSU и Университета Дьюка вместе с сотрудниками Google DeepMind и других исследовательских лабораторий формализовали новую задачу в области искусственного интеллекта: автоматическое определение причины сбоя в многопроцессорных системах на базе LLM. В работе представлен эталон Who&When — набор данных и оценочный комплекс, предназначенный для идентификации агента, вызвавшего сбой, и шага, на котором это произошло. Этот проект появился своевременно, поскольку масштабируются автономные системы, а для отладки требуются более точные и быстрые диагностические инструменты.

| Спешите? Вот что важно: |

|---|

| • 🔎 Новая задача: автоматизация «кто виноват» и «когда это произошло» в многопроцессорных системах. |

| • 🧪 Эталон Who&When: человекоаннотированные логи из 127 систем позволяют проводить стандартизированное тестирование. |

| • 📉 Сложные результаты: около 53,5% по «кто» и около 14,2% по «когда»; существующие методы слабы на длинных логах. |

| • 🧰 Практические шаги: попробуйте гибридные стратегии и структурированные подсказки; смотрите практическое руководство по корням ошибок задач 🔧 |

Почему автоматическая атрибуция сбоев важна в многопроцессорных системах: прорыв PSU и Университета Дьюка

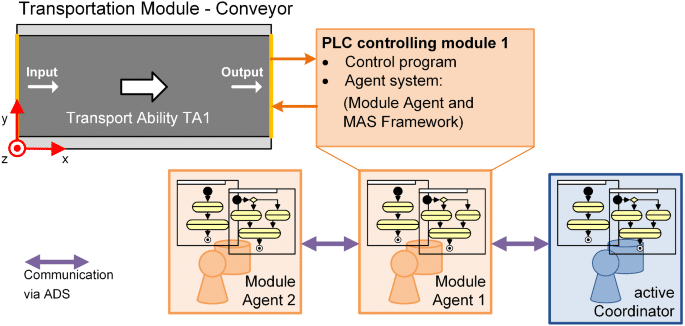

По мере масштабирования многопроцессорных систем на базе LLM разработчики часто сталкиваются с парадоксом: потоки сообщений агентов, срабатывание инструментов, рассуждения по цепочке – и всё равно задача проваливается. В терминах информатики проблема смещается с «каков правильный ответ?» на «где в цепочке сотрудничества произошёл сбой?». Именно этот пробел команда PSU и Университета Дьюка стремится заполнить с помощью автоматической атрибуции сбоев. Цель: превратить часы пролистывания логов в прозрачный, структурированный диагностический этап.

Возьмём Аву, инженера платформы в финтех-стартапе. Её команда автономных систем использует четыре специализированных агента — планировщика, исследователя, кодера и тестировщика. Запрос клиента проваливается после 23 взаимодействий. Без атрибуции выявить корень проблемы сложно: неправильно ли планировщик определил подзадачи, упустил ли исследователь важное API или тестировщик неверно интерпретировал вывод? Атрибуция служит как «чёрный ящик» для координации, позволяя определить ответственного агента и решающий шаг, на котором ошибка запустила сбой.

Узкое место в отладке, с которым сталкиваются разработчики

Современные AI-воркфлоу часто тормозят не на моделировании, а на наблюдаемости. Даже с мощными моделями машинного обучения неясные границы ответственности усложняют циклы итераций и управление. Подход PSU формализует эту проблему как отдельную задачу, связывая отладку с оценкой — давно назревший шаг для автоматизации в масштабе.

- 🧵 Длинные цепочки взаимодействий затрудняют выявление причин через подробные логи.

- 🧭 Неоднозначные роли агентов размывают, кто решил, а кто распространил решение.

- ⏱️ Увеличение времени диагностики из-за необходимости ручной проверки каждого сбоя.

- 🔐 Давление по соответствию требует аудитории данных в исследовательских лабораториях и на продакшн-стеке.

Эталон Who&When решает эту проблему, стандартизируя аннотации «кто» и «когда», обеспечивая количественную оценку. Он также создаёт общий язык для команд: баг — это не просто сбой, а конкретная ошибка агента на определённом шаге, отслеживаемая и устранимая.

| Проблема 🚧 | Почему это важно 💥 | Преимущество атрибуции ✅ |

|---|---|---|

| Непрозрачное взаимодействие агентов | Ошибочные обвинения или неэффективные исправления | Точное «кто» указывает ответственного 🔍 |

| Длинные логи и ограничения контекста | Пропускается важный шаг среди шума | Точное «когда» сужает область поиска ⏳ |

| Ручной разбор логов | Медленные итерации и переутомление | Автоматическая сортировка ускоряет цикл исправлений 🚀 |

| Требования к аудиту и соответствию | Непоследовательные отчёты | Стандартизированные, воспроизводимые доказательства 📚 |

Для команд, управляющих сложными AI-деплойментами, ключевая идея проста: атрибуция превращает хаос в ответственность, создавая рабочий процесс, который напрямую поддерживает надёжность.

Внутри эталона Who&When: дизайн данных, аннотации и охват для атрибуции сбоев

Эталон Who&When агрегирует логи сбоев из 127 многопроцессорных систем, охватывающих разные задачи, использование инструментов и модели координации. Некоторые логи алгоритмически сгенерированы для проверки конкретных типов ошибок; другие созданы экспертами, отражая реалистичные истории сбоев. Каждый лог содержит три критические аннотации: Кто вызвал сбой, Когда произошёл решающий шаг, и Почему это случилось — на естественном языке.

Эта триада важна. «Кто» устанавливает ответственность; «Когда» задаёт временную привязку; «Почему» даёт причинно-следственное объяснение, направляющее исправление. Вместе это делает сбой не просто обнаруживаемым, а объяснимым — необходимым условием для устойчивой автоматизации в продакшн-средах. Стандартизация позволяет исследовательским лабораториям сравнивать методы напрямую, избегая единичных метрик, скрывающих проблемы с обобщением.

Что аннотируется и почему это важно

Руководства по аннотациям гарантируют, что сложные крайние случаи — например, цепные ошибки или незаметные сдвиги — обрабатываются последовательно. При участии нескольких агентов в сбое аннотаторы отмечают решающий момент, когда успех становится недостижимым. Это особенно полезно в планировочных цепочках, где ранняя ошибка может обречь последующие шаги, даже если они выглядят корректными поотдельности.

- 🧩 Идентификация роли: планировщик, критик, исполнитель, вызывающий инструмент, проверяющий и т.д.

- 🕰️ Индекс шага: решающий момент, изменивший результат.

- 🗣️ Причинное объяснение на естественном языке: краткое объяснение причинной связи.

- 🧪 Метаданные задачи: домен, вызванные инструменты, наличие эталона.

Размах эталона поддерживает исследования в разных областях — помощь в программировании, анализ данных, планирование контента и помощь в реальных решениях. Он также позволяет производить контролируемые эксперименты: сохраняется ли атрибуция при смене состава агентов или при периодических сбоях инструментов?

| Поле аннотации 📝 | Определение 📘 | Ценность для отладки 🧯 |

|---|---|---|

| Кто | Агент, ответственный за решающую ошибку | Позволяет направить исправление в нужный модуль 🎯 |

| Когда | Конкретный шаг, на котором произошла фатальная ошибка | Существенно сокращает область поиска в логе 🔍 |

| Почему | Объяснение причинности на естественном языке | Помогает в разработке патча и тестов 🧪 |

| Контекст | Тип задачи, инструменты, статус эталона | Обеспечивает справедливое сравнение методов ⚖️ |

Для команд, желающих отработать послесмертные анализы до инцидентов, практической отправной точкой является чеклист на основе Who&When. Полезным сопровождающим ресурсом служит краткое руководство по отслеживанию корней сбоев в AI-системах, дополняющее отладку на основе эталона.

Разработчики часто спрашивают, может ли автоматический инструмент «просто сказать, что исправить». Атрибуция не заменяет инженерное суждение, но предоставляет цепочку доказательств для быстрых и обоснованных решений. Итог: набор данных превращает анализ сбоев в повторяемое и обучаемое умение.

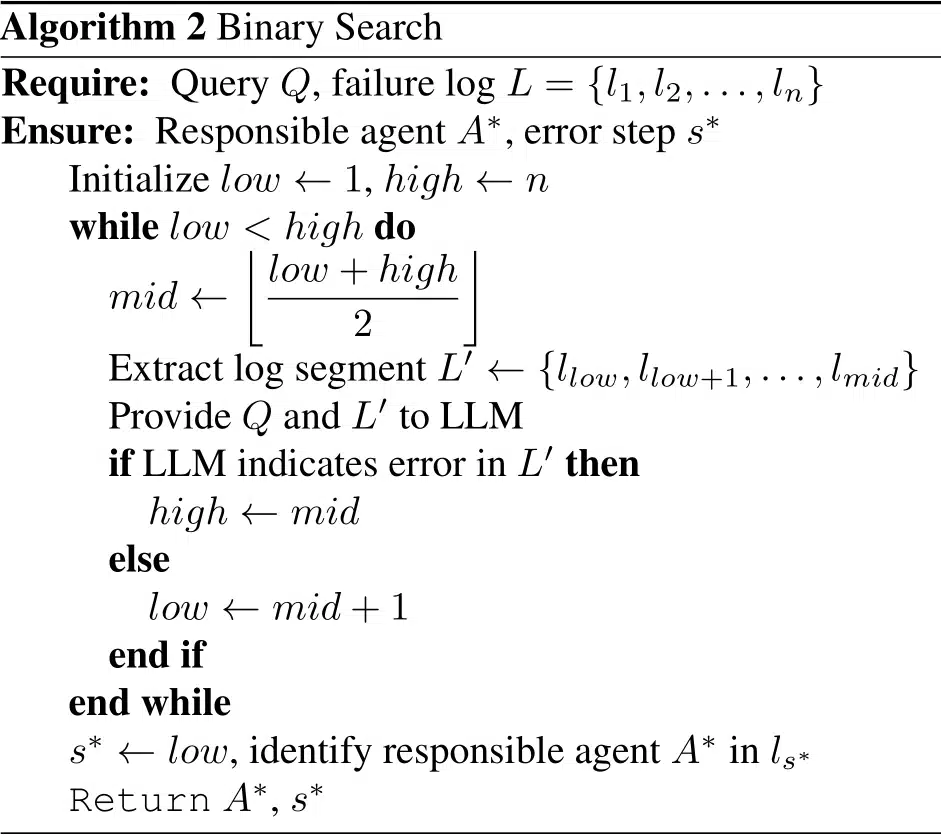

Сравненные методы: сразу, по шагам и двоичный поиск от PSU и Дьюка

Используя Who&When, исследователи оценили три стратегии автоматической атрибуции сбоев. Каждая методика балансирует между затратами, точностью и устойчивостью к длинным контекстам. В исследовании нет одного однозначного победителя — сделан акцент на инструментарий: выбирайте метод, соответствующий бюджету и особенностям ошибок.

Три стратегии, три подхода

Метод «Сразу» читает весь лог сбоя и за один проход выводит ответственного агента и решающий шаг. Он эффективен на коротких логах и чаще точен по «кто», но с ростом контекста может ошибаться по «когда». «По шагам» имитирует человеческую отладку: рассматривает лог шаг за шагом. Это улучшает локализацию, но может накапливать ошибки и увеличивает расход токенов. «Двоичный поиск» совмещает преимущества, рекурсивно разрезая лог пополам и выясняя, в какой половине ошибка, балансируя стоимость и точность.

- ⚡ Сразу: быстро, грубого масштаба, хорошо по «кто».

- 🪜 По шагам: тщательно, дороже, лучше по «когда».

- 🔍 Двоичный поиск: прагматично, средний парк.

- 🧩 Гибридные цепочки: сочетают сильные стороны за счёт больших вычислений.

Исследование также сравнивало работу при наличии и отсутствии эталонного знания о задаче. При наличии эталона методы могли сверять результаты для повышения уверенности; без него приходилось опираться только на динамику взаимодействий — ближе к реальным условиям. В обоих случаях с ростом длины контекста точность падала, особенно по «когда».

| Метод 🧭 | Сильные стороны 💪 | Слабые стороны ⚠️ | Лучшее использование 🧰 |

|---|---|---|---|

| Сразу | Низкая стоимость; сильный «кто» на коротких логах 🙂 | Сложности с длинными контекстами; слабее по «когда» 😵 | Быстрая сортировка на коротких трассах ⏱️ |

| По шагам | Точный «когда»; прозрачные рассуждения 🧠 | Высокий расход токенов; накопление ошибок 📈 | Анализ инцидентов 🧯 |

| Двоичный поиск | Сбалансирован; масштабируем на длинных логах ⚖️ | Может пропускать тонкие межшаговые подсказки 🧩 | Регулярная продуктивная сортировка 🔄 |

Команды могут комбинировать методы: сначала использовать Сразу для отбора агента, затем переключаться на По шагам для точечного уточнения шага. Для практической реализации стоит посмотреть руководство по отслеживанию корней ошибок агентов, в котором показано, как строить подсказки и логи.

Во всех подходах помогает явное обоснование. Подсказки с требованием разъяснений, цитат доказательств и окончательного решения улучшают согласованность. Главный принцип: заставьте модель показывать работу и ссылаться на конкретные повороты — небольшое изменение с большим эффектом в надёжности.

Что показывают результаты: ограничения, затраты и возможности в отладке AI

На Who&When даже самые продвинутые модели столкнулись с суровой реальностью. Лучший одиночный метод набрал примерно 53,5% по определению «кто» вызвал сбой и около 14,2% по точному «когда». Некоторые методы проигрывали случайным базовым линиям в сложных условиях, подчёркивая, что атрибуция требует более сильных причинно-следственных рассуждений, чем обычные задачи QA или суммаризации.

Результаты разделены также по тому, знает ли модель истинный ответ задачи. С эталоном атрибуция может сопоставлять противоречия («планировщик предлагает несовместимый с правильным план»). Без него модель должна диагностировать, основываясь лишь на динамике взаимодействий и следах инструментов — реальный взгляд на продакшн. В обоих режимах длинные контексты ухудшают точность, особенно по «когда».

Основные выводы для разработчиков

Несколько паттернов дают немедленные рекомендации для инженерных команд, стандартизирующих атрибуционные воркфлоу. Во-первых, важна инженерия подсказок: структурированные подсказки с первым обоснованием стабильно повышают согласованность с аннотациями людей. Во-вторых, гибридные цепочки работают лучше одиночных запусков, пусть и дороже. В-третьих, методики управления контекстом (скользящие окна, сводки разделов) помогают компенсировать усталость от контекста.

- 🧠 Явные обоснования повышают точность «кто» и «когда».

- 🧮 Гибридные цепочки меняют токены на качество — планируйте бюджет.

- 🧾 Управление контекстом (окна, выделения) замедляет падение точности.

- 🧰 Выбор модели не панацея; даже продвинутым сложно справиться.

| Параметр 📏 | Наблюдение 🔭 | Вывод 🧩 | Действие ☑️ |

|---|---|---|---|

| Кто vs. Когда | «Кто» проще; «Когда» заметно сложнее | Временная локализация — узкое место ⛔ | Используйте локальное рассуждение по шагам и цитаты 🗂️ |

| Гибридные методы | Высокая точность при высокой стоимости | Полезно для серьёзных инцидентов 🔥 | Переходите от дешёвых к комплексным проходам постепенно 📶 |

| Длина контекста | Снижение качества с ростом длины лога | Одна суммаризация не спасёт 🧱 | Используйте двоичный поиск и предсказатели критических шагов 🧭 |

| Масштаб модели | Более крупная ≠ всегда лучше | Рассуждения важнее мощности 🧠 | Тренируйте шаблоны подсказок; добавляйте эвристики 📐 |

Для прикладного сравнения с повседневной отладкой этот гид по корням сбоев задач AI хорошо сочетается с эмпирическими результатами Who&When, помогая командам связывать метрики с методиками исправления.

Главный вывод стратегический: сделайте атрибуцию полноценным этапом вашего пайплайна, а не побочным шагом. Когда она становится частью цикла сборки, тестирования и деплоя, надёжность растёт равномерно, а не скачкообразно.

Практическое руководство: внедрение автоматической атрибуции сбоев в исследовательских лабораториях и продакшне

Переход от исследований к рутине начинается с инструментализации. Команды могут наслоить атрибуцию поверх существующих оркестрационных фреймворков, логируя структурированные ходы с ролями агентов, вызовами инструментов и промежуточными суждениями. В итоге формируется воспроизводимая цепочка, поддерживающая как оперативную сортировку, так и анализ после инцидентов — в стартапе или крупной платформенной команде.

Проверенный шаблон рабочего процесса

Ниже приведён плейбук, отражающий подходы команд с высоким уровнем зрелости в анализе сбоев при контролируемых затратах. Он сочетает выбор методов, шаблоны подсказок и гигиену логов в устойчивую практику для команд машинного обучения и разработки ПО.

- 🧾 Структура логов: маркируйте каждый ход ролью, намерением, цитатой доказательств и эффектами инструментов.

- 🗂️ Сортировка: используйте Сразу для быстрого определения «кто» по коротким трассам.

- 🧭 Углубление: в сложных случаях переходите к Двоичному поиску или По шагам.

- 🧪 Подсказки с обоснованиями: требуйте объяснений и цитат конкретных ходов.

- 🧯 Правила эскалации: используйте гибриды только для серьёзных или повторяющихся инцидентов.

| Этап 🛠️ | Цель 🎯 | Сочетание методов 🧪 | Совет по эксплуатации 🧭 |

|---|---|---|---|

| Инструментализация | Собирать полезные логи | Метки ролей + следы инструментов | Обеспечить схему в CI ✅ |

| Быстрая сортировка | Определить вероятного агента | Сразу | Ограничить контекст критическими ходами ✂️ |

| Локализация | Точно определить решающий шаг | Двоичный поиск → По шагам | Цитировать доказательства из лога 🔎 |

| Исправление | Применить целевой фикс | Обновления спецификаций, тесты, защитные меры | Тестировать на похожих сбоях ♻️ |

Чтобы команды могли начать, есть несколько лаконичных объяснений маршрута от симптомов к корню. Обзор по поиску корневых причин в рабочих процессах агентов полезен для адаптации, а сопутствующая заметка по отладке передачи между агентами раскрывает проблемы координации. Для менеджеров по надёжности есть плейбук по разработке SLO с учётом атрибуции, связывающий метрики с операционными целями. Команды, работающие с регулируемыми доменами, могут адаптировать эти идеи для аудита: смотрите рекомендации по документированию причин инцидентов. Для глубокого погружения подходит практическое исследование анализа корня неисправностей в соответствии со схемой Who&When.

Два последних замечания по внедрению. Во-первых, атрибуция должна быть модельно-агностичной и ориентированной на логи: обеспечьте схему, чтобы любая модель могла участвовать. Во-вторых, учитывайте затраты явно; гибриды используйте только при оправданной важности инцидента. Практическое правило ясно: оптимизируйте быстрые и объяснимые исправления, затем по мере развития таксономии ошибок масштабируйте сложность.

От исследований к дорожной карте: что значит работа PSU и Дениса для следующего поколения автономных систем

Формализовав автоматическую атрибуцию сбоев, команда PSU и Университета Дьюка переосмыслила отладку как измеряемую способность в системах искусственного интеллекта, а не как ремесленное умение. Этот сдвиг выгоден исследователям, платформенным командам и продуктовым лидерам. Это мост между оценкой и улучшением — недостающая составляющая, делающая итерации системными.

Что будет дальше

Впереди вероятно появление более богатых причинно-следственных сигналов (например, семантики инструментов), предсказания критических шагов и обучаемых политик выбора методов с учётом затрат. Ожидайте более тесной интеграции с оркестрационными фреймворками, контрактного тестирования API между агентами и дашбордов, где «кто» и «когда» будут напрямую связаны с шаблонами исправлений. По мере развития атрибуции многопроцессорные системы станут менее хрупкими, а их отказы — менее загадочными.

- 🧭 Причинные подсказки: интеграция результатов инструментов и изменений состояний в подсказки атрибутора.

- 🧱 Защитные агенты: добавление проверок по рискованным паттернам «кто/когда».

- 📊 Видимость операций: отображение метрик атрибуции в скорбордах надёжности.

- 🧑⚖️ Управление: поддержание отчетов, готовых к аудиту для обзоров инцидентов.

| Заинтересованные лица 👥 | Ценность атрибуции 💡 | Первый шаг 🪜 | Сигнал для мониторинга 👁️ |

|---|---|---|---|

| Исследовательские лаборатории | Сравнимые базовые линии по методам | Внедрить разбиение Who&When | Разрыв между «кто» и «когда» 📉 |

| Платформенные команды | Ускоренное разрешение инцидентов | Логи с применением схемы | Среднее время до атрибуции ⏱️ |

| Владельцы продуктов | Предсказуемые циклы итераций | Плейбук по сортировке | Частота регрессий после исправлений 🔁 |

| Соответствие | Отчёты готовые к аудиту | Шаблоны отчётов | Покрытие обоснований «почему» 📚 |

Раньше отладка была ремеслом. С атрибуцией она становится возможностью операционной системы для AI-продуктов. Направление однозначно: надёжность через доказательное рассуждение, и вклад PSU и Дьюка является ключевым этапом.

{“@context”:”https://schema.org”,”@type”:”FAQPage”,”mainEntity”:[{“@type”:”Question”,”name”:”Что такое автоматическая атрибуция сбоев?”,”acceptedAnswer”:{“@type”:”Answer”,”text”:”Это формальная задача, определяющая, какой агент ответственен за сбой («кто») и решающий ошибочный шаг («когда») в многопроцессорных системах на базе LLM. Команда PSU и Университета Дьюка сформулировала задачу и выпустила эталон Who&When с человекоаннотациями по «кто», «когда» и «почему».”}},{“@type”:”Question”,”name”:”Почему текущие методы достигают только около 53,5% по «кто» и 14,2% по «когда»?”,”acceptedAnswer”:{“@type”:”Answer”,”text”:”Атрибуция требует причинно-следственного анализа длинных, зашумлённых логов. Моделям необходимо изолировать решающий шаг, гарантировавший сбой, что сложнее типичных задач QA. Длина контекста, тонкие передачи и накопление ошибок делают «когда» особенно трудным.”}},{“@type”:”Question”,”name”:”Как командам начать использовать атрибуцию в продакшне?”,”acceptedAnswer”:{“@type”:”Answer”,”text”:”Инструментировать логи с метками ролей и следами инструментов, запустить быструю сортировку методом «Сразу», затем переходить к двоичному поиску или пошаговому анализу для сложных случаев. Требовать явных обоснований в подсказках и учитывать стоимость, используя гибриды только при серьёзности.”}},{“@type”:”Question”,”name”:”Заменяет ли это модульные тесты и оценки?”,”acceptedAnswer”:{“@type”:”Answer”,”text”:”Нет. Атрибуция дополняет тесты и оценки, объясняя причинность сбоев. Она связывает «что сломалось» и «почему сломалось», позволяя целенаправленно исправлять и улучшать регрессионные тесты.”}},{“@type”:”Question”,”name”:”Где я могу узнать практические методы анализа корня проблем у агентов?”,”acceptedAnswer”:{“@type”:”Answer”,”text”:”Краткой и применимой отправной точкой служит руководство по отслеживанию сбоев: смотрите ресурс по корням сбоев задач по ссылке: https://chat-gpt-5.ai/task-failure-root-causes.”}}]}Что такое автоматическая атрибуция сбоев?

Это формальная задача, определяющая, какой агент ответственен за сбой («кто») и решающий ошибочный шаг («когда») в многопроцессорных системах на базе LLM. Команда PSU и Университета Дьюка сформулировала задачу и выпустила эталон Who&When с человекоаннотациями по «кто», «когда» и «почему».

Почему текущие методы достигают только около 53,5% по «кто» и 14,2% по «когда»?

Атрибуция требует причинно-следственного анализа длинных, зашумлённых логов. Моделям необходимо изолировать решающий шаг, гарантировавший сбой, что сложнее типичных задач QA. Длина контекста, тонкие передачи и накопление ошибок делают «когда» особенно трудным.

Как командам начать использовать атрибуцию в продакшне?

Инструментировать логи с метками ролей и следами инструментов, запустить быструю сортировку методом «Сразу», затем переходить к двоичному поиску или пошаговому анализу для сложных случаев. Требовать явных обоснований в подсказках и учитывать стоимость, используя гибриды только при серьёзности.

Заменяет ли это модульные тесты и оценки?

Нет. Атрибуция дополняет тесты и оценки, объясняя причинность сбоев. Она связывает «что сломалось» и «почему сломалось», позволяя целенаправленно исправлять и улучшать регрессионные тесты.

Где я могу узнать практические методы анализа корня проблем у агентов?

Краткой и применимой отправной точкой служит руководство по отслеживанию сбоев: смотрите ресурс по корням сбоев задач по ссылке: https://chat-gpt-5.ai/task-failure-root-causes.

-

Open Ai6 days ago

Open Ai6 days agoGPT-4 Turbo 128k: Раскрывая инновации и преимущества 2025 года

-

Инструменты2 weeks ago

Инструменты2 weeks agoОткройте лучшие инструменты для генерации имен гномов для уникальных фэнтезийных имен

-

Open Ai1 week ago

Open Ai1 week agoОткрывая возможности плагинов ChatGPT: улучшите свой опыт в 2025 году

-

Open Ai6 days ago

Open Ai6 days agoОсвоение тонкой настройки GPT: руководство по эффективной кастомизации ваших моделей в 2025 году

-

Модели ИИ6 days ago

Модели ИИ6 days agoМодели GPT-4: Как искусственный интеллект преобразует 2025 год

-

Open Ai7 days ago

Open Ai7 days agoСравнивая ChatGPT от OpenAI, Claude от Anthropic и Bard от Google: какой инструмент генеративного ИИ будет доминировать в 2025 году?