Innovatie

PSU en Duke-onderzoekers onthullen baanbrekende geautomatiseerde fouttoewijzing voor multi-agent systemen

PSU- en Duke University-onderzoekers, samen met samenwerkingspartners van Google DeepMind en andere Onderzoekslaboratoria, hebben een nieuw probleem in Kunstmatige Intelligentie geformaliseerd: Geautomatiseerde Fouttoeschrijving voor door LLM aangestuurde Multi-Agent Systemen. Het werk introduceert de Who&When benchmark, een dataset en evaluatiesuite ontworpen om te identificeren welke agent een storing heeft veroorzaakt en op welke stap. De inspanning komt op een tijdig moment aangezien Autonomous Systems opschalen en debugging scherpere, snellere diagnostische tools vereist.

| Haast? Dit is wat telt: |

|---|

| • 🔎 Nieuwe taak: Automatiseer “wie faalde” en “wanneer het gebeurde” in Multi-Agent Systemen. |

| • 🧪 Who&When benchmark: Door mensen geannoteerde logs van 127 systemen maken gestandaardiseerde tests mogelijk. |

| • 📉 Uitdagende resultaten: ~53,5% op “wie” en ~14,2% op “wanneer”; huidige methoden falen bij lange logs. |

| • 🧰 Uitvoerbare volgende stappen: Probeer hybride strategieën en gestructureerde prompts; zie een praktische gids over oorzaken van taakfalen 🔧 |

Waarom Geautomatiseerde Fouttoeschrijving van Belang is in Multi-Agent Systemen: Doorbraak van PSU en Duke Onderzoekers

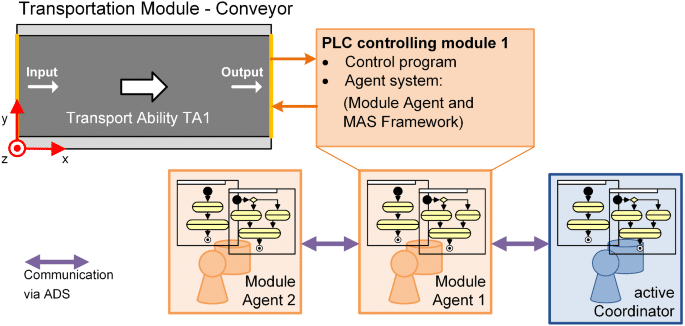

Naarmate met LLM aangedreven Multi-Agent Systemen opschalen, komen ontwikkelaars vaak paradoxen tegen: een stortvloed aan agentberichten, tools die afgaan, chain-of-thought redenering—en toch mislukt de taak. In termen van Computerwetenschap verschuift het probleem van “wat was het juiste antwoord?” naar “waar in de samenwerking begon de storing?” Dat is precies de kloof die het PSU- en Duke University-team aanpakt met Geautomatiseerde Fouttoeschrijving. Het doel: urenlang zoeken door logs veranderen in een transparante, gestructureerde diagnostische stap.

Denk aan Ava, een platformingenieur bij een fintech-startup. Haar Autonomous Systems-team gebruikt vier gespecialiseerde agents—planner, onderzoeker, programmeur en tester. Een klantvraag mislukt na 23 interacties. Zonder toeschrijving is het diagnosticeren van de oorzaak vaag: heeft de planner subdoelen verkeerd gespecificeerd, heeft de onderzoeker een belangrijke API gemist, of heeft de tester de output verkeerd geïnterpreteerd? Toeschrijving functioneert als een black box-recorder voor coördinatie, die de verantwoordelijke agent en de beslissende stap identificeert waar de fout de storing in gang zette.

De bottleneck waar ontwikkelaars tegenaan lopen bij debugging

Moderne AI-werkstromen stagneren vaak door observeerbaarheid, niet door modelleer-capaciteit. Zelfs met sterke Machine Learning-modellen bemoeilijken onduidelijke verantwoordelijkheidslijnen iteratiecycli en governance. De door PSU geleide framing formaliseert dit als een aparte taak, die debugging aan evaluatie koppelt—een lang uitgestelde stap voor automatisering op schaal.

- 🧵 Lange interactieketens maken het moeilijk om causaliteit te zien in drukke logs.

- 🧭 Ambigue agentrollen vervagen wie een beslissing nam versus wie deze doorgeeft.

- ⏱️ Tijd tot diagnose neemt explosief toe als elke storing menselijke speurtocht vereist.

- 🔐 Compliancedruk vereist auditbaarheid over Onderzoekslaboratoria en productie-omgevingen heen.

De Who&When benchmark pakt deze pijn aan door “wie” en “wanneer” annotaties te standaardiseren, wat kwantitatieve evaluatie mogelijk maakt. Het creëert ook een gedeelde taal binnen teams: een bug is niet slechts een storing, maar een specifieke agent-stap fout, traceerbaar en oplosbaar.

| Uitdaging 🚧 | Waarom het pijn doet 💥 | Toeschrijvingsvoordeel ✅ |

|---|---|---|

| Ondoorzichtige agentcoördinatie | Verkeerde schuld of onscherpe fixes | Precieze “wie” wijst verantwoordelijkheid aan 🔍 |

| Lange logs en contextlimieten | Belangrijke stap gemist in ruis | Exacte “wanneer” versmalt zoekvenster ⏳ |

| Handmatige log-analyse | Langzame iteraties en burn-out | Geautomatiseerde triage versnelt bug-fix cyclus 🚀 |

| Compliancy-/auditvereisten | Inconsistente nacalculaties | Gestandaardiseerd, reproduceerbaar bewijs 📚 |

Voor teams die complexe AI-uitrol beheren is de belangrijkste les simpel: toeschrijving verandert chaos in verantwoordelijkheid, wat een workflow creëert die betrouwbaarheid direct ondersteunt.

Inzichten in de Who&When Benchmark: Datadesign, Annotaties en Dekking voor Fouttoeschrijving

De Who&When benchmark verzamelt foutlogs van 127 Multi-Agent Systemen met uiteenlopende taken, toolgebruik en coördinatiepatronen. Sommige logs zijn algoritmisch gegenereerd om specifieke foutmodi te belasten; anderen zijn handmatig gemaakt door experts om realistische faalverhalen weer te geven. Elke log bevat drie cruciale annotaties: Wie veroorzaakte de fout, Wanneer de beslissende stap plaatsvond, en Waarom het gebeurde in natuurlijke taal.

Deze drie-eenheid is belangrijk. “Wie” stelt verantwoordelijkheid vast; “Wanneer” biedt een tijdsaanduiding; “Waarom” levert causale redenering die een corrigerend patch aanstuurt. Samen maken ze falen niet alleen detecteerbaar maar ook verklaarbaar—een vereiste voor duurzame automatisering in productieomgevingen. Standaardisatie laat Onderzoekslaboratoria daarnaast methoden appels-met-appels vergelijken, waardoor eenmalige metrics die generalisatieproblemen maskeren worden vermeden.

Wat wordt geannoteerd en waarom is dat belangrijk

Annotatierichtlijnen zorgen dat moeilijke randgevallen—zoals ketenfouten of stille afwijkingen—consistente worden afgehandeld. Wanneer meerdere agents bijdragen aan een storing, markeren annotatoren het beslissende punt waar succes onmogelijk werd. Dit is vooral nuttig in planningspijplijnen, waar een vroege mis-specifcatie later stappen kan doem brengen, ook als die op zichzelf correct lijken.

- 🧩 Rol-identiteit: planner, criticus, uitvoerder, tool-aanroeper, verifier, enz.

- 🕰️ Stapindex: het beslissende moment dat het resultaat omkeerde.

- 🗣️ Natuurlijke taalredenering: een beknopte uitleg van de oorzaak.

- 🧪 Taakmetadata: domein, gebruikte tools, beschikbaarheid van waarheid.

De breedte van de benchmark ondersteunt studie over domeinen heen—codeerhulp, data-analyse, contentplanning en beslissingsondersteuning in de echte wereld. Het maakt ook gecontroleerde ablatie mogelijk: houdt toeschrijving stand als agenten wisselen of tools intermitterend falen?

| Annotatieveld 📝 | Definitie 📘 | Debugwaarde 🧯 |

|---|---|---|

| Wie | Agent verantwoordelijk voor de beslissende fout | Richt remedie op de juiste module 🎯 |

| Wanneer | Specifieke stap waar de fatale fout plaatsvond | Reduceert zoekruimte in logs drastisch 🔍 |

| Waarom | Natuurlijke taalverklaring van causaliteit | Begeleidt patchontwikkeling en testgevallen 🧪 |

| Context | Taaktype, tools en status van grondwaarheid | Maakt eerlijke methodenvergelijkingen mogelijk ⚖️ |

Voor teams die nacalculaties willen oefenen vóór incidenten, is een praktisch startpunt een checklist geïnformeerd door Who&When. Een nuttige metgezel is deze beknopte gids voor het traceren van faaloorzaken in AI-systemen, die benchmark-gedreven debugging aanvult.

Ontwikkelaars vragen vaak of een geautomatiseerde tool “gewoon kan vertellen wat ik moet repareren.” Toeschrijving vervangt geen engineering-oordeel, maar levert het bewijspad dat snelle, verdedigbare beslissingen mogelijk maakt. Het resultaat: de dataset verandert faalanalyse in een herhaalbare, leerbare vaardigheid.

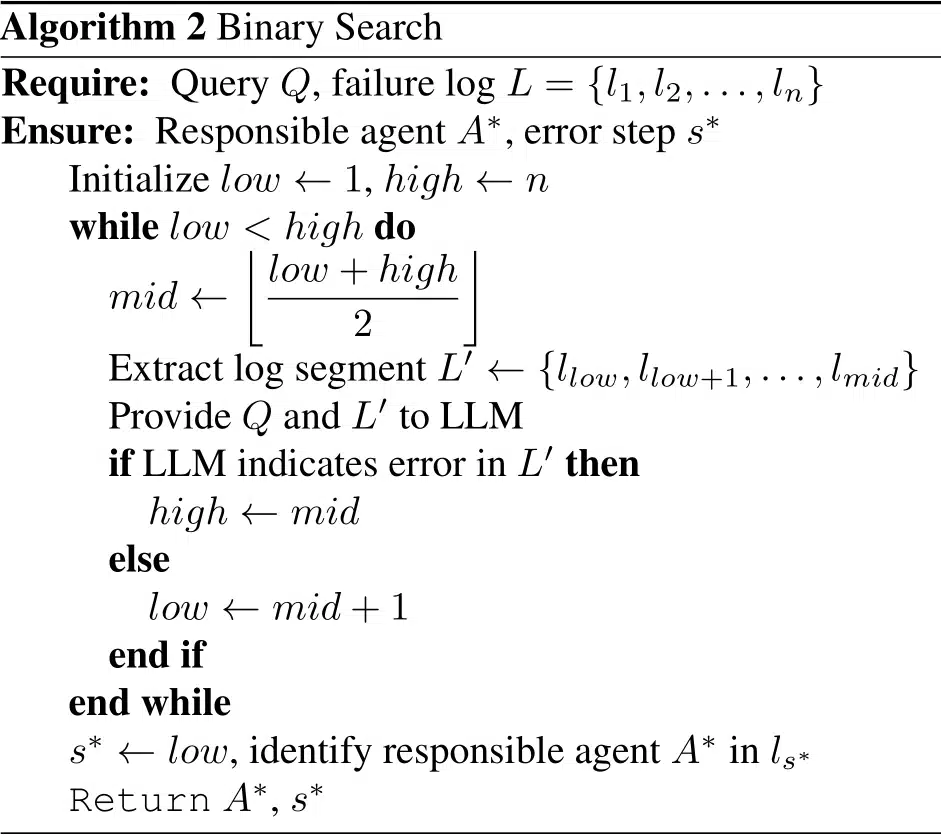

Vergelijking van Methoden: All-at-Once, Stap-voor-Stap en Binaire Zoekstrategieën van PSU en Duke

Met behulp van Who&When evalueerden de onderzoekers drie strategieën voor Geautomatiseerde Fouttoeschrijving. Elke methode ruilt kosten, nauwkeurigheid en robuustheid bij lange contexten tegen elkaar in. In plaats van een onbetwiste kampioen benadrukt de studie een gereedschapskist-benadering: kies de methode die past bij je budget en foutoppervlak.

Drie strategieën, drie denkwijzen

All-at-Once leest de gehele foutlog en geeft in één keer de verantwoordelijke agent en beslissende stap terug. Het is efficiënt bij korte logs en vaak beter in “wie,” maar kan “wanneer” verkeerd plaatsen als de context groeit. Stap-voor-Stap spiegelt menselijke speurtocht: het doorloopt de log en beoordeelt elke stap. Dit verbetert lokalisatie maar kan eerdere beoordelingsfouten opstapelen en verhoogt tokenkosten. Binaire Zoek deelt het verschil door de log recursief te halveren en te vragen welke helft de fout verbergt, wat kosten en precisie balanceert.

- ⚡ All-at-Once: snel, grofmazig, solide voor “wie.”

- 🪜 Stap-voor-Stap: nauwkeurig “wanneer”; transparante redenering 🧠

- 🔍 Binaire Zoek: pragmatisch, goede gemiddelde trade-off.

- 🧩 Hybride ketens: combineren sterktes tegen meer compute-kosten.

De studie mat ook prestaties met en zonder grondwaarheidskennis van de onderliggende taak. Als grondwaarheid beschikbaar is, kunnen methoden uitkomsten tegen elkaar afzetten om vertrouwen te verhogen; zonder die kennis moeten ze alleen uit interactiedynamiek en toolsporen afleiden—dichter bij reële omstandigheden. In beide gevallen verslechtert nauwkeurigheid bij langere contexten, vooral voor “wanneer.”

| Methode 🧭 | Sterktes 💪 | Zwaktes ⚠️ | Beste Gebruik 🧰 |

|---|---|---|---|

| All-at-Once | Laag kost; sterk in “wie” bij korte logs 🙂 | Worstelt bij lange contexten; zwakker in “wanneer” 😵 | Snel triage op korte sporen ⏱️ |

| Stap-voor-Stap | Nauwkeurig “wanneer”; transparante redenering 🧠 | Hoog tokenverbruik; cumulatie van fouten 📈 | Nacalculaties voor kritieke incidenten 🧯 |

| Binaire Zoek | Gebalanceerd; schaalbaar bij langere logs ⚖️ | Kan subtiele cross-step aanwijzingen missen 🧩 | Routine productietriage 🔄 |

Teams kunnen methoden combineren: gebruik All-at-Once om de agent te filteren, daarna Stap-voor-Stap om de beslissende stap exact te lokaliseren. Voor een hands-on implementatieblauwdruk laat deze praktische walkthrough over het traceren van faaloorzaken bij agenten zien hoe je prompts en logs structureert.

Over alle strategieën helpt expliciete redenering. Prompts die een rationale, bewijscitaten en een uiteindelijke beslissing vereisen, verhogen de consistentie. Het leidprincipe: dwing het model zijn werk te tonen en specifieke beurten te citeren—een kleine verandering die betrouwbaarheid versterkt.

Wat de Resultaten Tonen: Grenzen, Kosten en Kansen in AI Debugging

Op Who&When ondervonden zelfs topmodellen een realiteitstest. De beste enkele methode scoorde zo’n 53,5% op het identificeren van “wie” de fout veroorzaakte en ongeveer 14,2% op de exacte “wanneer.” Sommige methoden deden het slechter dan willekeurige grondlijnen in moeilijke omstandigheden, wat benadrukt dat toeschrijving sterkere causale redenering vereist dan typische QA of samenvattingsopdrachten.

Resultaten zijn verder uitgesplitst naar mate het model het echte taakantwoord kent. Met grondwaarheid kan toeschrijving tegenstrijdigheden trianguleren (“het plan van de planner strookt niet met het correcte antwoord”). Zonder die kennis moet het model diagnosticeren op alleen conversatiedynamiek en toolsporen—een authentiekere kijk op productie. In beide gevallen neemt de nauwkeurigheid af bij langere contexten, vooral bij “wanneer.”

Belangrijke bevindingen voor ontwikkelaars

Verschillende patronen bieden directe richtlijnen voor engineeringteams die toeschrijvingsworkflows standaardiseren. Ten eerste, prompt-engineering is doorslaggevend: gestructureerde, rationale-eerst prompts verbeterden consistentie met menselijke annotaties. Ten tweede presteren hybride methoden beter dan individuele runs, hoewel de kosten stijgen. Ten derde helpen lengtebewuste ontwerpen—zoals schuivende vensters of sectiesamenvattingen—om contextvermoeidheid te verminderen.

- 🧠 Explciiete rationales verbeteren zowel “wie” als “wanneer”.

- 🧮 Hybride pipelines ruilen tokens voor kwaliteit—budgetteer dienovereenkomstig.

- 🧾 Contextbeheer (vensters, highlights) vertraagt nauwkeurigheidsverlies.

- 🧰 Modelkeuze is geen heilige graal; zelfs geavanceerde redenaars worstelen.

| Dimensie 📏 | Observatie 🔭 | Implicatie 🧩 | Actie ☑️ |

|---|---|---|---|

| Wie vs. Wanneer | “Wie” is makkelijker; “Wanneer” is opvallend moeilijker | Temporale lokalisatie is de bottleneck ⛔ | Pas stap-gewijze redenering en bewijscitaten toe 🗂️ |

| Hybride methoden | Hogere nauwkeurigheid tegen hogere kosten | Handig voor ernstige incidenten 🔥 | Ga progressief van goedkoop naar uitgebreid 📶 |

| Contextlengte | Prestaties verminderen bij langere logs | Samenvatten alleen is niet voldoende 🧱 | Gebruik binaire zoek- en cruciale-stap voorspellers 🧭 |

| Modelgrootte | Groter ≠ altijd beter | Redenering > ruwe capaciteit hier 🧠 | Train promptpatronen; voeg heuristieken toe 📐 |

Voor een pragmatische vergelijking met dagelijkse troubleshooting past deze gids over oorzaken van taakfalen goed bij de empirische Who&When-resultaten, waarmee teams metrics koppelen aan fixstrategieën.

De kernboodschap is strategisch: maak toeschrijving een volwaardige fase in je pipeline, niet een bijzaak. Wordt het onderdeel van de build-test-deploy cyclus, dan verbetert betrouwbaarheid gestaag in plaats van sporadisch.

Praktisch Handboek: Geautomatiseerde Fouttoeschrijving Werkzaam Maken in Onderzoekslaboratoria en Productie

Onderzoek omzetten in routinepraktijk begint met instrumentatie. Teams kunnen toeschrijving in bestaande orkestratiekaders leggen, met het loggen van gestructureerde beurten met agentrollen, tool-aanroepen en tussentijdse oordelen. Het resultaat is een reproduceerbaar spoor dat zowel realtime triage als post-incident reviews ondersteunt, of het nu een startup of een groot platformteam betreft.

Een praktijkgetemplateerde workflow

Het volgende handboek spiegelt hoe teams met hoge volwassenheid falenanalyse benaderen terwijl kosten beheersbaar blijven. Het combineert methodeselectie, promptpatronen en loghygiëne tot een duurzame praktijk voor Machine Learning en Software Engineering groepen.

- 🧾 Logstructuur: label elke beurt met rol, intentie, geciteerde bewijzen en tool-effecten.

- 🗂️ Triage-run: voer All-at-Once uit voor snelle “wie” op korte sporen.

- 🧭 Diepgang: voor complexe gevallen, schakel naar Binaire Zoek of Stap-voor-Stap.

- 🧪 Rationale-prompts: vereist uitleg en citeer specifieke beurten.

- 🧯 Escalatieregels: gebruik hybriden alleen voor ernstige of herhaalde incidenten.

| Fase 🛠️ | Doel 🎯 | Methode Mix 🧪 | Ops Tip 🧭 |

|---|---|---|---|

| Instrumentatie | Leg actiegerichte logs vast | Rol-tags + toolsporen | Dwing schema af in CI ✅ |

| Snel triage | Vind de waarschijnlijke agent | All-at-Once | Beperk context tot cruciale beurten ✂️ |

| Lokalisatie | Plaatst de beslissende stap precies | Binaire Zoek → Stap-voor-Stap | Citeer bewijzen uit de log 🔎 |

| Remediatie | Pas gerichte fix toe | Spec-update, tests, veiligheidsvoorzieningen | Backtest tegen soortgelijke fouten ♻️ |

Om teams op weg te helpen illustreren verscheidene beknopte uitleggen het traject van symptoom tot grondoorzaak. Dit overzicht over hoe je grondoorzaken in agent-werkstromen opspoort is nuttig voor onboarding, terwijl deze begeleidende notitie over debugging van agent-overdrachten dieper ingaat op coördinatievalkuilen. Voor reliability engineering-managers verbindt een handleiding over ontwerp van met toeschrijving geïnformeerde SLO’s metrics aan operationele afspraken. Teams die standaardiseren in gereguleerde domeinen kunnen dezelfde ideeën toepassen voor auditsporen: zie deze richtlijn over documentatie van incidentcausaliteit. En voor diepere achtergrondinformatie sluit een praktische deep dive in root cause analyse goed aan bij het schema van Who&When.

Twee laatste opmerkingen voor implementatie. Ten eerste moet toeschrijving model-agnostisch en log-centraal zijn: dwing een schema af zodat elk model kan participeren. Ten tweede, bewaak kosten expliciet; gebruik hybriden alleen wanneer de ernst dit rechtvaardigt. De praktische regel is duidelijk: optimaliseer voor snelle, verklaarbare fixes, en verhoog daarna de complexiteit naarmate je incidententaxonomie rijpt.

Van Onderzoek naar Routekaart: Wat het Werk van PSU en Duke Betekent voor de Volgende Golf Autonomous Systems

Door Geautomatiseerde Fouttoeschrijving te formaliseren, herdefinieert het PSU- en Duke University-team debugging als een meetbare vaardigheid binnen Kunstmatige Intelligentie-systemen, niet als ambachtelijke vaardigheid. Die verandering profiteert onderzoekers, platformteams en productleiders tegelijk. Het is een brug tussen evaluatie en verbetering—de ontbrekende schakel die iteratie systematisch maakt.

Waar dit naartoe gaat

De weg vooruit zal waarschijnlijk rijkere causale signalen bevatten (bijv. toolsemantiek), voorspelling van kritieke stappen, en geleerde beleidslijnen voor methodeselectie onder kostbeperkingen. Verwacht nauwere integratie met orkestratiekaders, contracttesten voor inter-agent API’s, en dashboards waar “wie” en “wanneer” doorstromen in remediatie-templates. Naarmate toeschrijving rijpt, worden Multi-Agent Systemen minder fragiel en hun storingen minder mysterieus.

- 🧭 Causale aanwijzingen: integreer tooluitkomsten en statusveranderingen in toeschrijver-prompts.

- 🧱 Agents met veiligheidsvoorzieningen: voeg controles toe die te risicovolle “wie/wanneer”-patronen triggeren.

- 📊 Ops-zichtbaarheid: toon toeschrijvingsmetrics in betrouwbaarheids-scorekaarten.

- 🧑⚖️ Governance: onderhoud auditklare narratieven voor incidentreviews.

| Belanghebbende 👥 | Waarde van Toeschrijving 💡 | Eerste Stap 🪜 | Signaal om op te letten 👁️ |

|---|---|---|---|

| Onderzoekslaboratoria | Vergelijkbare baselines over methoden heen | Adopteer Who&When-splitsingen | Kloof tussen “wie” en “wanneer” 📉 |

| Platformteams | Snellere incidentoplossing | Schema-afgedwongen logs | Gemiddelde tijd tot toeschrijving ⏱️ |

| Producteigenaren | Voorspelbare iteratiecycli | Triage-handboek | Regressieratio na fixes 🔁 |

| Compliance | Auditklare nacalculaties | Template-narratieven | Dekking van “waarom” rationales 📚 |

Debugging was ooit een ambacht. Met toeschrijving wordt het een besturingssysteemcapaciteit voor AI-producten. De richting is onmiskenbaar: betrouwbaarheid door bewijs-gebaseerde redenering, met de bijdrage van PSU en Duke als een bepalende stap.

{“@context”:”https://schema.org”,”@type”:”FAQPage”,”mainEntity”:[{“@type”:”Question”,”name”:”Wat is precies Geautomatiseerde Fouttoeschrijving?”,”acceptedAnswer”:{“@type”:”Answer”,”text”:”Het is een formele taak die identificeert welke agent verantwoordelijk is voor een fout (‘wie’) en de beslissende foutstap (‘wanneer’) in LLM Multi-Agent Systemen. Het PSU- en Duke University-team definieerde de taak en bracht de Who&When benchmark uit met door mensen gemaakte annotaties voor wie, wanneer en waarom.”}},{“@type”:”Question”,”name”:”Waarom scoren huidige methoden slechts ongeveer 53,5% voor ‘wie’ en 14,2% voor ‘wanneer’?”,”acceptedAnswer”:{“@type”:”Answer”,”text”:”Toeschrijving vereist causale redenering over lange, rumoerige logs. Modellen moeten de beslissende stap isoleren die de fout garandeerde, wat moeilijker is dan typische QA. Contextlengte, subtiele overdrachten en cumulatieve fouten maken ‘wanneer’ bijzonder uitdagend.”}},{“@type”:”Question”,”name”:”Hoe kunnen teams beginnen met toeschrijving in productie?”,”acceptedAnswer”:{“@type”:”Answer”,”text”:”Instrumenteer logs met rol-tags en toolsporen, voer een snelle All-at-Once triage uit en escaleren daarna naar Binaire Zoek of Stap-voor-Stap voor moeilijke incidenten. Vereis expliciete rationales in prompts en houd kosten bij zodat hybriden alleen worden gebruikt als de ernst het rechtvaardigt.”}},{“@type”:”Question”,”name”:”Vervangt dit unittests en evaluaties?”,”acceptedAnswer”:{“@type”:”Answer”,”text”:”Nee. Toeschrijving vult tests en evaluaties aan door faaloorzaak uit te leggen. Het koppelt ‘wat faalde’ aan ‘waarom het faalde’, wat gerichte fixes en betere regressietests mogelijk maakt.”}},{“@type”:”Question”,”name”:”Waar kan ik praktische grondoorzaaktechnieken voor agents leren?”,”acceptedAnswer”:{“@type”:”Answer”,”text”:”Een beknopt, toepasbaar startpunt is deze gids over het traceren van fouten: zie de bron over faaloorzaken in taken hier: https://chat-gpt-5.ai/task-failure-root-causes.”}}]}Wat is precies Geautomatiseerde Fouttoeschrijving?

Het is een formele taak die identificeert welke agent verantwoordelijk is voor een fout (‘wie’) en de beslissende foutstap (‘wanneer’) in LLM Multi-Agent Systemen. Het PSU- en Duke University-team definieerde de taak en bracht de Who&When benchmark uit met door mensen gemaakte annotaties voor wie, wanneer en waarom.

Waarom scoren huidige methoden slechts ongeveer 53,5% voor ‘wie’ en 14,2% voor ‘wanneer’?

Toeschrijving vereist causale redenering over lange, rumoerige logs. Modellen moeten de beslissende stap isoleren die de fout garandeerde, wat moeilijker is dan typische QA. Contextlengte, subtiele overdrachten en cumulatieve fouten maken ‘wanneer’ bijzonder uitdagend.

Hoe kunnen teams beginnen met toeschrijving in productie?

Instrumenteer logs met rol-tags en toolsporen, voer een snelle All-at-Once triage uit en escaleren daarna naar Binaire Zoek of Stap-voor-Stap voor moeilijke incidenten. Vereis expliciete rationales in prompts en houd kosten bij zodat hybriden alleen worden gebruikt als de ernst het rechtvaardigt.

Vervangt dit unittests en evaluaties?

Nee. Toeschrijving vult tests en evaluaties aan door faaloorzaak uit te leggen. Het koppelt ‘wat faalde’ aan ‘waarom het faalde’, wat gerichte fixes en betere regressietests mogelijk maakt.

Waar kan ik praktische grondoorzaaktechnieken voor agents leren?

Een beknopt, toepasbaar startpunt is deze gids over het traceren van fouten: zie de bron over faaloorzaken in taken hier: https://chat-gpt-5.ai/task-failure-root-causes.

-

Ongecategoriseerd4 days ago

Ongecategoriseerd4 days agohoe je afscheid zegt: zachte manieren om om te gaan met vaarwel en eindes

-

Open Ai1 week ago

Open Ai1 week agoDe Kracht van ChatGPT-plugins Ontsluiten: Verbeter je Ervaring in 2025

-

Uncategorized2 weeks ago

Uncategorized2 weeks agoOntdek het oak and ember-menu van 2025: wat te verwachten en topgerechten om te proberen

-

Open Ai6 days ago

Open Ai6 days agoMeesterschap in GPT Fine-Tuning: Een Gids voor het Effectief Aanpassen van Uw Modellen in 2025

-

Open Ai1 week ago

Open Ai1 week agoChatGPT in 2025: De belangrijkste beperkingen en strategieën om deze te overwinnen verkend

-

Tools7 days ago

Tools7 days agoChatGPT Typefouten: Hoe Veelvoorkomende Fouten te Herstellen en te Voorkomen