Uncategorized

Het benutten van toestandsruimte-modellen om het langetermijngeheugen in video-wereldmodellen te verbeteren: inzichten van Adobe Research

State-Space Modellen voor Langetermijngeheugen in Video Wereldmodellen: Waarom Alleen Attention Tekortschiet

Video wereldmodellen streven ernaar toekomstige frames te voorspellen, geconditioneerd op acties, waardoor agenten kunnen plannen en redeneren in dynamische omgevingen. Recente vooruitgang in video diffusiemodellen heeft cinematische realiteit aan voorspelde sequenties toegevoegd, maar langetermijngeheugen blijft een knelpunt. De boosdoener is bekend: de kwadratische complexiteit van attention ten opzichte van de lengte van de sequentie. Naarmate clips zich uitstrekken tot honderden of duizenden frames, krijgen attentielaagjes te maken met geheugenexplosies en vertragingen, waardoor de meeste systemen de contextvensters moeten verkorten en onbedoeld cruciale vroege gebeurtenissen “vergeten”. Dat vergeetachtigheid ondermijnt taken zoals navigatie, voorraadsregistratie of meervoudige stappen scène-manipulatie.

Het nieuwste werk van Stanford, Princeton en Adobe Research—getiteld Long-Context State-Space Video World Models—pakt het probleem aan door monolithische attention te vervangen door State-Space Modellen (SSM’s) als de globale temporele ruggengraat. In tegenstelling tot het achteraf toepassen van SSM’s op niet-causale vision stacks, leunt deze aanpak op de sterke punten van SSM’s: causale sequentieverwerking met lineaire complexiteit en leerbare recursie die gecomprimeerd geheugen kan dragen over zeer lange tijdshorizonnen. Waar attention focus verspreidt over alle tokens, aggregeren en propaganderen SSM’s een toestand, verspreiden geheugen als een zorgvuldig ingepakte reistas in plaats van een uitgestrekte koffer.

Overweeg een setting vergelijkbaar met Minecraft: een agent mijnbouwt ertsen bij t=120, maakt gereedschappen bij t=450 en keert terug naar een herkenningspunt bij t=900. Pure attention verkort de context of verbruikt veel rekenkracht; in beide gevallen vervagen de vroegste frames. Een SSM-ruggengraat behoudt wat belangrijk is—wijzigingen in de inventaris, herkenningspunten, objectposities—en houdt de semantische draad intact met een marginale extra kost. Deze aanpak weerspiegelt de praktische druk die gevoeld wordt in industriële labs bij Google, Microsoft, Meta en DeepMind, waar teams herhaaldelijk hebben vastgesteld dat alleen attention-stacks moeite hebben te schalen voorbij nichetoepassingen of korte clips.

SSM’s zijn op zichzelf geen wondermiddel. Ruimtelijke precisie en fijnmazige coherentie profiteren nog steeds van lokale attention. De sleutel is een hybride aanpak: gebruik SSM’s voor langetermijn temporeel geheugen en dicht-dichte lokale attention voor precisie vlakbij het frame. Het resultaat is een model dat oorzaken ver terug onthoudt terwijl het scherpe texturen en objectovereenkomsten per frame behoudt. Deze taakverdeling weerspiegelt hoe mensen verhalen volgen—het plot behouden terwijl de details van elke scène worden gevolgd.

De rekenkundige muur van attention

De kosten van attention schalen met het kwadraat van de sequentielengte. Dat is deels beheersbaar in tekst, maar video vermenigvuldigt tokens over tijd en ruimte. In 2025-implementaties bereiken zelfs high-end NVIDIA versnellers bandbreedte- en geheugendrempels wanneer clips minutenlang duren. Deze realiteit dwingt ontwikkelaars tot ongemakkelijke compromissen: frames ondersamples, tokens schrappen of geheugen periodiek resetten—elke tactiek introduceert afwijkingen of gaten.

SSM’s keren het schaalverhaal om. Met geleerde toestandspropagatie breiden zij het receptieve veld uit zonder de token-tot-token interactiegrafiek te vergroten. Voor agenten die vroegere doelen, oude obstakels of eerdere camerabewegingen moeten onthouden, is dit een pragmatische weg vooruit.

- 🧠 Langetermijnredenering: intentie en scènes toestanden honderden frames meenemen zonder kwadratische explosies.

- ⚡ Lagere latency: lineaire updates ondersteunen interactief gebruik, van creatieve tools tot simulatie.

- 🧩 Hybride precisie: combineer globaal SSM-geheugen met lokale attention voor detailgetrouwheid.

- 🏗️ Composabel ontwerp: wissel blokken zonder hele pipelines te herstructureren.

| Aanpak 🔍 | Geheugenhorizon ⏳ | Complexiteit 📈 | Lokale getrouwheid 🎯 | Notities 📝 |

|---|---|---|---|---|

| Alleen attention | Medium | Kwadratisch 😵 | Hoog | Moeite met lange clips |

| Alleen SSM | Lang | Lineair 🚀 | Medium | Uitstekend voor causaliteit; heeft hulp nodig bij details |

| Hybride (SSM + lokale attention) | Lang | Bijna-lineair ⚖️ | Hoog | Het beste van beide, praktisch voor productie |

De conclusie is duidelijk: een state-space ruggengraat verandert de economie van geheugen, waardoor video wereldmodellen verder kunnen denken zonder onder hun eigen rekenkracht te bezwijken.

Inside Adobe Research’s Long-Context State-Space Video World Models (LSSVWM)

Het voorgestelde LSSVWM herdenkt de temporele kern met een blokgewijze SSM-scanmethode en hecht precisie daarna weer in met behulp van dichte lokale attention. Het ontwerp erkent een compromis: ruimtelijke consistentie binnen elk blok kan iets losser, maar de beloning is een enorme uitbreiding van het temporele geheugen. Door de video in beheersbare blokken te rollen en een compacte toestand tussen hen door te geven, houdt het model kennis uit het verleden vast zonder elke paren-tot-token interactie te hoeven enumereren.

Waarom blokgewijs? In lange opnamen—denk aan sport, autorijden of creatieve edits—strekken temporele afhankelijkheden zich vaak ver voorbij standaard contextvensters uit. Een enkele monolithische SSM-pass kan nog steeds onhandelbaar zijn voor enorme sequenties. Blokken maken in plaats daarvan gebalanceerde rekenbudgetten mogelijk, benutten parallelisme over GPU’s en behouden een trainbare toestand die van het ene blok naar het andere springt.

Blokgewijze scanning, ontrafeld

Stel je een documentaire voor die in hoofdstukken is verdeeld. Binnen elk hoofdstuk is het verhaal consistent en strak; over hoofdstukken heen moet de plot coherent blijven. Het blokgewijs SSM werkt op dezelfde manier. Elk blok verwerkt frames met een SSM om de verborgen toestand te comprimeren en bij te werken, daarna geeft het die toestand door aan het volgende blok. De toestand werkt als een estafettestok die door een estafette wordt doorgegeven, waarbij scènegeheugen en intenties door de hele sequentie worden gedragen. Dit levert langetermijnherinnering zonder dat het geheugen exploderen.

Dichte lokale attention voor ruimtelijke getrouwheid

Omdat SSM’s samenvatten in plaats van cross-attend op elk pixelniveau token, kunnen fijne details vervagen zonder een begeleider. Dichte lokale attention vervult deze rol en handhaaft korte-afstands consistentie over aangrenzende frames en binnen blokken. Randen, texturen en kleine objectinteracties blijven scherp, wat een videokwaliteit garandeert die niet alleen consistent is over minuten, maar ook aangenaam frame-voor-frame.

Productieteams bij Adobe en collega’s zoals Apple en Amazon geven prioriteit aan betrouwbaarheid over diverse content—handheld footage, animaties, UI-opnames. Hybride modellering geeft ze een enkele ruggengraat die alle drie gracieus afhandelt zonder maatwerk afstemming.

- 🧭 Blokgewijs SSM: schaalbaar geheugen via toestandoverdracht tussen blokken.

- 🔬 Lokale attention: scherpe details en temporele vloeiendheid waar het oog het meest om geeft.

- 🛠️ Modulaire inzet: wissel blokgroottes of attention-vensters per werklast.

- 💽 Hardware-harmonie: geschikt voor tensor-core uitvoering op moderne GPU’s.

| Component 🧩 | Rol in LSSVWM 🎛️ | Voordeel ✅ | Risico ⚠️ | Mitigatie 💡 |

|---|---|---|---|---|

| Blokgewijs SSM | Globaal temporeel geheugen | Verlengde horizon 🕰️ | Intra-blok afwijking | Lokale attention + calibratie |

| Dichte lokale attention | Ruimtelijke en korte-afstands coherentie | Scherpe details 🎨 | Rekenkundige overhead | Vensterinstelling + sparsiteit |

| Hybride scheduler | Balans tussen rekenkracht en kwaliteit | Voorspelbare latency ⏱️ | Configuratie-overdaad | Profielen en presets |

Voor ondernemingen van Microsoft tot IBM biedt het LSSVWM-blauwdruk een duurzame route naar wereldmodellering die groeit met de inhoudslengte in plaats van erdoor te bezwijken. De volgende stap is het trainen om daadwerkelijk herinneringen vast te houden onder rumoerige, realistische omstandigheden.

Training voor lange horizons: Diffusion Forcing en Frame Local Attention

De trainingsregime in Long-Context State-Space Video World Models is net zo belangrijk als de architectuur. Twee technieken springen eruit: Diffusion Forcing en Frame Local Attention. Samen brengen ze het model in lijn met de realiteiten van lang-achtige generatie, waar imperfecte inputs, gedeeltelijke prompts of spars cues eerder de norm zijn dan de uitzondering.

Diffusion Forcing moedigt het netwerk aan om frames te genereren geconditioneerd op een prefix van de input, terwijl het ruis over de resterende tokens toestaat. In het speciale geval waarbij de prefixlengte nul is—dus geen frames zonder ruis—wordt de opzet pure diffusion forcing. Dit leert het systeem coherent te blijven vanuit een koude start, een scenario dat vaak voorkomt in interactieve tools waar gebruikers naar het midden van een clip scrubben en stabiele voortzetting verwachten. Voor wereldmodellen betekent dit dat de agent een consistente scènesstaat kan herleiden wanneer de context dun is.

Frame Local Attention pakt efficiëntie aan. Met behulp van FlexAttention worden frames gegroepeerd in blokken (bijv. blokken van 5 met een framevenster van 10). Binnen een blok is de attention bidirectioneel, wat rijke lokale structuren behoudt; elk frame let ook op het vorige blok, waardoor het effectieve receptieve veld wordt uitgebreid zonder de volle kost van een globale causale maskering te betalen. Het resultaat is snellere training en sampling met hoge perceptuele kwaliteit—cruciaal voor iteratieve workflows en reinforcement learning loops.

- 🧩 Diffusion Forcing: robuustheid tegen beperkte of ruizige prefixes.

- 🔗 Frame Local Attention: geblokkeerde vensters voor snelheid en stabiliteit.

- 🏎️ FlexAttention: hardware-vriendelijke attentiepatronen op NVIDIA GPU’s.

- 🧪 Curriculum-schema’s: lengen de contexten geleidelijk om vroege training te stabiliseren.

| Techniek 🧪 | Wat het doet ⚙️ | Waarom het belangrijk is 🌟 | Voorbeeldresultaat 📽️ | Industrie Relevantie 🏢 |

|---|---|---|---|---|

| Diffusion Forcing | Conditioneert op gedeeltelijke prefixes; traint voor nullengte prefixes | Stabiliteit vanuit minimale context 💪 | Consistente voortzetting midden in clip | Adobe bewerkingstools, Apple apparaten 🧯 |

| Frame Local Attention | Geblokkeerde bidirectionele vensters via FlexAttention | Doorvoersnelheidswinst ⚡ | Snellere reinforcement learning roll-outs en sampling | Amazon robotica, OpenAI agenten 🤖 |

Deze trainingstoolkit ondersteunt een spectrum aan contexten—van koude starts zonder prefix tot lange, ruizige sequenties. Het past natuurlijk bij de hybride SSM-attention stack, waardoor langetermijngeheugencapaciteit niet alleen theoretisch is maar ook veerkrachtig in realistische toepassingen.

Voor teams die alternatieven als op Mamba-gebaseerde vision stacks evalueren, zijn deze methoden complementair, niet tegenstrijdig, en kunnen ze met minimale wrijving in bredere architecturen worden geïntegreerd.

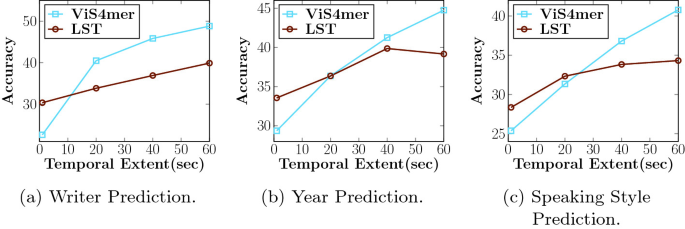

Benchmarks die geheugen testen: Memory Maze, Minecraft en verder

LSSVWM is geëvalueerd op Memory Maze en Minecraft, benchmarks die specifiek zijn ontworpen om ruimtelijke terugvindbaarheid en langetermijnredenering te testen. Memory Maze meet of een agent eerder geziene herkenningspunten, deuren en sleutels kan herinneren na lange omwegen. Minecraft vereist persistent bewustzijn van inventaris, maakstappen en coördinaten, waarbij laag-niveau controle wordt gemengd met hoog-niveau plannen. Beiden onthullen de achilleshiel van kort-contextmodellen: fragmentatie van toestanden.

Op Memory Maze illustreren kwalitatieve resultaten dat LSSVWM consistente weergaves van eerder bezochte kamers behoudt, objectidentiteit over lange onderbrekingen bewaart en correct heroriënteert bij terugkeer naar eerdere gezichtspunten. Concurrerende attention-zware baselines vertonen “identiteits-afwijking”—vloerpatronen vervormen, objecten springen of muren veranderen subtiel. In Minecraft-stijl evaluaties bewaart het model het geheugen van gedolven grondstoffen en recepten over honderden frames en genereert toekomstscenario’s die actieconsistent zijn, waarbij gereedschappen in de juiste volgorde worden gebruikt en herkenningspunten blijven staan.

Vergelijkingen gaan ook naar sterke baselines, waaronder causale-attentie modellen en SSM-varianten zoals Mamba2 zonder frame-lokale vensters. De hybride met Frame Local Attention levert consistent hogere langetermijnconsistentie en betere samplekwaliteit bij vergelijkbare of lagere latency. Voor interactieve toepassingen—creatieve previews, robotica planning of gameagenten—is de balans tussen snelheid en herinnering doorslaggevend.

- 🗺️ Ruimtelijke terugvindbaarheid: herken verre herkenningspunten om efficiënt te navigeren.

- 🧰 Procedureel geheugen: onthoud meervoudige maak- of gereedschapssequenties.

- 🎯 Consistentie onder ruis: ga goed om met camerabewegingen en occlusies.

- ⏱️ Praktische latency: ondersteunt realtime of bijna realtime beslissingslussen.

| Benchmark 🧭 | Geteste vaardigheid 🧠 | Baseline gedrag 🐢 | LSSVWM gedrag 🚀 | Impact 📊 |

|---|---|---|---|---|

| Memory Maze | Langetermijn ruimtelijke terugvindbaarheid | Identiteits-afwijking 😕 | Stabiele herkenningspunten 😊 | Minder verkeerde bochten, snellere voltooiing |

| Minecraft | Procedureel en inventarisgeheugen | Vergeten stappen 🔁 | Correcte actiereeks 🧩 | Betere coherente toekomstige uitkomsten |

| Vrije video | Globale coherentie + lokale details | Contextverkorting ✂️ | Verlengde horizons 🕰️ | Betere planningspreviews |

Voor onderzoekers bij DeepMind, Meta en Google weerspiegelen deze resultaten interne bevindingen: langetermijngeheugen is niet alleen belangrijk voor nauwkeurigheid, maar ook voor gebruikersvertrouwen. Wanneer een model het verhaal tot nu toe onthoudt, voelt alles geloofwaardiger en bruikbaarder aan.

Het bewijs wijst op een eenvoudige conclusie: praktische wereldmodellen moeten efficiënt langetermijngeheugen combineren met mechanismes die lokale getrouwheid bewaken. LSSVWM zet dat sjabloon neer.

Implicaties voor de industrie: van creatieve tools tot robotica

De architectuur en trainingskeuzes in LSSVWM hebben verregaande effecten buiten academische benchmarks. In creatieve software verwachten editors onmiddellijke, contextbewuste voorspellingen: waar zal de camera naartoe pannen, hoe zal de belichting evolueren, wat blijft consistent tussen cuts? Systemen gebouwd rond SSM’s + lokale attention kunnen intelligente previews en context-stabiele generatieve toevoegingen bieden, nuttig voor storyboarding, motion design en post-productie. Voor een hypothetische streamingstudio betekent dat snellere iteratiecycli en minder correctierondes per frame.

In robotica en autonome systemen is langetermijngeheugen nog belangrijker. Een magazijnrobot die wordt aangestuurd door een video wereldmodel moet obstakels onthouden die minuten eerder gezien zijn, niet alleen seconden. Met ontwerpen als LSSVWM kunnen plannings-stacks vertrouwenwekkend vooruit simuleren, gebruikmakend van NVIDIA hardwareversnelling om latency veilig te houden. Teams bij Amazon zouden zulke modellen in logistieke simulatoren kunnen integreren, terwijl ondernemingen met IBM en Microsoft cloudstacks ze kunnen inbedden in inspectiepijplijnen of slimme stadsmonitoring.

Voor consumentenvoorkant kunnen mobiele en headsetapparaten van Apple profiteren van compacte SSM-ruggengraten die geheugen uitbreiden zonder het stroomverbruik te overschrijden. Combineer dit met efficiënte aandachtkernels en het resultaat is overtuigend: lang-context AR-scènebegrip dat responsief blijft. Ondertussen kunnen onderzoeksorganisaties als OpenAI en DeepMind hybride geheugen in multimodale agenten steken, waardoor videovoorspelling overeenkomt met tekstplanning en actiebeleid.

- 🎬 Creatieve suites: stabiele inpainting, langere previews, consistente effecten.

- 🤖 Robotica: persistent scènesgeheugen voor veilige navigatie en manipulatie.

- 📱 Edge-apparaten: energie-efficiënte lang-context modellering voor AR/VR.

- 🧭 Simulatie + planning: betrouwbare vooruitziende blik in complexe omgevingen.

| Sector 🏭 | Gebruikssituatie 🎯 | Kernbehoefte 🧰 | LSSVWM Voordeel 🌟 | Stakeholders 👥 |

|---|---|---|---|---|

| Media creatie | Context-stabiele video-generatie | Lang geheugen + getrouwheid | Hybride SSM/attention 🎞️ | Adobe, Apple 🍏 |

| Logistiek/robotica | Planning uit video wereldmodellen | Latency + herinnering | Lineair geheugen ⚙️ | Amazon, Microsoft 🪟 |

| AI-agenten | Multimodale redenering | Cross-modale coherentie | Lang-context ruggengraten 🧠 | OpenAI, DeepMind 🧪 |

| Onderzoek/infrastructuur | Efficiënte training & inferentie | Doorvoer + schaal | Geblokkeerde vensters, FlexAttention 💡 | Google, Meta, IBM 🏛️ |

Over sectoren heen geldt één patroon: wanneer modellen langer de juiste dingen onthouden, voelen producten slimmer, veiliger en creatiever aan. Het LSSVWM-blauwdruk laat zien hoe je dat resultaat kunt bouwen zonder de rekenbank te breken.

{“@context”:”https://schema.org”,”@type”:”FAQPage”,”mainEntity”:[{“@type”:”Question”,”name”:”What makes State-Space Models better for long-term memory than attention alone?”,”acceptedAnswer”:{“@type”:”Answer”,”text”:”SSMs propagate a compact hidden state through time with linear complexity, enabling far longer horizons without quadratic cost. In hybrid stacks, dense local attention maintains fine details while SSMs carry the long-range story.”}},{“@type”:”Question”,”name”:”How does block-wise SSM scanning extend memory?”,”acceptedAnswer”:{“@type”:”Answer”,”text”:”By processing frames in blocks and passing a learned state across blocks, the model preserves past information over long sequences while keeping compute bounded. It trades a bit of intra-block rigidity for dramatically longer recall.”}},{“@type”:”Question”,”name”:”Why use Diffusion Forcing in training?”,”acceptedAnswer”:{“@type”:”Answer”,”text”:”Diffusion Forcing conditions generation on partial or even zero-length prefixes, teaching the model to stay coherent from minimal context. This is useful for mid-clip edits, interactive previews, and agent resets.”}},{“@type”:”Question”,”name”:”What is Frame Local Attention and why is FlexAttention important?”,”acceptedAnswer”:{“@type”:”Answer”,”text”:”Frame Local Attention groups frames into chunks with bidirectionality inside each chunk and lookback to the previous chunk. FlexAttention implements these patterns efficiently, yielding speedups over fully causal masks.”}},{“@type”:”Question”,”name”:”Where could industry adopt LSSVWM first?”,”acceptedAnswer”:{“@type”:”Answer”,”text”:”Creative tools (Adobe), robotics and logistics (Amazon, Microsoft), edge AR/VR (Apple), and multimodal agent research (OpenAI, DeepMind) are immediate candidates due to their need for long-horizon consistency and low latency.”}}]}What makes State-Space Models better for long-term memory than attention alone?

SSMs propagate a compact hidden state through time with linear complexity, enabling far longer horizons without quadratic cost. In hybrid stacks, dense local attention maintains fine details while SSMs carry the long-range story.

How does block-wise SSM scanning extend memory?

By processing frames in blocks and passing a learned state across blocks, the model preserves past information over long sequences while keeping compute bounded. It trades a bit of intra-block rigidity for dramatically longer recall.

Why use Diffusion Forcing in training?

Diffusion Forcing conditions generation on partial or even zero-length prefixes, teaching the model to stay coherent from minimal context. This is useful for mid-clip edits, interactive previews, and agent resets.

What is Frame Local Attention and why is FlexAttention important?

Frame Local Attention groups frames into chunks with bidirectionality inside each chunk and lookback to the previous chunk. FlexAttention implements these patterns efficiently, yielding speedups over fully causal masks.

Where could industry adopt LSSVWM first?

Creative tools (Adobe), robotics and logistics (Amazon, Microsoft), edge AR/VR (Apple), and multimodal agent research (OpenAI, DeepMind) are immediate candidates due to their need for long-horizon consistency and low latency.

-

Ongecategoriseerd5 days ago

Ongecategoriseerd5 days agohoe je afscheid zegt: zachte manieren om om te gaan met vaarwel en eindes

-

Open Ai1 week ago

Open Ai1 week agoDe Kracht van ChatGPT-plugins Ontsluiten: Verbeter je Ervaring in 2025

-

Uncategorized2 weeks ago

Uncategorized2 weeks agoOntdek het oak and ember-menu van 2025: wat te verwachten en topgerechten om te proberen

-

Open Ai7 days ago

Open Ai7 days agoMeesterschap in GPT Fine-Tuning: Een Gids voor het Effectief Aanpassen van Uw Modellen in 2025

-

Open Ai1 week ago

Open Ai1 week agoChatGPT in 2025: De belangrijkste beperkingen en strategieën om deze te overwinnen verkend

-

Tools7 days ago

Tools7 days agoChatGPT Typefouten: Hoe Veelvoorkomende Fouten te Herstellen en te Voorkomen