Actualités

Exploiter les modèles d’espace d’états pour améliorer la mémoire à long terme dans les modèles vidéo du monde : Perspectives de la recherche Adobe

Modèles d’État-Espace pour la Mémoire à Long Terme dans les Modèles Vidéo du Monde : Pourquoi l’Attention Seule Ne Suffit Pas

Les modèles vidéo du monde visent à prédire les images futures conditionnées par les actions, permettant aux agents de planifier et de raisonner dans des environnements dynamiques. Les progrès récents dans les modèles de diffusion vidéo ont apporté un réalisme cinématographique aux séquences prédites, mais la mémoire à long terme reste un point bloquant. Le coupable est bien connu : la complexité quadratique de l’attention par rapport à la longueur de la séquence. Lorsque les clips s’étendent sur des centaines ou milliers d’images, les couches d’attention rencontrent des pics de mémoire et de latence, forçant la plupart des systèmes à raccourcir les fenêtres de contexte et, par inadvertance, à « oublier » des événements cruciaux au début. Cet oubli compromet des tâches comme la navigation, le suivi d’inventaire ou la manipulation de scènes en plusieurs étapes.

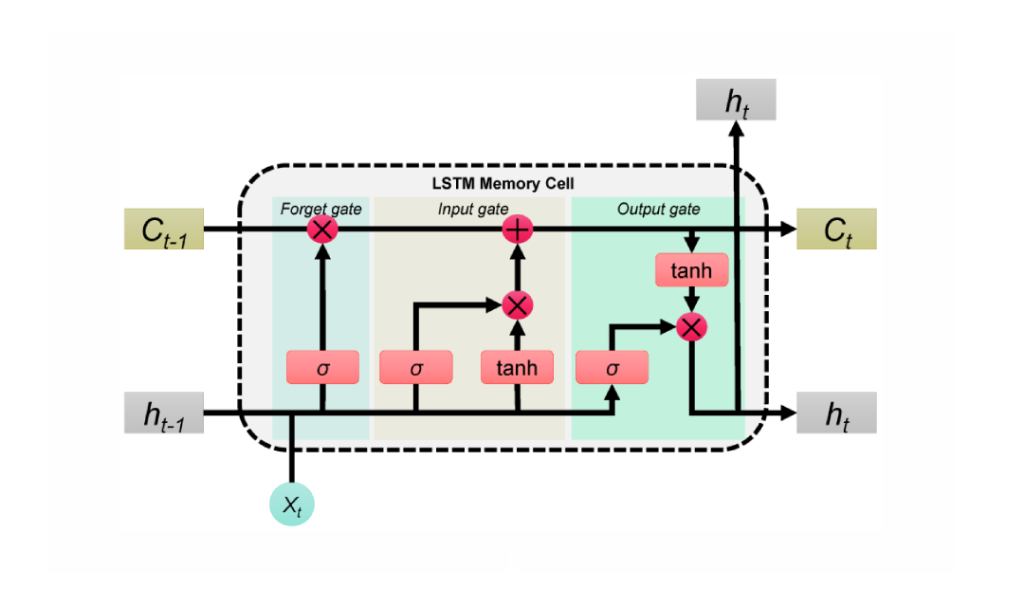

Les travaux récents de Stanford, Princeton, et Adobe Research — intitulés Long-Context State-Space Video World Models — attaquent ce problème en remplaçant l’attention monolithique par des modèles d’État-Espace (SSMs) comme colonne vertébrale temporelle globale. Contrairement à l’adaptation des SSMs aux piles de vision non causales, cette approche mise sur les forces des SSMs : un traitement causal des séquences avec une complexité linéaire et une récurrence apprenable qui peut transporter une mémoire compressée sur des horizons très longs. Là où l’attention disperse la focalisation sur tous les tokens, les SSMs agrègent et propagent un état, diffusant la mémoire comme une valise bien organisée plutôt qu’une valise volumineuse.

Considérons un cadre semblable à Minecraft : un agent mine du minerai à t=120, fabrique des outils à t=450, et revient à un point de repère à t=900. L’attention pure tronque soit le contexte soit brûle du calcul ; dans les deux cas, les images les plus anciennes s’effacent. Une colonne vertébrale SSM conserve ce qui importe — changements d’inventaire, repères, positions d’objets — maintenant le fil sémantique intact à un coût marginal supplémentaire. Cette approche correspond à la pression pratique ressentie dans les laboratoires industriels de Google, Microsoft, Meta et DeepMind, où les équipes ont à maintes reprises constaté que les piles uniquement basées sur l’attention peinent à se déployer au-delà d’applications de niche ou de clips courts.

Les SSMs ne sont pas une solution miracle en soi. La fidélité spatiale et la cohérence fine bénéficient toujours d’une attention locale. La clé est un hybride : utiliser les SSMs pour la mémoire temporelle à longue portée et l’attention locale dense pour la précision proche des images. Le résultat est un modèle qui se souvient des causes lointaines tout en préservant textures nettes et correspondances d’objets d’image à image. Cette division du travail reflète la manière dont les humains naviguent dans les histoires — en gardant l’intrigue tout en suivant les détails de chaque scène.

Le mur computationnel de l’attention

Le coût de l’attention croît avec le carré de la longueur de la séquence. Cela reste partiellement gérable dans le texte, mais la vidéo multiplie les tokens dans le temps et l’espace. En 2025, même les accélérateurs NVIDIA haut de gamme atteignent leurs limites de bande passante et de mémoire lorsque les clips durent plusieurs minutes. Cette réalité a poussé les développeurs à adopter des compromis gênants : sous-échantillonnage des images, élagage des tokens ou réinitialisation périodique de la mémoire — chaque tactique introduisant dérive ou lacunes.

Les SSMs inversent cette histoire d’échelle. Avec la propagation d’un état appris, ils étendent le champ réceptif sans agrandir le graphe d’interactions token-à-token. Pour les agents qui doivent se souvenir d’objectifs précédents, d’obstacles obsolètes ou de mouvements de caméra antérieurs, c’est une voie pragmatique.

- 🧠 Raisonnement à long horizon : porter l’intention et l’état de la scène sur des centaines d’images sans explosion quadratique.

- ⚡ Latence réduite : des mises à jour en temps linéaire supportent un usage interactif, des outils créatifs à la simulation.

- 🧩 Précision hybride : combiner la mémoire SSM globale avec l’attention locale pour la fidélité des détails.

- 🏗️ Conception modulaire : remplacer des blocs sans ré-architecturer les pipelines entiers.

| Approche 🔍 | Horizon Mémoire ⏳ | Complexité 📈 | Fidélité Locale 🎯 | Notes 📝 |

|---|---|---|---|---|

| Attention uniquement | Moyen | Quadratique 😵 | Élevée | Peine avec les longs clips |

| SSM uniquement | Long | Linéaire 🚀 | Moyenne | Excellent pour causalité ; besoin d’aide sur les détails |

| Hybride (SSM + attention locale) | Long | Quasi-linéaire ⚖️ | Élevée | Le meilleur des deux, pratique pour la production |

La conclusion est claire : une colonne vertébrale d’état-espace change l’économie de la mémoire, permettant aux modèles vidéo du monde de penser plus loin sans s’effondrer sous leur propre calcul.

À l’intérieur des Long-Context State-Space Video World Models (LSSVWM) d’Adobe Research

Le LSSVWM proposé réinvente le noyau temporel avec un schéma de balayage SSM par blocs, puis réinjecte la précision via une attention locale dense. Le design reconnaît un compromis : la cohérence spatiale à l’intérieur de chaque bloc peut se relâcher légèrement, mais la récompense est une extension immense de la mémoire temporelle. En découpant la vidéo en blocs gérables et en passant un état compact entre eux, le modèle conserve la connaissance du passé sans énumérer toutes les interactions token-à-token.

Pourquoi par blocs ? Dans les longues séquences — pensez sports, conduite ou montages créatifs — les dépendances temporelles s’étendent souvent bien au-delà des fenêtres de contexte standard. Un passage monolithique unique de SSM serait encore ingérable pour des séquences massives. Au lieu de cela, les blocs permettent des budgets de calcul équilibrés, exploitant le parallélisme sur GPU et préservant un état entraînable qui passe d’un bloc à l’autre.

Balayage par blocs, démystifié

Imaginez un documentaire découpé en chapitres. Dans chaque chapitre, le récit est cohérent et serré ; entre les chapitres, l’intrigue doit rester cohérente. Le SSM par blocs fonctionne de la même façon. Chaque bloc traite les images avec un SSM pour compresser et mettre à jour l’état caché, puis transmet cet état au bloc suivant. L’état agit comme un témoin passé dans un relais, transportant la mémoire de la scène et l’intention d’action à travers la séquence. Cela permet un rappel à long terme sans explosion de l’empreinte mémoire.

Attention locale dense pour la fidélité spatiale

Parce que les SSMs résument plutôt que de croiser l’attention sur chaque token pixel, les détails fins pourraient devenir flous sans accompagnement. L’attention locale dense joue ce rôle, assurant la cohérence à court terme entre images adjacentes et au sein des blocs. Les contours, textures et interactions d’objets restent nets, garantissant une qualité vidéo non seulement cohérente sur plusieurs minutes mais aussi plaisante image par image.

Les équipes de production chez Adobe et des pairs comme Apple et Amazon privilégient la fiabilité sur des contenus variés — séquences à main levée, animation, captures UI. La modélisation hybride leur offre une colonne vertébrale unique qui gère avec élégance tous les trois sans réglages spécifiques.

- 🧭 SSM par blocs : mémoire évolutive via transmission d’état entre blocs.

- 🔬 Attention locale : détails nets et fluidité temporelle là où l’œil est exigeant.

- 🛠️ Déploiement modulaire : adapter la taille des blocs ou la portée de l’attention selon la charge de travail.

- 💽 Harmonie matérielle : adapté à l’exécution sur tensor-cores des GPU modernes.

| Composant 🧩 | Rôle dans LSSVWM 🎛️ | Avantage ✅ | Risque ⚠️ | Atténuation 💡 |

|---|---|---|---|---|

| SSM par blocs | Mémoire temporelle globale | Horizons étendus 🕰️ | Dérive intra-bloc | Attention locale + calibration |

| Attention locale dense | Cohérence spatiale et à court terme | Détails nets 🎨 | Surcharge de calcul | Réglage des fenêtres + sparsité |

| Ordonnanceur hybride | Équilibre entre calcul et qualité | Latence prévisible ⏱️ | Prolifération de configurations | Profils et préréglages |

Pour des entreprises de Microsoft à IBM, la feuille de route LSSVWM offre une voie durable vers la modélisation du monde qui grandit avec la longueur du contenu plutôt que de céder sous sa charge. L’étape suivante est de l’entraîner à vraiment conserver les souvenirs dans des conditions bruitées du monde réel.

Entraînement pour Longs Horizons : Diffusion Forcing et Attention Locale sur Images

Le régime d’entraînement dans Long-Context State-Space Video World Models est aussi important que l’architecture. Deux techniques se distinguent : le Diffusion Forcing et l’Attention Locale sur Images. Ensemble, elles alignent le modèle avec les réalités de la génération en contexte long, où les entrées imparfaites, les prompts partiels ou les indices dispersés sont la norme plutôt que l’exception.

Diffusion Forcing encourage le réseau à générer des images conditionnées sur un préfixe de l’entrée tout en acceptant du bruit sur les autres tokens. Dans le cas spécial où la longueur du préfixe est zéro — c’est-à-dire aucune image non bruitée — la configuration devient un véritable diffusion forcing. Cela apprend au système à maintenir la cohérence depuis un démarrage à froid, un scénario courant dans les outils interactifs où les utilisateurs naviguent au milieu d’un clip et attendent une continuation stable. Pour les modèles du monde, cela signifie que l’agent peut redéduire un état de scène cohérent même quand le contexte est mince.

Attention Locale sur Images traite de l’efficacité. En utilisant FlexAttention, les images sont groupées en fragments (par exemple, fragments de 5 avec une fenêtre d’images de 10). Dans un fragment, l’attention est bidirectionnelle, préservant une structure locale riche ; chaque image est aussi attentive au fragment précédent, étendant le champ réceptif effectif sans payer le coût total d’un masque causal global. Le résultat est un entraînement et un échantillonnage plus rapides avec une haute qualité perceptuelle — crucial pour les flux de travail itératifs et les boucles d’apprentissage par renforcement.

- 🧩 Diffusion Forcing : robustesse aux préfixes limités ou bruités.

- 🔗 Attention Locale sur Images : fenêtres fragmentées pour vitesse et stabilité.

- 🏎️ FlexAttention : schémas d’attention optimisés pour matériel sur GPU NVIDIA.

- 🧪 Programmes d’apprentissage progressifs : allongement progressif des contextes pour stabiliser les débuts d’entraînement.

| Technique 🧪 | Ce qu’elle fait ⚙️ | Pourquoi c’est important 🌟 | Exemple de résultat 📽️ | Pertinence industrielle 🏢 |

|---|---|---|---|---|

| Diffusion Forcing | Conditionne sur des préfixes partiels ; entraîne pour cas sans préfixe | Stabilité avec un contexte minimal 💪 | Continuation cohérente au milieu d’un clip | Outils Adobe, appareils Apple 🧯 |

| Attention Locale sur Images | Fenêtres bidirectionnelles fragmentées via FlexAttention | Gain de débit ⚡ | Déploiements RL plus rapides et échantillonnage | Amazon robotique, agents OpenAI 🤖 |

Cette boîte à outils d’entraînement supporte un spectre de contextes — du démarrage à froid sans préfixe à de longues séquences bruitées. Elle s’associe naturellement à la pile hybride SSM-attention, garantissant que la capacité mémoire longue durée n’est pas seulement théorique mais résiliente en conditions réelles.

Pour les équipes évaluant des alternatives comme les piles vision basées sur Mamba, ces méthodes sont complémentaires, non contradictoires, et peuvent être intégrées dans des architectures plus larges avec un minimum de friction.

Benchmarks mettant la Mémoire à l’Épreuve : Memory Maze, Minecraft et Au-delà

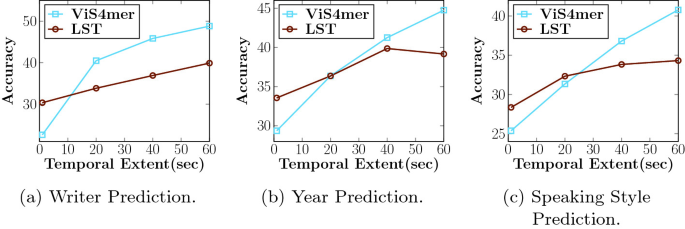

LSSVWM a été évalué sur Memory Maze et Minecraft, des benchmarks spécifiquement conçus pour tester la récupération spatiale et le raisonnement à long horizon. Memory Maze mesure si un agent peut se souvenir des repères, portes et clés vus précédemment après de longs détours. Minecraft exige une conscience persistante de l’inventaire, des étapes de fabrication et des coordonnées, combinant contrôle bas niveau et plans de haut niveau. Les deux exposent le talon d’Achille des modèles à court contexte : la fragmentation de l’état.

Sur Memory Maze, les résultats qualitatifs montrent que LSSVWM maintient des rendus cohérents des pièces visitées, préserve l’identité des objets malgré de longues interruptions, et se réoriente correctement en revenant à des points de vue antérieurs. Les baselines lourds en attention montrent une « dérive d’identité » — les motifs de sol changent, les objets sautent ou les murs changent subtilement. Dans les évaluations de type Minecraft, le modèle conserve la mémoire des ressources minières et des recettes sur des centaines d’images, générant des futurs cohérents d’actions où les outils sont utilisés dans le bon ordre et les repères restent en place.

Les comparaisons incluent des baselines solides, notamment des modèles à attention causale et des variantes SSM comme Mamba2 sans fenêtres locales sur images. L’hybride avec Frame Local Attention délivre systématiquement une cohérence long-terme supérieure et une meilleure qualité d’échantillons à latence comparable ou moindre. Pour les applications interactives — prévisualisations créatives, planification robotique ou agents de jeu — l’équilibre entre vitesse et rappel est décisif.

- 🗺️ Récupération spatiale : ré-identifier des repères anciens pour naviguer efficacement.

- 🧰 Rappel procédural : se souvenir de séquences de fabrication ou d’outils en plusieurs étapes.

- 🎯 Consistance sous bruit : gérer avec grâce les sauts de caméra et les occultations.

- ⏱️ Latence pratique : supporter des boucles décisionnelles en temps réel ou quasi.

| Benchmark 🧭 | Compétence Testée 🧠 | Comportement Baseline 🐢 | Comportement LSSVWM 🚀 | Impact 📊 |

|---|---|---|---|---|

| Memory Maze | Récupération spatiale à long terme | Dérive d’identité 😕 | Repères stables 😊 | Moins d’erreurs, exécution plus rapide |

| Minecraft | Mémoire procédurale et inventaire | Étapes oubliées 🔁 | Ordre d’actions correct 🧩 | Déroulements futurs plus cohérents |

| Vidéo libre | Cohérence globale + détails locaux | Troncature du contexte ✂️ | Horizons étendus 🕰️ | Meilleures prévisualisations de planification |

Pour les chercheurs de DeepMind, Meta et Google, ces résultats font écho à leurs découvertes internes : la mémoire longue durée importe non seulement pour la précision mais pour la confiance des utilisateurs. Quand un modèle se souvient de l’histoire jusqu’ici, tout paraît plus crédible et exploitable.

Les preuves mènent à une conclusion simple : les modèles du monde pratiques doivent associer une mémoire longue durée efficace à des mécanismes qui garantissent la fidélité locale. LSSVWM établit ce modèle.

Implications pour l’Industrie : Des Outils Créatifs à la Robotique

L’architecture et les choix d’entraînement dans LSSVWM ont un impact bien au-delà des benchmarks académiques. Dans les logiciels créatifs, les éditeurs attendent des prédictions instantanées et sensibles au contexte : où la caméra va-t-elle se déplacer ensuite, comment l’éclairage va-t-il évoluer, que reste-t-il cohérent entre les coupes ? Les systèmes basés sur SSMs + attention locale peuvent offrir des prévisualisations intelligentes et des remplissages génératifs stables dans le contexte, utiles pour le storyboard, le design de mouvement et la post-production. Pour un studio de streaming hypothétique, cela signifie des cycles d’itération plus rapides et moins de retouches d’images.

En robotique et systèmes autonomes, la mémoire à long terme est encore plus vitale. Un robot d’entrepôt guidé par un modèle vidéo du monde doit se souvenir des obstacles vus plusieurs minutes auparavant, pas juste des secondes. Avec des conceptions comme LSSVWM, les piles de planification peuvent simuler en toute confiance, tirant parti de l’accélération matérielle NVIDIA pour maintenir la latence dans une plage sécurisée. Les équipes d’Amazon pourraient intégrer ces modèles dans des simulateurs logistiques, tandis que les entreprises utilisant les infrastructures cloud de IBM et Microsoft pourraient les embarquer dans des pipelines d’inspection ou de surveillance de villes intelligentes.

Sur le front consumer, les appareils mobiles et casques de Apple peuvent bénéficier de colonnes vertébrales SSM compactes qui étendent la mémoire sans dépasser les budgets énergétiques. Associez cela avec des noyaux d’attention efficaces et le résultat est convaincant : une compréhension de scène AR à long contexte qui reste réactive. Pendant ce temps, des organisations de recherche comme OpenAI et DeepMind peuvent intégrer la mémoire hybride dans des agents multimodaux, alignant la prédiction vidéo avec la planification textuelle et les politiques d’action.

- 🎬 Suites créatives : retouche stable, prévisualisations plus longues, effets cohérents.

- 🤖 Robotique : mémoire de scène persistante pour navigation et manipulation sécurisées.

- 📱 Appareils de périphérie : modélisation longue durée économe en énergie pour AR/VR.

- 🧭 Simulation + planification : prévoyance fiable dans des environnements complexes.

| Secteur 🏭 | Cas d’usage 🎯 | Besoins principaux 🧰 | Avantage LSSVWM 🌟 | Parties prenantes 👥 |

|---|---|---|---|---|

| Création média | Génération vidéo stable dans le contexte | Mémoire longue + fidélité | Hybride SSM/attention 🎞️ | Adobe, Apple 🍏 |

| Logistique/robotique | Planification via modèles vidéo du monde | Latence + rappel | Mémoire en temps linéaire ⚙️ | Amazon, Microsoft 🪟 |

| Agents IA | Raisonnement multimodal | Cohérence inter-modale | Colonnes vertébrales long contexte 🧠 | OpenAI, DeepMind 🧪 |

| Recherche/infrastructure | Entraînement & inférence efficaces | Débit + échelle | Fenêtres fragmentées, FlexAttention 💡 | Google, Meta, IBM 🏛️ |

Dans tous les secteurs, un motif se vérifie : quand les modèles se souviennent plus longtemps des bonnes choses, les produits paraissent plus intelligents, sûrs et créatifs. La feuille de route LSSVWM montre comment construire pour ce résultat sans exploser la facture calculatoire.

{« @context »: »https://schema.org », »@type »: »FAQPage », »mainEntity »:[{« @type »: »Question », »name »: »Qu’est-ce qui rend les Modèles d’État-Espace meilleurs pour la mémoire à long terme que l’attention seule ? », »acceptedAnswer »:{« @type »: »Answer », »text »: »Les SSM propagent un état caché compact dans le temps avec une complexité linéaire, permettant des horizons bien plus longs sans coût quadratique. Dans les piles hybrides, l’attention locale dense maintient les détails fins tandis que les SSM portent l’histoire à longue portée. »}},{« @type »: »Question », »name »: »Comment le balayage SSM par blocs étend-il la mémoire ? », »acceptedAnswer »:{« @type »: »Answer », »text »: »En traitant les images par blocs et en transmettant un état appris entre blocs, le modèle conserve les informations passées sur de longues séquences tout en limitant le calcul. Il échange un peu de rigidité intra-bloc contre un rappel beaucoup plus long. »}},{« @type »: »Question », »name »: »Pourquoi utiliser le Diffusion Forcing à l’entraînement ? », »acceptedAnswer »:{« @type »: »Answer », »text »: »Le Diffusion Forcing conditionne la génération sur des préfixes partiels voire de longueur nulle, apprenant au modèle à rester cohérent avec un contexte minimal. Ceci est utile pour les éditions en milieu de clip, les prévisualisations interactives et les réinitialisations d’agent. »}},{« @type »: »Question », »name »: »Qu’est-ce que l’Attention Locale sur Images et pourquoi FlexAttention est-elle importante ? », »acceptedAnswer »:{« @type »: »Answer », »text »: »L’Attention Locale sur Images regroupe les images en fragments avec bidirectionnalité à l’intérieur de chaque fragment et un regard vers le fragment précédent. FlexAttention implémente ces schémas efficacement, offrant des accélérations par rapport aux masques causals complets. »}},{« @type »: »Question », »name »: »Où l’industrie pourrait-elle adopter LSSVWM en premier ? », »acceptedAnswer »:{« @type »: »Answer », »text »: »Les outils créatifs (Adobe), la robotique et la logistique (Amazon, Microsoft), l’AR/VR en périphérie (Apple) et la recherche sur agents multimodaux (OpenAI, DeepMind) sont des candidats immédiats en raison de leur besoin de cohérence à long horizon et faible latence. »}}]}Qu’est-ce qui rend les Modèles d’État-Espace meilleurs pour la mémoire à long terme que l’attention seule ?

Les SSM propagent un état caché compact dans le temps avec une complexité linéaire, permettant des horizons bien plus longs sans coût quadratique. Dans les piles hybrides, l’attention locale dense maintient les détails fins tandis que les SSM portent l’histoire à longue portée.

Comment le balayage SSM par blocs étend-il la mémoire ?

En traitant les images par blocs et en transmettant un état appris entre blocs, le modèle conserve les informations passées sur de longues séquences tout en limitant le calcul. Il échange un peu de rigidité intra-bloc contre un rappel beaucoup plus long.

Pourquoi utiliser le Diffusion Forcing à l’entraînement ?

Le Diffusion Forcing conditionne la génération sur des préfixes partiels voire de longueur nulle, apprenant au modèle à rester cohérent avec un contexte minimal. Ceci est utile pour les éditions en milieu de clip, les prévisualisations interactives et les réinitialisations d’agent.

Qu’est-ce que l’Attention Locale sur Images et pourquoi FlexAttention est-elle importante ?

L’Attention Locale sur Images regroupe les images en fragments avec bidirectionnalité à l’intérieur de chaque fragment et un regard vers le fragment précédent. FlexAttention implémente ces schémas efficacement, offrant des accélérations par rapport aux masques causals complets.

Où l’industrie pourrait-elle adopter LSSVWM en premier ?

Les outils créatifs (Adobe), la robotique et la logistique (Amazon, Microsoft), l’AR/VR en périphérie (Apple) et la recherche sur agents multimodaux (OpenAI, DeepMind) sont des candidats immédiats en raison de leur besoin de cohérence à long horizon et faible latence.

-

Open Ai1 semaine ago

Open Ai1 semaine agoLibérer la puissance des Plugins ChatGPT : améliorez votre expérience en 2025

-

Open Ai6 jours ago

Open Ai6 jours agoMaîtriser l’ajustement fin de GPT : un guide pour personnaliser efficacement vos modèles en 2025

-

Open Ai7 jours ago

Open Ai7 jours agoComparer ChatGPT d’OpenAI, Claude d’Anthropic et Bard de Google : quel outil d’IA générative dominera en 2025 ?

-

Open Ai6 jours ago

Open Ai6 jours agoTarification de ChatGPT en 2025 : Tout ce que vous devez savoir sur les tarifs et abonnements

-

Open Ai7 jours ago

Open Ai7 jours agoLa suppression progressive des modèles GPT : à quoi les utilisateurs peuvent s’attendre en 2025

-

Modèles d’IA7 jours ago

Modèles d’IA7 jours agoModèles GPT-4 : Comment l’intelligence artificielle transforme 2025