Zustandsraummodelle für Langzeitspeicher in Video-Weltmodellen: Warum allein Aufmerksamkeit nicht ausreicht

Video-Weltmodelle zielen darauf ab, zukünftige Frames unter Berücksichtigung von Aktionen vorherzusagen, wodurch Agenten in die Lage versetzt werden, in dynamischen Umgebungen zu planen und zu argumentieren. Jüngste Fortschritte bei Video-Diffusionsmodellen haben filmische Realismus in vorhergesagten Sequenzen gebracht, doch Langzeitspeicher bleibt ein Stolperstein. Der Übeltäter ist wohlbekannt: die quadratische Komplexität der Aufmerksamkeit in Bezug auf die Sequenzlänge. Wenn Clips sich über Hunderte oder Tausende von Frames erstrecken, stoßen Aufmerksamkeitsschichten an Speichergrenzen und Latenzspitzen, was die meisten Systeme dazu zwingt, Kontextfenster zu verkürzen und unbeabsichtigt „wichtige frühe Ereignisse“ zu „vergessen“. Dieses Vergessen untergräbt Aufgaben wie Navigation, Bestandsverfolgung oder mehrstufige Szenenmanipulation.

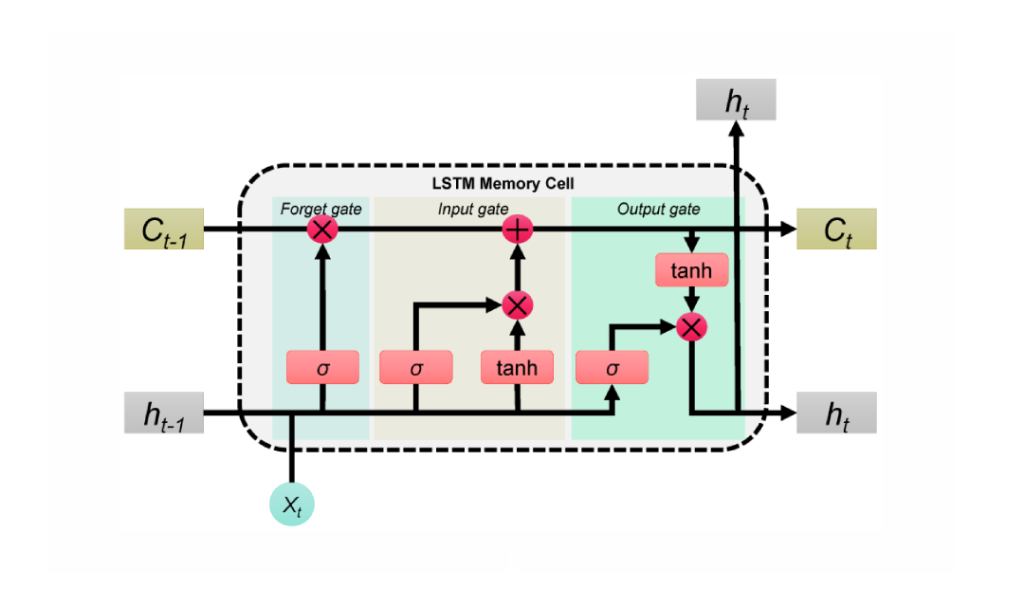

Die neueste Arbeit von Stanford, Princeton und Adobe Research – mit dem Titel Long-Context State-Space Video World Models – geht das Problem an, indem sie monolithische Aufmerksamkeit durch Zustandsraummodelle (SSMs) für das globale zeitliche Rückgrat ersetzt. Anders als das Nachrüsten von SSMs auf nicht-kausale Vision-Stapel setzt dieser Ansatz auf die Stärken von SSMs: kausale Sequenzverarbeitung mit linearer Komplexität und lernbarem Rückgriff, der komprimierten Speicher über sehr lange Horizonte tragen kann. Wo Aufmerksamkeit den Fokus über alle Tokens streut, aggregieren und propagieren SSMs einen Zustand und verteilen Speicher wie eine sorgfältig gepackte Reisetasche statt eines unübersichtlichen Koffers.

Betrachten Sie eine Minecraft-ähnliche Umgebung: Ein Agent baut bei t=120 Erz ab, fertigt Werkzeuge bei t=450 und kehrt bei t=900 zu einer Landmarke zurück. Reine Aufmerksamkeit kürzt entweder den Kontext ab oder verbraucht viel Rechenleistung; in beiden Fällen verblassen die frühesten Frames. Ein SSM-Rückgrat behält Wesentliches – Bestandsänderungen, Landmarken, Objektpositionen – und erhält den semantischen Faden bei marginalen Zusatzkosten intakt. Dieser Ansatz spiegelt die praktische Belastung wider, wie sie in Industrie-Labors bei Google, Microsoft, Meta und DeepMind beobachtet wurde, wo Teams wiederholt feststellen, dass auf Aufmerksamkeit allein basierende Stapel schwer skalieren und nur für Nischenanwendungen oder kurze Clips geeignet sind.

SSMs sind für sich genommen kein Allheilmittel. Räumliche Genauigkeit und feingliedrige Kohärenz profitieren weiterhin von lokaler Aufmerksamkeit. Der Schlüssel liegt in einer Hybridlösung: Verwenden Sie SSMs für Langzeit-zeitliche Speicher und dichte lokale Aufmerksamkeit für präzise Nahbereichsdetails. Das Ergebnis ist ein Modell, das Ursachen aus der Ferne erinnert und gleichzeitig scharfe Texturen und Objektkorrespondenzen Frame-zu-Frame bewahrt. Diese Arbeitsteilung spiegelt wider, wie Menschen Geschichten navigieren – sie behalten die Handlung im Auge und verfolgen gleichzeitig die Details jeder Szene.

Die rechnerische Wand der Aufmerksamkeit

Die Kosten von Aufmerksamkeit skalieren mit dem Quadrat der Sequenzlänge. Das ist in Texten teilweise beherrschbar, aber Video vervielfacht Tokens über Zeit und Raum. In den Einsätzen 2025 stoßen selbst High-End-NVIDIA-Beschleuniger bei Clips von Minutenlänge an Bandbreiten- und Speichergrenzen. Diese Realität hat Entwickler zu unkomfortablen Kompromissen gezwungen: Unterabtastung von Frames, Kürzung von Tokens oder periodisches Zurücksetzen des Speichers – jede Taktik verursacht Drift oder Lücken.

SSMs kehren diese Skalierungsgeschichte um. Mit gelerntem Zustandsübergang erweitern sie das Rezeptivfeld, ohne das Token-zu-Token-Interaktionsdiagramm zu vergrößern. Für Agenten, die sich an frühere Ziele, alte Hindernisse oder vorangegangene Kamerabewegungen erinnern müssen, ist das ein pragmatischer Weg nach vorne.

- 🧠 Langfristiges Schließen von Zusammenhängen: Absichten und Szenenzustände über Hunderte Frames ohne quadratische Explosionen transportieren.

- ⚡ Geringere Latenz: Updates in linearer Zeit ermöglichen interaktive Anwendungen, von Kreativwerkzeugen bis Simulationen.

- 🧩 Hybride Präzision: Kombination aus globalem SSM-Speicher mit lokaler Aufmerksamkeit für Detailtreue.

- 🏗️ Komponierbares Design: Austausch von Blöcken ohne komplette Neuentwicklung von Pipelines.

| Ansatz 🔍 | Speicherhorizont ⏳ | Komplexität 📈 | Lokale Detailtreue 🎯 | Hinweise 📝 |

|---|---|---|---|---|

| Nur Aufmerksamkeit | Mittel | Quadratisch 😵 | Hoch | Schwierig bei langen Clips |

| Nur SSM | Lang | Linear 🚀 | Mittel | Ideal für Kausalität; braucht Hilfe bei Details |

| Hybrid (SSM + lokale Aufmerksamkeit) | Lang | Nahe linear ⚖️ | Hoch | Beste Lösung, praktisch für Produktion |

Das Fazit ist klar: Ein Zustandsraum-Rückgrat verändert die Ökonomie des Speichers und ermöglicht Video-Weltmodellen, weiter zu denken, ohne unter eigenem Rechenaufwand zusammenzubrechen.

Einblick in Adobe Researchs Long-Context State-Space Video World Models (LSSVWM)

Das vorgeschlagene LSSVWM gestaltet den zeitlichen Kern mit einem blockweisen SSM-Scanverfahren neu und führt Präzision mit dichter lokaler Aufmerksamkeit wieder ein. Das Design erkennt einen Kompromiss an: Räumliche Konsistenz innerhalb jedes Blocks kann leicht gelockert werden, aber die Belohnung ist eine enorme Erweiterung des temporalen Speichers. Indem das Video in handhabbare Blöcke zerlegt und ein kompakter Zustand zwischen ihnen weitergereicht wird, behält das Modell vergangenes Wissen, ohne jede paarweise Token-Interaktion aufzulisten.

Warum blockweise? In langen Aufnahmen – denken Sie an Sport, Fahren oder kreative Schnitte – dehnen sich zeitliche Abhängigkeiten oft weit über Standard-Kontextfenster hinaus. Ein einziger monolithischer SSM-Durchgang könnte bei riesigen Sequenzen unpraktisch sein. Stattdessen ermöglichen Blöcke ausgewogene Rechenbudgets, nutzen Parallelismus über GPUs und bewahren einen trainierbaren Zustand, der von einem Block zum nächsten springt.

Blockweises Scannen, erklärt

Stellen Sie sich eine Dokumentation vor, die in Kapitel unterteilt ist. Innerhalb jedes Kapitels ist die Erzählung konsistent und straff; über die Kapitel hinweg muss die Handlung kohärent bleiben. Das blockweise SSM funktioniert ähnlich. Jeder Block verarbeitet Frames mit einem SSM, um den verborgenen Zustand zu komprimieren und zu aktualisieren, und übergibt diesen Zustand dann an den nächsten Block. Der Zustand wirkt wie ein Staffelstab in einem Staffellauf, der Szenenspeicher und Handlungsabsicht durch die Sequenz trägt. Dies ermöglicht eine Langzeitrückerinnerung, ohne die Speicherauslastung explodieren zu lassen.

Dichte lokale Aufmerksamkeit für räumliche Genauigkeit

Da SSMs zusammenfassen, anstatt jeden Pixel-Level-Token zu durchkreuzen, könnten feine Details ohne Begleitung unscharf werden. Dichte lokale Aufmerksamkeit füllt diese Rolle aus und sorgt für konsistente Nahbereichsstruktur über angrenzende Frames und innerhalb von Blöcken. Kanten, Texturen und kleine Objektinteraktionen bleiben scharf und gewährleisten eine Videoqualität, die nicht nur über Minuten konsistent, sondern auch Frame-zu-Frame ansprechend ist.

Produktionsteams bei Adobe und Partnern wie Apple und Amazon legen Wert auf Zuverlässigkeit über vielfältige Inhalte hinweg – Handheld-Aufnahmen, Animation, UI-Captures. Hybrides Modellieren bietet eine einzige Rückgratstruktur, die alle drei elegant ohne maßgeschneiderte Anpassung handhabt.

- 🧭 Blockweises SSM: skalierbarer Speicher durch Zustandsübergabe zwischen Blöcken.

- 🔬 Lokale Aufmerksamkeit: scharfe Details und zeitliche Glätte, wo das Auge es am meisten wahrnimmt.

- 🛠️ Modulare Bereitstellung: Austausch von Blockgrößen oder Aufmerksamkeitsfenstern je nach Arbeitslast.

- 💽 Hardware-Harmonie: geeignet für Tensor-Core-Ausführung auf modernen GPUs.

| Komponente 🧩 | Rolle in LSSVWM 🎛️ | Nutzen ✅ | Risiko ⚠️ | Abmilderung 💡 |

|---|---|---|---|---|

| Blockweises SSM | Globaler zeitlicher Speicher | Erweiterte Horizonte 🕰️ | Drift innerhalb von Blöcken | Lokale Aufmerksamkeit + Kalibrierung |

| Dichte lokale Aufmerksamkeit | Räumliche und kurzfristige Kohärenz | Scharfe Details 🎨 | Rechenaufwand | Fensterabstimmung + Sparsamkeit |

| Hybrider Scheduler | Ausgleich von Rechenaufwand vs. Qualität | Vorhersehbare Latenz ⏱️ | Konfigurationsüberfrachtung | Profile und Voreinstellungen |

Für Unternehmen von Microsoft bis IBM bietet die LSSVWM-Vorlage einen nachhaltigen Weg für Weltmodellierung, der mit der Inhaltslänge wächst, statt unter ihr zusammenzubrechen. Der nächste Schritt besteht darin, es tatsächlich zu trainieren, um Speicher auch unter lauten, realen Bedingungen zu halten.

Training für lange Horizonte: Diffusion Forcing und Frame Local Attention

Das Trainingsregime in Long-Context State-Space Video World Models ist ebenso wichtig wie die Architektur. Zwei Techniken stechen hervor: Diffusion Forcing und Frame Local Attention. Gemeinsam stimmen sie das Modell auf die Realitäten der Langkontext-Erzeugung ab, bei der unvollständige Eingaben, partielle Prompts oder spärliche Hinweise eher die Norm als die Ausnahme sind.

Diffusion Forcing ermutigt das Netzwerk, Frames bedingt auf einem Präfix der Eingabe zu erzeugen, während es Rauschen über die verbleibenden Tokens hinweg berücksichtigt. Im Spezialfall, wenn die Präfixlänge null ist – also keine Frames ungerauscht sind – wird das Setup zu reinem Diffusionsforcing. Dies lehrt das System, Kohärenz von einem Kaltstart aufrechtzuerhalten, ein Szenario, das in interaktiven Tools häufig vorkommt, wenn Nutzer zur Mitte eines Clips vorspulen und stabile Fortsetzung erwarten. Für Weltmodelle bedeutet dies, dass der Agent einen konsistenten Szenenzustand rekonstruieren kann, wenn der Kontext dünn ist.

Frame Local Attention adressiert Effizienz. Mit FlexAttention werden Frames in Abschnitte gruppiert (z.B. Abschnitte von 5 Frames mit einem Fenster von 10 Frames). Innerhalb eines Abschnitts ist die Aufmerksamkeit bidirektional und erhält eine reichhaltige lokale Struktur; jeder Frame attendiert auch auf den vorherigen Abschnitt, wodurch das effektive Rezeptivfeld erweitert wird, ohne die volle Kosten eines globalen kausalen Masks zu zahlen. Das Ergebnis ist schnelleres Training und Sampling mit hoher wahrnehmbarer Qualität – entscheidend für iterative Arbeitsabläufe und Verstärkungs-Lernschleifen.

- 🧩 Diffusion Forcing: Robustheit gegenüber begrenzten oder verrauschten Präfixen.

- 🔗 Frame Local Attention: segmentierte Fenster für Geschwindigkeit und Stabilität.

- 🏎️ FlexAttention: hardwarefreundliche Aufmerksamkeitsmuster auf NVIDIA-GPUs.

- 🧪 Curriculum-Pläne: schrittweise Verlängerung der Kontexte für stabiles Frühtraining.

| Technik 🧪 | Was es tut ⚙️ | Warum es wichtig ist 🌟 | Beispiel-Ergebnis 📽️ | Branchenbezug 🏢 |

|---|---|---|---|---|

| Diffusion Forcing | Bedingt auf partielle Präfixe; trainiert für Fälle mit Null-Präfix | Stabilität auch bei minimalem Kontext 💪 | Konsistente Fortsetzung mitten im Clip | Adobe-Werkzeuge, Apple Geräte 🧯 |

| Frame Local Attention | Segmentierte, bidirektionale Fenster via FlexAttention | Durchsatzsteigerung ⚡ | Schnellere RL-Durchläufe und Samplings | Amazon Robotik, OpenAI Agenten 🤖 |

Dieses Trainingswerkzeug unterstützt ein Spektrum von Kontexten – von Null-Präfix-Kaltstarts bis hin zu langen, verrauschten Sequenzen. Es passt natürlich zum hybriden SSM-Aufmerksamkeits-Stapel und stellt sicher, dass Langzeitspeicherfähigkeit nicht nur theoretisch, sondern auch im praktischen Einsatz robust ist.

Für Teams, die Alternativen wie Mamba-basierte Vision-Stapel evaluieren, sind diese Methoden komplementär, nicht widersprüchlich, und können mit minimalem Reibungsverlust in breitere Architekturen integriert werden.

Benchmarks, die Speicher belasten: Memory Maze, Minecraft und darüber hinaus

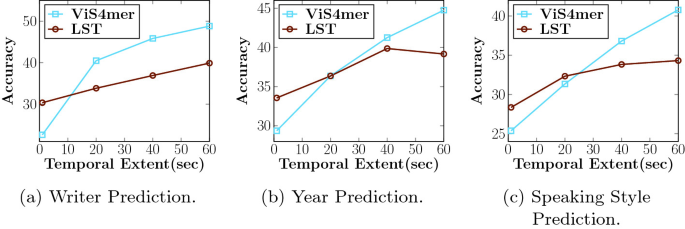

LSSVWM wurde auf Memory Maze und Minecraft bewertet, Benchmarks, die speziell für räumliche Wiedererkennung und Langzeit-Schlussfolgerungen entwickelt wurden. Memory Maze prüft, ob ein Agent zuvor gesehene Landmarken, Türen und Schlüssel nach langen Umwegen abrufen kann. Minecraft verlangt persistentes Bewusstsein für Inventar, Fertigungsschritte und Koordinaten und verbindet Low-Level-Steuerung mit High-Level-Plänen. Beide legen die Achillesferse von Kurzzeit-Kontextmodellen offen: Zustandsfragmentierung.

Bei Memory Maze heben qualitative Ergebnisse hervor, dass LSSVWM konsistente Renderings bereits besuchter Räume beibehält, Objektidentitäten über lange Lücken hinweg bewahrt und sich beim Zurückkehren zu früheren Blickpunkten korrekt neu orientiert. Vergleichbare, auf Aufmerksamkeit fokussierte Baselines zeigen „Identitätsdrift“ – Bodenmuster verändern sich, Objekte springen oder Wände verändern sich subtil. In Minecraft-artigen Bewertungen bewahrt das Modell die Erinnerung an abgebautes Material und Rezepte über Hunderte Frames und erzeugt action-konsistente Zukunftsszenarien, bei denen Werkzeuge in der richtigen Reihenfolge verwendet und Landmarken an ihrem Platz bleiben.

Vergleiche reichen bis zu starken Baselines, darunter kausale Aufmerksamkeitsmodelle und SSM-Varianten wie Mamba2 ohne frame-lokale Fenster. Die Hybridlösung mit Frame Local Attention liefert durchgehend höhere Langstreckenkonsistenz und bessere Stichprobenqualität bei vergleichbarer oder geringerer Latenz. Für interaktive Anwendungen – kreative Vorschauen, Roboterplanung oder Spielagenten – ist die Balance aus Geschwindigkeit und Erinnerungsvermögen entscheidend.

- 🗺️ Räumliche Wiedererkennung: Entfernungslankmarken wiedererkennen, um effizient zu navigieren.

- 🧰 Prozedurale Erinnerung: mehrstufige Herstellungs- oder Werkzeugsequenzen merken.

- 🎯 Kohärenz unter Rauschen: Kamerasprünge und Verdeckungen achtungsvoll behandeln.

- ⏱️ Praxisnahe Latenz: Echtzeit- oder nahezu Echtzeit-Entscheidungsschleifen unterstützen.

| Benchmark 🧭 | Getestete Fähigkeit 🧠 | Baseline-Verhalten 🐢 | LSSVWM-Verhalten 🚀 | Auswirkung 📊 |

|---|---|---|---|---|

| Memory Maze | Langstreckige räumliche Wiedererkennung | Identitätsdrift 😕 | Stabile Landmarken 😊 | Weniger Fehlwege, schnellere Fertigstellung |

| Minecraft | Prozedurales und Inventar-Gedächtnis | Vergessene Schritte 🔁 | Korrekte Reihenfolge der Aktionen 🧩 | Koherentere Zukunftsszenarien |

| Freiform-Video | Globale Kohärenz + lokale Details | Kontextkürzung ✂️ | Erweiterte Horizonte 🕰️ | Bessere Planungs-Vorschauen |

Für Forscher bei DeepMind, Meta, und Google spiegeln diese Ergebnisse interne Erkenntnisse wider: Langzeitspeicher ist nicht nur für Genauigkeit wichtig, sondern auch für das Vertrauen der Nutzer. Wenn ein Modell die bisherige Geschichte erinnert, wirkt alles glaubwürdiger und handlungsfähiger.

Die Beweise deuten auf eine einfache Schlussfolgerung hin: praktische Weltmodelle müssen effizienten Langzeitgedächtnis mit Mechanismen kombinieren, die lokale Genauigkeit schützen. LSSVWM setzt diese Vorlage.

Implikationen für die Industrie: Von Kreativwerkzeugen bis zur Robotik

Die Architektur- und Trainingsentscheidungen in LSSVWM wirken weit über akademische Benchmarks hinaus. In Kreativsoftware erwarten Editoren sofortige, kontextbewusste Vorhersagen: Wohin schwenkt die Kamera als nächstes, wie wird sich die Beleuchtung entwickeln, was bleibt über Schnittgrenzen hinweg konsistent? Systeme, die auf SSMs + lokaler Aufmerksamkeit basieren, können intelligente Vorschauen und kontextstabile generative Füllungen bieten, nützlich für Storyboarding, Motion Design und Postproduktion. Für ein hypothetisches Streaming-Studio bedeutet das schnellere Iterationszyklen und weniger Frame-Korrekturdurchgänge.

In Robotik und autonomen Systemen ist Langzeitspeicher noch wichtiger. Ein Lagerroboter, der von einem Video-Weltmodell gesteuert wird, muss Hindernisse, die Minuten zuvor gesehen wurden, erinnern, nicht nur Sekunden. Mit LSSVWM-ähnlichen Designs können Planungsschichten mit Zuversicht simulieren, wobei NVIDIA-Hardwarebeschleunigung die Latenz im sicheren Bereich hält. Teams bei Amazon könnten solche Modelle in Logistik-Simulatoren integrieren, während Unternehmen, die IBM und Microsoft Cloud-Stacks nutzen, sie in Inspektions-Pipelines oder Smart-City-Überwachung einbetten könnten.

Beim Endverbraucher profitieren mobile und Headset-Geräte von Apple von kompakten SSM-Rückgraten, die Speicher ausdehnen, ohne die Leistungsbudgets zu überschreiten. Kombiniert mit effizienten Aufmerksamkeitskernen ist das Ergebnis überzeugend: Langkontext-AR-Szenenverständnis, das reaktionsfähig bleibt. Forschungseinrichtungen wie OpenAI und DeepMind können hybride Speicher in multimodale Agenten integrieren und Videovorhersage mit Textplanung und Aktionsrichtlinien abstimmen.

- 🎬 Kreativ-Suiten: stabile Inpainting, längere Vorschauen, konsistente Effekte.

- 🤖 Robotik: persistenter Szenenspeicher für sichere Navigation und Manipulation.

- 📱 Edge-Geräte: energieeffiziente Langkontextmodellierung für AR/VR.

- 🧭 Simulation + Planung: verlässliche Voraussicht in komplexen Umgebungen.

| Sektor 🏭 | Anwendungsfall 🎯 | Kernbedarf 🧰 | LSSVWM-Vorteil 🌟 | Interessengruppen 👥 |

|---|---|---|---|---|

| Medienerstellung | Kontextstabiles Video-Generieren | Langzeitgedächtnis + Genauigkeit | Hybrid SSM/Aufmerksamkeit 🎞️ | Adobe, Apple 🍏 |

| Logistik/Robotik | Planung mit Video-Weltmodellen | Latenz + Rückruf | Lineare Zeit im Speicher ⚙️ | Amazon, Microsoft 🪟 |

| KI-Agenten | Multimodales Schließen | Modalitätenübergreifende Kohärenz | Langkontext-Rückgrat 🧠 | OpenAI, DeepMind 🧪 |

| Forschung/Infra | Effizientes Training & Inferenz | Durchsatz + Skalierung | Segmentierte Fenster, FlexAttention 💡 | Google, Meta, IBM 🏛️ |

Branchenübergreifend gilt: Wenn Modelle länger die richtigen Dinge erinnern, wirken Produkte schlauer, sicherer und kreativer. Die LSSVWM-Vorlage zeigt, wie man dies erreicht, ohne die Rechenressourcen zu sprengen.

{“@context”:”https://schema.org”,”@type”:”FAQPage”,”mainEntity”:[{“@type”:”Question”,”name”:”Was macht Zustandsraummodelle für Langzeitspeicher besser als alleinige Aufmerksamkeit?”,”acceptedAnswer”:{“@type”:”Answer”,”text”:”SSMs propagieren einen kompakten verborgenen Zustand über die Zeit mit linearer Komplexität und ermöglichen so viel längere Horizonte ohne quadratische Kosten. In hybriden Stapeln erhält dichte lokale Aufmerksamkeit feine Details, während SSMs die Langstreckengeschichte tragen.”}},{“@type”:”Question”,”name”:”Wie erweitert blockweises SSM-Scannen den Speicher?”,”acceptedAnswer”:{“@type”:”Answer”,”text”:”Indem Frames in Blöcken verarbeitet und ein gelernter Zustand zwischen den Blöcken weitergegeben wird, bewahrt das Modell vergangene Informationen über lange Sequenzen, während die Rechnerkosten begrenzt bleiben. Es tauscht etwas Strenge innerhalb der Blöcke gegen dramatisch längere Erinnerungsfähigkeit.”}},{“@type”:”Question”,”name”:”Warum Diffusion Forcing im Training verwenden?”,”acceptedAnswer”:{“@type”:”Answer”,”text”:”Diffusion Forcing konditioniert die Erzeugung auf partielle oder sogar null-lange Präfixe und lehrt das Modell, von minimalem Kontext aus kohärent zu bleiben. Dies ist nützlich für Mid-Clip-Bearbeitungen, interaktive Vorschauen und Agenten-Resets.”}},{“@type”:”Question”,”name”:”Was ist Frame Local Attention und warum ist FlexAttention wichtig?”,”acceptedAnswer”:{“@type”:”Answer”,”text”:”Frame Local Attention gruppiert Frames in Abschnitte mit Bidirektionalität innerhalb und Rückblick auf den vorherigen Abschnitt. FlexAttention setzt diese Muster effizient um und erzielt Geschwindigkeitsvorteile gegenüber komplett kausalen Masken.”}},{“@type”:”Question”,”name”:”Wo könnte die Industrie LSSVWM zuerst einsetzen?”,”acceptedAnswer”:{“@type”:”Answer”,”text”:”Kreativwerkzeuge (Adobe), Robotik und Logistik (Amazon, Microsoft), Edge-AR/VR (Apple) und multimodale Agentenforschung (OpenAI, DeepMind) sind unmittelbare Kandidaten, wegen ihres Bedarfs an Langzeitkonsistenz und niedriger Latenz.”}}]}Was macht Zustandsraummodelle für Langzeitspeicher besser als alleinige Aufmerksamkeit?

SSMs propagieren einen kompakten verborgenen Zustand über die Zeit mit linearer Komplexität und ermöglichen so viel längere Horizonte ohne quadratische Kosten. In hybriden Stapeln erhält dichte lokale Aufmerksamkeit feine Details, während SSMs die Langstreckengeschichte tragen.

Wie erweitert blockweises SSM-Scannen den Speicher?

Indem Frames in Blöcken verarbeitet und ein gelernter Zustand zwischen den Blöcken weitergegeben wird, bewahrt das Modell vergangene Informationen über lange Sequenzen, während die Rechnerkosten begrenzt bleiben. Es tauscht etwas Strenge innerhalb der Blöcke gegen dramatisch längere Erinnerungsfähigkeit.

Warum Diffusion Forcing im Training verwenden?

Diffusion Forcing konditioniert die Erzeugung auf partielle oder sogar null-lange Präfixe und lehrt das Modell, von minimalem Kontext aus kohärent zu bleiben. Dies ist nützlich für Mid-Clip-Bearbeitungen, interaktive Vorschauen und Agenten-Resets.

Was ist Frame Local Attention und warum ist FlexAttention wichtig?

Frame Local Attention gruppiert Frames in Abschnitte mit Bidirektionalität innerhalb und Rückblick auf den vorherigen Abschnitt. FlexAttention setzt diese Muster effizient um und erzielt Geschwindigkeitsvorteile gegenüber komplett kausalen Masken.

Wo könnte die Industrie LSSVWM zuerst einsetzen?

Kreativwerkzeuge (Adobe), Robotik und Logistik (Amazon, Microsoft), Edge-AR/VR (Apple) und multimodale Agentenforschung (OpenAI, DeepMind) sind unmittelbare Kandidaten, wegen ihres Bedarfs an Langzeitkonsistenz und niedriger Latenz.

-

Open Ai1 week ago

Open Ai1 week agoEntfesselung der Power von ChatGPT-Plugins: Verbessern Sie Ihr Erlebnis im Jahr 2025

-

Open Ai7 days ago

Open Ai7 days agoMastering GPT Fine-Tuning: Ein Leitfaden zur effektiven Anpassung Ihrer Modelle im Jahr 2025

-

Open Ai1 week ago

Open Ai1 week agoVergleich von OpenAIs ChatGPT, Anthropics Claude und Googles Bard: Welches generative KI-Tool wird 2025 die Vorherrschaft erlangen?

-

Open Ai7 days ago

Open Ai7 days agoChatGPT-Preise im Jahr 2025: Alles, was Sie über Tarife und Abonnements wissen müssen

-

Open Ai1 week ago

Open Ai1 week agoDas Auslaufen der GPT-Modelle: Was Nutzer im Jahr 2025 erwartet

-

KI-Modelle7 days ago

KI-Modelle7 days agoGPT-4-Modelle: Wie Künstliche Intelligenz das Jahr 2025 verändert